在现实生活中,许多规则的获取通常需要使用语言作为桥梁,特别是语义在信息传递中起着至关重要的作用。另外,个体使用的语言往往具有明显的奖励和惩罚元素,如赞扬和批评。一种常见的规则是寻求更多的赞扬,同时避免批评。以往的研究使用概率反转学习任务来检查抽象规则的学习。这个任务的结构涉及两个行为选择的奖励分配:当一个行为是高奖励,则另一个必然是高惩罚,反之亦然,并且在一段时间后规则将会发生偶然性的反转。这些研究经常使用不规则的图像作为刺激,以检查非语言刺激和反应之间的联系。然而,与非语言刺激相比,词汇的语义处理需要额外的认知资源,语义和反应之间的连接可能会更加复杂。

近日,辽宁师范大学脑与认知神经科学研究中心的刘欢欢副教授(通讯作者)和刘林焱(第一作者)在国际高水平期刊《NeuroImage》上发表题为“The right superior temporal gyrus plays a role in semantic-rule learning: Evidence supporting a reinforcement learning model”的研究论文。论文在强化学习框架下,采用Rescorla-Wagner强化学习算法的分层贝叶斯扩展模型,涉及期望值、预测误差、学习率和结果敏感性,以此推断被试与规则学习相关的内部状态,设计了语义规则和颜色规则的学习任务,并巧妙的加入了一个弱语义规则学习任务,即第二语言(L2)下的规则学习。结果表明涉及语义的规则学习并不是类似于条件刺激-反应的一般符号学习,而是具有自己独特的特征,右侧颞上沟在这种语义规则的学习中至关重要。

实验设计

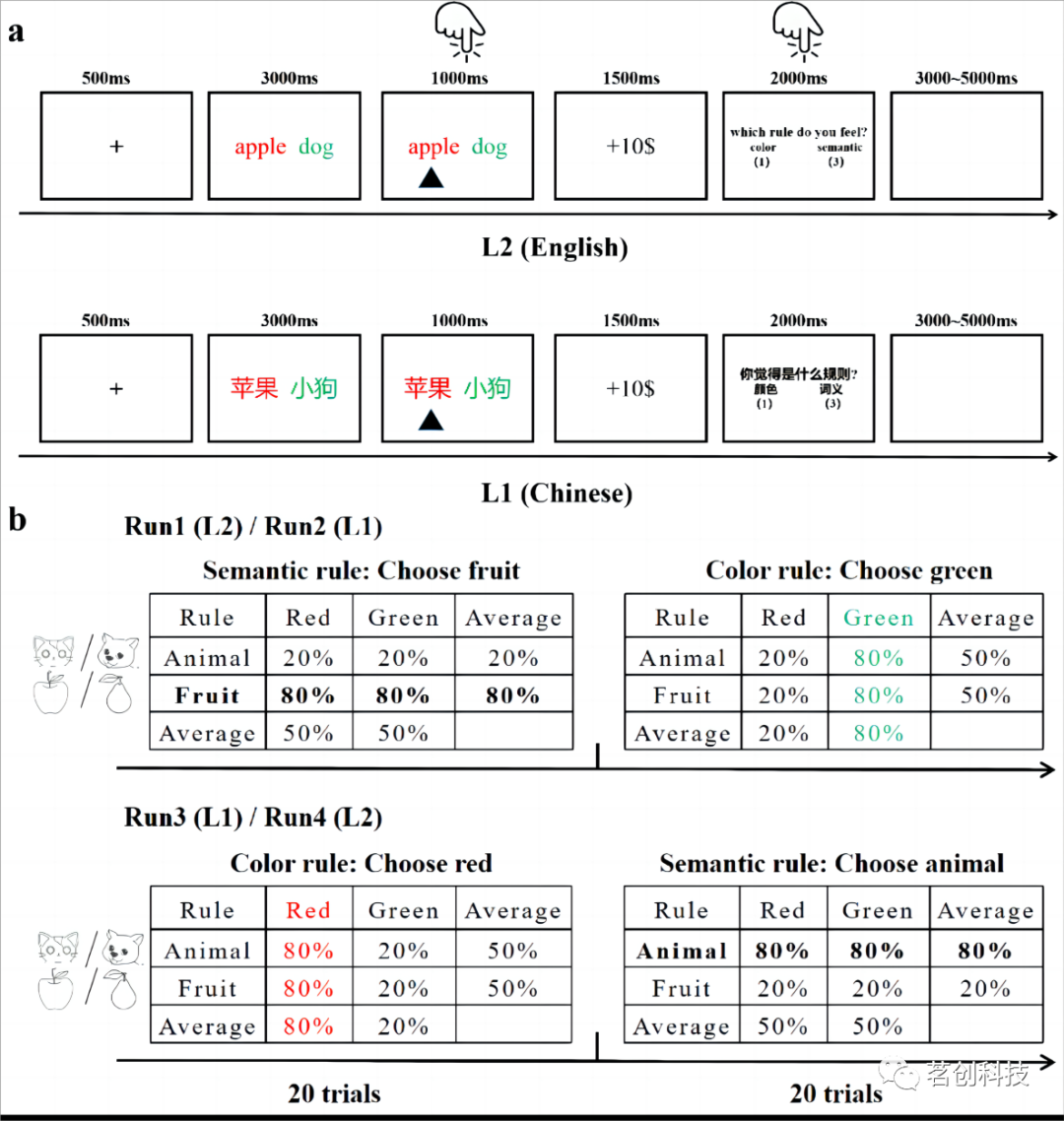

实验要求被试判断何种规则(即语义规则或颜色规则)对应当前规则学习任务中的最高奖励概率。例如,前20 次试验中的规则是颜色,那么选择正确的颜色会导致奖励与惩罚的比例为80:20。此时,如果被试根据语义类别选择刺激,则奖励与惩罚的比例为50:50。该实验共进行四轮,其中两次以中文呈现,两次以英文呈现(见图1)。

图1 实验步骤和实验流程

实验结果

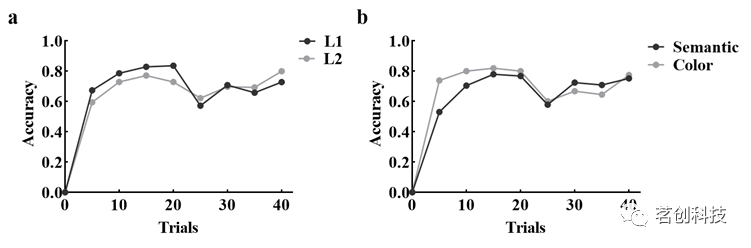

图2 行为结果

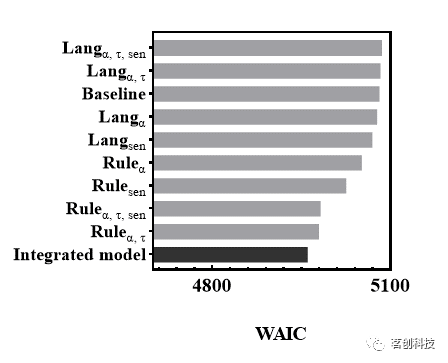

如图2所示,当规则更新时,被试重新学习了正确的规则。强化学习模型一共建立了四个语言模型、四个规则模型和一个基线模型。基线模型不包括语言和规则的影响。通过一般适用信息标准(WAIC)筛选出最优的语言模型和最优的规则模型。最后,将最优的语言模型和最优的规则模型结合,形成一个整合模型。如图3所示,根据强化学习模型WAIC指标的比较,整合模型具有最低的WAIC。

图3 强化学习模型对比

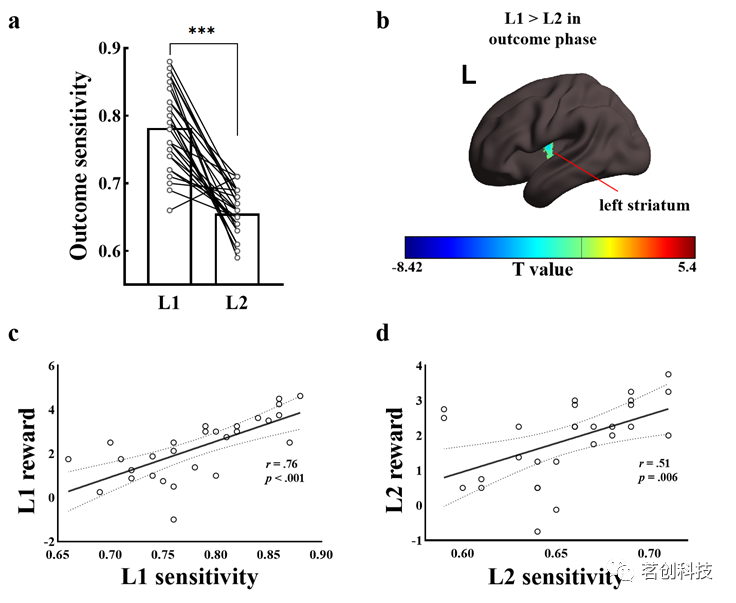

敏感性分析如图4所示,L1组的敏感性显著高于L2。结果敏感度越高,被试越倾向于获得奖励或不接受惩罚。fMRI的结果也表明在反馈阶段,左侧纹状体(MNI空间坐标:-33, - 6, 9)在L1组下的激活强于L2(GRF校正),支持了母语反馈比外语反馈的规则学习更敏感。此外,敏感性与不同语言下的平均奖励得分的相关分析表明,敏感度越高的被试积累的奖励越多,任务表现越好。

图4 结果敏感性的语言差异

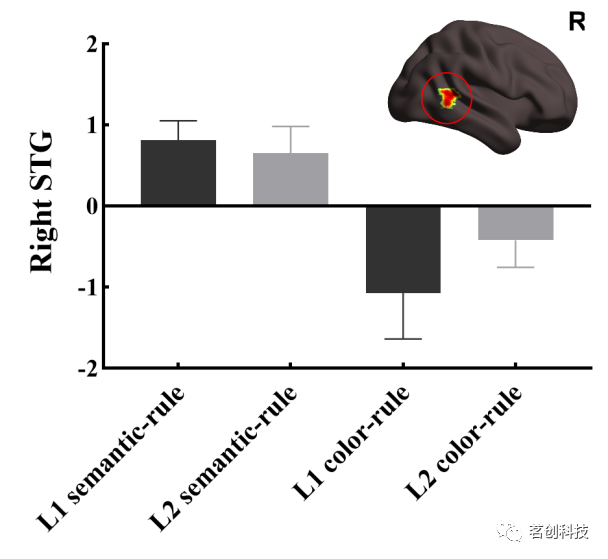

如图5所示,语义规则下对于预测误差的加工定位于右侧颞上回(STG),表明右侧STG是言语刺激学习中一个独特的脑区。注意,这是回归的斜率差异,而不是激活的差异。语义规则条件主效应的回归方向为正,而颜色规则条件的回归方向为负,表明不同规则在右侧STG的活动模式差异是定性的,而不是定量的。

图5 基于模型分析的fMRI结果

结论

这项研究揭示了语义影响规则学习的神经基础。研究修正了传统的强化学习模型,将语言对结果敏感性的影响、规则对学习率的影响纳入其中,以证实语义通过特殊的“条件刺激”影响规则学习。结果表明,母语的规则学习对反馈更为敏感,被试能够根据当前规则调整自己的学习策略。重要的是,这项研究揭示了语言刺激的规则学习存在独特的神经机制,定位于右侧STG。这些发现强调了依赖于语言的规则学习有其特殊性,不同于一般符号的学习。

论文信息:Linyan Liu, Dongxue Liu, Tingting Guo, John W. Schwieter, & Huanhuan Liu, The right superior temporal gyrus plays a role in semantic-rule learning: Evidence supporting a reinforcement learning model, NeuroImage (2023), doi: https://doi.org/10.1016/j.neuroimage.2023.120393

- 附代码)

Sequence Parallel分析)

)

)

02/2 PyTorch 教程)

![[23] IPDreamer: Appearance-Controllable 3D Object Generation with Image Prompts](http://pic.xiahunao.cn/[23] IPDreamer: Appearance-Controllable 3D Object Generation with Image Prompts)