-

这是CVPR2022的一篇曝光校正的文章,是中科大的。一作作者按同样的思路(现有方法加一个自己设计的即插即用模块以提高性能的思路)在CVPR2023也发了一篇文章,名字是Learning Sample Relationship for Exposure Correction。

-

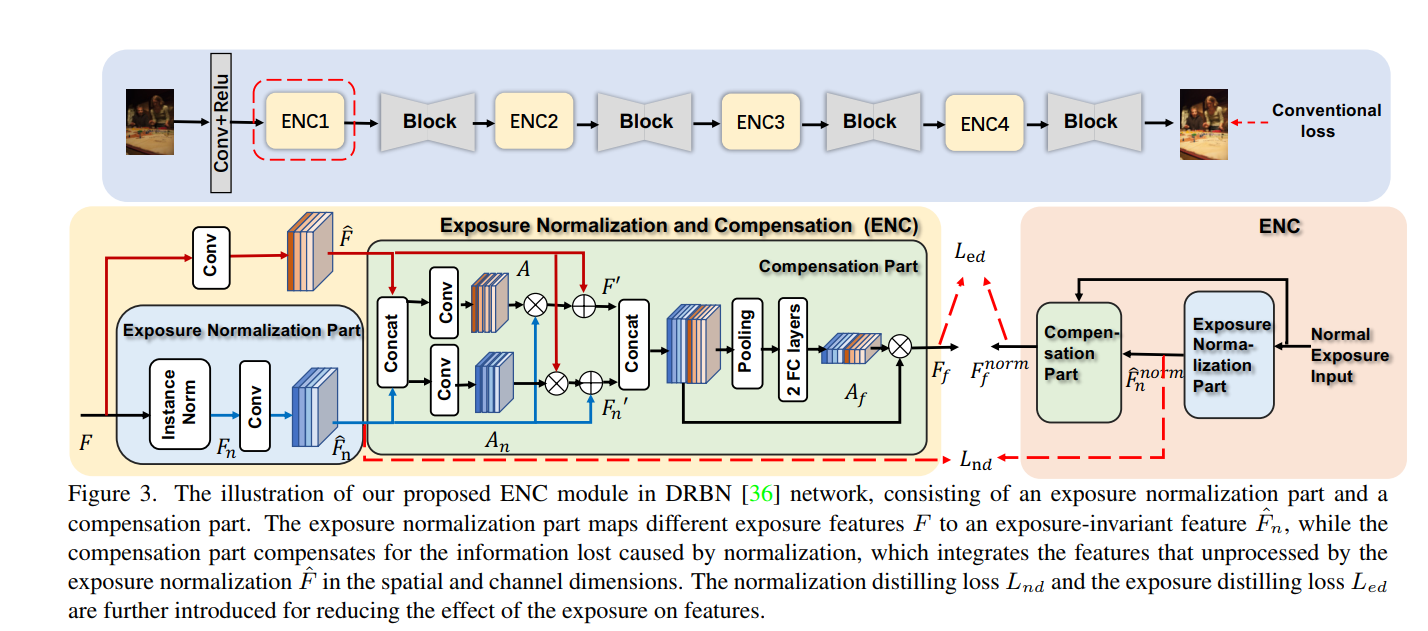

文章的动机是,多曝光图像中,过曝和欠曝的图片的调整方向是相反的,给训练带来了问题(和CVPR2023那篇的动机是一致的)。同时,网络优化过程中不同批次之间可能样本分布差距较大,从而网络对某些样本(类似难样本)进行忽视,拟合大多数样本来达到低的期望损失。为解决第一个问题提出了一个类即插即用的ENC模块,用了插在现有网络的block之间。如下图所示

-

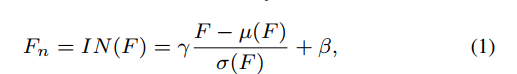

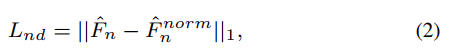

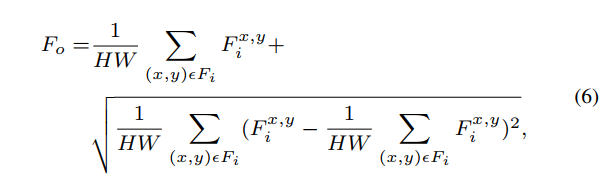

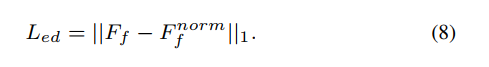

使用instanceNorm来对特征进行归一化,再经过一层卷积层,然后计算和GT归一化后的特征之间的L1损失:

-

-

为了弥补在归一化过程中损失掉的信息,又加了一个compensation 模块,即图中绿色的部分,通过红色实线箭头从归一化前的特征中提取额外特征进行补偿,其中还用到了空间注意力机制,具体看图。另外,图中的pooling是如下式的global contrast average pooling,如字面上的意思,是个global average pooling,但是加了边缘图的global average pooling结果:

-

同样,compensation模块的输出,也要和GT的compensation模块的输出算L1损失:

-

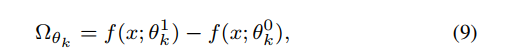

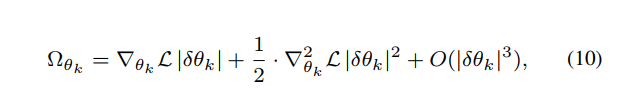

再然后就是文章第二个点了:fine-tuning with parameter regularization,这个是为了解决第二个问题。文章认为,常规的图像输入主要通过ENC模块来解决,那么fix ENC模块,finetune其它模块,就可以在保持常规图像输入的性能不下降的条件下提高难样本的性能。而finetune其它模块的时候,可以利用现有的一个方法来计算参数的重要性,从而对重要参数的变化进行惩罚,使得重要参数在finetune的过程中不要发生大的变化,使得对常规图像输入的性能不下降而对难样本的性能提升。

-

参数的重要性可以通过对常规样本的结果对参数的微分来计算,也就是(10)式,从而在finetune的过程中,通过限制在这m个常规样本上的输出的变化,使得对常规样本的性能不下降。有点像增量学习。

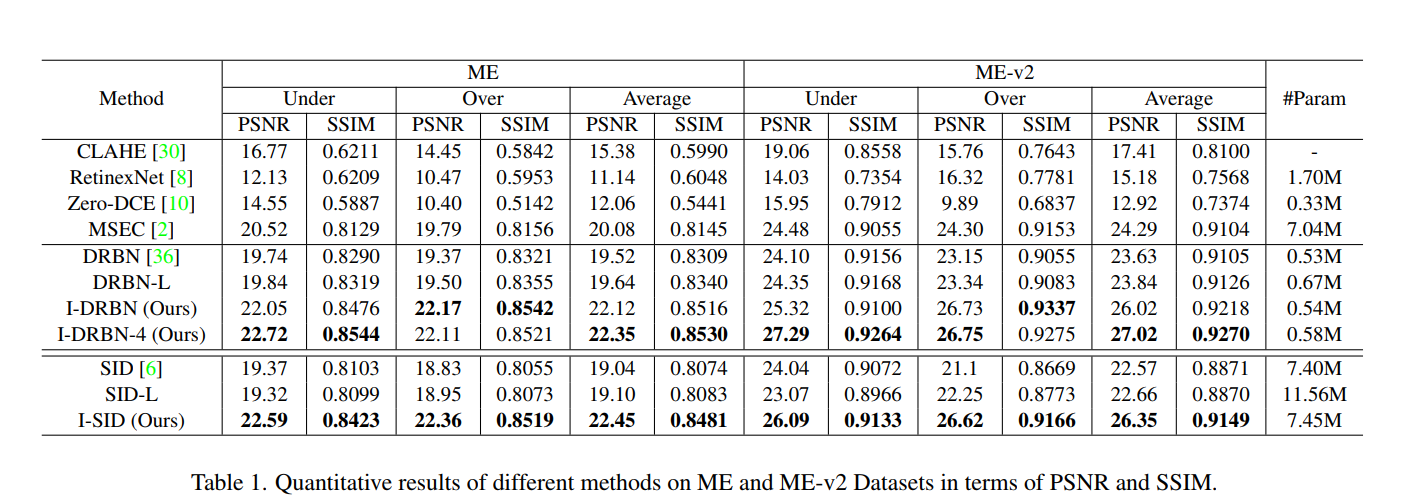

实验结果如下所示,通过添加这一模块,使得SID和DRBN在ME数据集上的性能有所提升:

-

评价:第二部分增量学习的部分感觉是为了凑创新点,和第一点没有什么必要放在同一篇论文中。但作为凑创新点来说又不够创新,本身idea就不是自己的,只是拿来用在多曝光图像的训练上了。第一部分我确实是认可的,我觉得instance norm在多曝光图像处理中确实是重要的一个操作。

回环地址写数据速度对比(二))

)