今天分享一篇Microsoft公司的一篇文章,Title: Improving Text Embeddings with Large Language Models:使用大语言模型改善文本嵌入。

这篇文章探索了直接利用LLM来做embedding模型,其只需要利用合成数据和少于1000次的训练步骤就能获得高质量文本表征。

该方法分为两步:

1)利用LLM生成文本embedding任务合成数据集: 利用专有的大语言模型(LLM)生成近100种语言的数十万个文本嵌入任务的多样化合成数据。

2)对比损失微调: 使用标准对比损失对开源的decoder-only LLM进行微调。

该方法特点总结如下:1)充分挖掘了大模型生成数据多样性还不错的特点,利用这个特点,可以利用LLM生成多样性比较好、类型丰富、以及多语言的文本表征模型数据集。2)相对于之前例如SimCSE等模型,需要在大量语料上继续做预训练以及微调,本文发现自回归的LLM只需少量监督数据就能获得一个非常不错的效果。3)多语言的检索能力也不错。

一、概述

Title:Improving Text Embeddings with Large Language Models

论文地址:https://arxiv.org/abs/2401.00368

1 Motivation

- 现有的文本嵌入方法依赖于多阶段预训练和少量标注数据的微调【大量数据->弱监督预训练,少量标注数据->fine-tuning】,需要构建复杂的训练流程,且数据集通常受限于任务多样性和语言覆盖范围。

- 本文提出了一种新的方法:利用大型语言模型生成多样化的合成数据,通过简单但有效的训练步骤改善文本嵌入的质量,特别在多种语言环境中效果非常不错。

2 Methods

省流版总结:

- 合成数据生成:分两步生成合成数据,第一步生成检索任务主题,第二步根据主题生成问题、正样本、负样本。其特点是生产的检索任务多样性不错、同时还可以生成多语言的数据集。

- 对比学习训练:利用常规的对比学习loss *InfoNCE函数训练模型,只是用合成数据,只需要1k步左右训练就能有一个不错的效果,叠加监督数据效果更佳* 。

2.1 利用LLM生成训练样本

通常训练embedding模型强烈依赖正负样本数据,标注成本比较高。这里本文尝试利用专有LLM(如GPT-4)生成近100种语言的多样化合成数据,用于训练embedding模型。

背景: 使用LLM合成数据,增强文本嵌入模型的多样性和鲁棒性。

方法: 设计了多种任务类型和语言的模板,通过LLM生成合成数据。

特点: 能够覆盖广泛的任务和语言类型,提高数据的多样性和质量。

1)利用LLM列举检索任务:

2)针对每个任务,利用LLM按照要求生成训练样本:

2.2 模型训练

要点一: 需要指定任务task_definition,输入用户问题。其中合成的数据用2.1中第一步LLM生成的任务定义,其他数据集人工设置固定的模版。

要点二: 相似度计算方式为cos相似度,并结合温度系数超参数来调节具体值。

要点三: Loss函数为标准的InfoNCE函数,其惩罚了负样本,提升正样本的相似度分数。

3 Conclusion

结论1: 使用LLM生成的合成数据可以显著提升文本嵌入的性能。

结论2: 方法在多语言环境下表现良好,特别是在BEIR和MTEB基准上。

结论3: 本方法提供了一种更高效的文本嵌入训练策略,避免了复杂的多阶段训练。

4 Limitation

- 尽管在多种语言中表现良好,但对低资源语言的支持仍有待改进,利用LLM做文本embedding成本还比较高。

- 未来工作将探索使用开源LLM生成合成数据,并提高模型在长文本处理方面的效率。

二、详细内容

2.1 合成数据的统计分析

结论1: 生成了500k个样例,涵盖了150k个独特指令。包括非对称任务(query和doc不对称):short-long代表query是短文本,doc为长文本,其他可以反推。另一类任务是对称任务(query和doc语义相近,但是不对等):sts代表单语言语义相似度计算、bitext代表双语言检索任务。

结论2: 生成数据中覆盖93种语言。语言多样性不错,英语占大多数,其他语言占比也不少。

2.2 模型微调与评估

试验设置: 基座模型为Mistral-7b,微调方法为Lora,rank=16。

结论1: "E5mistral-7b + full data"模型在MTEB基准上超过先前最佳模型2.4分。

结论2: 使用混合数据微调的模型在MTEB基准上取得了最高平均得分。

结论3: w/synthetic data only代表仅使用合成数据训练的模型表现仍然竞争力十足。

结论4: 该方法的实验结果显示了生成语言建模和文本嵌入之间的潜在联系。

2.3 与商业闭源模型对比

**结论:**在BEIR Retrieval数据集和MTEB数据集都取得了SoTa。

2.4 LLM只需要少量数据做微调即可取得比较好的效果

结论一: 传统数据利用大量数据结合对比学习做无监督训练可以带来不错的提升。

结论二: 经过大量语料训练的自回归LLM模型已经不需要继续做预训练了,只需要少量的数据微调即可取得比较好的效果。

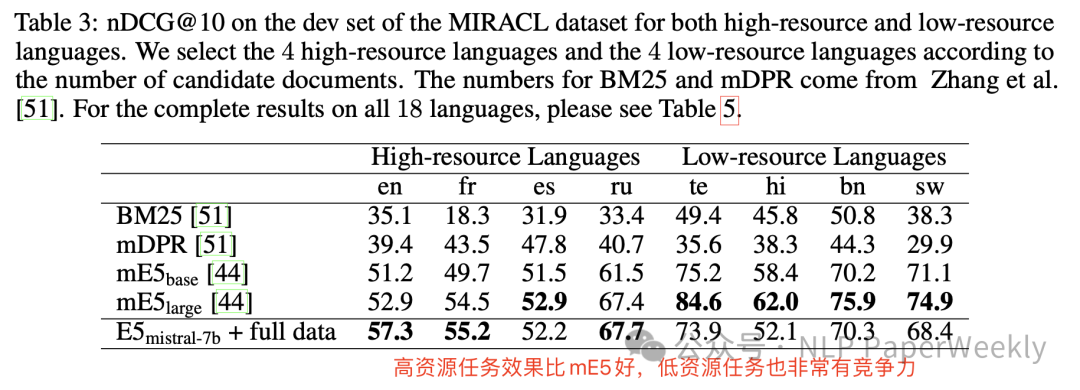

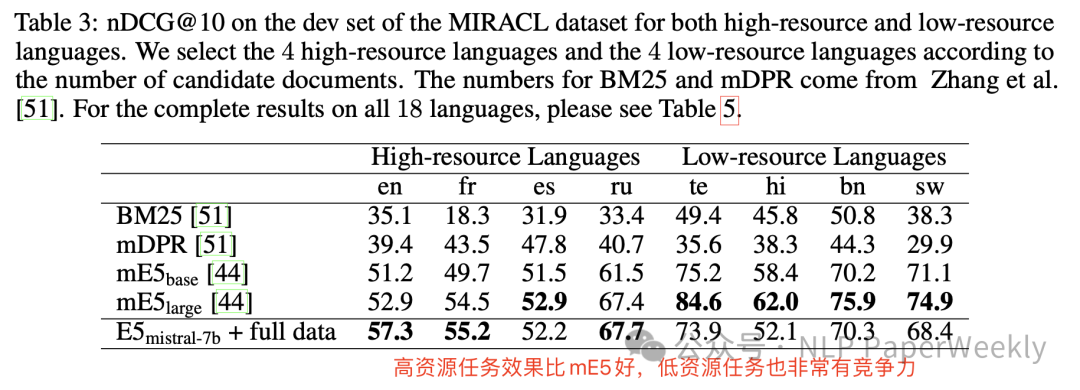

2.5 多语言任务上也非常有竞争力

结论一: 高资源(数据量多)任务例如英语,效果比之前的mE5模型效果好,低资源任务效果相对mE5也非常有竞争力。

2.6 消融实验:instruction设置比较关键

结论一: 基座模型选择也比较重要,选择LLaMA-2的基座模型比Mistral-7b作为基座模型差。

结论二: instruction的设置也非常重要,对最终结果的影响可能差4个点以上。

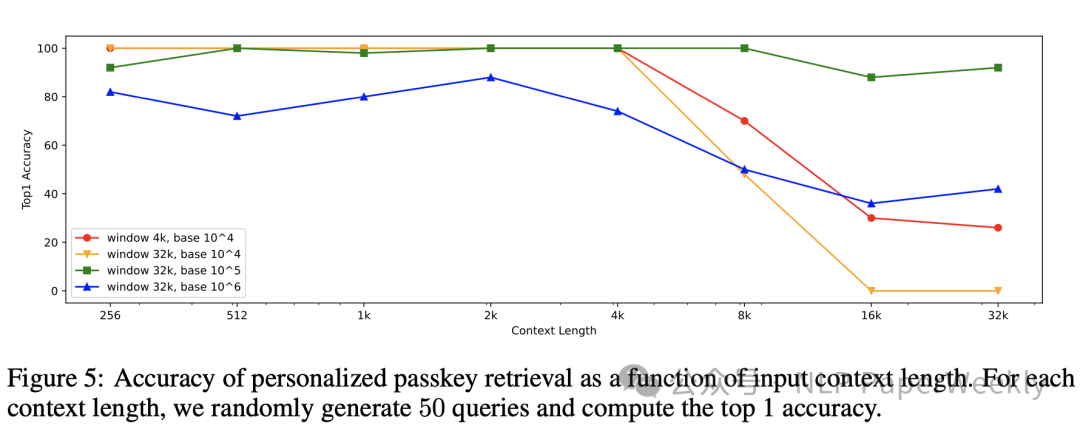

2.7 context长度对检索质量的影响:4k左右上下文文本表征都还不错,随后效果急剧下降。

结论:引入了一项名为个性化密码检索的新型合成任务,此任务需要在长上下文中将密钥信息编码到嵌入中。通过更改图5中的滑动窗口大小和RoPE旋转底座来比较不同变体的性能。结果显示,带有4k滑动窗口的默认配置在4k token数达到100%的准确性,但随着上下文长度的增长,准确性会迅速下降。

三、总结

结论1:利用LLM生成的合成数据可以显著提升文本嵌入的性能。 这种方法在处理多种语言时尤其有效,能够生成高质量、多样化的合成数据。

结论2:利用LLM训练Embedding模型可以非常高效。 与现有多阶段方法相比,其只需要少于1000次的训练步骤就可以拿到比较好的效果,而现有方法可能要先利用大量数据做自监督训练,然后再使用有监督数据训练,效率不高。

结论3:本文利用LLM做embedding是一个突破,但产业界还不太适用。 本文首次探索LLM做embedding,效果还不错,但模型大,推理成本也高,产业界实用性不高(bge相关模型只有400M左右,本文方法模型达到7B以上),后续可以探索LLM生成和挖掘正负样本数据,利用传统方法例如双塔+SimCSE系列等模型进行训练,然后再应用到产业界。

如何学习大模型

现在社会上大模型越来越普及了,已经有很多人都想往这里面扎,但是却找不到适合的方法去学习。

作为一名资深码农,初入大模型时也吃了很多亏,踩了无数坑。现在我想把我的经验和知识分享给你们,帮助你们学习AI大模型,能够解决你们学习中的困难。

我已将重要的AI大模型资料包括市面上AI大模型各大白皮书、AGI大模型系统学习路线、AI大模型视频教程、实战学习,等录播视频免费分享出来,需要的小伙伴可以扫取。

一、AGI大模型系统学习路线

很多人学习大模型的时候没有方向,东学一点西学一点,像只无头苍蝇乱撞,我下面分享的这个学习路线希望能够帮助到你们学习AI大模型。

二、AI大模型视频教程

三、AI大模型各大学习书籍

四、AI大模型各大场景实战案例

五、结束语

学习AI大模型是当前科技发展的趋势,它不仅能够为我们提供更多的机会和挑战,还能够让我们更好地理解和应用人工智能技术。通过学习AI大模型,我们可以深入了解深度学习、神经网络等核心概念,并将其应用于自然语言处理、计算机视觉、语音识别等领域。同时,掌握AI大模型还能够为我们的职业发展增添竞争力,成为未来技术领域的领导者。

再者,学习AI大模型也能为我们自己创造更多的价值,提供更多的岗位以及副业创收,让自己的生活更上一层楼。

因此,学习AI大模型是一项有前景且值得投入的时间和精力的重要选择。

)

)