问题详情:

WARNING:tensorflow:Your input ran out of data; interrupting training. Make sure that your dataset or generator can generate at least steps_per_epoch * epochs batches (in this case, 13800 batches). You may need to use the repeat() function when building your dataset.

根据报错信息,问题似乎出现在数据集生成器上。可以使用数据集的repeat()函数来确保生成足够的批次供训练使用。

我们可以对训练数据集(train_dataset)应用repeat()函数,以确保生成足够的批次:

train_dataset = train_dataset.repeat()问题原因:

generator产生的训练数据不够用,少于所要求的steps_per_epoch * epochs 个batch数。

(len(train_data)/batch_size)*epochs=所需要的训练数据的batch数

如果盲目的按照提示repeat()函数来扩充train_data的话,要求的所需的batch数也会相应地增多,会陷入一条死路。。

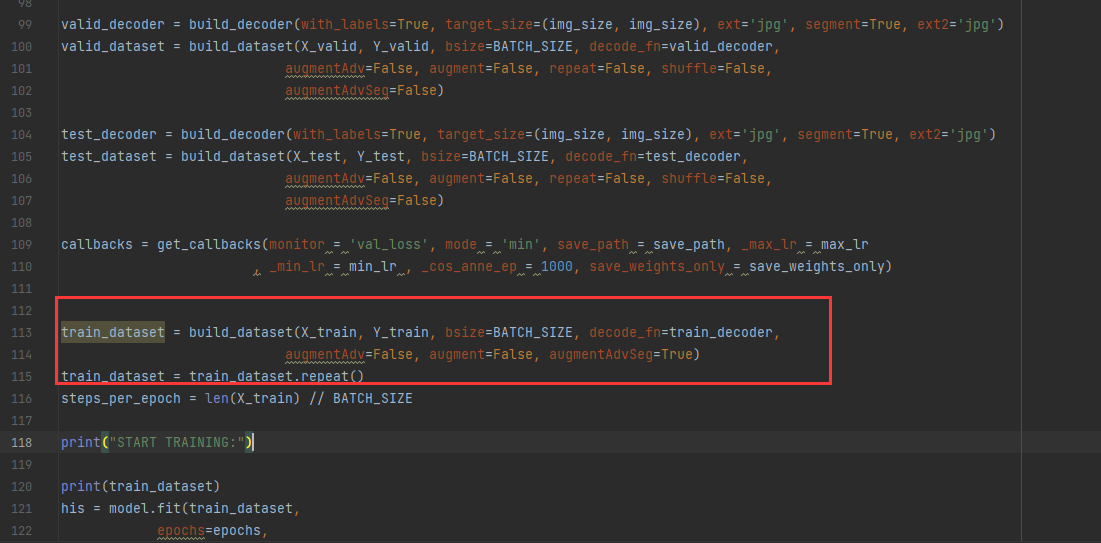

具体修改如下:

在我的代码中,在定义好的各种函数下,在steps_per_epoch = len(X_train) // BATCH_SIZE之前。

train_dataset = build_dataset(X_train, Y_train, bsize=BATCH_SIZE, decode_fn=train_decoder, augmentAdv=False, augment=False, augmentAdvSeg=True)

train_dataset = train_dataset.repeat()这样,在开始训练之前,数据集将使用 repeat() 函数来确保生成足够的批次供训练使用。

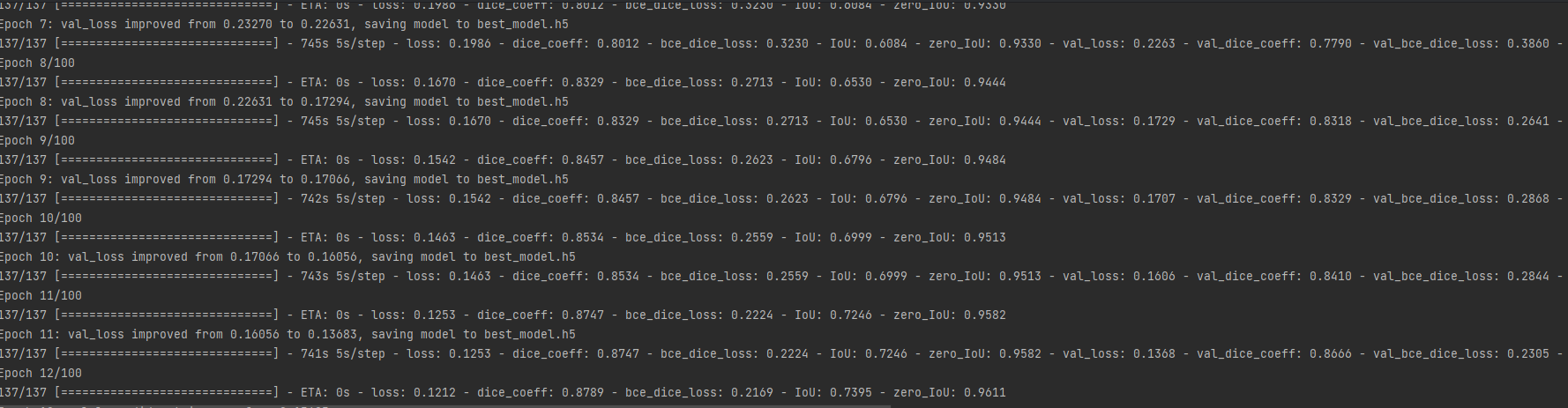

之前两个epoch就会停止,现在可以正常运行了

)

的设计与实现 Java实战项目 附源码+文档+视频讲解)

)

)

)

)