目录

云原生后端与大模型融合的开篇之章

探秘云原生后端开发

云原生后端是什么

云原生后端架构核心要素

微服务架构

容器化技术

服务发现与配置管理

Kubernetes 编排

走进腾讯云大模型知识引擎

引擎独特功能与优势

DeepSeek - R1、V3 两款模型 API 解析

代码实战:基于腾讯云大模型 API 构建云原生后端服务

前期准备工作

项目初始化与框架搭建

选择后端框架

创建 FastAPI 项目并展示基本结构

配置项目依赖

接入腾讯云 DeepSeek API

编写 API 调用函数

参数设置与优化

实现云原生后端服务核心功能

智能问答功能

文档解析与信息抽取

与其他云原生组件集成

总结与展望

云原生后端与大模型融合的开篇之章

在数字化浪潮汹涌澎湃的当下,云原生后端开发已然成为构建高效、灵活且可扩展应用的关键基石。随着云计算技术的迅猛发展,企业对于应用的性能、可靠性以及快速迭代能力提出了前所未有的高要求。云原生后端以其独特的优势,如容器化部署带来的高效资源利用、微服务架构实现的高可扩展性和灵活性,以及动态管理与持续集成部署所赋予的敏捷开发能力,正逐渐成为现代软件开发的主流范式。

与此同时,大模型技术的横空出世,如同一颗璀璨的新星照亮了人工智能领域的天空。大模型凭借其强大的语言理解、生成和推理能力,为各个行业带来了革命性的变革。从智能客服到内容创作,从数据分析到智能决策,大模型的应用场景愈发广泛,展现出巨大的潜力。

而腾讯云大模型知识引擎,无疑是这一领域的佼佼者。它同步提供 DeepSeek-R1、V3 两款模型 API 快速接入,为开发者们打开了一扇通往大模型世界的便捷之门。这两款模型 API 不仅具备强大的功能,而且在稳定性、安全性和易用性方面表现卓越。其稳定的 API 服务,如同坚实的桥梁,确保了数据传输的顺畅与可靠;严格的安全机制,为数据和应用筑牢了安全防线,让开发者无后顾之忧;而简洁易用的设计理念,大大降低了开发门槛,使更多的开发者能够轻松驾驭大模型技术,将其融入到自己的应用中。

通过腾讯云 DeepSeek API 结合大模型知识引擎开放的文档解析、拆分、embedding、多轮改写等多项 API 原子能力,开发者们仿佛拥有了一把神奇的钥匙,可以开启无限的创新可能。企业或者个人开发者能够根据自身的实际项目需求,或是对潜在应用开发的深入思考,灵活组建开发专属 AI 服务。这种高度的灵活性和定制化能力,使得大模型技术能够更好地满足不同行业、不同场景的多样化需求,为企业带来独特的竞争优势。

探秘云原生后端开发

云原生后端是什么

云原生后端,是基于云计算环境进行设计和开发的服务端应用,它深度融合了云服务与云原生技术,旨在为现代应用提供灵活、高效、弹性且可扩展的解决方案,已然成为当下构建应用程序的核心方式。在当今数字化时代,企业对应用的性能、敏捷性以及应对高并发的能力有着极高的要求,云原生后端正是顺应这一趋势而蓬勃发展。

云原生后端开发涵盖了一系列先进的技术与理念。从编程语言层面来看,常用的有 Golang、Java、Python 等。Golang 以其高效的并发处理能力和轻量级特性,在云原生开发中备受青睐,特别适合构建高性能、低延迟的微服务;Java 凭借其成熟的生态系统和强大的企业级框架,如 Spring Boot,为大型复杂应用的开发提供了坚实的基础;Python 则以其简洁易用和丰富的数据处理库,在快速迭代开发和数据相关的服务中展现出独特的优势。

云原生后端架构核心要素

微服务架构

微服务架构是云原生后端的核心架构模式之一,它将一个大型的、复杂的应用程序拆分成多个小型的、独立的服务,每个服务专注于完成一个特定的业务功能。这些微服务可以独立开发、独立部署、独立扩展,并且通过轻量级的通信机制相互协作。

微服务架构具有诸多显著优势。首先,它极大地提高了开发效率。不同的微服务可以由不同的团队负责开发,各团队能够根据自身的技术专长和业务需求,选择最合适的技术栈。例如,在一个电商系统中,用户认证服务可以使用 Java 和 Spring Security 来确保安全性和稳定性;而商品推荐服务则可以采用 Python 和相关的机器学习库,以充分利用 Python 在数据处理和算法实现方面的优势。这种技术多样性使得每个微服务都能发挥其最大效能,同时也促进了团队之间的技术交流与创新。

以电商系统为例,我们可以按照业务功能将其拆分为多个微服务。用户管理服务负责用户的注册、登录、个人信息管理等功能;商品管理服务负责商品的发布、编辑、上架、下架等操作;订单管理服务则专注于订单的创建、支付、发货、退款等流程;支付服务集成了各种支付方式,如支付宝、微信支付等,为订单支付提供支持。每个微服务都遵循单一职责原则,只负责自己特定的业务领域,这样使得代码结构更加清晰,易于维护和扩展。在实际开发中,用户管理服务可以使用 Java 和 Spring Boot 框架进行开发,利用 Spring Security 实现用户认证和授权功能;商品管理服务可以采用 Golang 编写,借助其高效的并发处理能力,快速响应用户对商品信息的查询和修改请求;订单管理服务和支付服务则可以根据具体需求,选择合适的技术栈进行开发。这些微服务之间通过轻量级的通信协议,如 RESTful API 或 gRPC 进行交互,实现数据的共享和业务流程的协同。例如,当用户下单时,订单管理服务会调用商品管理服务检查商品库存,调用支付服务进行支付操作,调用用户管理服务获取用户信息,最终完成订单的创建和处理。通过这种方式,电商系统的各个业务功能被拆分成独立的微服务,每个微服务都可以独立演进和扩展,从而提高了整个系统的灵活性和可维护性。

容器化技术

容器化技术是云原生后端开发的重要基石,而 Docker 则是其中最为流行的实现方式。Docker 通过将应用程序及其所有依赖项,包括代码、运行时环境、系统工具、系统库等,打包成一个标准的、独立的单元,即容器,实现了应用的跨环境一致性部署和运行。

容器化技术具有众多突出的优势。首先,它实现了环境的高度一致性。无论应用是在开发人员的本地机器上进行开发和测试,还是部署到测试环境、生产环境,只要使用相同的 Docker 镜像,应用就能以完全相同的方式运行。这彻底解决了因环境差异导致的 “在我这里运行没问题,到了其他环境就出错” 的问题,大大提高了开发和运维的效率。例如,开发团队在本地使用 Docker 容器搭建开发环境,安装了应用所需的各种依赖,如数据库、Web 服务器等。当需要将应用部署到测试环境或生产环境时,只需将本地的 Docker 镜像直接复制过去,就能确保应用在不同环境中的运行环境完全一致,避免了因环境配置不一致而引发的各种错误。

再者,容器化技术便于应用的迁移和部署。由于容器包含了应用运行所需的一切,将其从一个环境迁移到另一个环境变得非常简单。无论是从本地开发环境迁移到测试环境,还是从测试环境迁移到生产环境,甚至是在不同的云平台之间进行迁移,只要目标环境支持 Docker 引擎,就可以轻松地部署应用。例如,企业可以将基于 Docker 容器的应用从私有云平台迁移到公有云平台,或者在不同的公有云平台之间进行切换,而无需担心应用的兼容性和环境配置问题。这种灵活性使得企业能够根据自身的业务需求和成本考量,自由选择最合适的云服务提供商和部署环境。

以一个简单的 Python Web 应用为例,我们可以使用 Docker 将其容器化。假设该应用使用 Flask 框架开发,代码如下:

from flask import Flaskapp = Flask(__name__)@app.route('/')

def hello_world():return 'Hello, World!'if __name__ == '__main__':app.run(host='0.0.0.0', port=5000)为了将这个应用容器化,我们需要创建一个 Dockerfile。Dockerfile 是一个文本文件,其中包含了构建 Docker 镜像的指令。以下是一个简单的 Dockerfile 示例:

# 使用官方的Python 3.9基础镜像

FROM python:3.9# 设置工作目录

WORKDIR /app# 将当前目录下的所有文件复制到容器的/app目录下

COPY. /app# 安装应用所需的依赖项(这里假设使用requirements.txt文件来管理依赖)

RUN pip install -r requirements.txt# 暴露应用运行的端口

EXPOSE 5000# 定义容器启动时要运行的命令

CMD ["python", "app.py"]在上述 Dockerfile 中,首先指定了使用官方的 Python 3.9 基础镜像作为构建基础。然后设置了工作目录为 /app,将当前目录下的所有文件复制到容器的 /app 目录中。接着使用 RUN 指令安装应用所需的依赖项,这里假设依赖项已经记录在 requirements.txt 文件中。通过 EXPOSE 指令暴露应用运行的端口 5000,最后使用 CMD 指令定义容器启动时要运行的命令,即运行 Python 应用程序 app.py。

有了 Dockerfile 后,我们可以在包含应用代码和 Dockerfile 的目录下执行以下命令来构建 Docker 镜像:

docker build -t my-python-app.其中,“-t” 参数用于指定镜像的标签(tag),“my-python-app” 是我们给镜像起的名字,最后的 “.” 表示当前目录,即 Docker 会在当前目录下寻找 Dockerfile。构建完成后,我们可以使用以下命令来运行容器:

docker run -p 5000:5000 my-python-app“-p” 参数用于将宿主机的端口 5000 映射到容器内的端口 5000,这样我们就可以通过宿主机的 IP 和映射的端口访问容器内运行的应用了。通过这个简单的例子,我们可以清晰地看到 Docker 是如何将一个应用容器化并运行的,以及容器化技术在实现环境一致性和便捷部署方面的强大优势。

服务发现与配置管理

在云原生后端开发中,服务发现与配置管理是至关重要的环节,它们为微服务架构的稳定运行提供了有力支持。

以 Consul 为例,它是一个分布式的服务发现和配置管理工具,具有高可用、分布式、一致性等特点。Consul 基于 Raft 算法实现了数据的一致性,确保在集群环境下数据的可靠性。在使用 Consul 进行服务发现时,每个微服务在启动时会向 Consul 注册自己的服务信息,包括服务名称、IP 地址、端口号等。同时,Consul 会定期检查服务的健康状态,当某个服务出现故障时,Consul 会将其从服务列表中移除,避免其他服务向故障服务发送请求。当一个微服务需要调用另一个服务时,它会向 Consul 查询目标服务的地址,Consul 会返回可用的服务实例列表,微服务可以根据一定的负载均衡策略选择其中一个实例进行通信。例如,在一个由多个微服务组成的分布式系统中,用户管理服务可以通过 Consul 发现订单服务的地址,然后向订单服务发送创建订单的请求。通过这种方式,Consul 实现了微服务之间的动态发现和通信,提高了系统的灵活性和可扩展性。

Spring Cloud Config 是 Spring Cloud 生态系统中的一个配置管理组件,它为分布式系统中的微服务提供了集中化的外部配置支持。Spring Cloud Config 基于 Git 存储配置文件,通过将配置文件存储在 Git 仓库中,可以方便地进行版本控制和管理。微服务可以通过 Spring Cloud Config 客户端从配置服务器获取配置信息,并且支持配置的动态刷新。例如,我们可以在 Git 仓库中创建一个配置文件,用于存储微服务的数据库连接配置:

spring.datasource.url=jdbc:mysql://localhost:3306/mydb

spring.datasource.username=root

spring.datasource.password=password然后在微服务的配置文件中指定配置服务器的地址和应用名称,微服务启动时就会从配置服务器获取相应的配置信息。当配置信息发生变化时,我们可以通过发送 POST 请求到配置服务器的刷新端点,实现配置的动态更新,而无需重启微服务。通过这种方式,Spring Cloud Config 实现了微服务配置的集中管理和动态更新,提高了系统的可维护性和灵活性。

Kubernetes 编排

Kubernetes,简称 K8s,在云原生后端开发中扮演着 “超级管家” 的角色,是实现云原生架构的关键技术之一。它提供了一套强大的容器编排和管理功能,能够自动化地部署、扩展、监控和管理容器化应用程序,确保应用在复杂的云环境中稳定、高效地运行。

Kubernetes 的核心概念丰富而强大。Pod 是 Kubernetes 中最小的可部署和可管理的计算单元,它可以包含一个或多个紧密相关的容器。这些容器共享网络命名空间、存储卷等资源,它们之间可以通过localhost进行高效通信,就像在同一个进程中一样。例如,在一个 Web 应用中,我们可以将 Web 服务器容器和应用程序容器放在同一个 Pod 中,它们可以共享网络端口,并且可以方便地共享数据存储卷,实现数据的共享和交互。

在实际使用中,假设我们有一个简单的 Node.js Web 应用,我们希望使用 Kubernetes 进行部署。首先,我们需要创建一个 Docker 镜像,将应用及其依赖打包到镜像中。然后,我们可以编写一个 Kubernetes 的 Deployment 配置文件,例如 deployment.yaml:

apiVersion: apps/v1

kind: Deployment

metadata:name: my-nodejs-app

spec:replicas: 3selector:matchLabels:app: my-nodejs-apptemplate:metadata:labels:app: my-nodejs-appspec:containers:- name: my-nodejs-appimage: my-nodejs-app:latestports:- containerPort: 3000在这个配置文件中,我们定义了一个名为 my-nodejs-app 的 Deployment,期望创建 3 个 Pod 副本。通过 selector.matchLabels 来选择具有 app: my-nodejs-app 标签的 Pod。在 template 部分,我们定义了 Pod 的模板,包括容器的镜像、要暴露的端口等信息。

接着,我们可以创建一个 Service 配置文件,例如 service.yaml:

apiVersion: v1

kind: Service

metadata:name: my-nodejs-service

spec:selector:app: my-nodejs-appports:- protocol: TCPport: 80targetPort: 3000type: LoadBalancer这个 Service 配置文件将 my-nodejs-app 的 Pod 暴露出来,通过 LoadBalancer 类型的 Service,Kubernetes 会为我们分配一个外部可访问的 IP 地址,其他服务可以通过这个 IP 地址和端口 80 来访问我们

走进腾讯云大模型知识引擎

引擎独特功能与优势

腾讯云大模型知识引擎宛如一座智能的知识宝库,在云原生后端开发领域散发着独特的魅力,展现出诸多强大的功能与显著的优势。

| 接口名称 | 单价 | ||

| DeepSeek API 接口 | DeepSeek-R1 模型 | 输入:0.004元/千token | 输出(含思维链):0.016元/千token |

| DeepSeek-V3 模型 | 输入:0.002元/千token | 输出:0.008元/千token | |

多轮对话功能是其一大亮点,它使得人与机器之间的交互更加自然、流畅,仿佛是与一位知识渊博且耐心十足的专家进行交流。在实际应用中,比如智能客服场景,当用户咨询问题时,多轮对话功能能够理解用户的意图,根据上下文进行精准的回答,并能灵活应对用户的追问和进一步的需求。例如,用户询问 “我想购买一款手机,有什么推荐吗?” 知识引擎可以根据用户的需求,询问用户对手机品牌、预算、功能等方面的偏好,然后给出针对性的推荐。如果用户继续追问某款推荐手机的具体参数、价格等信息,知识引擎也能快速响应,提供详细的解答。这种多轮对话的能力,大大提升了用户体验,使智能客服能够更好地满足用户的需求,提高客户满意度。

文档解析能力则为处理各种复杂的文档提供了有力的支持。在企业级应用中,常常会遇到各种格式的文档,如 PDF、Word、Excel 等,这些文档可能包含丰富的业务信息和知识。腾讯云大模型知识引擎能够对这些文档进行深入解析,准确提取其中的关键信息,并将其转化为结构化的数据,以便后续的处理和分析。例如,在金融领域,知识引擎可以解析银行的财报文档,提取出资产负债表、利润表等关键数据,为金融分析师提供准确的数据支持;在法律行业,它可以解析合同文档,识别出合同中的关键条款、权利义务等信息,帮助律师进行合同审查和风险评估。这种强大的文档解析能力,不仅提高了文档处理的效率,还为企业的决策提供了更加准确和可靠的依据。

拆分和 embedding 能力也是知识引擎的重要功能之一。拆分能力可以将大型的文档或文本按照一定的规则进行分割,使其更易于处理和管理。而 embedding 能力则能够将文本转化为低维的向量表示,这些向量蕴含了文本的语义信息,使得计算机能够更好地理解和处理文本。通过 embedding 技术,知识引擎可以实现文本的相似度计算、聚类分析等功能,为知识检索和推荐提供了坚实的技术基础。例如,在企业知识库中,当用户搜索相关知识时,知识引擎可以通过计算用户输入的关键词与知识库中文本的向量相似度,快速找到与之相关的文档和知识,提高知识检索的准确性和效率。

此外,腾讯云大模型知识引擎还具有高度的可扩展性和灵活性。它可以轻松地与其他云服务和工具进行集成,如腾讯云的对象存储(COS)、数据库服务等,实现数据的无缝流动和共享。同时,知识引擎支持多种编程语言和开发框架,方便开发者根据自己的需求和技术栈进行定制化开发。无论是大型企业还是初创公司,都可以根据自身的业务需求,灵活地使用知识引擎的功能,构建出符合自己需求的 AI 应用。

在云原生后端开发中,腾讯云大模型知识引擎的这些优势能够为开发者带来诸多便利。它可以帮助开发者快速搭建智能应用,减少开发成本和时间。通过与云原生技术的深度融合,知识引擎能够充分利用云服务的弹性和高效性,实现应用的快速部署和扩展。例如,在一个电商应用中,知识引擎可以与微服务架构相结合,为各个微服务提供智能的知识支持,提升整个电商系统的智能化水平。同时,知识引擎的安全性和稳定性也为云原生后端应用的可靠运行提供了保障,确保应用在面对高并发和复杂业务场景时能够稳定、高效地运行。

DeepSeek - R1、V3 两款模型 API 解析

DeepSeek - R1 和 V3 两款模型 API 犹如两颗璀璨的明星,在云原生后端开发的舞台上各自闪耀,展现出独特的魅力和广泛的应用潜力。

| 接入地域 | 域名 |

|---|---|

| 就近地域接入(推荐,只支持非金融区) | lke.tencentcloudapi.com |

| 华南地区(广州) | lke.ap-guangzhou.tencentcloudapi.com |

| 华东地区(上海) | lke.ap-shanghai.tencentcloudapi.com |

| 华北地区(北京) | lke.ap-beijing.tencentcloudapi.com |

| 西南地区(成都) | lke.ap-chengdu.tencentcloudapi.com |

| 西南地区(重庆) | lke.ap-chongqing.tencentcloudapi.com |

| 港澳台地区(中国香港) | lke.ap-hongkong.tencentcloudapi.com |

| 亚太东南(新加坡) | lke.ap-singapore.tencentcloudapi.com |

| 亚太东南(曼谷) | lke.ap-bangkok.tencentcloudapi.com |

| 亚太南部(孟买) | lke.ap-mumbai.tencentcloudapi.com |

| 亚太东北(首尔) | lke.ap-seoul.tencentcloudapi.com |

| 亚太东北(东京) | lke.ap-tokyo.tencentcloudapi.com |

| 美国东部(弗吉尼亚) | lke.na-ashburn.tencentcloudapi.com |

| 美国西部(硅谷) | lke.na-siliconvalley.tencentcloudapi.com |

| 欧洲地区(法兰克福) | lke.eu-frankfurt.tencentcloudapi.com |

DeepSeek - R1 模型 API 专为复杂推理任务而精心设计,它就像是一位逻辑思维缜密的智者,在数学、代码生成和逻辑推理等领域展现出卓越的能力。在架构方面,它采用了稠密 Transformer 架构,这种架构能够有效地处理长上下文信息,为复杂推理任务提供了强大的支持。然而,稠密 Transformer 架构也带来了较高的计算资源消耗,就如同一位强大的运动员需要大量的能量补给一样。不过,其在推理任务上的表现堪称惊艳,在数学问题求解中,它能够凭借其强大的推理能力,准确地分析问题,找到解题思路,并给出精确的答案。例如,在解决复杂的数学证明题时,DeepSeek - R1 能够理解题目中的条件和要求,运用逻辑推理规则,逐步推导出证明过程,其准确率和效率在同类模型中表现出色。在代码生成方面,它也有着出色的表现。当开发者需要生成特定功能的代码时,只需提供相关的描述和需求,DeepSeek - R1 就能根据这些信息,生成高质量的代码片段。无论是 Python、Java 还是其他编程语言,它都能应对自如,为开发者节省了大量的时间和精力。在云原生后端开发中,DeepSeek - R1 模型 API 的应用场景主要集中在对复杂逻辑处理和深度推理有较高要求的领域。例如,在科研项目中,研究人员可以利用它来处理复杂的实验数据和模型分析,帮助他们发现数据中的规律和潜在的科学问题;在算法交易领域,它可以根据市场数据和交易策略,进行复杂的逻辑推理和决策分析,为投资者提供精准的交易建议。

| 参数名称 | 类型 | 必选 | 描述 |

|---|---|---|---|

| Action | String | 是 | HTTP 请求头:X-TC-Action。操作的接口名称。取值参考接口文档输入参数章节关于公共参数 Action 的说明。例如云服务器的查询实例列表接口,取值为 DescribeInstances。 |

| Region | String | - | HTTP 请求头:X-TC-Region。地域参数,用来标识希望操作哪个地域的数据。取值参考接口文档中输入参数章节关于公共参数 Region 的说明。注意:某些接口不需要传递该参数,接口文档中会对此特别说明,此时即使传递该参数也不会生效。 |

| Timestamp | Integer | 是 | HTTP 请求头:X-TC-Timestamp。当前 UNIX 时间戳,可记录发起 API 请求的时间。例如 1529223702。注意:如果与服务器时间相差超过5分钟,会引起签名过期错误。 |

| Version | String | 是 | HTTP 请求头:X-TC-Version。操作的 API 的版本。取值参考接口文档中入参公共参数 Version 的说明。例如云服务器的版本 2017-03-12。 |

| Authorization | String | 是 | HTTP 标准身份认证头部字段,例如: TC3-HMAC-SHA256 Credential=AKID***/Date/service/tc3_request, SignedHeaders=content-type;host, Signature=fe5f80f77d5fa3beca038a248ff027d0445342fe2855ddc963176630326f1024 其中, - TC3-HMAC-SHA256:签名方法,目前固定取该值; - Credential:签名凭证,AKID*** 是 SecretId;Date 是 UTC 标准时间的日期,取值需要和公共参数 X-TC-Timestamp 换算的 UTC 标准时间日期一致;service 为具体产品名,通常为域名前缀。例如,域名 cvm.tencentcloudapi.com 意味着产品名是 cvm。本产品取值为 lke;tc3_request 为固定字符串; - SignedHeaders:参与签名计算的头部信息,content-type 和 host 为必选头部; - Signature:签名摘要,计算过程详见 文档。 |

| Token | String | 否 | HTTP 请求头:X-TC-Token。即 安全凭证服务 所颁发的临时安全凭证中的 Token,使用时需要将 SecretId 和 SecretKey 的值替换为临时安全凭证中的 TmpSecretId 和 TmpSecretKey。使用长期密钥时不能设置此 Token 字段。 |

| Language | String | 否 | HTTP 请求头:X-TC-Language。指定接口返回的语言,仅部分接口支持此参数。取值:zh-CN,en-US。zh- |

DeepSeek - V3 模型 API 则定位为通用型大语言模型,它就像是一位多才多艺的艺术家,在自然语言处理、知识问答、内容生成等多个领域都有着出色的表现。其采用的混合专家(MoE)架构是一大创新亮点,这种架构拥有 6710 亿参数,但每次激活仅 370 亿参数,通过动态路由机制巧妙地优化了计算成本,实现了高效的计算和运行。在性能表现上,DeepSeek - V3 在知识类任务、多语言任务和编码任务中都展现出了优秀的能力。在知识问答方面,当用户提出问题时,它能够迅速理解问题的含义,从庞大的知识库中检索相关信息,并以清晰、准确的方式回答用户的问题。无论是历史、科学、文化还是其他领域的问题,它都能给出令人满意的答案。在多语言任务中,它支持多种语言之间的翻译和交互,能够实现不同语言之间的无缝切换和交流。例如,在跨国企业的客服系统中,DeepSeek - V3 可以实时地将客户的问题翻译成客服人员能够理解的语言,并将客服人员的回答翻译成客户的语言,大大提高了客服的效率和质量。在编码任务中,它能够根据代码的上下文和需求,生成准确的代码补全和建议,帮助开发者提高编码的效率和准确性。在云原生后端开发中,DeepSeek - V3 模型 API 的应用场景十分广泛。在智能客服领域,它可以作为核心的对话引擎,为用户提供高效、智能的服务。当用户咨询问题时,它能够快速理解用户的意图,提供准确的解答,并能根据用户的反馈进行多轮对话,不断优化服务质量。在内容创作方面,它可以帮助创作者生成高质量的文案、小说、新闻报道等内容。例如,在新媒体运营中,运营人员可以利用 DeepSeek - V3 生成吸引人的标题、文章内容等,提高内容的质量和传播效果。

对比两款模型 API,DeepSeek - R1 更侧重于复杂推理任务,其强大的推理能力和对长上下文的处理能力使其在科研、算法交易等领域具有独特的优势;而 DeepSeek - V3 则以其通用性和高效性在自然语言处理的多个领域发挥着重要作用,尤其是在对响应速度和多语言支持要求较高的场景中表现出色。在云原生后端开发中,开发者可以根据具体的项目需求和应用场景,灵活选择使用 DeepSeek - R1 或 V3 模型 API,或者将两者结合使用,充分发挥它们的优势,构建出功能强大、性能卓越的 AI 应用。例如,在一个综合性的电商平台中,对于商品推荐、用户行为分析等需要复杂逻辑推理的任务,可以使用 DeepSeek - R1 模型 API;而对于智能客服、商品描述生成等自然语言处理任务,则可以使用 DeepSeek - V3 模型 API。通过合理的选择和搭配,能够为电商平台提供更加智能化、个性化的服务,提升用户体验和平台的竞争力。

| 模型 | 参数量 | 上下文长度 | 最大输入长度 | 最大输出长度 |

| DeepSeek-R1 | 671B | 64k | 56k | 8k(不含思维链长度) |

| DeepSeek-V3 | 671B | 64k | 56k | 8k(不含思维链长度) |

代码实战:基于腾讯云大模型 API 构建云原生后端服务

前期准备工作

在开启基于腾讯云大模型 API 构建云原生后端服务的精彩旅程之前,我们首先要精心做好一系列的前期准备工作,这就如同建造高楼大厦前的打地基,是确保后续开发顺利进行的关键。

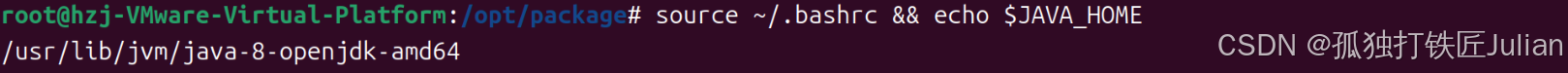

Python 作为一种简洁、高效且拥有丰富库资源的编程语言,在云原生后端开发中占据着重要的地位。我们需要确保 Python 已经成功安装在我们的开发环境中。如果你还没有安装 Python,可以前往 Python 官方网站(https://www.python.org/downloads/),根据你的操作系统版本下载对应的安装包进行安装。在安装过程中,记得勾选 “Add Python to PATH” 选项,这样可以将 Python 添加到系统环境变量中,方便后续在命令行中使用 Python 命令。

安装好 Python 后,接下来要安装相关的依赖库。这些依赖库就像是搭建房屋所需的各种建筑材料,为我们的开发提供了强大的支持。我们可以使用 pip,Python 的包管理工具,来安装这些依赖库。在命令行中输入以下命令,即可安装我们项目所需的依赖库:

pip install fastapi uvicorn requests tencentcloud-sdk-python-common tencentcloud-sdk-python-lkeap其中,fastapi是一个现代、快速(高性能)的 Web 框架,用于构建 API,它基于标准 Python 类型提示,支持异步编程,能够帮助我们快速搭建出高效的后端服务;uvicorn是一个轻量级的 ASGI 服务器,用于运行我们的 FastAPI 应用;requests库则用于发送 HTTP 请求,在我们调用腾讯云大模型 API 时发挥着重要作用;tencentcloud-sdk-python-common和tencentcloud-sdk-python-lkeap是腾讯云的 Python SDK,提供了与腾讯云服务交互的接口,方便我们接入腾讯云大模型知识引擎。

此外,我们还需要注册腾讯云账号并获取 API 密钥。腾讯云账号是我们使用腾讯云服务的通行证,而 API 密钥则是我们调用腾讯云大模型 API 的身份凭证。前往腾讯云官网(https://cloud.tencent.com/),按照注册流程完成账号注册。注册成功后,登录腾讯云控制台,在 “访问管理” - “API 密钥管理” 中,点击 “新建密钥”,妥善保管好生成的 API 密钥,这将是我们后续调用 API 的重要依据,千万不要泄露给他人哦。

项目初始化与框架搭建

选择后端框架

在众多的后端框架中,FastAPI 脱颖而出,成为我们构建云原生后端服务的首选框架。FastAPI 就像是一位高效的建筑师,以其卓越的性能、简洁的设计和强大的功能,为我们打造出坚固、灵活且易于维护的后端架构。

FastAPI 的高性能源于其基于 Python 的类型提示和异步编程特性。它能够充分利用 Python 的优势,实现高效的请求处理和响应返回,大大提高了应用的性能和响应速度。例如,在处理高并发请求时,FastAPI 的异步编程能力可以让多个请求同时处理,而不会相互阻塞,从而显著提升应用的吞吐量。

同时,FastAPI 的设计理念简洁明了,易于上手。它采用了直观的路由系统和依赖注入机制,使得代码结构清晰,易于理解和维护。例如,定义一个 API 路由,只需要使用简单的装饰器语法,就可以轻松实现:

from fastapi import FastAPIapp = FastAPI()@app.get("/")

def read_root():return {"Hello": "World"}在这个例子中,我们使用@app.get装饰器定义了一个根路径(“/”)的 GET 请求处理函数read_root,当客户端访问根路径时,将返回 “Hello, World” 的响应。这种简洁的语法和清晰的结构,使得开发人员能够快速上手,提高开发效率。

而且,FastAPI 还具有丰富的功能和强大的扩展性。它支持自动生成 API 文档,方便我们进行接口测试和文档管理;同时,它还可以与各种数据库、中间件和云服务进行集成,满足不同项目的需求。例如,我们可以使用 FastAPI 与数据库进行交互,实现数据的存储和查询功能;也可以将 FastAPI 与 Kubernetes 等容器编排工具结合,实现应用的自动化部署和管理。

创建 FastAPI 项目并展示基本结构

接下来,我们就开始创建 FastAPI 项目。在命令行中,切换到你希望创建项目的目录,然后执行以下命令:

mkdir my_fastapi_project

cd my_fastapi_project这两条命令分别用于创建一个名为my_fastapi_project的项目目录,并进入该目录。接下来,我们创建项目的基本文件结构。在项目目录下,创建一个名为app的文件夹,用于存放我们的应用代码。在app文件夹中,创建一个__init__.py文件,这个文件可以为空,它的作用是告诉 Python 这个文件夹是一个 Python 包。然后,再创建一个main.py文件,这是我们项目的主文件,用于定义 FastAPI 应用和路由。

mkdir app

touch app/__init__.py

touch app/main.py此时,我们的项目基本结构如下:

my_fastapi_project

└── app├── __init__.py└── main.py在main.py文件中,我们编写以下代码,创建一个简单的 FastAPI 应用:

from fastapi import FastAPIapp = FastAPI()@app.get("/")

def read_root():return {"Hello": "World"}这段代码创建了一个 FastAPI 应用实例app,并定义了一个根路径(“/”)的 GET 请求处理函数read_root,当客户端访问根路径时,将返回 “Hello, World” 的响应。

配置项目依赖

为了更好地管理项目依赖,我们使用requirements.txt文件。在项目根目录下,创建一个requirements.txt文件,然后将我们之前安装的依赖库及其版本信息添加到这个文件中。可以使用以下命令自动生成requirements.txt文件:

pip freeze > requirements.txt这个命令会将当前环境中安装的所有依赖库及其版本信息输出到requirements.txt文件中。打开requirements.txt文件,你会看到类似以下的内容:

这些版本号可能会因为你安装的时间和环境不同而有所差异。当我们在其他环境中部署项目时,只需要在项目目录下执行以下命令,就可以安装项目所需的所有依赖库:

pip install -r requirements.txt这样,通过requirements.txt文件,我们可以方便地管理项目依赖,确保在不同环境中项目的一致性和可重复性。

接入腾讯云 DeepSeek API

编写 API 调用函数

现在,我们开始编写调用腾讯云 DeepSeek API 的函数,这就像是搭建一座通往智能世界的桥梁,让我们的应用能够与强大的大模型进行交互。

首先,在app文件夹中,创建一个新的文件api_calls.py,用于存放 API 调用相关的代码。在api_calls.py文件中,编写以下代码:

import json

import requests

from tencentcloud.common import credential

from tencentcloud.common.exception.tencent_cloud_sdk_exception import TencentCloudSDKException

from tencentcloud.common.profile.client_profile import ClientProfile

from tencentcloud.common.profile.http_profile import HttpProfile

from tencentcloud.lkeap.v20240522 import lkeap_client, modelsdef call_deepseek_api(model, messages, stream=False):try:# 实例化一个认证对象,入参需要传入腾讯云账户 SecretId 和 SecretKeycred = credential.Credential("your_secret_id", "your_secret_key")httpProfile = HttpProfile()httpProfile.endpoint = "lkeap.tencentcloudapi.com"clientProfile = ClientProfile()clientProfile.httpProfile = httpProfileclient = lkeap_client.LkeapClient(cred, "ap-guangzhou", clientProfile)req = models.ChatCompletionsRequest()params = {"Model": model,"Messages": messages,"Stream": stream}req.from_json_string(json.dumps(params))resp = client.ChatCompletions(req)return resp.to_json_string()except TencentCloudSDKException as err:print(err)return None

在这段代码中,我们定义了一个call_deepseek_api函数,它接受三个参数:model表示要使用的模型名称(如deepseek-r1或deepseek-v3),messages是聊天上下文信息,stream表示是否启用流式输出。函数内部首先实例化一个腾讯云认证对象cred,并配置了 HTTP 请求的相关参数,然后创建了LkeapClient客户端实例。接着,构建了 API 请求参数,创建了ChatCompletionsRequest请求对象,并将参数传递给请求对象。最后,调用client.ChatCompletions(req)方法发送请求,并返回响应结果。如果在调用过程中出现异常,会打印异常信息并返回None。

参数设置与优化

在调用腾讯云 DeepSeek API 时,合理设置参数对于提高性能和获得准确的结果至关重要。

model参数用于指定要使用的模型,根据实际需求选择deepseek-r1或deepseek-v3。如前所述,deepseek-r1适用于复杂推理任务,而deepseek-v3是通用型大语言模型,在自然语言处理的多个领域都有出色表现。

prompt参数(在上述代码中以messages形式体现)是发送给模型的输入提示,它直接影响模型的回答。编写清晰、明确且具体的prompt能够引导模型给出更符合预期的回答。例如,在智能问答场景中,如果用户提问 “如何提高写作能力?”,我们可以将prompt设置为:

messages = [{"role": "user", "content": "如何提高写作能力?"}

]这样,模型就能根据这个prompt进行分析和回答。

max_tokens参数用于限制模型生成的最大令牌数,它决定了回答的长度。如果设置过小,可能导致回答不完整;如果设置过大,不仅会增加响应时间,还可能生成冗长无用的内容。一般来说,可以根据具体需求和应用场景来调整这个参数。例如,在短文本回答场景中,可以将max_tokens设置为 100 - 200;而在长文本生成场景中,可以适当增大这个值,如 500 - 1000。

temperature参数控制模型输出的随机性,取值范围通常在 0 - 1 之间。较低的temperature值(接近 0)会使模型的回答更加确定性和保守,适合需要精确答案的场景;较高的temperature值(接近 1)会使模型的回答更加随机和富有创造性,适合需要生成多样化内容的场景。例如,在生成创意写作、故事创作等内容时,可以将temperature设置为 0.7 - 0.9;而在问答、事实陈述等场景中,可以将temperature设置为 0.3 - 0.5。

通过合理设置这些参数,并根据实际应用场景进行优化,我们能够充分发挥腾讯云 DeepSeek API 的优势,为用户提供更加优质、高效的服务。

实现云原生后端服务核心功能

智能问答功能

智能问答功能是我们云原生后端服务的核心亮点之一,它让我们的应用能够像一位知识渊博的导师,随时为用户解答各种问题。

在app/main.py文件中,引入api_calls.py中定义的call_deepseek_api函数,并编写智能问答的路由处理函数:

from fastapi import FastAPI

from app.api_calls import call_deepseek_apiapp = FastAPI()@app.post("/question_answer")

async def question_answer(question: str):model = "deepseek-v3" # 选择模型messages = [{"role": "user", "content": question}]response = call_deepseek_api(model, messages)if response:response_data = json.loads(response)answer = response_data["Choices"][0]["Message"]["Content"]return {"question": question, "answer": answer}else:return {"question": question, "answer": "抱歉,无法回答您的问题"}

在这段代码中,我们定义了一个/question_answer的 POST 请求路由,当客户端发送一个包含问题的 POST 请求时,函数会首先选择使用deepseek-v3模型(可根据实际需求切换),然后构建包含用户问题的messages列表。接着,调用call_deepseek_api函数向腾讯云 DeepSeek API 发送请求,并获取响应。如果响应成功,解析响应数据,提取出回答内容并返回给客户端;如果响应失败,返回一个错误提示。

文档解析与信息抽取

文档解析与信息抽取功能能够帮助我们从各种文档中提取出有价值的信息,为后续的业务处理提供支持。

假设我们已经将文档解析 API 的调用封装在app/api_calls.py文件中的parse_document函数中,以下是在app/main.py中使用该函数实现文档解析与信息抽取的示例:

from fastapi import FastAPI, File, UploadFile

from app.api_calls import parse_documentapp = FastAPI()@app.post("/document_parse")

async def document_parse(file: UploadFile = File(...)):contents = await file.read()response = parse_document(contents)if response:# 这里可以根据实际需求对解析结果进行处理,例如存储到数据库或进行进一步分析return {"filename": file.filename, "parsed_data": response}else:return {"filename": file.filename, "parsed_data": "文档解析失败"}

在这个示例中,我们定义了一个/document_parse的 POST 请求路由,客户端可以通过该路由上传文件。函数首先读取上传文件的内容,然后调用parse_document函数对文档进行解析。如果解析成功,返回包含文件名和解析数据的响应;如果解析失败,返回错误提示。

与其他云原生组件集成

将我们开发的后端服务与 Kubernetes、容器化技术集成,可以实现服务的自动化部署和管理,充分发挥云原生的优势。

首先,我们需要将 FastAPI 应用容器化。在项目根目录下,创建一个Dockerfile文件,内容如下:

# 使用官方的Python 3.10基础镜像

FROM python:3.10# 设置工作目录

WORKDIR /app# 将当前目录下的所有文件复制到容器的/app目录下

COPY. /app# 安装应用所需的依赖项

RUN pip install -r requirements.txt# 暴露应用运行的端口

EXPOSE 8000# 定义容器启动时要运行的命令

CMD ["uvicorn", "app.main:app", "--host", "0.0.0.0", "--port", "8000"]

这个Dockerfile定义了如何构建我们的 FastAPI 应用的 Docker 镜像。它首先使用官方的 Python 3.10 基础镜像,然后设置工作目录,将项目文件复制到容器中,安装依赖项,暴露应用运行的端口,并定义了容器启动时要运行的命令。

接下来,我们使用 Kubernetes 进行容器编排和部署。在项目根目录下,创建一个deployment.yaml文件,内容如下:

apiVersion: apps/v1

kind: Deployment

metadata:name: my-fastapi-app

spec:replicas: 3selector:matchLabels:app: my-fastapi-apptemplate:metadata:labels:app: my-fastapi-appspec:containers:- name: my-fastapi-containerimage: my-fastapi-app:latestports:- containerPort: 8000

这个deployment.yaml文件定义了一个 Kubernetes Deployment,它创建 3 个副本的 Pod,每个 Pod 运行我们的 FastAPI 应用容器。通过 Kubernetes,我们可以轻松地实现服务的自动化部署、扩展和管理。例如,当我们需要增加服务的容量时,只需要修改replicas字段的值,Kubernetes 会自动创建或删除相应数量的 Pod,以满足我们的需求。

总结与展望

在本次探索云原生后端与腾讯云大模型 API 融合的旅程中,我们深入了解了云原生后端开发的核心技术,包括微服务架构、容器化技术、服务发现与配置管理以及 Kubernetes 编排等,这些技术共同构成了云原生后端的坚实基础,为构建高效、灵活且可扩展的应用提供了强大的支持。

同时,我们也全面认识了腾讯云大模型知识引擎及其 DeepSeek - R1、V3 两款模型 API 的独特魅力。腾讯云大模型知识引擎凭借其多轮对话、文档解析、拆分和 embedding 等强大功能,为云原生后端开发注入了智能的力量;DeepSeek - R1 在复杂推理任务中表现卓越,而 DeepSeek - V3 则在通用自然语言处理任务中展现出优秀的能力,它们为开发者提供了丰富的选择,能够满足不同场景下的应用需求。

通过实际的代码实战,我们成功地基于腾讯云大模型 API 构建了云原生后端服务,实现了智能问答、文档解析与信息抽取等核心功能,并将其与其他云原生组件进行了集成。在这个过程中,我们不仅掌握了如何调用腾讯云大模型 API,还学会了如何优化 API 调用参数,以获得更好的性能和结果。同时,我们也通过引入缓存机制、异步处理和负载均衡等策略,对后端服务进行了性能优化,提高了服务的响应速度和可用性。

同时,云原生技术也将不断发展,为大模型的应用提供更加稳定、高效的运行环境。例如,Kubernetes 将进一步完善其功能,实现更加智能化的容器编排和管理;服务网格将提供更加精细的服务治理能力,保障微服务之间的通信安全和高效。

总之,云原生后端与大模型技术的融合是技术发展的必然趋势,将为各行各业带来更多的创新和变革。作为开发者,我们应紧跟技术发展的步伐,不断学习和探索,充分发挥云原生后端与大模型技术的优势,为用户提供更加优质、智能的服务。

![[入门]NUC13配置Ubuntu20.04详细步骤](https://i-blog.csdnimg.cn/img_convert/178b27b88e91f658fdb24c909f9cf0d1.png)