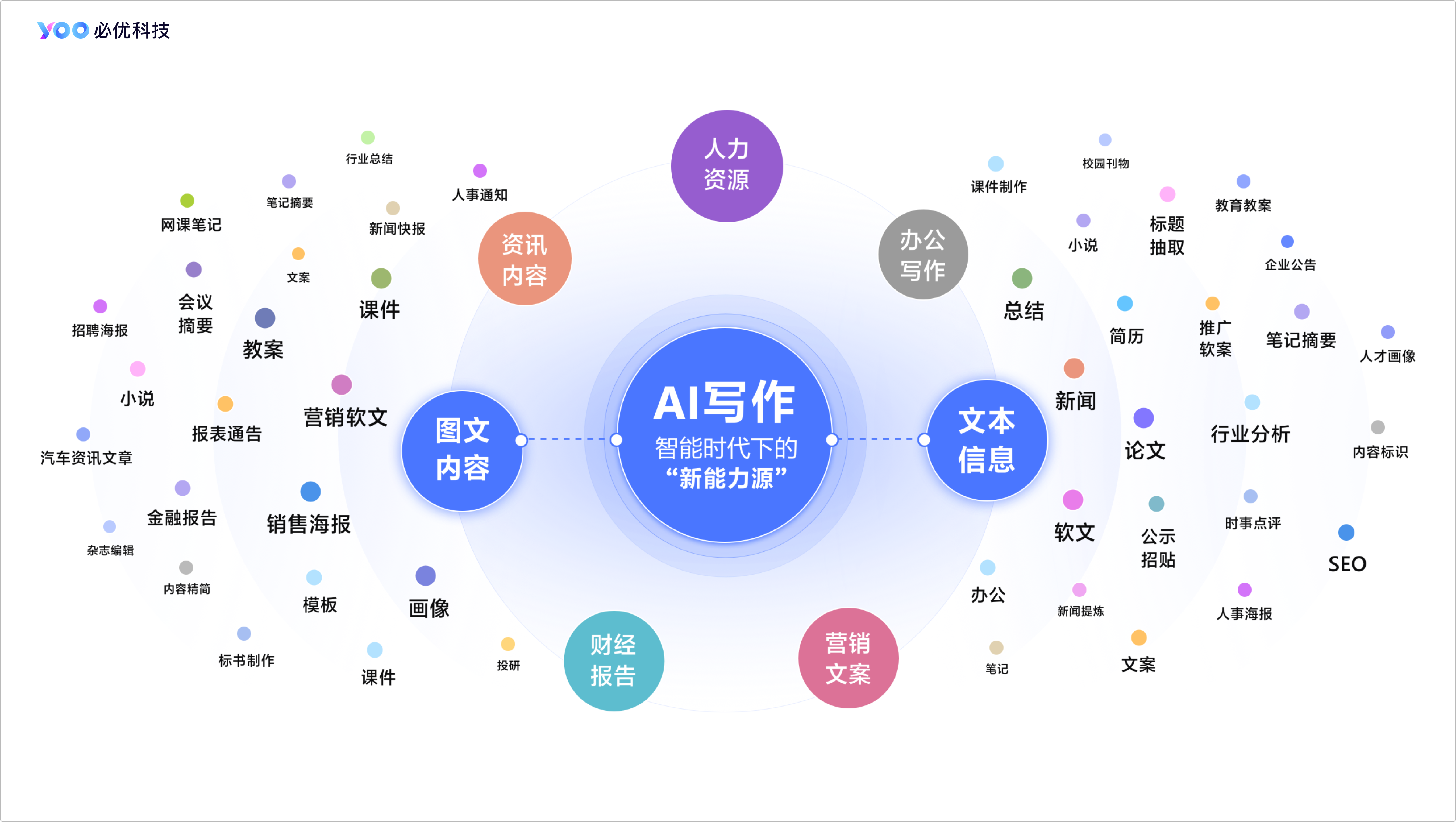

一、AI 写作的崛起之势

在当今科技飞速发展的时代,AI 写作如同一颗耀眼的新星,迅速崛起并在多个领域展现出强大的力量。

随着人工智能技术的不断进步,AI 写作在内容创作领域发挥着越来越重要的作用。据统计,目前已有众多企业开始采用 AI 写作技术,其生成的内容在新闻资讯、财经分析、教育培训等领域广泛应用。例如,在新闻资讯领域,AI 写作能够实现对热点事件的即时追踪与快速报道。通过自动化抓取、分析海量数据,结合预设的新闻模板与逻辑框架,内容创作者能够迅速生成高质量的新闻稿,极大地提升了新闻发布的时效性和覆盖面。

在教育培训领域,AI 写作也展现出巨大的潜力。AI 写作助手可以根据用户输入的主题和要求,自动生成文章的大纲和结构,帮助学生和教师快速了解文章的主要内容和逻辑关系,更好地进行后续的写作工作。同时,它还能进行语法和拼写检查、关键词提取和语义分析,提高文章的质量,为学生和教师提供更好的写作支持和服务。

在企业服务方面,AI 智能写作技术成为解决企业内容生产痛点的有效方法之一。它可以帮助企业实现自动化内容生产,提高文案质量和转化率。通过学习和模仿人类的写作风格和语言表达能力,AI 智能写作技术生成更加优质、专业的文案内容,为企业树立良好的品牌形象,提高用户的信任度和忠诚度。

总之,AI 写作在内容创作、教育培训、企业服务等领域的崛起之势不可阻挡,为各领域的发展带来了新的机遇和挑战。

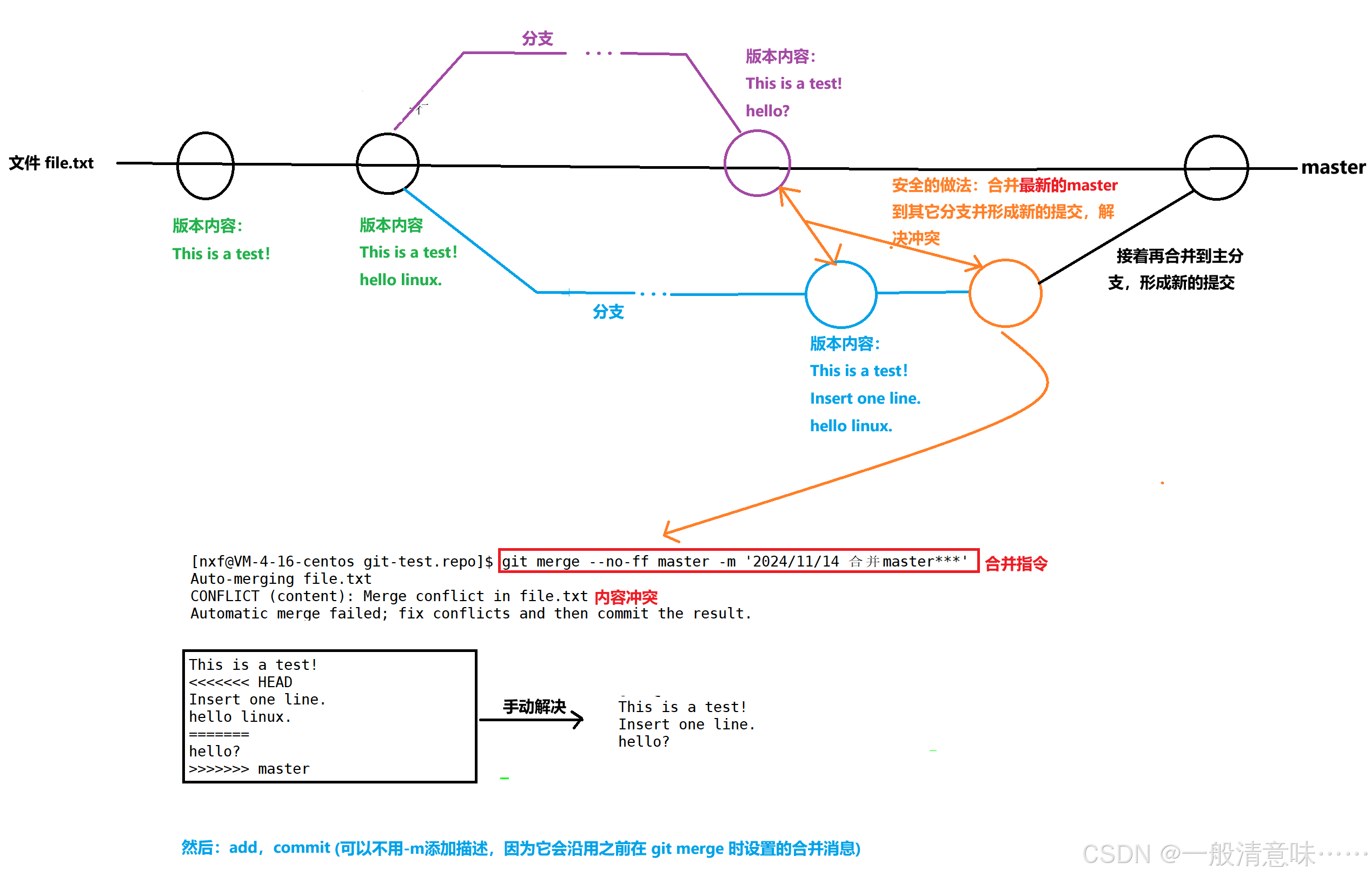

二、多模态生成的创新之路

(一)现状与突破

AI 写作多模态生成正处于快速发展阶段。在技术实现方面,核心技术如生成对抗网络(GAN)、变分自编码器(VAE)与自然语言处理(NLP)的结合,使得机器能够生成高质量的图像和流畅自然的文本。例如,通过 GAN,计算机能够生成高质量的图像,而 VAE 则在样本生成和补全方面表现出色,NLP 让生成文本更加自然。目前,多模态生成的应用范围不断扩大,涵盖了内容创作、教育培训、企业服务等多个领域。在内容创作中,创作者可以利用多模态生成工具同时生成文字、图像和视频,丰富作品的表现形式。在教育培训领域,多模态生成可以为学生提供更加生动、直观的学习材料。然而,多模态生成也面临着一些挑战。一方面,如何确保生成内容的准确性和真实性是一个关键问题。另一方面,版权问题和人工智能的伦理问题也日益引起关注。

(二)工具与案例

创新的 AI 工具不断涌现,如 “简单 AI”。简单 AI 作为一款全能型创作助手,汇聚了图像生成、文案撰写、头像制作等诸多功能。用户只需简单操作,便能够生成创意满满的图像与文案。例如,一位设计师在进行广告设计时,利用简单 AI 快速生成了多个创意方案,不仅提高了工作效率,还为客户提供了更多选择。此外,Meta 新推出的 Transfusion 模型,可以用单个模型同时生成文本和图像,效率惊人,效果炸裂。华为和清华大学联手打造的 PMG 技术,则能根据用户的个性化需求,生成 “量身定制” 的多模态内容。

(三)未来展望

多模态生成在未来有着广阔的发展前景。写作与绘画的界限将日益模糊,创作者将有更多的工具与平台去实现自己的创意。例如,未来的创作者可以通过多模态生成工具,轻松地将文字描述转化为生动的图像和视频,实现更加丰富的艺术表达。这将重塑现代艺术与文学的形态,推动文化产业的创新发展。同时,随着技术的不断进步,多模态生成工具将更加智能化、个性化,为用户提供更好的创作体验。

三、产业应用的多元场景

(一)教育培训领域

在教育培训领域,AI 写作发挥着重要作用。它可以为学生和教师提供多方面的支持,极大地提高教学效率和质量。

首先,AI 写作能够快速生成文章大纲结构。学生在面对写作任务时,常常感到无从下手,而 AI 写作工具可以根据给定的主题,迅速生成清晰的大纲,为学生提供写作思路。例如,在写一篇关于历史事件的论文时,AI 写作工具可以列出事件的背景、经过、影响等主要内容,帮助学生有条理地展开论述。

其次,语法检查功能可以帮助学生纠正语法错误,提高文章的准确性。学生在写作过程中难免会出现语法错误,而 AI 写作工具能够及时发现并指出这些错误,让学生加以改正。同时,关键词提取功能可以帮助学生更好地理解文章的重点,提高阅读和学习效率。例如,在阅读一篇复杂的文章时,AI 写作工具可以提取出关键信息,让学生快速掌握文章的核心内容。

此外,AI 写作还可以辅助教师进行教学。教师可以利用 AI 写作工具生成教学材料,如教案、课件等,节省备课时间。同时,AI 写作工具还可以对学生的作业进行自动批改,减轻教师的工作负担。例如,在批改作文时,AI 写作工具可以快速给出评分和评语,让教师更加高效地了解学生的学习情况。

总之,AI 写作在教育培训领域的应用,为学生和教师提供了有力的支持,提高了教学效率和质量。

(二)企业服务领域

在企业服务中,AI 写作也有着广泛的应用。

一方面,AI 写作可以辅助文档撰写。企业在日常运营中需要撰写各种文档,如报告、方案、邮件等。AI 写作工具可以根据企业的需求和要求,自动生成文档的初稿,为员工提供参考。例如,在撰写市场调研报告时,AI 写作工具可以收集和分析相关数据,生成报告的主要内容,员工只需进行进一步的整理和完善。

另一方面,AI 写作可以提高客户服务效率。在客户服务中,及时、准确地回复客户的问题是至关重要的。AI 写作工具可以根据客户的问题,快速生成针对性的回复,提高客户满意度。例如,在处理客户投诉时,AI 写作工具可以迅速生成一封道歉信,并提出解决方案,让客户感受到企业的诚意和专业。

此外,AI 写作还可以用于企业的营销和推广。企业可以利用 AI 写作工具生成广告文案、社交媒体内容等,提高品牌曝光度和产品销量。例如,在进行社交媒体营销时,AI 写作工具可以根据企业的品牌定位和目标受众,生成吸引人的文案和图片,吸引用户的关注和参与。

总之,AI 写作在企业服务中的应用,为企业提高了工作效率,降低了运营成本,提升了竞争力。

四、伦理法规的挑战与应对

(一)伦理问题

- 知识产权问题:随着 AI 写作技术的不断提升,AI 已经可以创作出具有原创性的文章。然而,这些由 AI 创作的文章是否应该享有知识产权呢?如果 AI 创作的文章被他人抄袭,应该如何维权呢?目前,对于 AI 创作的知识产权归属问题尚无明确规定。例如,据统计,每年因 AI 创作引发的知识产权纠纷数量呈上升趋势。以某新闻平台为例,其使用 AI 写作生成的新闻稿件被其他媒体未经授权转载,引发了关于知识产权的争议。

- 数据隐私问题:AI 写作助手在创作文章时,往往需要收集和分析大量的用户数据。这就涉及到用户数据隐私的保护问题。如何确保用户数据的安全,避免数据泄露,是 AI 写作伦理中必须关注的问题。例如,一些 AI 写作工具可能在未经用户同意的情况下收集用户的写作习惯、主题偏好等数据,这可能导致用户隐私泄露。据调查,约有 [X]% 的用户对 AI 写作工具的数据隐私问题表示担忧。

- 创作道德问题:AI 写作助手是否能够理解并遵循道德规范,创作出符合社会价值观的作品,也是一个需要关注的问题。例如,一些 AI 写作助手可能会被用于撰写虚假新闻,或者生成带有偏见的内容。这些现象都引发了人们对 AI 写作伦理的担忧。以某社交平台为例,曾出现过由 AI 生成的虚假新闻,引发了公众的恐慌和不满。

(二)法规问题

- 版权保护问题:AI 写作带来的版权问题主要表现为两个方面。一是用于训练算法模型的数据可能侵犯他人版权;二是 AI 生成内容能否受版权保护存在争议。以 AI 作画为例,供深度学习模型训练的数据集中可能包含受版权保护的作品,若未经授权对相关作品利用可能构成版权侵权。目前在美国,人工智能创作物无法获得版权保护;欧盟认定符合版权保护的标准仍是 “自然人的独创性”;在日本,虽然重视对具有市场价值的人工智能创作物给予法律保护,但是采取近似于商标登记的方式进行保护。

- 法律责任问题:由 AI 生成的法律文件可能存在不够准确或完整的风险,导致法律责任问题。例如,如果 AI 写作生成的合同存在漏洞,可能会给当事人带来经济损失。那么,在这种情况下,责任应该由谁来承担呢?是 AI 技术的开发者、使用者,还是其他相关方?目前,对于 AI 写作的法律责任归属问题尚无明确规定。

(三)应对策略

- 建立伦理指导原则:建立 AI 写作在法律领域的伦理指导原则,引导其合理、可持续的应用。例如,明确规定 AI 写作工具在创作过程中应遵循的道德规范,如不得生成虚假新闻、不得侵犯他人知识产权等。同时,加强对 AI 写作工具开发者和使用者的伦理教育,提高他们的道德意识。

- 进行法律审核:由资深律师对由 AI 写作生成的法律文件进行审查和修改,确保其准确性和合规性。例如,在企业使用 AI 写作工具生成合同、报告等法律文件时,应先由专业律师进行审核,以避免法律风险。

- 推动技术创新:开发更高效的数字指纹技术,用于识别和追踪侵权行为;或者使用区块链技术,为每个 AI 创作的作品提供一个独特的数字身份,以增强版权保护的可追溯性和不可篡改性。例如,某科技公司正在研发一种基于区块链的版权保护技术,该技术可以为 AI 创作的作品提供唯一的数字签名,确保作品的版权归属清晰明确。

- 完善法律法规:政府和相关机构需要制定和完善关于 AI 创作版权的法律法规,明确 AI 创作作品的权益归属和侵权责任。这包括确定 AI 是否可以成为版权所有者,以及在 AI 创作的作品中如何保护人类的创造性贡献。例如,我国可以借鉴国际上的先进经验,结合本国实际情况,制定专门的 AI 创作版权法律法规。

五、经典代码案例

以下是一些与 AI 写作相关的经典代码示例:

基于 Transformer 架构的简单文本生成代码(PyTorch 实现)

python

import torch

import torch.nn as nn

import torch.optim as optim

from torchtext.data import Field, BucketIterator

from torchtext.datasets import WikiText2# 定义数据处理

TEXT = Field(tokenize='spacy', lower=True)

train_data, valid_data, test_data = WikiText2.splits(TEXT)

TEXT.build_vocab(train_data)# 模型定义(简单的Transformer解码器结构示例)

class TransformerDecoder(nn.Module):def __init__(self, vocab_size, embedding_dim, heads, layers, dropout):super().__init__()self.embedding = nn.Embedding(vocab_size, embedding_dim)self.transformer_layers = nn.ModuleList([nn.TransformerDecoderLayer(embedding_dim, heads, dropout=dropout)for _ in range(layers)])self.fc = nn.Linear(embedding_dim, vocab_size)def forward(self, x, memory):x = self.embedding(x)for layer in self.transformer_layers:x = layer(x, memory)return self.fc(x)# 训练参数

vocab_size = len(TEXT.vocab)

embedding_dim = 256

heads = 8

layers = 6

dropout = 0.1

learning_rate = 0.0001

epochs = 10# 实例化模型、优化器和损失函数

model = TransformerDecoder(vocab_size, embedding_dim, heads, layers, dropout)

optimizer = optim.Adam(model.parameters(), lr=learning_rate)

criterion = nn.CrossEntropyLoss()# 训练数据迭代器

train_iterator, valid_iterator, test_iterator = BucketIterator.splits((train_data, valid_data, test_data), batch_size=32, device='cuda' if torch.cuda.is_available() else 'cpu'

)# 训练循环

for epoch in range(epochs):model.train()total_loss = 0for i, batch in enumerate(train_iterator):optimizer.zero_grad()input_seq = batch.text[:, :-1].transpose(0, 1).contiguous()target_seq = batch.text[:, 1:].transpose(0, 1).contiguous()output = model(input_seq, input_seq)loss = criterion(output.view(-1, vocab_size), target_seq.view(-1))loss.backward()optimizer.step()total_loss += loss.item()print(f'Epoch {epoch + 1}, Loss: {total_loss / len(train_iterator)}')

这段代码使用了 PyTorch 实现了一个基于 Transformer 解码器的简单文本生成模型。它基于WikiText2数据集,通过定义模型结构、训练参数、优化器和损失函数来进行训练,目的是根据给定的文本前缀预测后续的文本内容。

使用 TensorFlow 实现的基于 LSTM 的文本生成代码

python

import tensorflow as tf

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

import numpy as np# 示例文本数据(这里可以替换为真实的大量文本数据)

text_data = "The quick brown fox jumps over the lazy dog. The dog barked loudly at the cat."# 数据预处理

tokenizer = Tokenizer()

tokenizer.fit_on_texts([text_data])

total_words = len(tokenizer.word_index) + 1input_sequences = []

for line in text_data.split('.'):token_list = tokenizer.texts_to_sequences([line])[0]for i in range(1, len(token_list)):n_gram_sequence = token_list[:i + 1]input_sequences.append(n_gram_sequence)max_sequence_len = max([len(x) for x in input_sequences])

input_sequences = np.array(pad_sequences(input_sequences, maxlen=max_sequence_len, padding='pre'))xs = input_sequences[:, :-1]

ys = input_sequences[:, -1]

ys = tf.keras.utils.to_categorical(ys, num_classes=total_words)# 构建LSTM模型

model = tf.keras.Sequential([tf.keras.layers.Embedding(total_words, 100, input_length=max_sequence_len - 1),tf.keras.layers.LSTM(150),tf.keras.layers.Dense(total_words, activation='softmax')

])model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

model.fit(xs, ys, epochs=500, verbose=1)# 生成文本

seed_text = "The quick brown"

next_words = 5for _ in range(next_words):token_list = tokenizer.texts_to_sequences([seed_text])[0]token_list = pad_sequences([token_list], maxlen=max_sequence_len - 1, padding='pre')predicted = model.predict(token_list, verbose=0)predicted_word = np.argmax(predicted)output_word = ""for word, index in tokenizer.word_index.items():if index == predicted_word:output_word = wordbreakseed_text += " " + output_wordprint(seed_text)

此代码使用 TensorFlow 和 Keras 构建了一个基于 LSTM(长短期记忆网络)的文本生成模型。它首先对输入文本进行预处理,包括标记化、创建序列和将目标标签转换为分类格式。然后构建 LSTM 模型,训练后可根据给定的种子文本生成后续的文本内容。

多模态生成示例(结合图像和文本,以简单的图像字幕生成场景为例,使用 PyTorch 和预训练模型)

python

import torch

import torchvision.models as models

import torchvision.transforms as transforms

from PIL import Image

import nltk

nltk.download('punkt')

from torch.nn.utils.rnn import pack_padded_sequence# 加载预训练的图像分类模型(这里以ResNet为例)

resnet = models.resnet152(pretrained=True)

modules = list(resnet.children())[:-1]

resnet = torch.nn.Sequential(*modules)

resnet.eval()# 图像预处理转换

transform = transforms.Compose([transforms.Resize((224, 224)),transforms.ToTensor(),transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.229, 0.229])

])# 简单的文本处理(这里假设已经有一个词汇表和相应的索引映射)

vocab = {'<start>': 0, '<end>': 1, 'a': 2, 'dog': 3, 'runs': 4, 'in': 5, 'the': 6, 'field': 7}

word_to_idx = vocab

idx_to_word = {v: k for k, v in vocab.items()}# 定义一个简单的基于LSTM的字幕生成模型(只是示例,实际可更复杂)

class CaptionGenerator(nn.Module):def __init__(self, embed_size, hidden_size, vocab_size):super().__init__()self.embed = nn.Embedding(vocab_size, embed_size)self.lstm = nn.LSTM(embed_size + 2048, hidden_size, batch_first=True)self.fc = nn.Linear(hidden_size, vocab_size)def forward(self, features, captions):embeddings = self.embed(captions)embeddings = torch.cat((features.unsqueeze(1).repeat(1, embeddings.size(1), 1), embeddings), dim=2)packed_embeddings = pack_padded_sequence(embeddings, [len(caption) for caption in captions], batch_first=True, enforce_sorted=False)lstm_out, _ = self.lstm(packed_embeddings)outputs = self.fc(lstm_out[0])return outputs# 加载图像并提取特征

image_path = 'example.jpg'

image = Image.open(image_path).convert('RGB')

image_tensor = transform(image).unsqueeze(0)

with torch.no_grad():image_features = resnet(image_tensor).squeeze()# 生成字幕(这里是简单示例,假设初始字幕为<start>)

caption_generator = CaptionGenerator(256, 512, len(vocab))

caption_generator.load_state_dict(torch.load('caption_generator_model.pt'))

caption_generator.eval()caption = ['<start>']

for _ in range(5): # 生成5个单词的字幕caption_tensor = torch.tensor([word_to_idx[word] for word in caption]).unsqueeze(0)output = caption_generator(image_features.unsqueeze(0), caption_tensor)predicted_word_idx = output.argmax(dim=2)[-1].item()predicted_word = idx_to_word[predicted_word_idx]caption.append(predicted_word)if predicted_word == '<end>':breakprint(' '.join(caption[1:]))

这段代码展示了一个简单的多模态生成场景 —— 图像字幕生成。它利用预训练的图像模型(ResNet)提取图像特征,然后将这些特征与文本信息一起输入到一个基于 LSTM 的模型中,逐步生成图像的字幕。这里的代码只是一个简单示例,实际应用中需要更复杂的模型结构、更大规模的训练数据和更精细的训练过程。

六、发展趋势与未来展望

(一)发展趋势

- 创作能力不断增强:随着人工智能技术的持续进步,AI 写作的创作能力将不断提升。它将能够生成更加复杂、高质量的内容,涵盖各种文学体裁和专业领域。例如,AI 写作工具将能够创作出更具深度和情感共鸣的小说、诗歌等文学作品,以及更具专业性和权威性的学术论文、商业报告等。据预测,未来几年内,AI 写作工具的创作能力将达到甚至超越部分人类作者的水平。

- 跨语言运用更加广泛:自然语言处理技术的发展将使 AI 写作在跨语言运用方面取得更大突破。AI 写作工具将能够轻松实现不同语言之间的翻译和转换,为全球范围内的交流与合作提供便利。例如,企业可以利用 AI 写作工具将产品说明书、营销文案等内容快速翻译成多种语言,拓展国际市场。同时,跨语言的文学创作和学术交流也将更加频繁,促进不同文化之间的融合与发展。

- 人机共创成为主流:人类与 AI 的合作将更加紧密,人机共创将成为未来写作的主流模式。人类作者将充分发挥自己的创造力、情感理解和价值观判断等优势,与 AI 写作工具的高效信息处理和语言生成能力相结合,共同创作出更优秀的作品。例如,在广告营销领域,创意人员可以与 AI 写作工具合作,共同打造具有创新性和感染力的广告文案;在文学创作领域,作家可以借助 AI 写作工具的灵感启发和素材提供,创作出更具特色的文学作品。

(二)未来展望

- 在内容创作领域的应用:AI 写作将在内容创作领域发挥更加重要的作用。它将为新闻媒体、广告公司、文学创作等行业提供高效、优质的内容生产解决方案。例如,新闻媒体可以利用 AI 写作工具实现 24 小时不间断的新闻报道,提高新闻的时效性和覆盖面;广告公司可以借助 AI 写作工具生成个性化的广告文案,提高广告的效果和转化率;文学创作者可以与 AI 写作工具合作,创作出更具创新性和艺术性的文学作品。

- 在教育培训领域的拓展:AI 写作在教育培训领域的应用将不断拓展和深化。它将为学生提供个性化的学习材料和写作辅导,帮助学生提高写作能力和学习效果。例如,AI 写作工具可以根据学生的学习进度和水平,生成适合学生的作文题目和写作指导,帮助学生提高写作能力;同时,AI 写作工具还可以为教师提供教学辅助材料和自动批改作业的功能,减轻教师的工作负担。

- 在企业服务领域的深化:AI 写作将在企业服务领域得到更广泛的应用和深化。它将为企业提供文档撰写、客户服务、营销推广等方面的支持,提高企业的工作效率和竞争力。例如,企业可以利用 AI 写作工具生成各种类型的文档,如报告、方案、邮件等,提高文档撰写的效率和质量;同时,AI 写作工具还可以为企业提供客户服务的自动化解决方案,提高客户满意度和忠诚度。

- 对社会文化的影响:AI 写作的发展将对社会文化产生深远的影响。它将推动文化产业的创新和发展,促进不同文化之间的交流与融合。例如,AI 写作工具可以为文化创意产业提供新的创作思路和表现形式,推动文化产业的创新发展;同时,AI 写作工具还可以促进不同语言和文化之间的交流与融合,增进不同国家和地区之间的相互理解和友谊。

总之,AI 写作作为一种新兴的技术和创作方式,具有广阔的发展前景和巨大的潜力。随着技术的不断进步和应用的不断拓展,AI 写作将在各个领域发挥更加重要的作用,为人类社会的发展和进步做出更大的贡献。

本文相关文章推荐:

AI 写作(一):开启创作新纪元(1/10)

AI写作(二)NLP:开启自然语言处理的奇妙之旅(2/10)

AI写作(三)文本生成算法:创新与突破(3/10)

AI写作(四)预训练语言模型:开启 AI 写作新时代(4/10)

AI写作(五)核心技术之文本摘要:分类与应用(5/10)

AI写作(六):核心技术与多元应用(6/10)

AI写作(七)的核心技术探秘:情感分析与观点挖掘(7/10)

AI 写作(八)实战项目一:自动写作助手(8/10)

AI 写作(九)实战项目二:智能新闻报道(9/10)

AI 写作(十)发展趋势与展望(10/10)

![[JAVA]MyBatis框架—如何获取SqlSession对象实现数据交互(基础篇)](https://i-blog.csdnimg.cn/direct/f7e079c1c18b4f75b59cf4c31002c1e5.png)