本文重点

在深度学习领域,卷积神经网络(Convolutional Neural Networks,CNN)因其强大的特征提取和分类能力而广泛应用于图像识别、自然语言处理等多个领域。然而,从头开始训练一个CNN模型往往需要大量的数据和计算资源,且训练时间较长。幸运的是,迁移学习(Transfer Learning)技术为我们提供了一条有效途径:通过微调(Fine-tuning)已训练好的神经网络模型,使其适应新的任务和数据集。

微调的基本原理

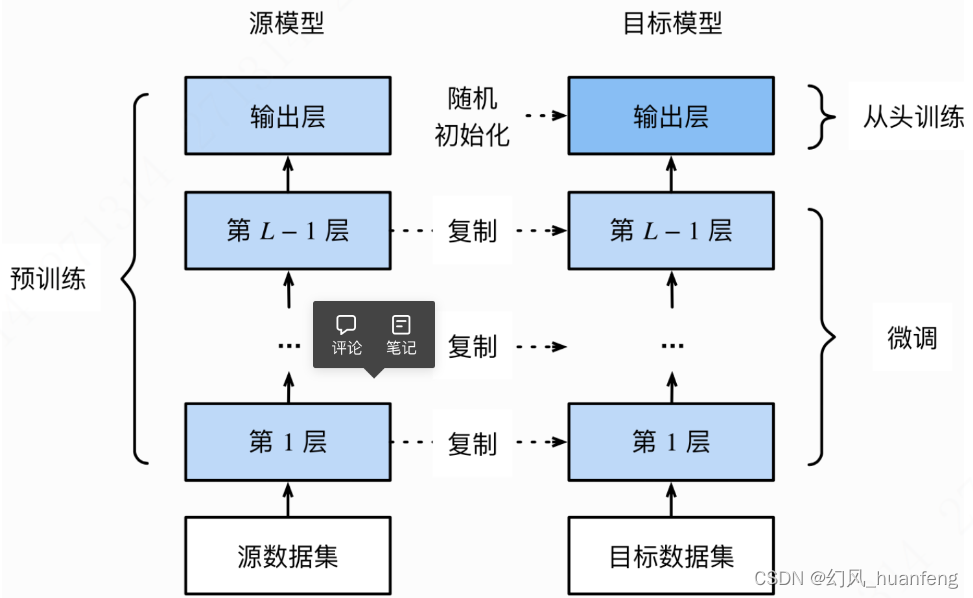

微调是指在已训练好的神经网络模型基础上,通过修改部分网络结构和参数,使其适应新的任务和数据集。具体来说,微调包括以下几个步骤:

选择合适的预训练模型:预训练模型通常是在大规模数据集上训练得到的,具有强大的特征提取能力。选择与目标任务相似领域的预训练模型,可以更快地收敛并获得更好的性能。

修改网络结构:根据目标任务的需求,修改预训练模型的网络结构。例如,如果目标任务是分类任务,可以将预训练模型的最后一层全连接层替换为新的分类层,以适应新的类别数。

初始化参数:将预训练模型的参数作为初始值,加载到新的网络结构中。这些参数已经在大规模数据集上进行了优化,可以作为良好的起点。

微调参数:使用新的数据集对模型进行训练,更新部分或全部参数。在微调过程中,通常使用较小的学习率,以避免破坏预训练模型的特征提取能力。

![服务器每次登陆都需要source .bashrc才能使用conda的问题[已解决]](http://pic.xiahunao.cn/服务器每次登陆都需要source .bashrc才能使用conda的问题[已解决])

处理表格会出现下拉框的问题)

)