- MZUAI和IIAI在NIPS2023上的一篇论文,用prompt来编码degradation,然后用来guide restoration network,使得模型能够泛化到不同degradation types and levels,也就是说是一个模型一次训练能够应对多种degradation的unified model。

- 文章分析,对每种degradation都要train一个模型是compute-intensive and tedious process, and oftentimes impractical for resource-constrained platforms. 同时,为了对一张图片进行restore,需要提前知道degradation以选择对应的模型。因此本文提出这样的框架,对输入图片,用一个PGM来生成degradation prompt,然后在现有restoration网络中插入PIM,利用degradation prompt来实现对多种degradation的差异化处理,实现一个unified网络完成多种restoration任务。

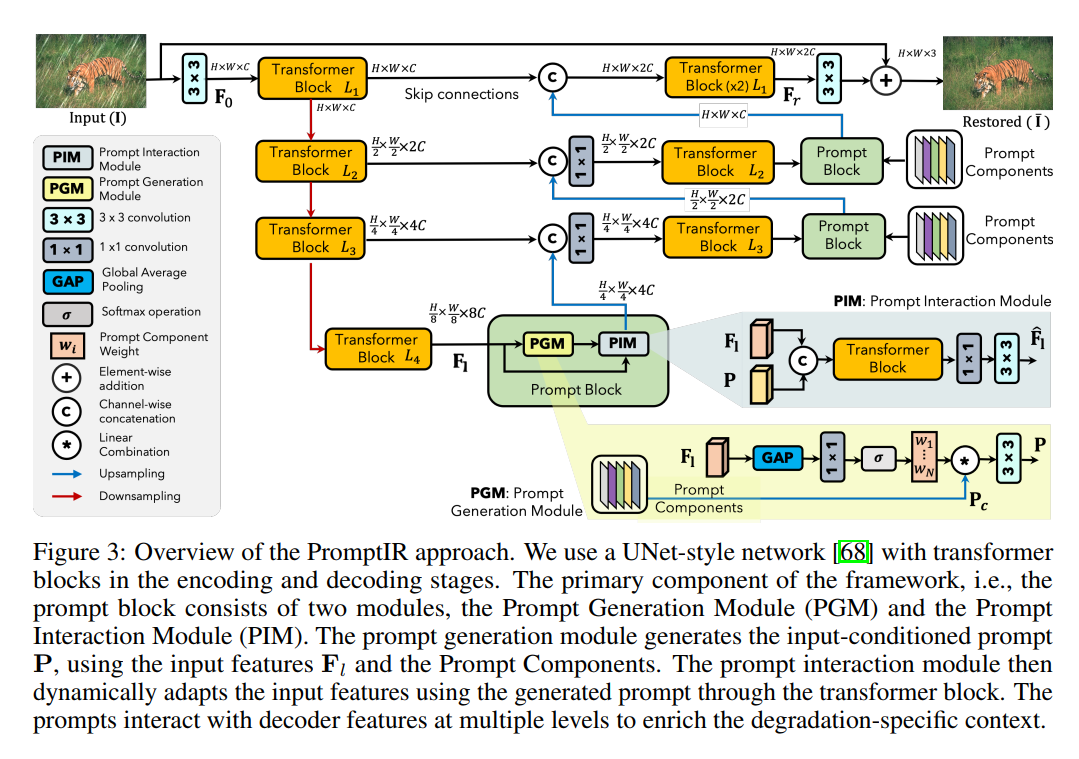

- 具体如下图所示,主要就是这个PGM和PIM。首先预定义好一些prompt components,他们是可训练的参数,有固定的size,是CHW的。然后在每个块里面,会对prompt components进行bilinear upsampling到本层特征的size大小,然后用w对不同通道分配权重后再过一层3x3卷积然后和本层特征concatenate到一起去处理。w是从本层特征经过GAP,全连接,softmax后得到的。整个网络的backbone用的是restormer:

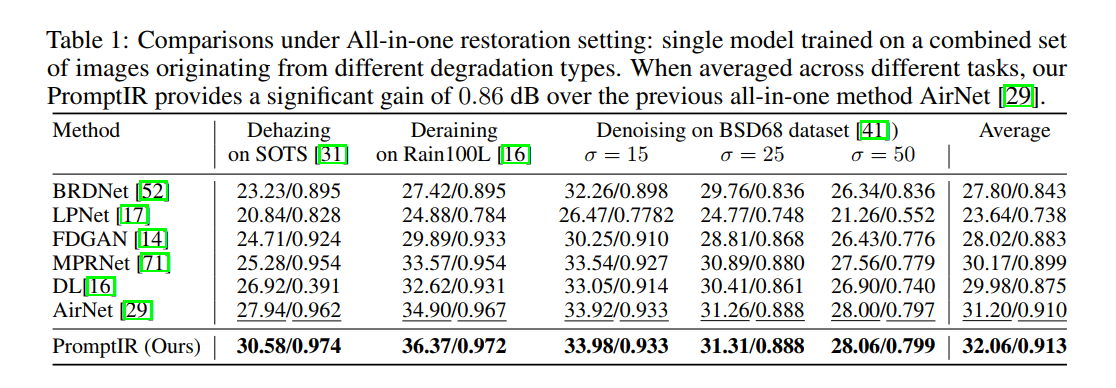

- 实验部分,做了两类实验,一类是single task的,就是一个task train一个模型,去测。multi-task的,就是在混合的数据集中train一个模型,去多个task上测。可以看到all-in-one的结果确实是sota,虽然在denoising上优势不高,但在其它两个任务上有很大优势:

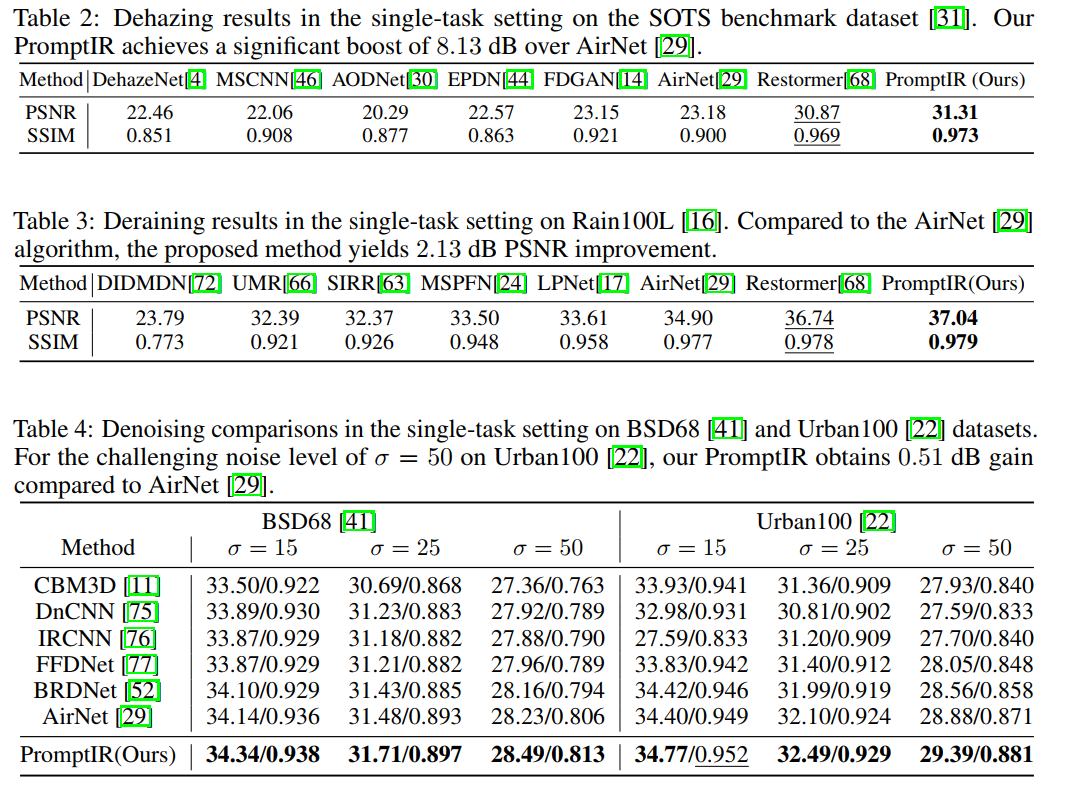

- 而在single task也达到了各个任务的sota:

- 评价:我有一点强烈的质疑,就是prompt是CHW这个事情,从数学上看就非常不合理。concatenate进去的prompt,如果代表的是degradation信息,为什么在不同的位置有不同的预设值?难道所有的图片的degradation的空间分布都一样吗?假设其中一个通道代表噪声强度,那这个HxW的map的实际意义是什么呢?噪声强度?那这个map的左上角比中间小,难道代表对所有图片来说,左上角的噪声强度都比中间小吗?这个CHW的prompt总之在可解释性上非常存疑。

)

)

)

:引用、内联、auto)

)