2k字讲清楚如何在有限素材的基础上,用MJ随机生成设计服装,附本人实操步骤图~

灵感来源:既然Midjourney(MJ)能够参考图片进行绘图,那么,提供一些素材,借由MJ的随机成图来寻找一些服装设计的创意灵感,按理说应该也是可行的。

怀着这样的想法,我进了初步尝试。

1、 最简单的垫图

我在网上随便找了件衣服的图片,另外找了个EVA的元素,然后直接用垫图功能,结果嘛,嗯挺还原啊!

随机找的衣服照片

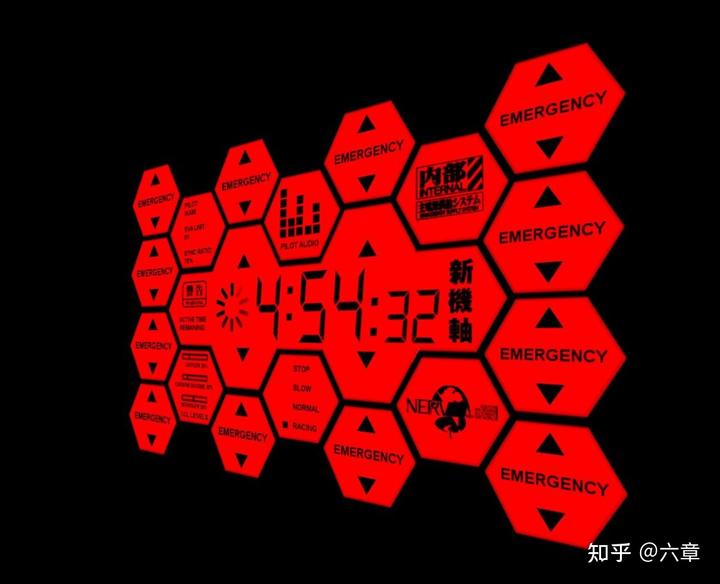

随手照的EVA元素照片

合体!!

效果其实挺好的,就是,创意在哪呢?这不就是1+1=2嘛。

2、垫图+提示词

还是用同样上边的两张垫图,这次我想试试黑色的卫衣(毕竟黑红搭配没毛病),于是稍微加了一点点提示词,毕竟是要创意灵感,所以就不做过多要求了。提示词极简单:black hoodie, front view, studio light, Bright background。结果如下:

是不是有那味了?

不过有没有发现,由于加入了提示词,所以卫衣上的图案与之前的蓝色卫衣相比,其实已经不那么严格参照了。这里我猜MJ的底层逻辑是,如果没有任何提示词,MJ应该更可能倾向于两者图片的简单融合,不过如果一旦有了提示词的介入,就会影响了融合的机制,开始从资源库中去匹配,这样就会让图片产生偏差,不过创意也就由此生成了。

3、那如果垫三张图会如何呢?搞起!

在提示词不变的前提下,我又加了一副垫图:

结果:

如果仔细看呢,其实还是多少能看到一丢丢1号机的影子,不过不够突出啊,然后我又稍微改了改提示词,强调了下EVA:black hoodie with Neon Genesis Evangelion graphics, Red pattern accents, front view, studio light, Bright background,结果翻车了……

MJ,咱俩看得绝对不是同一个EVA,就这形象,使徒都没你土!这怕不是参考的星际争霸里穿着机甲的虫族吧。

后续我又试过几次,都不太理想,我觉得MJ不适合垫图超过2张,垫图越多,越不可控,当然,从创意角度看,没毛病……你也不知道它会怎么选这几张图的元素。

MJ作为AI绘画工具的典型代表,其可挖掘的使用价值毋庸置疑,毕竟商用案例比比皆是,可以说MJ既是一个风口,也是一份冲击。

对从事有关设计等行业的人,该技能是一份处于浪尖的竞争力,对于从事电商自媒体的人而言,这是一个不可忽视的资源库,对于计算机专业的人而言,更是把握技术风向的一个好机会。

光说今天的服装设计,谁能保证就不是个等着你来挖掘的金矿呢。

AI绘画虽然好玩,可因为它是个黑箱子,导致单一用户很难摸清内部机制,从而依靠有限命令控制出品质量,造成其上限高下限低的问题,形成了一定的上手门槛。

4、然后我又想到了MJ的blend功能

依旧是用以上两张EVA的元素图,用MJ的blend功能来张创意的图案混合:

感觉左一还不错,于是选了左一和衣服那张图进行垫图,提示词还是用的:black hoodie, Red pattern accents, front view, studio light, Bright background:

我的机器人哪去了?

然后我把提示词删除,依旧单纯只用垫图的形式:

额,机器人有了,可是这图案……MJ你出来,咱俩谈谈,为啥我的机器人是绿的?那么红的图案,怎么就成绿的了?

虽然效果不太理想,MJ的逻辑也确实没摸清,但是利用blend进行图片的一次融合,然后再进行有目的倾向的垫图生图,这个思路应该是可行的。

5、花絮

其实我还试了白色卫衣,以下是垫图:

以及成图:

我TM……

当然,后期经过一些尝试,最终成了两幅图,我觉得还是可以作为思考的参考的:

几番折腾下来,我总体感觉是,MJ目前用于找找灵感是没问题的。但是如果要求特别准确的固有元素,那么即使垫图,大概率MJ也很难保留到理想的元素形态。现阶段比较可行的一种选择是,将某一方向的元素,投喂给MJ,让其以此参照进行生图,成图作为设计的灵感参考,然后进行二次修正,那么应该是比较容易达到理想状态的。

但由于AIGC刚刚爆火,网上相关内容的文章博客五花八门、良莠不齐。要么杂乱、零散、碎片化,看着看着就衔接不上了,要么内容质量太浅,学不到干货。

这里分享给大家一份Adobe大神整理的《AIGC全家桶学习笔记》,相信大家会对AIGC有着更深入、更系统的理解。

有需要的朋友,可以点击下方免费领取!

)

Tkinter笔记(十四):Entry与Button的碰撞(1))