YOLOv9最新改进系列:融合空间信息关注机制(SimAM)于YOLOv9网络,在通道之间和空间位置之间建立更加准确的关联,助力YOLOv9有效涨点!!!

在此之前!先恭喜两位家人!!!!

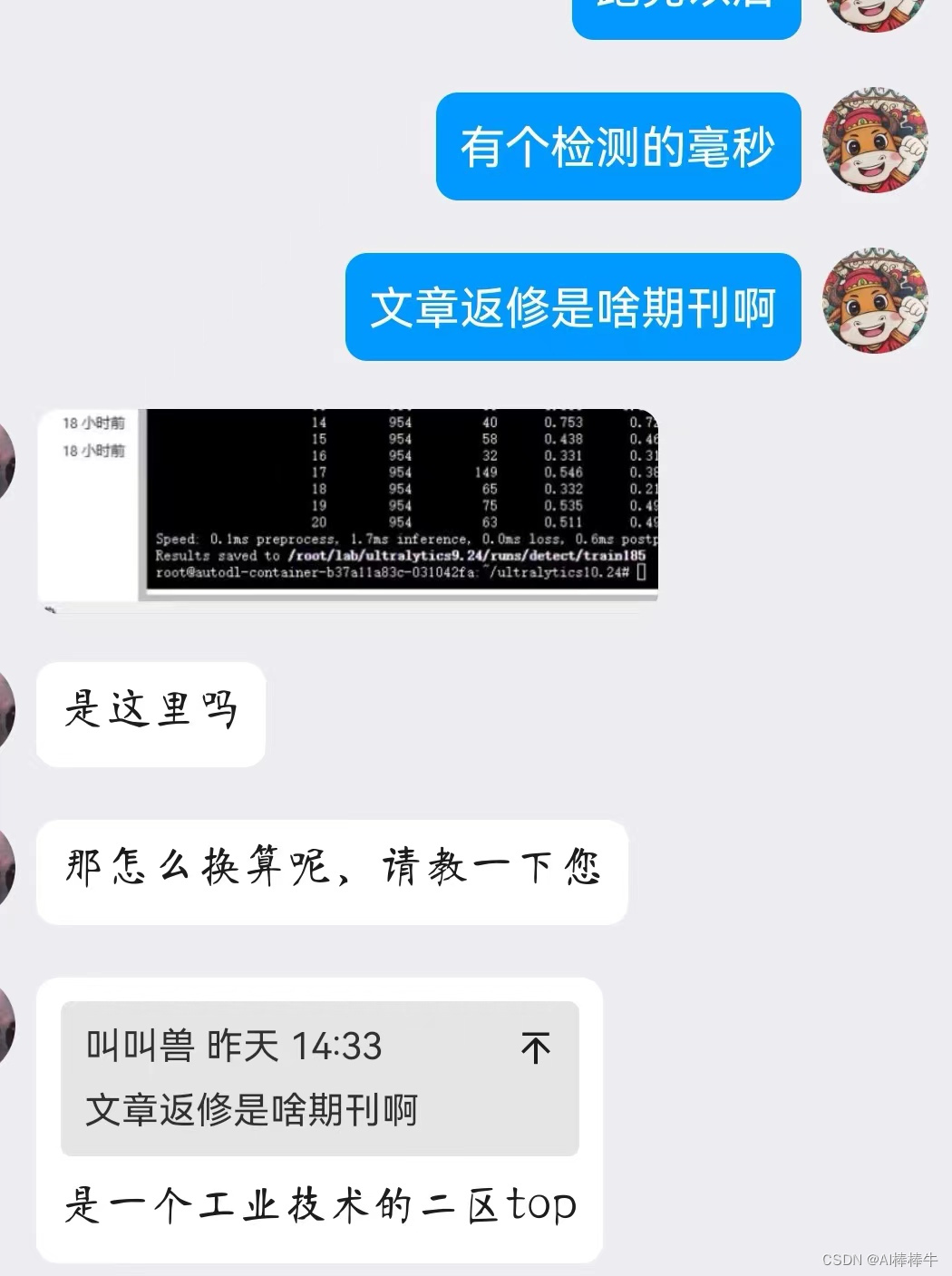

第一位优秀的家人~

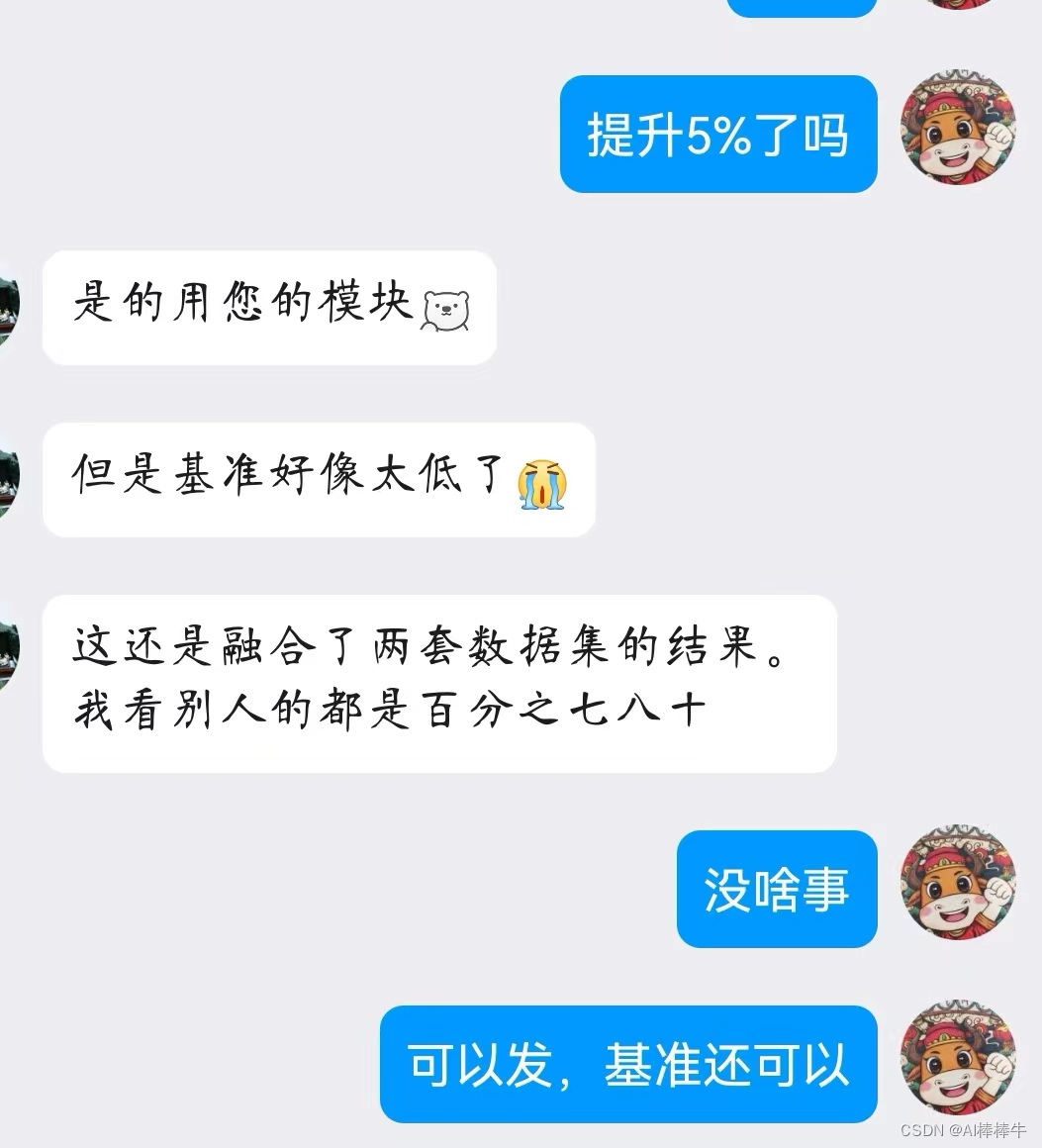

第二位优秀的家人~

第二位优秀的家人~

YOLOv9原文链接戳这里,原文全文翻译请关注B站Ai学术叫叫首er

B站全文戳这里!

详细的改进教程以及源码,戳这!戳这!!戳这!!!B站:AI学术叫叫兽 源码在工房的链接中,动态中也有链接,感谢支持!祝科研遥遥领先!

Involution新卷积网络算子提出原文

YOLOv9最新改进系列:融合空间信息关注机制(SimAM)于YOLOv9网络,在通道之间和空间位置之间建立更加准确的关联,助力YOLOv9有效涨点!!!

- YOLOv9最新改进系列:融合空间信息关注机制(SimAM)于YOLOv9网络,在通道之间和空间位置之间建立更加准确的关联,助力YOLOv9有效涨点!!!

- 摘要

- 1 介绍

- 2 相关工作

- 3 结论

- 四 修改步骤!

- 4.1 修改YAML文件

- 4.2 新建.py

- 4.3 修改tasks.py

- 五、验证是否成功即可

SimAM: A Simple, Parameter-Free Attention Module for

Convolutional Neural Networks(提出原文戳这)

详细的改进教程以及源码,戳这!戳这!!戳这!!!B站:AI学术叫叫兽 源码在相簿的链接中,动态中也有链接,感谢支持!祝科研遥遥领先!

截止到发稿时,B站YOLOv9最新改进系列的源码包,已更新了21种的改进!自己排列组合2-4种后,考虑位置不同后可排列组合上千种!!专注AI学术,关注B站博主:Ai学术叫叫兽er!

摘要

在本文中,我们提出了一个概念上简单但非常有效的卷积神经网络(ConvNets)注意力模块。 与现有的通道和空间注意力模块相比,我们的模块为层中的特征图推断 3D 注意力权重,而不向原始网络添加参数。 具体来说,我们基于一些著名的神经科学理论,提出优化能量函数来找出每个神经元的重要性。 我们进一步推导了能量函数的快速封闭式解决方案,并表明该解决方案可以用不到十行代码来实现。 该模块的另一个优点是,大多数算子是根据定义的能量函数的解来选择的,避免了过多的结构调整工作。 对各种视觉任务的定量评估表明,所提出的模块灵活有效,可以提高许多ConvNet的表示能力。

图 1. 不同网络获得的特征激活的可视化。 所有比较的网络均在一致的设置下在 ImageNet(Russakovsky 等人,2015)上进行训练。 这些特征是在验证集上提取的,并由 Grad-CAM 显示(Selvaraju 等人,2017)。 我们的 SimAM 帮助网络关注一些靠近下图所示图像标签的主要区域。

图 1. 不同网络获得的特征激活的可视化。 所有比较的网络均在一致的设置下在 ImageNet(Russakovsky 等人,2015)上进行训练。 这些特征是在验证集上提取的,并由 Grad-CAM 显示(Selvaraju 等人,2017)。 我们的 SimAM 帮助网络关注一些靠近下图所示图像标签的主要区域。

受人脑注意力机制的启发,

1我们提出了一个具有完整 3D 权重的注意力模块,并设计了一个能量函数来计算权重。

2 我们推导了能量函数的封闭式解,该解加速了重量计算并允许整个模块的轻量级形式。

3 我们将所提出的模块集成到一些众所周知的网络中,并在各种任务上对其进行评估。 我们的模块在准确性、模型大小和速度方面优于其他流行模块。

1 介绍

在大规模数据集(例如 ImageNet(Russakovsky 等人,2015))上训练的卷积神经网络(ConvNet)极大地提高了许多视觉任务的性能,例如图像分类(Krizhevsky 等人,2012;Simonyan 和 Zisserman) ,2014;He 等人,2016b;Szegedy 等人,2015;Sandler 等人,2018),物体检测(Ren 等人,2015;Liu 等人,2016) 等,2017)和视频理解(Feichtenhofer 等,2016;Wang 等,2018a)。 多项研究表明,更好的 ConvNet 结构可以显着提高各种问题的性能。 因此,构建强大的ConvNet是视觉研究中的一项重要任务。 现代 ConvNet 通常具有多个阶段,每个阶段由几个块组成。 这样的块由几个算子构建,如卷积、池化、激活或一些定制的元结构(在本文中称为模块)。 最近,许多工作不再像(Krizhevsky et al., 2012)那样设计整个架构,而是专注于构建高级模块以提高 ConvNet 的表示能力。 堆叠卷积 (Simonyan & Zisserman, 2014)、残差单元 (He et al., 2016b;a; Zagoruyko & Komodakis, 2016; Sandler et al., 2018) 和密集连接 (Huang et al., 2017; 2018) 是 其中最具代表性的,在现有架构中得到了广泛的应用。 然而,设计这些模块需要丰富的专业知识和大量的时间。 为了规避这一点,许多研究人员寻求一些搜索策略来自动构建架构(Zoph & Le,2016;Liu et al.,2018b;Dong & Yang,2019;Tan & Le,2019;Guo et al.,2020;Liu 等人,2019;Feichtenhofer,2020;Tan 等人,2020)。 除了设计复杂的模块之外,另一条研究重点是构建即插即用模块(Hu et al., 2018b; Woo et al., 2018; Cao et al., 2020; Lee et al., 2019; Wang et al., 2019) ., 2020; Yang et al., 2020)可以细化块内的卷积输出,并使整个网络能够学习更多信息特征。 例如,挤压和激励(SE)模块(Hu et al., 2018b)允许网络捕获任务相关特征(参见图 1 中的“山帐篷”)并抑制许多背景激活(参见中的“钢拱桥”)。 图1)。 该模块独立于网络架构,因此可以插入广泛的网络中,例如 VGG (Simonyan & Zisserman, 2014)、ResNets (He et al., 2016b) 和 ResNeXts (Xie et al., 2017) 。 最近,SE 模块作为 AutoML 的一个组件包含在内,以搜索更好的网络结构(Howard 等人,2019 年;Tan & Le,2019 年)。 然而,现有的注意力模块有两个问题。 首先,它们只能沿着通道或空间维度细化特征,限制了它们学习跨通道和空间变化的注意力权重的灵活性。 其次,它们的结构是由一系列复杂因素构建的,例如池化的选择。 我们通过提出一个基于完善的神经科学理论的模块来解决这些问题。 具体来说,为了使网络学习更具辨别力的神经元,我们建议直接从当前神经元推断 3D 权重(即考虑空间和通道维度),然后依次细化这些神经元。 为了有效地推断此类 3-D 权重,我们定义了一个由神经科学知识指导的能量函数,并得出了一个封闭式解决方案。 如图 1 所示,我们的模块帮助网络捕获许多与图像一致的有价值的线索

2 相关工作

在本节中,我们将简要讨论网络架构和即插即用注意力模块的代表性工作。 网络架构。 2012 年,发布了现代深度卷积网络 AlexNet(Krizhevsky et al., 2012),用于大规模图像分类。 它是一个简单的前馈结构,类似于 LeNet 中的设置(LeCun 等人,1998)。 之后,人们提出了多种方法来增强卷积网络的能力。 一些工作侧重于寻找最佳滤波器形状(Zeiler & Fergus,2014;Chatfield 等人,2014),而其他一些方法尝试设计更深的网络。 例如,VGG (Simonyan & Zisserman, 2014) 和 Inception Net (Szegedy et al., 2015) 使用堆叠卷积来降低梯度消失/爆炸的风险 (Bengio et al., 1994; Glorot & Bengio, 2010)。 接下来,ResNet(He et al., 2016b)和 Highway network(Srivastava et al., 2015)在每个块内添加从输入到输出的快捷连接。 快捷连接使 ConvNet 能够扩展到数百层。 他们的结果表明,增加网络深度可以大大提高卷积网络的表示能力。 除了网络深度之外,一些工作建议增加滤波器的数量(Zagoruyko & Komodakis,2016)以获得更宽的块,在每个块内添加更多连接(Huang et al.,2017),或者探索组/深度明智的卷积( 谢等人,2017;Chollet,2017)。 最近,一系列工作使用 AutoML (Zoph & Le, 2016; Liu et al., 2018b;a; Tan et al., 2019; Howard et al., 2019; Wu et al., 2019) 来保存手册 网络设计方面的努力。 与上述工作不同,我们的目标是设计一个轻量级的即插即用模块。 该模块可用于许多ConvNet,以进一步提高其在各种任务中的性能,而无需对架构进行大的改变。 注意和重新校准模块。 之前的作品还设计了一些细化特征图的计算模块。 它们通常被称为注意力模块或重新校准模块。 为了简单起见,我们在本文中将它们称为注意力模块。 事实上,人类注意力是最重要的选择机制之一,它优先考虑与任务相关的信息并减弱不相关的信号(Reynolds & Chelazzi,2004;Chun 等,2011)。 人类视觉处理中的注意力机制激发研究人员在卷积网络中设计类似的注意力模块。 一项代表性工作,挤压和激励(SE)(Hu et al., 2018b),通过以下方式学习不同通道的重要性:首先从全局视图中捕获一些上下文线索,然后使用两个完全连接的层来模拟通道之间的交互。 输出又用于在通道级别完善这些功能。 该模块通过其他方法进一步扩展,例如,使用卷积聚合器捕获全局上下文(Hu et al., 2018a)、学习与基于通道的卷积的交互(Wang et al., 2020)、添加空间注意力(Woo 等人,2018),合并远程依赖关系(Cao 等人,2020;Wang 等人,2018b),统一注意力和标准化过程(Li 等人,2019a),或利用该特征的风格线索( 李等人,2019)。 然而,所有这些方法都平等地对待一个通道中的所有神经元或一个空间位置上的所有神经元,因此它们无法有效地计算真实的 3-D 权重。 此外,他们计算注意力权重的算法大多是手工制作的,需要大量的计算能力。 相比之下,我们基于一些著名的神经科学理论来设计我们的模块,这更具可解释性。 值得注意的是,一些模块也受到神经科学理论的启发,例如自适应上下文驱动的卷积(Lin et al., 2020)和选择性内核的感受野调整(Li et al., 2019b)。 与它们不同的是,我们的模块基于从哺乳动物大脑观察到的空间抑制,并将重量生成公式化为能量函数。 导出了该能量函数的封闭式解。 由于快速的封闭式解决方案,我们的模块没有引入额外的参数,这是与以前的作品不同的引人注目的属性。

详细方法请家人们仔细研读原文一手资料!!!

3 结论

在本文中,我们受到哺乳动物大脑神经科学理论的启发,提出了一种新的注意力模块 - SimAM。 特别是,我们基于完善的空间抑制理论,设计了能量函数来实现该理论。 我们还得出了该函数的一个简单解决方案,其中该函数进一步用作特征图中每个神经元的注意力重要性。 我们的注意力模块是在这个能量函数的指导下实现的,避免了太多的启发式方法。 进行了大量的实验来验证所提出的 SimAM 的有效性和效率。 我们的结果表明,针对不同视觉任务,所提出的 SimAM 与各种网络中的其他注意力模块的性能相当。

四 修改步骤!

4.1 修改YAML文件

详细的改进教程以及源码,戳这!戳这!!戳这!!!B站:AI学术叫叫兽 源码在相簿的链接中,动态中也有链接,感谢支持!祝科研遥遥领先!

4.2 新建.py

详细的改进教程以及源码,戳这!戳这!!戳这!!!B站:AI学术叫叫兽er 源码在相簿的链接中,动态中也有链接,感谢支持!祝科研遥遥领先!

4.3 修改tasks.py

详细的改进教程以及源码,戳这!戳这!!戳这!!!B站:AI学术叫叫兽er 源码在相簿的链接中,动态中也有链接,感谢支持!祝科研遥遥领先!

五、验证是否成功即可

执行命令

python train.py

改完收工!

关注B站:Ai学术叫叫兽er

从此走上科研快速路

遥遥领先同行!!!!

详细的改进教程以及源码,戳这!戳这!!戳这!!!B站:AI学术叫叫兽er 源码在相簿的链接中,动态中也有链接,感谢支持!祝科研遥遥领先!

![[IM002][Microsoft][ODBC 驱动程序管理器] 未发现数据源名称并且未指定默认驱动程序](http://pic.xiahunao.cn/[IM002][Microsoft][ODBC 驱动程序管理器] 未发现数据源名称并且未指定默认驱动程序)

)

:string的使用及初阶原理)

)

数据)

:寻找数组的中心下标)

)