在计算机科学领域,算法是解决问题的有效方法,而对算法进行分类有助于理解它们的特性、优劣以及在不同场景下的应用。常见的算法分类方法,包括按设计思想、问题类型、数据结构和应用领域等,每一类算法会对应有其典型和实际应用。

算法的出现是为了解决问题和简化复杂的任务。它们提供了一种系统的方法来执行特定的计算或操作,可以应用于各种领域,包括计算机科学、数学、工程、经济学等。

算法的优点:

- 解决问题:算法能够解决各种问题,从简单的计算到复杂的优化和决策问题。

- 效率:好的算法能够以较短的时间内处理大量数据,提高工作效率和生产力。

- 精确性:算法设计得当可以提供准确的结果,符合特定的需求和标准。

- 可复用性:一旦开发出有效的算法,它们可以被多次使用,甚至在不同的应用中重复使用。

算法的缺点:

- 复杂性:某些算法可能非常复杂,难以理解和实现,需要较高水平的专业知识。

- 局限性:某些算法只适用于特定类型的问题,无法应用于其他领域或情景。

- 资源消耗:一些算法可能需要大量的计算资源(如时间和内存),尤其是在处理大规模数据时。

- 误差和不确定性:算法可能会受到数据质量、输入参数等因素的影响,导致输出结果的误差或不确定性。

按设计思想分类

1、贪婪算法

算法说明: 贪婪算法是一种在每一步选择中都采取当前状态下最优解的方法,以期望最终能够达到全局最优解的算法思想。

算法原理: 贪婪算法每一步选择局部最优解,并且不会回溯,通过这种贪心选择性质,最终可以得到全局最优解。

时间复杂度: O(n)

空间复杂度: O(1)

代码示例: 针对背包问题的贪婪算法

同类算法对比: 动态规划算法。贪婪算法和动态规划算法都是求解最优化问题的方法,但贪婪算法每一步选择局部最优解,不能保证最终结果是全局最优的;而动态规划算法则通过保存中间结果来避免重复计算,可以得到全局最优解。

应用场景介绍: 贪婪算法适用于一些组合优化问题,如背包问题、最小生成树问题等,但需要注意的是,并不是所有问题都适合贪婪算法,因为贪婪算法得到的解不一定是最优解。

2、分治算法

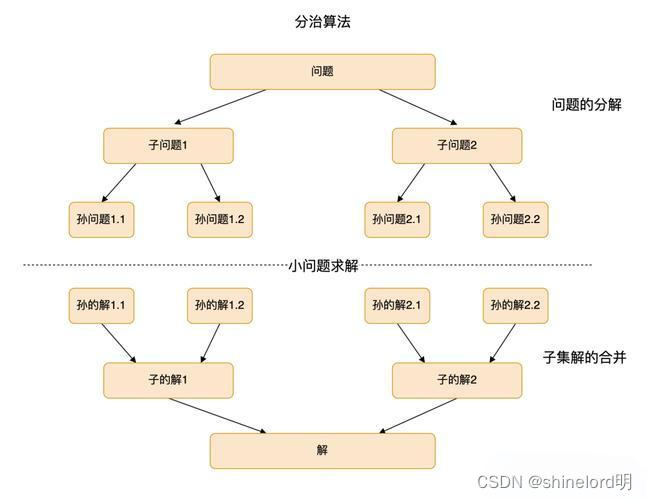

算法说明: 分治算法将问题分解成相互独立的子问题,递归求解子问题,然后将子问题的解合并起来得到原问题的解。

算法原理: 分治算法包含三个步骤:分解(Divide)、解决(Conquer)和合并(Combine)。首先将问题分解成更小的子问题,然后递归地解决这些子问题,最后将子问题的解合并起来得到原问题的解。

时间复杂度: 取决于子问题的数量和规模,通常为 O(n log n),其中 n 是问题的规模。

空间复杂度: 取决于递归调用的深度,通常为 O(log n)。

代码示例: 归并排序是分治算法的典型应用。

def merge_sort(arr):if len(arr) <= 1:return arrmid = len(arr) // 2left_half = arr[:mid]right_half = arr[mid:]left_half = merge_sort(left_half)right_half = merge_sort(right_half)return merge(left_half, right_half)def merge(left, right):result = []left_idx, right_idx = 0, 0while left_idx < len(left) and right_idx < len(right):if left[left_idx] < right[right_idx]:result.append(left[left_idx])left_idx += 1else:result.append(right[right_idx])right_idx += 1result.extend(left[left_idx:])result.extend(right[right_idx:])return resultarr = [12, 11, 13, 5, 6, 7]

sorted_arr = merge_sort(arr)

print("Sorted array:", sorted_arr)同类算法对比: 动态规划算法。分治算法和动态规划算法都是将问题分解成子问题求解的方法,但动态规划算法通常用于子问题之间存在重叠的情况,而分治算法则通常适用于子问题相互独立的情况。

应用场景介绍: 分治算法适用于许多需要递归求解的问题,如归并排序、快速排序、最接近点对问题等。

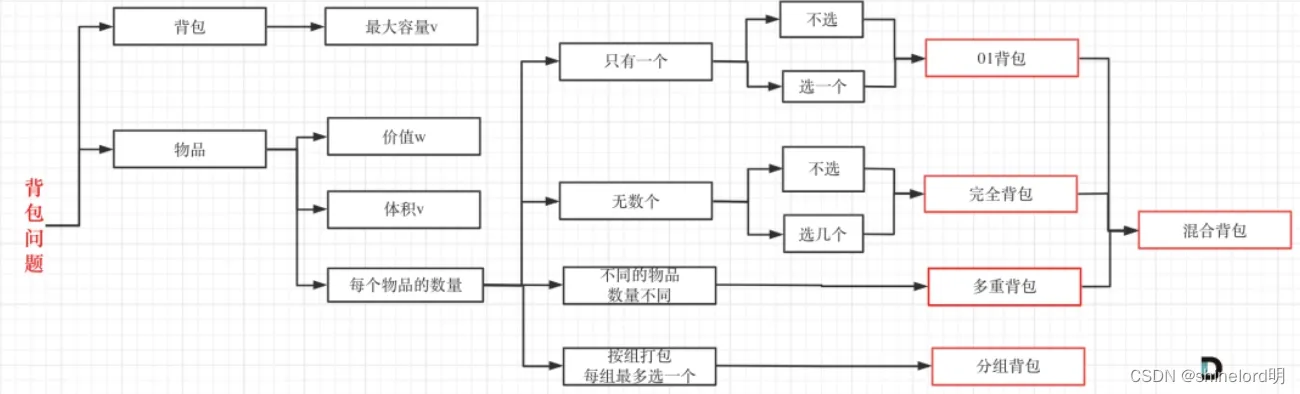

3、动态规划算法

算法说明: 动态规划算法是将复杂问题分解成简单子问题的解决方案,通过保存子问题的解避免重复计算,从而提高效率。

算法原理: 动态规划算法通常采用自底向上或自顶向下的方式求解问题。它包含两个关键步骤:定义子问题和求解子问题。通过定义状态和状态转移方程,可以将原问题分解成子问题,并通过求解子问题得到原问题的解。

时间复杂度: 取决于子问题的数量和规模,通常为 O(n^2) 或 O(n^3)。

空间复杂度: 取决于状态表的大小,通常为 O(n) 或 O(n^2)。

代码示例: 背包问题是动态规划算法的典型应用。

def knapsack(weights, values, capacity):n = len(weights)dp = [[0] * (capacity + 1) for _ in range(n + 1)]for i in range(1, n + 1):for w in range(1, capacity + 1):if weights[i - 1] <= w:dp[i][w] = max(values[i - 1] + dp[i - 1][w - weights[i - 1]], dp[i - 1][w])else:dp[i][w] = dp[i - 1][w]return dp[n][capacity]weights = [10, 20, 30]

values = [60, 100, 120]

capacity = 50max_value = knapsack(weights, values, capacity)

print("Maximum value:", max_value)同类算法对比: 贪婪算法。动态规划算法和贪婪算法都是求解最优化问题的方法,但动态规划算法通过保存中间结果来避免重复计算,可以得到全局最优解,而贪婪算法则每一步选择局部最优解,不能保证最终结果是全局最优的。

应用场景介绍: 动态规划算法适用于许多需要求解最优化问题的场景,如背包问题、最长公共子序列问题、最短路径问题等。

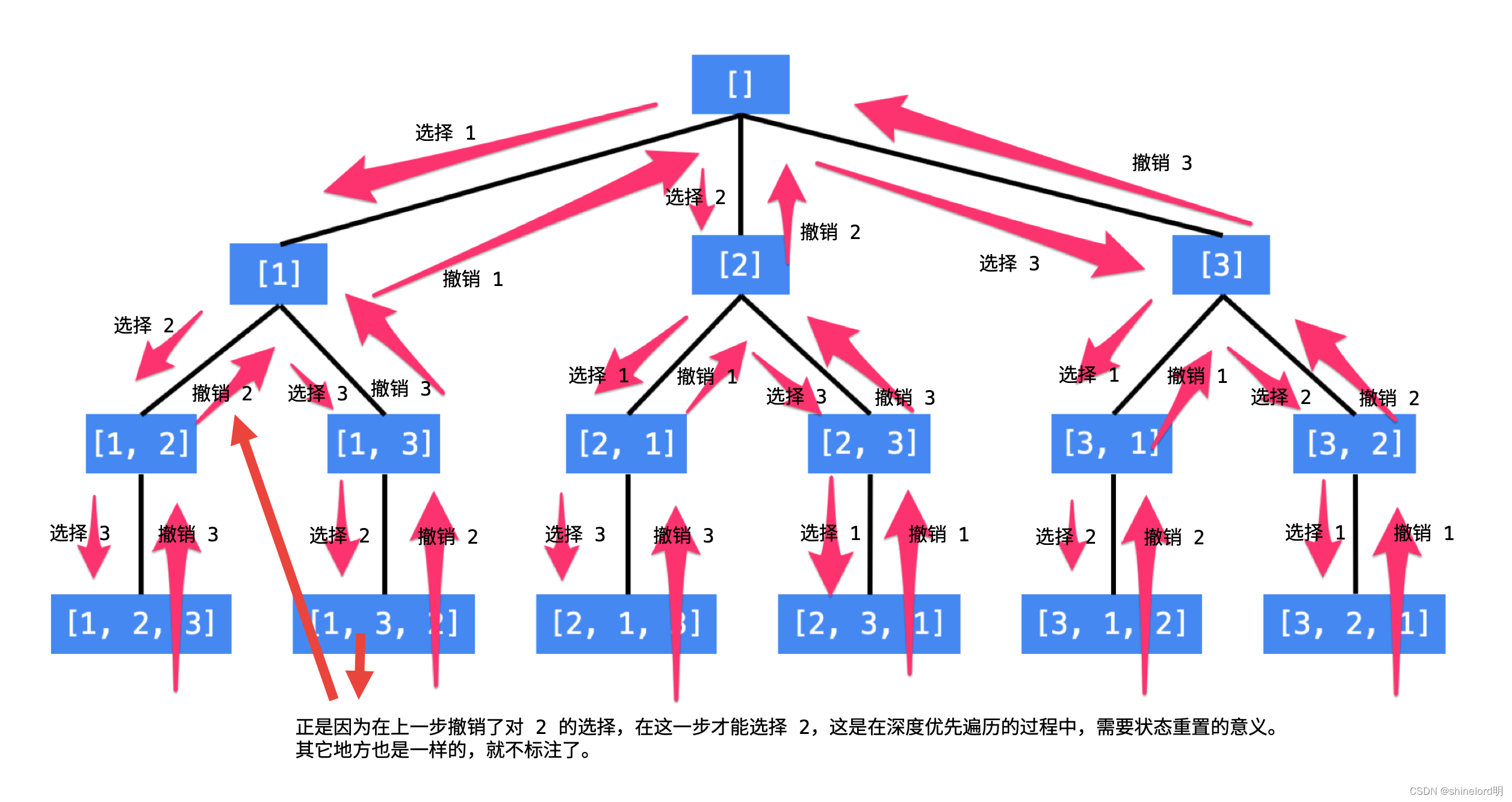

4、回溯算法

算法说明: 回溯算法是一种通过穷举所有可能的解,并在搜索过程中剪枝,以避免无效搜索的方法,常用于求解组合优化问题。

算法原理: 回溯算法通常通过递归方式搜索所有可能的解空间,当搜索到某一节点无法满足条件时,回溯到上一节点继续搜索其他可能的解。在搜索过程中,通过剪枝操作来减少无效搜索,提高搜索效率。

时间复杂度: 取决于问题的规模和搜索空间的大小,通常为指数级别的时间复杂度。

空间复杂度: 取决于递归调用的深度,通常为 O(n),其中 n 表示问题的规模。

代码示例: 八皇后问题是回溯算法的经典应用。

def solve_n_queens(n):def is_safe(row, col, queens):for r, c in queens:if col == c or row - col == r - c or row + col == r + c:return Falsereturn Truedef backtrack(row, queens):if row == n:solutions.append(queens)returnfor col in range(n):if is_safe(row, col, queens):backtrack(row + 1, queens + [(row, col)])solutions = []backtrack(0, [])return solutionsn = 8

solutions = solve_n_queens(n)

print("Number of solutions for {} queens:".format(n), len(solutions))同类算法对比: 动态规划算法。回溯算法通过穷举所有可能的解空间,适用于求解组合优化问题;动态规划算法通过保存中间结果避免重复计算,适用于问题具有最优子结构性质的场景。

应用场景介绍: 回溯算法适用于一些需要穷举所有可能解空间的场景,如八皇后问题、0-1背包问题、图的着色问题等。

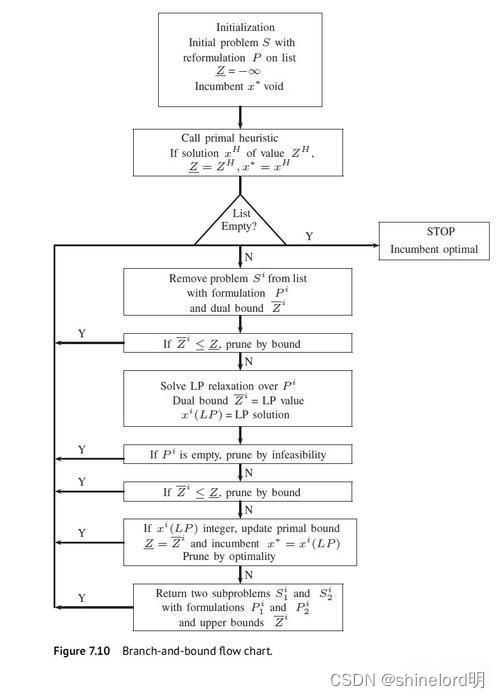

5、分支定界算法

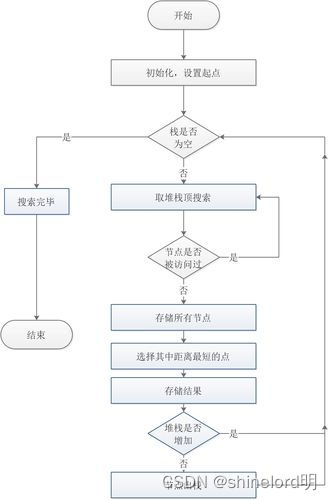

算法说明: 分支定界算法是一种通过分支、限界和剪枝来有效搜索问题解空间的方法,常用于求解组合优化问题。

算法原理: 分支定界算法通常通过递归方式搜索问题解空间,每次选择一个分支进行搜索,同时利用上下界信息来限制搜索范围,并通过剪枝操作来减少无效搜索。

时间复杂度: 取决于问题的规模和搜索空间的大小,通常介于指数级别和多项式级别之间。

空间复杂度: 取决于递归调用的深度和每次递归调用的空间消耗,通常为 O(n),其中 n 表示问题的规模。

代码示例: 0-1背包问题是分支定界算法的经典应用。

def knapsack_branch_and_bound(values, weights, capacity):def bound(i, w, v):while i < n and w + weights[i] <= capacity:w += weights[i]v += values[i]i += 1if i < n:v += (capacity - w) * values[i] / weights[i]return vdef backtrack(i, w, v):nonlocal max_valueif w <= capacity and v > max_value:max_value = vif i < n and bound(i, w, v) > max_value:backtrack(i + 1, w + weights[i], v + values[i])backtrack(i + 1, w, v)max_value = 0n = len(values)backtrack(0, 0, 0)return max_valuevalues = [60, 100, 120]

weights = [10, 20, 30]

capacity = 50

max_value = knapsack_branch_and_bound(values, weights, capacity)

print("Maximum value in knapsack:", max_value)同类算法对比: 动态规划算法。分支定界算法通过限界和剪枝来减少搜索空间,适用于求解组合优化问题;动态规划算法通过保存中间结果避免重复计算,适用于问题具有最优子结构性质的场景。

应用场景介绍: 分支定界算法适用于一些需要在搜索过程中限制搜索范围的场景,如0-1背包问题、旅行商问题、任务分配问题等。

按问题类型分类

1、搜索算法

算法说明: 搜索算法是一种用于在数据集合中查找特定元素或满足特定条件的算法。

算法原理: 搜索算法的原理因算法而异,常见的搜索算法包括线性搜索、二分搜索、广度优先搜索(BFS)、深度优先搜索(DFS)等。

时间复杂度: 取决于算法的具体实现和数据集合的大小,通常为线性时间复杂度、对数时间复杂度或指数时间复杂度。

空间复杂度: 取决于算法的具体实现和所需的额外空间,通常为常数空间复杂度或线性空间复杂度。

代码示例: 二分搜索是搜索算法的经典示例。

def binary_search(arr, target):left, right = 0, len(arr) - 1while left <= right:mid = left + (right - left) // 2if arr[mid] == target:return midelif arr[mid] < target:left = mid + 1else:right = mid - 1return -1arr = [1, 3, 5, 7, 9, 11, 13]

target = 7

index = binary_search(arr, target)

print("Index of target:", index)同类算法对比: 线性搜索算法。二分搜索通过每次将搜索空间减半来提高搜索效率;线性搜索则按顺序逐个查找元素。

应用场景介绍: 二分搜索适用于有序数组或有序列表中查找特定元素的场景,例如在查找算法中使用二分搜索。

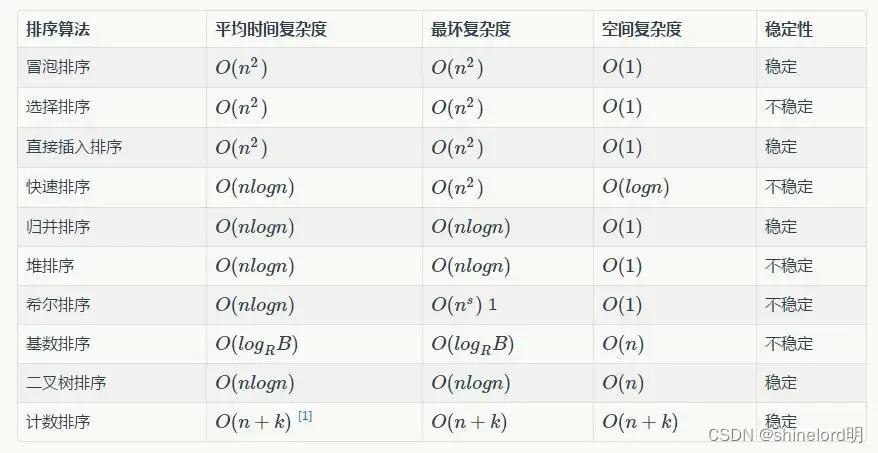

2、排序算法

算法说明: 排序算法是一种将数据元素按照指定顺序重新排列的算法。

算法原理: 排序算法的原理因算法而异,常见的排序算法包括冒泡排序、选择排序、插入排序、快速排序、归并排序等。

时间复杂度: 取决于算法的具体实现和数据集合的大小,通常为平方级别、对数级别或线性级别的时间复杂度。

空间复杂度: 取决于算法的具体实现和所需的额外空间,通常为常数空间复杂度或线性空间复杂度。

代码示例: 快速排序是排序算法的经典示例。

def quick_sort(arr):if len(arr) <= 1:return arrpivot = arr[len(arr) // 2]left = [x for x in arr if x < pivot]middle = [x for x in arr if x == pivot]right = [x for x in arr if x > pivot]return quick_sort(left) + middle + quick_sort(right)arr = [3, 6, 8, 10, 1, 2, 1]

sorted_arr = quick_sort(arr)

print("Sorted array:", sorted_arr)同类算法对比: 归并排序算法。快速排序通过分治法将问题分解为较小的子问题并分别解决,再将子问题的解合并起来;归并排序也采用分治法,但是它是先将问题划分为两个子问题,然后对子问题进行递归求解,最后将子问题的解合并起来。

应用场景介绍: 快速排序适用于大多数数据集合的排序场景,尤其是对于较大数据集合的排序,其性能优于许多其他排序算法。

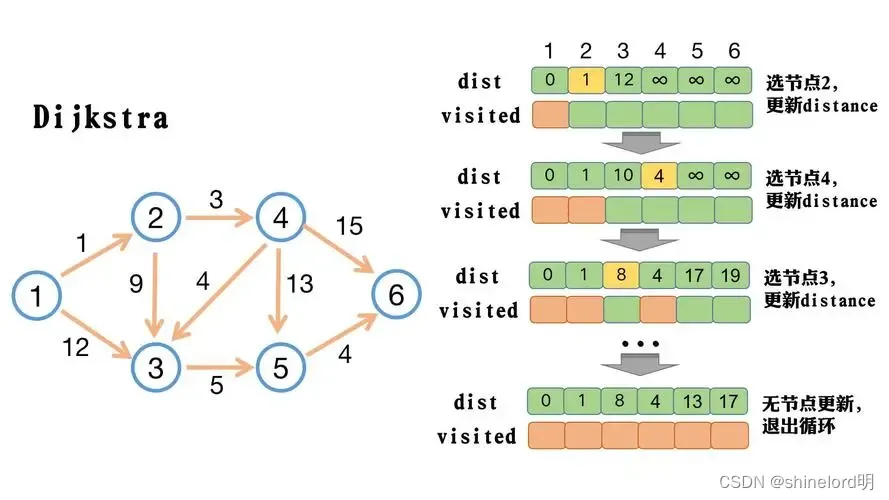

3、图算法

算法说明: 图算法是一种用于在图(Graph)数据结构上执行操作的算法,例如查找最短路径、遍历图等。

算法原理: 图算法的原理因算法而异,常见的图算法包括深度优先搜索(DFS)、广度优先搜索(BFS)、Dijkstra算法、最小生成树算法(如Prim算法和Kruskal算法)等。

时间复杂度: 取决于算法的具体实现和图的大小以及结构,通常为线性时间复杂度或指数时间复杂度。

空间复杂度: 取决于算法的具体实现和所需的额外空间,通常为常数空间复杂度或线性空间复杂度。

代码示例: 使用深度优先搜索(DFS)来遍历图的示例。

def dfs(graph, node, visited):if node not in visited:print(node)visited.add(node)for neighbor in graph[node]:dfs(graph, neighbor, visited)graph = {'A': ['B', 'C'],'B': ['D', 'E'],'C': ['F'],'D': [],'E': ['F'],'F': []

}visited = set()

dfs(graph, 'A', visited)同类算法对比: 广度优先搜索(BFS)算法。DFS和BFS都是图遍历的经典算法,它们的主要区别在于搜索的顺序。

应用场景介绍: 图算法广泛应用于网络路由、社交网络分析、地图导航等领域,在需要对关系网进行分析和搜索的场景中非常有用。

4、字符串匹配算法

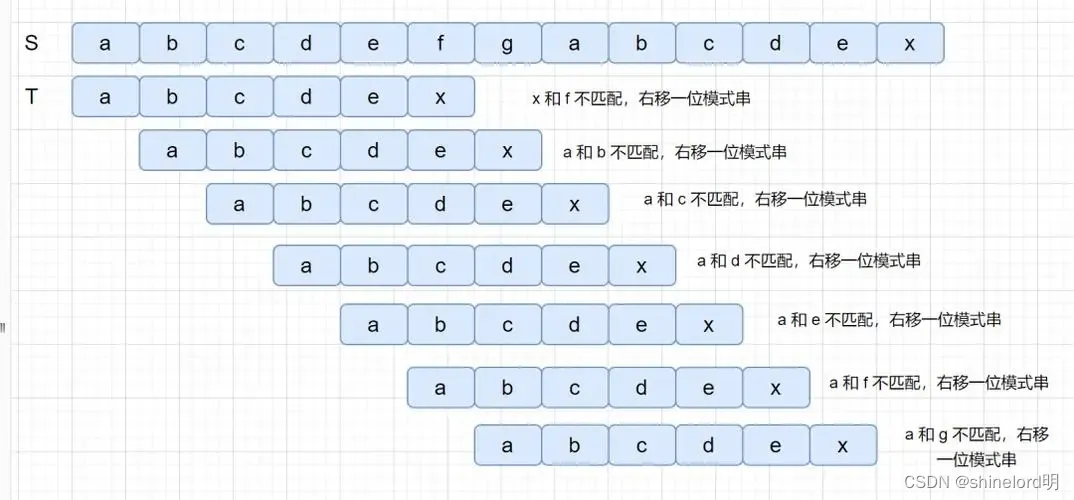

算法说明: 字符串匹配算法是一种用于在一个字符串(称为主串)中查找一个子串的位置的算法。

算法原理: 常见的字符串匹配算法包括暴力匹配算法、KMP算法(Knuth-Morris-Pratt算法)、Boyer-Moore算法等。这些算法的原理各不相同,但主要思想是通过在主串中移动匹配窗口并进行比较,以确定子串的位置。

时间复杂度: 不同算法的时间复杂度各不相同,暴力匹配算法的时间复杂度为O(m*n),其中m是主串的长度,n是子串的长度;KMP算法和Boyer-Moore算法通常具有线性的时间复杂度O(m+n)。

空间复杂度: 空间复杂度也因算法而异,通常为常数空间复杂度或线性空间复杂度。

代码示例: 简单的暴力匹配算法示例:

def brute_force_search(text, pattern):n = len(text)m = len(pattern)for i in range(n - m + 1):j = 0while j < m and text[i + j] == pattern[j]:j += 1if j == m:return ireturn -1text = "ABCABCDABABCDABCDABDE"

pattern = "ABCDABD"

index = brute_force_search(text, pattern)

print("Pattern found at index:", index)同类算法对比: KMP算法和Boyer-Moore算法是字符串匹配算法中的两个经典算法。与暴力匹配算法相比,它们在特定情况下具有更好的性能。

应用场景介绍: 字符串匹配算法广泛应用于文本编辑、搜索引擎、字符串处理等领域,在需要查找特定模式或关键字的文本场景中非常有用。

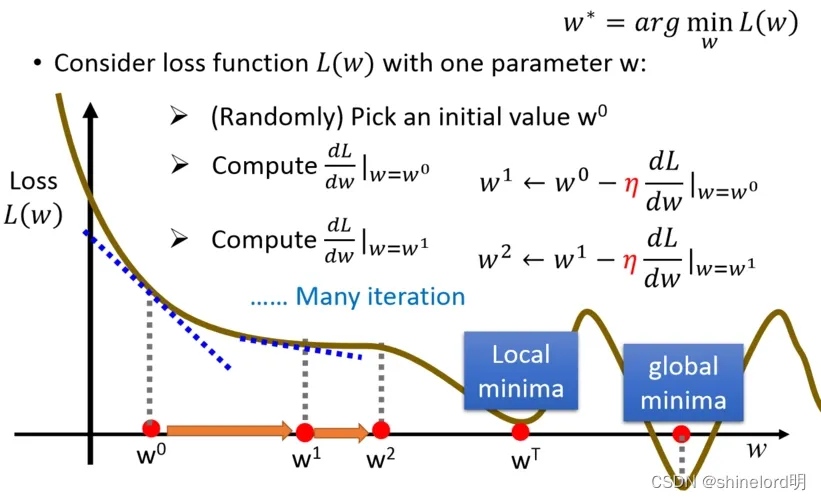

5、最优化算法

算法说明: 最优化算法是一类用于解决优化问题的算法,旨在找到问题的最优解或接近最优解的解。

算法原理: 最优化算法的原理因算法而异,常见的最优化算法包括贪心算法、动态规划、遗传算法、模拟退火算法等。这些算法采用不同的策略和思想来搜索解空间,并根据特定的目标函数选择最优解。

时间复杂度: 最优化算法的时间复杂度因算法而异,通常取决于问题的规模和复杂度。

空间复杂度: 空间复杂度也因算法而异,通常为常数空间复杂度或线性空间复杂度。

代码示例: 简单的贪心算法示例,用于解决背包问题:

def greedy_knapsack(values, weights, capacity):n = len(values)indexes = list(range(n))indexes.sort(key=lambda i: values[i] / weights[i], reverse=True)total_value = 0knapsack = [0] * nfor i in indexes:if weights[i] <= capacity:knapsack[i] = 1total_value += values[i]capacity -= weights[i]return total_value, knapsackvalues = [60, 100, 120]

weights = [10, 20, 30]

capacity = 50

total_value, knapsack = greedy_knapsack(values, weights, capacity)

print("Total value:", total_value)

print("Items in knapsack:", knapsack)同类算法对比: 动态规划算法。贪心算法和动态规划算法都用于解决优化问题,但它们的主要区别在于贪心算法每一步都选择当前最优解,而动态规划算法则考虑了之前所有的选择。

应用场景介绍: 最优化算法在各种领域中都有广泛应用,例如在工程优化、金融投资、资源分配等方面。它们可以帮助优化资源利用,提高效率,降低成本。

按数据结构分类

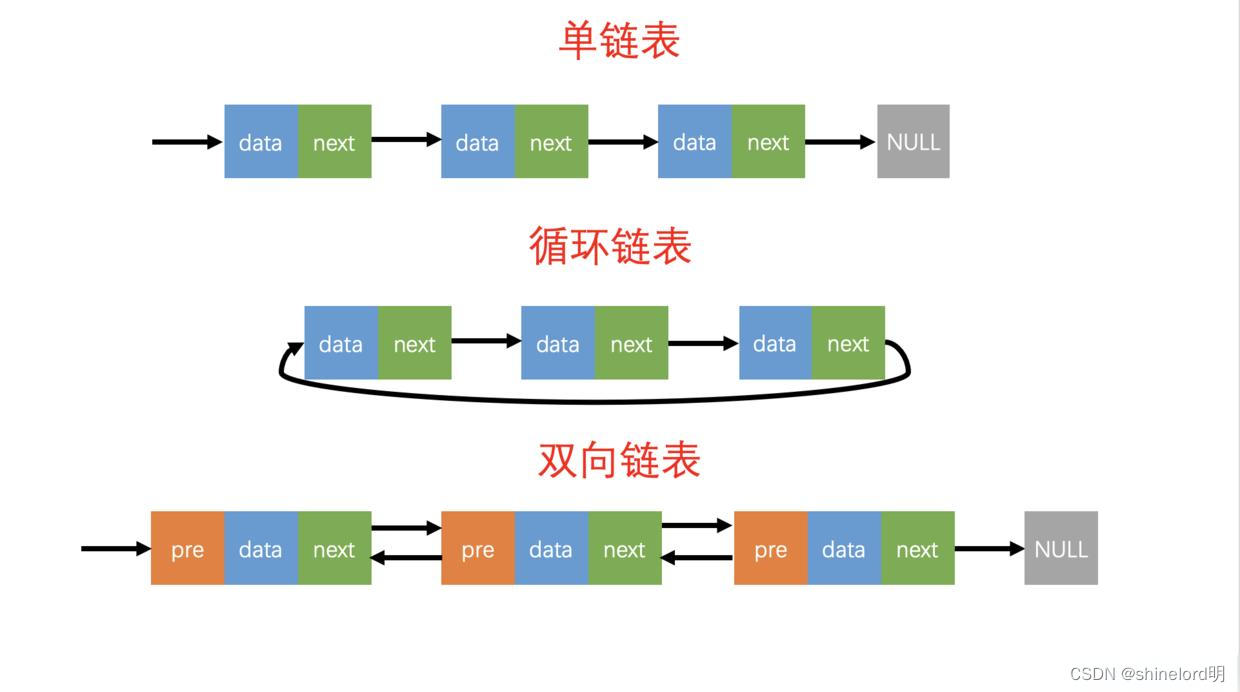

1、数组和链表算法

算法说明: 数组和链表是两种常见的线性数据结构,用于存储和组织数据。数组是一组连续的内存空间,而链表是一组通过指针相连的节点。

算法原理:

- 数组:在内存中分配一段连续的空间来存储元素,可以通过索引直接访问元素,插入和删除操作可能需要移动其他元素。

- 链表:由节点组成,每个节点包含数据和指向下一个节点的指针。插入和删除操作可以在O(1)时间内完成,但访问元素需要遍历链表,时间复杂度为O(n)。

时间复杂度:

- 数组:访问元素的时间复杂度为O(1),插入和删除操作的时间复杂度为O(n)。

- 链表:访问元素的时间复杂度为O(n),插入和删除操作的时间复杂度为O(1)。

空间复杂度:

- 数组和链表的空间复杂度都为O(n),取决于存储元素的数量。

代码示例: 简单Python示例,分别演示了数组和链表的基本操作:

# 数组示例

array = [1, 2, 3, 4, 5]

print("Array:", array)

array.append(6)

print("After appending 6:", array)# 链表示例

class ListNode:def __init__(self, val=0, next=None):self.val = valself.next = next# 创建链表

head = ListNode(1)

head.next = ListNode(2)

head.next.next = ListNode(3)# 插入节点

new_node = ListNode(4)

new_node.next = head.next

head.next = new_node# 打印链表

print("Linked List:")

current = head

while current:print(current.val, end=" -> ")current = current.next同类算法对比: 数组和链表都是线性数据结构,但它们在内存分配、操作效率等方面有所不同。其他类似的数据结构包括队列和栈。

应用场景介绍:

- 数组常用于需要快速随机访问元素的场景,例如矩阵操作、动态规划等。

- 链表常用于需要频繁插入和删除操作的场景,例如实现队列、栈、LRU缓存等。

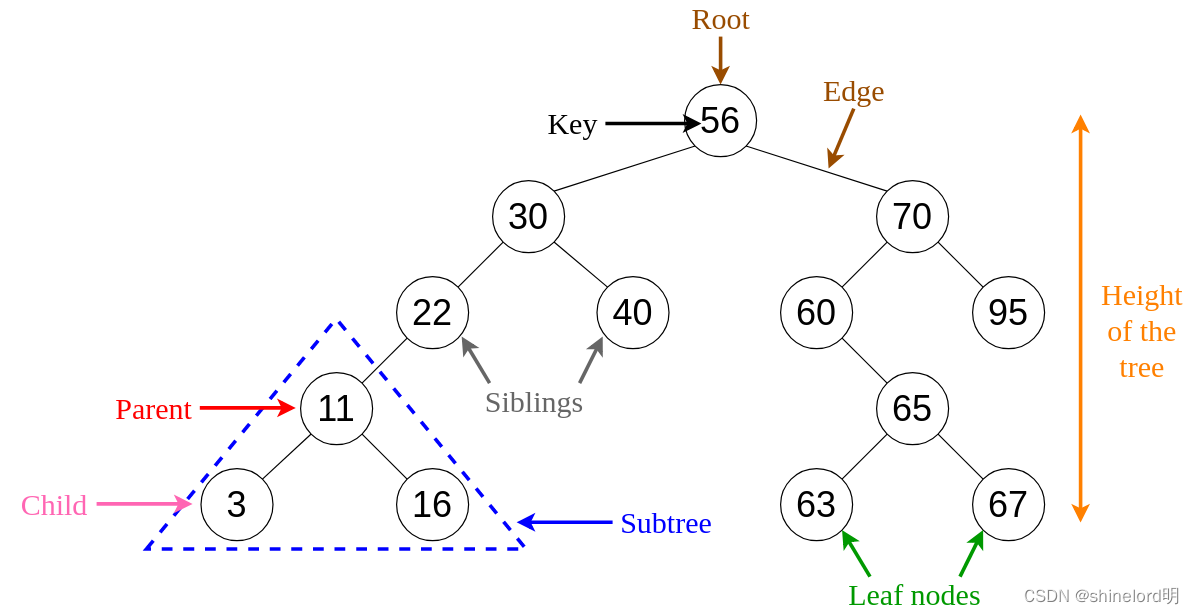

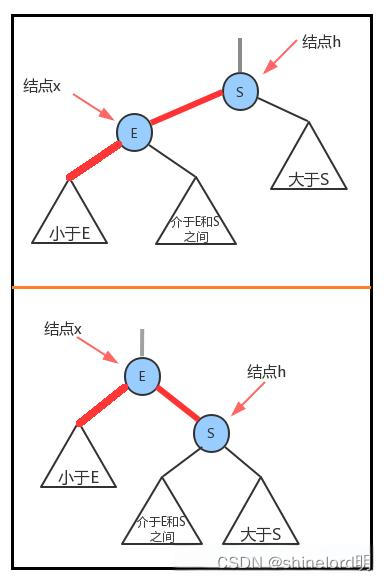

2、树和图算法

算法说明: 树和图是非线性数据结构,用于表示层级关系和网络关系。

算法原理:

- 树:由节点组成,每个节点最多有一个父节点和多个子节点。树可以分为二叉树、平衡树、二叉搜索树等。

- 图:由节点(顶点)和边组成,表示节点之间的关系。图可以分为有向图、无向图、加权图等。

时间复杂度:

- 树和图的算法时间复杂度因具体算法而异,通常取决于问题的规模和复杂度。

空间复杂度:

- 树和图的空间复杂度通常为O(n),取决于节点和边的数量。

代码示例: Python示例,演示了二叉树的创建和遍历操作:

class TreeNode:def __init__(self, val=0, left=None, right=None):self.val = valself.left = leftself.right = right# 创建二叉树

root = TreeNode(1)

root.left = TreeNode(2)

root.right = TreeNode(3)

root.left.left = TreeNode(4)

root.left.right = TreeNode(5)# 前序遍历

def preorder_traversal(node):if not node:returnprint(node.val, end=" ")preorder_traversal(node.left)preorder_traversal(node.right)print("Preorder traversal:")

preorder_traversal(root)同类算法对比:

- 树的常见操作包括遍历、搜索、插入、删除等,与树类似的数据结构还有二叉搜索树、平衡树等。

- 图的常见操作包括遍历、搜索、最短路径、最小生成树等,与图类似的数据结构还有有向图、加权图等。

应用场景介绍:

- 树常用于表示层级关系,例如文件系统、组织结构等。

- 图常用于表示网络关系,例如社交网络、路由器网络等。

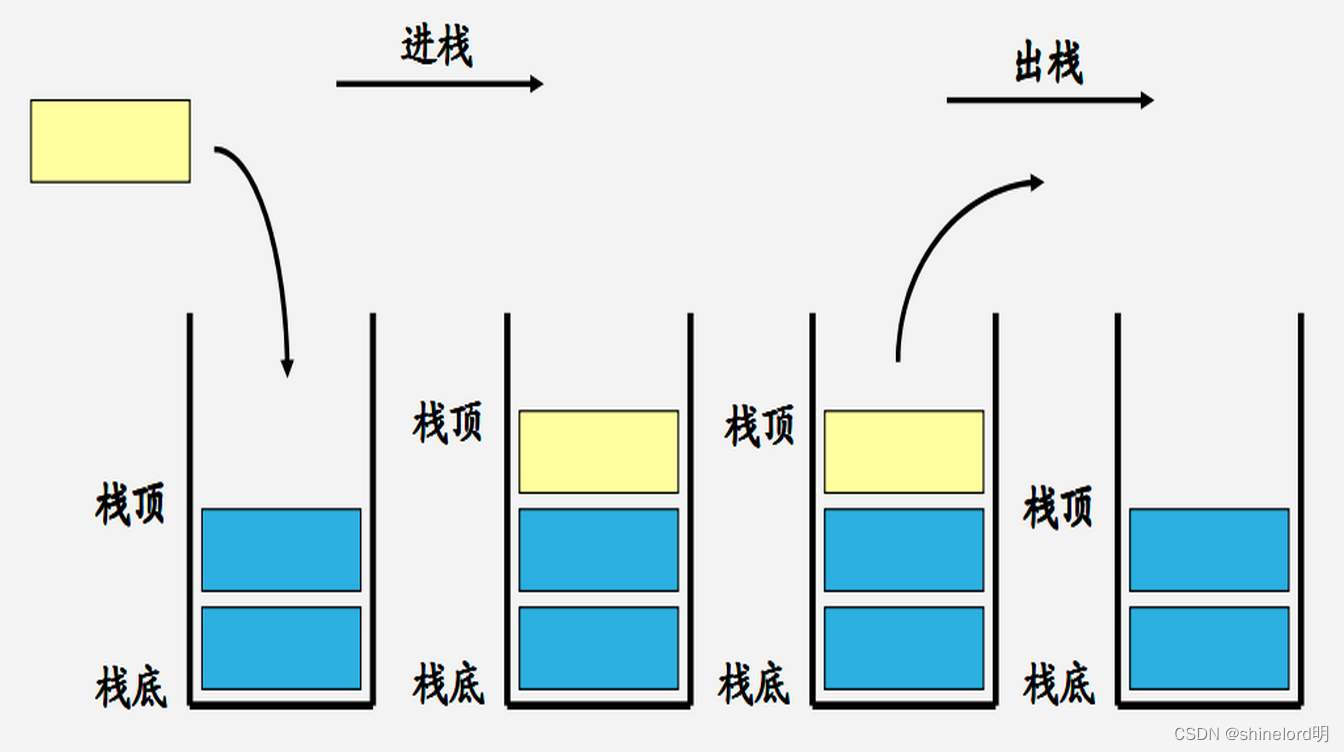

3、堆和栈算法

算法说明: 堆和栈都是基于数组或链表实现的数据结构,用于解决特定的问题。

算法原理:

- 堆:是一种特殊的树形数据结构,通常用于实现优先队列等问题。堆分为最大堆和最小堆,满足堆序性质。

- 栈:是一种后进先出(LIFO)的数据结构,只能在栈顶进行插入和删除操作。

时间复杂度:

- 堆和栈的操作时间复杂度取决于具体实现和操作。

空间复杂度:

- 堆和栈的空间复杂度通常为O(n),取决于元素数量。

代码示例:简单Python示例,分别演示了堆和栈的基本操作:

import heapq# 堆示例

heap = [4, 1, 7, 3, 8, 5]

print("Original heap:", heap)# 将列表转换为最小堆

heapq.heapify(heap)

print("Min heap:", heap)# 插入元素

heapq.heappush(heap, 2)

print("Heap after pushing 2:", heap)# 弹出最小元素

min_element = heapq.heappop(heap)

print("Min element popped:", min_element)

print("Heap after popping min element:", heap)# 栈示例

stack = []

print("Original stack:", stack)# 入栈操作

stack.append(1)

stack.append(2)

stack.append(3)

print("Stack after pushing elements:", stack)# 出栈操作

popped_element = stack.pop()

print("Popped element:", popped_element)

print("Stack after popping element:", stack)同类算法对比:

- 堆和栈都是基于数组实现的数据结构,但它们解决的问题不同。堆通常用于实现优先队列,而栈通常用于实现函数调用、表达式求值等。

- 堆和栈都可以通过数组或链表实现,但它们的操作效率和适用场景有所不同。

应用场景介绍:

- 堆常用于求解最小(大)值问题,例如求解Top K 问题、排序算法中的堆排序等。

- 栈常用于处理递归、表达式求值、括号匹配等问题,例如计算器实现、深度优先搜索等。

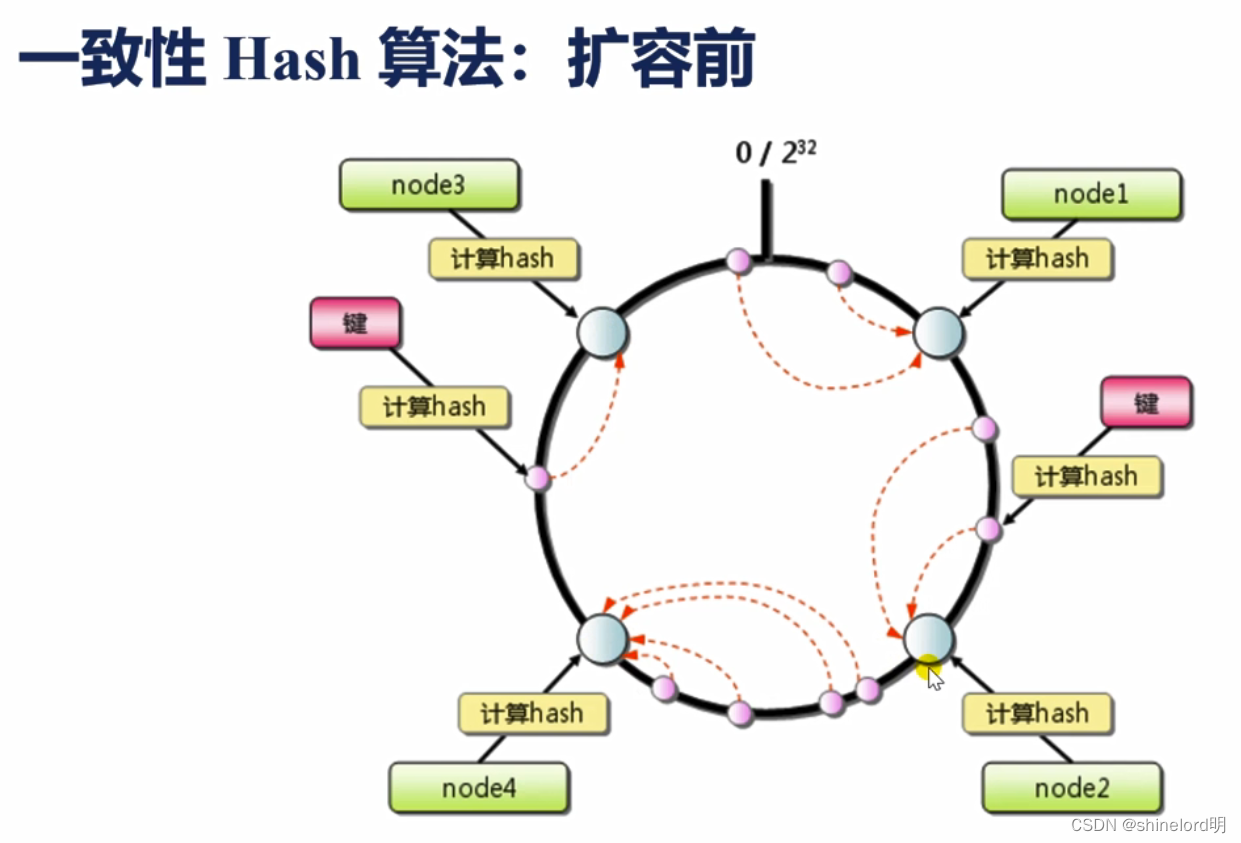

4、哈希表算法

算法说明: 哈希表(Hash Table)是一种用于存储键值对的数据结构,通过哈希函数将键映射到存储桶(Bucket)中,以实现快速的插入、删除和查找操作。

算法原理:

- 哈希函数:将键映射到存储桶的过程称为哈希函数。哈希函数应该具有良好的分布特性,尽可能地避免冲突。

- 冲突处理:当多个键映射到同一个存储桶时,需要采取冲突处理策略,常见的策略包括链地址法(Separate Chaining)和开放地址法(Open Addressing)。

时间复杂度:

- 插入、删除和查找操作的平均时间复杂度为O(1),但在最坏情况下可能达到O(n)。这取决于哈希函数的质量、冲突处理策略以及负载因子等因素。

空间复杂度:

- 哈希表的空间复杂度取决于存储桶的数量和存储元素的数量,通常为O(n)。

代码示例: 简单Python示例,演示了哈希表的基本操作:

class HashTable:def __init__(self, size):self.size = sizeself.table = [None] * sizedef _hash(self, key):return hash(key) % self.sizedef insert(self, key, value):index = self._hash(key)if not self.table[index]:self.table[index] = []self.table[index].append((key, value))def get(self, key):index = self._hash(key)if self.table[index]:for k, v in self.table[index]:if k == key:return vreturn None# 创建哈希表

hash_table = HashTable(5)

hash_table.insert("apple", 10)

hash_table.insert("banana", 20)

hash_table.insert("orange", 30)# 查找元素

print("Value for 'banana':", hash_table.get("banana"))

print("Value for 'grape':", hash_table.get("grape"))同类算法对比:

- 哈希表的同类算法包括其他基于哈希函数的数据结构,如哈希集合、哈希集合映射等。

- 相比于平衡树(如红黑树),哈希表通常具有更好的平均性能,尤其是在插入、删除和查找操作方面。

应用场景介绍:

- 哈希表常用于需要快速查找的场景,如数据库索引、缓存实现、字典数据结构等。

- 哈希表也常用于解决大规模数据处理问题,如分布式系统中的数据分片、分布式缓存等。

按应用领域分类

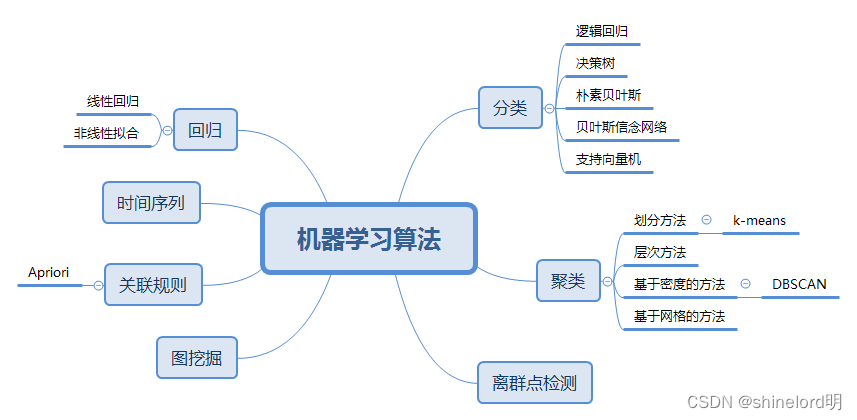

1、机器学习算法

算法说明: 机器学习算法是一类通过数据学习模型,从而实现预测、分类、聚类等任务的算法。

算法原理:

- 监督学习:利用带标签的数据训练模型,使其学习输入与输出之间的映射关系,常见的算法包括线性回归、逻辑回归、决策树、支持向量机等。

- 无监督学习:使用无标签的数据训练模型,寻找数据中的隐藏结构,常见的算法包括聚类、降维、关联规则挖掘等。

- 强化学习:通过与环境的交互学习最优的行为策略,常见的算法包括Q学习、深度强化学习等。

时间复杂度和空间复杂度: 机器学习算法的时间复杂度和空间复杂度因算法而异,通常取决于模型的复杂度、数据量和特征维度等因素。

代码示例: 简单的Python示例,使用Scikit-learn库实现线性回归算法:

from sklearn.linear_model import LinearRegression

import numpy as np# 生成随机数据

X = np.random.rand(100, 1)

y = 2 * X + np.random.randn(100, 1)# 创建模型并训练

model = LinearRegression()

model.fit(X, y)# 预测

new_X = np.array([[0.5]])

prediction = model.predict(new_X)

print("Prediction for {}: {}".format(new_X[0][0], prediction[0][0]))同类算法对比:

- 在监督学习中,线性回归和逻辑回归是两种常见的回归和分类算法,各有优劣。线性回归适用于线性关系的预测,而逻辑回归适用于二分类问题。

- 在无监督学习中,K均值聚类和DBSCAN聚类是两种常见的聚类算法,各有适用场景。K均值适用于凸形簇,而DBSCAN适用于发现任意形状的簇。

应用场景介绍:

- 机器学习算法广泛应用于各种领域,包括自然语言处理、计算机视觉、医疗诊断、金融风控等。例如,医疗诊断可以利用监督学习算法从医学影像中识别疾病,金融风控可以利用无监督学习算法检测异常交易。

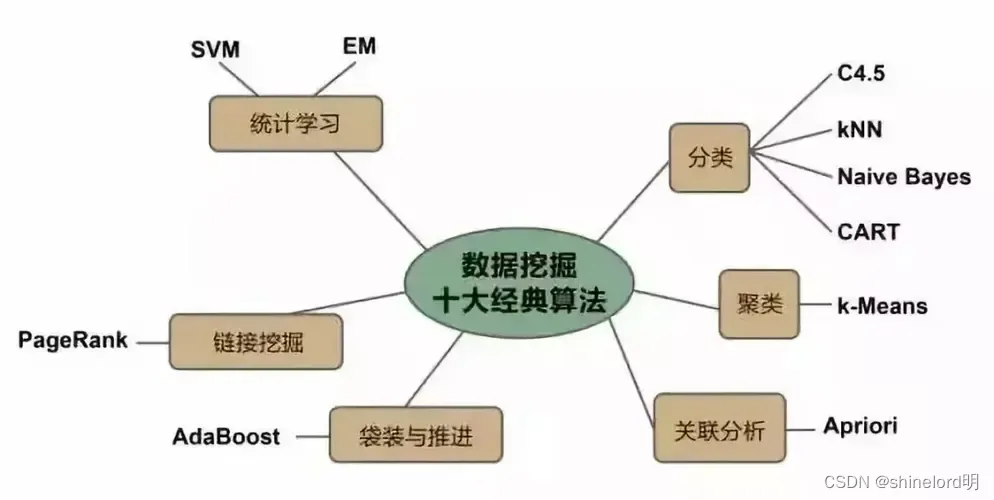

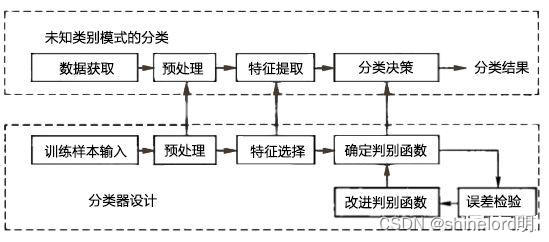

2、数据挖掘算法

算法说明: 数据挖掘算法是一类从大规模数据集中提取模式、关系或其他有用信息的技术。

算法原理:

- 聚类算法:将数据集中的对象划分为若干组,使得同一组内的对象相似度较高,不同组之间的对象相似度较低。常见的算法包括K均值聚类、DBSCAN、层次聚类等。

- 分类算法:建立分类模型,将数据集中的对象划分为预定义的类别之一。常见的算法包括决策树、朴素贝叶斯、支持向量机等。

- 关联规则挖掘算法:发现数据集中的项之间的关联关系,常见的算法包括Apriori算法、FP-growth算法等。

时间复杂度和空间复杂度: 数据挖掘算法的时间复杂度和空间复杂度因算法而异,取决于数据集的大小、维度和算法的复杂度。

代码示例: 下面是一个简单的Python示例,使用Scikit-learn库实现K均值聚类算法:

from sklearn.cluster import KMeans

import numpy as np# 生成随机数据

X = np.random.rand(100, 2)# 创建模型并训练

kmeans = KMeans(n_clusters=3)

kmeans.fit(X)# 预测

labels = kmeans.labels_

print("Cluster labels:", labels)同类算法对比:

- 在聚类算法中,K均值聚类、层次聚类和DBSCAN是常见的算法,各有适用场景。K均值聚类适用于凸形簇,层次聚类适用于发现层次结构,DBSCAN适用于发现任意形状的簇。

- 在分类算法中,决策树、朴素贝叶斯和支持向量机是常见的算法,各有优劣。决策树易于理解和解释,朴素贝叶斯适用于文本分类,支持向量机适用于高维数据。

- 在关联规则挖掘算法中,Apriori算法和FP-growth算法是常见的算法,各有优劣。Apriori算法适用于稀疏数据,FP-growth算法适用于稠密数据。

应用场景介绍:

- 数据挖掘算法广泛应用于市场营销、电子商务、社交网络分析等领域。例如,电子商务可以利用关联规则挖掘算法发现商品之间的关联关系,从而进行交叉销售;社交网络分析可以利用聚类算法发现社交网络中的社区结构,从而识别关键节点。

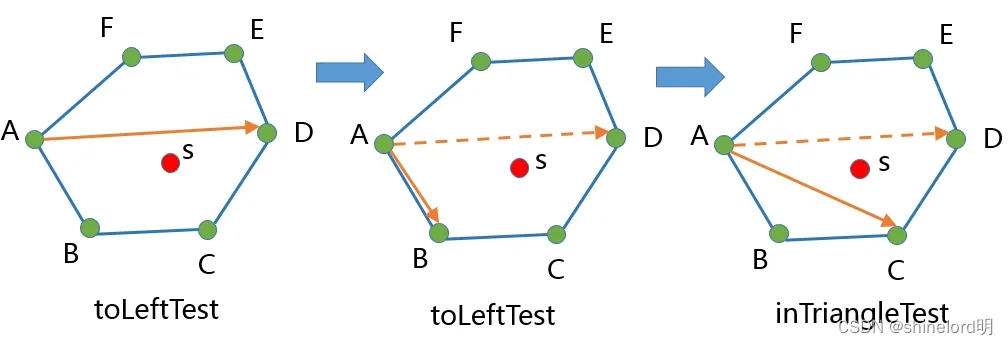

3、计算几何算法

凸包算法(Graham Scan)

算法说明:凸包问题是在计算几何中常见的问题之一。凸包可以定义为包围给定点集的最小凸多边形。

算法原理:Graham扫描算法首先找到所有点中y坐标最小的点(基准点)。然后以基准点为起点,按照各点相对于此点的极角大小进行排序。最后,通过一次扫描,使用一个栈来构建凸包,依次判断每个点与栈顶两点是否构成一个左转,如果不是则栈顶点将被弹出。

时间复杂度:排序步骤的时间复杂度为 (O(n \log n)),扫描步骤的时间复杂度为 (O(n)),因此总的时间复杂度为 (O(n \log n))。

空间复杂度:(O(n)),因为需要存储所有点和栈空间。

代码举例(Python):

def graham_scan(points):# 基准点start = min(points, key=lambda p: (p[1], p[0]))points.pop(points.index(start))# 按极角排序points.sort(key=lambda p: (atan2(p[1] - start[1], p[0] - start[0]), -p[0]))# 构建凸包stack = [start]for point in points:while len(stack) > 1 and cross_product(stack[-2], stack[-1], point) <= 0:stack.pop()stack.append(point)return stackdef cross_product(o, a, b):return (a[0] - o[0]) * (b[1] - o[1]) - (a[1] - o[1]) * (b[0] - o[0])# 示例点集

points = [(0, 0), (4, 4), (1, 2), (3, 1), (3, 3)]

convex_hull = graham_scan(points)

print(convex_hull)同类算法对比:

- Andrew's Monotone Chain Algorithm:也是 (O(n \log n)) 时间复杂度,但通常在实际应用中更简单且效率更高。

- Jarvis March Algorithm:时间复杂度为 (O(nh)),其中 (h) 是凸包上的点数,适用于 (h) 较小的情况。

应用场景:凸包算法在图形处理、计算机视觉、多边形操作、碰撞检测等领域有广泛应用。

4、模式识别算法

K-最近邻 (K-NN)

算法说明:K-最近邻是一种基于实例的学习方法,可用于分类和回归。

算法原理:在给定一个查询点后,算法找出训练集中距离该点最近的 (k) 个点,并基于这些邻近点的标签来预测查询点的标签。

时间复杂度:在没有索引结构的情况下,时间复杂度为 (O(n))。如果使用如KD-树等结构,可以降至 (O(\log n)),但这依赖于数据维度和分布。

空间复杂度:(O(n)),因为需要存储整个训练集。

代码举例(Python):

from sklearn.neighbors import KNeighborsClassifier# 训练数据

X = [[0], [1], [2], [3]]

y = [0, 0, 1, 1]# 创建和训练模型

neigh = KNeighborsClassifier(n_neighbors=3)

neigh.fit(X, y)# 预测

print(neigh.predict([[1.1]]))同类算法对比:

- 支持向量机(SVM):更适合高维空间的分类问题,复杂度依赖于支持向量的数量,而不是整个数据集。

- 决策树:更快的训练时间,但可能在高维数据上过拟合。

应用场景:

K-NN广泛应用于推荐系统、图像识别和分类问题,在医疗诊断、股票市场分析等领域也有应用。

)

详解)

)