0. 简介

多视角聚合技术有望克服多目标检测和跟踪中的遮挡和漏检问题。最近的多视角检测和三维物体检测方法通过将所有视角投影到地面平面上,并在鸟瞰图中进行检测,取得了巨大的性能提升。《EarlyBird: Early-Fusion for Multi-View Tracking in the Bird’s Eye View》研究了在**鸟瞰图中进行跟踪是否也能在多目标多摄像头跟踪中带来下一次性能突破。**目前大多数多视角跟踪方法在每个视角上执行检测和跟踪任务,并使用基于图的方法在每个视角上进行行人关联。这种空间关联已经通过在鸟瞰图中检测每个行人一次来解决,只剩下时间关联的问题。对于时间关联,我们展示了如何为每个检测学习强大的重新识别(re-ID)特征。当前代码也已经在Github上开源了

1. 主要贡献

-

本文在鸟瞰图中引入了早期融合跟踪,并采用了简单但强大的re-ID关联策略。

-

本文为BEV特征引入了更强大的解码器架构,从而改善了本文的跟踪结果和检测。

-

在本文的实验中,本文定性和定量地验证了本文的方法相对于最近相关方法的有效性,并通过 +4.6 MOTA 和 +5.6 IDF1 提高了 Wildtrack 跟踪的SOTA。

2. 整体框架

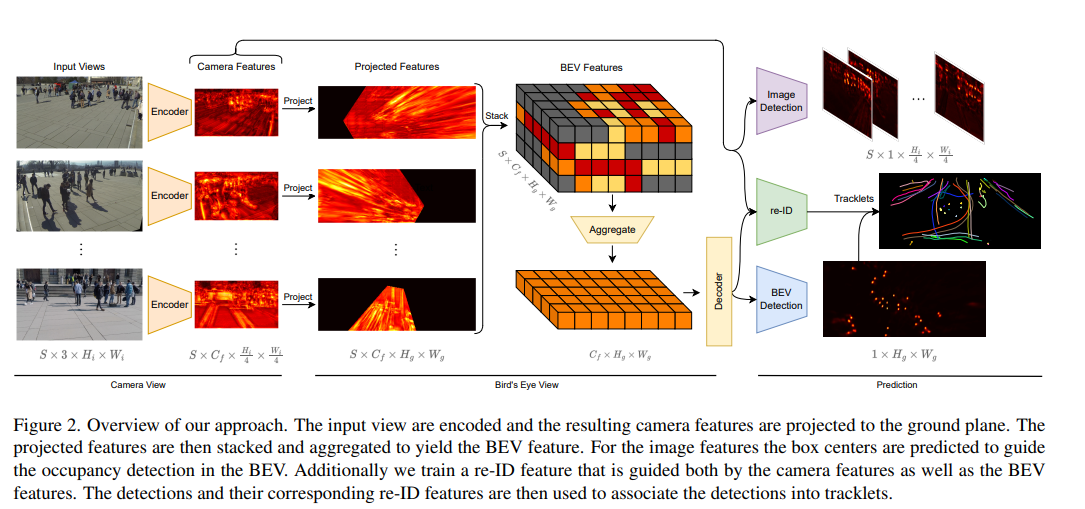

我们在图2中提供了EarlyBird的全面概述。它从输入图像开始,经过增强处理后,输入到编码器网络中,生成我们的图像特征。图像特征的大小是输入图像的四分之一。然后,将所有摄像头的图像特征投影到地面平面,并堆叠到BEV空间中。接下来,BEV空间在垂直维度上进行降维处理。最后,将BEV特征输入到解码器网络中。图像特征和BEV特征都有用于中心和偏移检测的独立头部,但共享一个用于重新识别预测的头部。

图2. 我们方法的概述。输入视图被编码,生成的相机特征被投影到地面平面上。然后将投影特征堆叠和聚合,得到BEV特征。对于图像特征,预测盒子中心以指导BEV中的占用检测。此外,我们训练了一个re-ID特征,该特征既受相机特征的引导,也受BEV特征的引导。然后使用检测和相应的re-ID特征将检测关联成轨迹片段。

3. 编码器

我们的方法假设从S个相机获取的RGB输入图像是同步的,输入大小为 3 × H i × W i 3 × H_i × W_i 3×Hi×Wi。我们使用ResNet或Swin Transformer网络对图像进行特征编码,使用网络的三个块,每个块将输入下采样2倍。我们的目标是将图像仅缩小4倍,因此我们对每个层的输出特征进行上采样和拼接,直到获得 C f × H f × W f C_f × H_f × W_f Cf×Hf×Wf的输出,其中 H f = H i / 4 , W f = W i / 4 , C f = 128 H_f = H_i/4,W_f = W_i/4,C_f = 128 Hf=Hi/4,Wf=Wi/4,Cf=128。

分享好用的ChatGPT)

【二】)

)

Qt编译 MySQL(8.0以上版本)链接库 Qt版本 5.12.12及以上 包含Mysql动态库缺失问题)

—— wasmtime实现合约引擎补充)

)