- B站:啥都会一点的研究生

- 公众号:啥都会一点的研究生

距离MobileNet系列上一代版本MobileNet V3的发布已经过去五年

熟悉该系列的同学应该知道,MobileNet致力于维持神经网络在精度和效率之间的微妙平衡,为了让用户在移动设备上拥有快速、实时和交互式的体验,谷歌推出了MobileNet V4——专为移动设备设计的通用高效架构

研究团队预计这一开创性贡献和分析框架将推动移动计算机视觉领域的进一步发展

MobileNet V4(MNv4)的核心在于通用倒置颈结构(Universal Inverted Bottleneck, UIB)和Mobile MQA两大模块,搭配优化后的神经网络架构搜索(NAS)配方

作者仍然基于MobileNet的经典组件如可分离的深度卷积(DW)和逐点(PW)扩展及投影倒置瓶颈块,引入了通用倒置颈结构(UIB)。这个结构相当简单,在倒置瓶颈块中引入了两个可选的深度卷积(DW),一个位于扩展层之前,另一个位于扩展层和投影层之间。这两个深度卷积的存在与否是神经架构搜索(NAS)优化过程的一部分,最终会生成新颖的网络架构。尽管这个修改看似简单,但作者却巧妙地统一了几个重要的模块,包括原始的倒置颈结构、ConvNext以及ViT中的FFN。此外,UIB还引入了一个新的变体:ExtraDW

在神经网络架构搜索过程中灵活的构建倒置颈结构,从而消除了手动制定缩放规则的需要。此外,结合基于SuperNet的神经网络架构搜索算法,这种方法实现了跨不同实例化的参数共享(>95%),使得NAS效率极高

与UIB相辅相成的是Mobile MQA,设计了一个专为加速器设计的开创性注意力块,实现高达39%的推理加速。此外,还引入一种优化的神经网络架构搜索(NAS)配方,提高了MNv4搜索的有效性

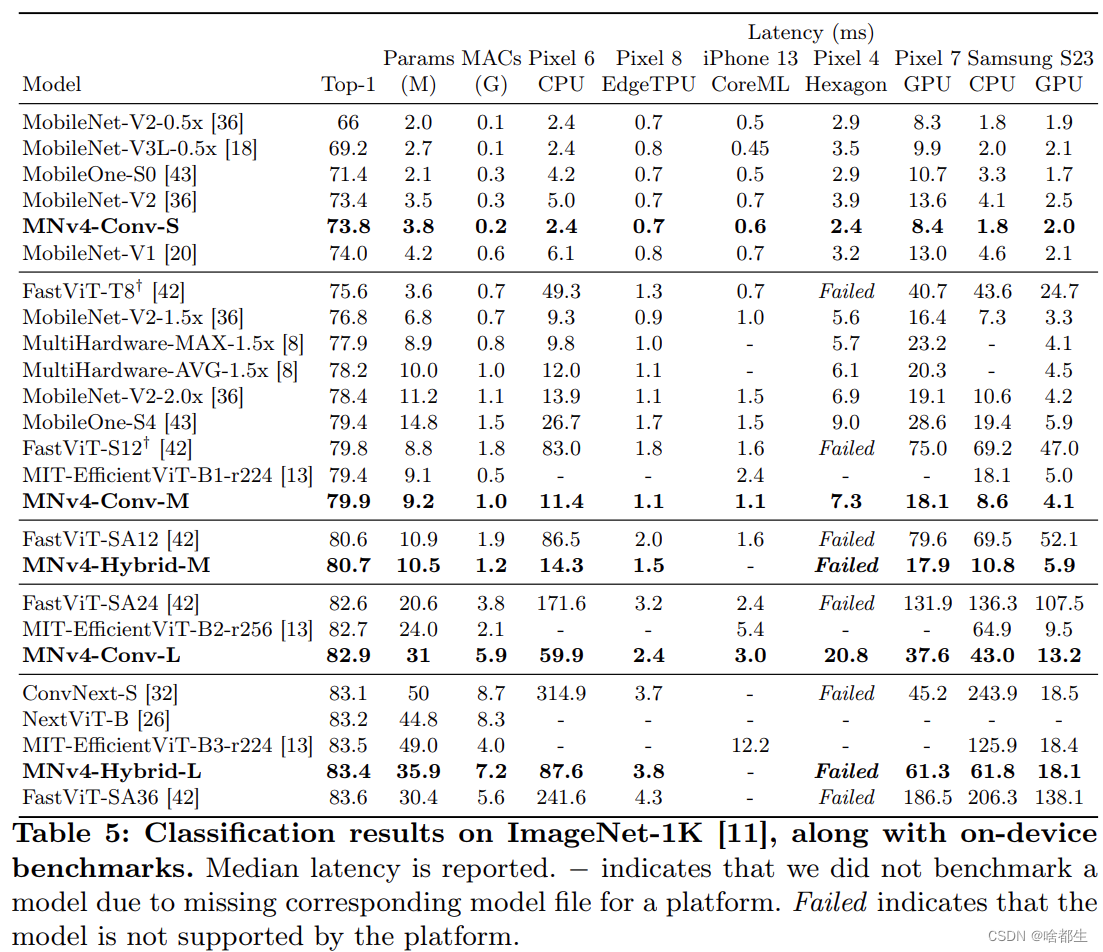

UIB、Mobile MQA和精细化NAS的融合,催生了一系列新颖的MNv4模型,这些模型在移动CPU、DSP、GPU以及如Apple Neural Engine和Google Pixel EdgeTPU等专用加速器上均表现出优异的性能

MNv4在Pixel 8 EdgeTPU上实现了87%的ImageNet-1K准确率,延迟仅为3.8毫秒,标志着移动计算机视觉能力取得了重大进展

感兴趣的赶紧动起来,创新点有了(dog),paper又不远了

pdf - https://arxiv.org/pdf/2404.10518.pdf

GitHub - https://github.com/tensorflow/models/blob/master/official/vision/modeling/backbones/mobilenet.py

)

![[Flutter3] 记录Dio的简单封装(一)](http://pic.xiahunao.cn/[Flutter3] 记录Dio的简单封装(一))

)

,这里只做个人理解笔记)