🚀 写在最前:这篇文章将学习如何运行ChatGML-6B大模型。

🚀:点个关注吧😀,让我们一起探索计算机的奥秘!

一、ChatGML-6B大模型介绍

ChatGML-6B 是一个大型语言模型,被训练来预测人类语言。它是基于 GPT 模型的一种改进版本,拥有 6.3 亿个参数,是当前最大规模的中文语言模型之一。ChatGML-6B 模型由清华大学 KEG 实验室和智谱AI共同训练,拥有强大的语言理解和生成能力。

二、环境配置

①ChatGML-6B大模型的下载

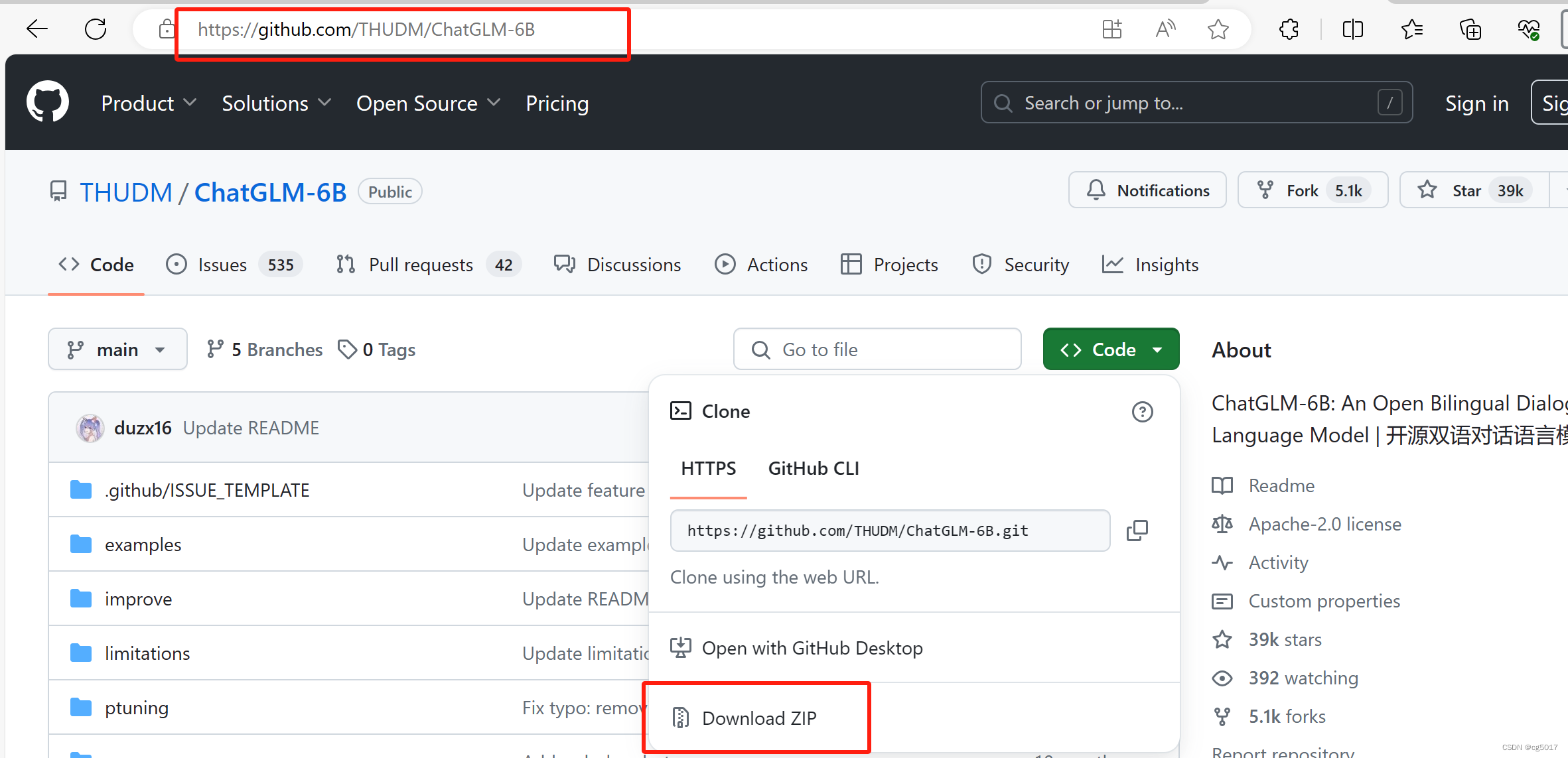

下载网址:/THUDM/ChatGLM-6B.

点击Dwonload ZIP,下载这个模型,并解压。

②TDM-GCC安装

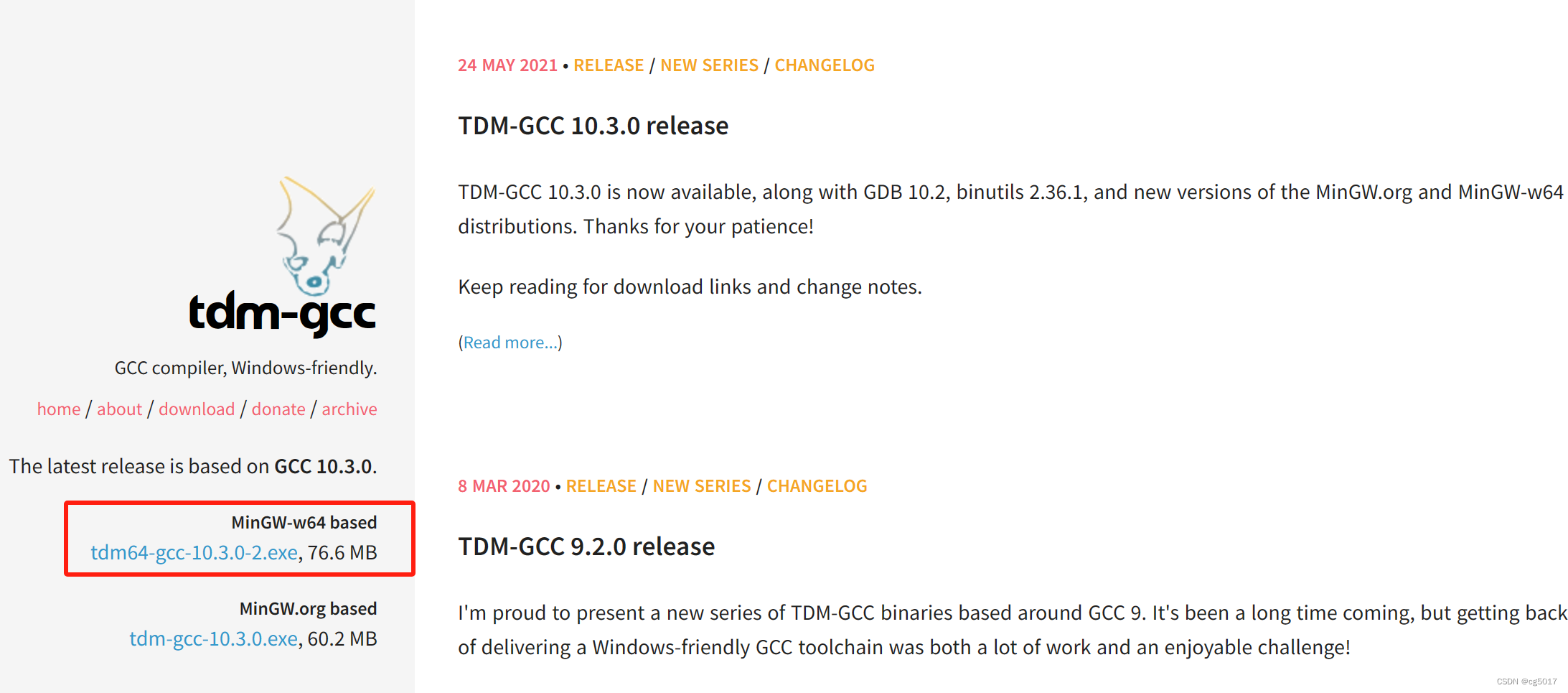

CPU部署ChatGLM-6B要涉及到一个kernel的编译问题。这样CPU部署的话就需要安装C/C++的编译环境。 这里推荐安装TDM-GCC,网址:/tdm-gcc/.

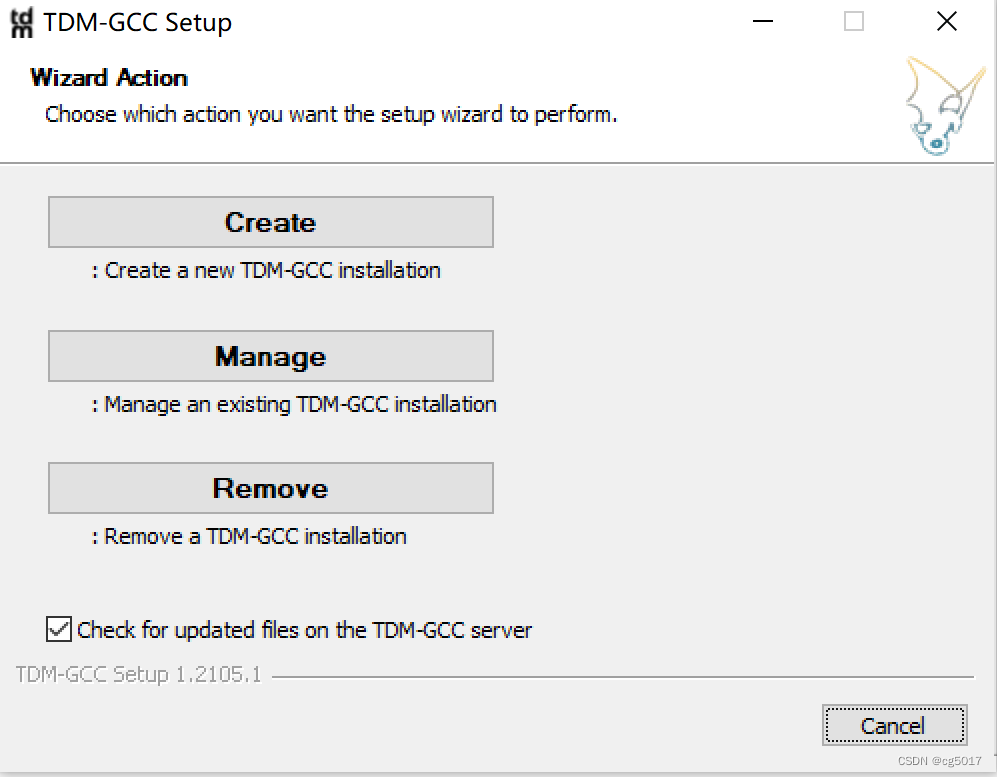

双击下载好的.exe文件,开始安装tdm-gcc。点击下面的create

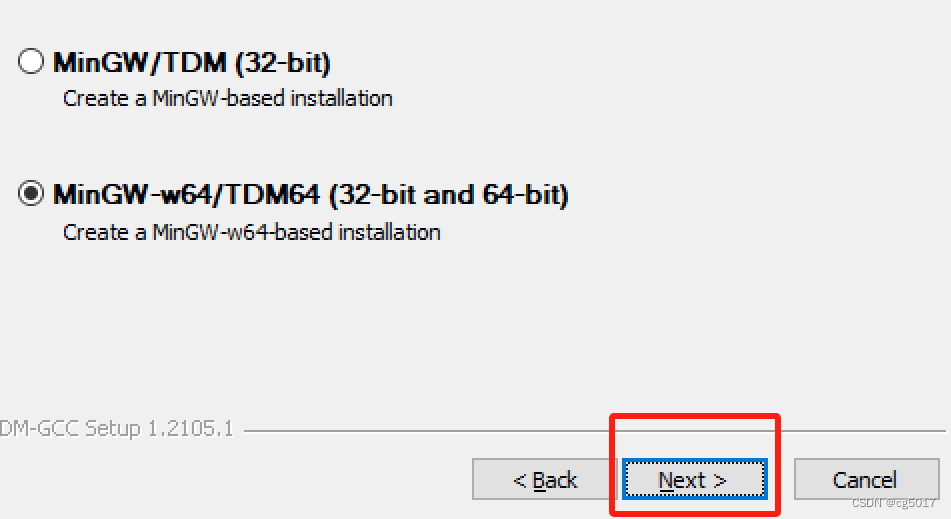

点击next

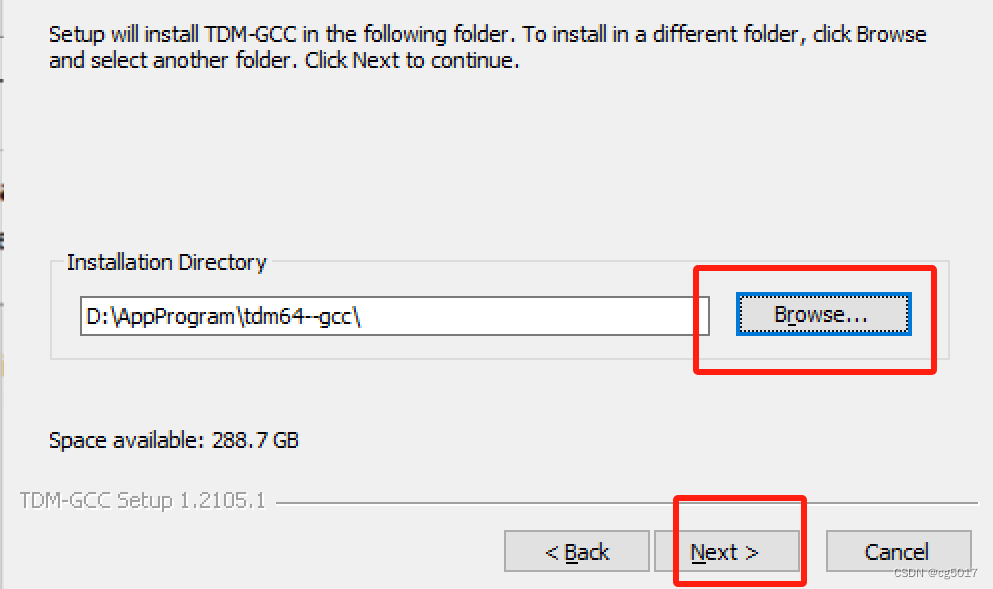

选择你想安装的路径,点击next

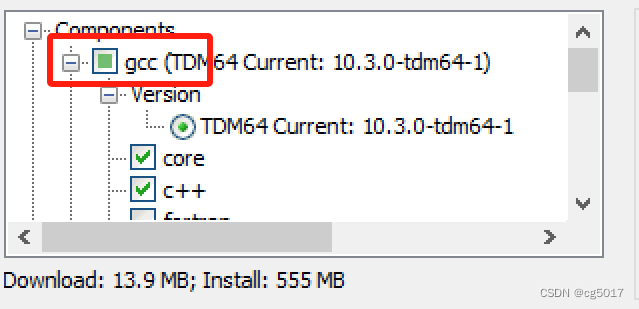

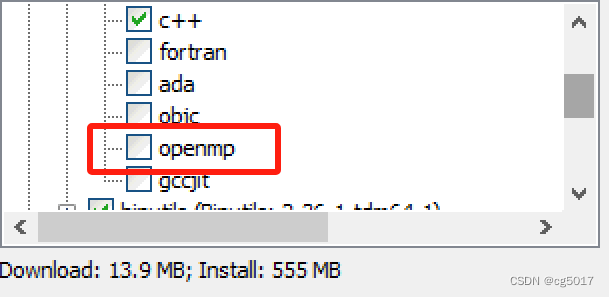

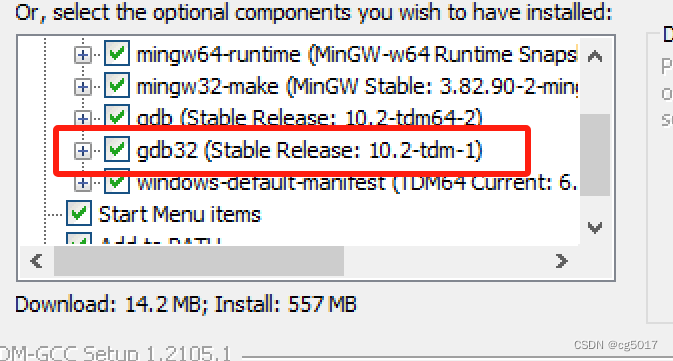

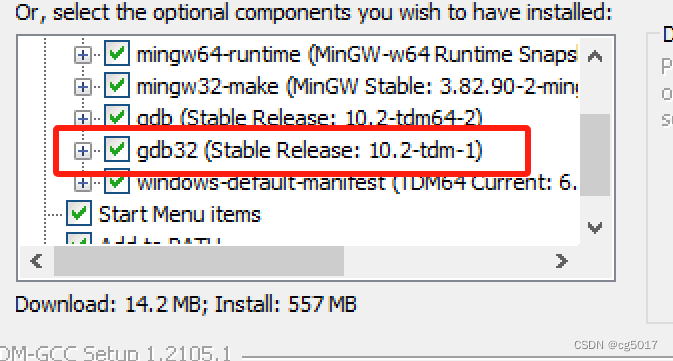

首先必须勾选openMP,先把gcc打开,然后往下翻,勾选openMP,同样的还得勾选gdb32 (Stable Release: 10.2-tdm-1)

选择好后,点击Install等待一会它的安装,安装完成后就会显示如下界面。

最后点击finish就行。

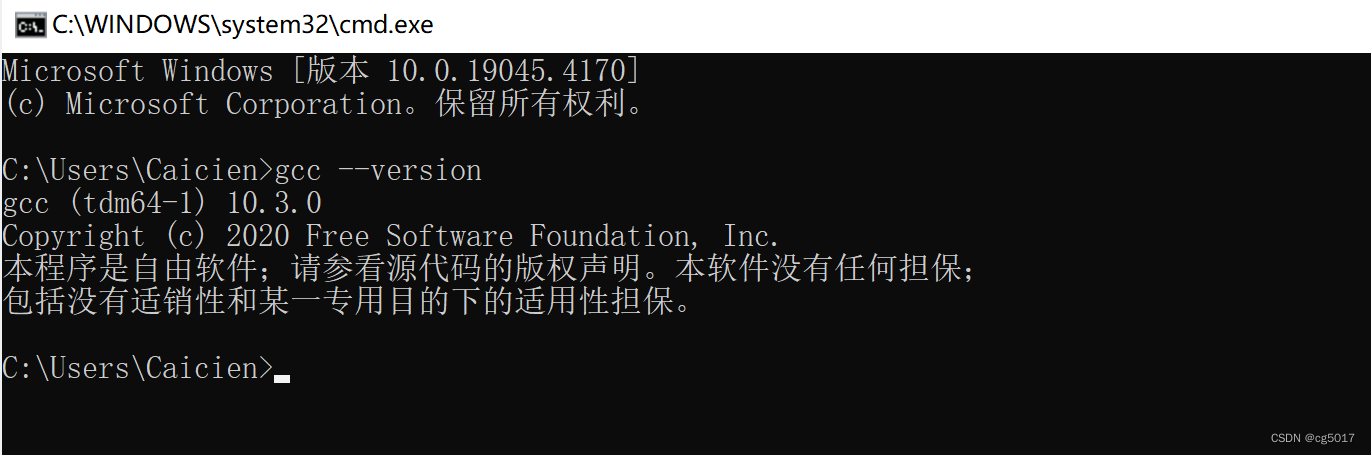

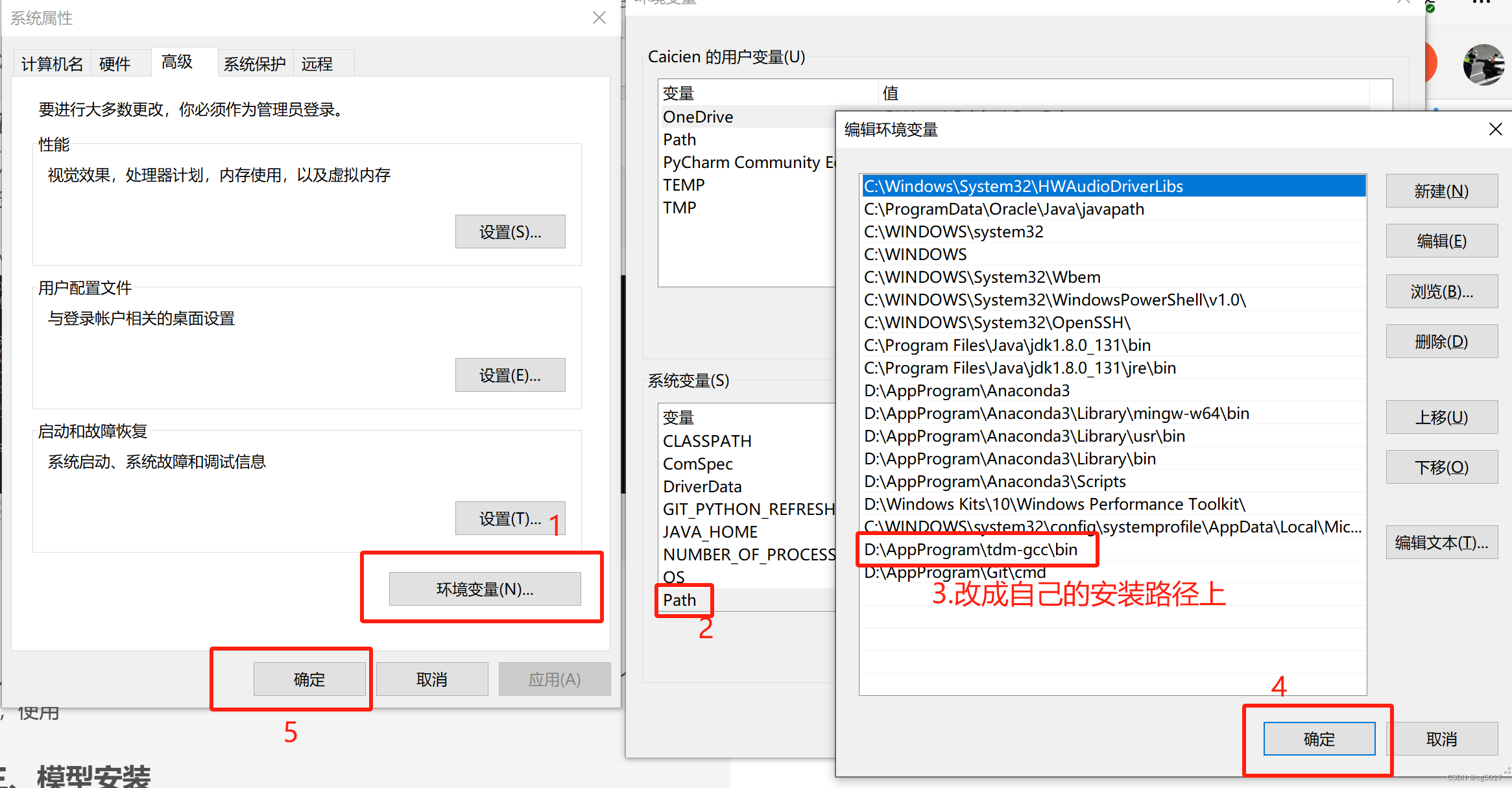

检查是否安装成功,win+r 输入cmd然后输入gcc --version,如显示为以下内容即表示安装成功,若没有显示,添加环境变量。

配置环境变量完成后,再次cmd中输入上述命令,直到显示上述内容则表示安装成功。

③Anaconda安装

对于人工智能大模型,每次运行都必须给其创建一个专属于它的自己的一个运行环境,使用Anaconda为ChatGML-6B创建属于它自己的运行环境。

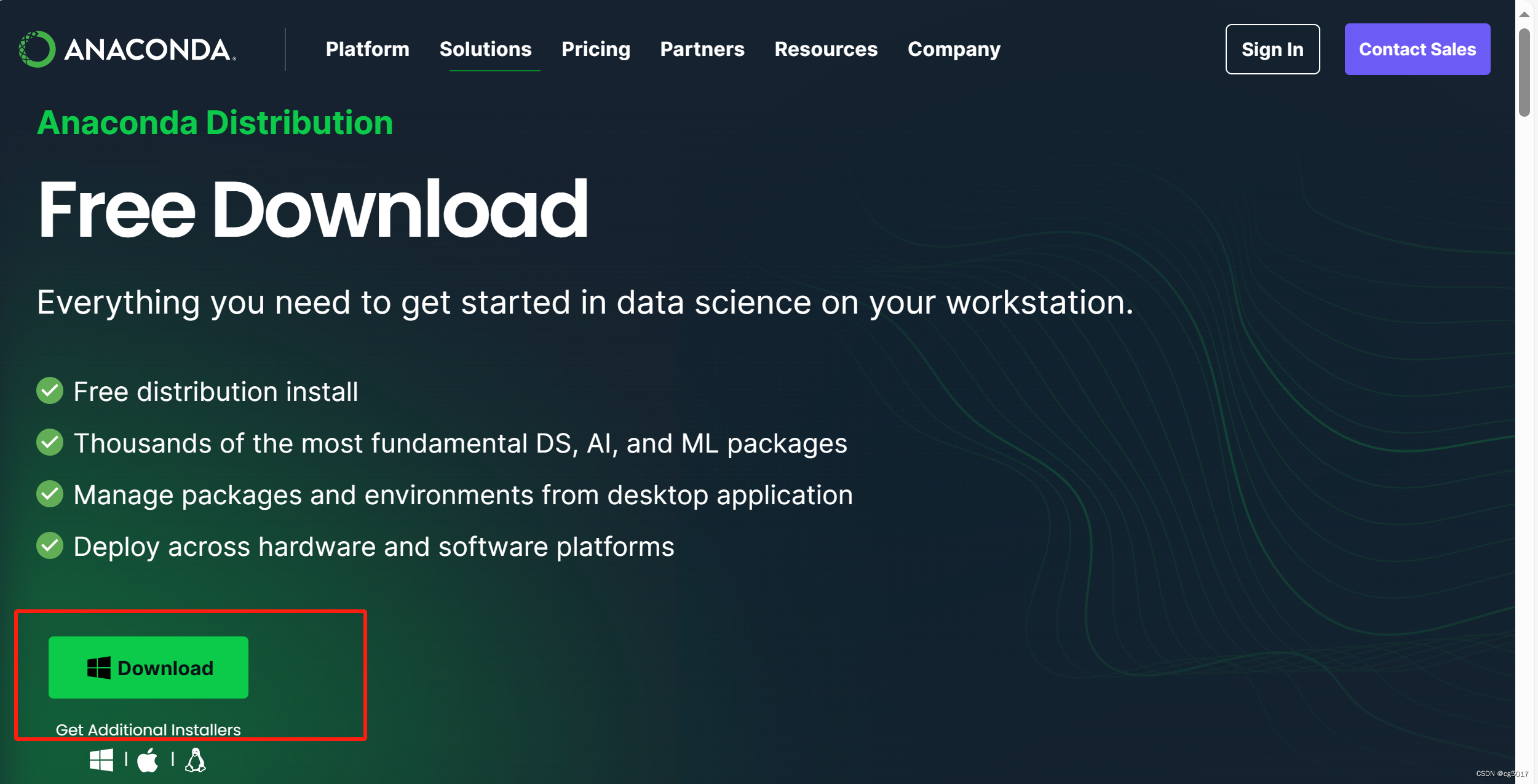

Anaconda下载链接:Anaconda.

直接点击下载即可!安装很无脑,基本直接下一步即可,推荐安装在C盘。以下是具体安装步骤。

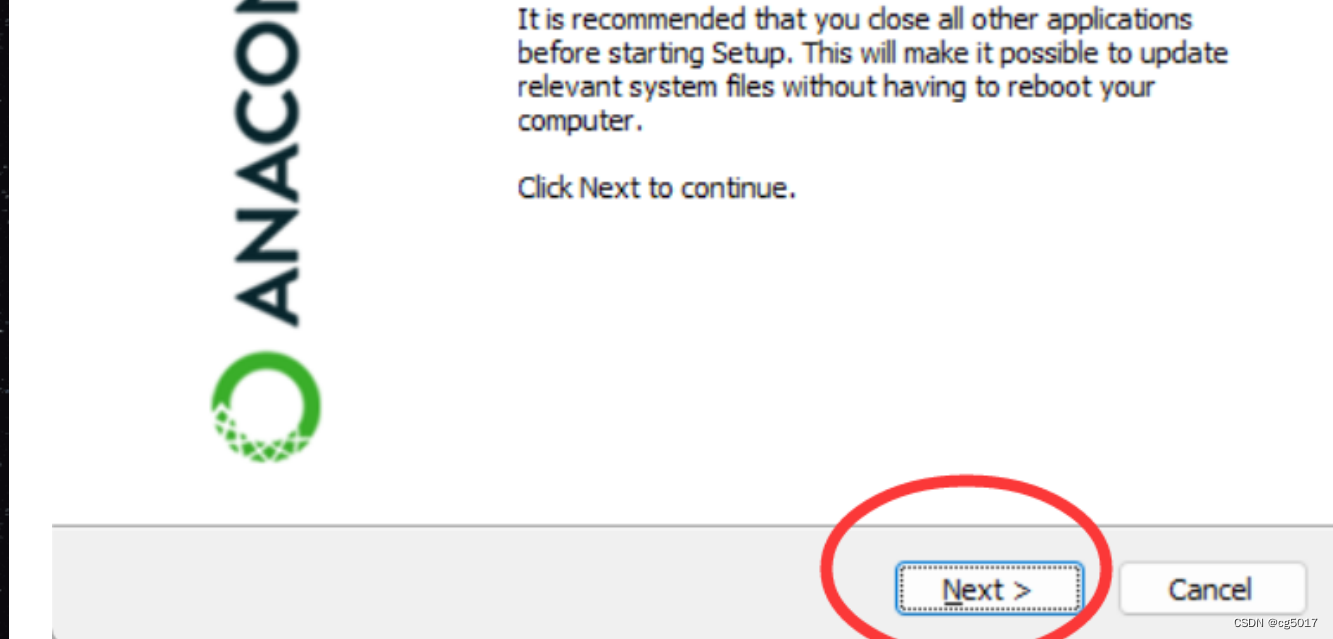

🚀 1)双击下载好的.exe文件,会弹出如下窗口,点击next。

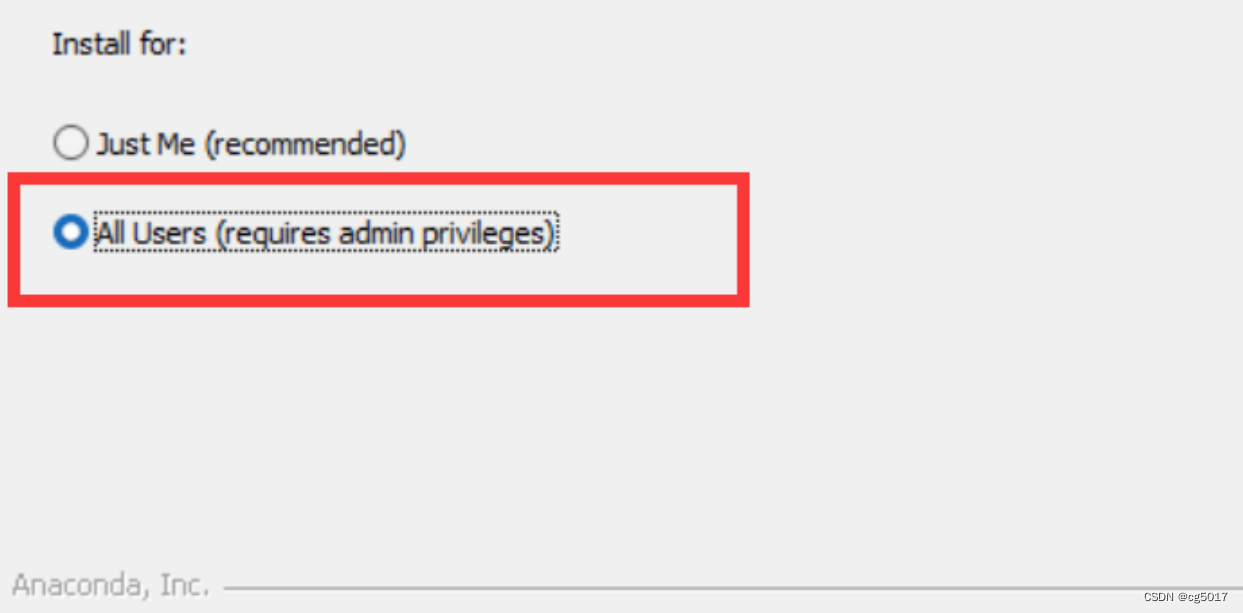

🚀 2)点击 I agree,然后选择ALL User。

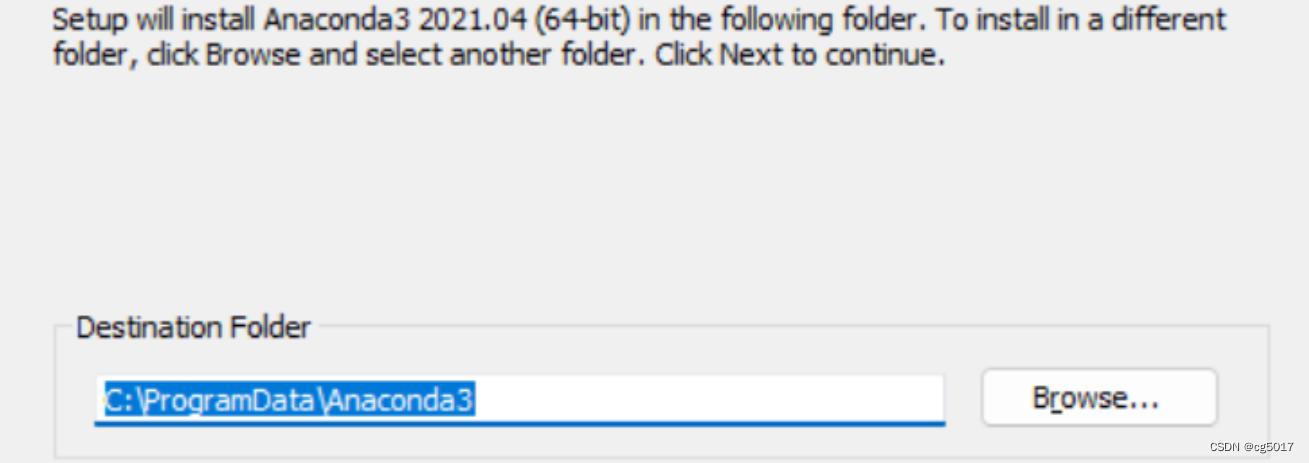

🚀 3)这里建议放C盘,因为我之前没放C盘,出现了一些奇怪的错误解决不了,不过我现在还是没放C盘,这个大家自行选择即可。

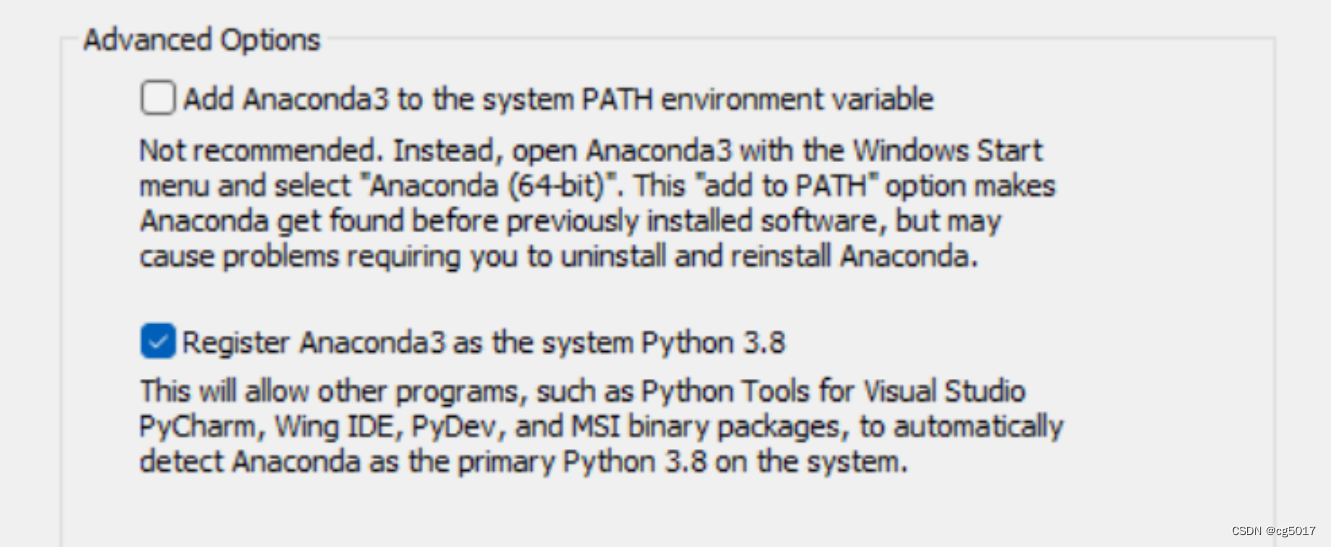

🚀 4)这里直接两个都勾选上,第一个是添加环境变量,建议勾上,不勾的话,后面得自己去path里配环境变量,第二个是默认勾上的,就让他勾上。

🚀 5)安装中,等待一会就好。

🚀 6)恭喜你,这样安装就完成了!!!completed successfully!!!

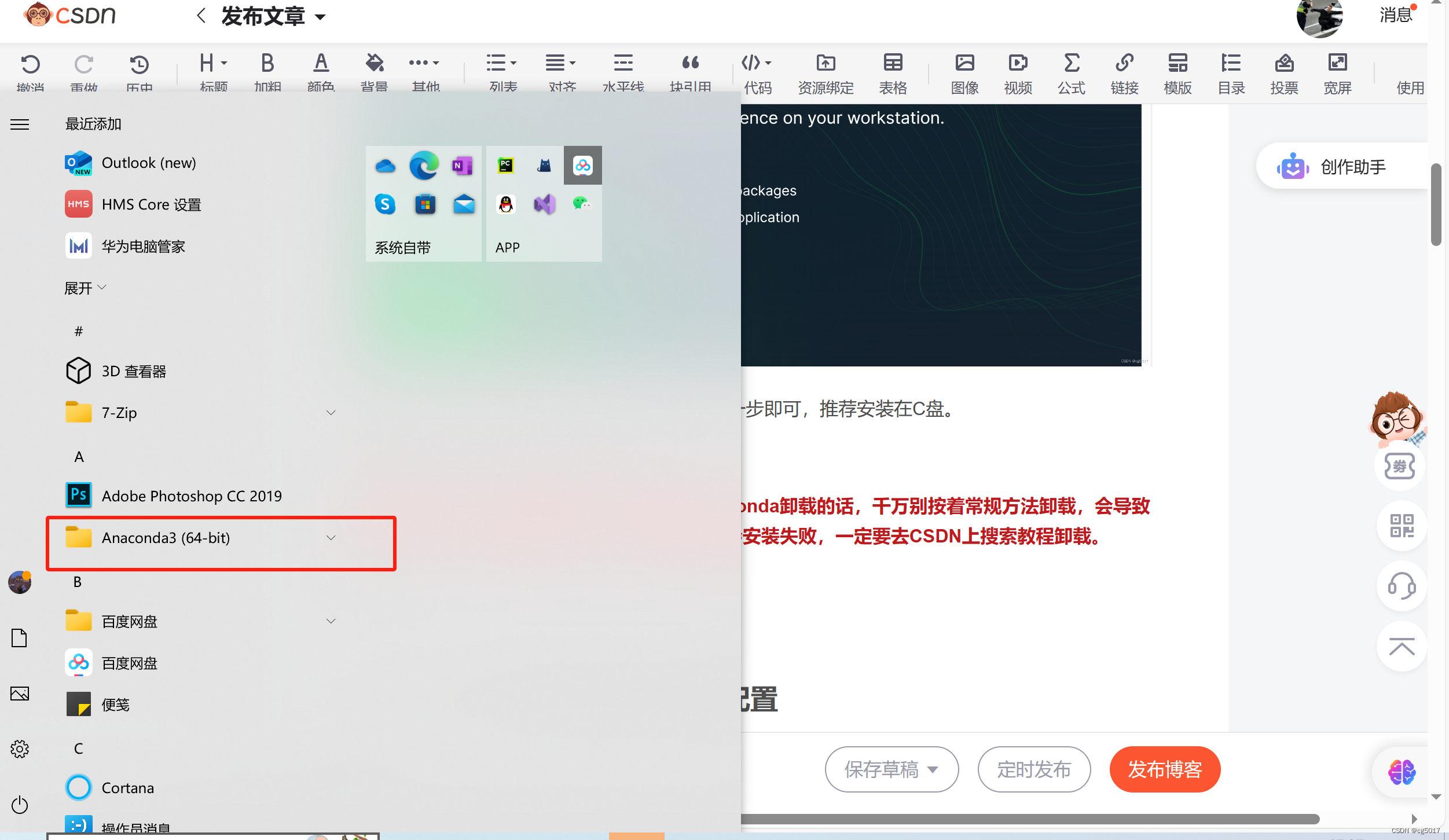

安装完成后,点击电脑的开始键,就可以看见我们安装的Anaconda

需要注意的是,安装后想将我们的大蟒蛇Anaconda卸载的话,千万别按着常规方法卸载,会导致卸载不干净,下次再安装Anaconda的时候就会安装失败,一定要去CSDN上搜索教程卸载。

④创建ChatGML-6B运行的虚拟环境

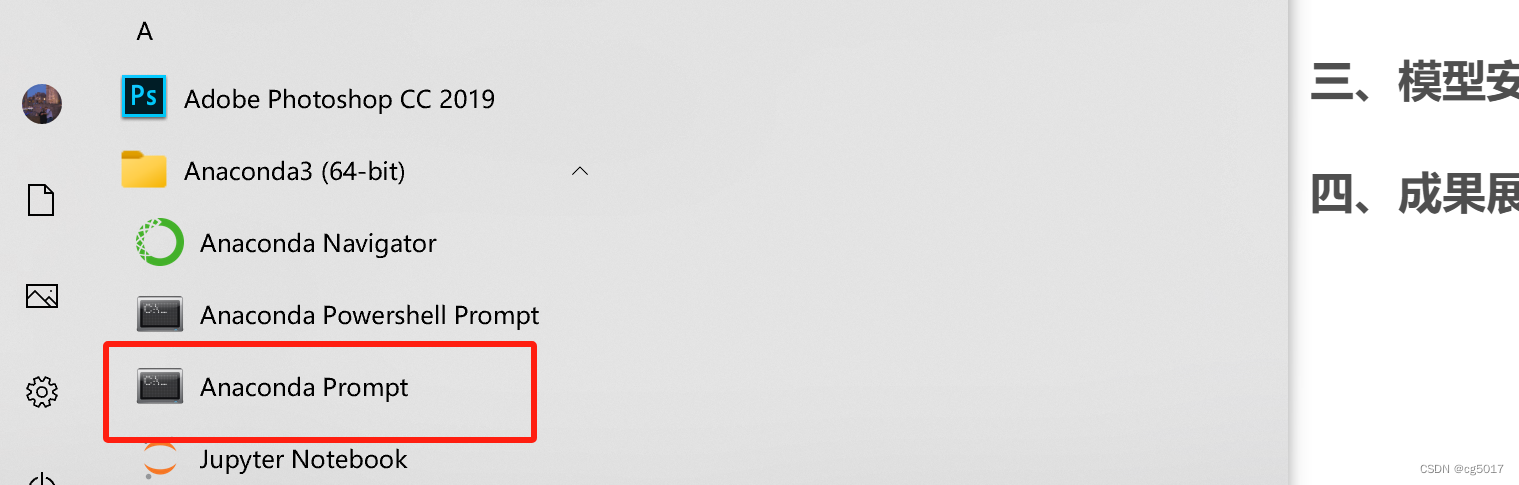

点击进入命令窗口

在命令窗口输入

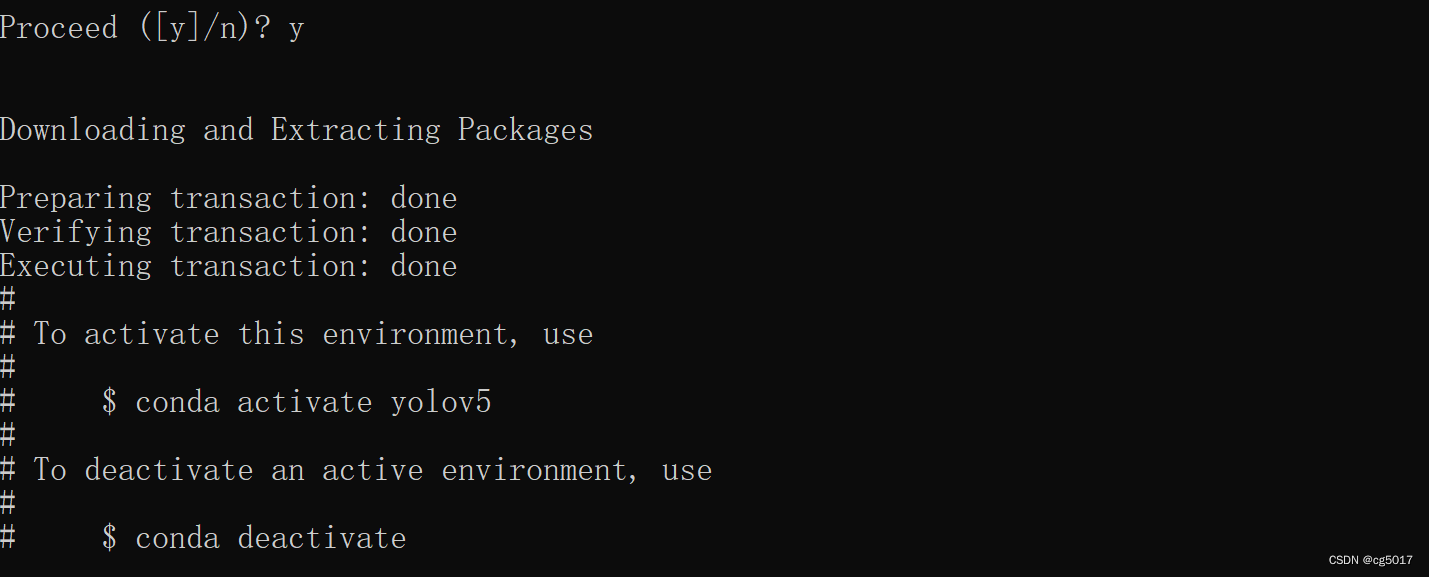

conda create -n ChatGML-6B python=3.8

然后输入y,如下所示就是创建成功,(下图是我创建yolov5时候截的图片,由于当时创建ChatGML-6B运行环境的时候没有截图,所以就用了yolov5时候截的图片,只要和下图一样就成功了)

输入

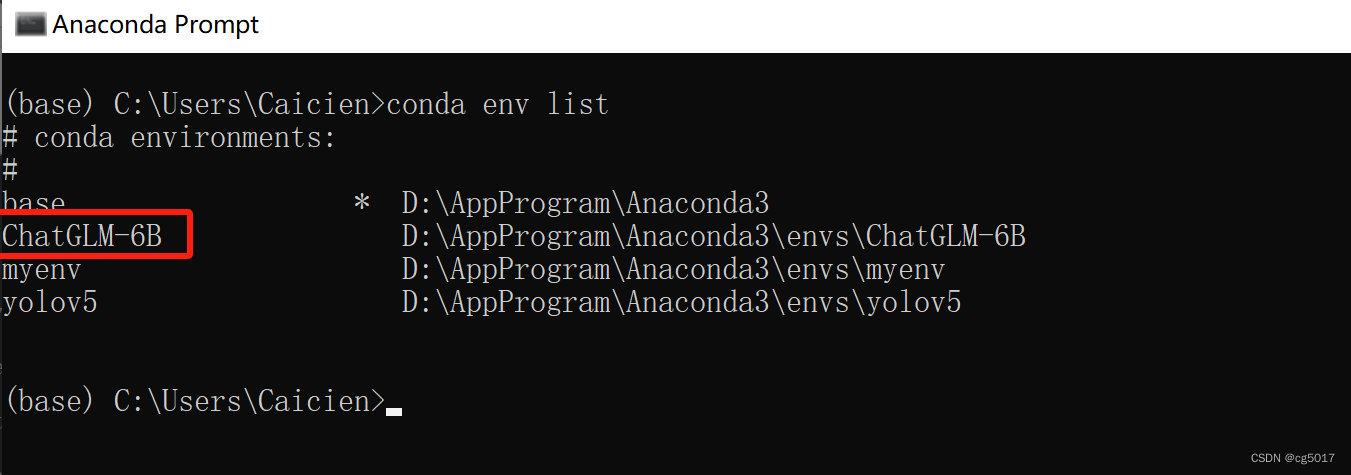

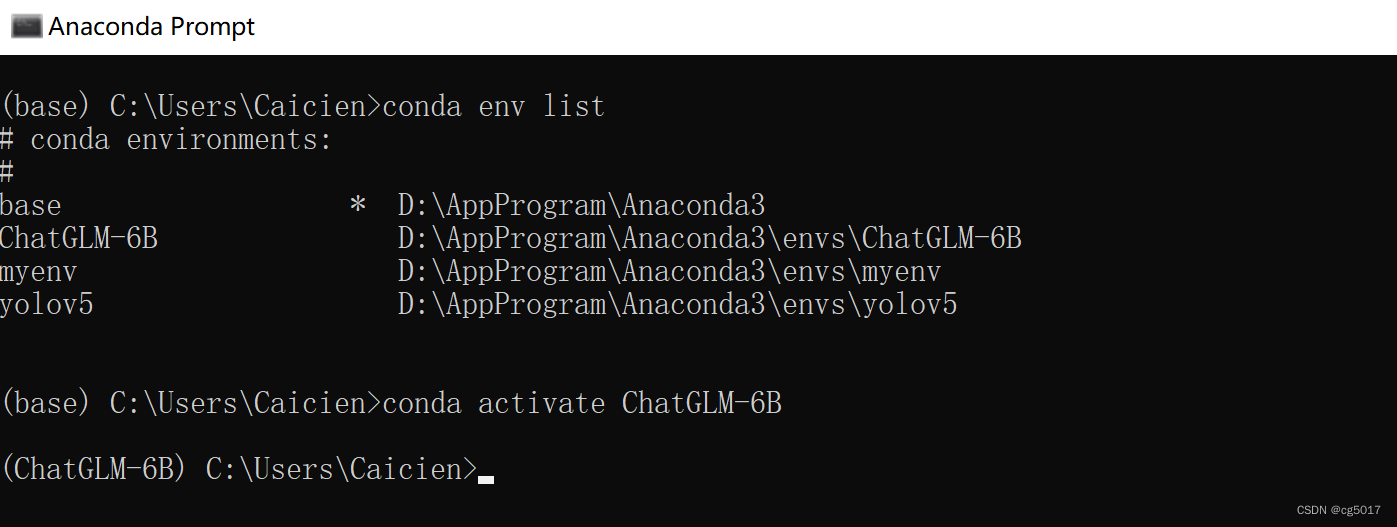

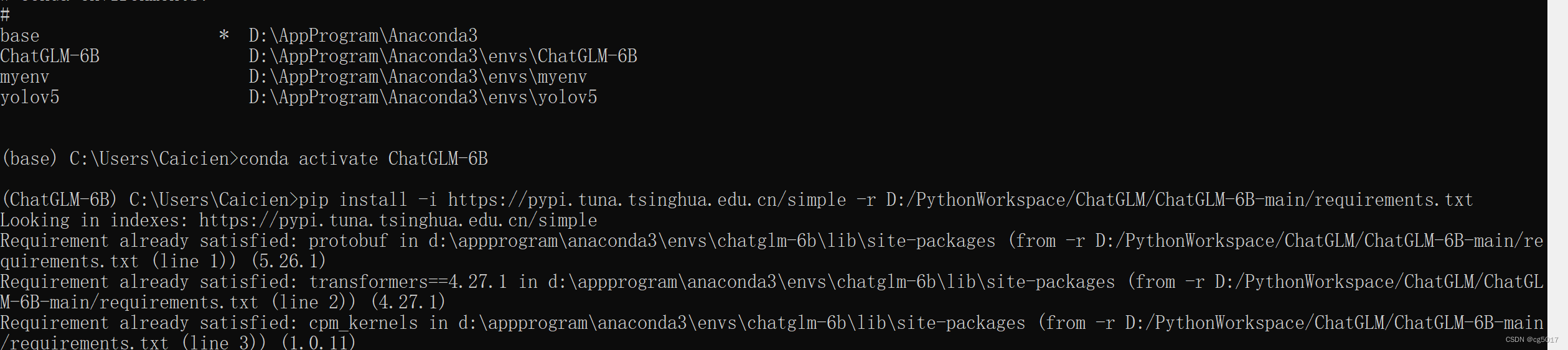

conda env list

查看是否成功,若显示出刚刚创建的虚拟环境名称,则表示创建成功。

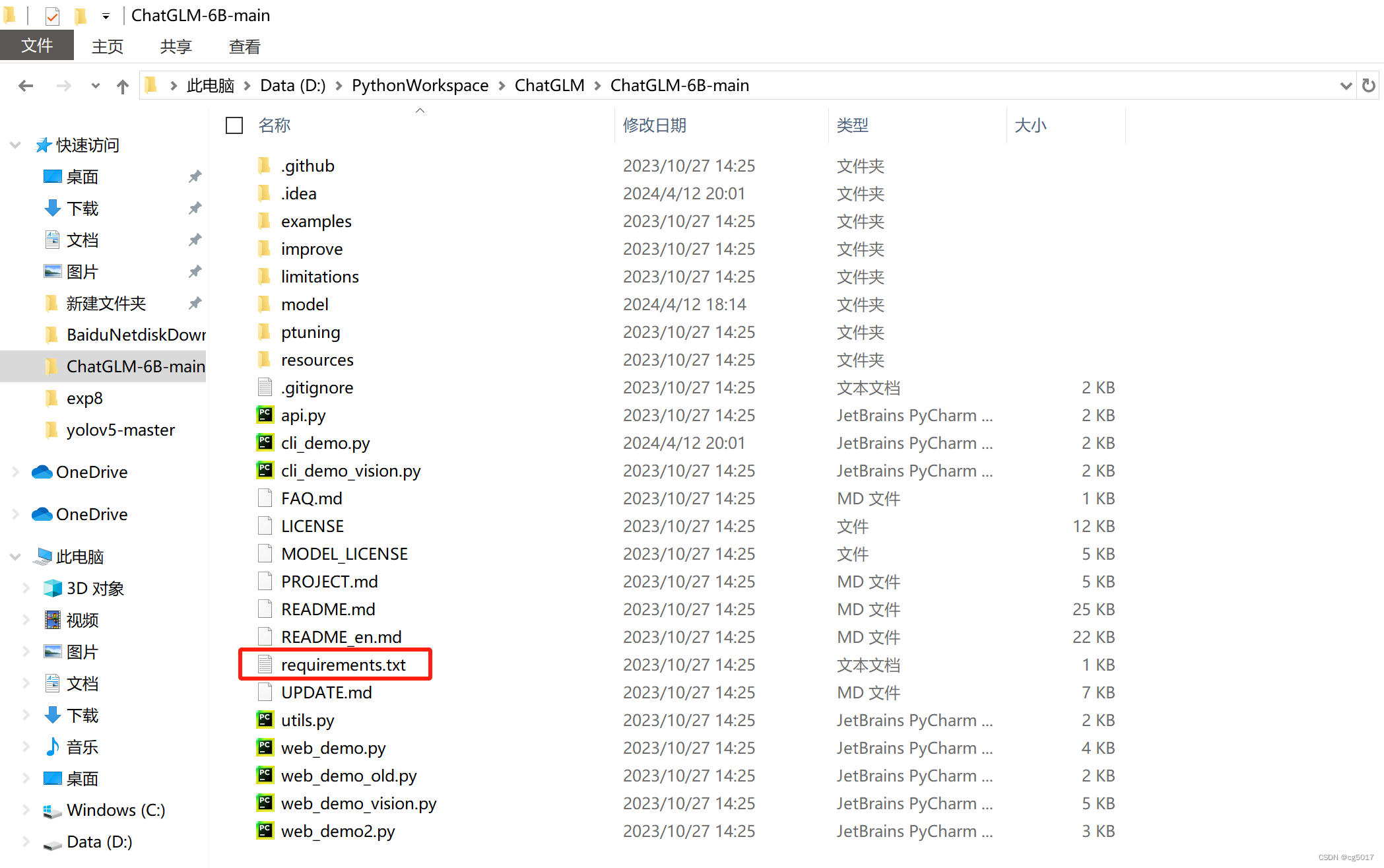

此时我们创建的虚拟环境里还什么都没有,还得安装运行ChatGML-6B代码的一下用到的一些库;ChatGML-6B的作者是已经给我们列好了安装哪些库的,他把这些需要的库都放在requirements.txt中,而这个requirements.txt就在我们刚下载的ChatGML-6B-main文件夹中。

输入以下命令,进入 ChatGLM-6B虚拟环境,在该环境中pip install requirements.txt

conda activate ChatGLM-6B

然后输入以下命令安装 requirements.txt。

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple -r D:/PythonWorkspace/ChatGLM/ChatGLM-6B-main/requirements.txt

由于我已经下载过了,就并不会显示下载,在这里等待它自动下载完成就行

⑤Pycharm的安装

这个安装也没什么要注意的,就不写教程了,要是有困难可以留言也可以网上找安装教程,注意下载社区版本community版,该版本免费。

下载地址:/pycharm/download.

三、模型安装

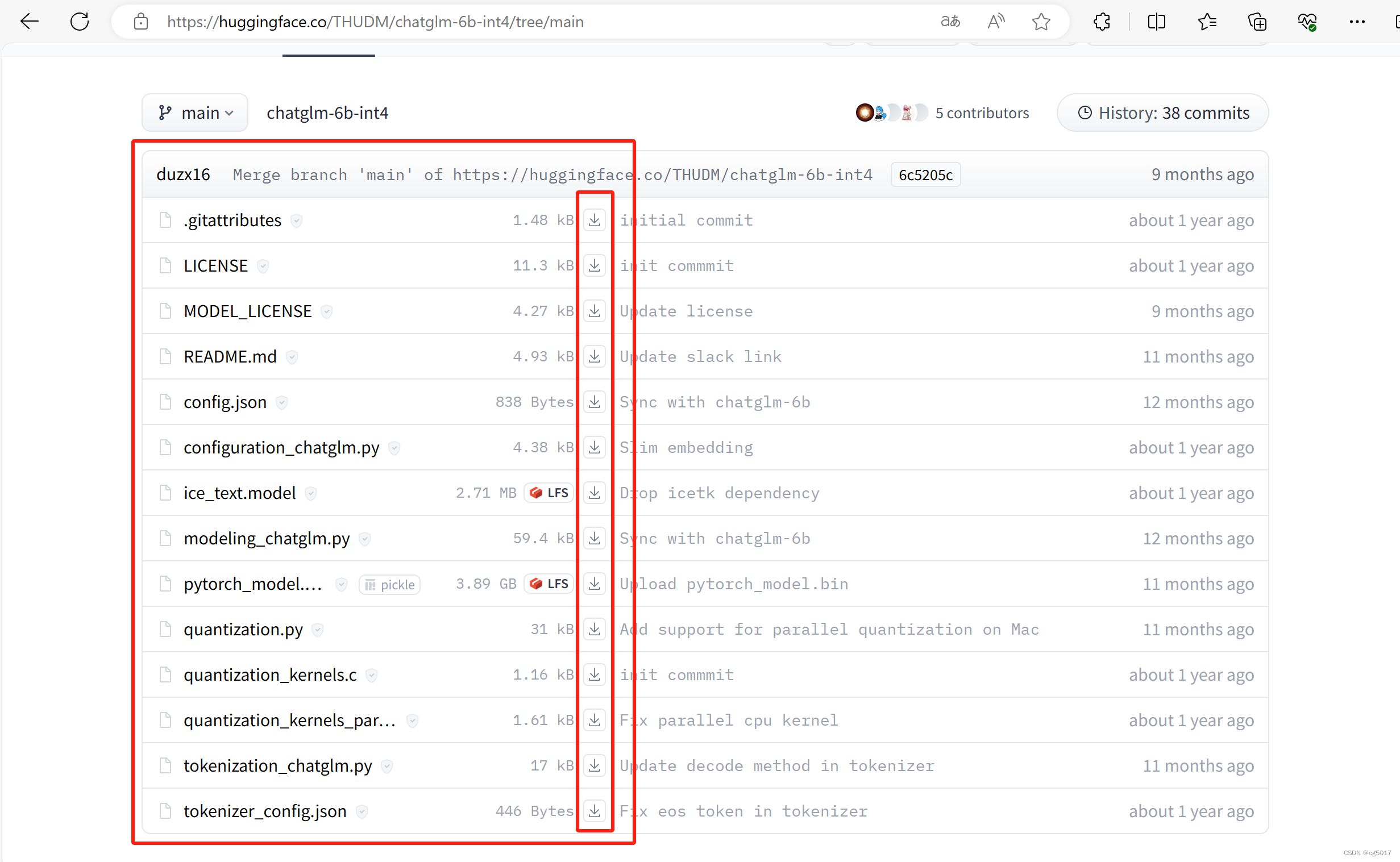

进入网站:https://huggingface.co/THUDM/chatglm-6b-int4/tree/main

下载ChatGML-6B的模型,下图框住的全部下载下来

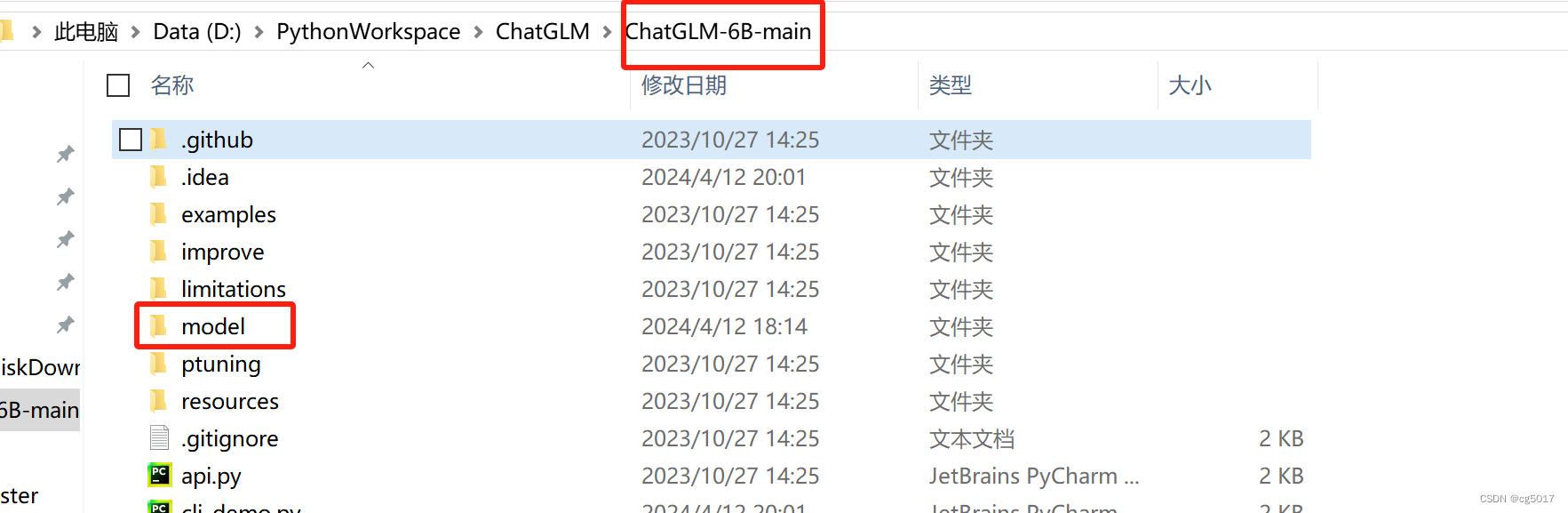

在之前下载的ChatGML-6B-main中新建model文件夹,然后将刚刚下载的文件全部放入model文件夹中。

至此,所有的准本工作就都做完了!!!

四、成果展示

右键,选择用Pycharm打开,进入后,所有都点×。

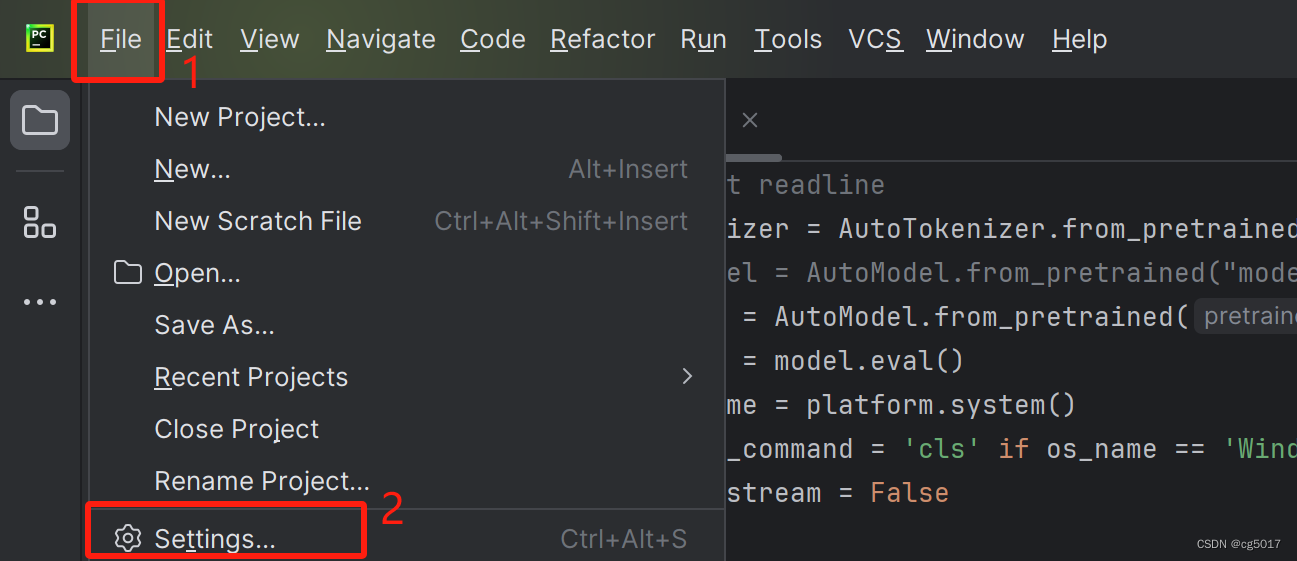

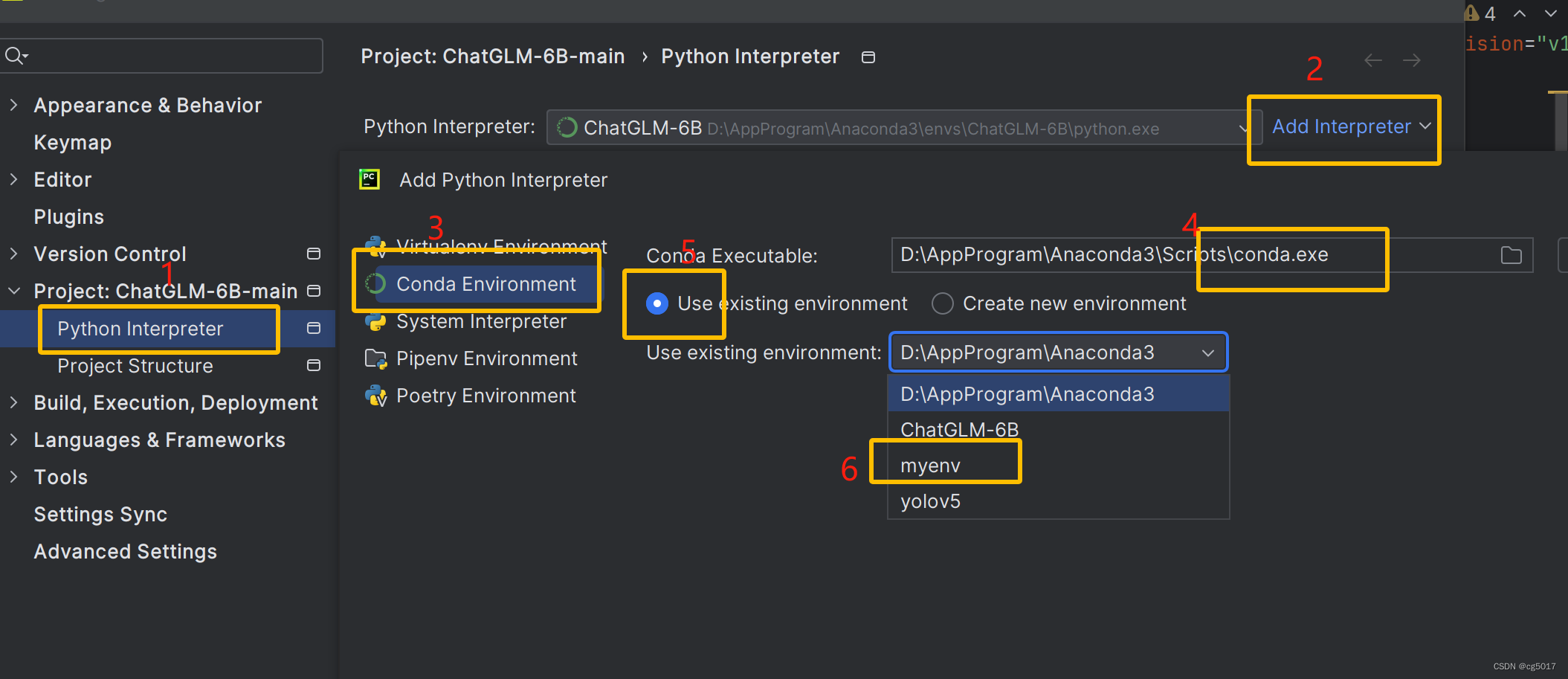

将刚刚创建的环境加入

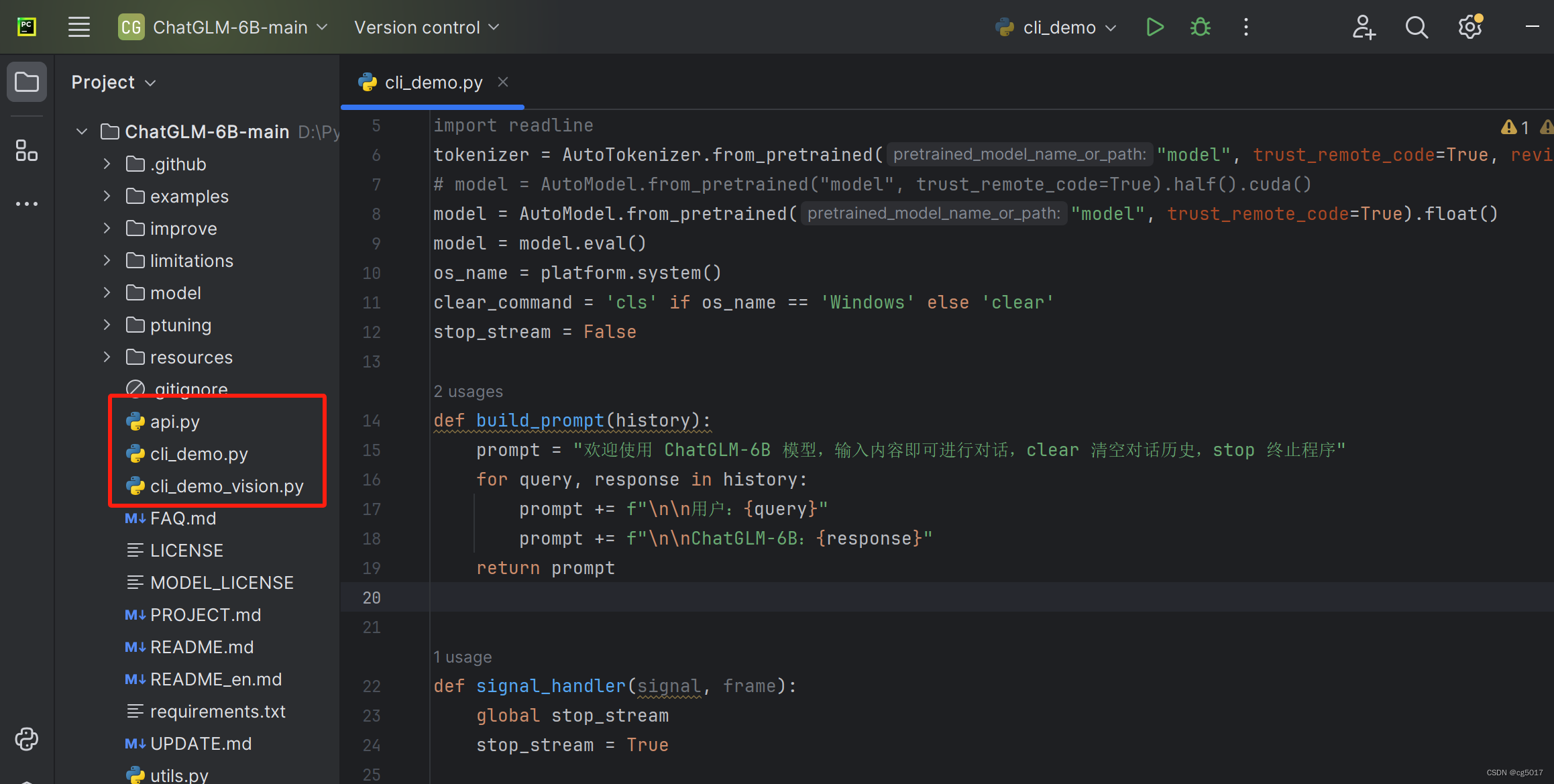

环境添加完成后等待一会,ChatGML-6B三种方式:

- 命令行

Demo:命令行模式(cli_demo.py) - 网页版

Demo:网页版(web_demo.py) API部署:API部署(api.py)

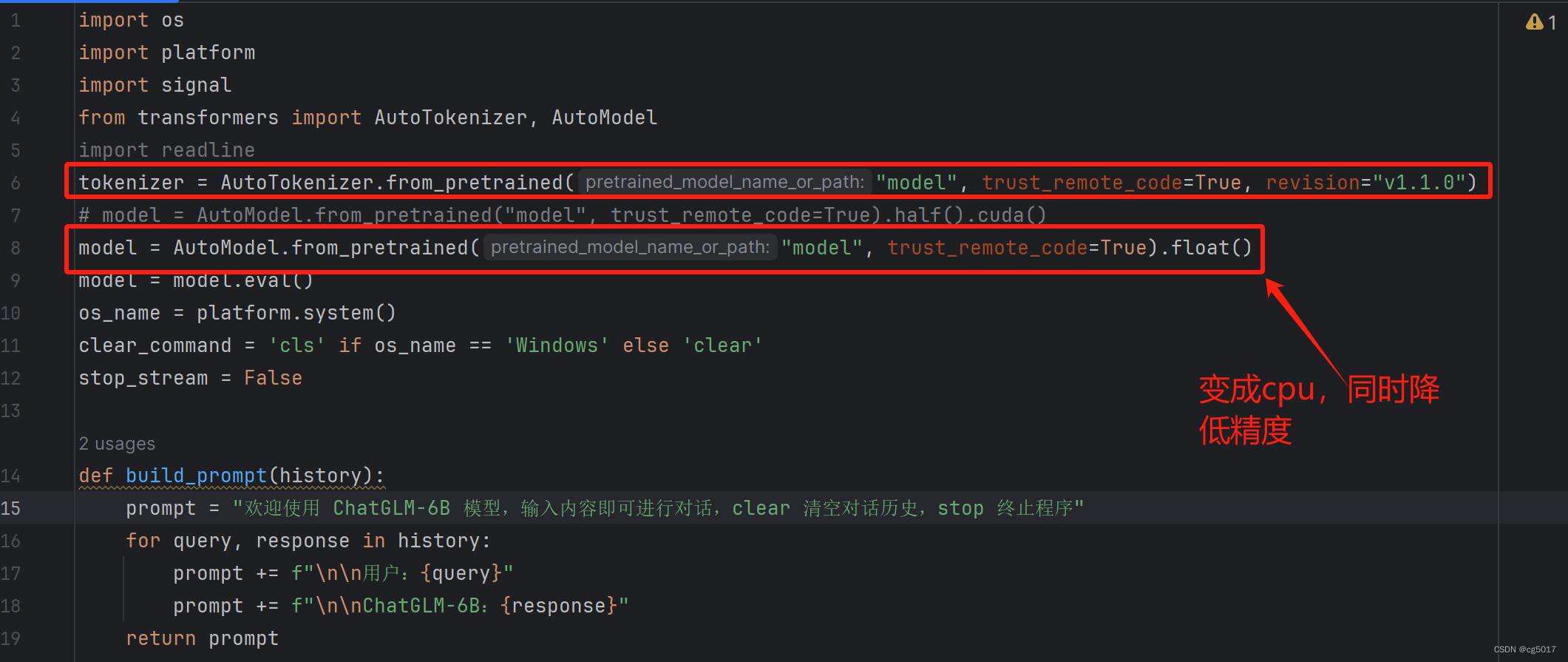

这里使用命令行Demo进行测试,双击打开cli_demo.py文件,修改一下其中的代码,修改如下

tokenizer = AutoTokenizer.from_pretrained("model", trust_remote_code=True, revision="v1.1.0")

# model = AutoModel.from_pretrained("model", trust_remote_code=True).half().cuda()

model = AutoModel.from_pretrained("model", trust_remote_code=True).float()

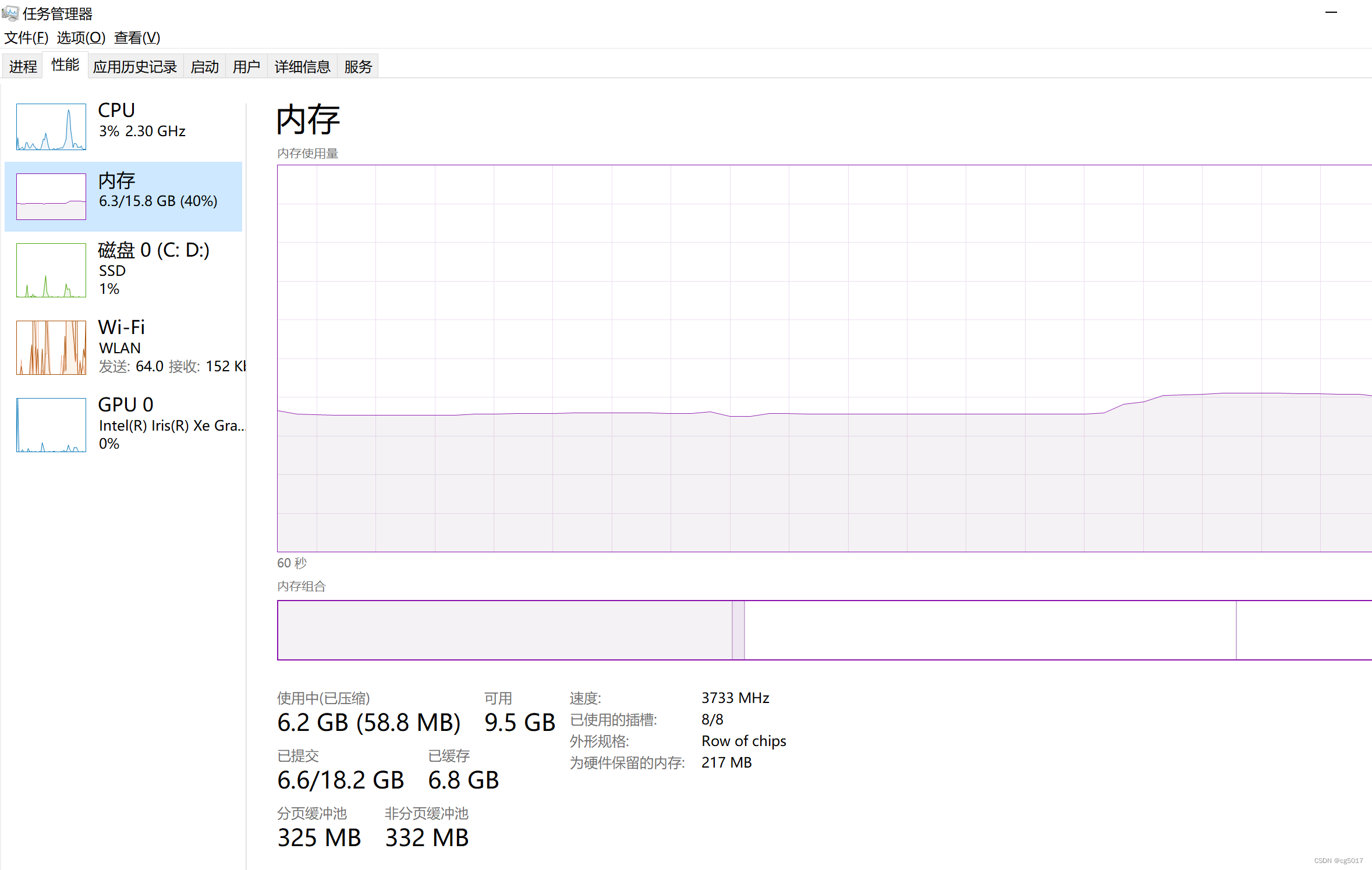

然后直接运行这个程序,就可以进入,但是由于我用的cpu,内存又只有16G,开启Pycharm运行,Pycharm本身会占用很大的内存,直接使用命令行方式运行,操作如下 (想多留点内存给ChatGML-6B运行,然后我就去把该结束的进程给结束,一不小心把资源管理器的进程结束了,只能无奈重启😭,大家也可以结束掉一些不用的进程)

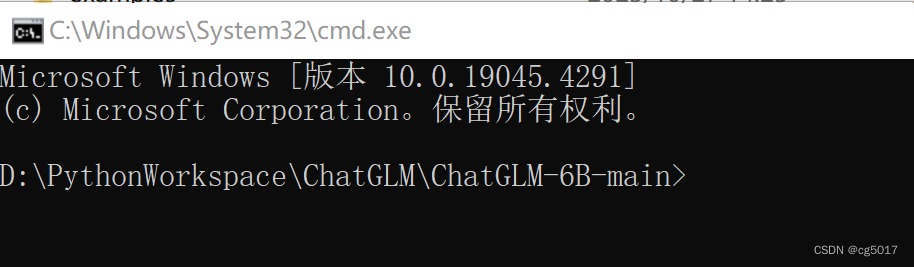

进入文件夹,在这里打开终端,在上方输入cmd就能打开。

进入后如下所示,一定要保证在ChatGML-6B-main文件夹下。

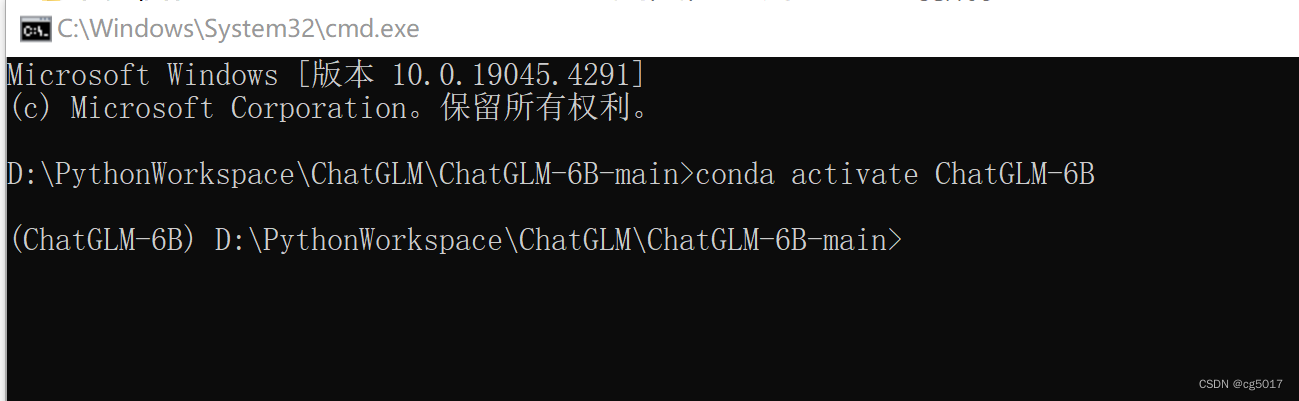

输入 conda activate ChatGLM-6B来激活虚拟运行环境,成功进入后命令行前方会多出(ChatGLM-6B),表示成功进入该虚拟环境。

conda activate ChatGLM-6B

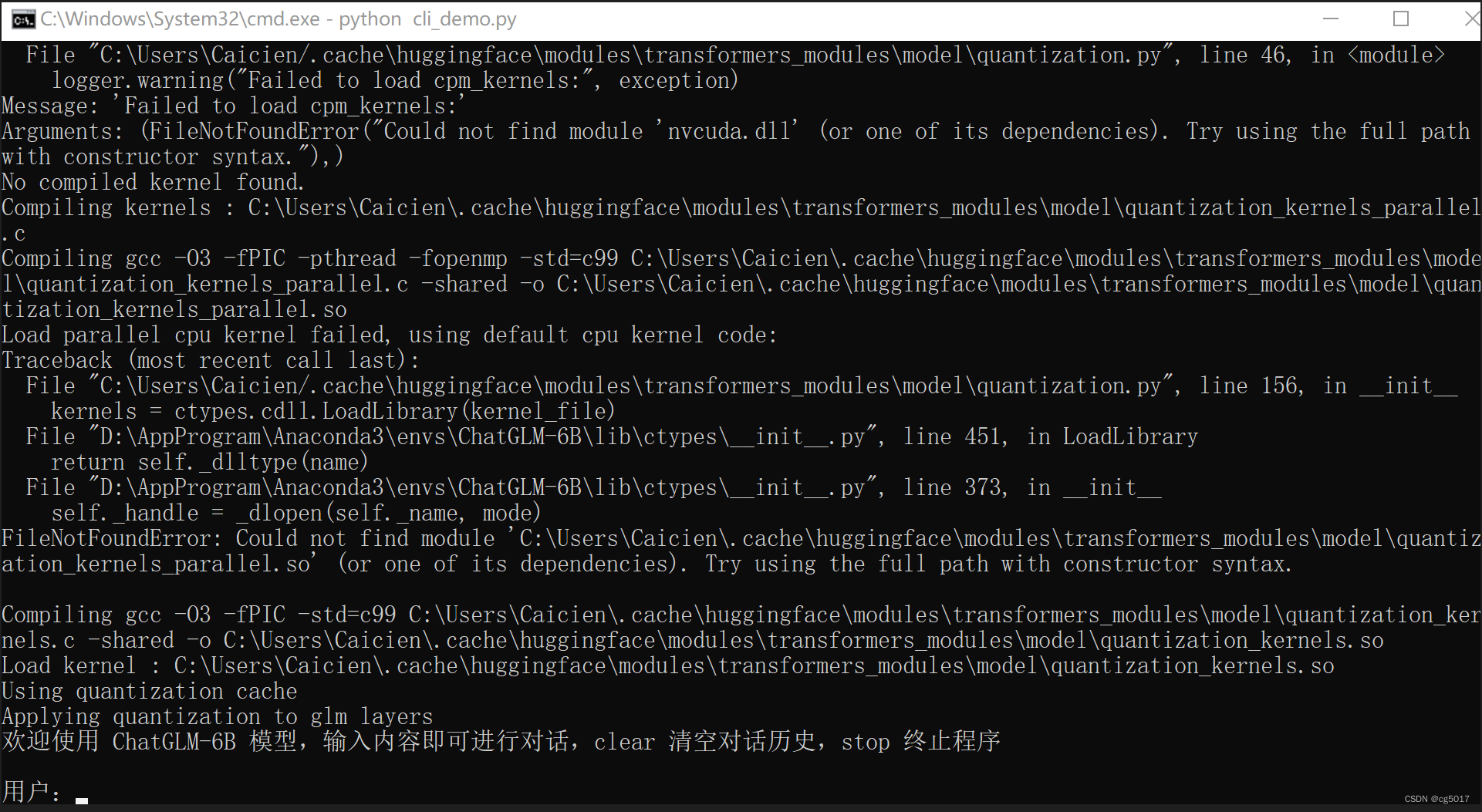

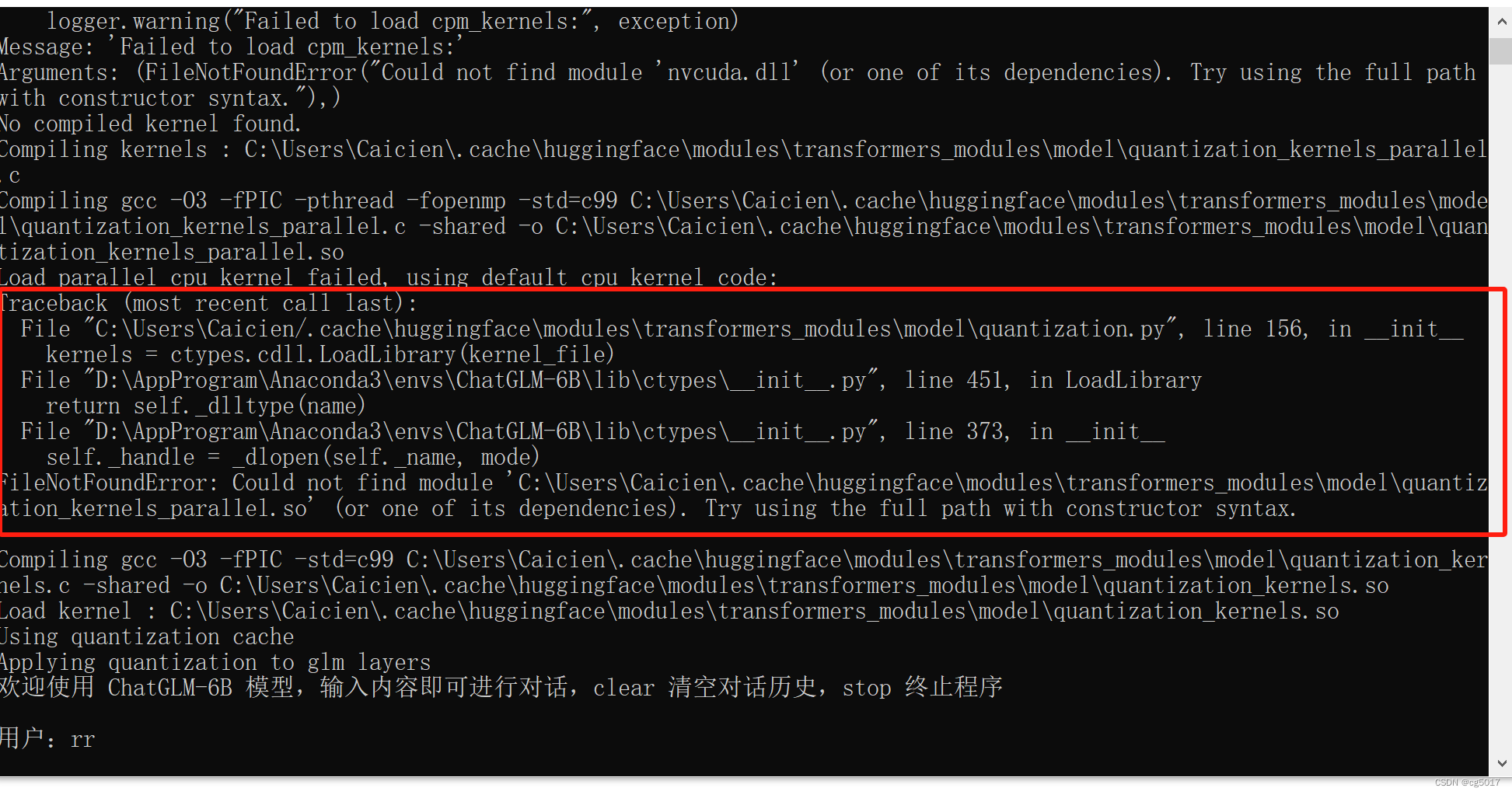

接着输入python cli_demo.py来运行该代码。运行就成功了!!!!

python cli_demo.py

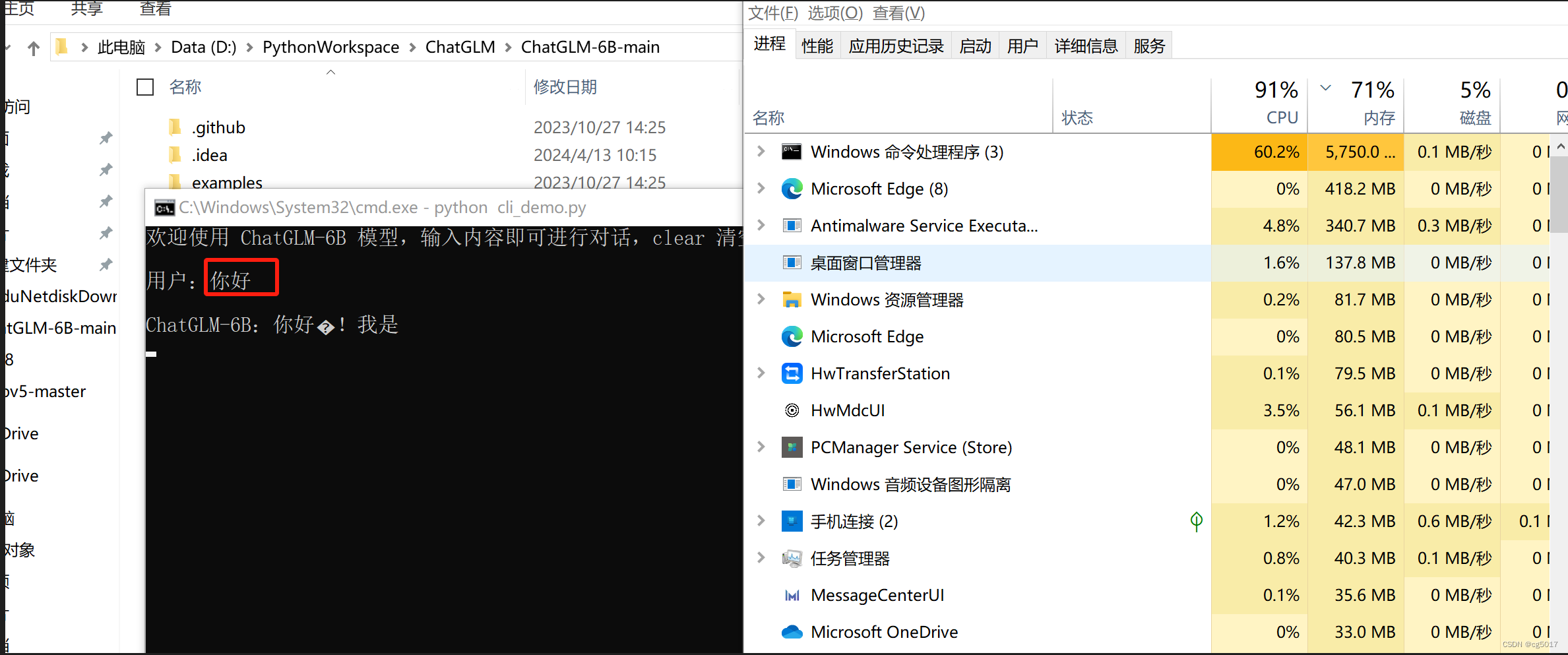

**输入一个你好测试,得到了回复!!!!运行成功!!!!**只不过由于是cpu运行,所以回复的会比较慢。

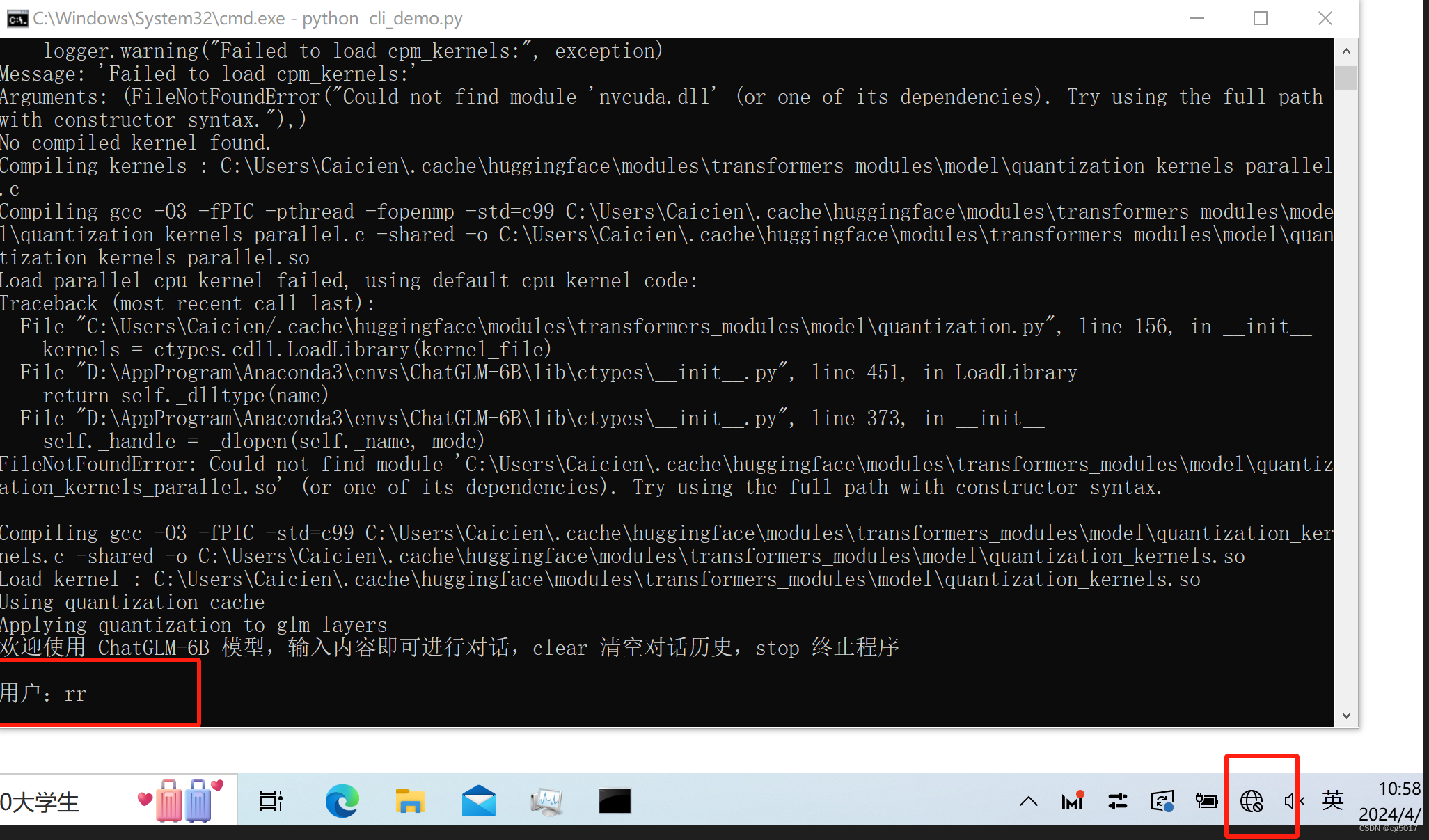

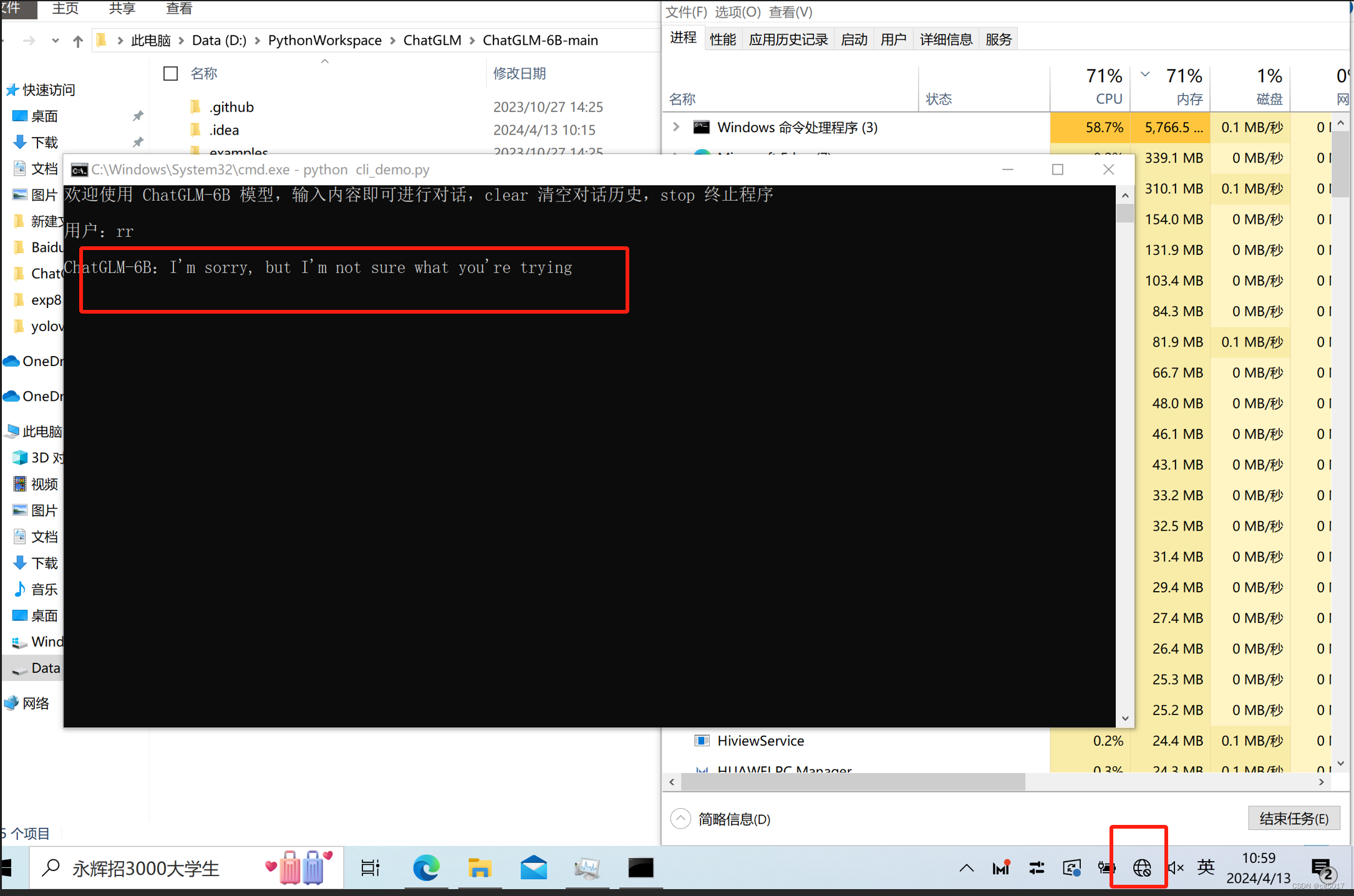

运行完一想,不对,我开着网络运行的,有没有可能模型并没有在我的电脑上跑,于是我就关闭了网络再试了一次,此时网络已经断开。

依然得到了回复,看来这个模型真的在我的电脑上跑着。

五、常见错误解决办法

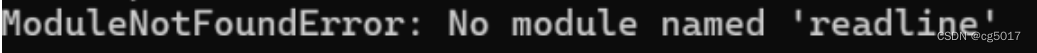

①解决办法:pip install pyreadline3

②有其他错误提示,但不影响正常运行,暂时未解决。

到这里教程就结束了,希望能得到大佬的一个小小的点赞😘。

安装深信服EasyConnect软件(图文详解))

项目前言)

切换PHP版本PDO拓展失效的问题)

-- 将多个节点组合到一个进程)