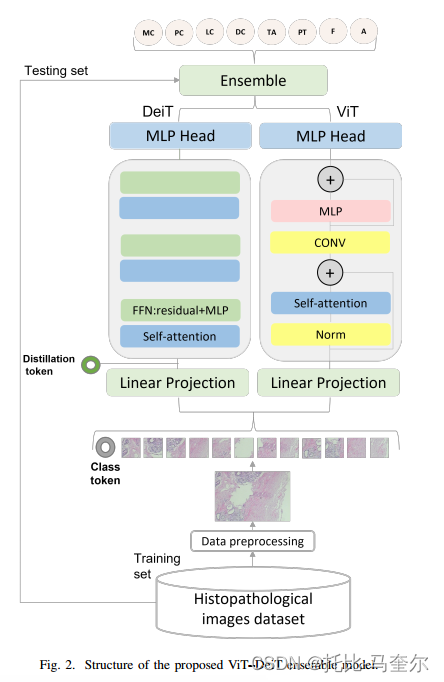

两种预训练Vision Transformer模型的集成模型,即Vision Transformer和数据高效视觉Transformer(Data-Efficient Image Transformer)。此集成模型是一种软投票模型。

近年来,乳腺癌的分类研究主要集中在超声图像分类、活检数据分类、组织病理图像分类。

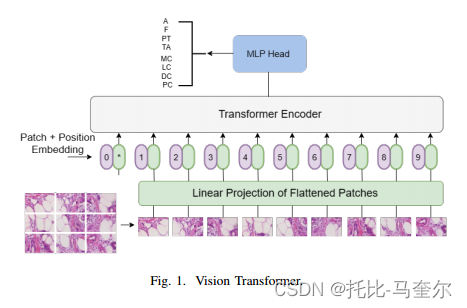

Transformer广泛应用于自然语言处理(NLP),Transformer模型的结构包括编码器和解码器, ViT 结构中不需要解码器 。ViT结构仅由用于图像处理的编码器组成。编码器组件由归一化层、多头注意力层和前馈层组成。多头注意力是自注意力的一种,其功能是从各个方面提供对特定信息的注意力。

在ViT模型中,每个图像在输入编码器之前都会经过线性嵌入层。嵌入层会将图像划分为大小相等的块,这些块被展平为一维向量。嵌入的位置被添加到展平的补丁中,并且添加嵌入图像的类。编码器处理这些输入,从而得到输出。

然后,输出通过MLP头部结构,该结构执行分类任务。类是MLP头结构的输出,MLP头部结构由两个具有GELU激活函数的全连接层组成。

DeiT模型

DeiT模型的结构是基于ViT模型构建的,它们在多头自注意力(MSA)层上添加了前馈神经网络(FFN),该层由GELU激活函数分割的两个线性层组成。

有一个称为蒸馏令牌的额外输入,该令牌允许模型从教师的输出中学习。

知识蒸馏:用teacher模型去训练student模型,通常teacher模型更大而且已经训练好了,student模型是我们当前需要训练的模型。在这个过程中,teacher模型是不训练的。

- 教师模型输出不同 。软蒸馏中教师模型在输出层使用softmax函数得到输出概率分布;硬蒸馏中教师模型的输出是"硬"标签,即每个样本只有一个类别的标签。

- 学生模型学习方式不同 。软蒸馏中学生模型通过最小化教师模型的输出概率分布和自身的输出概率分布之间的误差来学习教师模型的知识;硬蒸馏中学生模型通过最小化教师模型的输出和自身的输出之间的误差来学习教师模型的知识。

提出的方法

预处理数据集

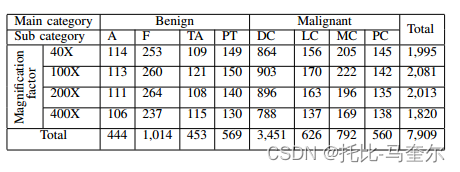

DC子类别在不同放大倍数下具有最多的图像数量。F子类别具有第二多的图像数量,其他子类别具有相似的图像数量。因此,这会导致数据不平衡,从而导致过度拟合。

为了避免过拟合,可以采用欠采样技术。欠采样技术减少了样本量较大的每个子类别中的样本数量。

微调ViT和DeiT模型

为了训练模型,深度学习需要大量样本。需要采用迁移学习技术。

通过少量图像,可以对大型数据集训练得出的训练模型进行微调,从而大大减少训练时间。迁移学习除了提高模型的收敛速度和泛化能力之外,还降低了过拟合的风险。

通过将预测头放置在类标记的最终隐藏状态上来对模型进行微调,从而对八个子类别的图像进行分类。尽管模型由十二个自注意力头组成,但这些头的输出被组合起来产生最终的注意力分数。

最终的注意力分数用于关注每个组织病理学图像内的感兴趣区域。感兴趣区域代表癌细胞,用于检测和确定乳腺癌的类型。

开发集成模型

蒸馏令牌是通过自注意力层和补丁令牌交互的反向传播进行学习得到的。

软投票技术

软投票技术的工作原理是为每个样本分配高平均概率作为预测标签。当将图像作为输入时,这两个模型为每个类提供概率值。然后,对每个类别的概率求和,并除以分类器的数量。然后,为预测标签分配最高概率值。

其中,N为分类器个数,指的是第j个分类器对第i个类别的概率

ViT - DeiT集成模型避免了癌症诊断中最坏的情况,即将恶性样本诊断为良性。错误分类最多的图像是被预测为其他类型恶性肿瘤的恶性样本。

2024.04.15:UCOSIII第四十三节:任务消息队列)

)

)