HanDiffuser: Text-to-Image Generation With Realistic Hand Appearances

公和众和号:EDPJ(进 Q 交流群:922230617 或加 VX:CV_EDPJ 进 V 交流群)

目录

0. 摘要

2. 相关工作

3. HanDiffuser

3.1. 基础

3.2. Text-to-Hand-Params 扩散

3.3. 文本引导的 Hand-Params-to-Image 扩散

4. 实验

4.1. 数据集

4.3. 评估指标

5. 结论与局限性

0. 摘要

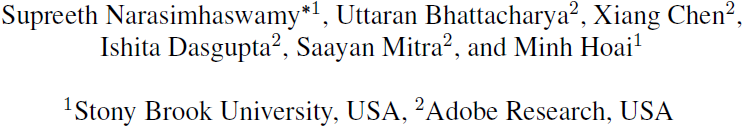

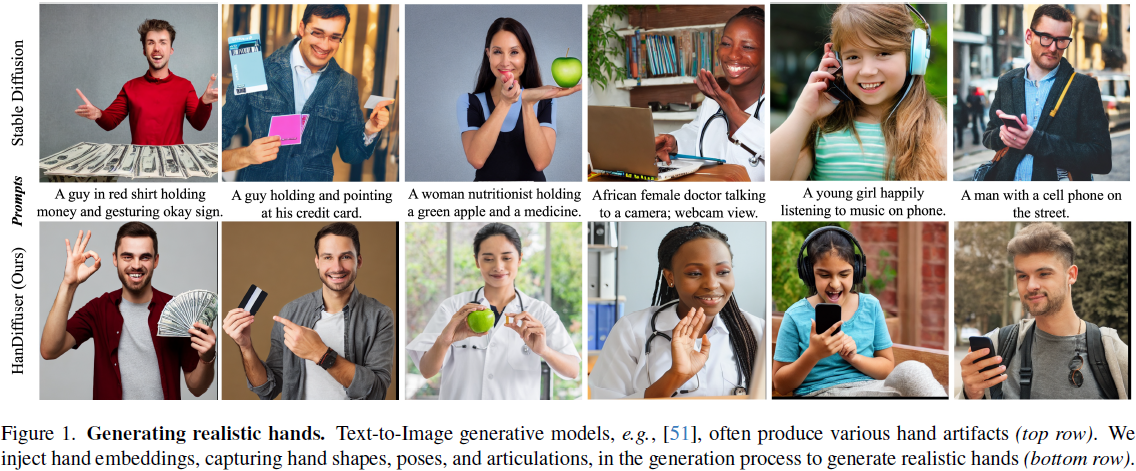

文本到图像生成模型可以生成高质量的人物,但在生成手部时会失去真实感。常见的伪影包括手部姿势不规则、形状不正确、手指数量错误以及物理上不合理的手指方向。为了生成具有真实手部的图像,我们提出了一种名为 HanDiffuser 的基于扩散的新架构,通过在生成过程中注入手部嵌入来实现真实感。HanDiffuser 由两个组件组成:一个 Text-to-Hand-Params (T2H) 扩散模型,用于从输入文本提示生成 SMPL-Body 和 MANO-Hand 参数,以及一个 Text-Guided Hand-Params-to-Image (T-H2I) 扩散模型,以先前组件生成的提示和手部参数上为条件合成图像。我们将手部表示的多个方面纳入考虑,包括 3D 形状和关节级别的手指位置、方向和关节动作,以实现稳健学习和可靠性推理。我们进行了大量的定量和定性实验,并进行了用户研究,以证明我们的方法在生成具有高质量手部的图像方面的有效性。

2. 相关工作

文本到人体生成。除了图像生成外,从文本提示生成人体姿势和动作也取得了相当大的进展。

- 近期的生成方法通常遵循各种骨骼关节格式,例如 OpenPose [5],或者结合关节和网格格式,如 SMPL [34],来表示人体。它们在各种大规模姿势和动作数据集上进行训练,包括 KIT [46],AMASS [36],BABEL [48] 和 HumanML3D [18]。

- 为了有效地将文本提示映射到动作序列,文本到动作生成方法使用了从递归神经网络 [2, 29]、分层姿势嵌入 [3, 14]、VQ-VAE transformers [44, 45] 到动作扩散模型 [7, 27, 60, 69] 的各种技术来学习语言和姿势的组合表示。一些方法甚至在姿势运动(pose motion)合成之上生成 3D 网格以合成完全渲染的人体 [23, 65]。

- 与动作合成分开,还有一些关于从文本生成参数化姿势模型的工作[8, 9, 42]。

- 然而,这些方法专注于人体,忽略了手部区域。因此,它们无法生成灵活的手部。一项同期工作 [35] 提出了一种修补(inpainting)方法来优化手部。给定一个生成的图像,该方法重建手部的 3D 网格并进一步优化手部区域。因此,重建的手部网格的质量,以及最终优化的手部的质量,取决于最初生成的手部的质量。

- 相比之下,我们的方法首先从提示生成手部网格参数,并进一步在这种中间手部参数上调整图像生成。此外,[35] 忽略了初始图像中的手部与物体的交互,并在优化手部时可能不会保留手部与物体的遮挡和交互。

手部表示。现有的手部配置、手势和手-物体交互的数据集提供了各种格式的手部表示,包括边界框、轮廓(silhouettes)、深度图 [28, 30, 31]、关键点和参数化模型 [12, 25, 26, 52]。这些表示对于多种以手为中心的任务都是有用的,包括图像检测 [61]、手势和姿势识别 [70]、动作生成 [58, 71] 和手物体交互 [15, 24, 57]。我们的工作将基于关键点和参数模型的表示结合起来,以有效地编码多样的手部形状和高度关节动作。

3. HanDiffuser

3.1. 基础

SMPL-H。我们的 Text-to-Hand-Params 模型从文本输入中生成人体和手部模型的参数。我们分别使用 SMPL [34] 和 MANO [52] 作为我们的人体和手部模型。

- SMPL 是一个可微函数 M_b(θ_b, β_b),其中 θb ∈ R^69 表示姿势参数,βb ∈ R^10 表示形状参数,返回带有 6890 个顶点的身体网格 Mb ∈ R^(6890×3)。

- 类似地,MANO 是一个可微函数 M_h(θ_h, β_h, s),其中 θh ∈ R^48 表示手部姿势参数,βh ∈ R^10 表示手部形状参数,s ∈ {left, right} 表示手部的一侧,返回带有 778 个顶点的手部网格 Mh ∈ R^778×3。可以使用预先训练的线性回归器 Wh 从顶点回归出 3D 手部关节位置 Jh ∈ R^(k×3) = Wh·Mh。

SMPL-H 模型将身体、左手和右手模型合并为一个单一的可微分函数 M(θ, β),其中姿势参数 θ = (θ_b, θ_lh, θ_rh),形状参数 β。姿势参数 θb、θlh 和 θrh 分别捕获了相对于根(root)的身体、左手和右手的关节旋转。形状参数 β 捕获了人的尺度。

稳定扩散。我们的 Text-Guided Hand-Params-to-Image 模型建立在稳定扩散 [51] 的基础上。稳定扩散是一个潜在扩散模型,包括一个自动编码器、一个用于噪声估计的 U-Net 和一个 CLIP 文本编码器。编码器 E 将图像 x 编码成在扩散过程操作的潜在表示 z = E(x)。解码器 D 从潜在表示 z 中重构图像,即 ˆx = D(z)。U-Net 以去噪步骤 t 和文本 τ_text(text) 为条件,其中 τ_text(text) 是一个 CLIP [49] 文本编码器,将一系列分词的文本投影到嵌入空间。

为了使图像生成同时以手部参数和文本为条件,我们用一种新颖的 Text+Hand 编码器

![]()

替换了文本编码器 τ_text(text),它将文本和手部参数联合嵌入到一个公共的嵌入空间中。

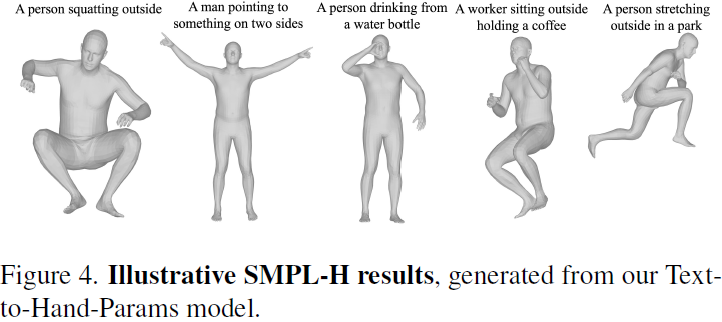

3.2. Text-to-Hand-Params 扩散

Text-to-Hand-Params 扩散模型以文本作为输入,并通过以文本为条件生成 SMPL-H 模型的姿势参数 θ=(θb, θlh, θrh) 和形状参数 β。 我们定义 x := (θ, β),并通过在 T 个时间步骤中将高斯噪声逐步添加到 x 来建模正向扩散过程:

![]()

其中 αt ∈ (0, 1) 是常数超参数。我们将基于文本的 SMPL-H 生成分布 p(x0|c) 建模为逐渐去噪 xT 的反向扩散过程。根据 [60],我们通过直接使用模型 G 来预测 ˆx0 = G(xt, t, c) 来学习去噪过程。我们使用以下训练目标来训练反向扩散:

![]()

我们通过使用 CLIP [49] 对文本进行编码来获取条件文本嵌入 c。我们使用类似于 MDM [60] 的仅编码器的 Transformer 架构来实现 G。

在推断过程中,给定一个文本,我们有条件地采样 x = (θ, β)。我们利用 MANO-Hand 模型,使用形状和姿势参数来获取左右手的关节 J_lh、J_rh 和顶点 M_lh、M_rh。我们还选择相机参数,并将关节 J_lh、J_rh 投影到图像空间,并获得相应的图像空间关节位置 J^(2D)_lh、J^(2D)_rh。我们使用关节旋转 θlh、θrh、手部顶点 Mlh、Mrh 和空间关节位置 J^(2D)_lh、J^(2D)_rh 作为下一阶段图像生成的条件。

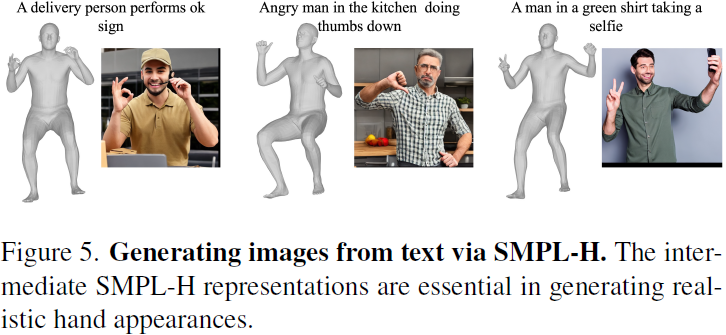

3.3. 文本引导的 Hand-Params-to-Image 扩散

文本引导的 Hand-Params-to-Image 扩散模型建立在稳定扩散 [51] 的基础上,并将图像生成以从 Text-to-Hand-Params 模型生成的手部参数和文本为条件。具体来说,文本引导的 Hand-Params-to-Image 使用了一种新颖的 Text+Hand 编码器 τ_(text+h),首先获得文本和手部参数的联合关节嵌入。然后以手部和文本嵌入作为图像生成的条件。我们在下面提供更多细节。

文本+手部编码器。给定提供的文本,以及手部的空间关节位置 J^(2D)_h、顶点 Mh 和关节旋转 θh,我们的目标是生成 D 维嵌入来编码文本和手部参数。这里 D 表示 CLIP [49] 的标记嵌入维度。为了将手部关节位置编码到图像空间中,我们遵循 [6, 63] 并引入额外的位置标记。我们将图像的高度和宽度均匀量化为 N_bins 个 bin。这使我们能够将任何归一化的空间坐标近似为 N_bins 个标记中的一个。然后,我们使用

![]()

将文本标记和手部关节空间标记编码到 D 维度。具体来说,我们通过将一个额外的 N_bins × D 嵌入层引入到现有的 CLIP 标记嵌入器中,并在训练过程中进行微调来构造 f。为了编码手部顶点,我们将它们转换为基点集(basis point set,BPS)[47] 表示,并通过 f_Mh,一个由全连接线性层和 ReLU 层组成的多层感知器(MLP)进行传递。同样,我们使用由全连接线性层和 ReLU 层组成的 MLP f_θh 来编码 6D 手部关节旋转 θh。最后,我们将来自文本、空间手部关节、手部顶点和手部关节旋转的嵌入进行连接,以生成联合文本和手部嵌入。

扩散。我们使用稳定扩散 [51] 实例化文本引导的 Hand-Params-to-Image,并使用以下目标进行训练:

![]()

在上述方程中,条件 y = (text, J^(2D)_h, Mh, θh) 表示文本和手部参数的组合,其中包括空间关节位置、顶点和关节旋转。函数 F 是一个去噪 U-Net,用于预测噪声,τ_(text+h) 是可训练的 Text+Hand 编码器。我们建议读者参考 [51],了解方程(3)的更多细节。

在 Text-to-Hand-Params 扩散中生成 SMPL-H v.s. 生成骨架(Skeleton)。我们设计 HanDiffuser 的第一个组件来生成 SMPL-H 的姿势和形状参数,而不是关键点或骨架,因为 SMPL-H 编码了关于人类的拓扑和几何先验,并且编码了比骨架更丰富的信息。此外,与骨架相比,SMPL-H 参数对噪声更稳健:即使在有噪声的情况下,我们仍然可以获得合理的姿势,而有噪声的关节位置会导致不合理的姿势。由于我们正在生成 SMPL-H 网格的参数(51 个关节旋转和 10 个形状参数),与第二个组件 Text-Guided Hand-Params-to-Image 相比,Text-to-Hand-Params 组件的计算量较小。

4. 实验

4.1. 数据集

我们使用我们自己策划的数据集来训练 HanDiffuser 的两个组件。

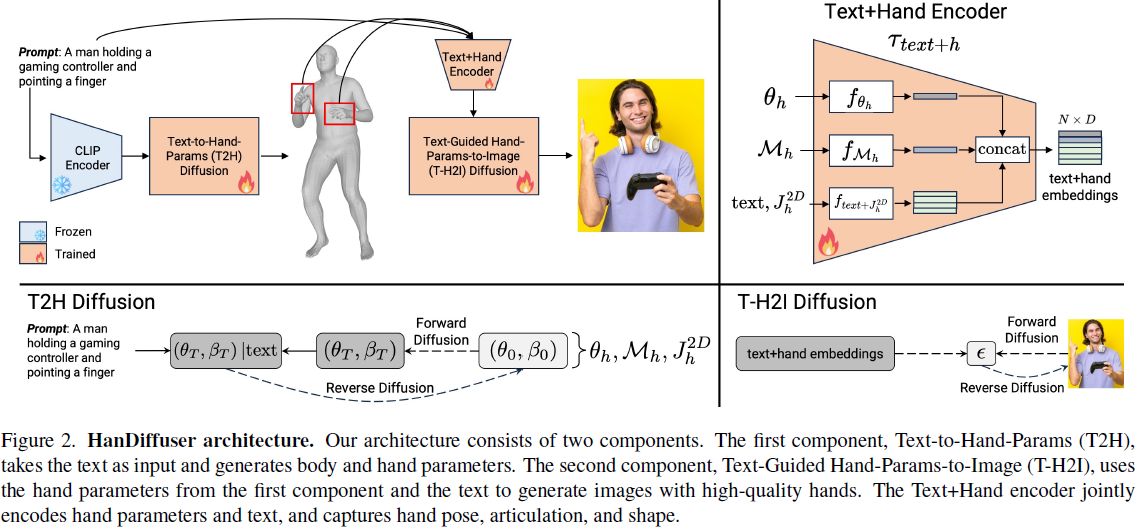

4.3. 评估指标

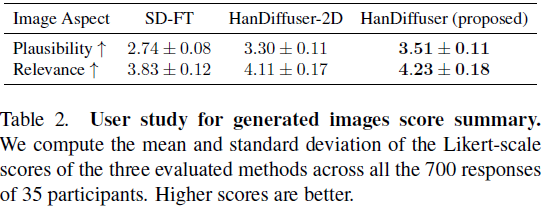

我们使用 Frechet Inception Distance(FID)和 Kernel Inception Distance(KID)[19, 43] 评估HanDiffuser 生成的图像质量。

由于 FID 和 KID 度量图像的整体质量,我们还计算了 FID-H 和 KID-H 来衡量仅手部区域图像的质量。我们首先使用手部边界框提取裁剪图像,然后使用这些手部裁剪图像计算 FID 和 KID。

我们还使用平均手部检测置信度分数来衡量手部的质量。具体来说,我们在生成的图像上运行一个现成的手部检测器 [66],并计算检测的置信度分数。较高的置信度分数意味着手部检测器更有信心地判断一个区域是手部,表明生成的手部质量更高。

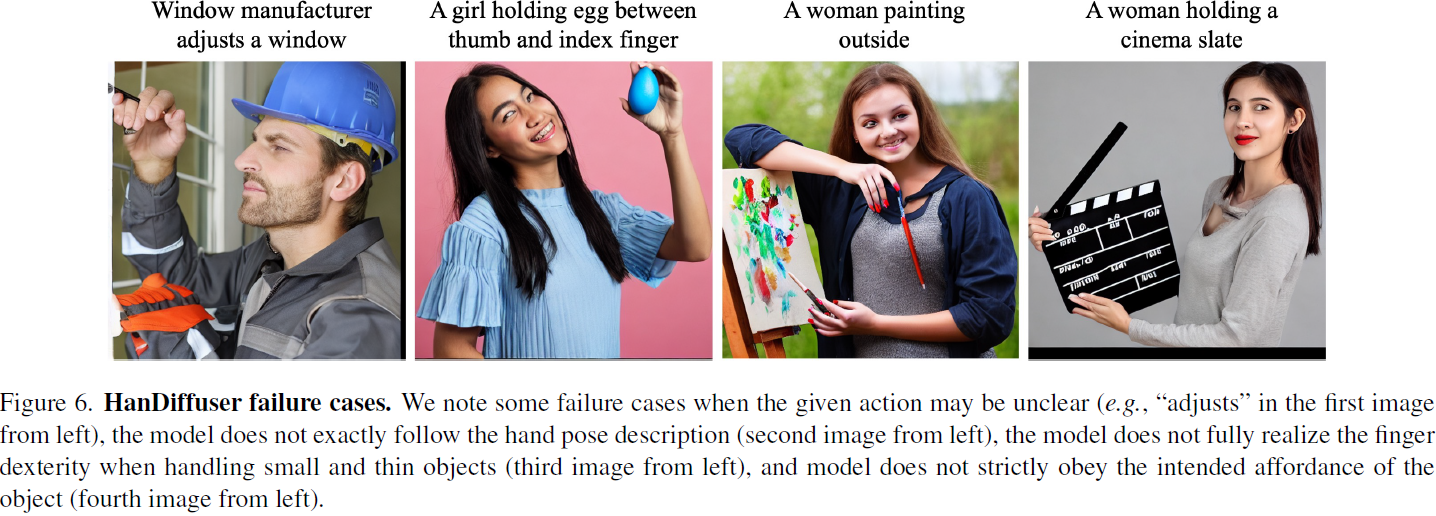

5. 结论与局限性

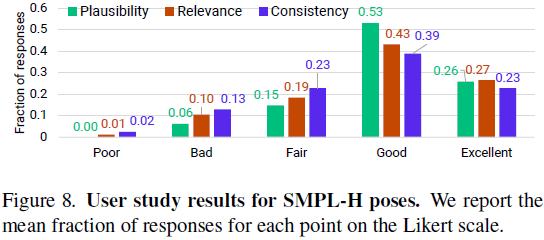

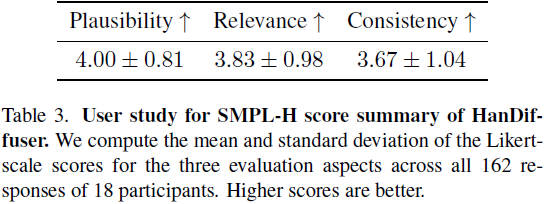

我们提出了 HanDiffuser,一个端到端的模型,用于从文本提示生成具有真实手部外观的图像。我们的模型明确学习了基于手部形状、姿势和手指级关节的手部嵌入,并将它们与文本嵌入结合起来,生成具有高质量手部的图像。我们通过多种评估指标的定量分析以及用户研究的定性分析,展示了我们方法在基准 T2I 数据集上的最新性能。

在未来,我们计划将我们的模型扩展到更多未开发的领域,以生成更逼真的手部。这些领域包括由多个人组成的图像、复杂的手部与物体交互、描述高度专业化手部活动(例如,折纸)的提示、同一人在同时处理多个对象、同一图像中两个或更多人的手部交互,以及非拟人化手部(例如,狗使用计算机)。同时,未来的一个方向是使手部生成流水线具有风格和形状感知,以便在要求在不同图像中生成相同人物时,能够一致地生成相同的手部。

最简单的案例)

)

![洛谷刷题 前缀和与差分-[P2004]领地选择(C++)](http://pic.xiahunao.cn/洛谷刷题 前缀和与差分-[P2004]领地选择(C++))

)

失败讲解)