文章目录

- 关于 LangSmith

- 创建 API Key

- 基本代码使用

- 查看控制台

关于 LangSmith

- 主页:https://www.langchain.com/langsmith

- 文档:https://docs.smith.langchain.com/

- LangSmith Walkthrough : https://python.langchain.com/docs/langsmith/walkthrough

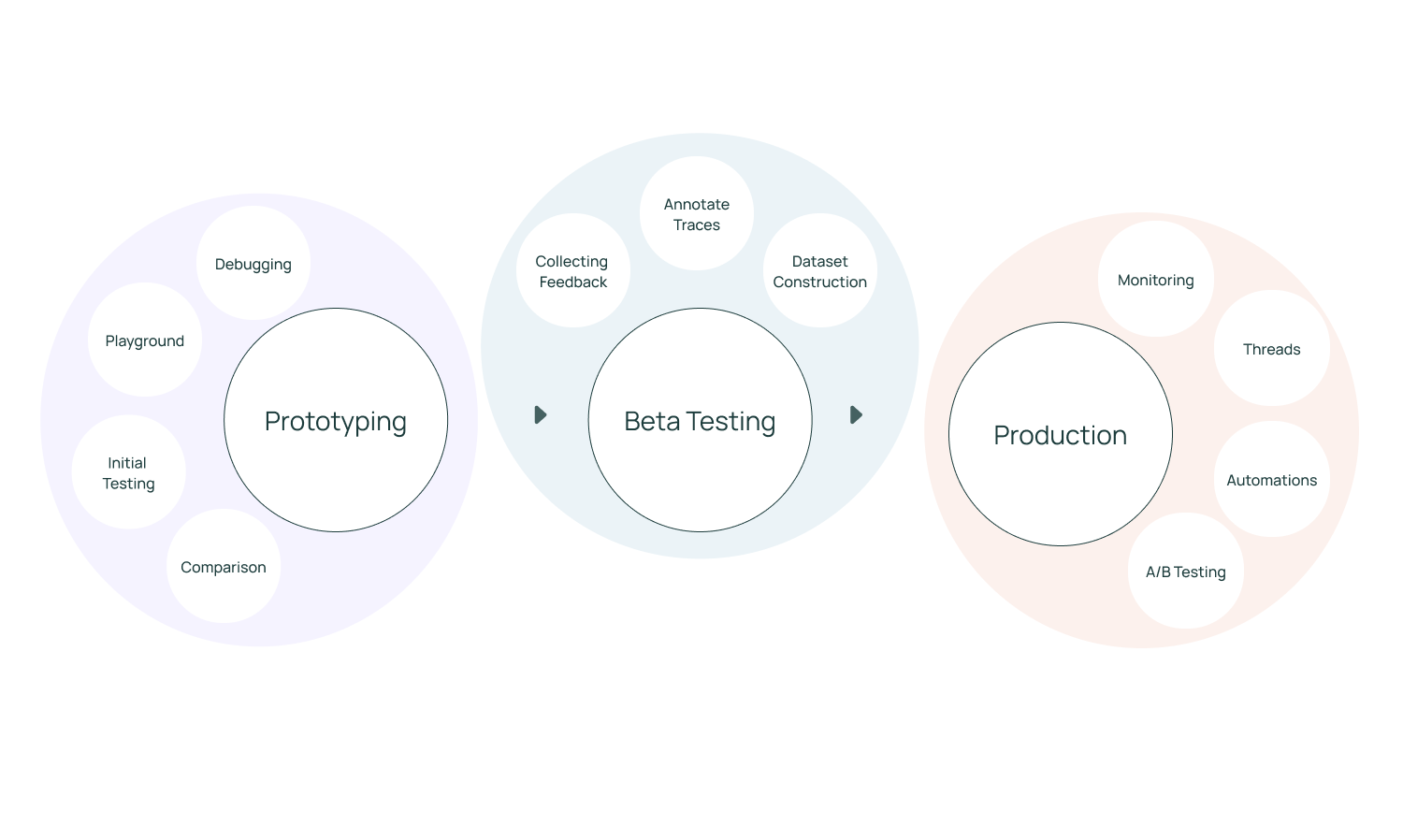

LangSmith is a platform for building production-grade LLM applications.

It lets you debug, test, evaluate, and monitor chains and intelligent agents built on any LLM framework and seamlessly integrates with LangChain, the go-to open source framework for building with LLMs.

LangSmith is developed by LangChain, the company behind the open source LangChain framework.

相关教程

- 同学小张:

- 【LangSmith: 生产级AI应用维护平台】0. 一文全览Tracing功能,让程序运行过程一目了然

https://mp.weixin.qq.com/s/PcsY6ul2kGPCFOUTTzn_1w - 【LangSmith: 生产级AI应用维护平台】1. 快速上手数据集与测试评估过程

https://mp.weixin.qq.com/s/d4x9VUTociltpEl1FHf8ww

- 【LangSmith: 生产级AI应用维护平台】0. 一文全览Tracing功能,让程序运行过程一目了然

- 深入LangSmith:如何帮助大模型(LLM)应用从原型到投入生产?【上】

https://mp.weixin.qq.com/s/x5nGYYyioNQlCxZ4tDKRpA

LangSmith基本架构:你的LLM应用(不必一定基于langchain框架)运行时向云端发送日志/信息,开发者登录langSmith的Web UI跟踪LLM调用、管理Prompt、测试输出、管理测试集、分析正确性等。

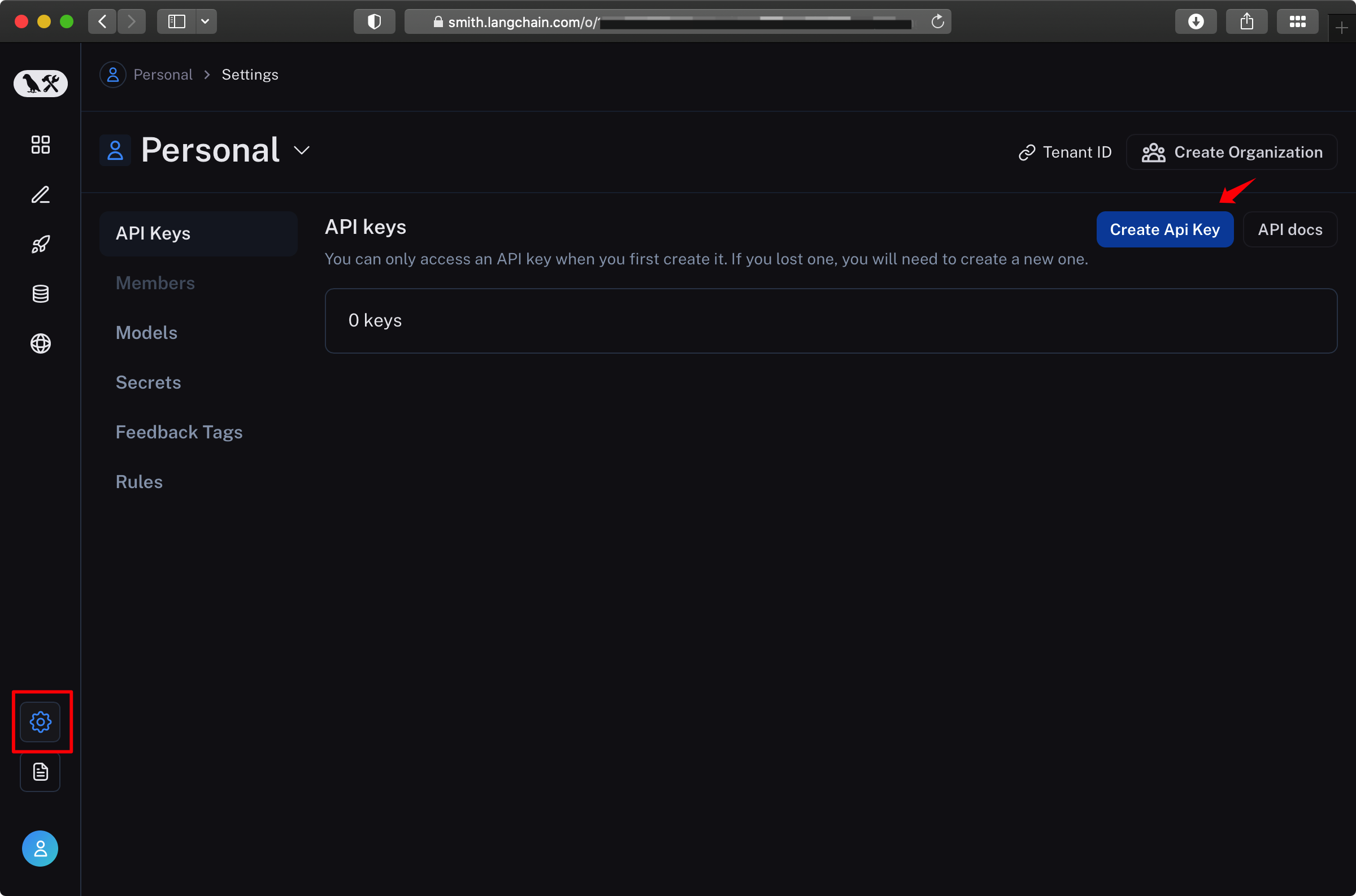

创建 API Key

创建后需要马上复制保存,因为无法查看。

没有保存,也可以删掉这个key,再创建一个。

基本代码使用

基本接入 LangSmith 只需要配置环境变量,不需要调用代码。

项目运行后,在 LangSmith 控制台查看运行情况,而非本地服务。

这里主要介绍如何接入 ,构建大模型的代码此处不展示

如果你使用 OpenAI,可以参考文章:https://mp.weixin.qq.com/s/PcsY6ul2kGPCFOUTTzn_1w

这里我使用 Qwen + ModelScope,可参考:https://blog.csdn.net/lovechris00/article/details/136985387

import osos.environ["LANGCHAIN_TRACING_V2"]="true"

os.environ["LANGCHAIN_PROJECT"]="test-001" #自定义项目名称

os.environ["LANGCHAIN_API_KEY"]="ls__xxxx"

os.environ["LANGCHAIN_ENDPOINT"]="https://api.smith.langchain.com" # 构建大模型,此处省略text = "What would be a good company name for a company that makes colorful socks?"

qwllm(text)

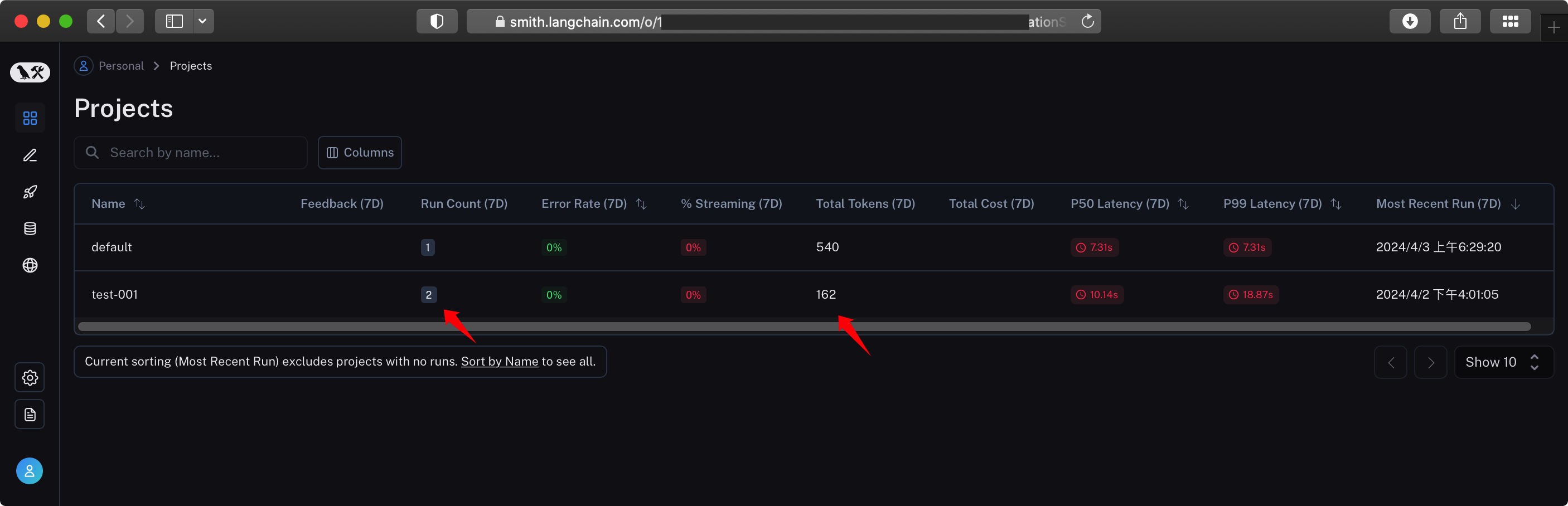

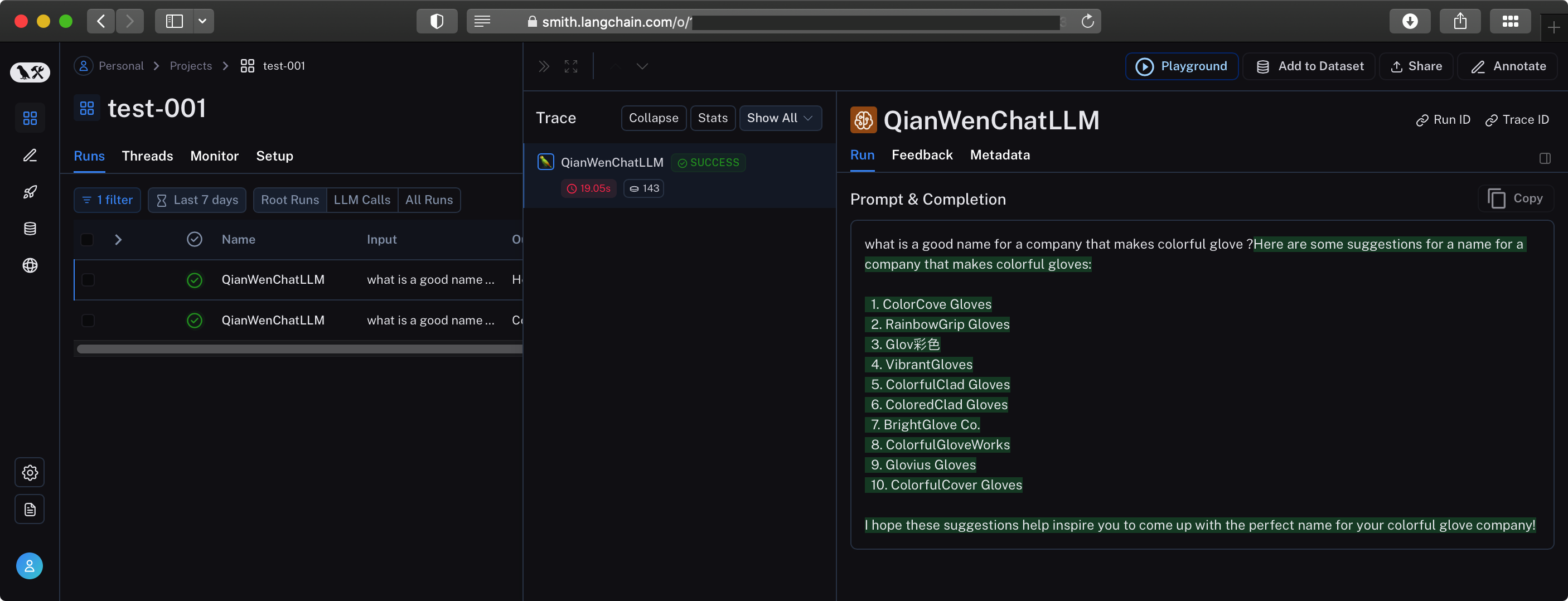

查看控制台

跑了两个 prompt,显示如下:

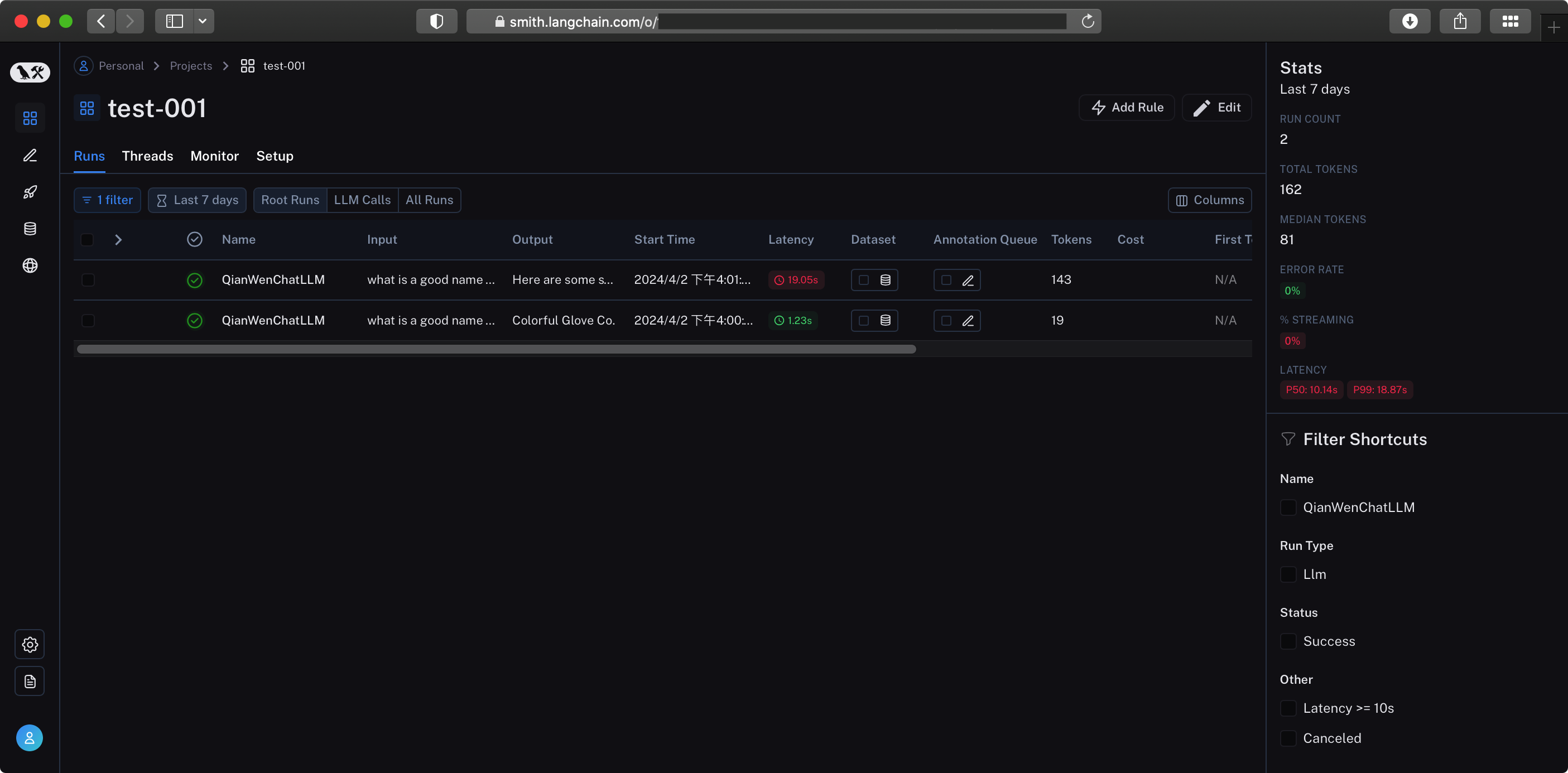

点击 Run Count 进去,可以看跑的任务

点击具体任务,右侧显示详情

伊织 2024-04-02(二)

-as-if-serial)

)

![[蓝桥杯练习]蓝桥王国](http://pic.xiahunao.cn/[蓝桥杯练习]蓝桥王国)

)

)

:添加硬币最小数量 初识贪心算法)