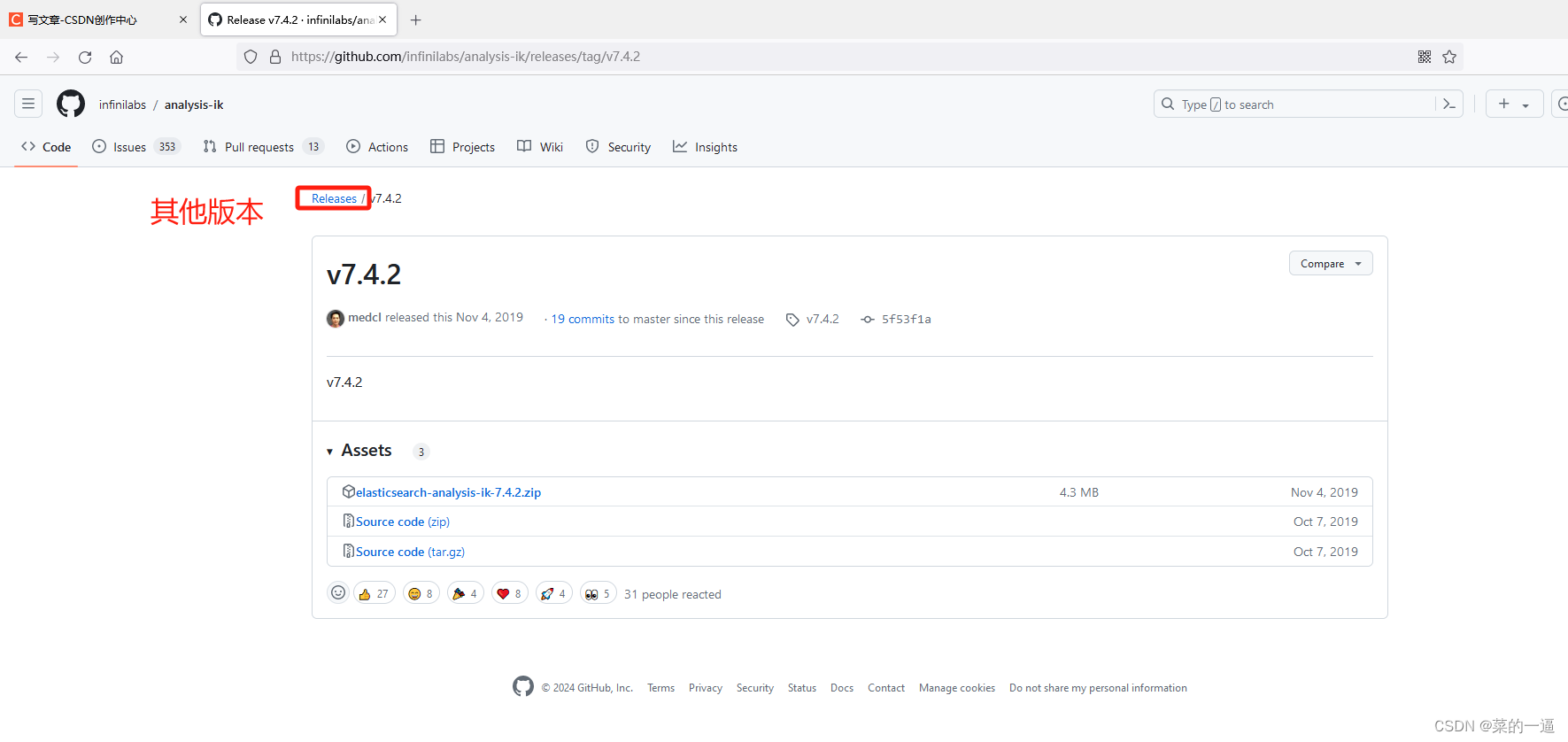

一、下载和安装

https://github.com/infinilabs/analysis-ik.git

网络不好可以用这个地址,注意:ik版本要和es版本保持一致

现成地址

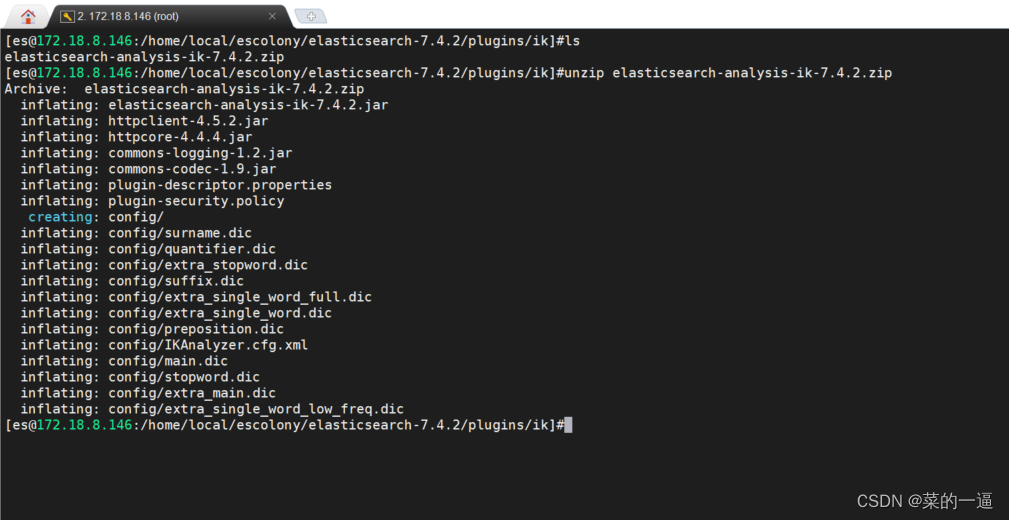

注意es用户操作或给es用户权限

plugins新建ik文件夹,并把压缩包解压到ik

unzip elasticsearch-analysis-ik-7.4.2.zip

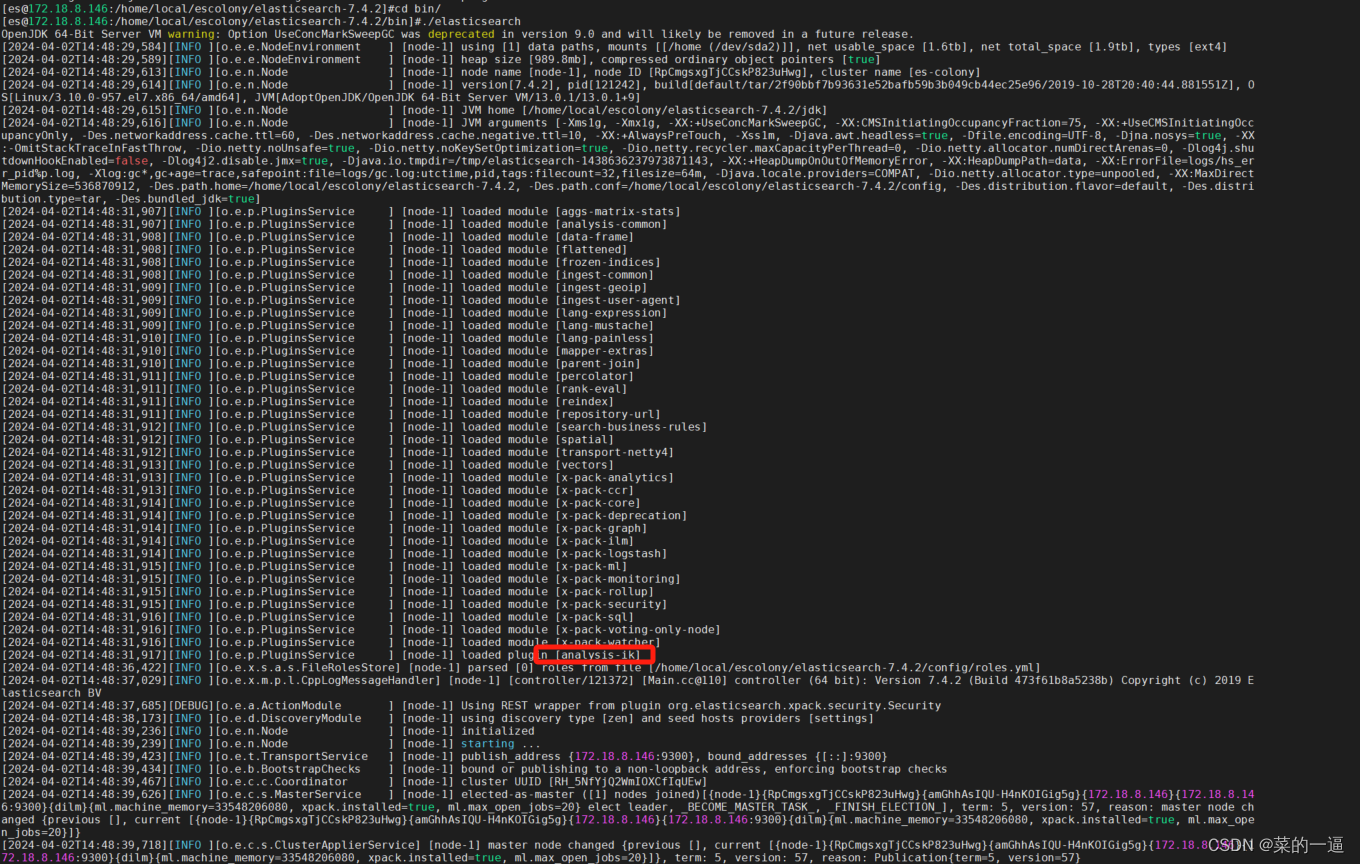

/bin目录启动es:

二、简易使用

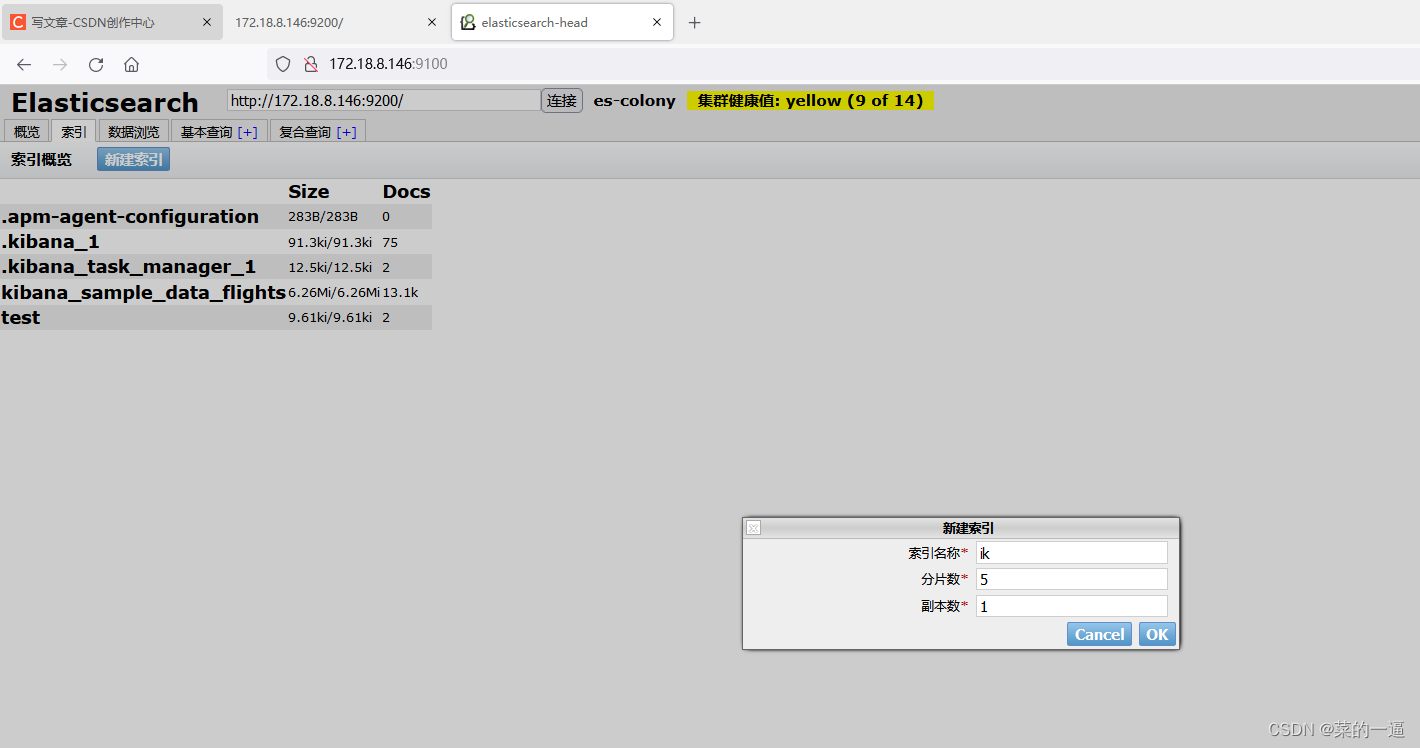

1.新建索引

打开head,新建索引ik

没有安装head的同学也可以直接敲命令创建索引(分片数5,副本数1),

curl -X PUT http://localhost:9200/ik -H 'Content-Type:application/json' -d'{"settings":{"number_of_shards":5"number_of_replicas": 1}

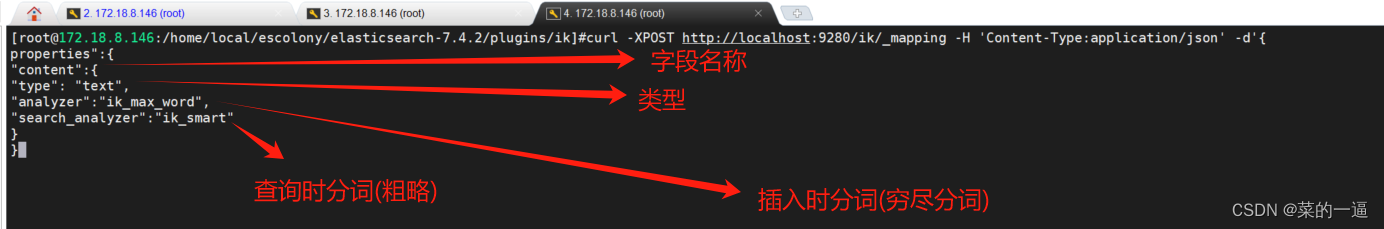

}'2.创建索引映射

映射:可以理解为mysql里面的字段,字段有varchar、double、bigint等;

常见类型有text(可以做分词)、keyword(关键词,无法分词)double、integer

官方解释如下图:

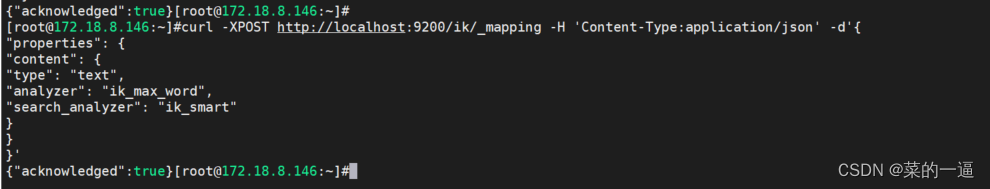

命令

curl -XPOST http://localhost:9200/ik/_mapping -H 'Content-Type:application/json' -d'{"properties":{"content":{"type": "text","analyzer":"ik_max_word","search_analyzer":"ik_smart"}}

}'

Analyzer分词配置解释:

·ik smart:粗粒度分词,比如中华人民共和国国歌,会拆分为中华人民共和国,国歌,

ik max_word:细粒度分词,比如中华人民共和国国歌,会拆分为中华人民共和国,中华人民,中华,华人人民共和国,人民,人,民,共和国,共和,和,国国,国歌,会穷尽各种可能的组合。

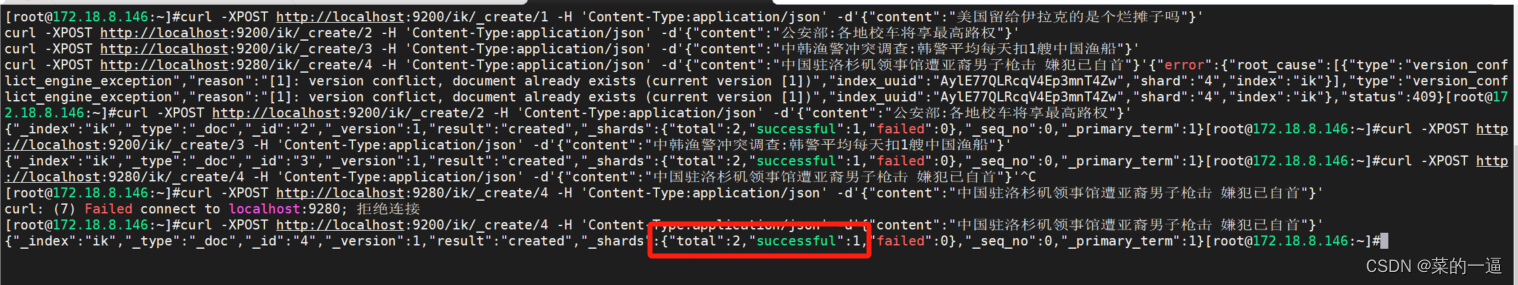

3.添加数据

示例数据:

curl -XPOST http://localhost:9200/ik/_create/1 -H 'Content-Type:application/json' -d'{"content":"美国留给伊拉克的是个烂摊子吗"}'

curl -XPOST http://localhost:9200/ik/_create/2 -H 'Content-Type:application/json' -d'{"content":"公安部:各地校车将享最高路权"}'

curl -XPOST http://localhost:9200/ik/_create/3 -H 'Content-Type:application/json' -d'{"content":"中韩渔警冲突调查:韩警平均每天扣1艘中国渔船"}'

curl -XPOST http://localhost:9200/ik/_create/4 -H 'Content-Type:application/json' -d'{"content":"中国驻洛杉矶领事馆遭亚裔男子枪击 嫌犯已自首"}'执行结果:不要关注过程,过程不重要...

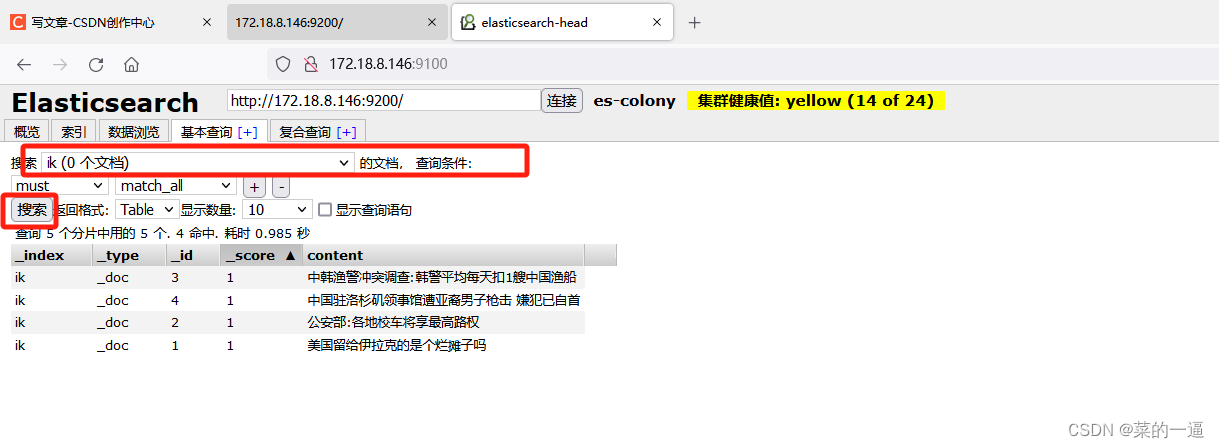

打开head,切换索引ik,点击搜索查看刚才插入的数据

4.查询

没有head的同学用命令:

curl -XGET http://localhost:9200/ik/_search?pretty -H 'Content-Type:application/json' -d'{"query": {"term" :{"content" : "中国"}}

}'

高亮查询,看标签,命令应该没问题

curl -XGET http://localhost:9200/ik/_search?pretty -H 'Content-Type:application/json' -d'

{"query" : { "match" : { "content" :"中国"}},"highlight" :{"pre_tags" :["<font color=red>" ],"post_tags" :["</font>"],"fields" :{"content" :{}}}

}'

写在最后

ik分词器有自己的分词规则,比如我拿刚才数据,搜"中"的结果

所以,这个分词,不是说有这个字,我就能分到,是有自己的规则的,是在添加数据时,按照规则进行分词,不是他的词,分不出来也搜不到,这点注意一下。

好了,这就是ik中文分词器,其实不需要做太多,就把分词器放到plugins里面启动,然后设置mapping,试着analyzer就可以了。

:使用Parchment克隆Medium)

)

![练习 17 Web [极客大挑战 2019]PHP](http://pic.xiahunao.cn/练习 17 Web [极客大挑战 2019]PHP)