贝叶斯分类器与贝叶斯学习:

贝叶斯分类器:只要是一种生成式模型,并且使用到了贝叶斯公式

贝叶斯学习:一定在使用分布估计

贝叶斯分类器并不等于贝叶斯学习

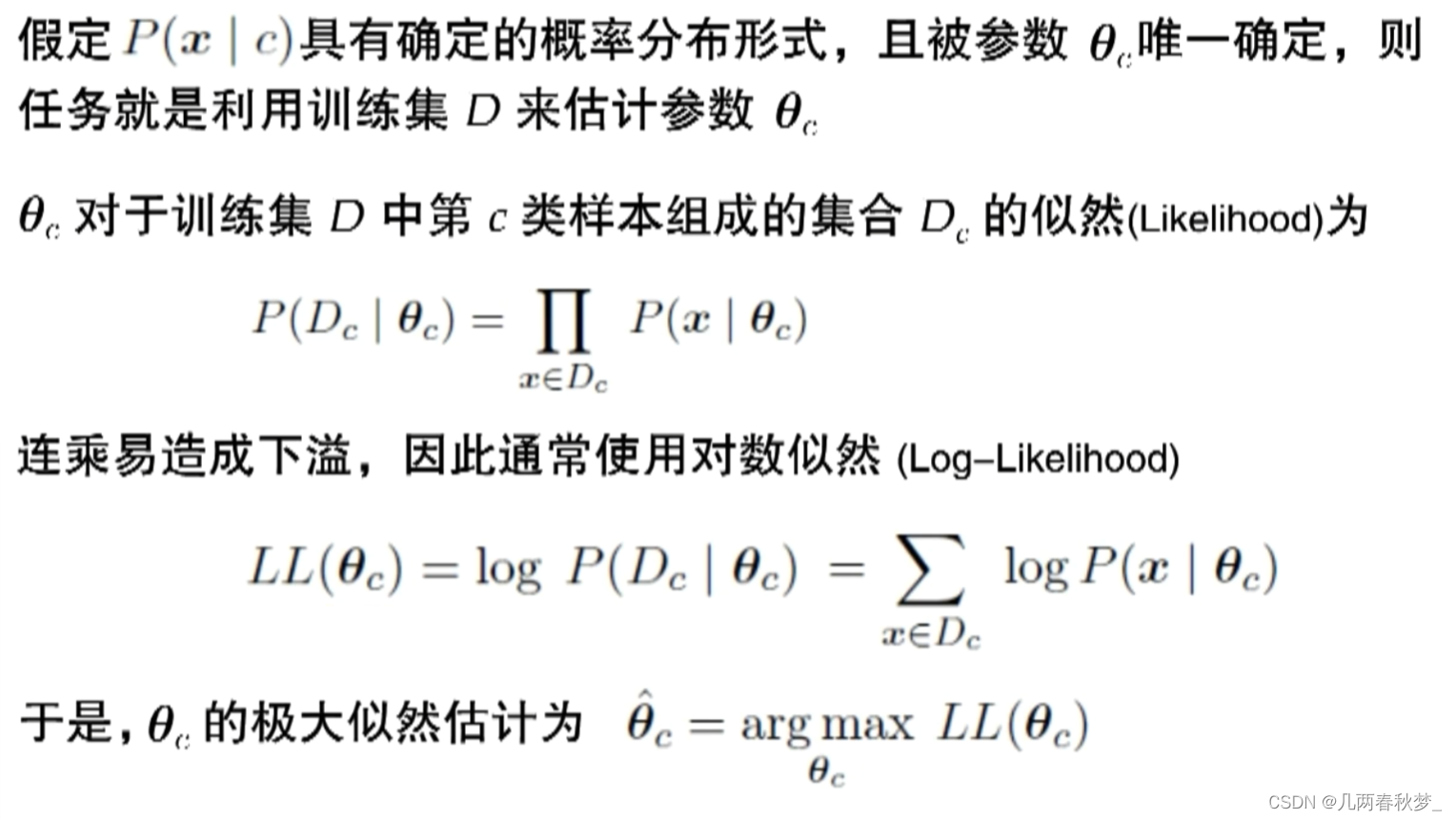

极大似然估计:

先假设某种概率分布形式,再基于训练样例对参数进行估计

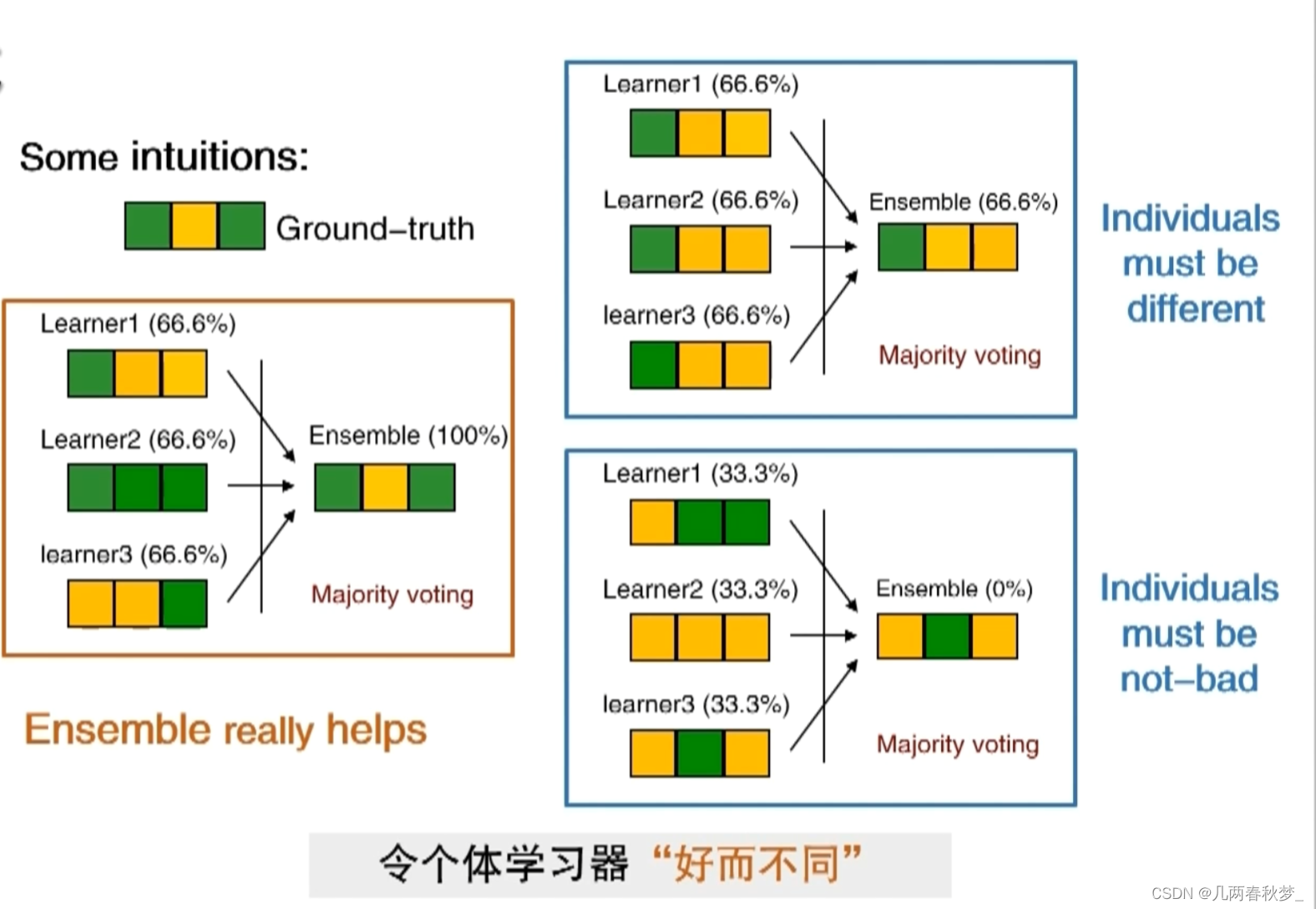

集成学习:

如何得到好的集成:

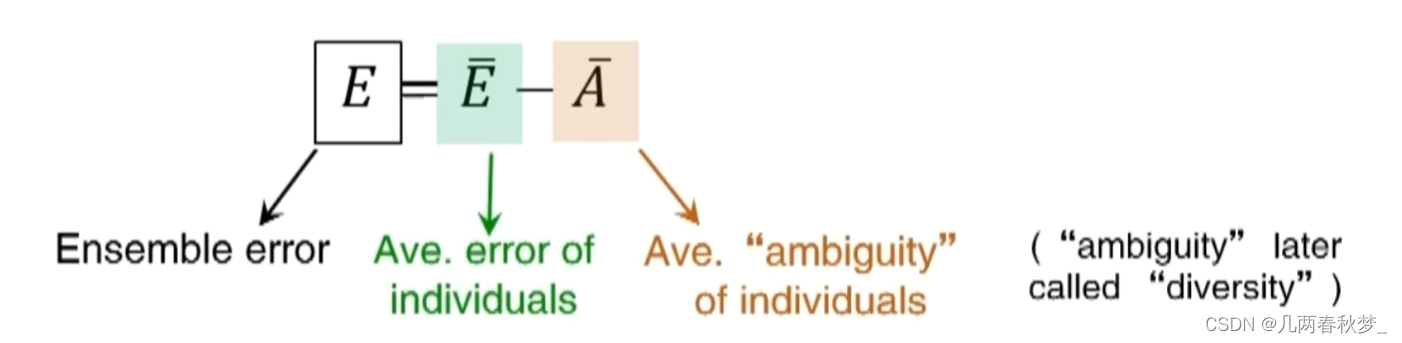

误差-分歧分期:

希望每一个个体的误差要小,希望个体间的差异比较大

集成学习方法:

1.序列化方法:AdaBoost、LPBoost、GradientBoost

2.并行化方法:Bagging、Random Forest、Random Subspace

Boosting:

越往后模型面对的困难与问题就越多,所以性能比前面的差,最后会使用加权结合将所有模型结合起来。

Bagging:

拿到一个数据集产生很多个学习器,最后将这些模型结合起来(投票做分类,平均做回归)

聚类:

在“无监督学习”任务中研究最多、应用最广

目标:将数据样本划分为若干个通常不相交的“簇”(cluster)

既可以作为一个单独过程(用于找寻数据内在的分布结构)也可以作为分类等其他学习任务的前驱过程。

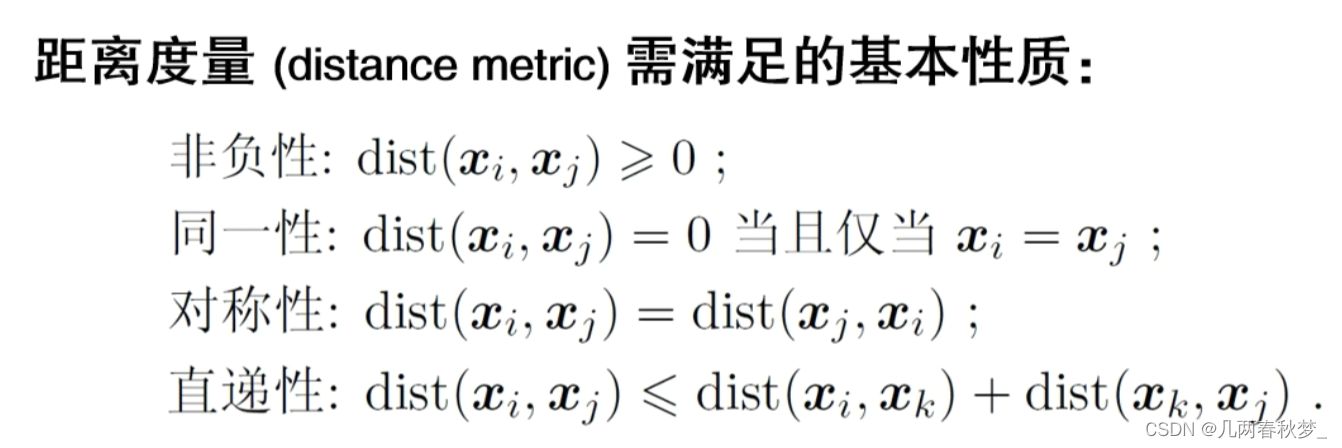

距离计算:

聚类方法概述:

聚类的"好坏"不存在绝对标准

常见聚类方法:

1.原型聚类

亦称:"基于原型的聚类"

假设:聚类结构能通过一组原型刻画

过程:先对原型初始化,然后对原型进行迭代更新求解

代表:k均值聚类、学习向量量化(LVQ)、高斯混合聚类

2.密度聚类

亦称:"基于密度的聚类"

假设:聚类结构能通过样本分布的紧密程度确定

过程:从样本密度的角度来考察样本之间的可连接性,并基于可连接样本不断扩展类簇

代表:DBSCAN、OPTICS、DENCLUE

3.层次聚类

假设:能够产生不同粒度的聚类结果

过程:在不同层次对数据集进行划分,从而形成树形的聚类结构

代表:AGNES(自底向上)、DIANA(自顶向下)

)

)

)