LLMs在处理NLP任务方面表现出色,而GNNs在挖掘和分析复杂关系数据(图数据)方面展现出其卓越的能力。这种趋势催生了将这两种技术整合的研究兴趣,为解决更多领域的实际问题。GNN结合LLMs也逐渐成为了研究的热点。

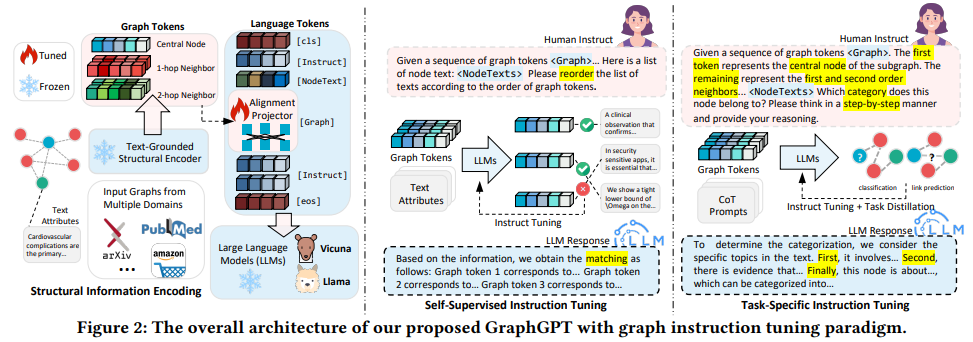

GNN+LLMs可以发挥二者的互补优势,实现更全面的数据处理和分析,以便构建更大的模型,获得更好的性能。以港大等发布的通用图大模型GraphGPT为例:

GraphGPT通过与图结构的文本信息进行对齐,结合自监督学习的图结构信号和任务特定的图指令,引导语言模型在理解复杂图结构和提高在不同任务中的适应性方面取得了显著的改进。

GraphGPT主要贡献:

1.通过引入文本-图对齐的概念,GraphGPT框架实现了图结构与自然语言空间之间的合理对齐。

2.利用自监督信号通过图匹配任务来指导语言模型的调优。通过引入这种自监督的指令调整,语言模型可以获得与图相关的领域特定的结构知识,从而增强其对图结构的理解能力。

3.通过将思维链(COT)蒸馏引入框架,GraphGPT增强了逐步推理的能力,并在面对分布转移时提高了性能。

目前,GNN结合LLMs主要有三大创新方向:LLM作为增强器、LLM作为预测器和GNN-LLM对齐。GraphGPT就属于LLM作为预测器这类。

本文整理了这三大创新方向最新的代表性成果(共16篇),模型原文以及开源代码已附,方便各位复现。

论文原文以及代码需要的同学看文末

LLM作为增强器

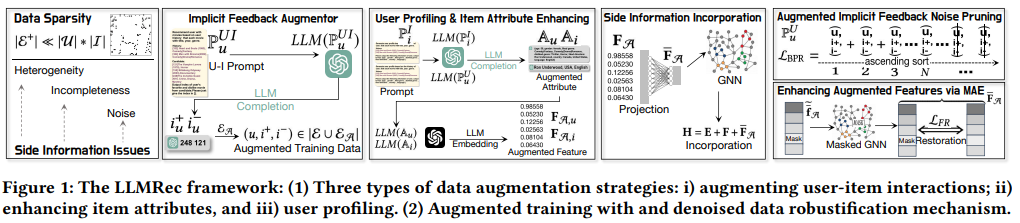

LLMRec: Large Language Models with Graph Augmentation for Recommendation

方法:通过使用LLM增强模型来解决稀疏隐式反馈信号和低质量辅助信息的挑战,通过对用户交互偏好进行分析和去偏执化的项目属性。同时,为了确保增强数据的质量,引入了去噪增强鲁棒机制。

创新点:

-

数据增强方法:作者引入了一种去噪的增强鲁棒性机制,以确保增强数据的质量。这种方法通过利用大模型的共识知识,使用LLMs作为推断模型,增强边缘和加强节点特征,从而提高模型的性能。

-

通过LLM增强的推荐模型:作者提出了一种LLMRec模型,该模型通过建立LLMs对用户互动偏好进行建模和解除项目属性偏差,从而解决了稀疏隐式反馈信号和低质量辅助信息的挑战。

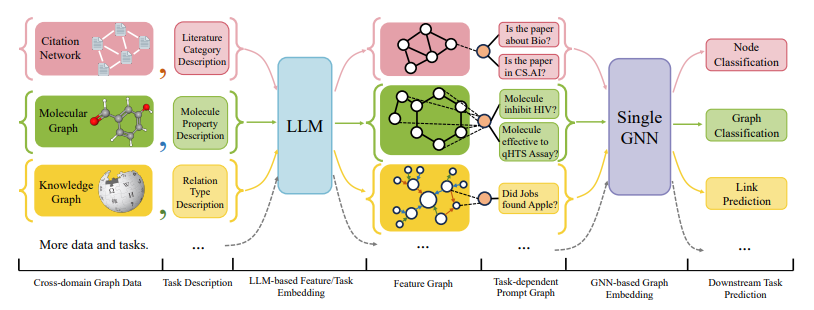

One for All: Towards Training One Graph Model for All Classification Tasks

方法:研究提出了一种名为OFA的通用框架,可以利用一个单一的图模型来解决图领域中的多样化任务。OFA使用文本属性图来统一不同的图数据,并使用语言模型将不同领域的文本属性编码成相同嵌入空间中的特征向量。

创新点:

-

利用Text-attributed graphs (TAGs)将不同领域的图数据统一为同一种格式,使得一个单一的LLM可以将所有TAGs编码到同一个嵌入空间中。

-

引入Nodes-of-Interest (NOI) subgraph和NOI prompt node的概念,将不同类型的图任务统一起来,并提升基于图模型的学习能力。

-

提出了Graph Prompting Paradigm (GPP)来实现图数据的上下文学习,通过将prompt graph插入原始输入图中,使得模型可以根据任务从图中获取相关信息,实现多任务学习和零样本学习的能力。

LLM作为预测器

Can Language Models Solve Graph Problems in Natural Language?

方法:论文提出了一种名为NLGraph(Natural Language Graph)的综合基准,用于评估大型语言模型在自然语言中处理图形和结构推理的能力。NLGraph包含29,370个问题,涵盖了八个不同复杂度的图推理任务,从简单的连通性和最短路径到复杂的最大流和模拟图神经网络。

创新点:

-

作者通过设计两种特殊情况(链和团)来评估LLMs在连接性任务上的脆弱性。

-

作者提出了“构建图形提示”和“算法提示”两种指导方法,显著提高了LLMs在解决自然语言图问题方面的性能。

-

NLGraph基准提供了一个全面的测试平台,涵盖了八个具有不同复杂性的图推理任务。

GNN-LLM对齐

GRENADE: Graph-Centric Language Model for Self-Supervised Representation Learning on Text-Attributed Graphs

方法:作者开发一种新的图中心语言模型——Grenade,旨在为各种下游任务创建具有表现力和可泛化性的表示。通过优化两个专门的自监督学习算法:图中心对比学习和图中心知识对齐,Grenade能够有效地捕捉文本属性图上的信息文本语义和结构上下文信息。

创新点:

- 图中心语言模型Grenade:

-

通过结合预训练语言模型和图神经网络的协同效应,Grenade有效地捕捉了文本属性图上的信息文本语义和结构上下文信息。

-

Grenade利用了两种专门的自监督学习算法进行优化:图中心对比学习和图中心知识对齐。

-

- 图中心对比学习:

-

与传统的实例级对比学习不同,图中心对比学习还强调邻近节点共享相似表示。

-

不同于现有方法,该方法通过考虑局部邻域信息来扩展正样本构建的设计,以捕捉复杂的图结构。

-

图中心对比学习有效地帮助Grenade捕捉了TAG上的信息文本语义以及结构上下文信息。

-

- 图中心知识对齐:

-

节点级知识对齐通过以跨模态形式进行图中心对比学习,对两个编码器学习的表示进行对齐。

-

邻域级知识对齐通过最小化两个编码器计算的邻域相似性分布之间的KL散度,对两个编码器之间的知识进行对齐。

-

关注下方《学姐带你玩AI》🚀🚀🚀

回复“大模型GNN”获取全部论文+代码

码字不易,欢迎大家点赞评论收藏

)

)

![[实战]API防护破解之签名验签](http://pic.xiahunao.cn/[实战]API防护破解之签名验签)

)