策略梯度网络是强化学习中的一类算法,它们直接学习一个策略,该策略可以映射从环境状态到采取的动作。与值函数方法(如Q学习和深度Q网络)不同,策略梯度方法通过优化策略本身来实现目标,即直接调整其输出动作的概率,以最大化累积奖励。这类方法的核心优势在于它们能够自然地处理连续动作空间和确定性策略,使之在许多复杂环境中特别有效。

策略梯度方法的基本原理

策略梯度方法依赖于策略函数 ,它以环境的状态 s 为输入,输出执行动作 a 的概率,其中 θ 表示策略参数。通过与环境交互获得的经验,策略梯度算法会估计这个策略函数的性能,并调整参数 θ 来提高这个性能,即增加获得更多奖励的概率。

,它以环境的状态 s 为输入,输出执行动作 a 的概率,其中 θ 表示策略参数。通过与环境交互获得的经验,策略梯度算法会估计这个策略函数的性能,并调整参数 θ 来提高这个性能,即增加获得更多奖励的概率。

策略梯度定理

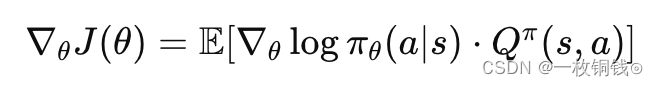

策略梯度算法的核心是策略梯度定理,该定理提供了一个用于计算策略参数梯度的公式。根据这个定理,策略的期望回报关于策略参数的梯度可以通过以下公式计算:

其中,J(θ) 是策略πθ 的性能函数,通常是累积奖励的期望值; 是在状态s下采取动作a 并遵循策略π 获得的未来累积奖励的期望值。

是在状态s下采取动作a 并遵循策略π 获得的未来累积奖励的期望值。

)

)

Ability应用模型概述)