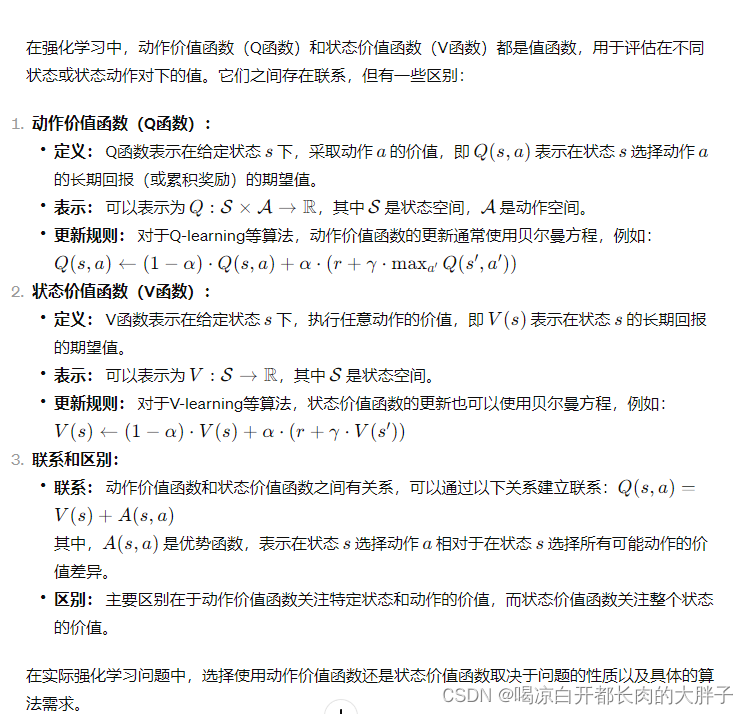

在强化学习中,动作价值函数(Q函数)和状态价值函数(V函数)都是值函数,用于评估在不同状态或状态动作对下的值。它们之间存在联系,但有一些区别:

-

动作价值函数(Q函数):

- 定义: Q函数表示在给定状态 (s) 下,采取动作 (a) 的价值,即 (Q(s, a)) 表示在状态 (s) 选择动作 (a) 的长期回报(或累积奖励)的期望值。

- 表示: 可以表示为 (Q: \mathcal{S} \times \mathcal{A} \rightarrow \mathbb{R}),其中 (\mathcal{S}) 是状态空间,(\mathcal{A}) 是动作空间。

- 更新规则: 对于Q-learning等算法,动作价值函数的更新通常使用贝尔曼方程,例如:

[ Q(s, a) \leftarrow (1 - \alpha) \cdot Q(s, a) + \alpha \cdot (r + \gamma \cdot \max_{a’} Q(s’, a’)) ]

-

状态价值函数(V函数):

- 定义: V函数表示在给定状态 (s) 下,执行任意动作的价值,即 (V(s)) 表示在状态 (s) 的长期回报的期望值。

- 表示: 可以表示为 (V: \mathcal{S} \rightarrow \mathbb{R}),其中 (\mathcal{S}) 是状态空间。

- 更新规则: 对于V-learning等算法,状态价值函数的更新也可以使用贝尔曼方程,例如:

[ V(s) \leftarrow (1 - \alpha) \cdot V(s) + \alpha \cdot (r + \gamma \cdot V(s’)) ]

-

联系和区别:

- 联系: 动作价值函数和状态价值函数之间有关系,可以通过以下关系建立联系:[ Q(s, a) = V(s) + A(s, a) ]

其中,(A(s, a)) 是优势函数,表示在状态 (s) 选择动作 (a) 相对于在状态 (s) 选择所有可能动作的价值差异。 - 区别: 主要区别在于动作价值函数关注特定状态和动作的价值,而状态价值函数关注整个状态的价值。

- 联系: 动作价值函数和状态价值函数之间有关系,可以通过以下关系建立联系:[ Q(s, a) = V(s) + A(s, a) ]

在实际强化学习问题中,选择使用动作价值函数还是状态价值函数取决于问题的性质以及具体的算法需求。

)

)

二)