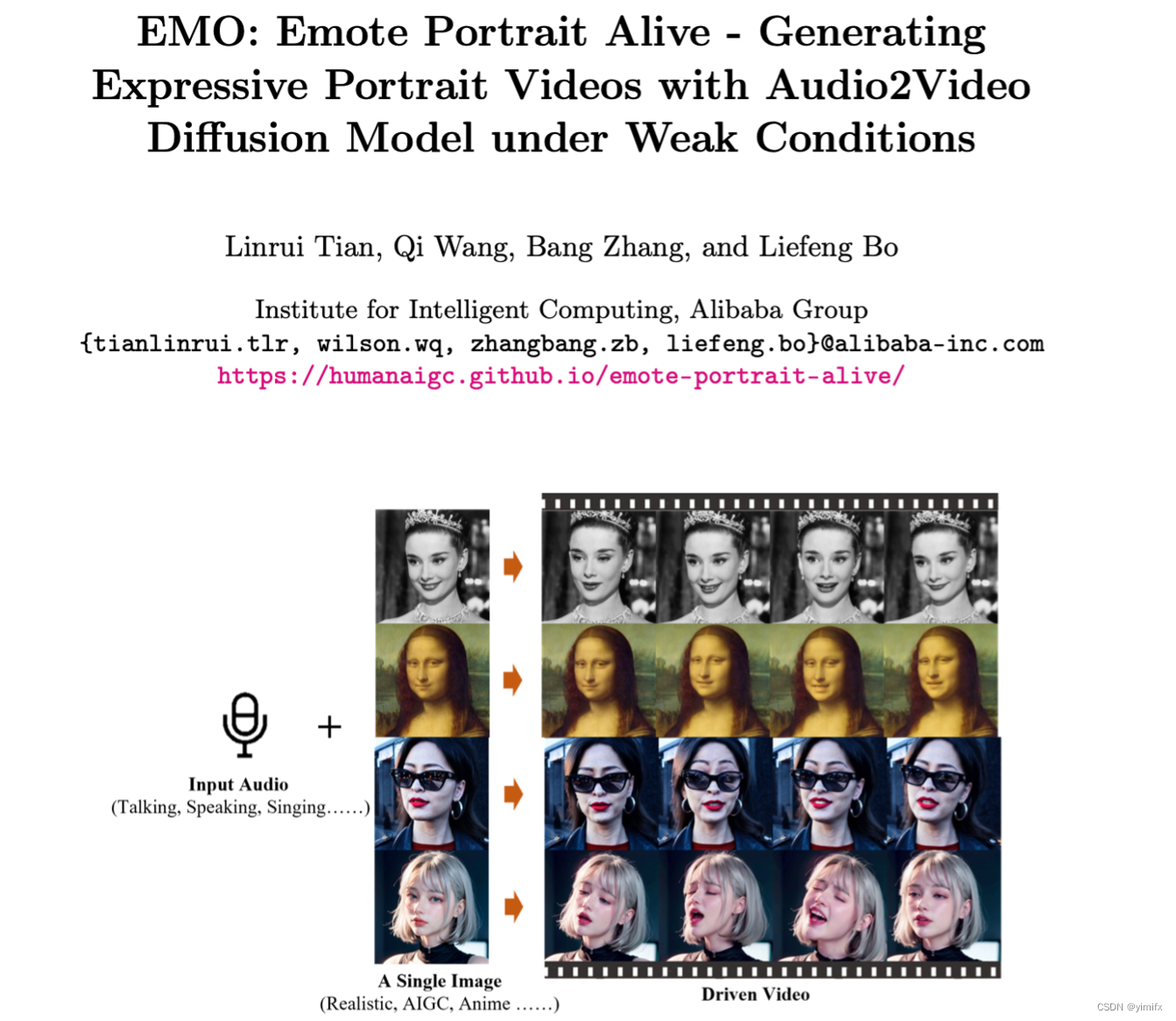

3 月 1 日消息,阿里巴巴研究团队近日发布了一款名为“EMO(Emote Portrait Alive)”的 AI 框架,该框架号称可以用于“对口型”,只需要输入人物照片及音频,模型就能够让照片中的人物开口说出相关音频,支持中英韩等语言。

据悉,EMO 基于英伟达的 Audio2Video 扩散模型打造,号称使用了超过 250 小时的专业视频进行训练,从而得到了相关 AI 框架。

注意到,研究团队分享了几段由 EMO 框架生成的 DEMO 演示片段,并在 ArXiv 上发布了模型的工作原理,感兴趣的小伙伴也可以访问 GitHub 查看项目。

据介绍,该框架工作过程分为两个主要阶段,研究人员首先利用参考网络(ReferenceNet)从参考图像和动作帧中提取特征,之后利用预训练的音频编码器处理声音并嵌入,再结合多帧噪声和面部区域掩码来生成视频,该框架还融合了两种注意机制和时间模块,以确保视频中角色身份的一致性和动作的自然流畅。

研究人员援引一系列实验结果,声称 EMO 不仅能够产生令人信服的说话视频,还能生成各种风格的歌唱视频,号称“显著优于目前的 DreamTalk、Wav2Lip、SadTalker 等竞品”。

据悉,你只需要提供一张照片和一段任意音频文件,EMO即可生成会说话唱歌的 AI 视频,以及实现无缝对接的动态小视频,最长时间可达1分30秒左右。表情非常到位,任意语音、任意语速、任意图像都可以一一对应。

比如,《狂飙》电视剧中“高启强”畅谈罗翔普法;蔡徐坤的一张图片,就能通过其他音频配合“唱出”一首rapper饶舌,连口型都几乎一模一样;甚至前不久OpenAI发布的Sora案例视频里面,一位 AI 生成的带墨镜的日本街头女主角,现在不仅能让她开口说话,而且还能唱出好听的歌曲。

阿里研究团队表示,EMO可以生成具有表情丰富的面部表情和各种头部姿势的声音头像视频,同时,其可以根据输入视频的长度生成任意持续时间的视频。

同时,EMO还拥有音频驱动的人像视频生成,表情丰富的动态渲染,多种头部转向姿势支持、增加视频的动态性和真实感,支持多种语言和肖像风格,快速节奏同步,跨演员表现转换等多个特点与功能。

技术层面,阿里研究人员分享称,EMO框架使用 Audio2Video 扩散模型,生成富有表现力的人像视频。

该技术主要包括三个阶段:一是帧编码的初始阶段,ReferenceNet 用于从参考图像和运动帧中提取特征;二是在扩散过程阶段,预训练的音频编码器处理音频嵌入。面部区域掩模与多帧噪声集成以控制面部图像的生成;三是使用主干网络来促进去噪操作。在主干网络中,应用了两种形式——参考注意力和音频注意力机制,这些机制分别对于保留角色的身份和调节角色的动作至关重要。此外,EMO的时间模块用于操纵时间维度,并调整运动速度。

目前,EMO框架上线到GitHub中,相关论文也在arxiv上公开。

GitHub:https://github.com/HumanAIGC/EMO

论文:https://arxiv.org/abs/2402.17485

事实上,过去一年,阿里巴巴在 AI 方面持续发力,包括阿里云推出通义千问、通义万相等多款对标 OpenAI 的 AI 大模型产品,以及基于双流条件扩散模型的真人百变换装技术Outfit Anyone、角色动画模型Animate Anyone等技术,实现多个场景应用。

今年1月26日,阿里推出的Qwen-VL模型实现多次迭代升级,并宣布 Plus 和 Max 两大版本升级,支持以图像、文本作为输入,并以文本、图像、检测框作为输出,让大模型真正具备了“看”世界的能力。

阿里方面称,相比于开源版本的 Qwen-VL,Plus 和 Max 版本模型在多项图文多模态标准测试中获得了堪比 Gemini Ultra 和 GPT-4V 的水准,并大幅超越此前开源模型的最佳水平。

“在可见的未来,我们生活中所有习以为常的产品形态都会发生变化,会有更智能的下一代产品进入我们的生活。更多中小企业将通过AI化协同,灵活替代一部分目前只有大企业才能提供的服务。生产、制造、流通的组织方式和协作方式也会发生根本性变革。AI助理会无处不在,成为每个人工作、生活、学习中的助手。每个企业也都会配备AI助手,就像我们今天的智能汽车,辅助驾驶和自动驾驶已经成为标配。”吴泳铭称。

)

)

)

)

)