传奇开心果短博文系列

- 系列短博文目录

- Python文本和语音相互转换库技术点案例示例系列

- 短博文目录

- 前言

- 一、雏形示例代码

- 二、扩展思路介绍

- 三、批量处理文本示例代码

- 四、自定义语音设置示例代码

- 五、结合其他库和API示例代码

- 六、语音交互系统示例代码

- 七、多语言支持示例代码

- 八、添加语音提示和反馈示例代码

- 九、结合图形界面示例代码

- 十、文本预处理和语音合成示例代码

- 十一、导出语音文件示例代码

- 十二、语音识别和语音合成的结合示例代码

- 十三、归纳总结

系列短博文目录

Python文本和语音相互转换库技术点案例示例系列

短博文目录

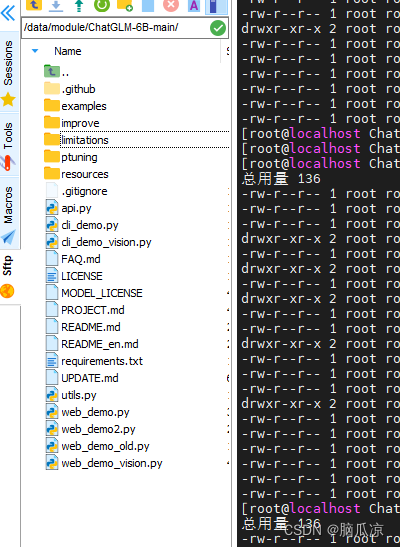

前言

使用

使用pyttsx3库创建自动化脚本有几个主要作用:

-

语音提示和反馈:通过将文本转换为语音输出,你可以为自动化脚本添加语音提示和反馈功能。这样,你可以通过语音提示告知用户脚本的进度、状态或结果,提供更直观和人性化的交互体验。

-

语音报告和通知:自动化脚本可以将生成的报告或通知以语音形式输出,使得用户可以通过听取语音报告来获取脚本执行的结果或重要信息。这对于需要在视觉上无法直接观察脚本输出的场景非常有用。

-

辅助无障碍功能:

pyttsx3库可以帮助实现无障碍功能,使得视觉障碍用户能够通过听取语音输出来与自动化脚本进行交互。这样,无障碍用户也可以享受到自动化脚本带来的便利和功能。 -

自动化语音交互系统:你可以结合

pyttsx3库和其他库或API,创建一个完整的语音交互系统。通过语音输入和语音输出,用户可以通过语音与脚本进行交互,实现更自然和便捷的操作。 -

多语言支持:

pyttsx3库支持多种语言和语音引擎,你可以根据需要选择合适的语言进行语音输出。这使得你可以为不同语言的用户提供本地化的语音交互体验。

总的来说,pyttsx3库为自动化脚本提供了语音合成的能力,使得脚本可以通过语音与用户进行交互、输出报告和通知,以及实现无障碍功能。这为脚本的使用者提供了更多的选择和便利,增强了脚本的可用性和用户体验。

一、雏形示例代码

下面是一个使用

下面是一个使用pyttsx库创建自动化脚本的示例:

import pyttsx3# 创建一个TTS引擎实例

engine = pyttsx3.init()# 设置要说的文本

text = "Hello, World!"# 说出文本

engine.say(text)# 等待引擎完成语音输出

engine.runAndWait()

这个脚本会使用pyttsx3库创建一个TTS(Text-to-Speech)引擎实例,然后设置要说的文本并将其传递给引擎进行语音输出。engine.say()函数用于将文本传递给引擎,engine.runAndWait()函数用于等待引擎完成语音输出。

你可以根据需要修改text的值来设置要说的文本,然后运行脚本即可听到语音输出。请确保已经安装了pyttsx3库,如果没有安装,可以使用以下命令进行安装:

pip install pyttsx3

二、扩展思路介绍

当涉及到使用

当涉及到使用pyttsx3库创建自动化脚本时,你可以考虑以下扩展思路:

-

批量处理文本:你可以编写一个脚本,从文件中读取一系列文本,然后使用

pyttsx3逐个将它们转换为语音输出。这对于批量处理大量文本文件或生成大量语音文件非常有用。 -

自定义语音设置:

pyttsx3库允许你设置语音的属性,如音量、语速、语调等。你可以根据需要调整这些属性,以获得更符合你要求的语音输出。 -

结合其他库和API:你可以将

pyttsx3与其他库和API结合使用,以实现更复杂的自动化任务。例如,你可以使用文本分析库来提取关键信息,然后使用pyttsx3将这些信息转换为语音输出。或者,你可以结合语音识别库,将语音转换为文本,然后使用pyttsx3将文本转换回语音输出。 -

语音交互系统:你可以使用

pyttsx3库创建一个简单的语音交互系统。通过监听用户的语音输入,将其转换为文本,然后使用pyttsx3将回应转换为语音输出。这可以用于构建语音助手、语音控制系统等。 -

多语言支持:

pyttsx3库支持多种语言和语音引擎。你可以根据需要切换语言和语音引擎,以实现多语言的语音输出。 -

添加语音提示和反馈:除了将文本转换为语音输出,你还可以使用

pyttsx3库为你的脚本添加语音提示和反馈。例如,在长时间运行的任务中,你可以使用语音提示来告知进度或完成情况。 -

结合图形界面:如果你正在开发一个图形界面应用程序,你可以将

pyttsx3与图形界面库(如Tkinter、PySide6等)结合使用,以实现语音交互的用户界面。这样,用户不仅可以通过界面操作应用程序,还可以通过语音与应用程序进行交互。 -

文本预处理和语音合成:在将文本传递给

pyttsx3进行语音合成之前,你可以进行一些文本预处理操作,如文本清洗、分词、标记化等。这可以帮助提高语音合成的质量和准确性。 -

导出语音文件:除了实时语音输出,

pyttsx3还支持将语音输出保存为音频文件。你可以使用该功能将语音输出保存为文件,以备后续使用或分享。 -

语音识别和语音合成的结合:如果你的脚本需要进行语音输入和输出,你可以结合语音识别库(如SpeechRecognition)和

pyttsx3,实现语音输入转换为文本,然后将文本转换为语音输出的完整语音交互过程。

这些扩展思路可以帮助你进一步发挥pyttsx3库的功能,根据你的需求定制自动化脚本。记得根据需要查阅相关文档,并灵活运用这些思路来满足你的具体需求。

三、批量处理文本示例代码

当使用

当使用pyttsx3库批量处理文本时,你可以编写一个脚本来读取文本文件,并将每个文本逐个转换为语音输出。以下是一个示例代码,演示如何实现这个功能:

import pyttsx3def text_to_speech(text, output_file):engine = pyttsx3.init()engine.save_to_file(text, output_file)engine.runAndWait()def process_text_files(file_list):for file_path in file_list:with open(file_path, 'r') as file:text = file.read()output_file = f"output_{file_path}.mp3"text_to_speech(text, output_file)print(f"Converted {file_path} to {output_file}")# 批量处理文本文件

file_list = ["file1.txt", "file2.txt", "file3.txt"]

process_text_files(file_list)

在这个示例代码中,我们定义了一个text_to_speech函数,它接受一个文本字符串和一个输出文件路径作为参数。这个函数使用pyttsx3库来将文本转换为语音,并将语音保存到指定的输出文件中。

然后,我们定义了一个process_text_files函数,它接受一个文本文件路径的列表作为参数。在这个函数中,我们遍历每个文件路径,打开文本文件并读取其中的文本内容。然后,我们生成一个对应的输出文件路径,并调用text_to_speech函数将文本转换为语音并保存到输出文件中。

最后,我们定义了一个文件路径列表file_list,包含要处理的文本文件的路径。你可以根据实际情况修改这个列表,添加或删除文件路径。

运行这个示例代码后,它将逐个处理文本文件,并将每个文本转换为对应的语音输出文件。输出文件的命名方式为output_原文件名.mp3,例如output_file1.txt.mp3。

请注意,这只是一个简单的示例代码,你可以根据自己的需求进行修改和扩展。例如,你可以添加错误处理、调整语音设置、修改输出文件格式等。

当扩展示例代码以添加错误处理、调整语音设置和修改输出文件格式时,可以进行如下修改:

import pyttsx3def text_to_speech(text, output_file, voice_id=None, rate=None, volume=None):engine = pyttsx3.init()# 设置语音引擎属性if voice_id:voices = engine.getProperty('voices')engine.setProperty('voice', voices[voice_id].id)if rate:engine.setProperty('rate', rate)if volume:engine.setProperty('volume', volume)try:engine.save_to_file(text, output_file)engine.runAndWait()print(f"Converted text to {output_file}")except pyttsx3.Error as e:print(f"Error occurred: {e}")def process_text_files(file_list, voice_id=None, rate=None, volume=None, output_format='mp3'):for file_path in file_list:with open(file_path, 'r') as file:text = file.read()output_file = f"output_{file_path}.{output_format}"text_to_speech(text, output_file, voice_id, rate, volume)# 批量处理文本文件

file_list = ["file1.txt", "file2.txt", "file3.txt"]

process_text_files(file_list, voice_id=0, rate=150, volume=1.5, output_format='wav')

在这个修改后的示例代码中,我们对text_to_speech函数进行了修改,添加了错误处理和语音设置的功能。在错误处理部分,我们使用try-except语句捕获pyttsx3.Error异常,并打印出错误消息。这样可以在出现错误时,及时通知用户并进行相应处理。

在语音设置部分,我们添加了三个参数:voice_id、rate和volume。voice_id参数用于选择语音引擎的声音,可以通过设置不同的索引值来选择不同的声音。rate参数用于调整语音的速度,可以设置一个整数值,表示语音的速度。volume参数用于调整语音的音量,可以设置一个浮点数值,表示音量的大小。

在process_text_files函数中,我们添加了output_format参数,用于指定输出文件的格式。默认为mp3格式。你可以根据需要修改为其他支持的格式,如wav、ogg等。

最后,我们调用process_text_files函数时,传入了相应的参数来进行语音设置和输出文件格式的修改。你可以根据实际需求调整这些参数的值。

请注意,这只是一个示例代码,你可以根据自己的需求进行修改和扩展。例如,你可以添加更多的语音设置选项、修改输出文件命名方式、添加更详细的错误处理逻辑等。

四、自定义语音设置示例代码

当使用

当使用pyttsx3库自定义语音设置时,你可以根据需要调整音量、语速、语调等属性。以下是一个示例代码,演示如何设置这些属性:

import pyttsx3def text_to_speech(text, output_file, voice_id=None, rate=None, volume=None, pitch=None):engine = pyttsx3.init()# 设置语音引擎属性if voice_id:voices = engine.getProperty('voices')engine.setProperty('voice', voices[voice_id].id)if rate:engine.setProperty('rate', rate)if volume:engine.setProperty('volume', volume)if pitch:engine.setProperty('pitch', pitch)try:engine.save_to_file(text, output_file)engine.runAndWait()print(f"Converted text to {output_file}")except pyttsx3.Error as e:print(f"Error occurred: {e}")# 示例调用

text = "Hello, how are you?"

output_file = "output.mp3"

text_to_speech(text, output_file, volume=1.5, rate=150, pitch=50)

在这个示例代码中,我们修改了text_to_speech函数,添加了pitch参数用于设置语音的语调。

pyttsx3库的setProperty方法可以用来设置语音引擎的属性。我们使用setProperty方法来设置音量(volume)、语速(rate)、语调(pitch)等属性。

在示例调用中,我们传入了相应的参数来设置音量为1.5倍,语速为150,语调为50。你可以根据需要调整这些参数的值。

请注意,具体可用的属性值和范围可能因语音引擎和系统而有所不同。你可以根据自己的需求和实际情况进行调整。

五、结合其他库和API示例代码

结合其他库和API可以实现更复杂的自动化任务。以下是一个示例代码,演示了如何结合文本分析库和

结合其他库和API可以实现更复杂的自动化任务。以下是一个示例代码,演示了如何结合文本分析库和pyttsx3库,以提取关键信息并将其转换为语音输出:

import pyttsx3

from nltk import pos_tag, word_tokenizedef extract_keywords(text):# 使用nltk库进行词性标注和分词tokens = word_tokenize(text)tagged = pos_tag(tokens)# 提取名词和形容词作为关键词keywords = [word for word, pos in tagged if pos.startswith('NN') or pos.startswith('JJ')]return keywordsdef text_to_speech(text, output_file, voice_id=None, rate=None, volume=None):engine = pyttsx3.init()# 设置语音引擎属性if voice_id:voices = engine.getProperty('voices')engine.setProperty('voice', voices[voice_id].id)if rate:engine.setProperty('rate', rate)if volume:engine.setProperty('volume', volume)try:engine.save_to_file(text, output_file)engine.runAndWait()print(f"Converted text to {output_file}")except pyttsx3.Error as e:print(f"Error occurred: {e}")# 示例调用

text = "The quick brown fox jumps over the lazy dog"

output_file = "output.mp3"# 提取关键词

keywords = extract_keywords(text)# 将关键词转换为语音输出

keyword_text = ', '.join(keywords)

text_to_speech(keyword_text, output_file, volume=1.5, rate=150)

在这个示例代码中,我们使用了nltk库进行词性标注和分词,然后提取名词和形容词作为关键词。你可以根据需要使用其他文本分析库或API来提取关键信息。

在示例调用中,我们首先使用extract_keywords函数提取关键词。然后,将关键词转换为逗号分隔的文本,并将其传递给text_to_speech函数进行语音转换。

你还可以结合语音识别库,将语音转换为文本,然后使用pyttsx3将文本转换为语音输出。这样可以实现语音交互系统或语音助手等功能。

六、语音交互系统示例代码

创建一个完整的语音交互系统需要结合语音识别库和语音合成库。在这个示例中,我们将使用

创建一个完整的语音交互系统需要结合语音识别库和语音合成库。在这个示例中,我们将使用SpeechRecognition库进行语音识别,然后使用pyttsx3库进行语音合成。以下是一个简单的示例代码:

import speech_recognition as sr

import pyttsx3def listen():r = sr.Recognizer()with sr.Microphone() as source:print("Listening...")audio = r.listen(source)try:text = r.recognize_google(audio)return textexcept sr.UnknownValueError:print("Sorry, I didn't understand.")except sr.RequestError as e:print(f"Request error: {e}")return ""def speak(text, voice_id=None, rate=None, volume=None):engine = pyttsx3.init()# 设置语音引擎属性if voice_id:voices = engine.getProperty('voices')engine.setProperty('voice', voices[voice_id].id)if rate:engine.setProperty('rate', rate)if volume:engine.setProperty('volume', volume)engine.say(text)engine.runAndWait()# 示例调用

while True:# 监听用户的语音输入user_input = listen()print("User:", user_input)# 判断用户的语音输入并作出回应if "hello" in user_input:speak("Hello, how can I help you?")elif "goodbye" in user_input:speak("Goodbye!")breakelse:speak("Sorry, I didn't understand. Can you please repeat?")

在这个示例代码中,我们使用SpeechRecognition库的Recognizer类进行语音识别。我们使用麦克风作为输入源,并使用Google语音识别API进行语音转文本的识别。

在listen函数中,我们使用recognize_google方法将语音转换为文本,并返回识别的文本结果。

在speak函数中,我们使用pyttsx3库将文本转换为语音输出。

在示例调用中,我们通过循环监听用户的语音输入,并根据用户的输入作出相应的回应。如果用户说"hello",则回应"Hello, how can I help you?";如果用户说"goodbye",则回应"Goodbye!“并退出循环;否则,回应"Sorry, I didn’t understand. Can you please repeat?”。

你可以根据需要扩展和定制这个系统,添加更多的语音命令和回应。

七、多语言支持示例代码

pyttsx3库支持多种语言和语音引擎,可以根据需要进行切换。以下是一个示例代码,演示了如何使用不同的语言和语音引擎进行语音输出:

import pyttsx3def speak(text, language='en', voice_id=None, rate=None, volume=None):engine = pyttsx3.init()# 设置语音引擎属性if voice_id:voices = engine.getProperty('voices')engine.setProperty('voice', voices[voice_id].id)if rate:engine.setProperty('rate', rate)if volume:engine.setProperty('volume', volume)# 设置语言engine.setProperty('language', language)engine.say(text)engine.runAndWait()# 示例调用

speak("Hello, how are you?", language='en', voice_id=0)

speak("你好,你好吗?", language='zh', voice_id=0)

在这个示例代码中,我们定义了speak函数,用于将文本转换为语音输出。

在speak函数中,我们使用pyttsx3库的init方法初始化语音引擎。

我们可以通过setProperty方法设置语音引擎的属性,包括语音、速率和音量。voice_id参数用于选择特定的语音,可以使用engine.getProperty('voices')获取可用的语音列表。

我们可以使用setProperty方法设置语言,使用ISO 639-1代码表示。例如,'en’表示英语,'zh’表示中文。

在示例调用中,我们分别使用英语和中文进行语音输出。language参数用于指定语言,voice_id参数用于指定特定的语音。

你可以根据需要切换语言和语音引擎,以满足具体的需求。

八、添加语音提示和反馈示例代码

确实,你可以使用

确实,你可以使用pyttsx3库为脚本添加语音提示和反馈,以增强用户体验。以下是一个示例代码,演示了如何在长时间运行的任务中使用语音提示来告知进度或完成情况:

import pyttsx3def speak(text, language='en', voice_id=None, rate=None, volume=None):engine = pyttsx3.init()# 设置语音引擎属性if voice_id:voices = engine.getProperty('voices')engine.setProperty('voice', voices[voice_id].id)if rate:engine.setProperty('rate', rate)if volume:engine.setProperty('volume', volume)# 设置语言engine.setProperty('language', language)engine.say(text)engine.runAndWait()# 示例调用

speak("开始处理数据,请稍等...", language='zh', voice_id=0)# 模拟长时间运行的任务

for i in range(10):# 执行任务的代码print(f"正在处理第 {i+1} 个数据...")# 使用语音提示告知进度speak(f"正在处理第 {i+1} 个数据...", language='zh', voice_id=0)# 完成任务后使用语音提示

speak("数据处理完成!", language='zh', voice_id=0)

在这个示例代码中,我们定义了speak函数,用于将文本转换为语音输出。

我们在任务开始前使用语音提示告知用户开始处理数据。

然后,我们使用循环模拟长时间运行的任务,在每次循环中执行任务的代码,并使用语音提示告知当前进度。

最后,当任务完成后,我们使用语音提示告知用户数据处理完成。

通过在适当的位置添加语音提示,用户可以通过听取语音消息来了解任务的进度和状态,提升用户体验。

你可以根据需要在适当的位置使用语音提示,以满足具体的需求。

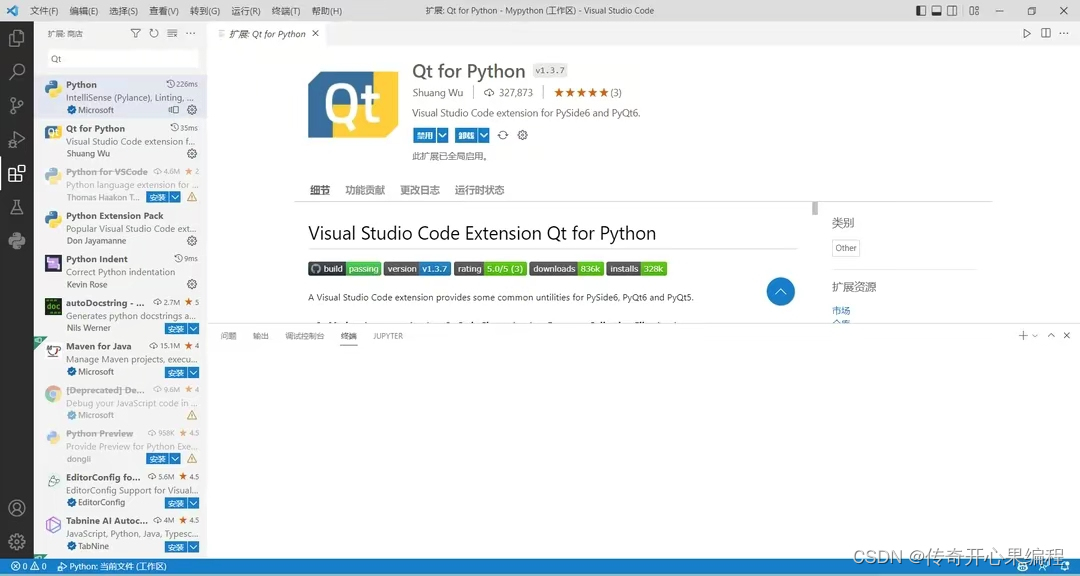

九、结合图形界面示例代码

当结合pyttsx3和图形界面库(如Tkinter)时,你可以创建一个具有语音交互功能的用户界面应用程序。

- 以下是一个示例代码,演示了如何结合

pyttsx3和Tkinter.ttk库创建一个简单的语音交互界面:

import pyttsx3

import tkinter as tk

from tkinter import ttkdef speak(text, language='en', voice_id=None, rate=None, volume=None):engine = pyttsx3.init()# 设置语音引擎属性if voice_id:voices = engine.getProperty('voices')engine.setProperty('voice', voices[voice_id].id)if rate:engine.setProperty('rate', rate)if volume:engine.setProperty('volume', volume)# 设置语言engine.setProperty('language', language)engine.say(text)engine.runAndWait()def on_button_click():user_input = entry.get()speak(f"You entered: {user_input}", language='en', voice_id=0)# 创建Tkinter窗口

window = tk.Tk()

window.title("语音交互界面")# 创建标签和输入框

label = ttk.Label(window, text="请输入文本:")

label.pack()

entry = ttk.Entry(window)

entry.pack()# 创建按钮

button = ttk.Button(window, text="提交", command=on_button_click)

button.pack()# 运行Tkinter事件循环

window.mainloop()

在这个示例代码中,我们创建了一个简单的Tkinter窗口应用程序。

我们定义了speak函数,用于将文本转换为语音输出。

在on_button_click函数中,我们获取用户在输入框中输入的文本,并使用语音提示告知用户输入的内容。

我们创建了一个标签、一个输入框和一个按钮,用于用户输入文本和提交。

当用户点击按钮时,会触发on_button_click函数,将用户输入的文本传递给speak函数进行语音输出。

通过结合pyttsx3和Tkinter库,你可以实现一个具有语音交互功能的用户界面应用程序。用户可以通过界面输入文本,并通过语音输出进行交互。

希望这个示例能帮助你开始开发一个结合图形界面和语音交互的应用程序。你可以根据需要进行进一步的定制和扩展。

当结合

当结合pyttsx3和PySide6时,你可以创建一个具有语音交互功能的用户界面应用程序。

- 以下是一个示例代码,演示了如何结合

pyttsx3和PySide6库创建一个简单的语音交互界面:

import pyttsx3

from PySide6.QtCore import Qt

from PySide6.QtWidgets import QApplication, QMainWindow, QLabel, QLineEdit, QPushButtondef speak(text, language='en', voice_id=None, rate=None, volume=None):engine = pyttsx3.init()# 设置语音引擎属性if voice_id:voices = engine.getProperty('voices')engine.setProperty('voice', voices[voice_id].id)if rate:engine.setProperty('rate', rate)if volume:engine.setProperty('volume', volume)# 设置语言engine.setProperty('language', language)engine.say(text)engine.runAndWait()class MainWindow(QMainWindow):def __init__(self):super().__init__()self.setWindowTitle("语音交互界面")# 创建标签和输入框self.label = QLabel("请输入文本:", self)self.label.setAlignment(Qt.AlignCenter)self.label.setGeometry(50, 50, 200, 30)self.entry = QLineEdit(self)self.entry.setGeometry(50, 100, 200, 30)# 创建按钮self.button = QPushButton("提交", self)self.button.setGeometry(50, 150, 200, 30)self.button.clicked.connect(self.on_button_click)def on_button_click(self):user_input = self.entry.text()speak(f"You entered: {user_input}", language='en', voice_id=0)# 创建PySide6应用程序

app = QApplication([])

window = MainWindow()

window.show()# 运行应用程序事件循环

app.exec()

在这个示例代码中,我们创建了一个简单的PySide6窗口应用程序。

我们定义了speak函数,用于将文本转换为语音输出。

我们创建了一个MainWindow类,继承自QMainWindow,作为主窗口。

在MainWindow类中,我们创建了一个标签、一个输入框和一个按钮,用于用户输入文本和提交。

当用户点击按钮时,会触发on_button_click方法,获取用户输入的文本,并使用语音提示告知用户输入的内容。

通过结合pyttsx3和PySide6库,你可以实现一个具有语音交互功能的用户界面应用程序。用户可以通过界面输入文本,并通过语音输出进行交互。

希望这个示例能帮助你开始开发一个结合PySide6和语音交互的应用程序。你可以根据需要进行进一步的定制和扩展。

十、文本预处理和语音合成示例代码

当使用

当使用pyttsx3进行语音合成之前,你可以进行一些文本预处理操作来提高语音合成的质量和准确性。以下是一个示例代码,演示了如何使用nltk库进行文本预处理,并将预处理后的文本传递给pyttsx3进行语音合成:

import pyttsx3

import nltk

from nltk.tokenize import word_tokenize

from nltk.corpus import stopwords

from string import punctuationdef preprocess_text(text):# 将文本转换为小写text = text.lower()# 分词tokens = word_tokenize(text)# 去除停用词和标点符号stop_words = set(stopwords.words('english'))tokens = [token for token in tokens if token not in stop_words and token not in punctuation]# 重新组合文本processed_text = ' '.join(tokens)return processed_textdef speak(text, language='en', voice_id=None, rate=None, volume=None):engine = pyttsx3.init()# 设置语音引擎属性if voice_id:voices = engine.getProperty('voices')engine.setProperty('voice', voices[voice_id].id)if rate:engine.setProperty('rate', rate)if volume:engine.setProperty('volume', volume)# 设置语言engine.setProperty('language', language)engine.say(text)engine.runAndWait()# 示例文本

text = "Hello, how are you? I'm doing great!"# 文本预处理

processed_text = preprocess_text(text)# 语音合成

speak(processed_text, language='en', voice_id=0)

在这个示例代码中,我们引入了nltk库,它是一个用于自然语言处理的强大工具。

我们定义了preprocess_text函数,用于对文本进行预处理。在这个函数中,我们将文本转换为小写,进行分词,去除停用词和标点符号,并重新组合文本。

在speak函数中,我们使用pyttsx3进行语音合成。

我们首先定义了一个示例文本,然后对其进行预处理。

最后,我们将预处理后的文本传递给pyttsx3的speak函数进行语音合成。

通过进行文本预处理操作,你可以提高语音合成的质量和准确性。你可以根据需要扩展preprocess_text函数,添加其他的文本处理步骤,以适应你的应用场景。

十一、导出语音文件示例代码

pyttsx3支持将语音输出保存为音频文件。以下是一个示例代码,演示了如何使用pyttsx3将语音输出保存为音频文件:

import pyttsx3def speak(text, language='en', voice_id=None, rate=None, volume=None, output_file=None):engine = pyttsx3.init()# 设置语音引擎属性if voice_id:voices = engine.getProperty('voices')engine.setProperty('voice', voices[voice_id].id)if rate:engine.setProperty('rate', rate)if volume:engine.setProperty('volume', volume)# 设置语言engine.setProperty('language', language)if output_file:# 将语音输出保存为音频文件engine.save_to_file(text, output_file)engine.runAndWait()else:# 实时语音输出engine.say(text)engine.runAndWait()# 示例文本

text = "Hello, how are you? I'm doing great!"# 将语音输出保存为音频文件

output_file = "output.wav"

speak(text, language='en', voice_id=0, output_file=output_file)print(f"语音输出已保存为文件: {output_file}")

在这个示例代码中,我们对speak函数进行了修改,添加了一个output_file参数用于指定输出文件的路径。

如果提供了output_file参数,则将语音输出保存为音频文件;否则,进行实时语音输出。

在示例中,我们将语音输出保存为名为output.wav的音频文件。

通过使用output_file参数,你可以方便地将语音输出保存为音频文件,以便后续使用或分享。

十二、语音识别和语音合成的结合示例代码

当你的脚本需要进行语音输入和输出时,你可以结合使用语音识别库(如SpeechRecognition)和

当你的脚本需要进行语音输入和输出时,你可以结合使用语音识别库(如SpeechRecognition)和pyttsx3,实现完整的语音交互过程。以下是一个示例代码,演示了如何结合使用这两个库:

import speech_recognition as sr

import pyttsx3def speech_to_text():r = sr.Recognizer()with sr.Microphone() as source:print("请说话...")audio = r.listen(source)try:text = r.recognize_google(audio, language='en')return textexcept sr.UnknownValueError:print("抱歉,无法识别语音")except sr.RequestError as e:print(f"请求错误:{e}")def text_to_speech(text, language='en', voice_id=None):engine = pyttsx3.init()# 设置语音引擎属性if voice_id:voices = engine.getProperty('voices')engine.setProperty('voice', voices[voice_id].id)# 设置语言engine.setProperty('language', language)engine.say(text)engine.runAndWait()# 语音输入

input_text = speech_to_text()

print(f"识别结果: {input_text}")# 语音输出

text_to_speech(input_text, language='en', voice_id=0)

在这个示例代码中,我们使用了speech_recognition库进行语音识别,以及pyttsx3库进行语音合成。

首先,我们定义了speech_to_text函数,用于将语音输入转换为文本。在这个函数中,我们使用麦克风作为音频源,使用recognize_google方法将音频转换为文本。

然后,我们定义了text_to_speech函数,用于将文本转换为语音输出。在这个函数中,我们使用pyttsx3进行语音合成。

在主程序中,我们首先调用speech_to_text函数进行语音输入,并将结果存储在input_text变量中。

然后,我们调用text_to_speech函数将input_text转换为语音输出。

通过结合使用语音识别库和pyttsx3,你可以实现完整的语音交互过程。你可以根据需要进行定制和扩展,例如添加错误处理、调整语音设置、结合其他库和API等。

十三、归纳总结

当使用

当使用pyttsx3库创建自动化脚本时,以下是一些关键的知识点归纳:

-

初始化语音引擎:使用

pyttsx3.init()方法初始化语音引擎,返回一个Engine对象。 -

设置语音引擎属性:使用

engine.setProperty()方法可以设置语音引擎的属性,例如语言、声音、语速和音量等。 -

获取可用的声音列表:使用

engine.getProperty('voices')方法可以获取可用的声音列表。每个声音都有一个唯一的标识符,可以通过voice.id访问。 -

实时语音输出:使用

engine.say(text)方法将文本转换为语音输出。然后使用engine.runAndWait()方法等待语音输出完成。 -

将语音输出保存为音频文件:使用

engine.save_to_file(text, output_file)方法可以将语音输出保存为音频文件。需要提供要保存的文本和输出文件的路径。 -

错误处理:在使用

pyttsx3时,可能会出现错误,例如无法找到声音或无法连接到语音引擎。可以使用try-except语句来捕获和处理这些错误。 -

多语言支持:可以使用

engine.setProperty('language', language)方法设置语音引擎的语言。可以通过指定语言的标识符(如’en’表示英语)来设置语言。 -

自定义语音设置:可以使用

engine.setProperty()方法设置其他语音属性,如声音、语速和音量等。可以根据需要进行调整和定制。 -

结合其他库和API:可以将

pyttsx3与其他库和API结合使用,以实现更复杂的语音功能。例如,结合语音识别库实现语音输入转换为文本,或结合文本处理库进行批量处理文本并生成语音输出。

这些知识点可以帮助你开始使用

这些知识点可以帮助你开始使用pyttsx3创建自动化脚本和语音交互系统。你可以根据需要进行定制和扩展,以满足特定的需求。