多重共线性的概念

在回归分析中,我们通常关注的是如何利用一个或多个自变量(解释变量)来预测一个因变量(响应变量)。当我们使用多元线性回归模型时,理想的情况是模型中的每一个自变量都能提供独特的、对因变量有用的信息。然而,如果两个或两个以上的自变量之间存在强烈的线性关系,就会出现多重共线性的问题。

识别多重共线性

识别多重共线性通常可以通过以下几种方法:

- 方差膨胀因子(VIF): VIF测量了一个自变量与其他自变量线性关系强度的指标。VIF值大于10通常被认为表明强烈的多重共线性。

- 相关系数矩阵: 查看自变量之间的相关系数可以帮助识别它们之间是否存在强烈的线性关系。

- 条件指数: 条件指数是另一种识别多重共线性的方法,条件指数值超过30通常被认为是多重共线性的迹象。

多重共线性的影响

多重共线性会对回归分析产生以下几方面的影响:

- 参数估计的不稳定性: 当模型中存在多重共线性时,小的数据变化可能会导致参数估计的显著变动。

- 模型解释的困难: 由于自变量之间的高度相关性,很难区分每个自变量对因变量的独立影响。

- 预测能力的降低: 多重共线性可能会降低模型对新数据的预测能力。

处理多重共线性的方法

尽管多重共线性是一个棘手的问题,但有几种方法可以用来减轻或解决这一问题:

- 删除自变量: 如果某些自变量之间存在强烈的相关性,可以考虑删除其中一个或多个。

- 岭回归(Ridge Regression): 岭回归通过引入一个小的偏差来减少参数估计的方差,从而降低多重共线性的影响。

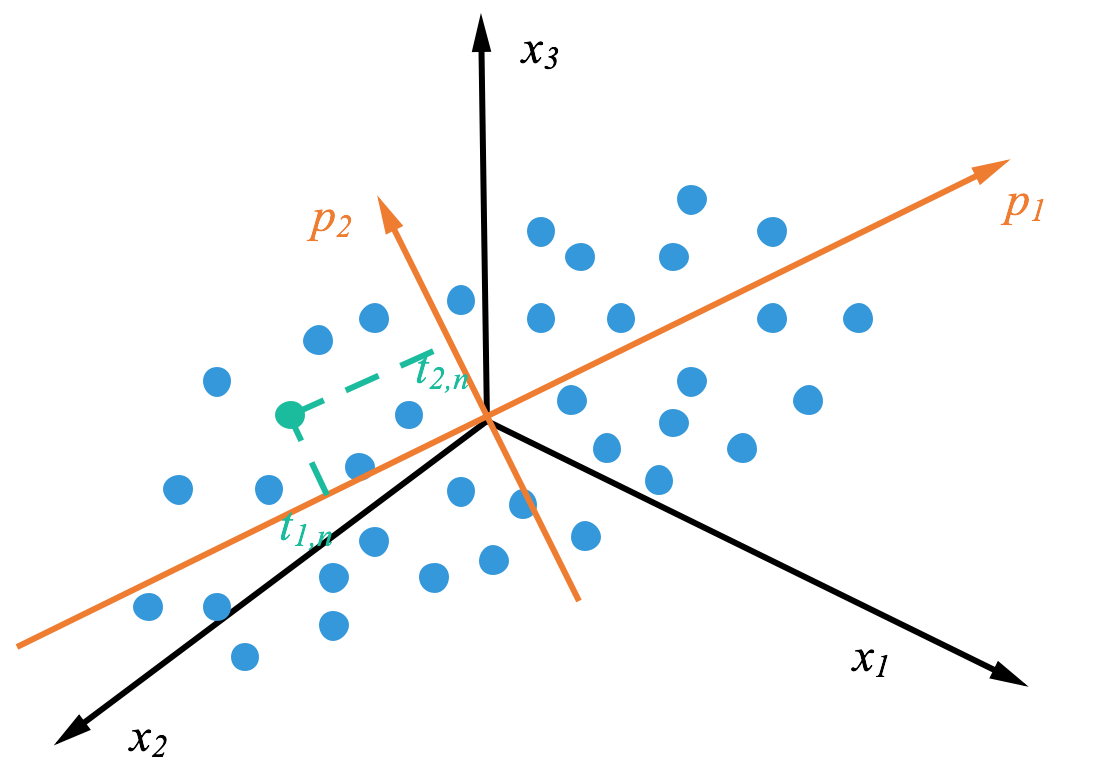

- 主成分分析(PCA): PCA可以用来转换自变量,生成一组彼此独立的新变量,然后在这些新变量上进行回归分析。

代码示例

处理多重共线性问题的常用方法包括使用方差膨胀因子(VIF)进行诊断,以及应用岭回归(Ridge Regression)和主成分分析(PCA)作为解决策略。下面提供了一些Python代码示例,这些示例使用了著名的statsmodels和sklearn库来演示这些技术的应用。

方差膨胀因子(VIF)的计算

首先,我们可以使用statsmodels库来计算VIF,以诊断多重共线性问题。

import pandas as pd

from statsmodels.stats.outliers_influence import variance_inflation_factor

from statsmodels.tools.tools import add_constant# 假设df是一个Pandas DataFrame,包含了你的数据

# df = pd.read_csv("your_data.csv") # 举例载入数据# 给数据添加常数项,用于计算VIF

X = add_constant(df)# 计算每个自变量的VIF并输出

VIFs = pd.Series([variance_inflation_factor(X.values, i) for i in range(X.shape[1])], index=X.columns)

print(VIFs)

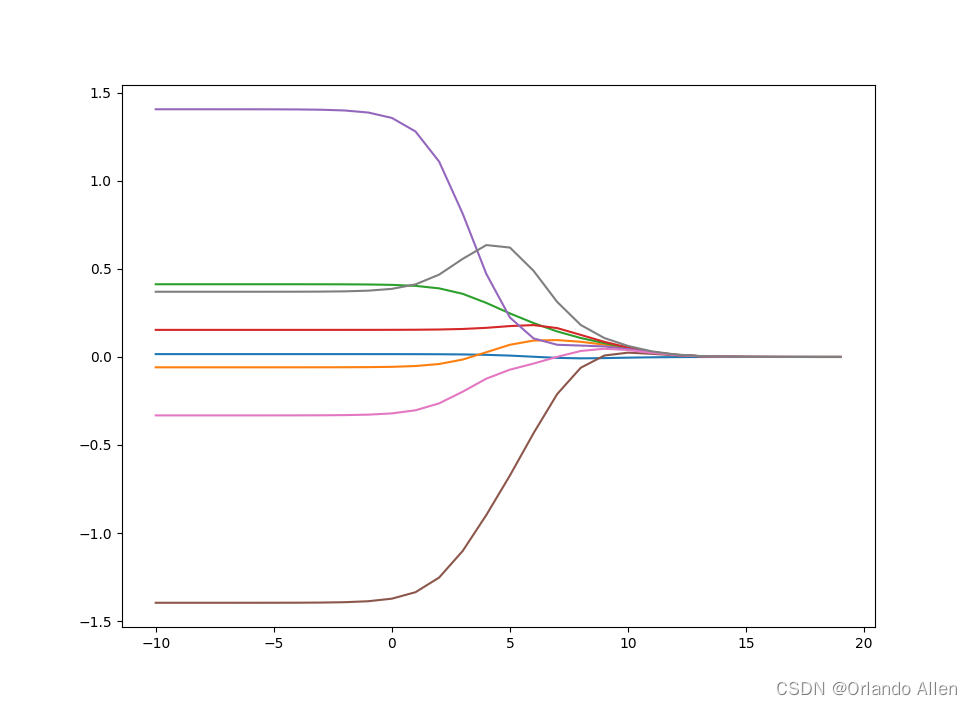

岭回归(Ridge Regression)

岭回归是处理多重共线性的一种常用方法。以下是使用sklearn库进行岭回归的示例。

from sklearn.model_selection import train_test_split

from sklearn.linear_model import Ridge

from sklearn.preprocessing import StandardScaler# 假设X和y是你的特征和目标变量

# X = df.drop('target_column', axis=1)

# y = df['target_column']# 数据标准化

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)# 划分数据集

X_train, X_test, y_train, y_test = train_test_split(X_scaled, y, test_size=0.2, random_state=42)# 应用岭回归

ridge_model = Ridge(alpha=1.0) # alpha是正则化强度

ridge_model.fit(X_train, y_train)# 模型评估

score = ridge_model.score(X_test, y_test)

print(f"Ridge Regression Score: {score}")

主成分分析(PCA)

当多重共线性问题无法通过移除变量或是其他简单方法解决时,主成分分析(PCA)可以作为一种有效的手段。

from sklearn.decomposition import PCA

from sklearn.linear_model import LinearRegression

from sklearn.pipeline import make_pipeline# 数据标准化并应用PCA

pca = PCA(n_components='mle') # 'mle'可以自动选择组件数

linear_model = LinearRegression()

model = make_pipeline(StandardScaler(), pca, linear_model)# 使用PCA转换后的数据进行回归

model.fit(X_train, y_train)# 模型评估

score = model.score(X_test, y_test)

print(f"PCA with Linear Regression Score: {score}")

结论

多重共线性是多元线性回归分析中常见的问题,但通过合理的方法可以有效地识别和处理。理解多重共线性的本质及其影响,选择合适的策略来减轻或避免这一问题,对于构建准确可靠的预测模型至关重要。通过综合应用VIF、相关系数矩阵、条件指数等工具,以及采取删除自变量、岭回归、主成分分析等技术手段,可以有效地解决多重共线性问题,提高模型的稳定性和预测能力。

No.114 - No.121)

)

)

原理及应用场景)

)