Cross-Entropy Loss

- 1.二分类

- 2. 对于多类别分类问题,其公式可以表示为:

- 3. 公式深度挖掘解释——交叉熵损失函数公式中(log)的解释

- 总结

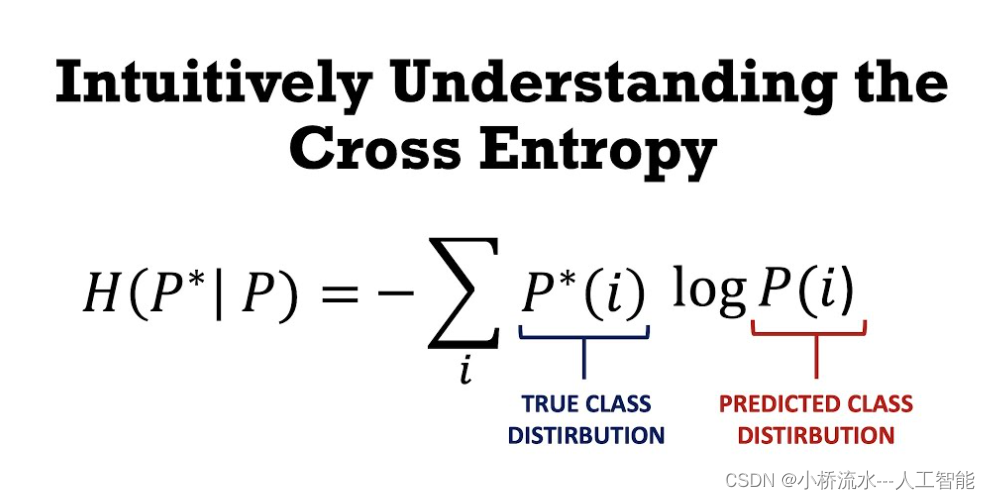

交叉熵损失函数(Cross-Entropy Loss)是在机器学习和深度学习中常用的一种损失函数,主要用于衡量模型输出与真实标签之间的差异,特别适用于分类任务,尤其是多类别分类问题。

1.二分类

交叉熵损失函数的数学公式可以有多种表示形式。对于二分类问题,其公式可以表示为:

L = - [ y * log§ + (1 - y) * log(1 - p) ]

其中,y 表示真实标签,取值为 0 或 1;p 表示模型预测为正类的概率。当 y = 1 时,损失函数只关注 log§,即模型预测为正类的概率;当 y = 0 时,损失函数只关注 log(1 - p),即模型预测为负类的概率。

2. 对于多类别分类问题,其公式可以表示为:

L = - Σ (y_i * log(p_i))

其中,y_i 表示真实标签中第 i 类的取值,取值为 0 或 1;p_i 表示模型预测第 i 类的概率。Σ 表示对所有类别进行求和。

在这些公式中,log 表示自然对数,p 和 q 分别表示实际分布概率和模型预测分布概率,n 表示样本数量。交叉熵损失函数的值越小,表示模型预测与真实标签之间的差异越小,即模型的性能越好。

3. 公式深度挖掘解释——交叉熵损失函数公式中(log)的解释

- 概率解释:在机器学习和深度学习中,模型的输出通常被解释为

概率分布。对数函数可以将概率值映射到实数域,使得我们可以使用实数域上的数学工具来处理概率问题。 - 数学性质:对数函数具有一些有用的数学性质,例如

单调性和可导性。这使得我们可以方便地优化交叉熵损失函数,例如使用梯度下降等优化算法。 - 处理极端预测值:当模型预测的概率值

接近0或1时,对数函数可以防止损失函数变得过大,从而提高模型的鲁棒性。

没有对数函数(log)的交叉熵损失函数在某些情况下也是可行的,但这会导致损失函数的性质发生变化。例如,去掉对数函数后,损失函数将不再是概率分布的函数,而是概率本身的函数。这可能会导致一些数学上的不便,例如在优化过程中可能会出现一些问题。

总结

对于二分类问题,模型的输出通常是一个标量,表示样本属于正类的概率。因此,在二分类的交叉熵损失函数中,我们只需要考虑一个概率值,即模型预测为正类的概率。具体来说,当真实标签为1时,我们关注模型预测为正类的概率;当真实标签为0时,我们关注模型预测为负类的概率。因此,二分类的交叉熵损失函数可以表示为:

L = - [ y * log§ + (1 - y) * log(1 - p) ]

其中,y 表示真实标签,取值为 0 或 1;p 表示模型预测为正类的概率。

而对于多分类问题,模型的输出通常是一个向量,表示样本属于各个类别的概率。因此,在多分类的交叉熵损失函数中,我们需要考虑所有类别的概率。具体来说,对于每个样本,我们计算其真实标签对应的概率的负对数,然后将所有类别的损失求和。因此,多分类的交叉熵损失函数可以表示为:

L = - Σ (y_i * log(p_i))

其中,y_i 表示真实标签中第 i 类的取值,取值为 0 或 1;p_i 表示模型预测第 i 类的概率。Σ 表示对所有类别进行求和。

)

![第三节课[LangChain]作业](http://pic.xiahunao.cn/第三节课[LangChain]作业)