1,Docker复杂安装说明

今天的优势会被明天趋势所取代

一切在云端

安装mysql主从复制

主从复制原理,默认你懂

主从搭建步骤

1,新建主从服务器容器实例3307

docker run -p 3307:3306 --name mysql-master\

-v /mydata/mysql-master/log:/var/log/mysql\

-v /mydata/mysql-master/data:/var/lib/mysql\

-v /mydata/mysql-master/conf:/etc/mysql\

-e MYSQL_roOT_PASSWORD=root\

-d mysql:5.7

2,进入/mydata/mysql-master/conf目录下新建my.cnf

[mysql]

##设置server_id,同一局域网中需要唯一

server_id=101

##指定不需要同步的数据库名称

binlog-ignore- db=mysql

##开启二进制日志功能

log- bin=mall-mysql-bin

##设置二进制日志使用内存大小(事务)

binlog_cache_size=1M

##设置使用的二进制日志格式(mixed,statement,row)

binlog_format=mixed

##二进制日志过期清理时间。默认值为0,表示不自动清理。

expire_logs_days=7

##跳过主从复制中遇到的所有错误或指定类型的错误,避免slave端复制中断。

##如:1062错误是指一些主键重复,1032错误是因为主从数据库不一致。

slave_skip_errors=1062

3,修改完配置后重启master'实例

docker restart mysql-master

4,进入mysql-master容器

docker exec -it mysql-master /bin/bash

mysql -uroot -proot

5,master容器实例内创建数据同步用户

CREATE USER 'slave'@'%'IDENTIFIED BY '123456';

GRANT REPLICATION SLAVE,REPLICATION CLIENT ON *.* TO 'slave'@'%';

6,新建从服务器容器实例3308

docker run -p 3308:3306 --name mysql-slave\

-v /mydata/mysql-slave/log:/var/log/mysql\

-v /mydata/mysql-slave/data:/var/lib/mysql\

-v /mydata/mysql-slave/conf:/etc/mysql\

-e MYSQL_ROOT_PASSWORD=root

-d mysql:5.7

7,进入/mydata/mysql-slave/conf目录下新建my.cnf

vim my.cnf

[mysqld]

##设置server_id,同一局域网中需要唯一

server_id=102

##指定不需要的数据库名称

binlog-ignore-db=mysql

##开启二进制日志功能,以备Slave作为其他数据库实例的Master是使用

log-bin=mall-mysql-slave1-bin

##设置二进制日志使用内存大小(事务)

binlog_format=mixed

##二进制日志过期清理时间。默认值为0,表示不自动清理。

expire_logs_days=7

##跳过主从复制中遇到的所有错误或指定类型的错误,避免slave端复制中断。

##如:1062错误是指一些主键重复,1032错误是因为主从数据库数据不一致。

slave_skip_errors=1062

##realy_log配置中继日志

realy_log=mall-mysql-relay-bin

##log_slave_updates表示slave将复制事件写进自己的二进制日志。

log_slave_updates=1

##slave设置为只读(具有super权限的用户除外)

read_only=1

my.cnf

8,修改完配置后重启slave实例

docker restart mysql-slave

9,在主数据库中查看主从同步状态

show master status;

10,进入mysql-slave容器

docker exec -it mysql-slave /bin/bash

mysql -uroot -proot

11,在从数据库中配置主从复制

change master to master_host='宿主机ip' ,master_user='slave' , master_password='123456' , master_port=3307,

master_log_file='mall-mysql-bin.000001' , master_log_pos=617,master_connect_retry=30;

例子:

mysql > change master to master_host='192.168.111.163', master_user=' slave' , master_password='123456' , master_port=3307,

master_log_file=' mall-mysql-bin.000001', master log pos=617, master connect retry=30;

master_host:主从数据库的IP地址;

master_port主数据库的运行端口;

master_user:在主数据库创建的用于同步数据的用户账号;

master_password:在主数据库创建的用于同步数据的用户密码;

master_log_file:指定从数据库要复制数据的日志文件,通过查看主数据的状态,获取File参数;

master_log_pos:指定从数据库从哪个位置开始复制数据,通过查看主数据的状态,获取Position参数;

master_connect_retry:连接失败重试的时间间隔,单位为秒。

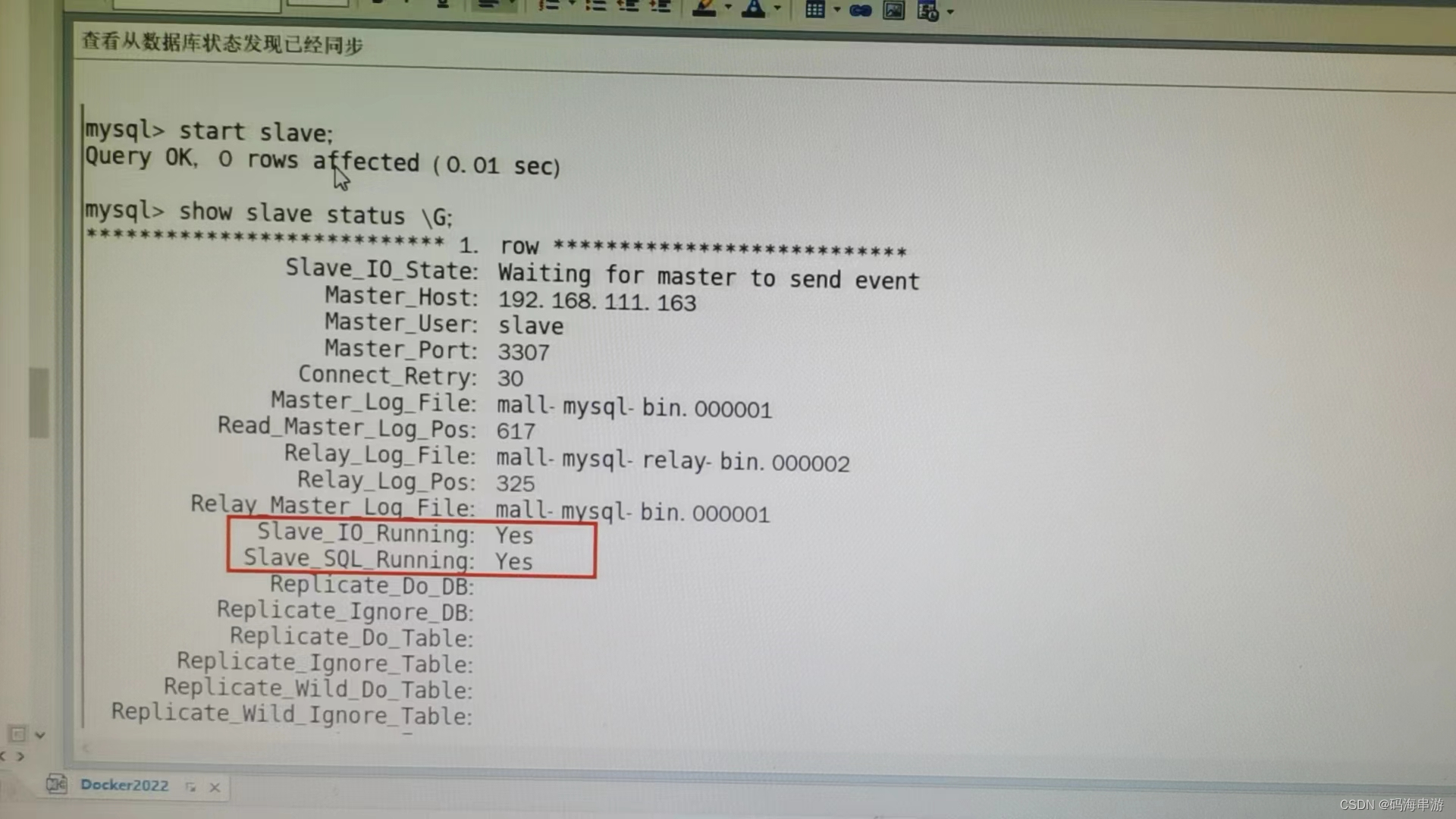

12,在从数据库中查看主从同步状态

show slave status \G;

13,在从数据库中开启主从同步

mysql>start slave;

Query OK, 0 rows affected (0.01 sec)

14,查看从数据库状态发现已经同步

15,主从复制测试

主机新建库-使用库-新建表-插入数据,ok

从机使用库-查看记录,ok

安装redis集群(大厂面试题第四季-分布式存储案例真题)

书到用时方恨少,钱到月底不够花。卷起来一个比一个狠

cluster(集群)模式-docker版哈希槽分区进行亿级数据存储

面试题:

1~2一亿条数据需要缓存,请问如何设计这个存储案例

回答

单机单台100%不可能,肯定是分布式存储,用redis如何落地?

上述问题阿里p6~p7工程案例和场景设计类必考题目,一般业界有3种解决方案。

1,哈希取余分区

2亿条记录就是2亿个k,v。我们单机不行必须要分布式多机,假设有三台机器构成一个集群,用户每次读写操作都是根据公式:

hash(key)%N个机器台数,计算出哈希值,用来决定数据映射到哪一个节点上。

优点:

简单粗暴,直接有效,只需要预估好数据规划好节点,例如3台。8台。10台,就能保证一段时间的数据支撑。使用Hash算法让固定的一部分请求落到同一台服务器上,这样每台服务器固定处理一部分请求(并维护这些请求的信息),起到负载均衡+分而治之的作用。

缺点:

原来规划好的节点,进行扩容或者缩容比较麻烦了,不管扩缩,每次数据变动导致节点有变动,映射关系需要重新进行计算,在服务器个数固定不变时没有问题,如果需要弹性扩容或故障停机的情况下,原来的取模公式就会发生变化:Hash(key)/3 会变成Hash(key)/?.此时地址经过取余运算的结果将发生很大的变化,根据公式获取的服务也会变得不可控。

某个redis机器宕机了,由于台数数量变化,会导致hash取余全部数据重新洗牌。

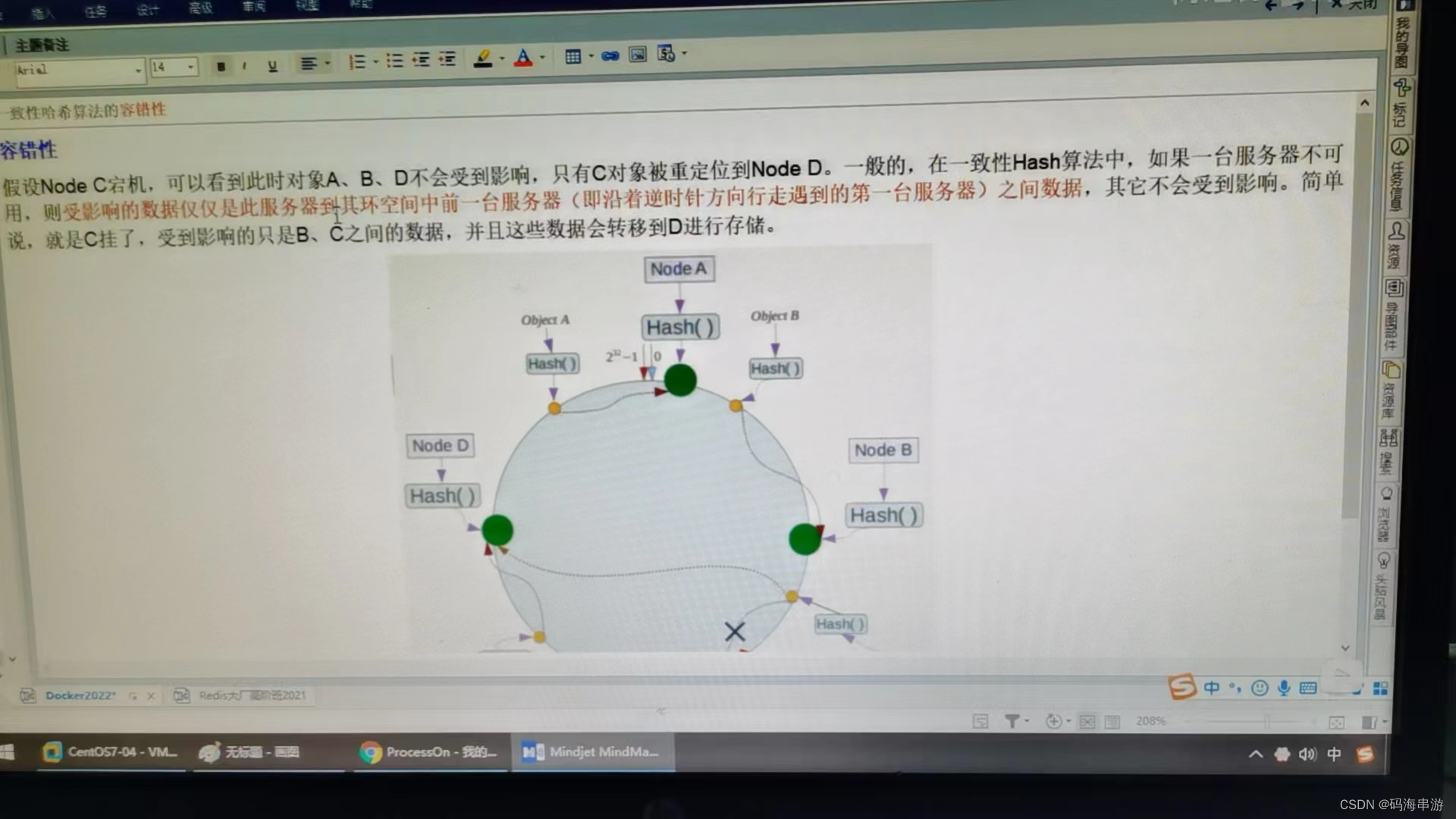

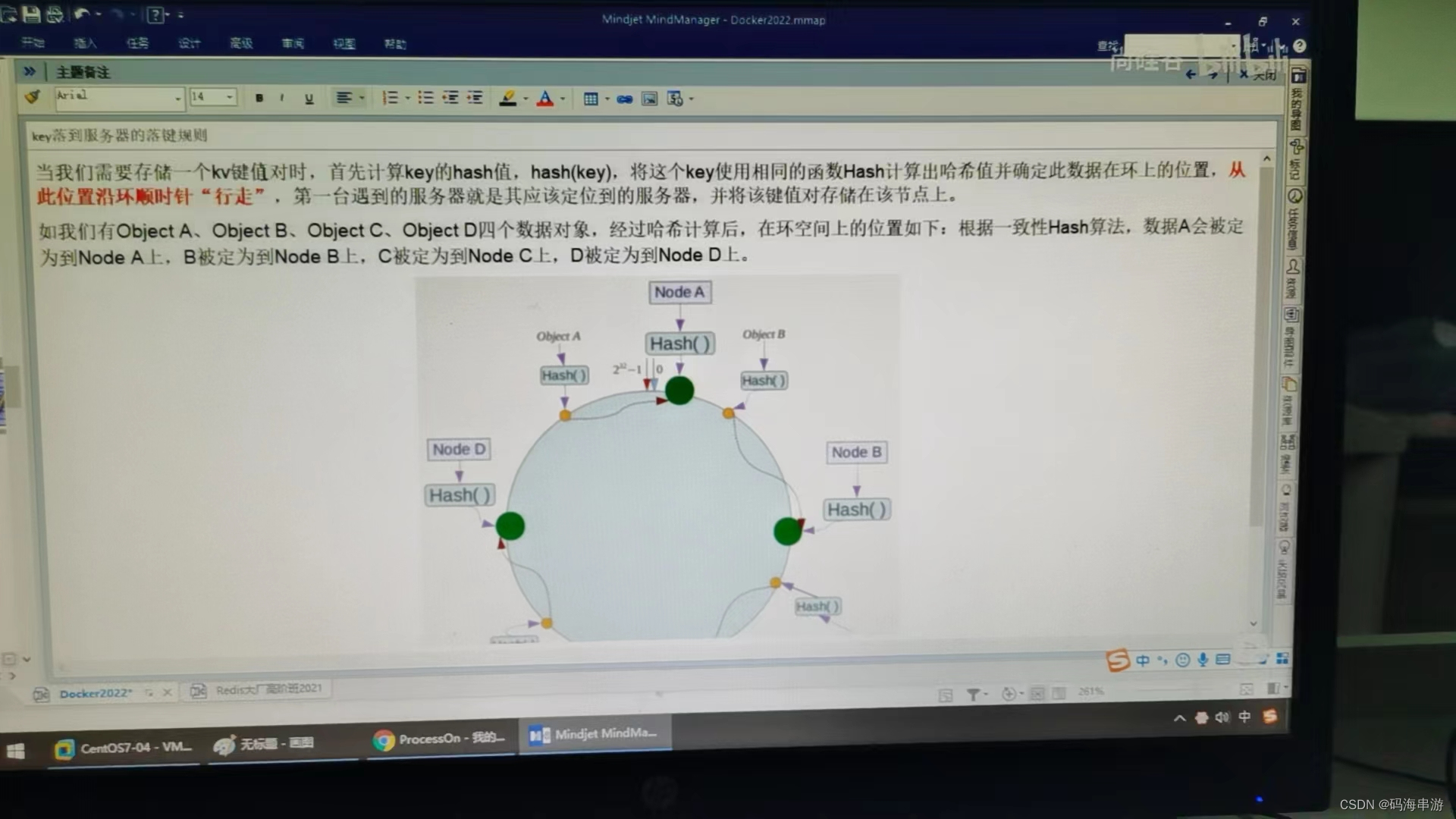

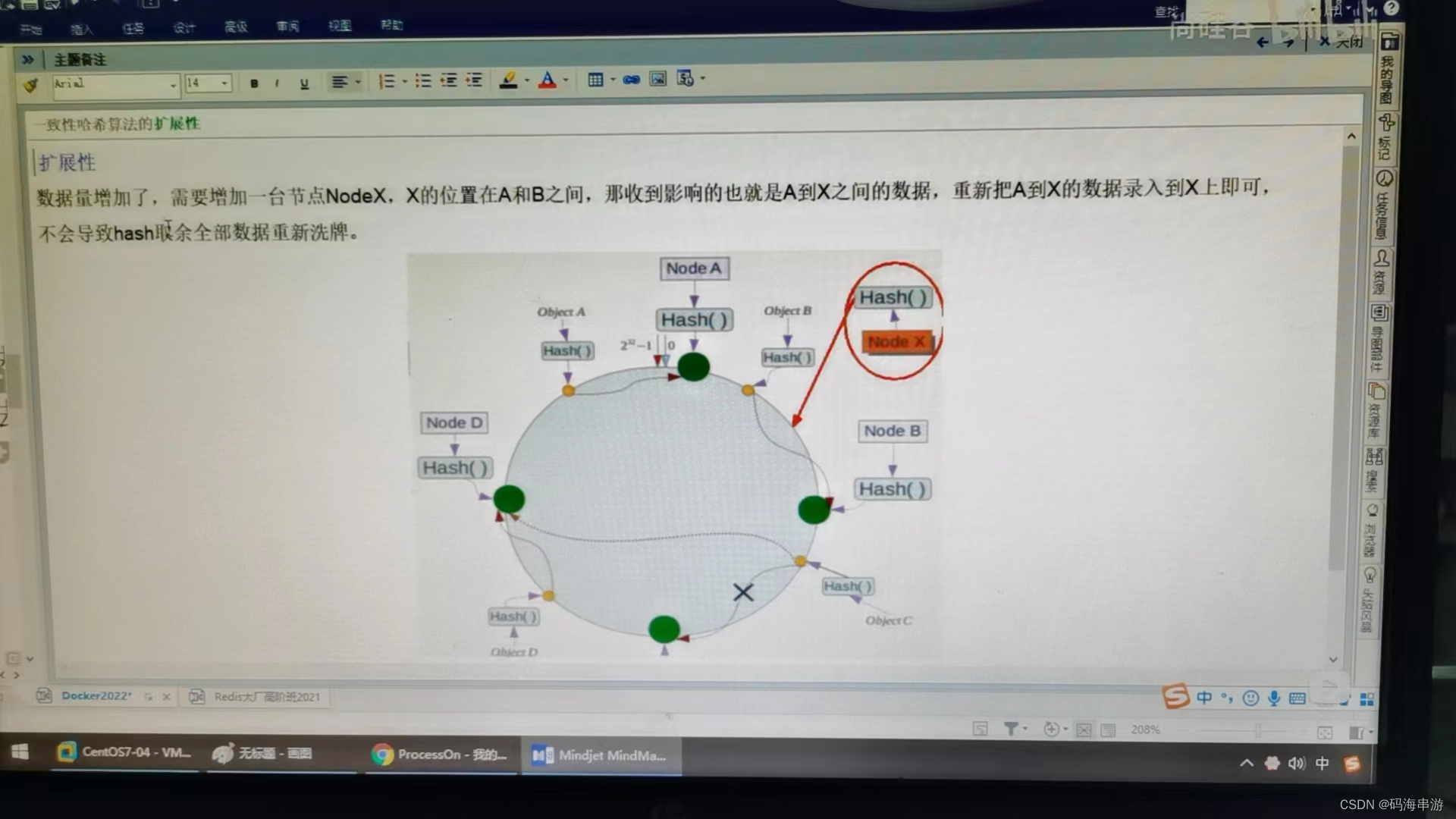

2,一致性哈希算法分区

一致性哈希算法在1997年由麻省理工学院中提出的,设计目标是为了解决分布式缓存数据变动和映射问题,某个机器单机了,分母数量改变了。自然取余数不OK了。

一致性哈希环

一致性哈希算法必然有个hash函数并按照算法产生hash值,这个算法的所有可能哈希值会构成一个全量集,这个集合可以成为一个hash空间[0,2^32-1],这个是一个线性空间,但是在算法中,我们通过适当的逻辑控制将它首尾相连(0 =2^32),这样让他逻辑上形成了一个环形空间。

它也是按照使用取模的方法,前面介绍的节点取模法是对节点(服务器)的数量进行取模。而一致性Hash算法是对2^32取模,简单来说,一致性Hash算法将整个哈希值空间组织成一个虚拟的圆环,如假设某哈希函数H的值空间为0-2^32-1(即哈希值是一个32位无符号整形),整个哈希环如下图:整个空间按顺时针方向组织,圆环的正上方的点代表0,0点右侧的第一个点代表1,以此类推,2,3,4------直到2^32-1,也就是说0点左侧的第一个点代表2^32-1,0和2^32-1在零点中方向重合,我们把这个由2^32个点组成的圆环成为Hash环。

节点映射:将集群中的各个IP节点映射到环上的某一个位置。

将各个服务器使用Hash进行一个哈希,具体可以选择服务器的IP或主机名作为关键字进行哈希,这样每台机器就能确定其在哈希换上的位置。假如4个节点NodeA,B,C,D,经过IP地址的哈希函数计算(hash(ip)),使用IP地址哈希后在环空间的位置如下:

优点:

缺点:

小总结

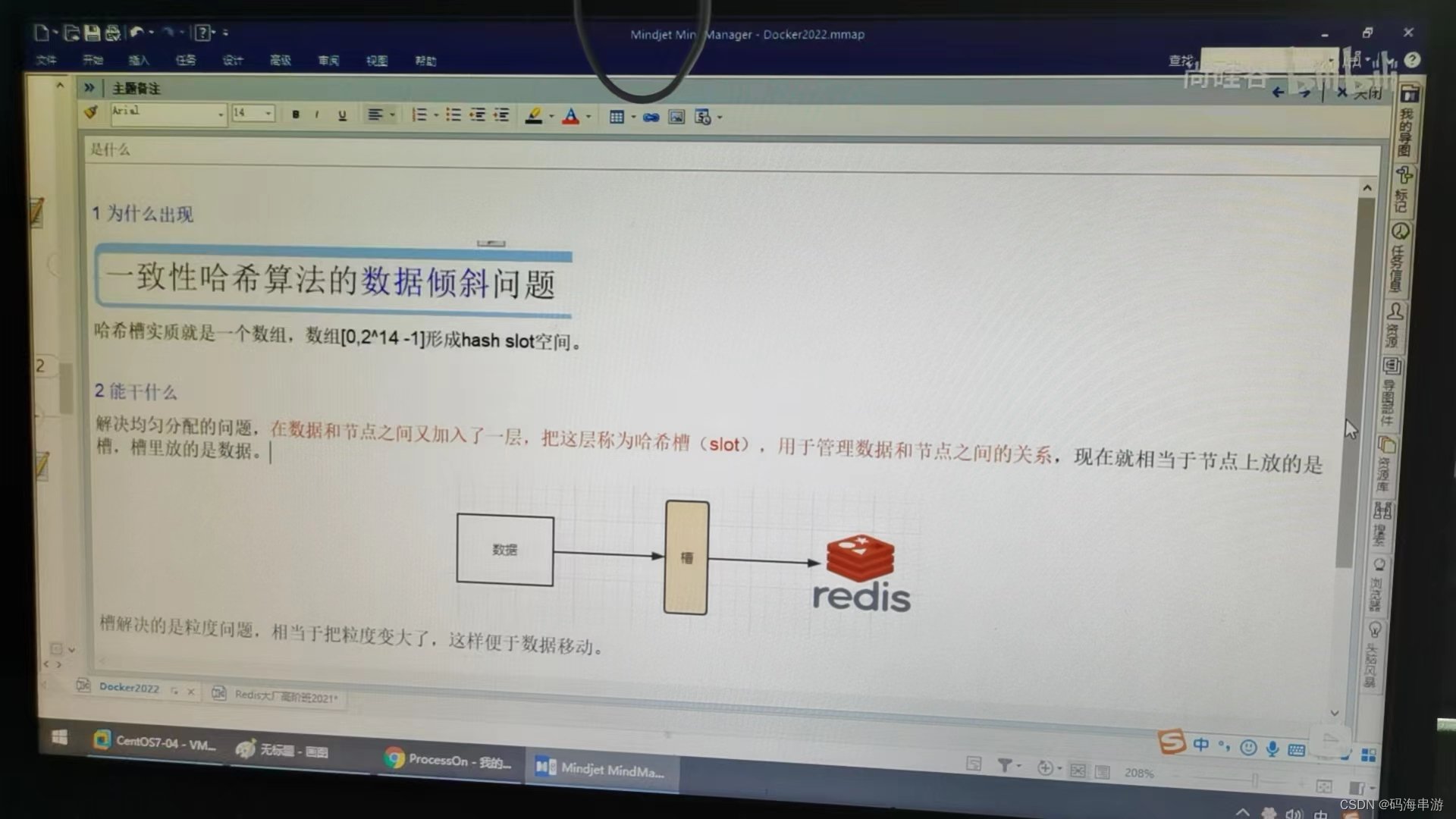

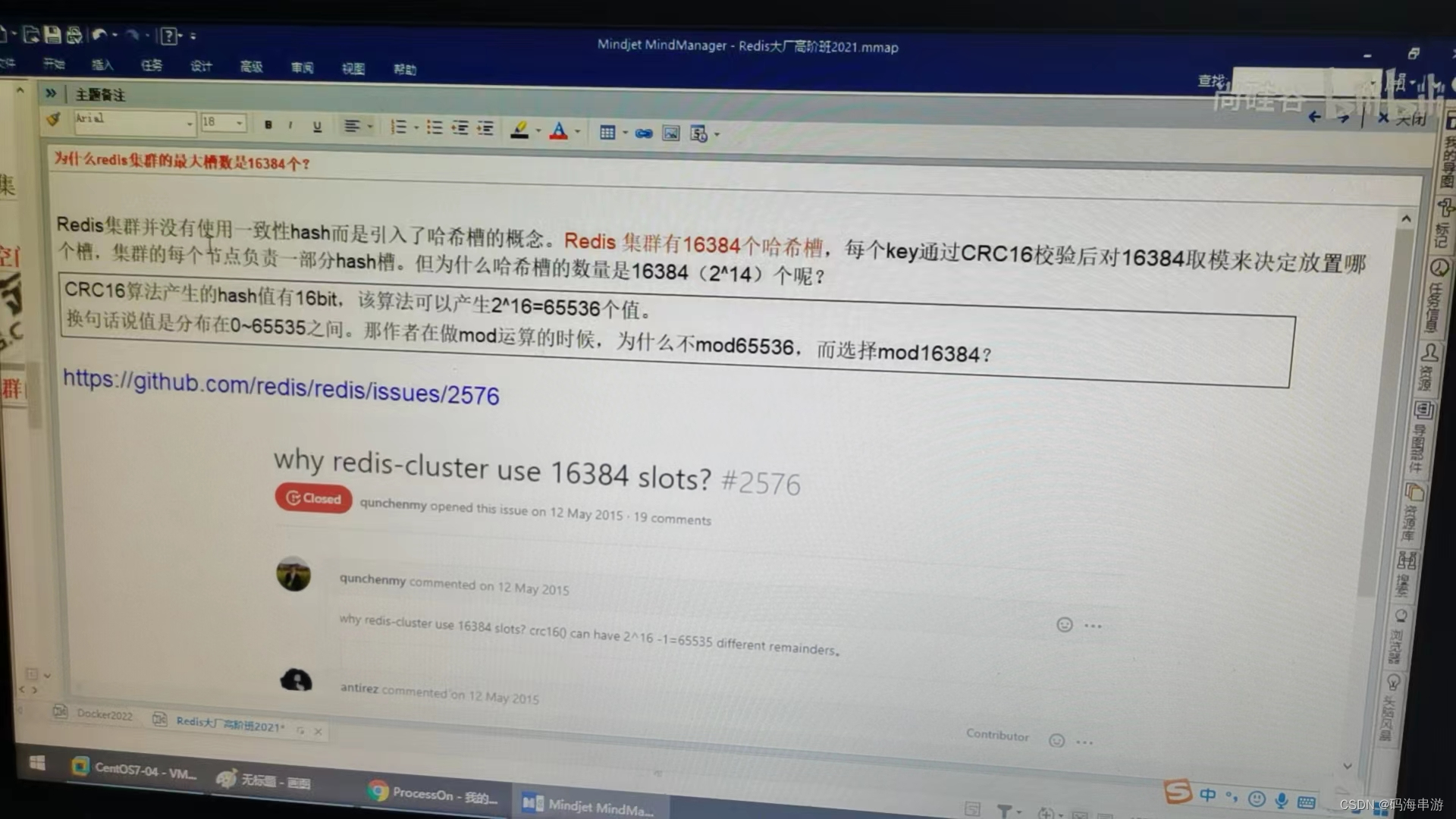

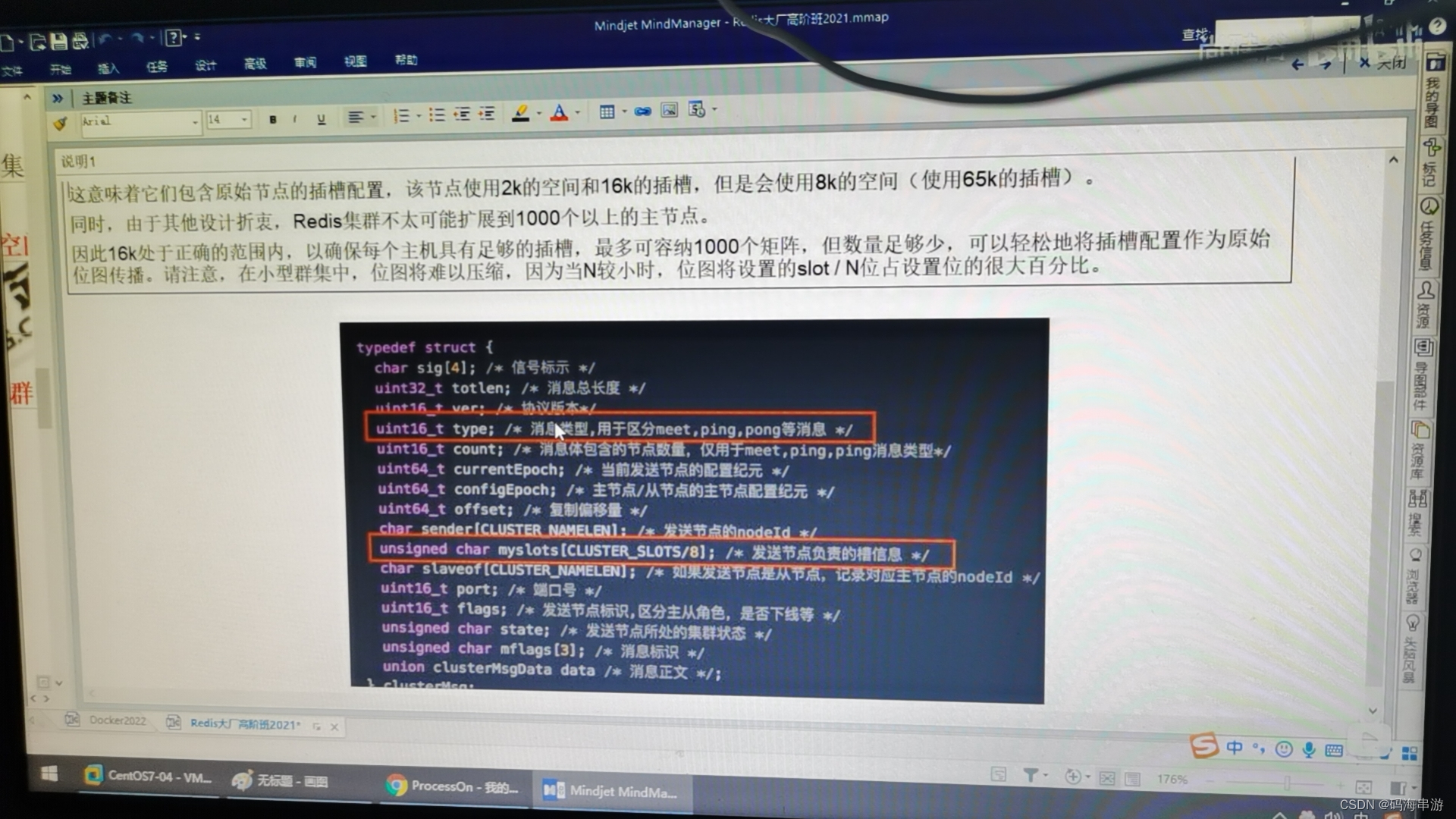

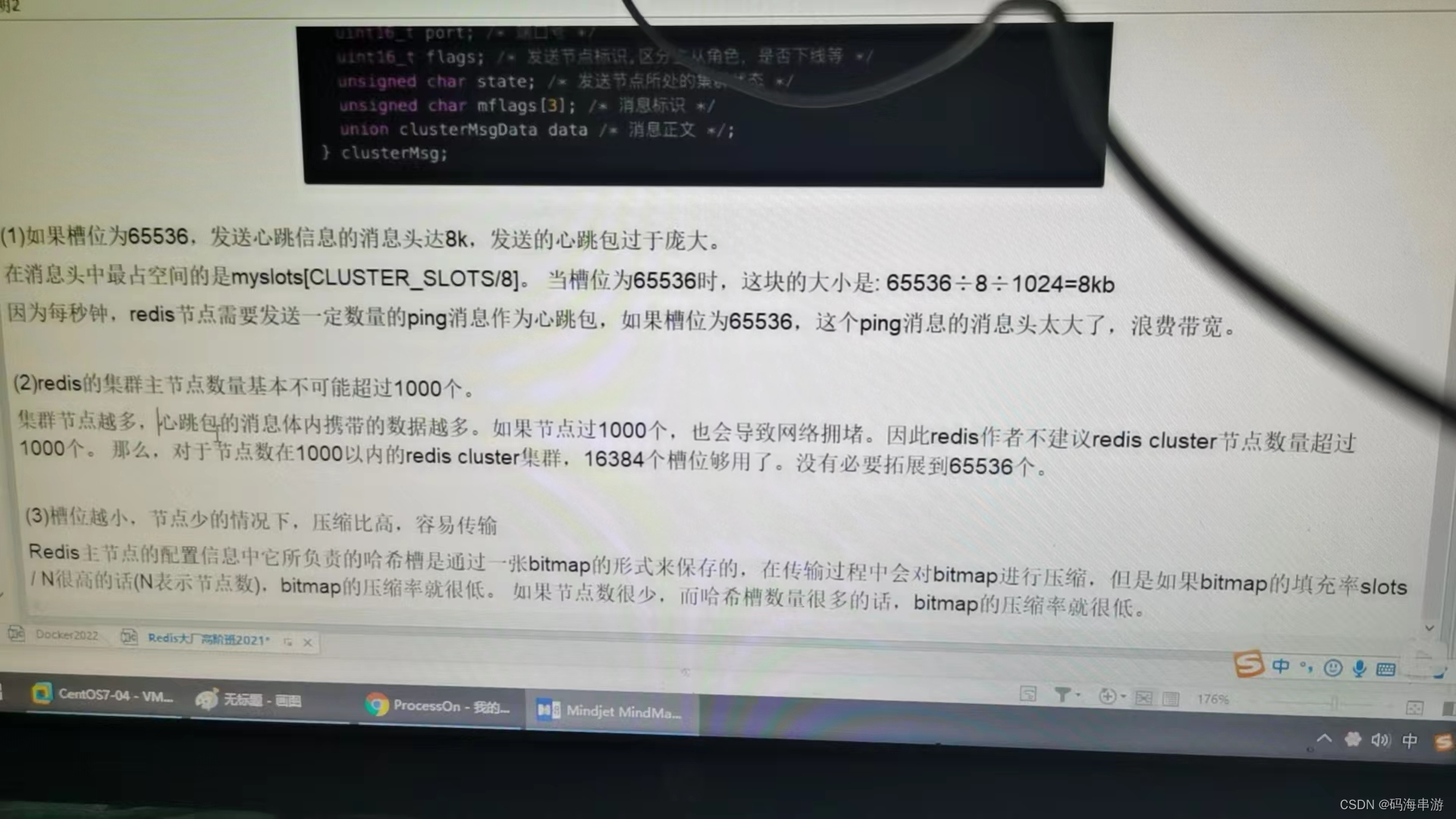

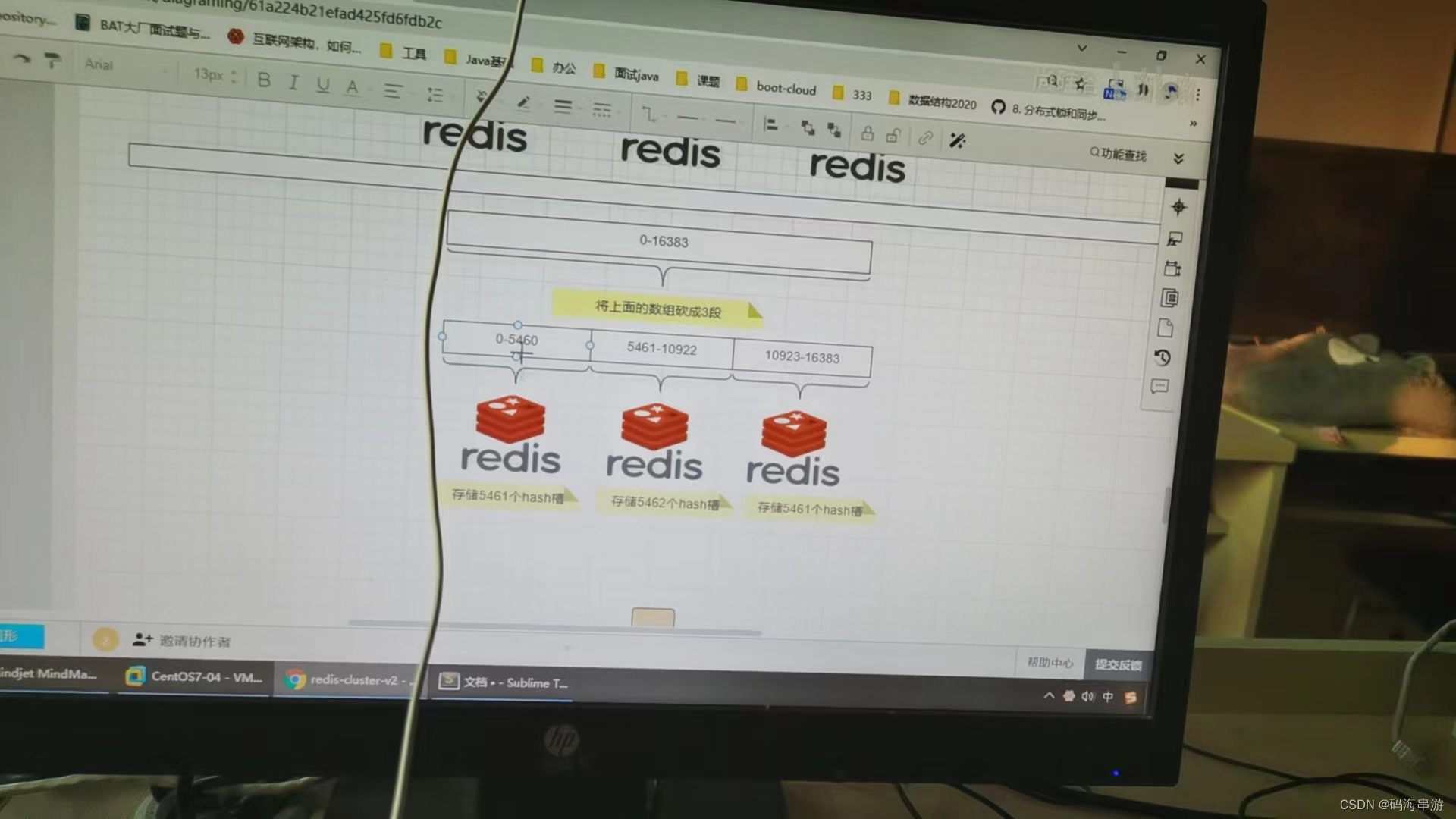

3,哈希槽分区

是什么?

哈希槽计算

服务器IP节点映射

key落到服务器的落键规则

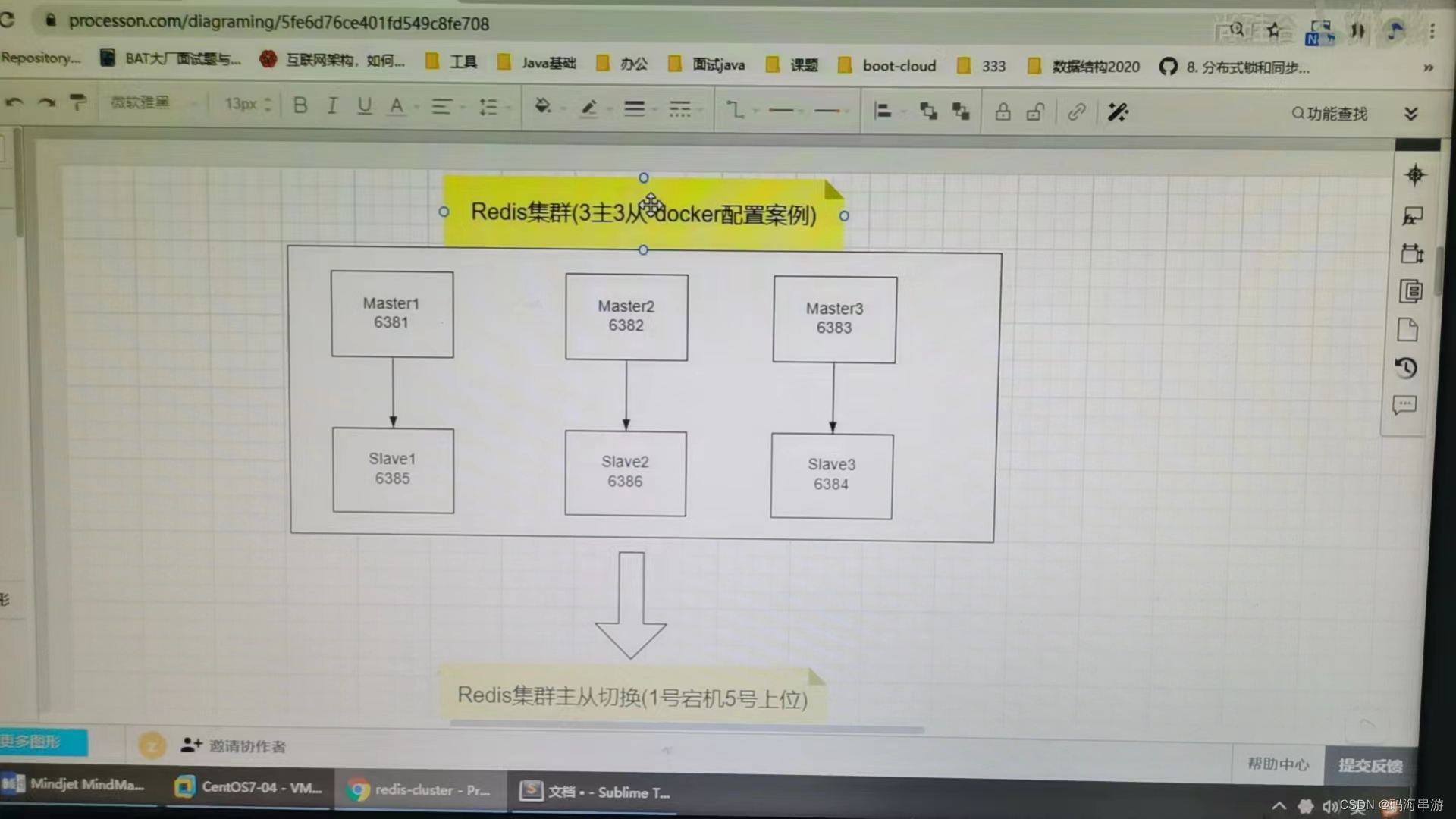

3主3从redis集群扩缩容配置案例架构说明

processon笔记

打开步骤

3主3从redis集群配置

Cannot connect to the Docker daemon at unix:///var/run/docker.sock. Is the docker daemon running?(这是docker服务没有启动)

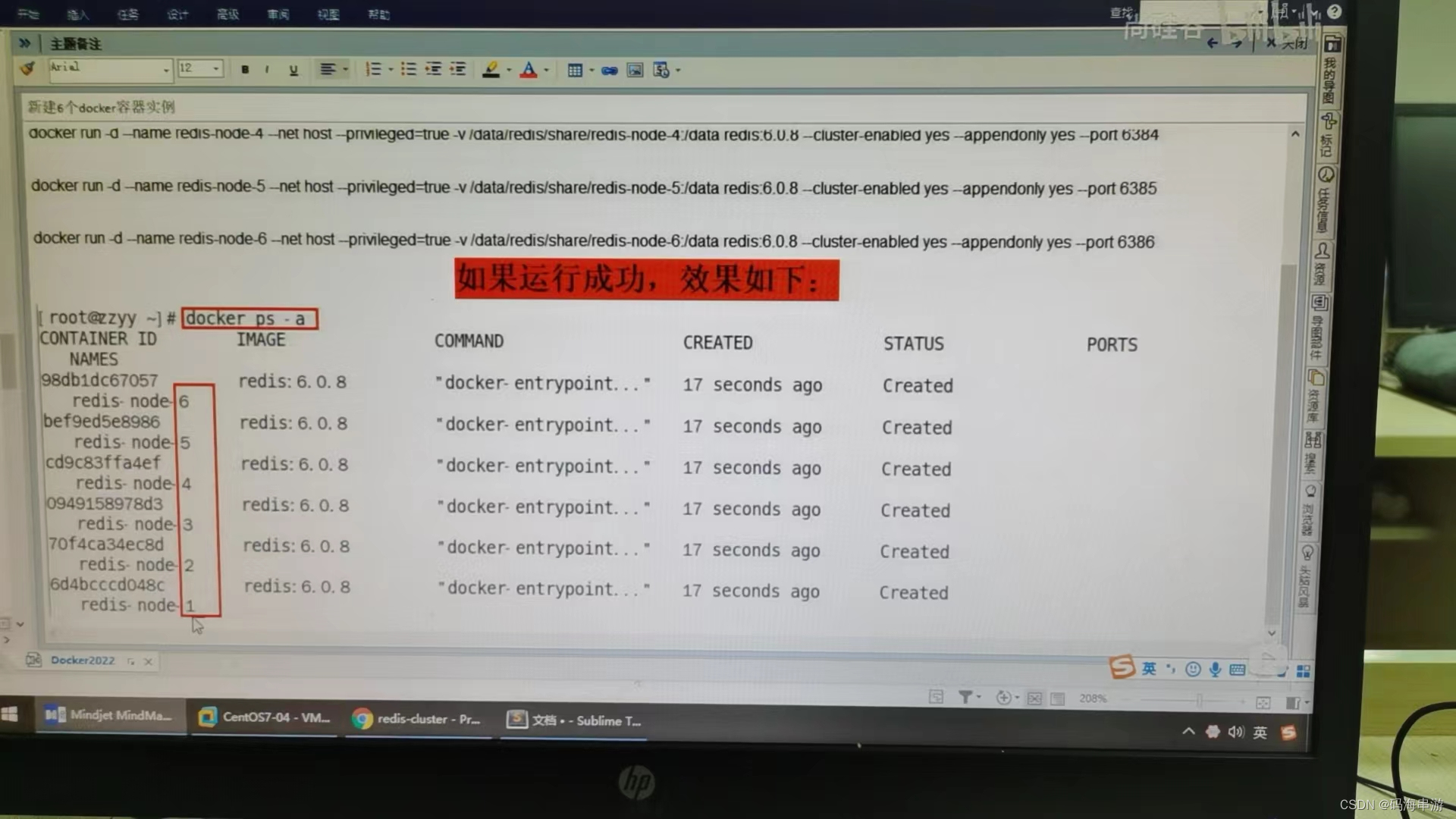

1)关闭防火墙+启动docker后台服务

systemctl start docker

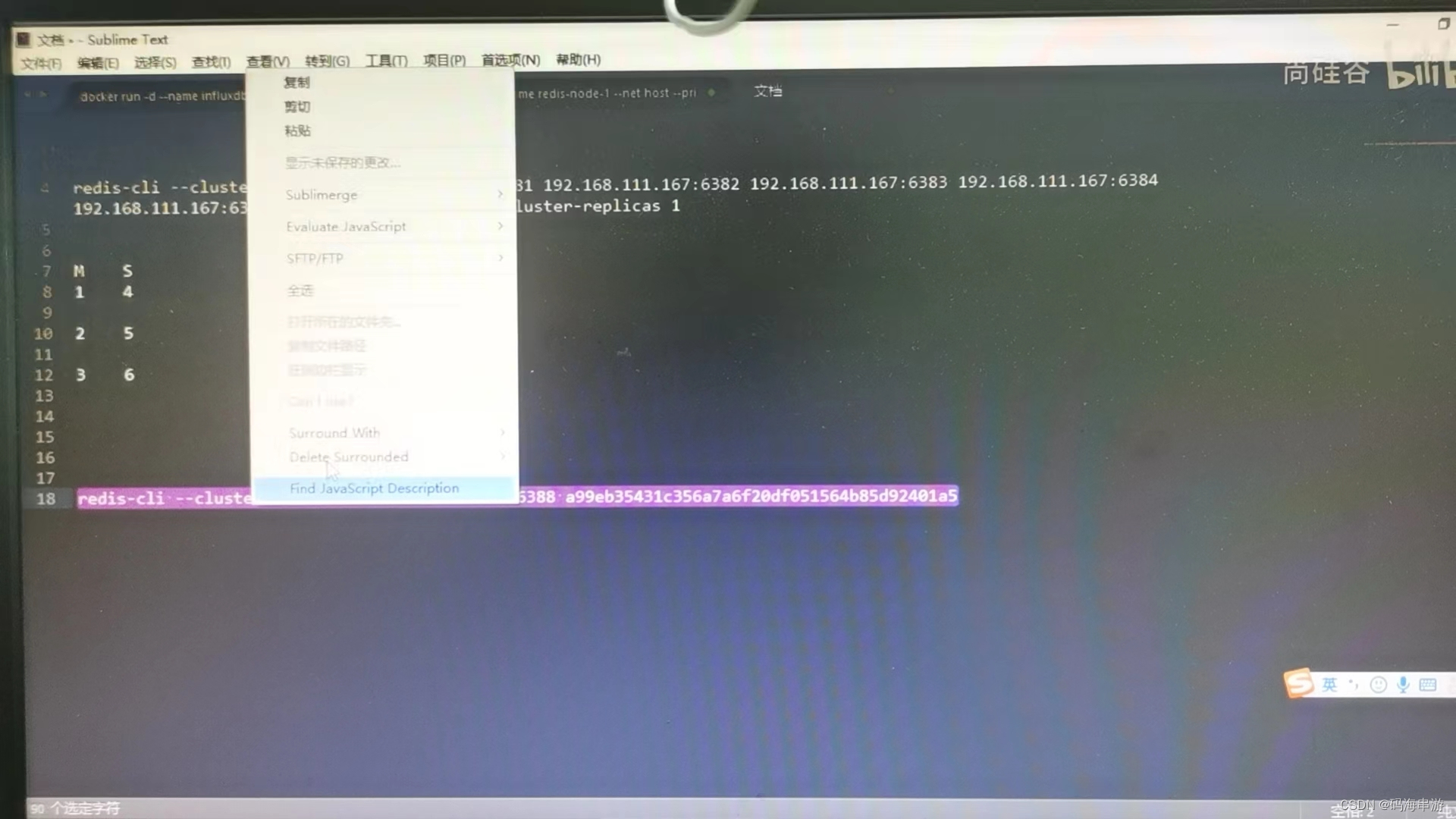

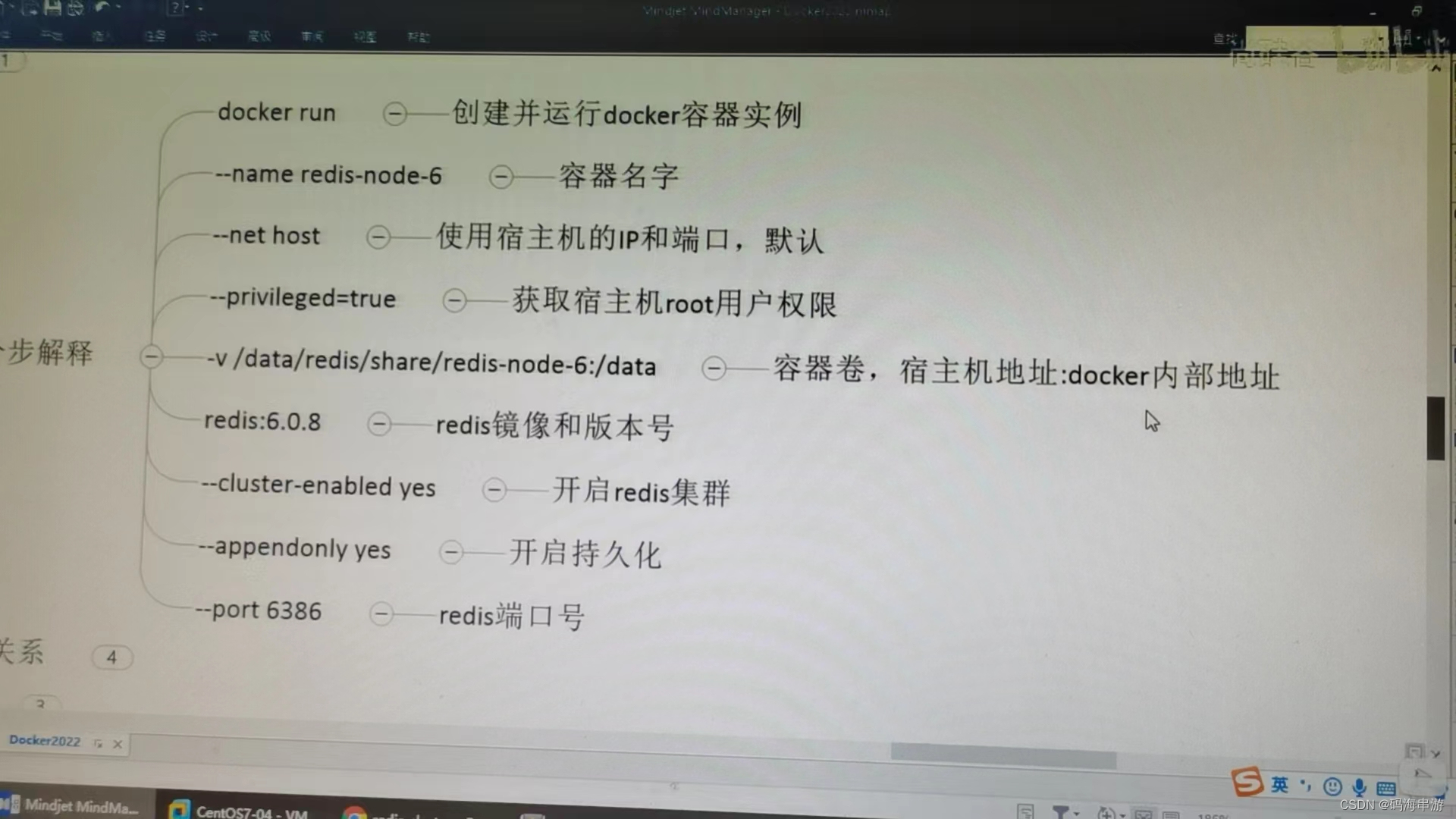

2)新建6个docker容器实例

命令分布解释

docker run -d --name redis-node-1 --net host --privileged=true -v /data/redis/share/redis-node-1:/data redis:6.0.8 --cluster

enabled yes --appendonly yes --port 6381

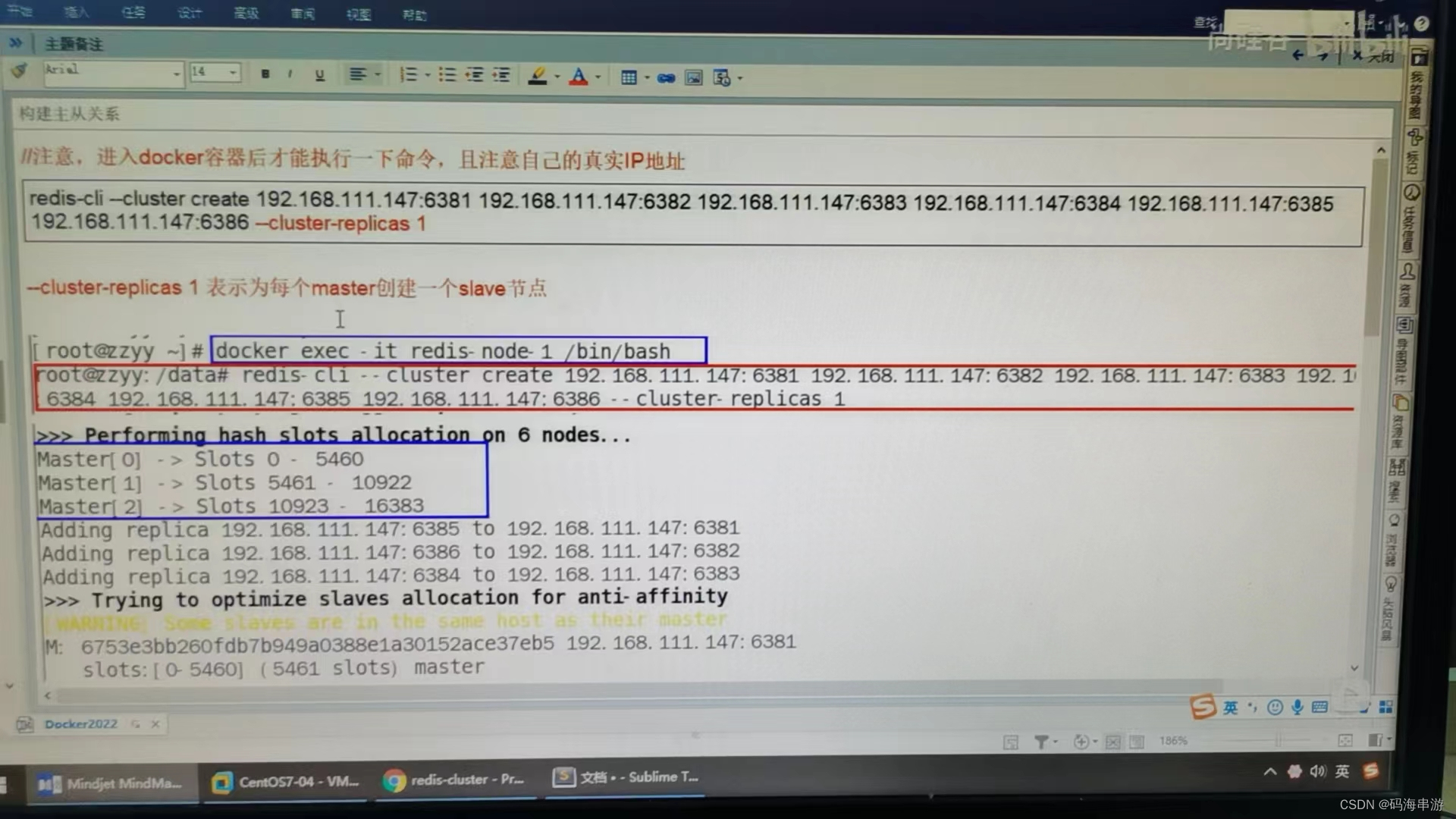

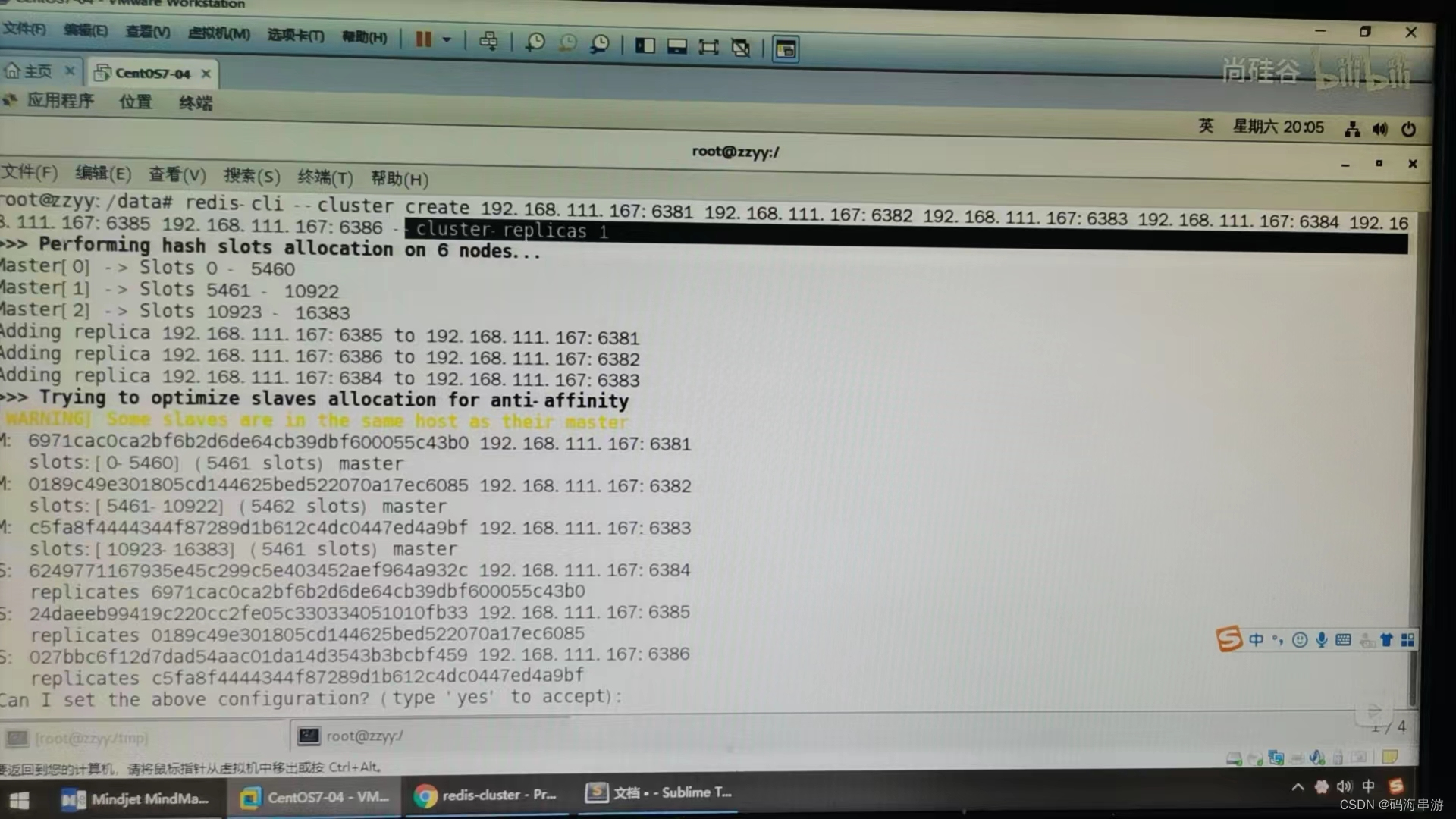

3)进入容器redis-node-1并为6台机器构建集群关系。

docker exec -it redis-node-1 /bin/bash

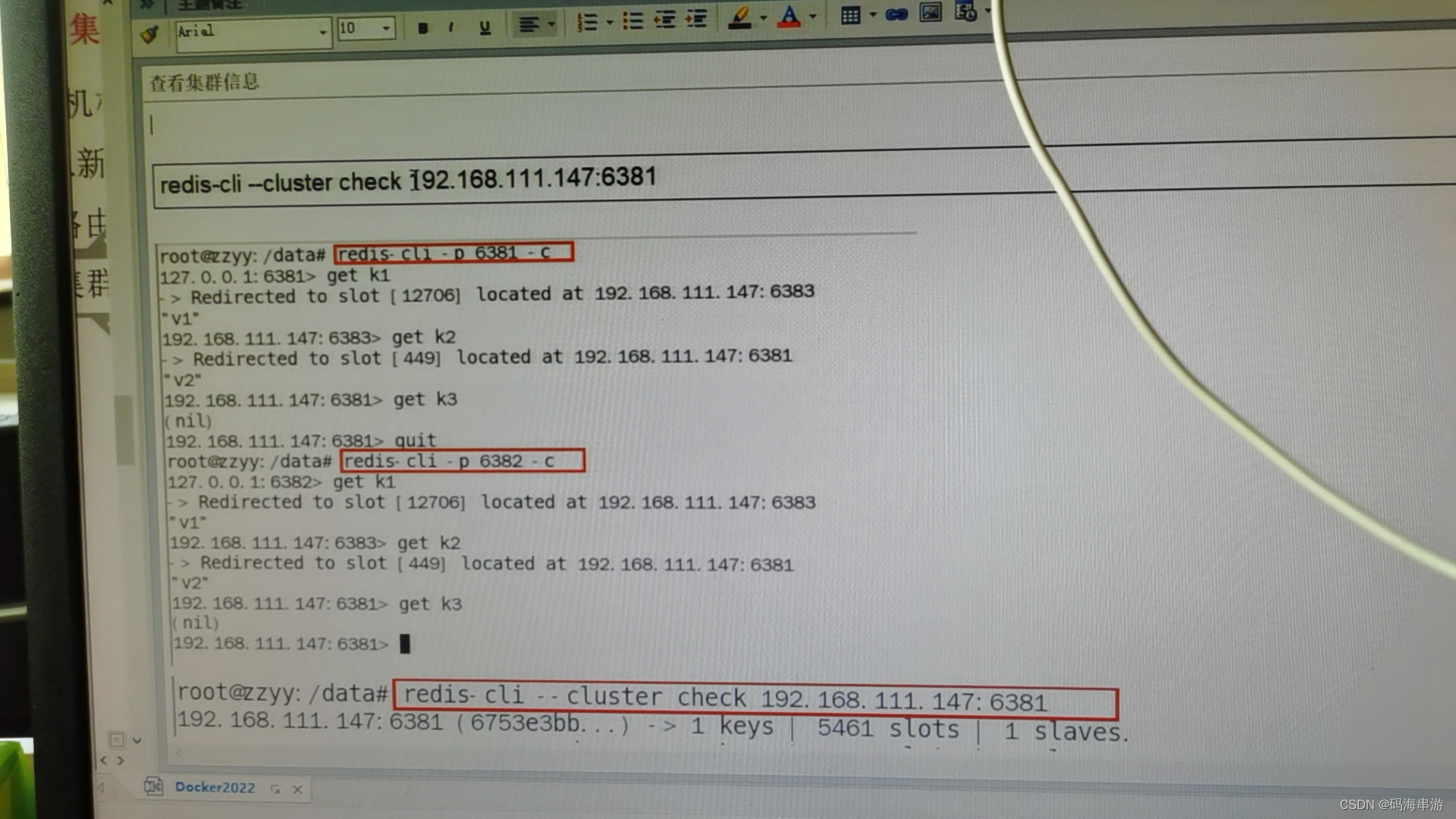

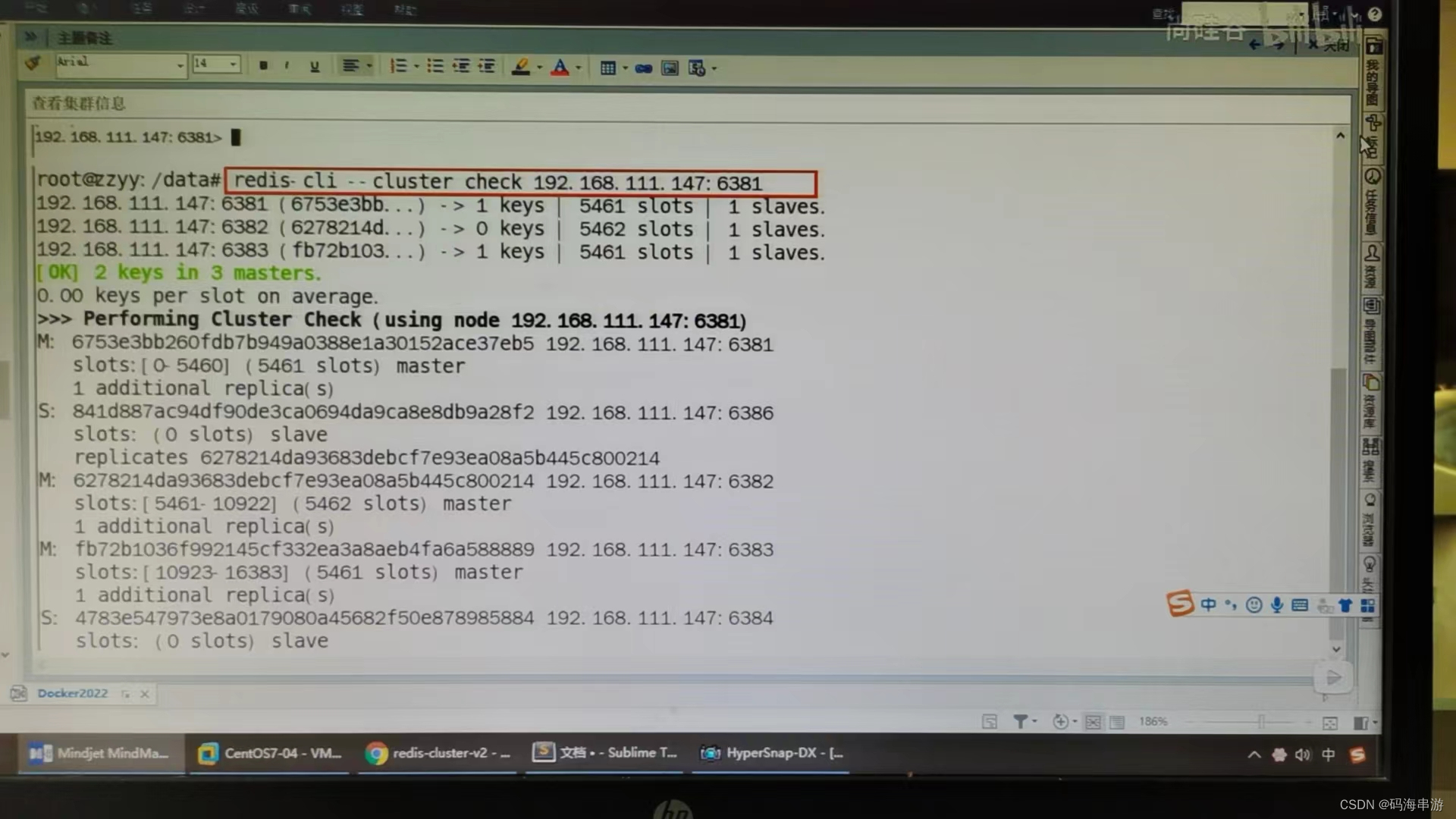

4)链接进入6381作为切入点,查看集群状态

从编号可以看出来那个是哪个的从

主从容错切换迁移案例

1,数据读写存储

1)启动6机构成的集群并通过exec进入

docker exec -it redis-node-1 /bin/bash

redis-cli -p 6381

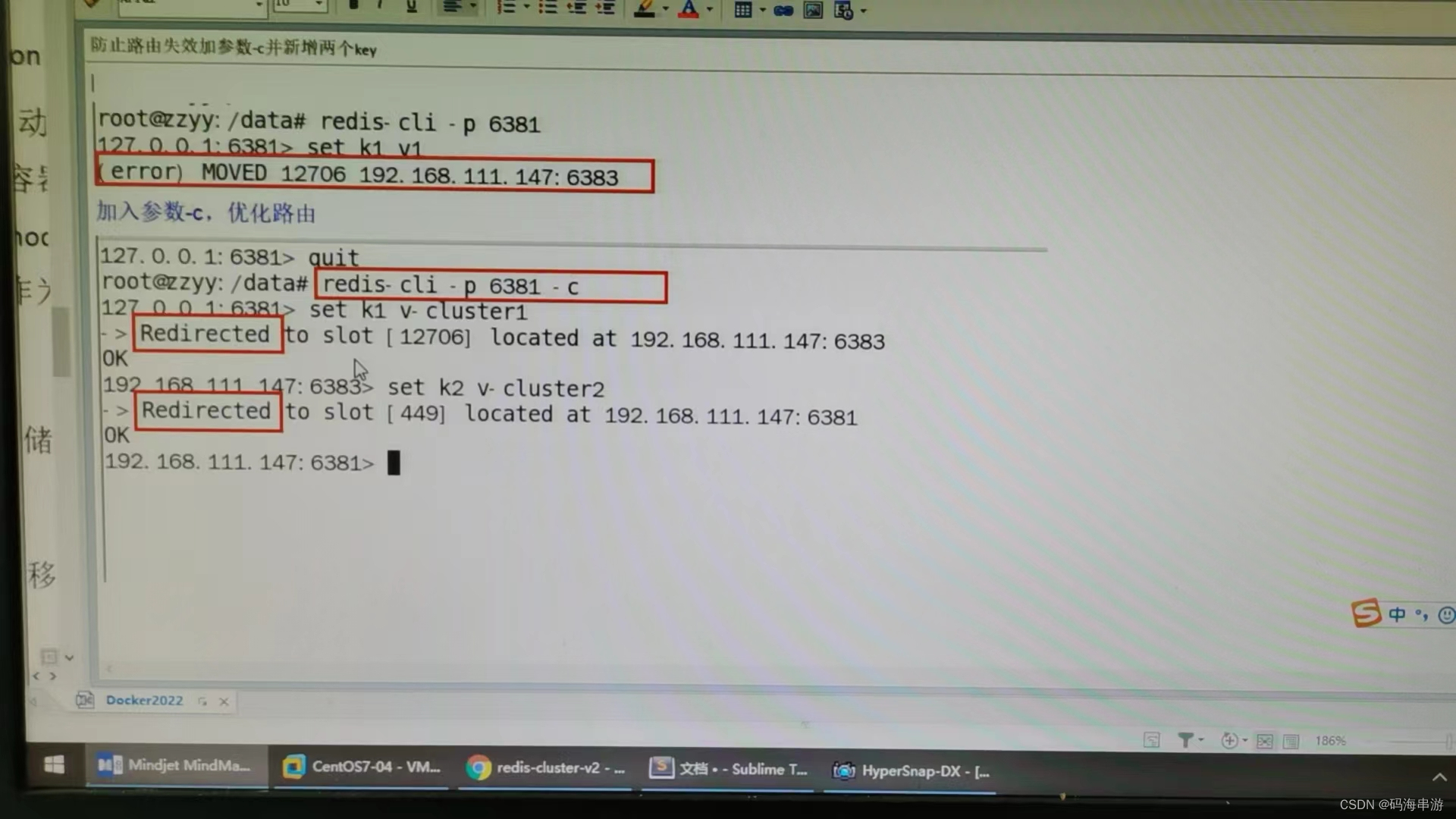

2)对6381新增两个key

keys *

set k1 v1

set k2 v2

set k3 v3

set k4 v4 (挂了)

docker exec -it redis-node-1 /bin/bash

redis-cli -p 6381 -c

FLUSHALL

set k1 v1

3)防止路由失效加参数-c并新增两个key

4)查看集群信息

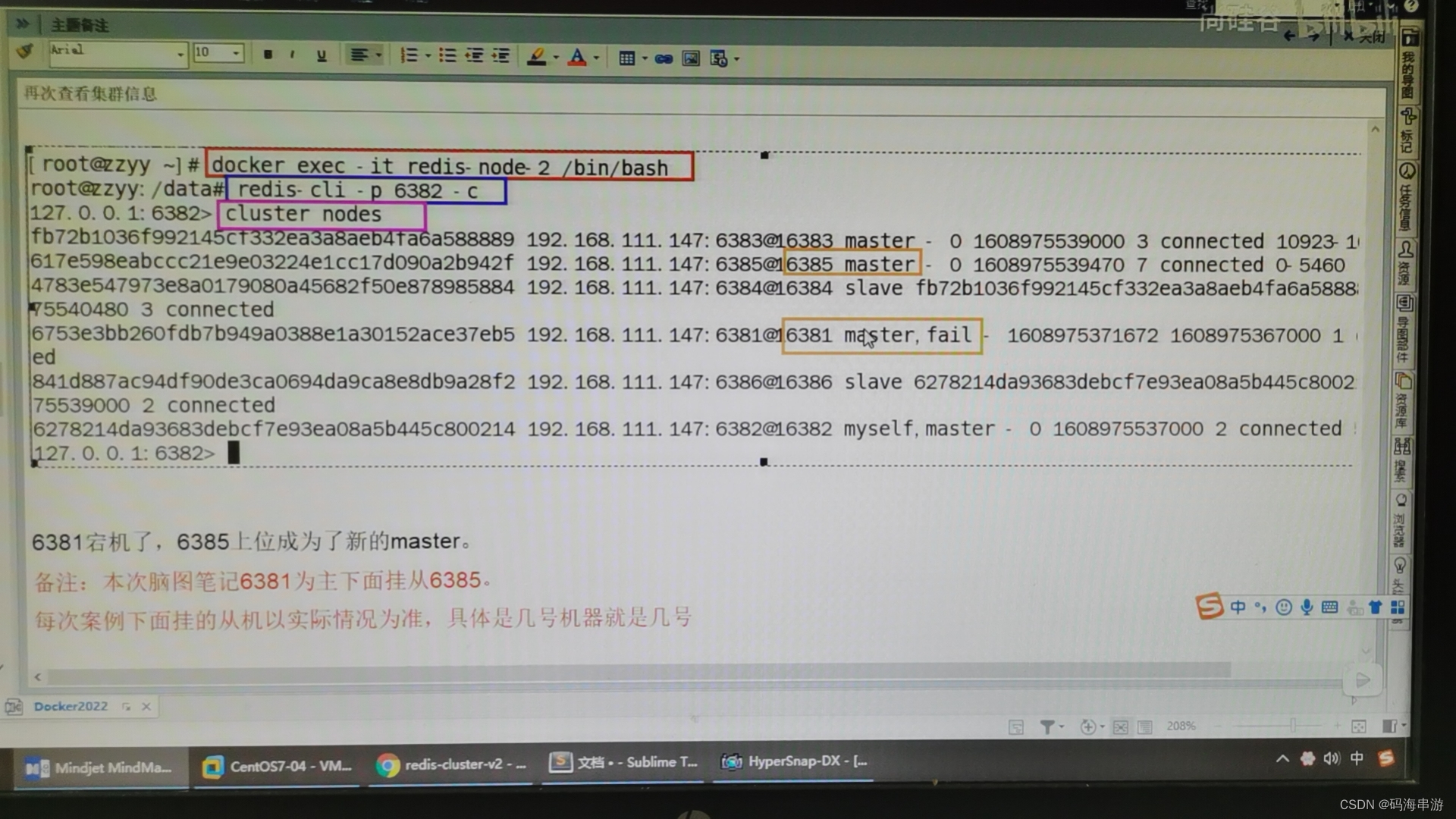

2,容错切换迁移

1)主6381和从机切换,先停止主机6381

docker ps

docker stop redis-node-1

docker ps

docker exec -it redis-node-2 bash

redis-cli -p 6382 -c

cluster nodes

2)再次查看集群信息

docker ps

docker start redis-node-1

docker ps

cluster nodes

发现宕机的主变成了slave从

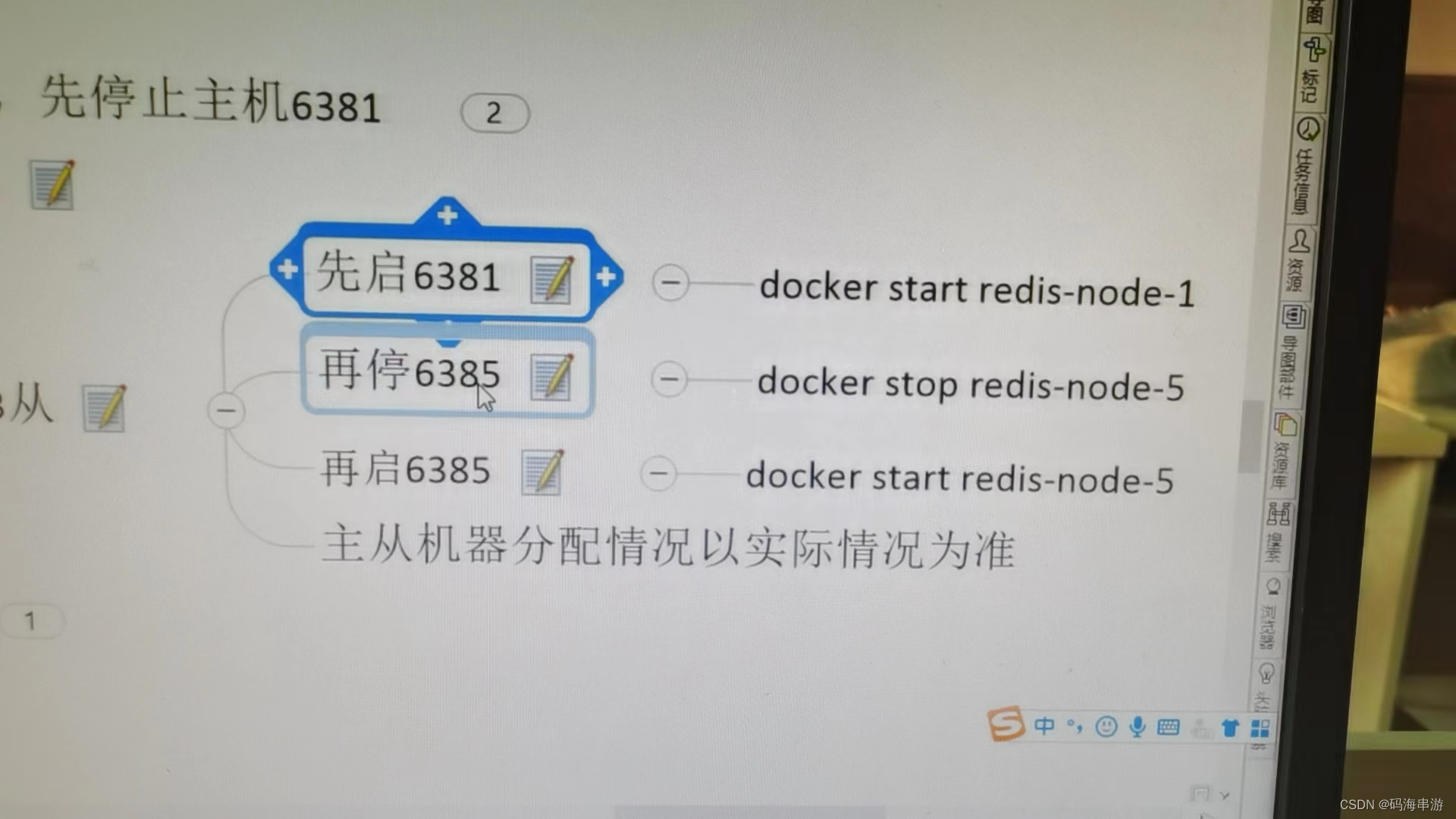

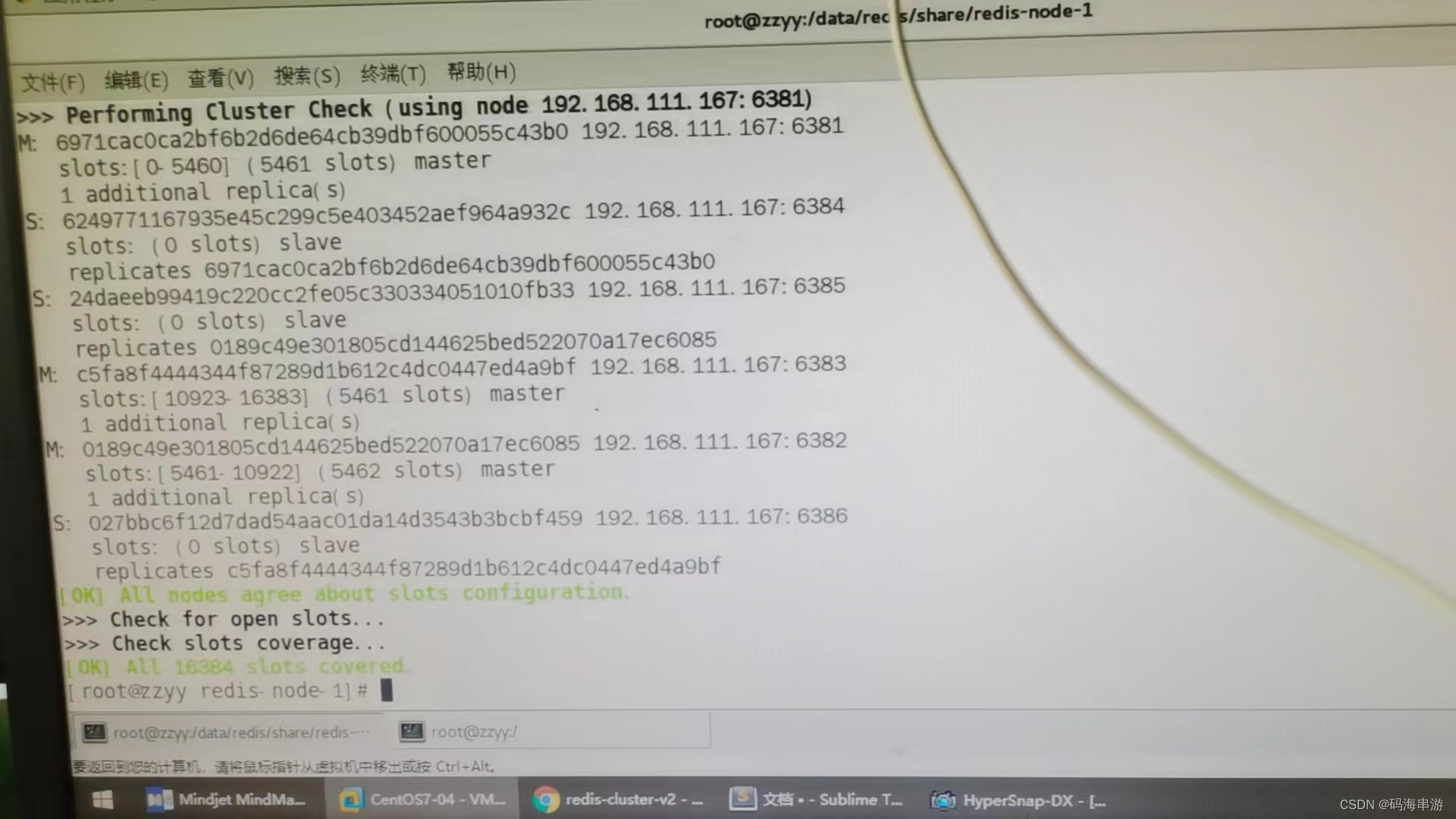

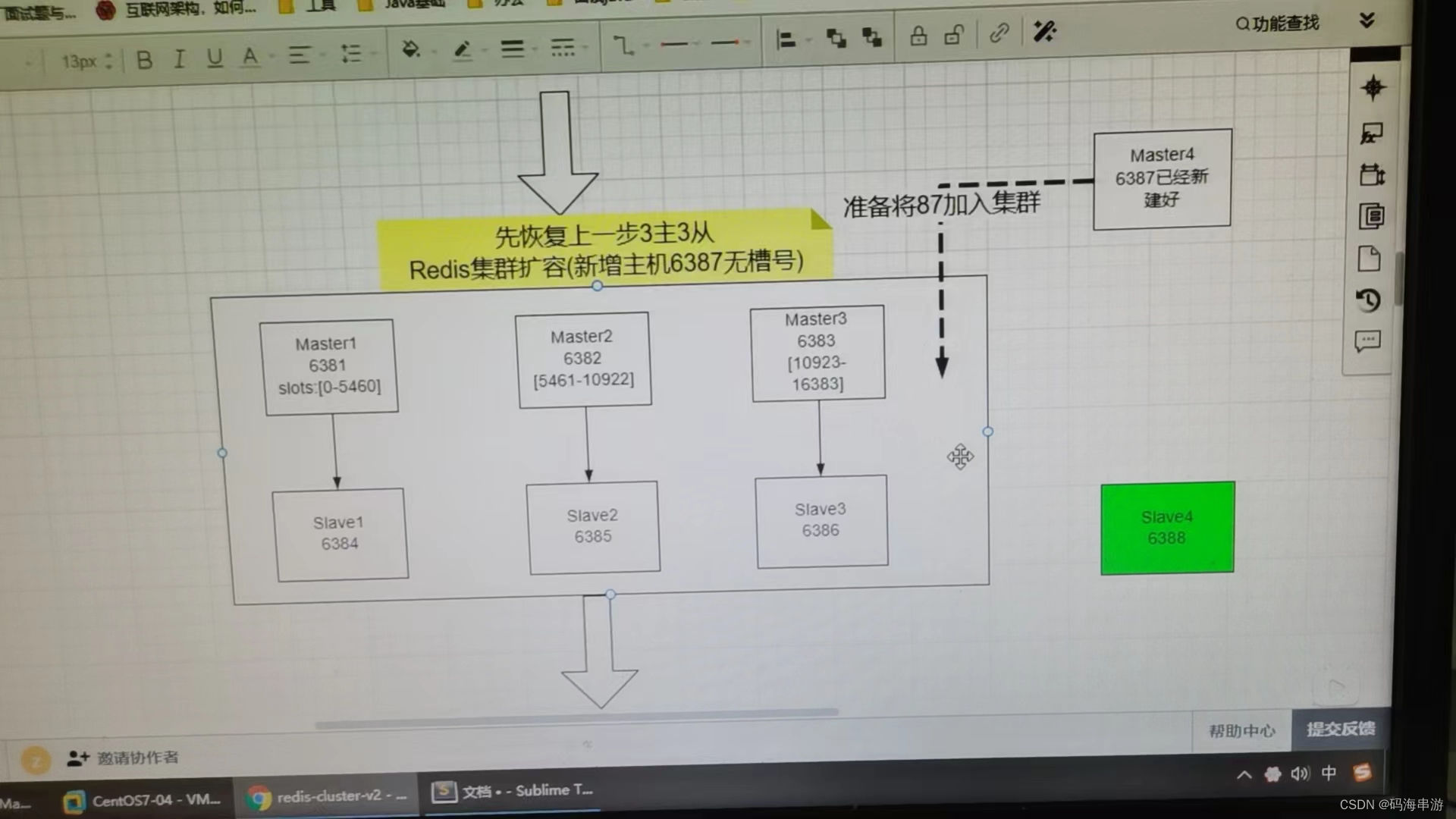

3)先还原之前的3主3从

4)查看集群状态

redis-lic --cluster check 自己IP:6381

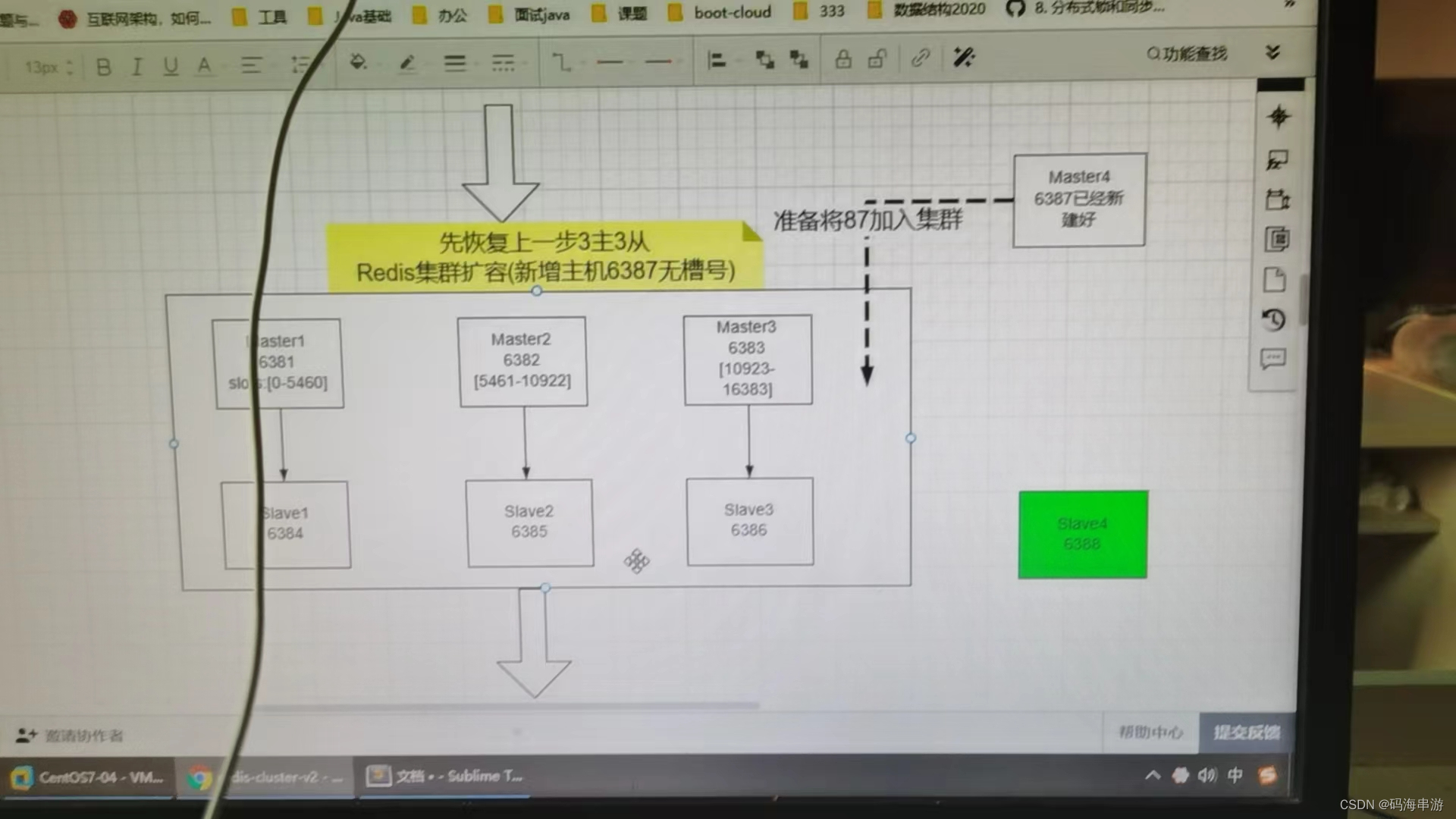

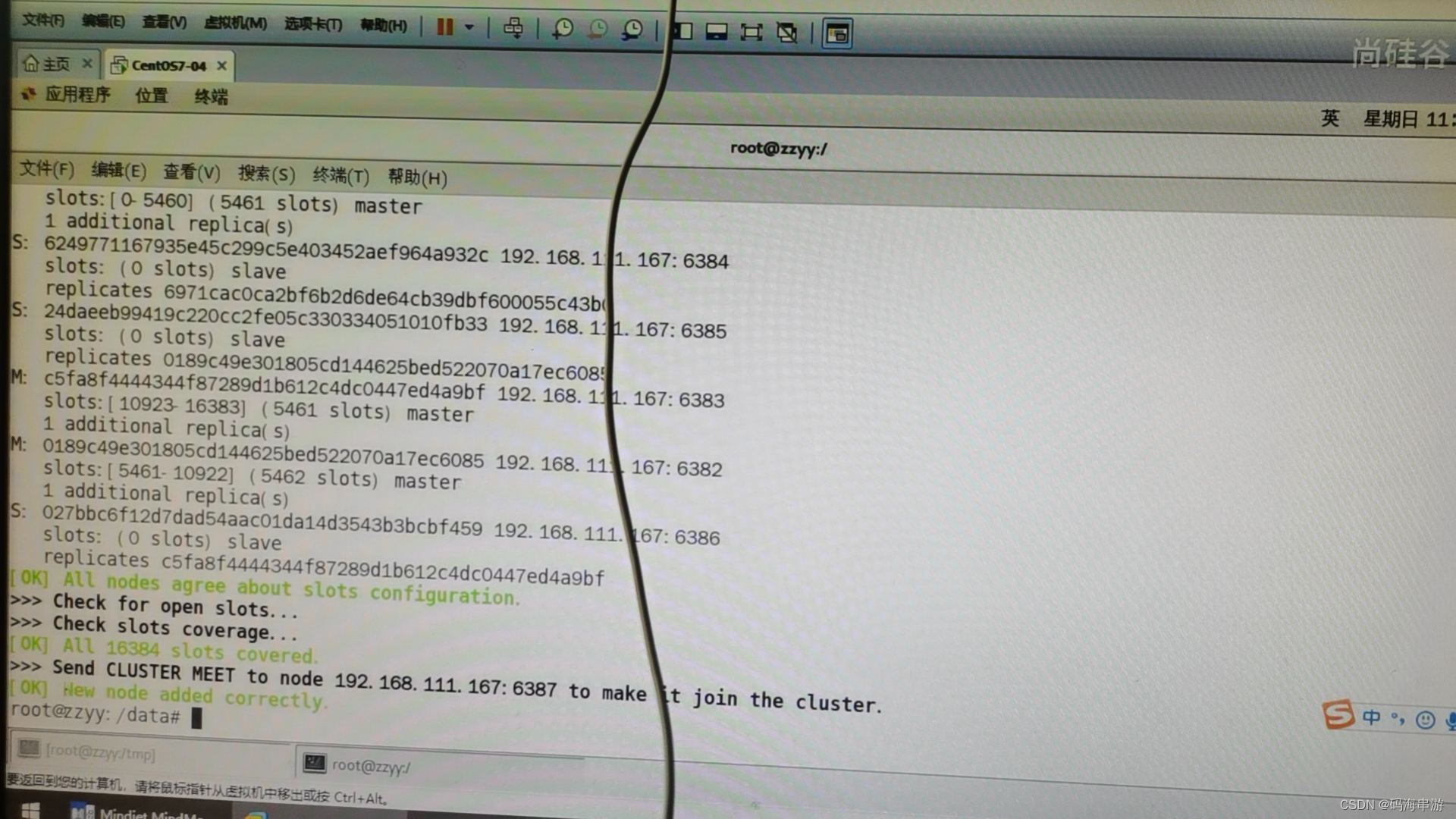

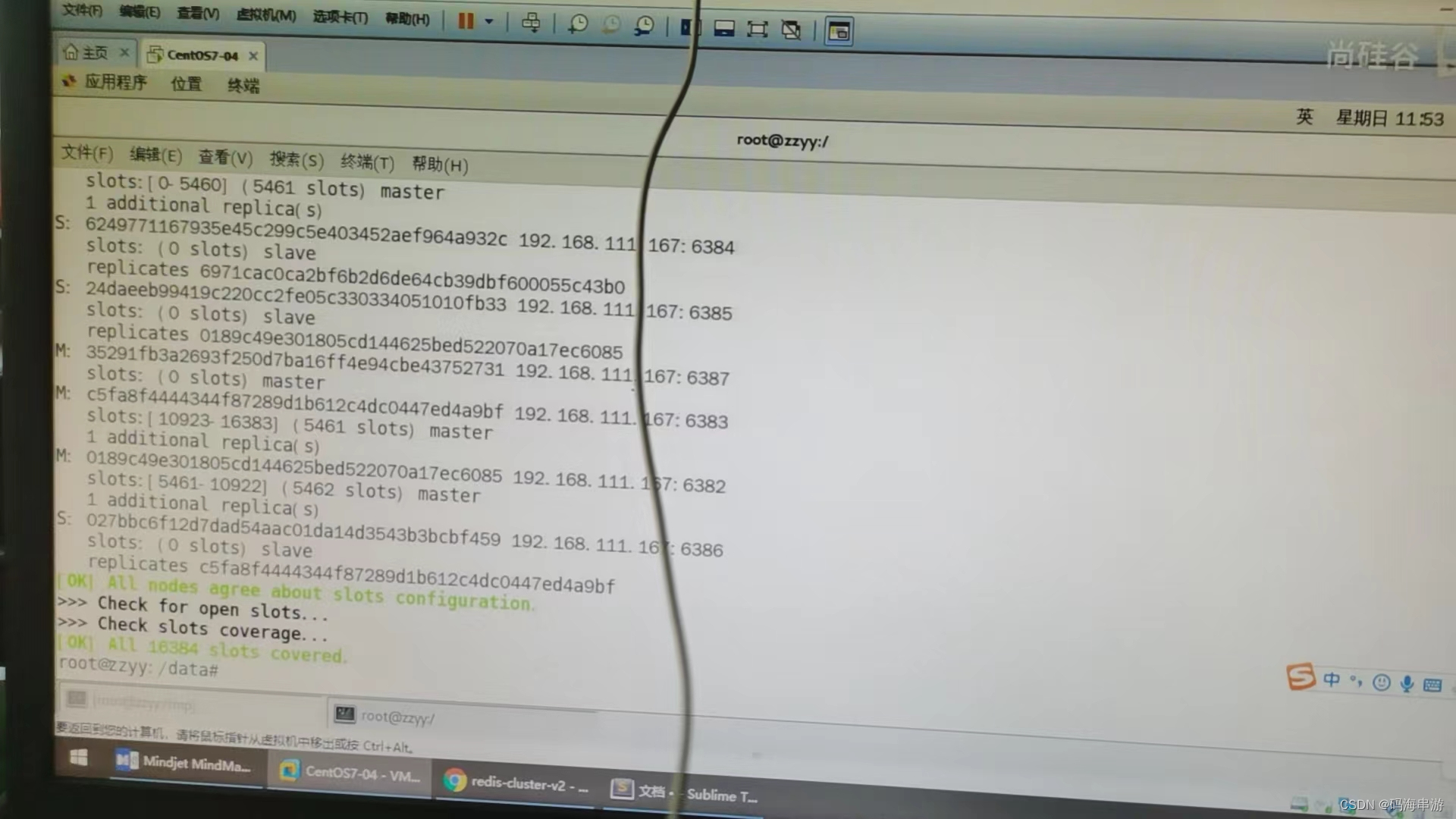

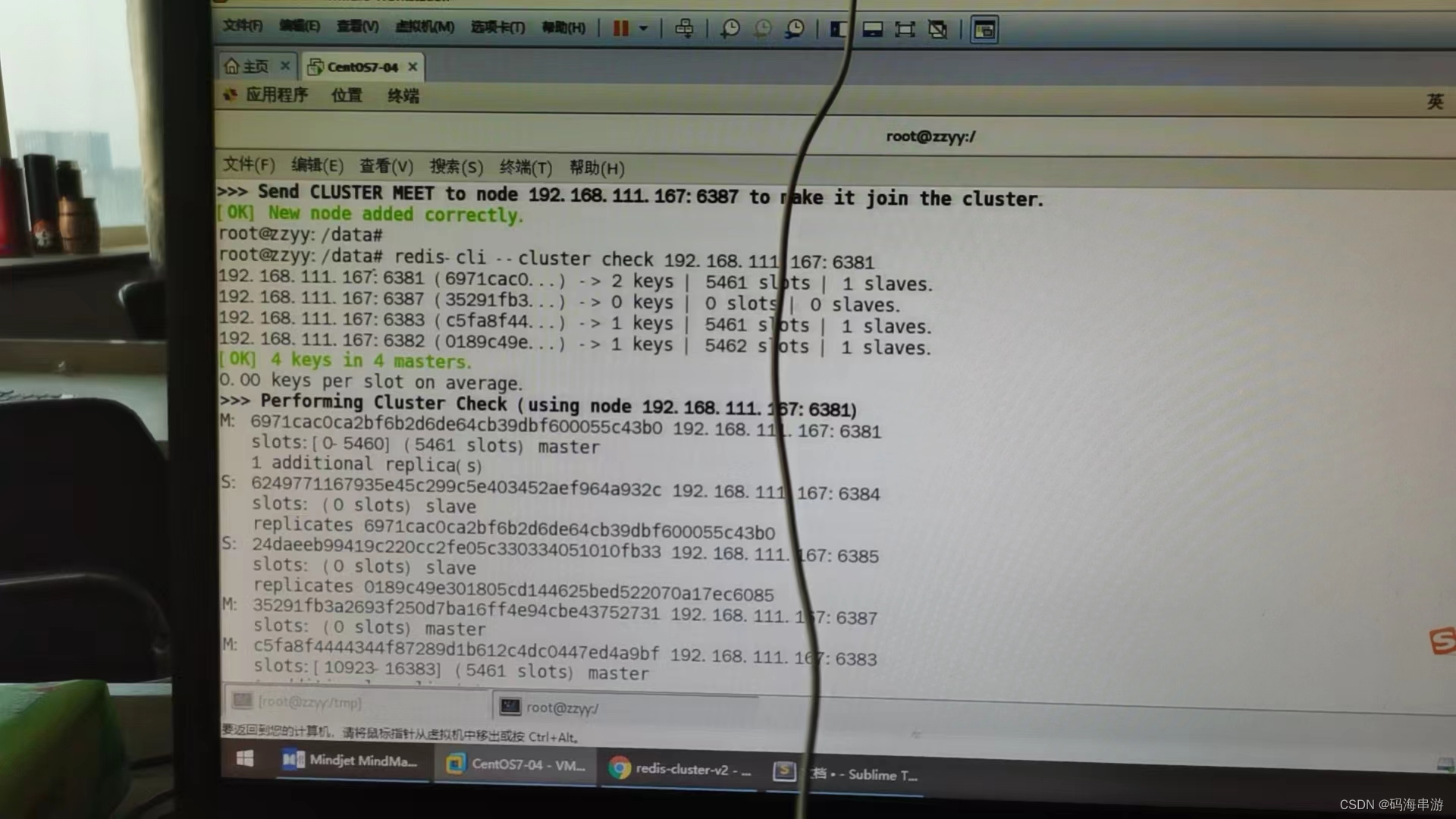

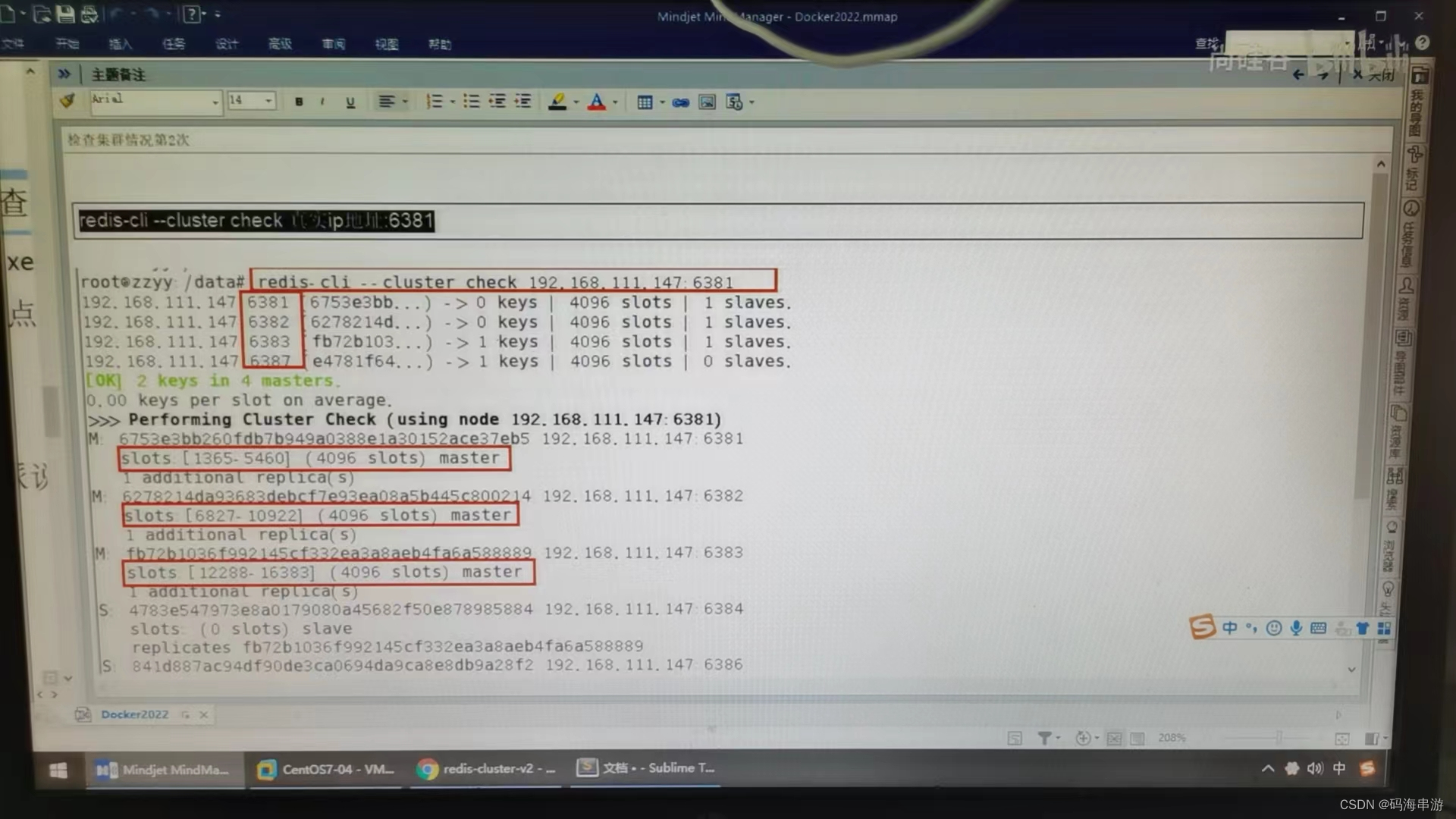

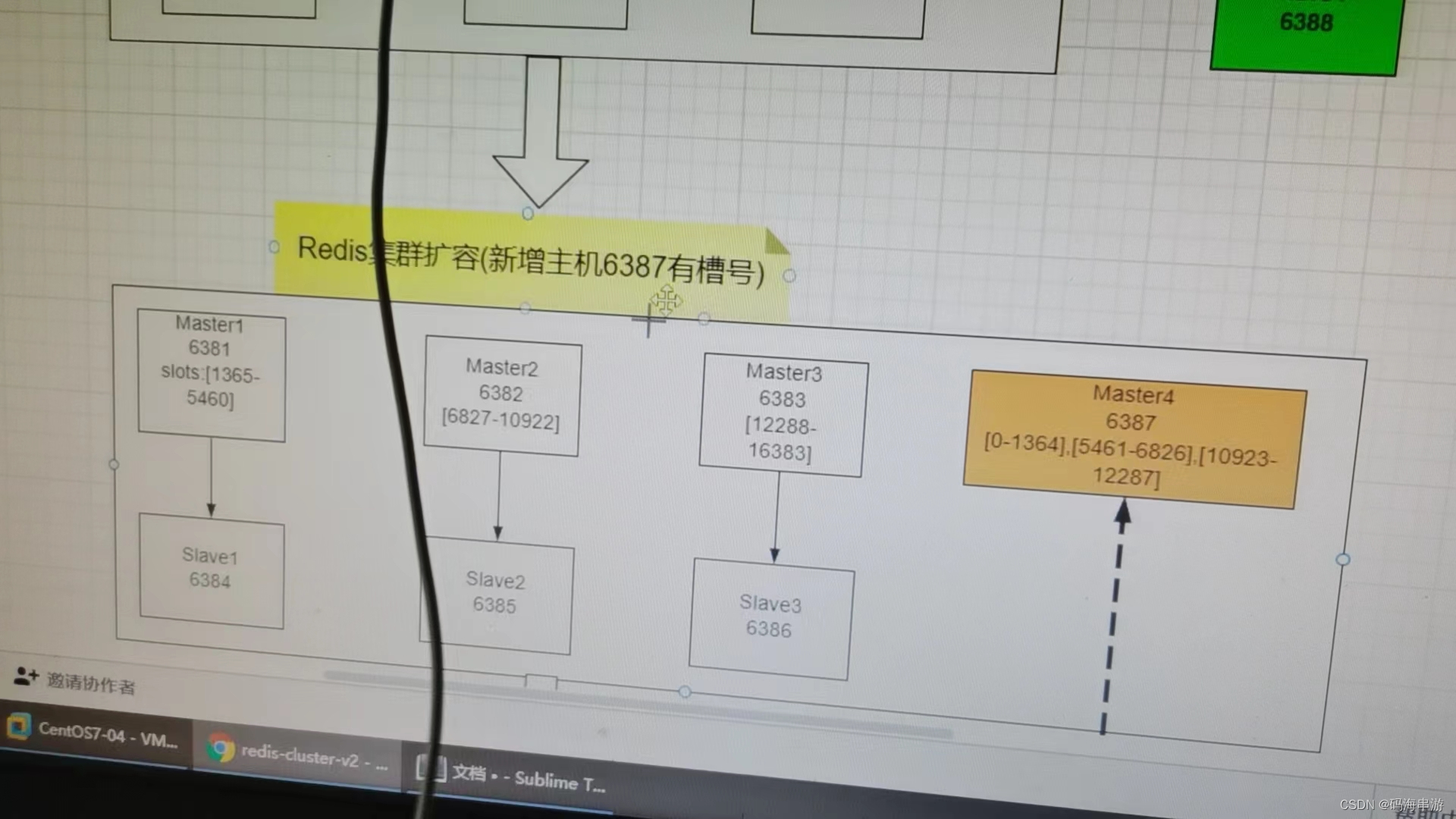

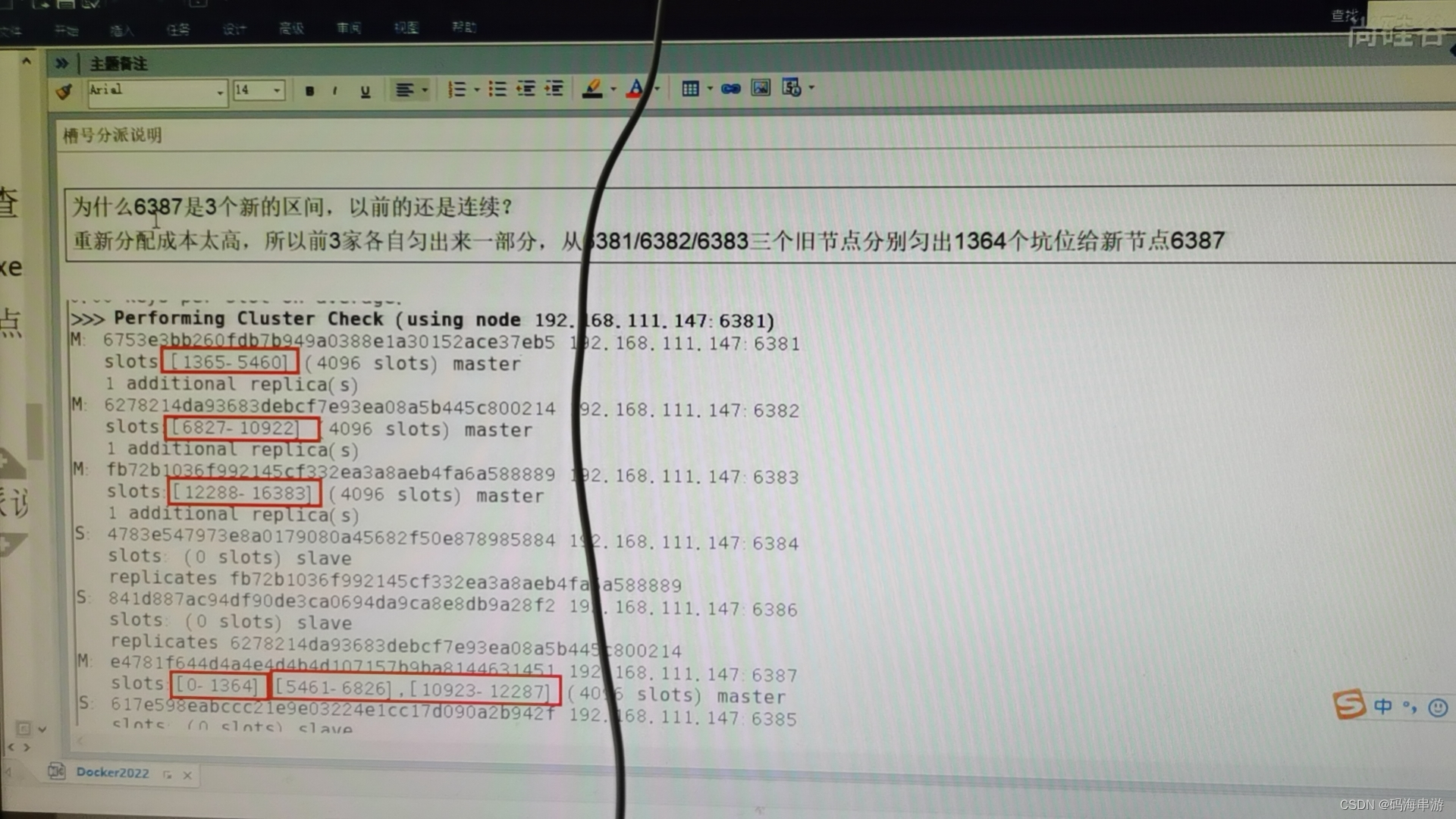

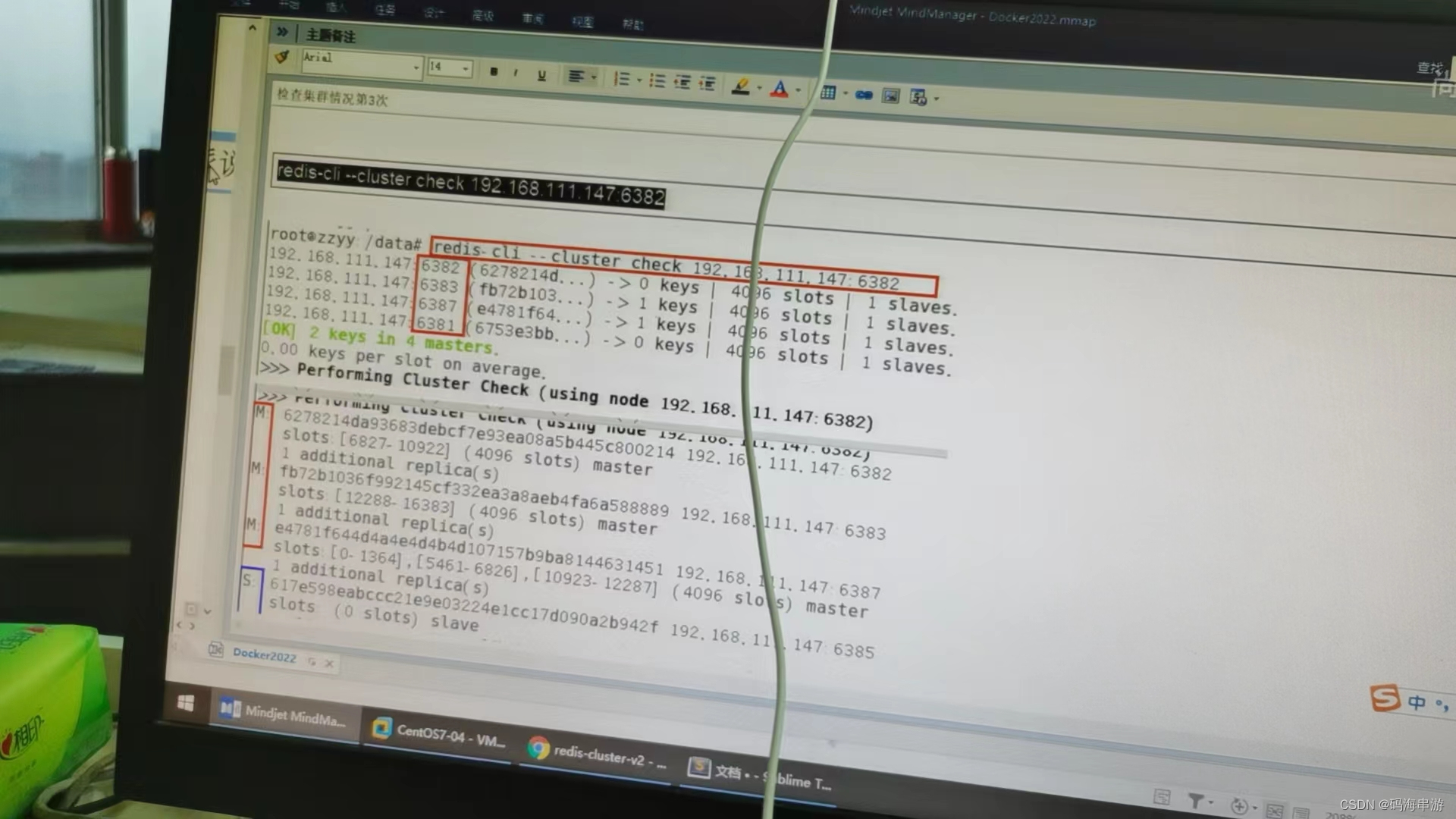

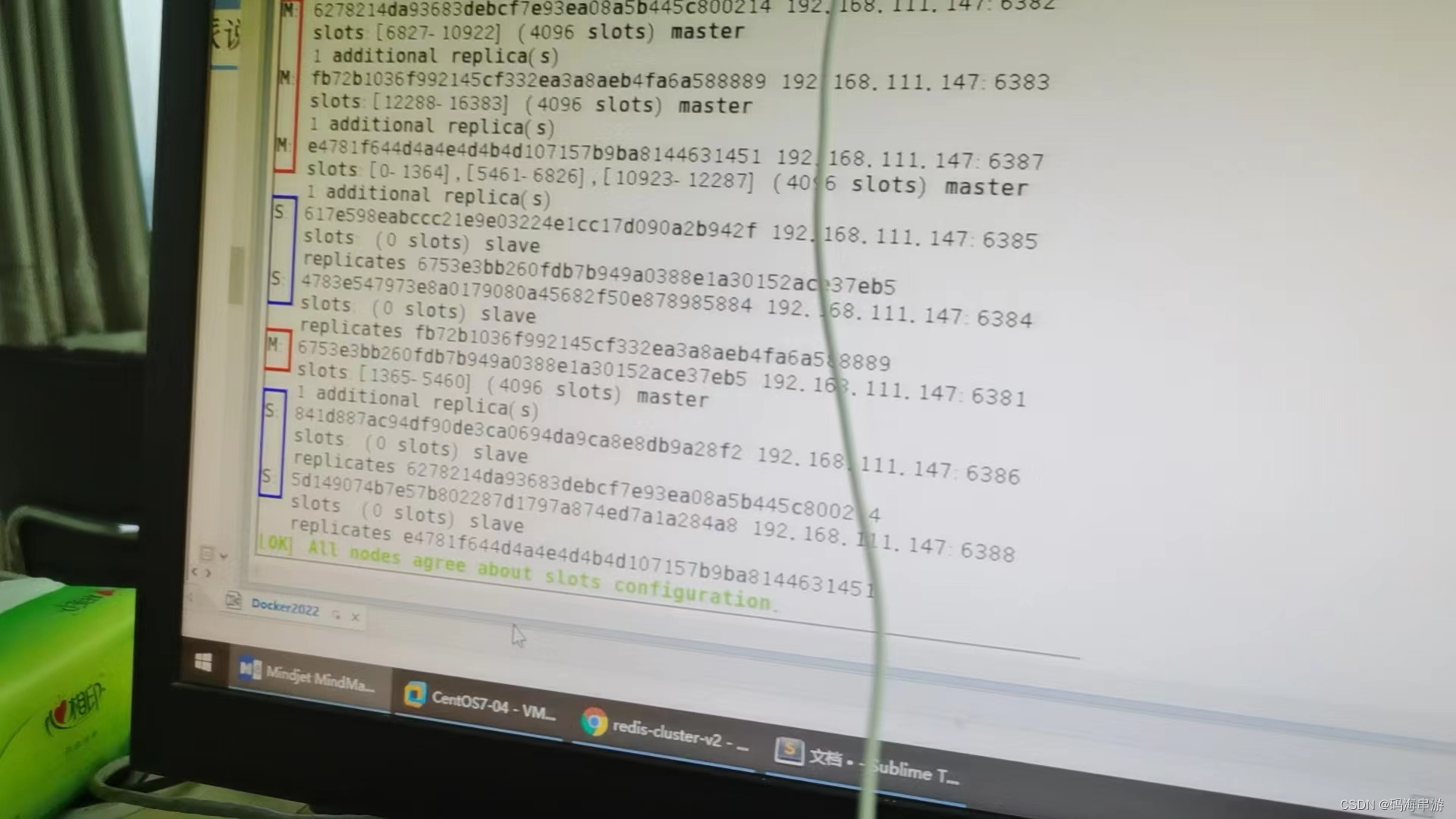

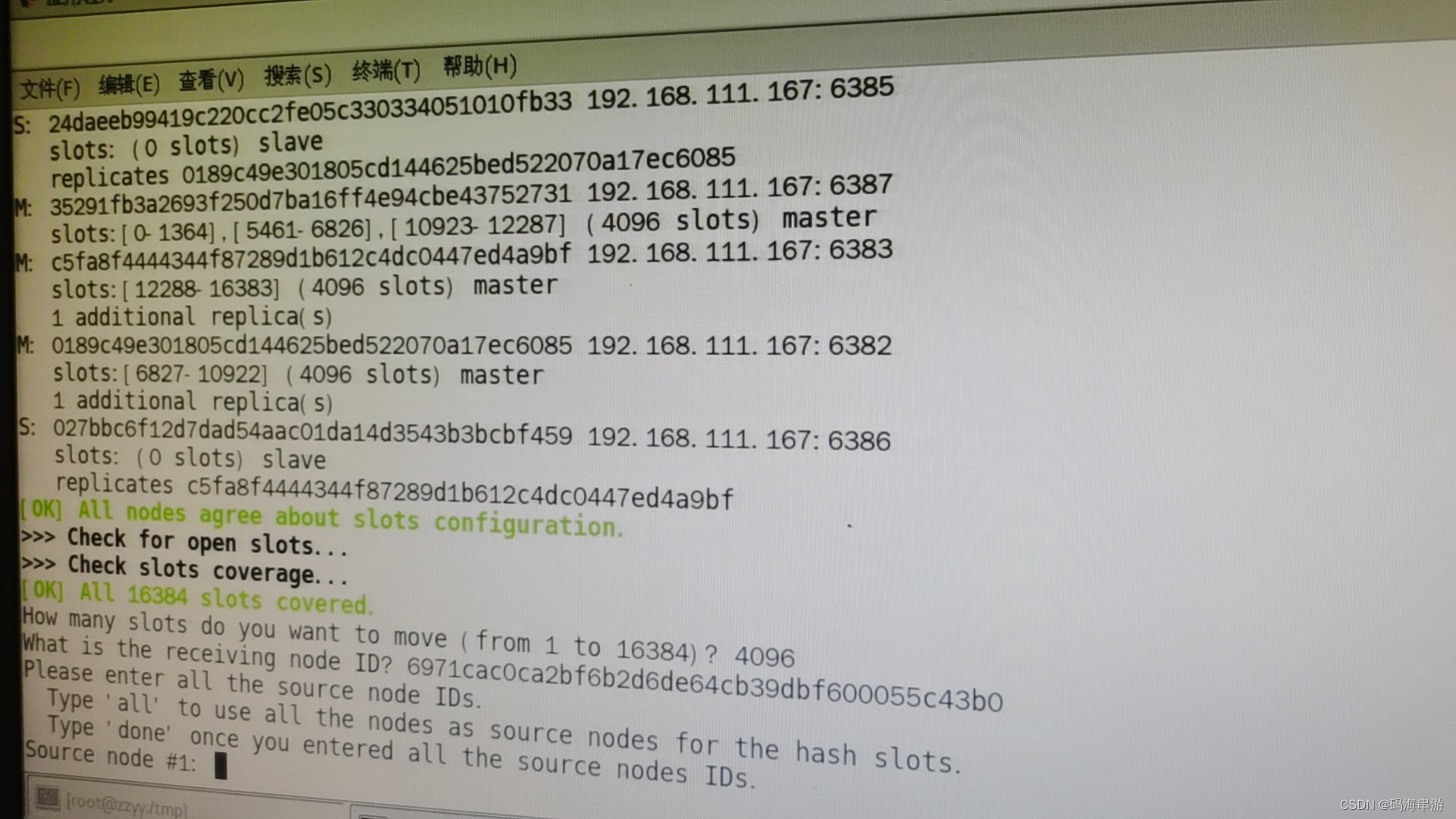

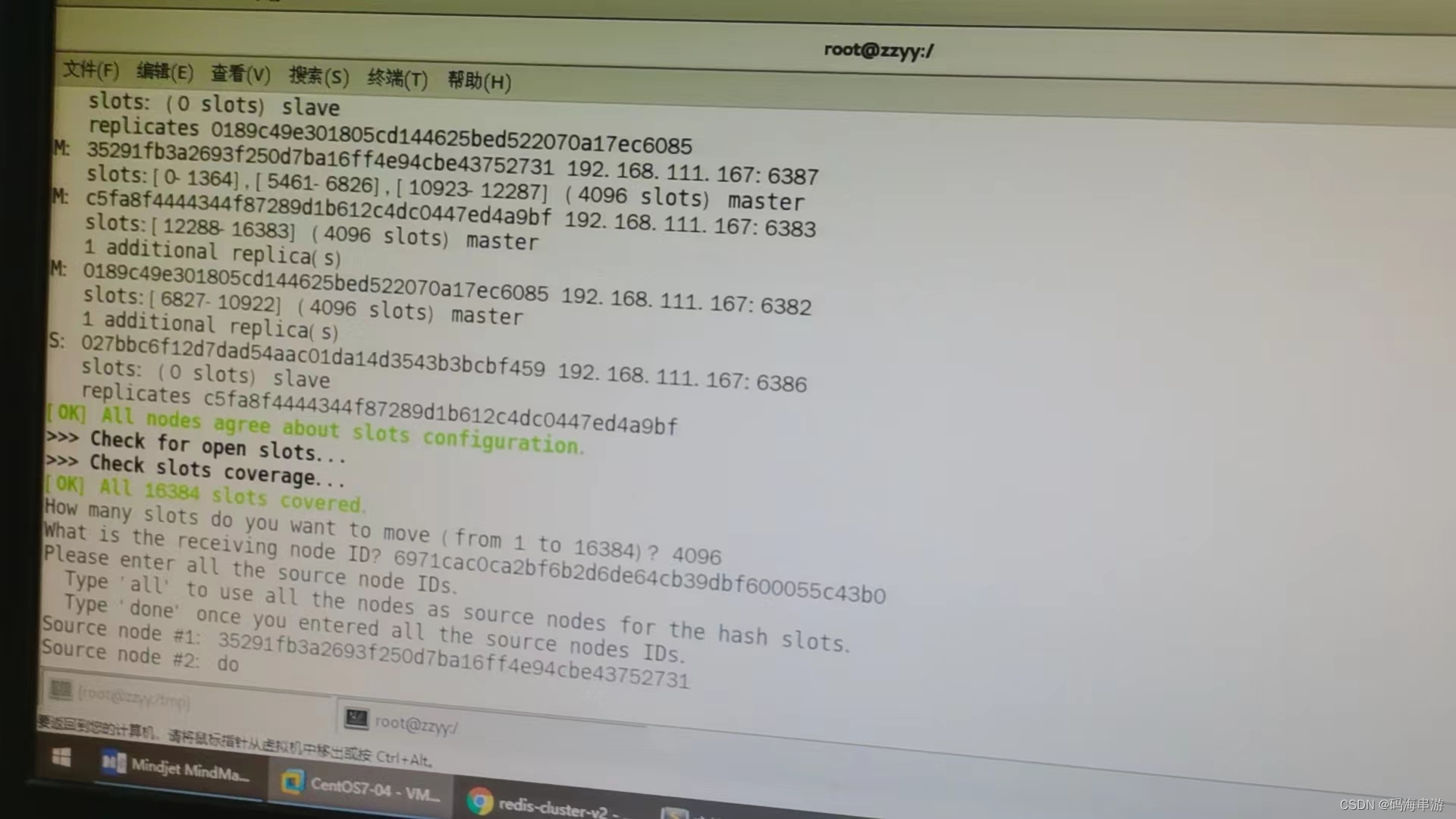

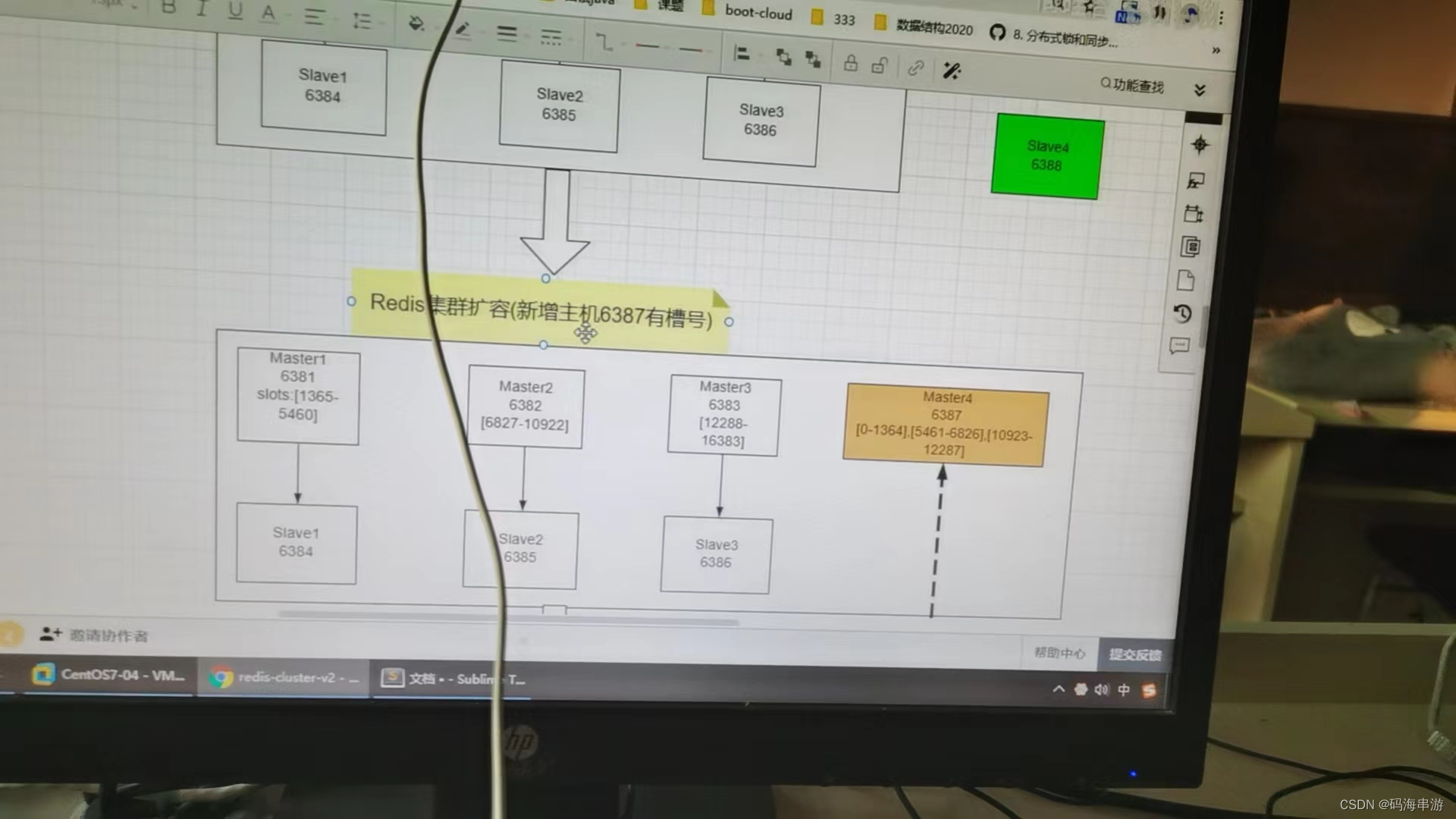

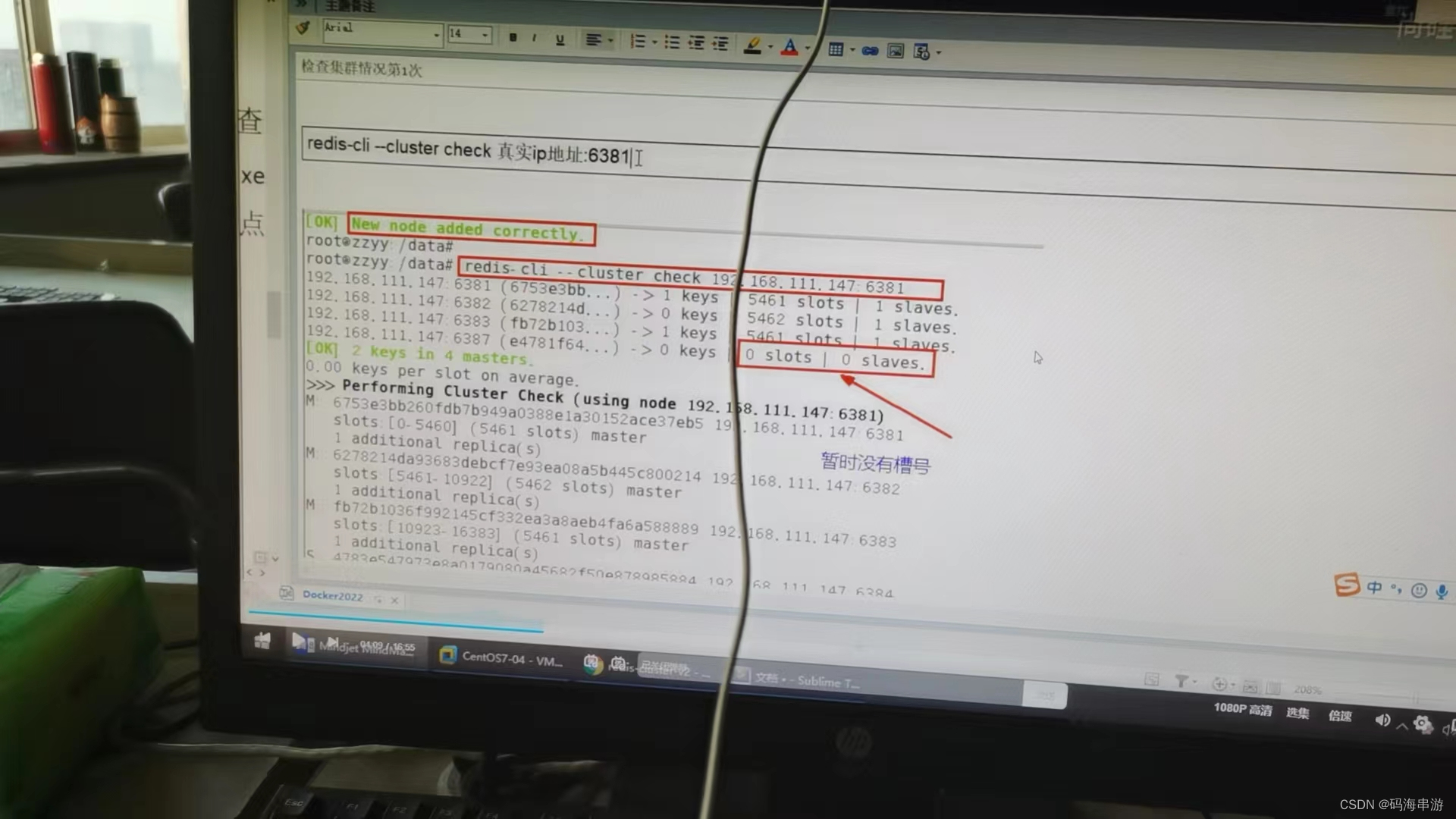

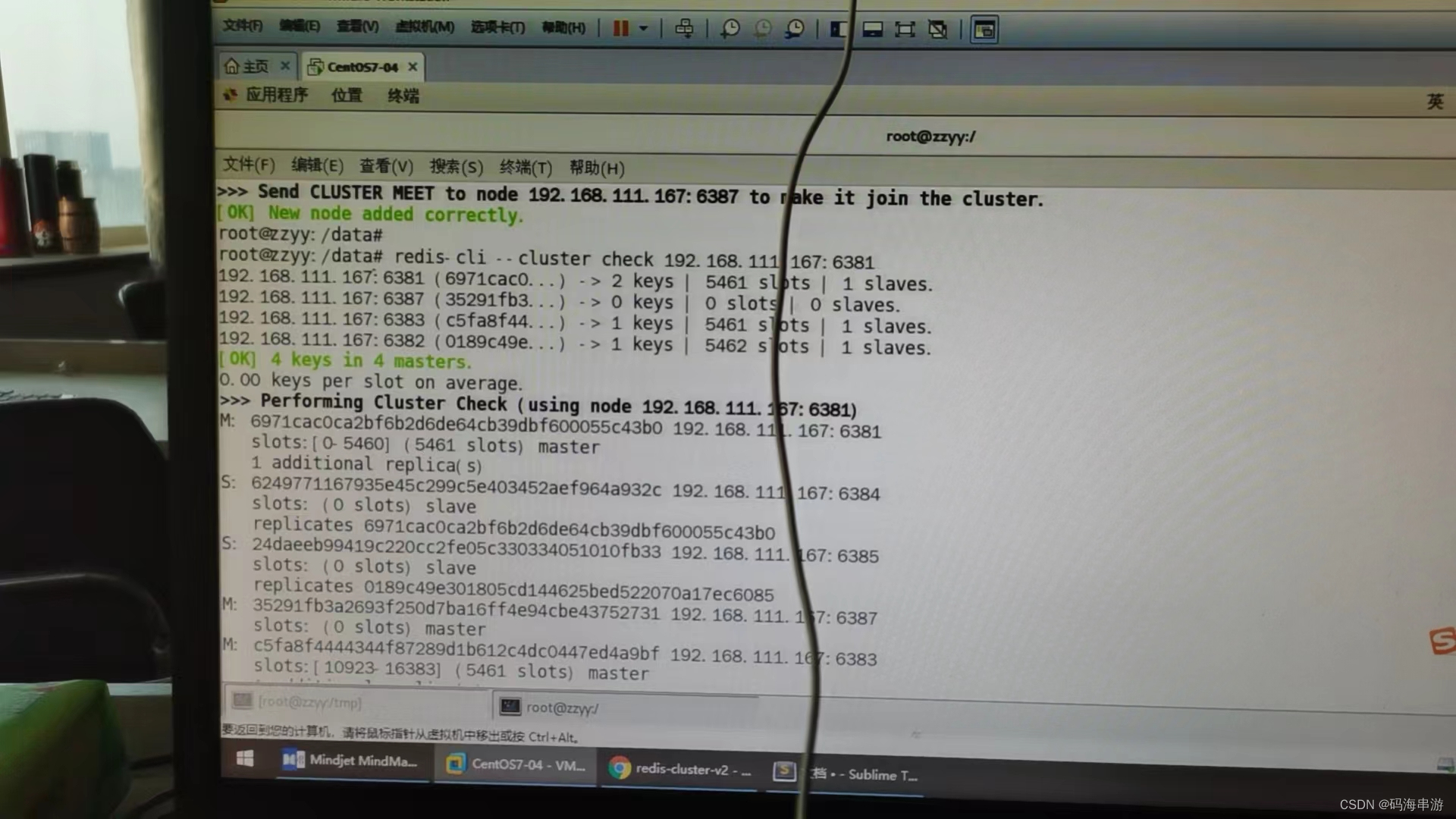

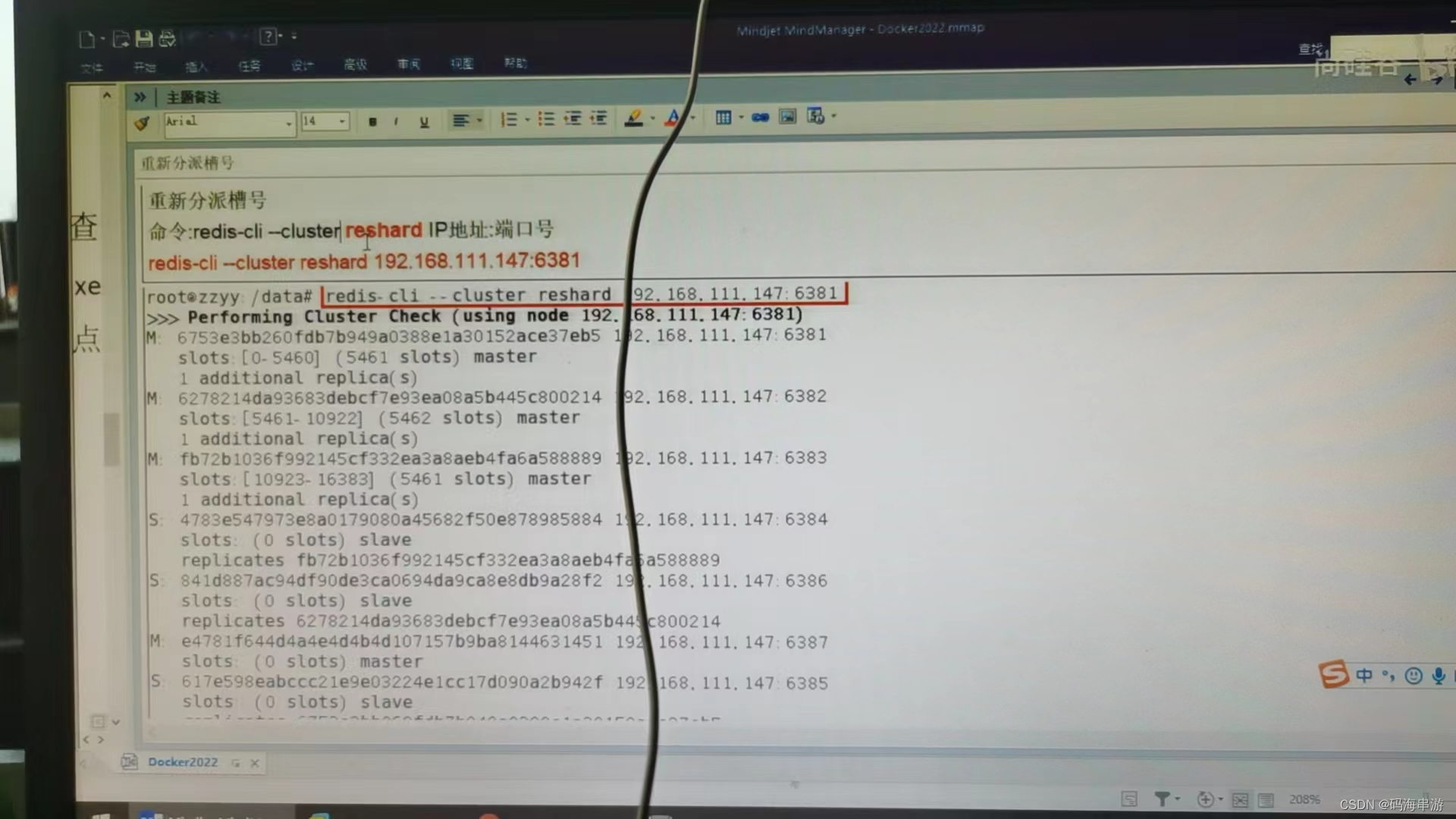

主从扩容案例

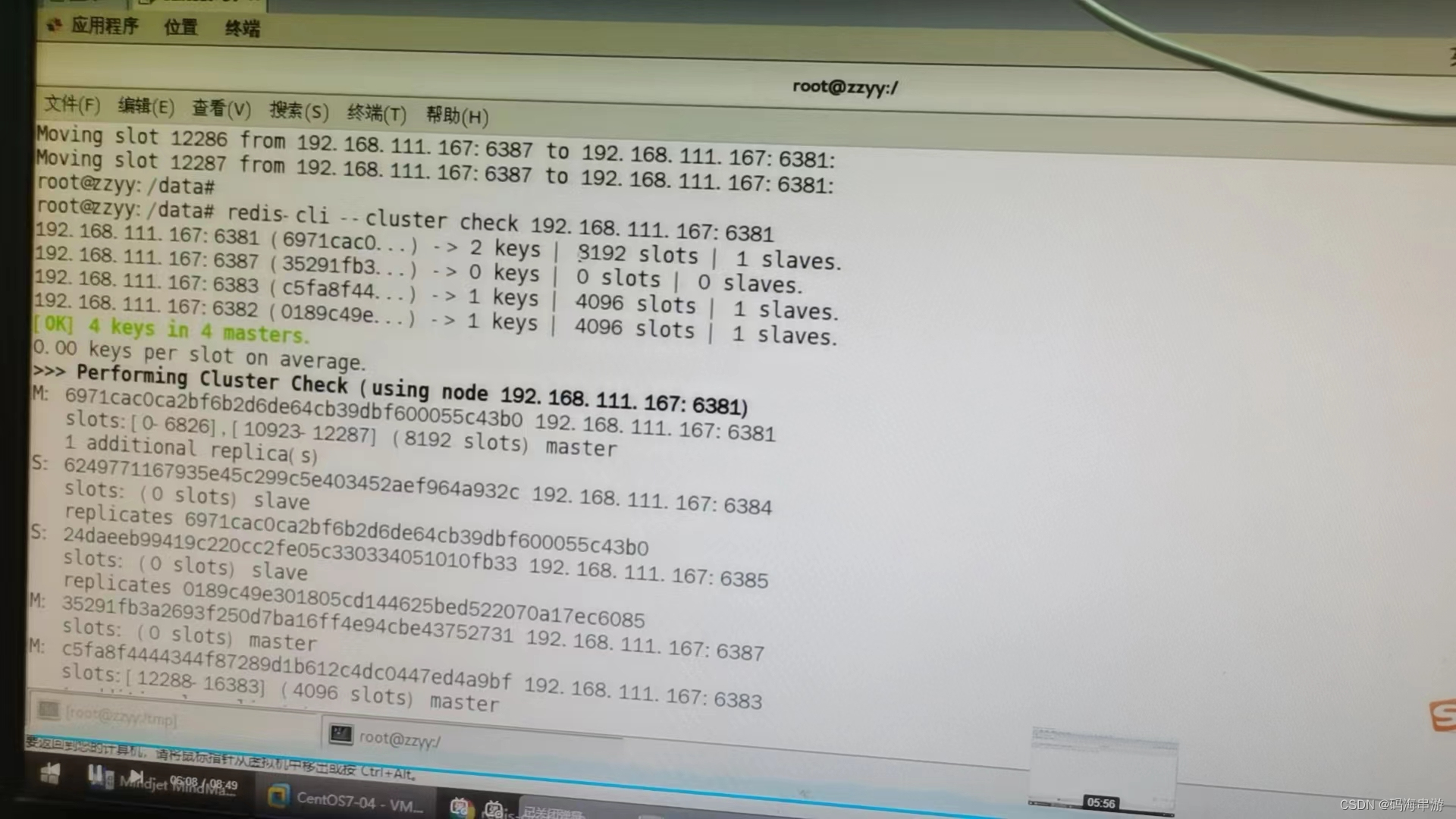

cluster nodes

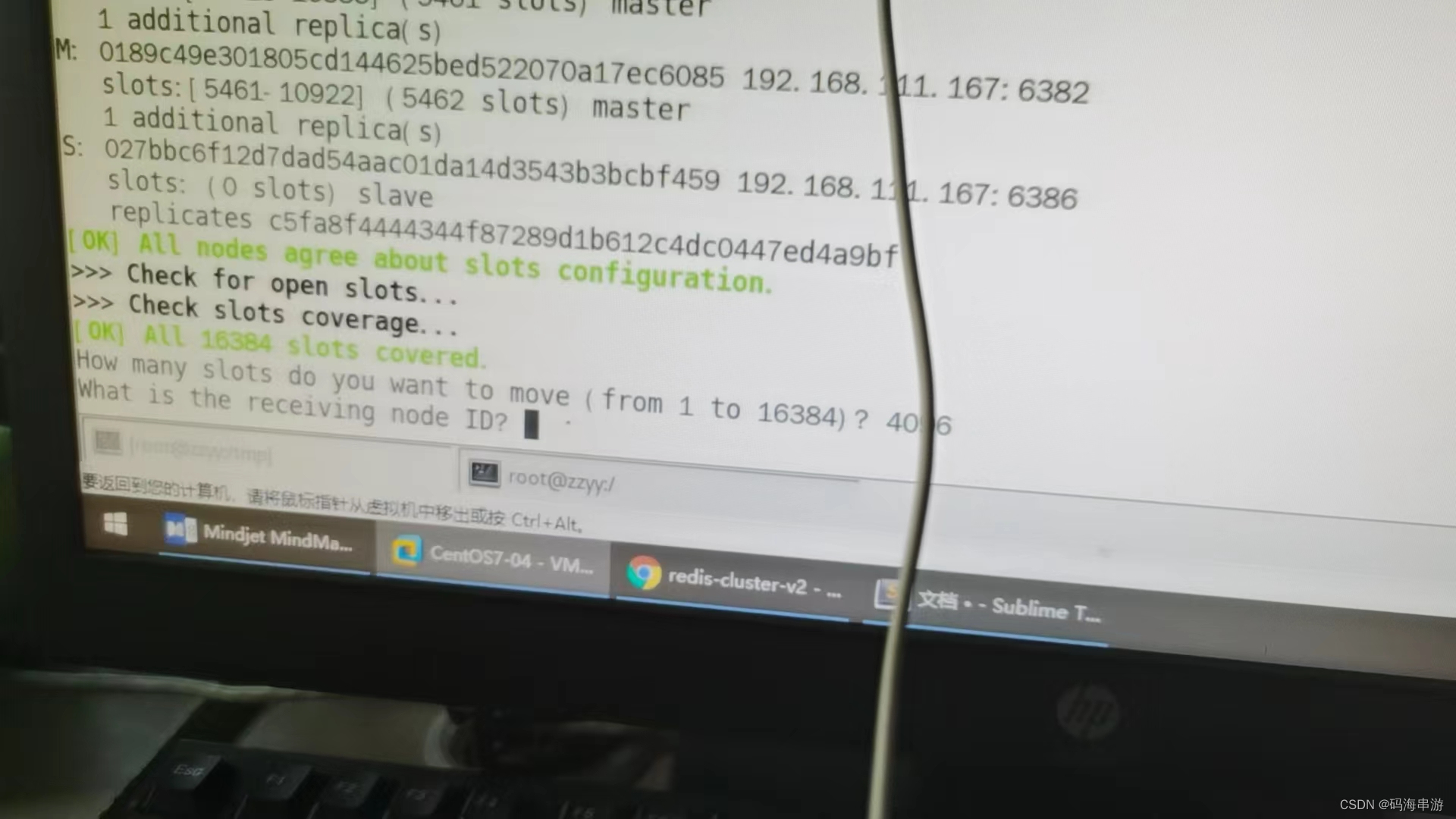

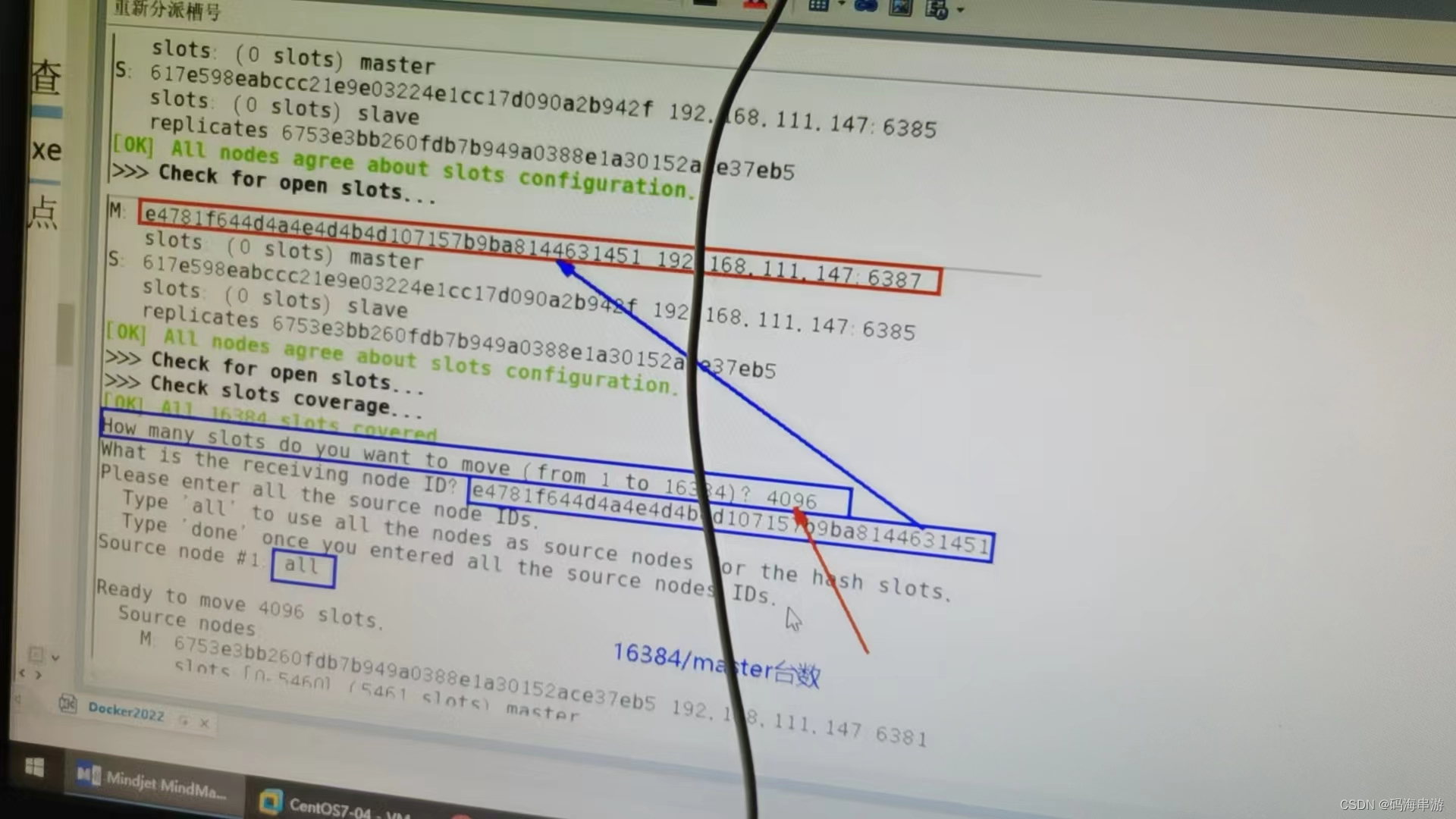

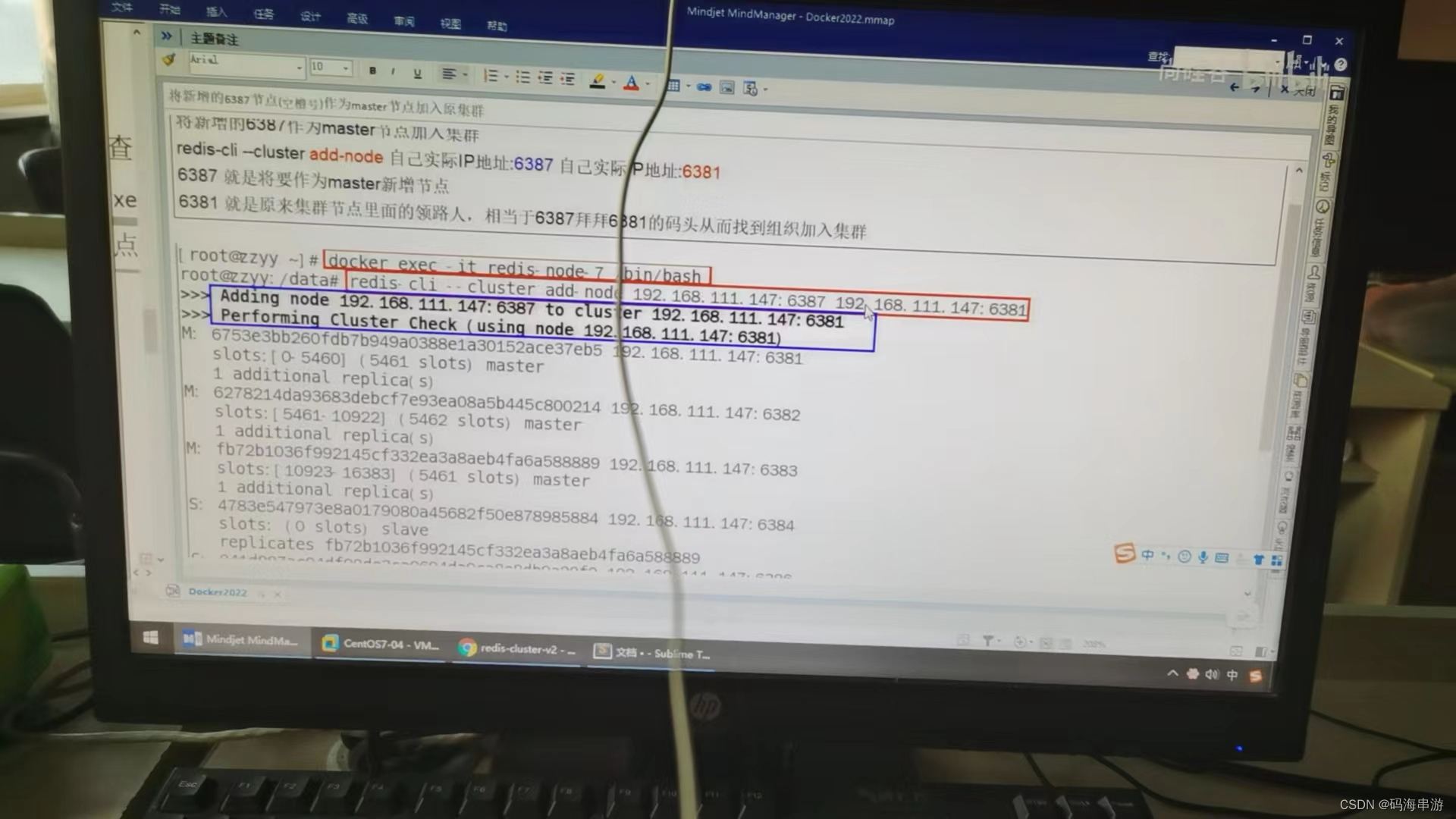

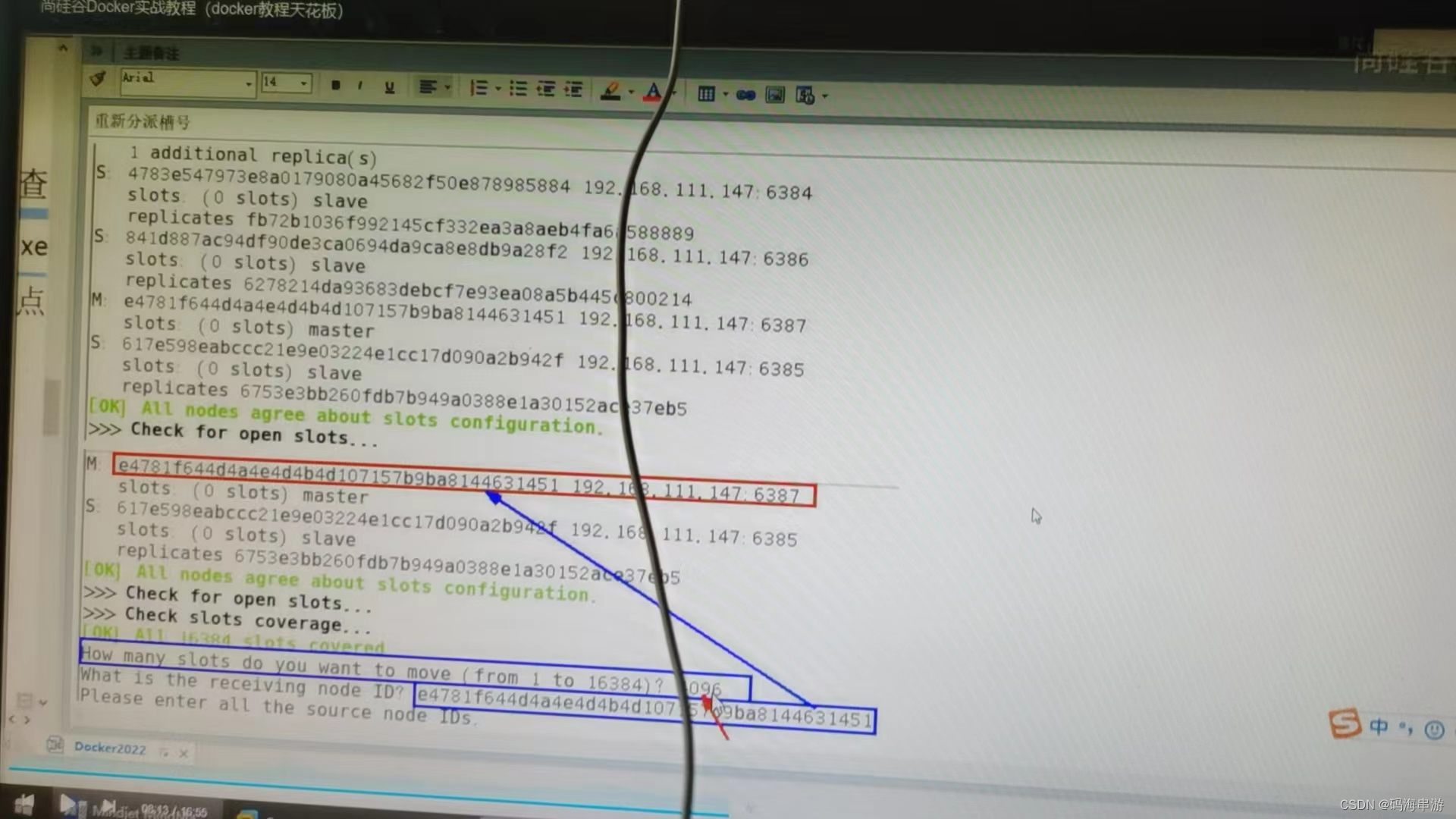

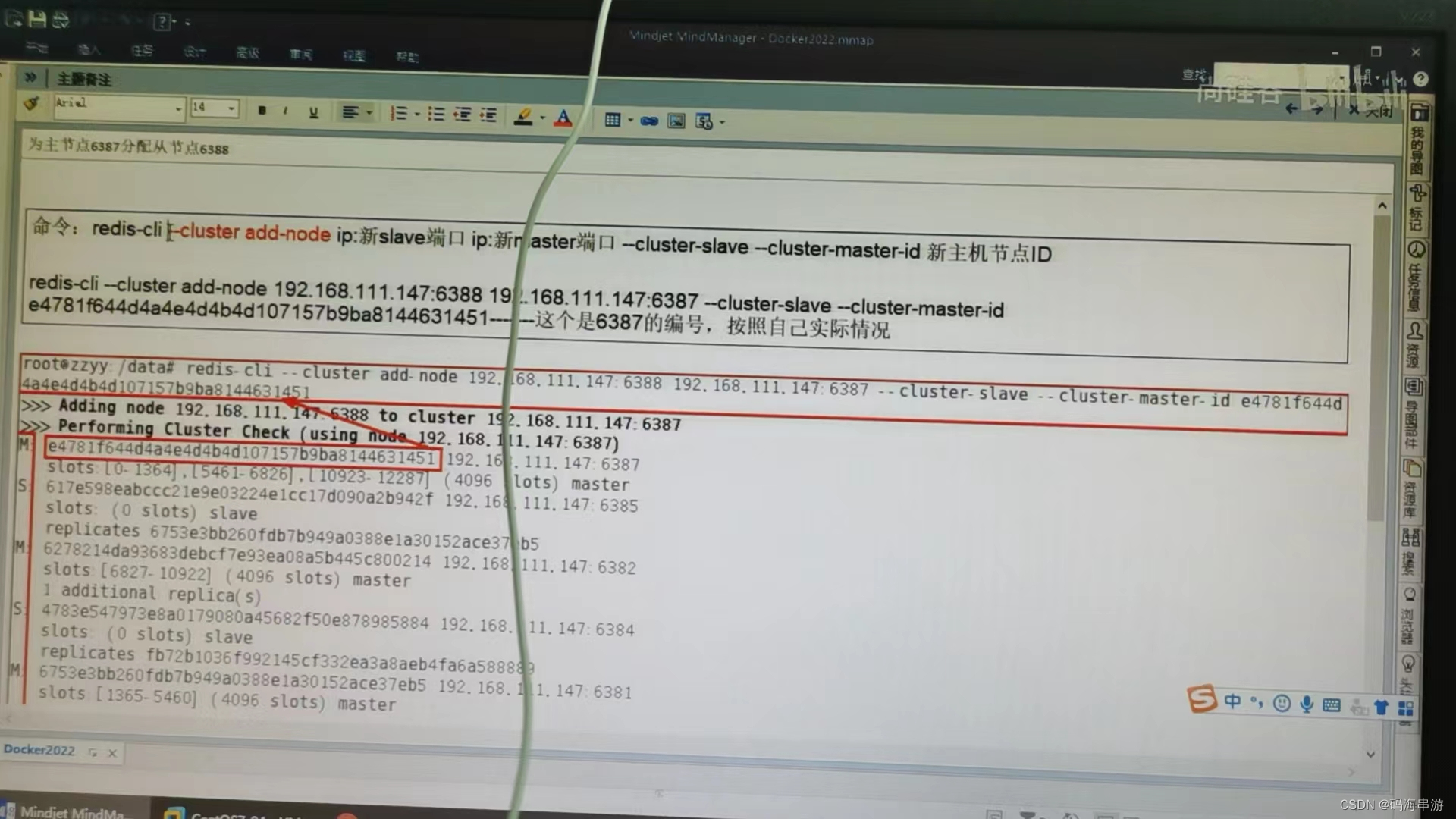

1,新增机器,槽位分配

docker ps

docker run -d --nmae redis-node-7 --net host --privileged=true -v /data/redis/share-node-7:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6387

docker ps

每一个分了点槽号给第四个

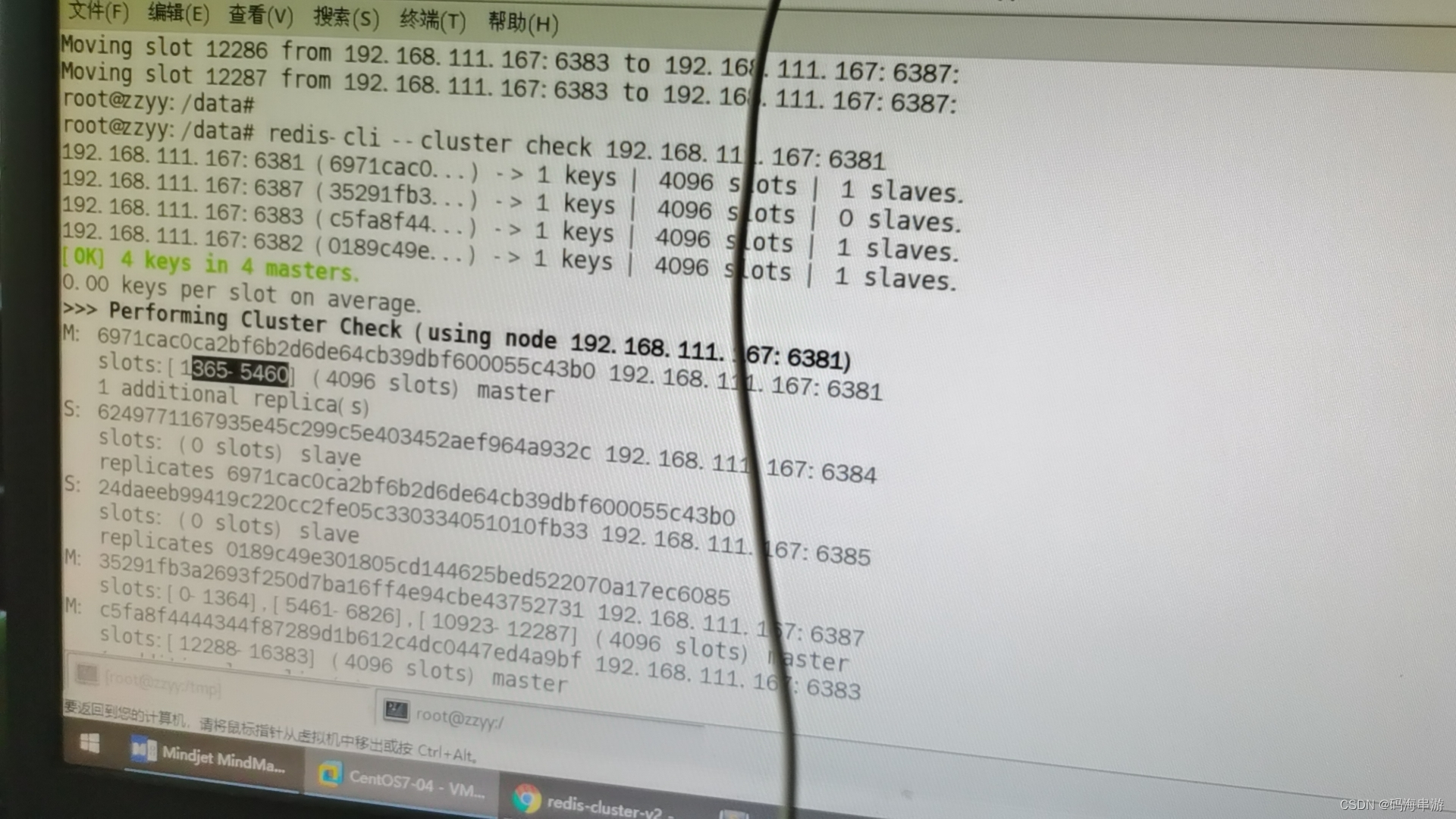

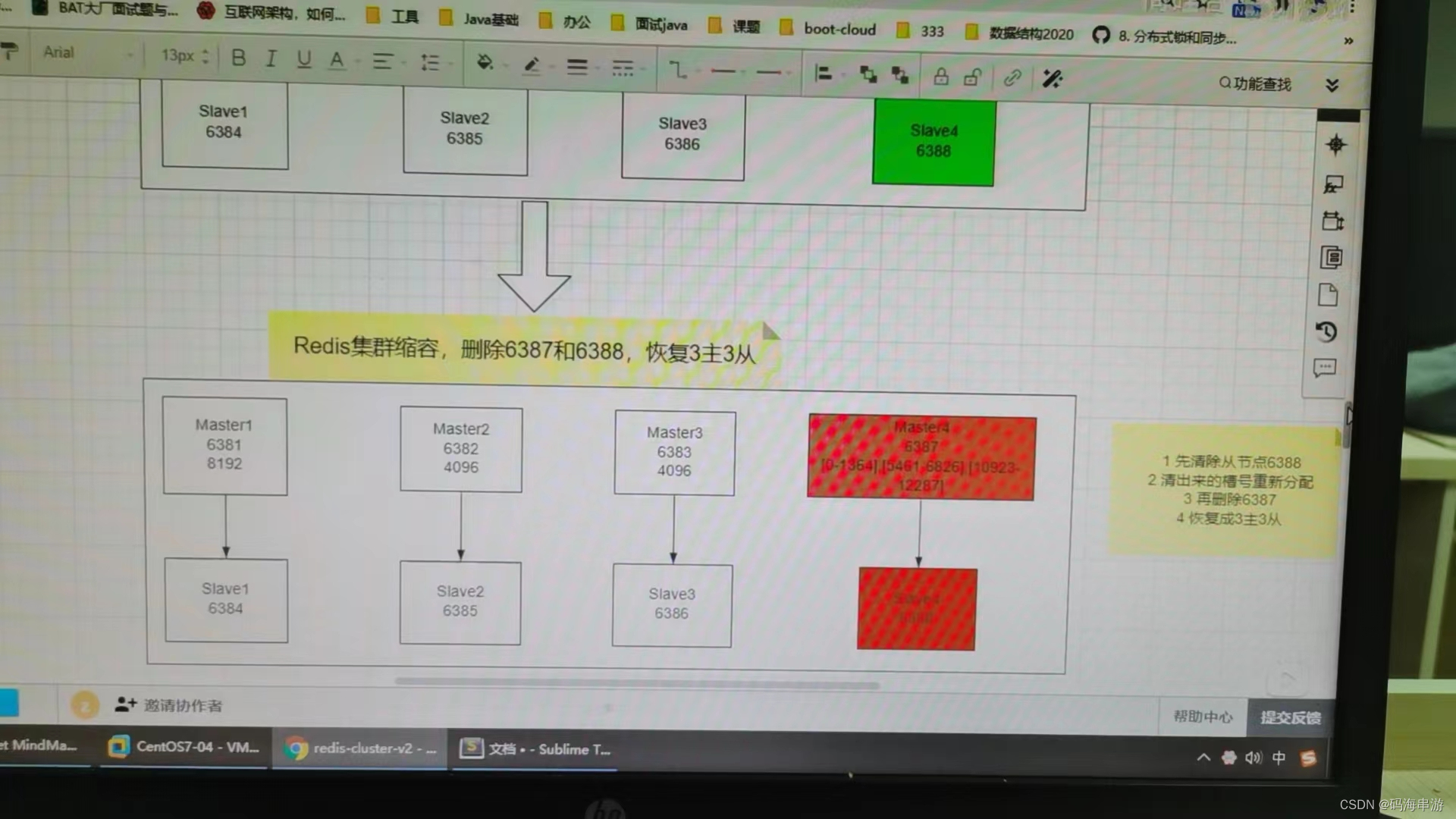

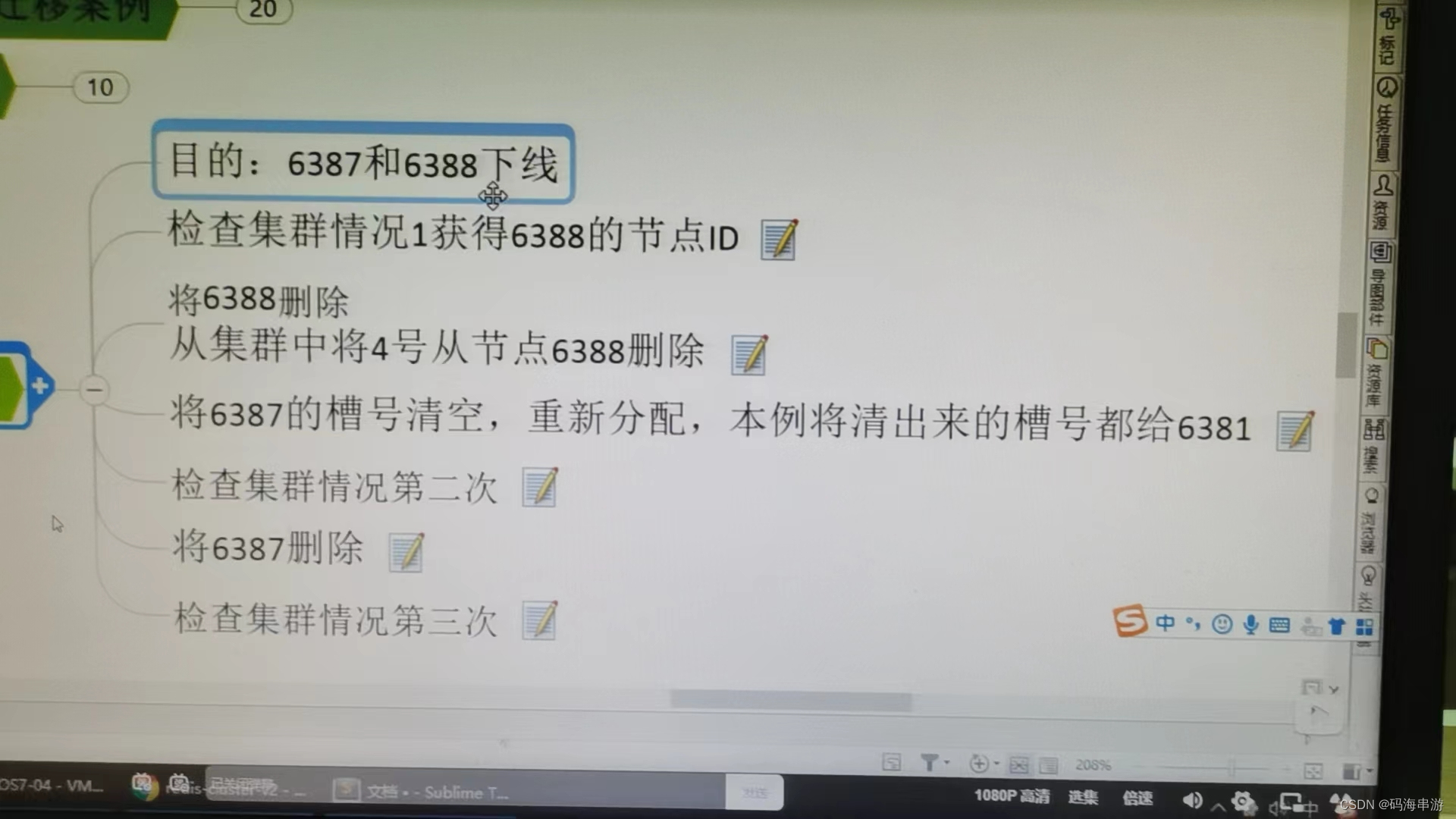

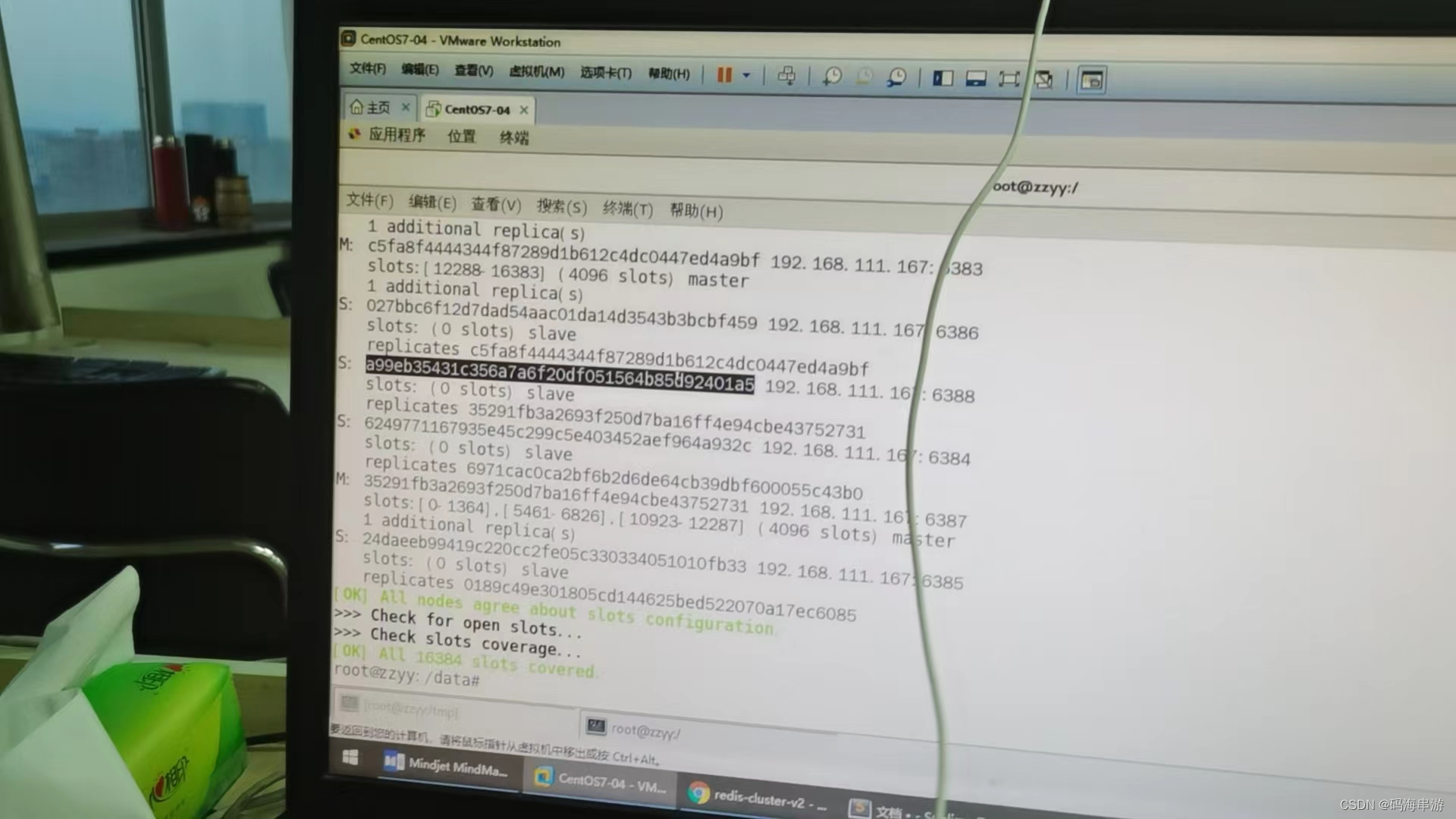

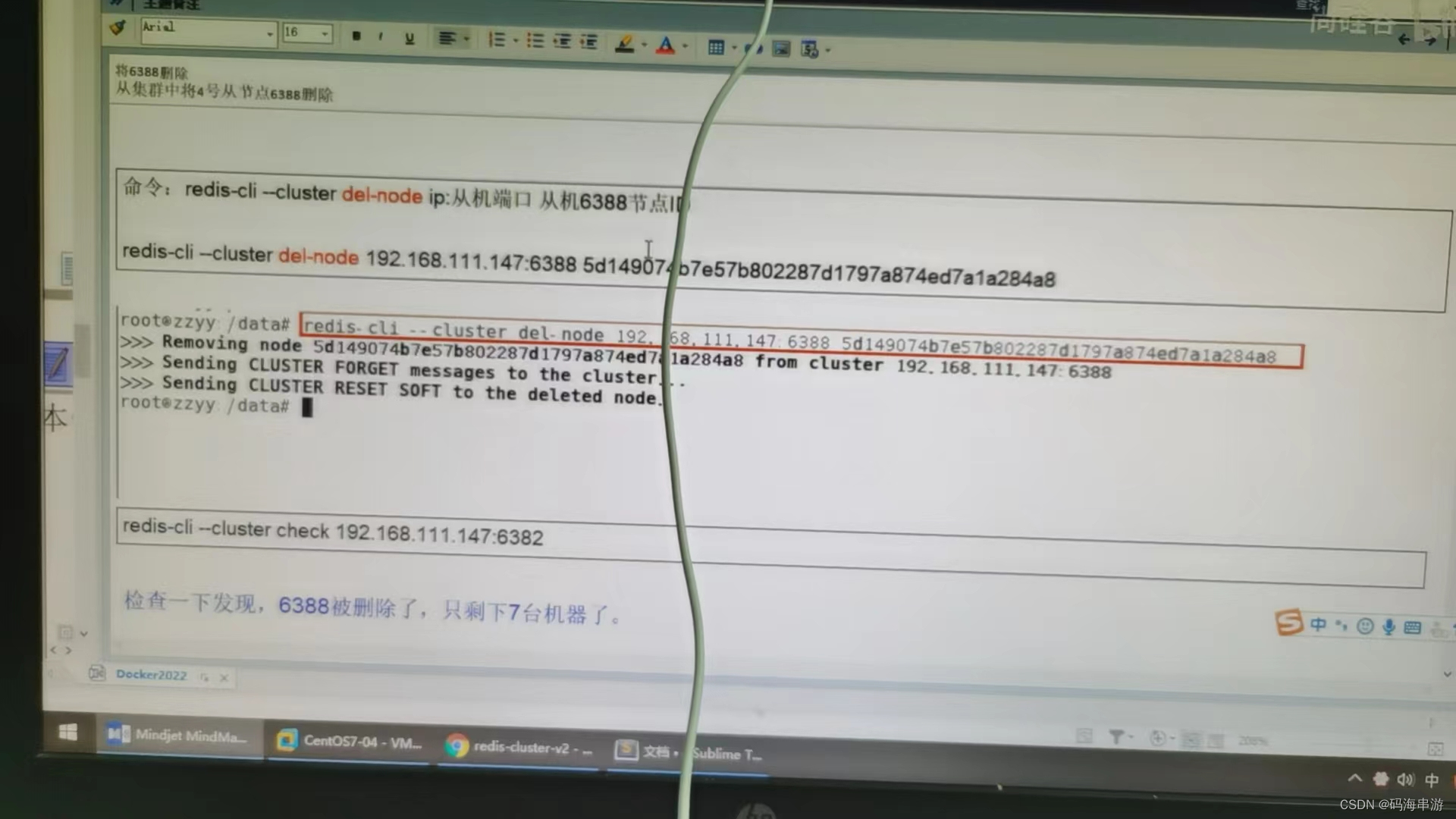

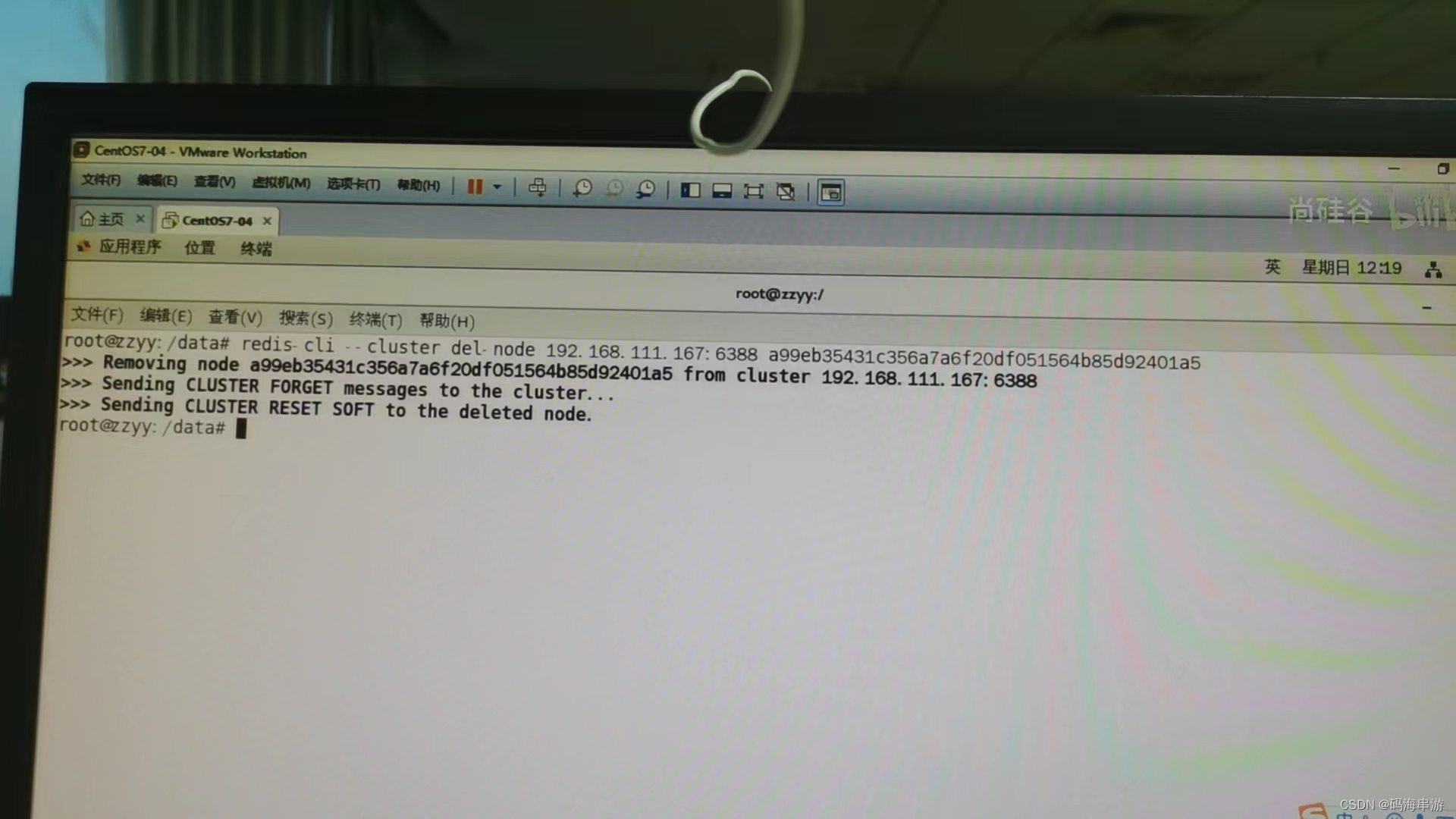

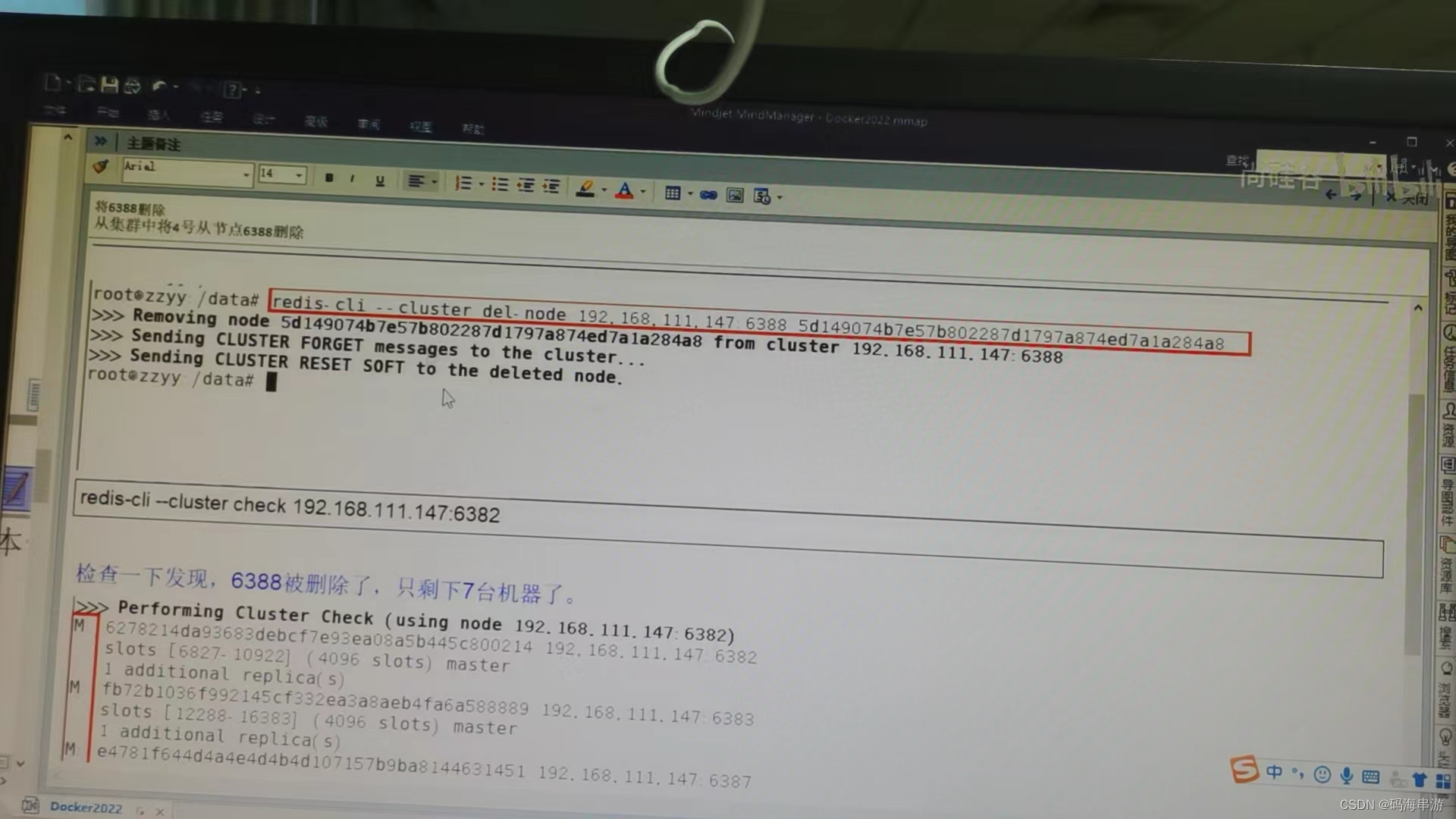

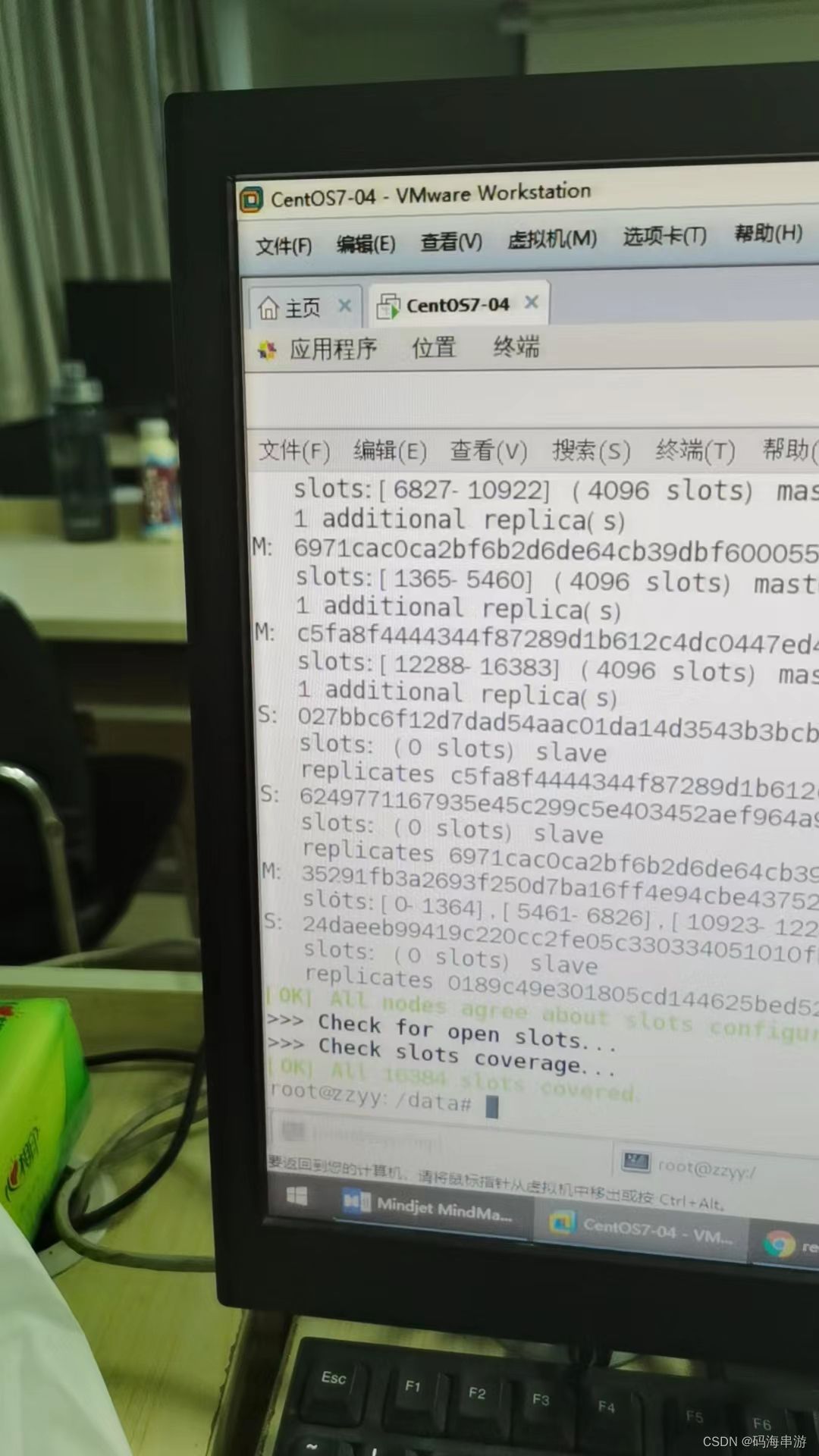

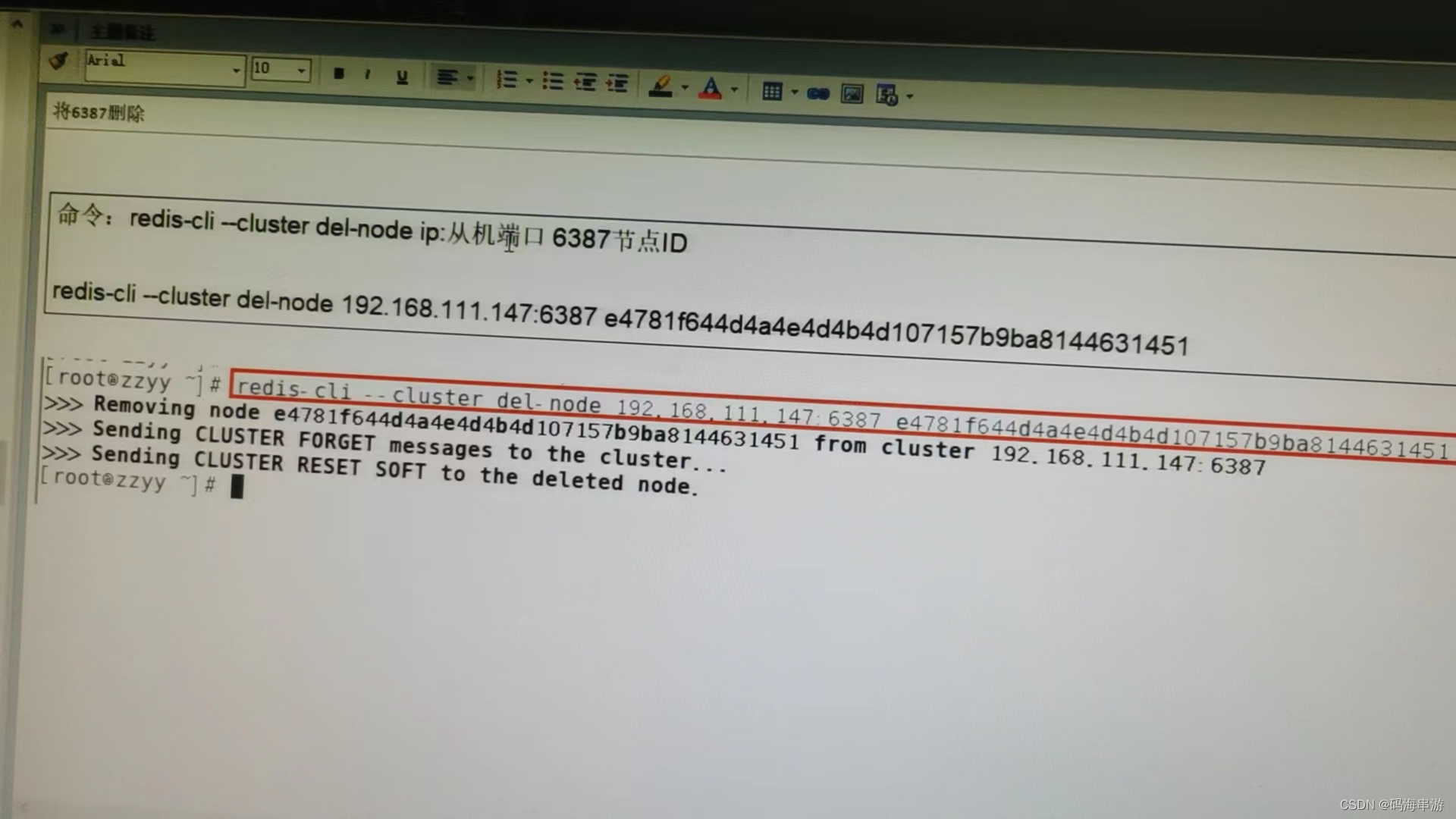

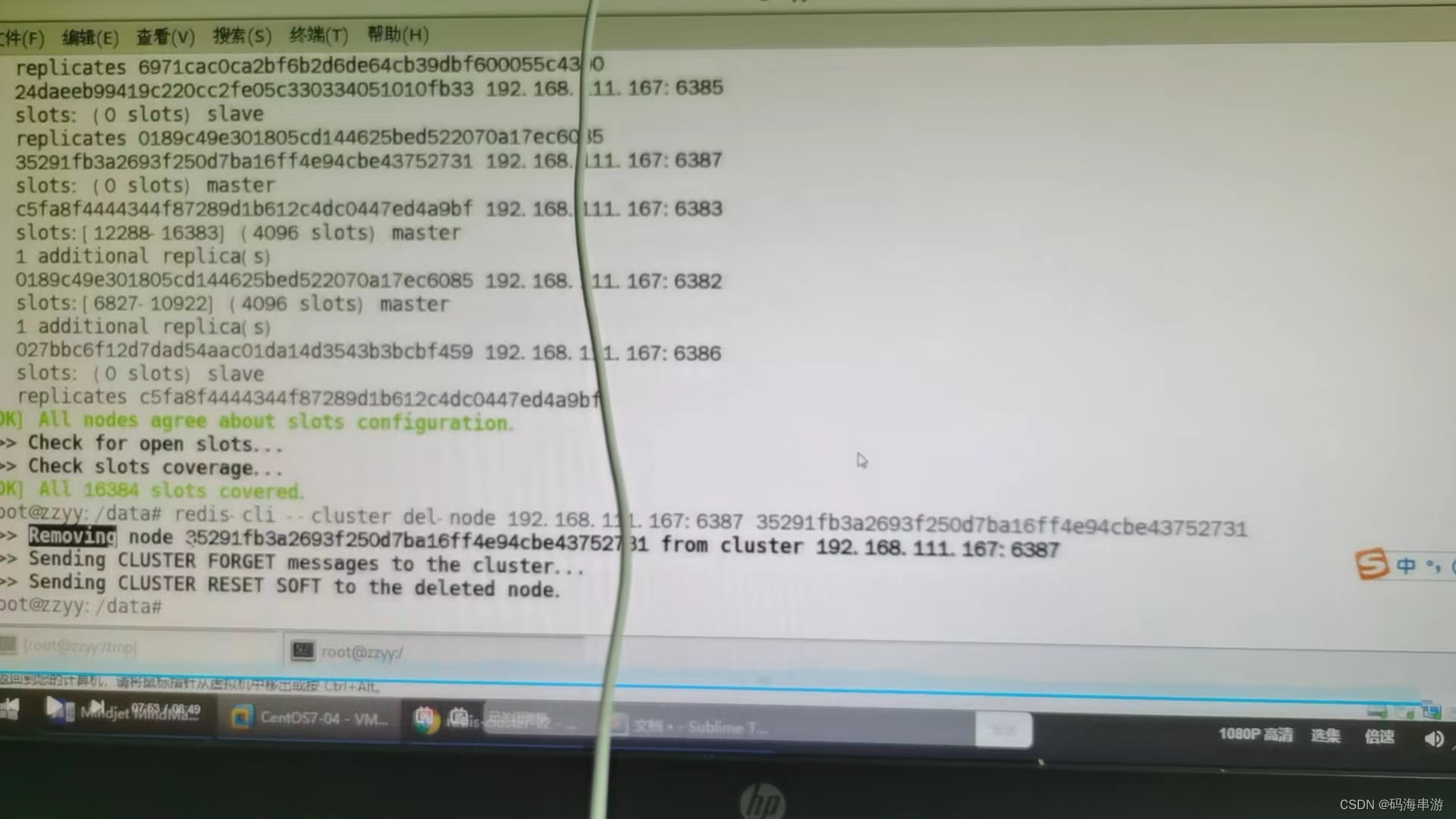

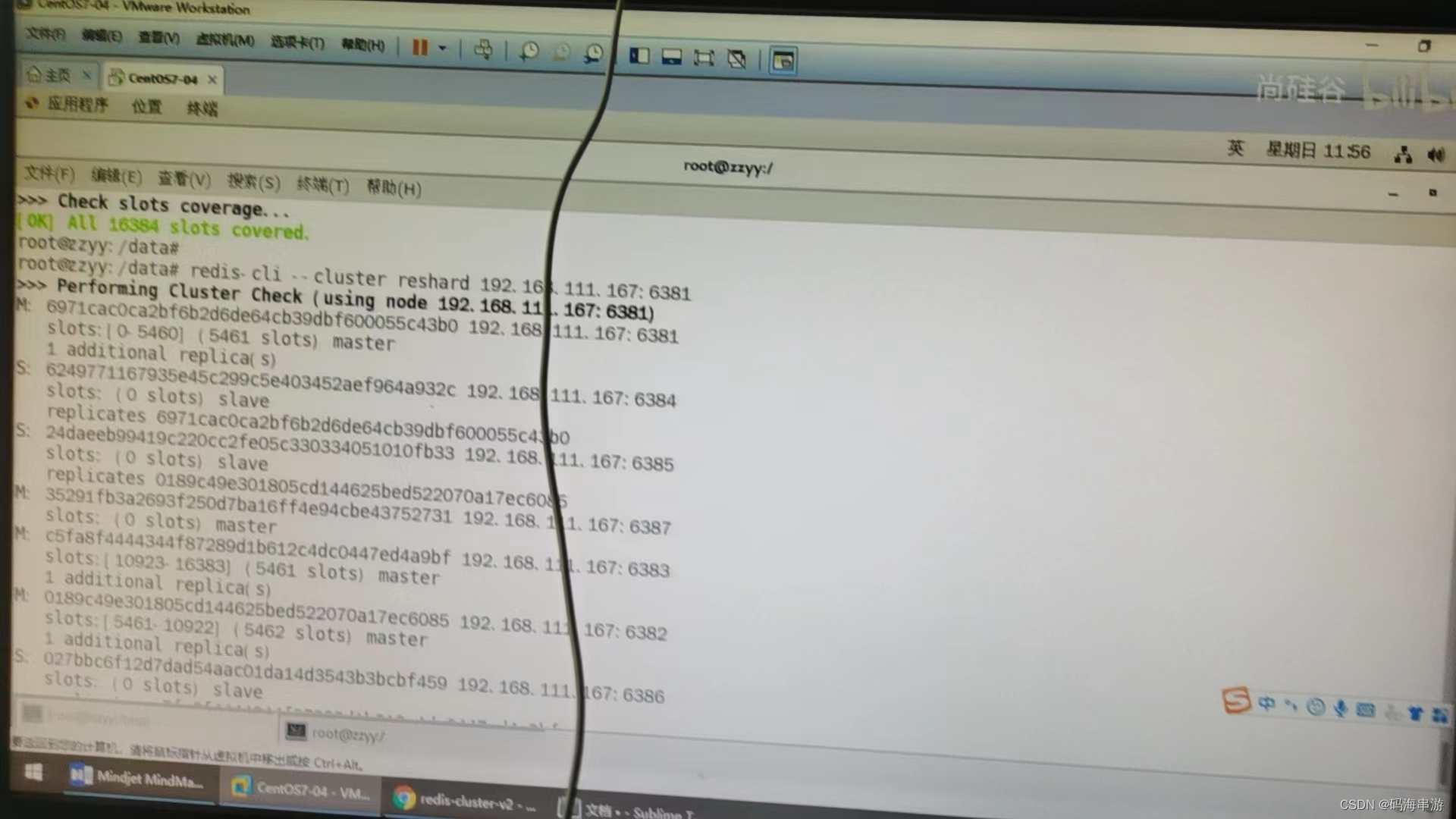

主从缩容案例

去掉从机,主机槽位分给别人

删除主机

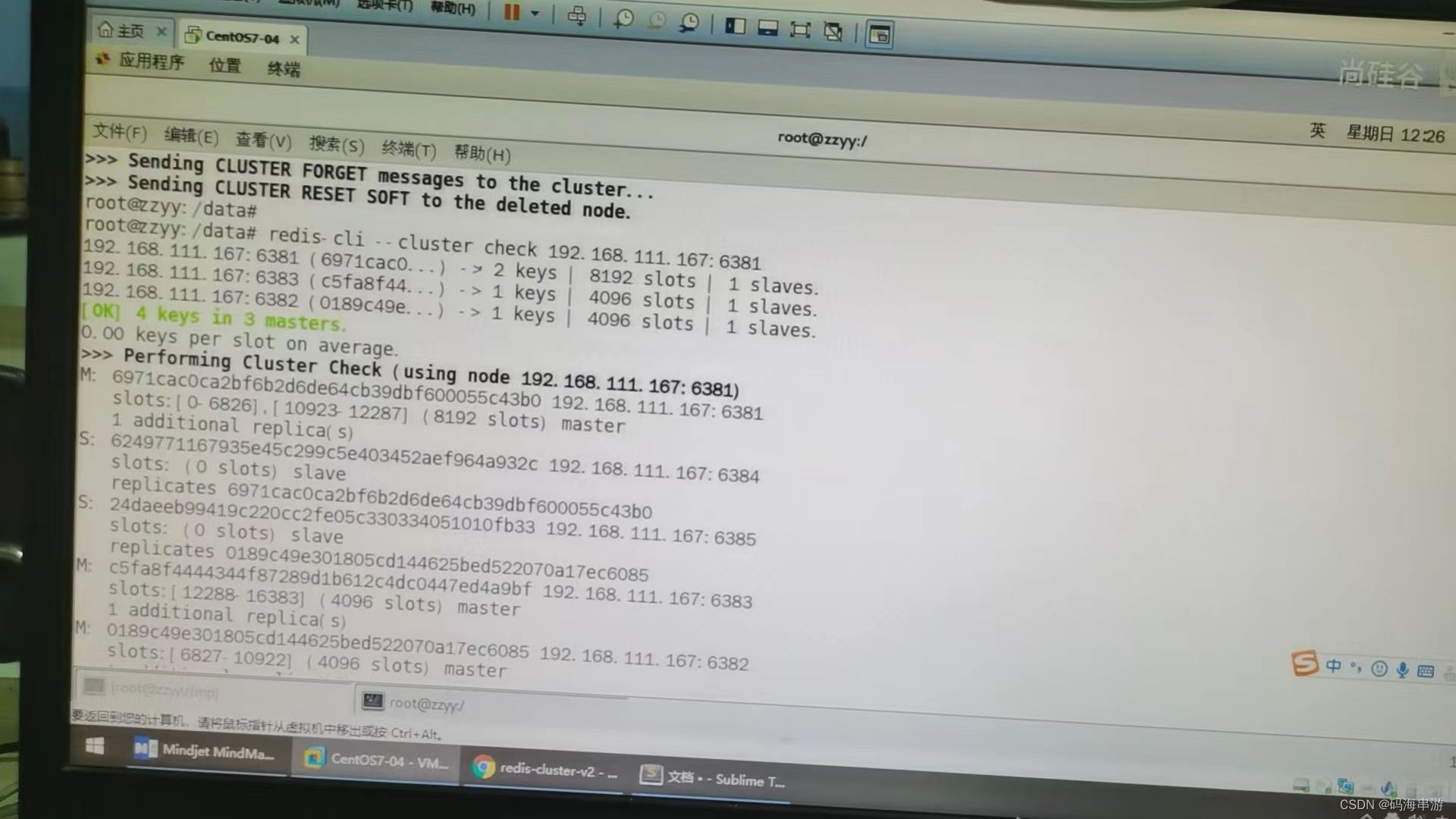

检查3主3从

多一份实力,生活就少一分恶意

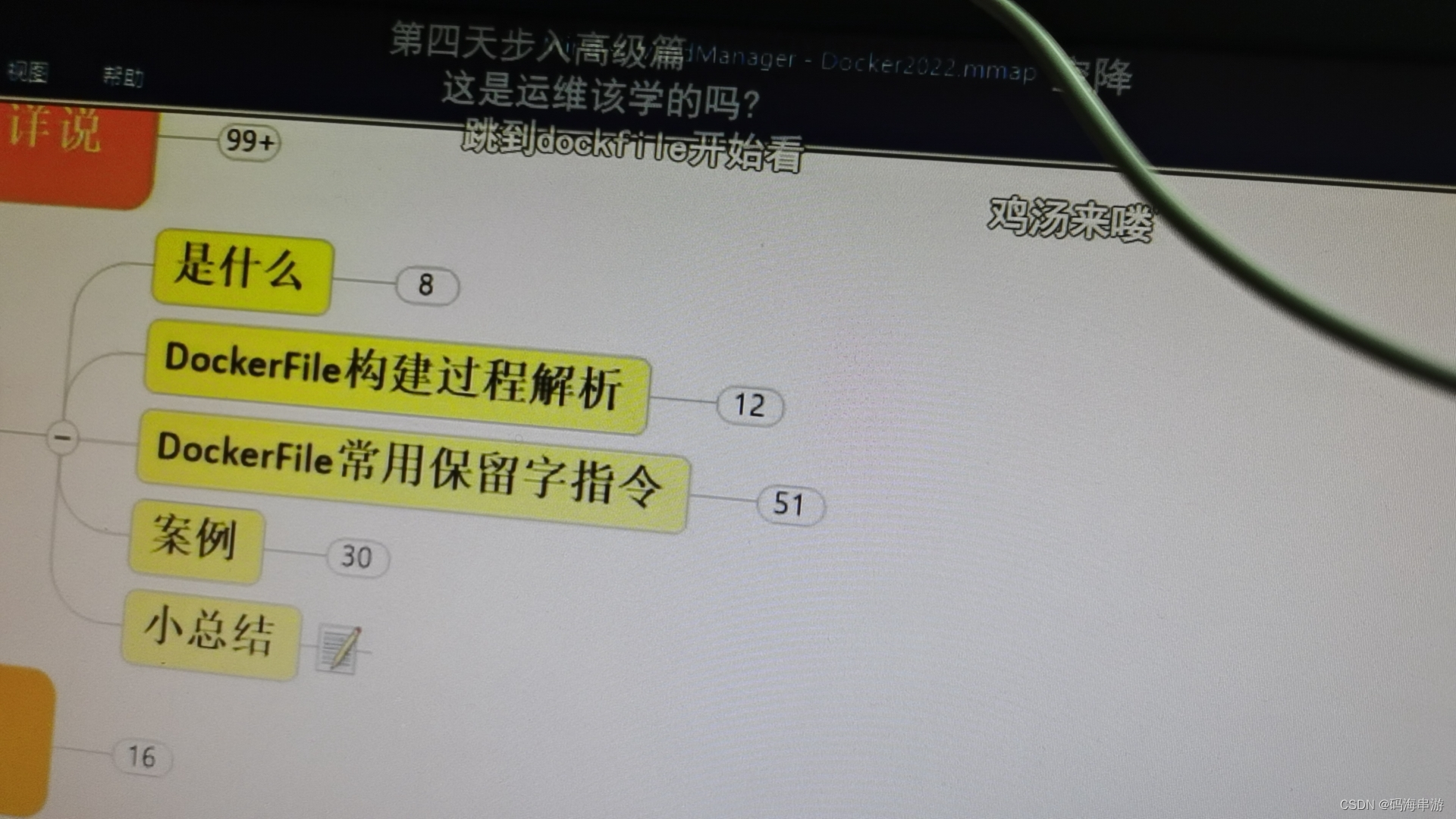

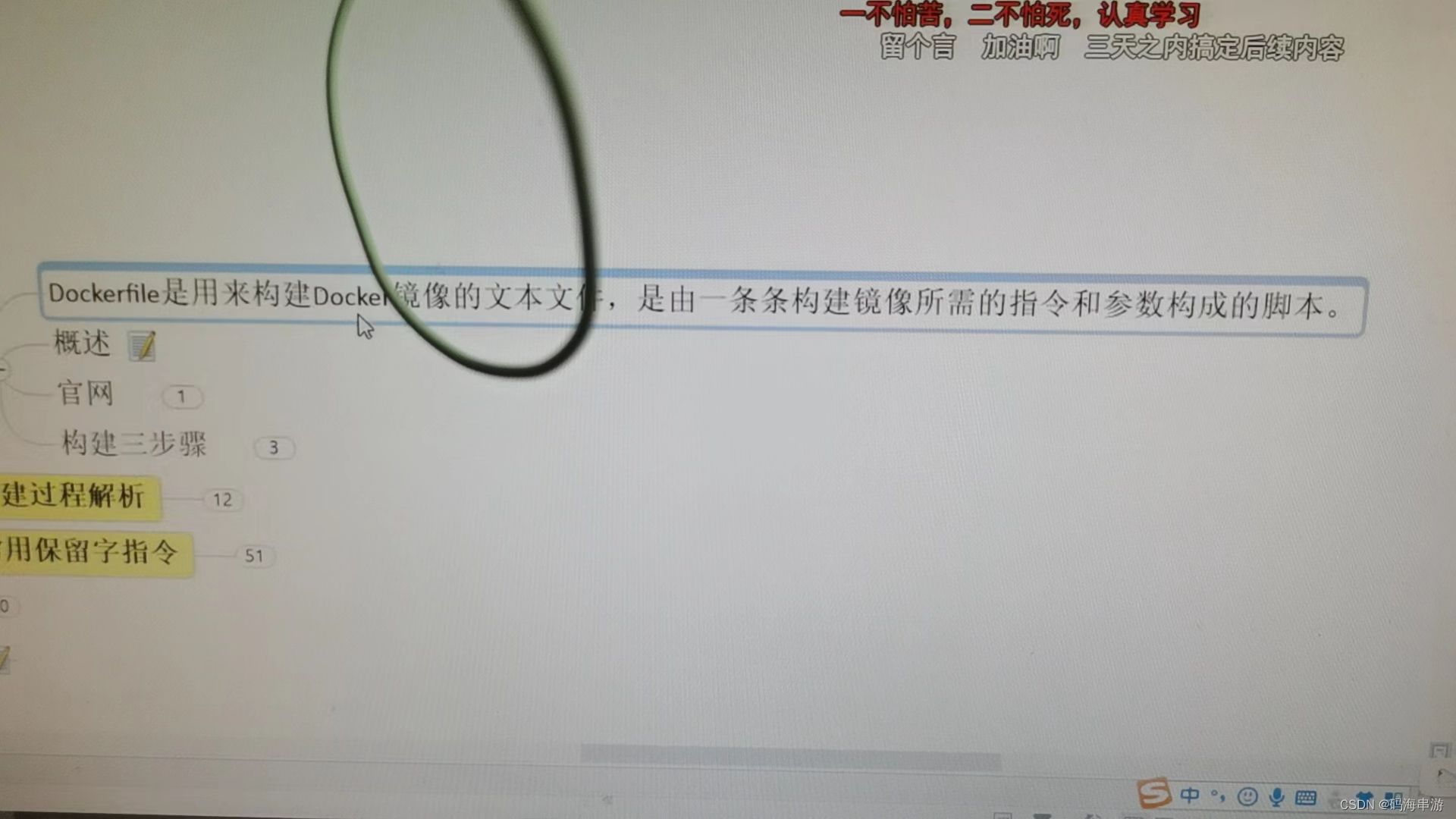

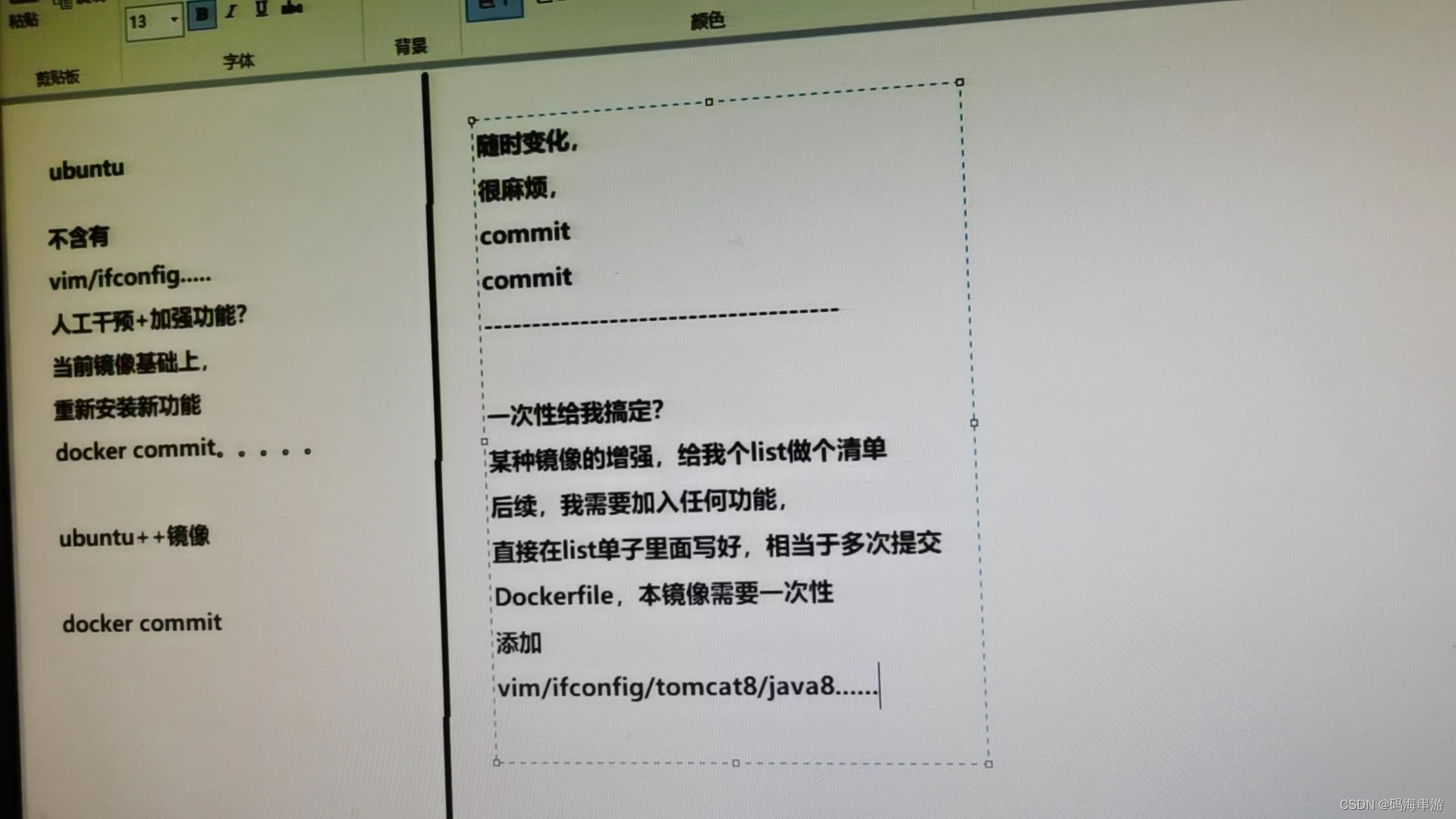

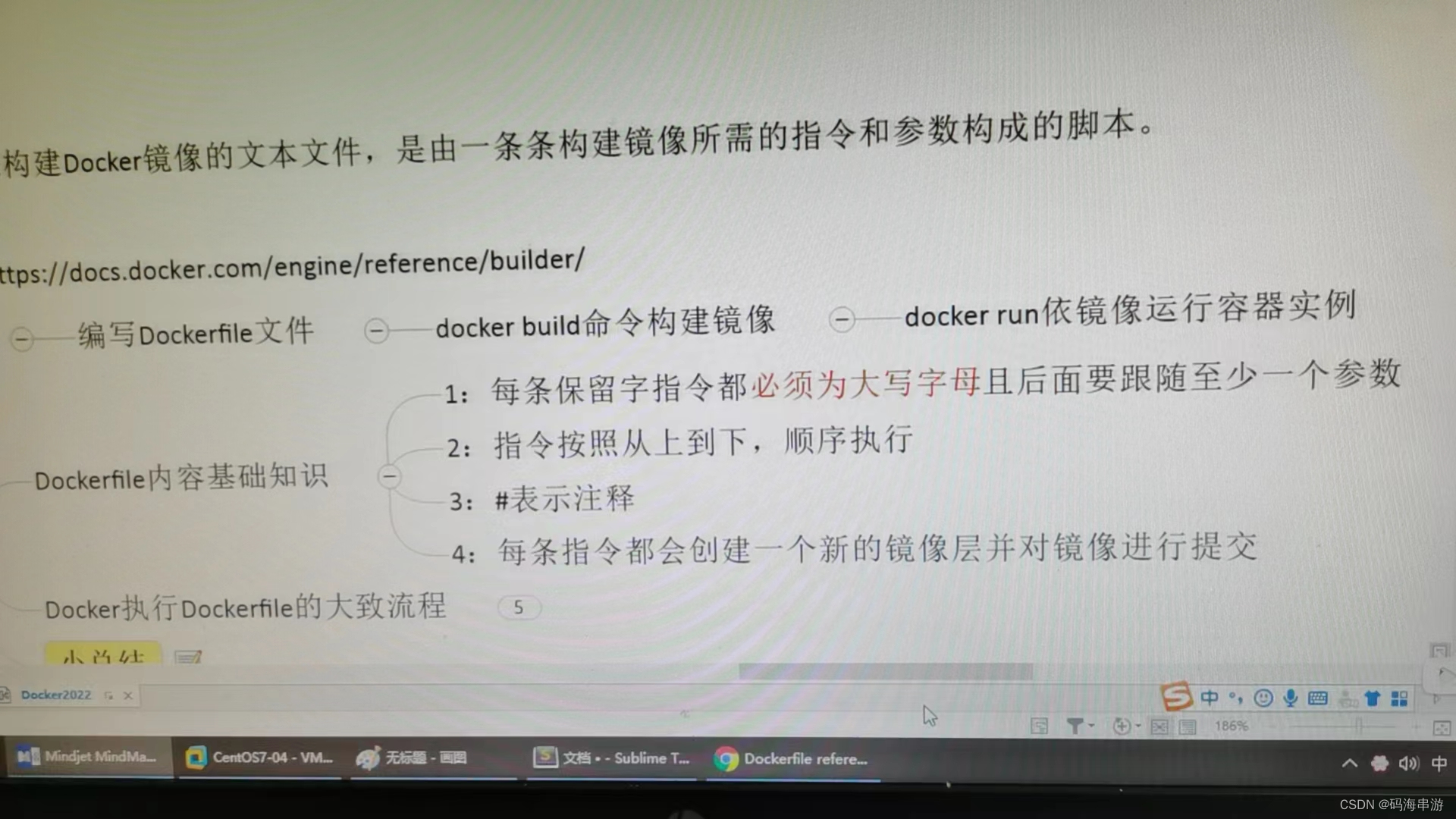

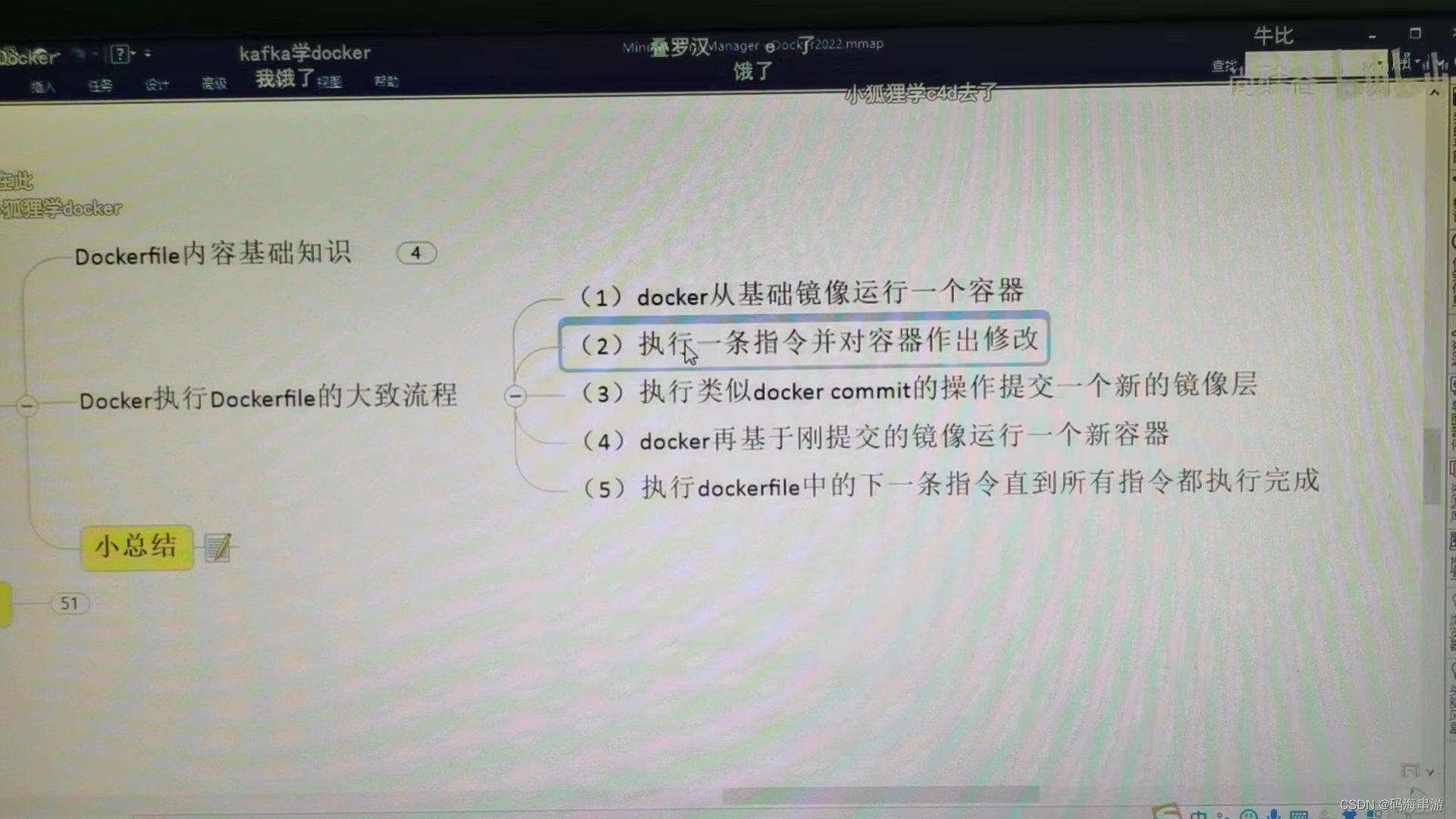

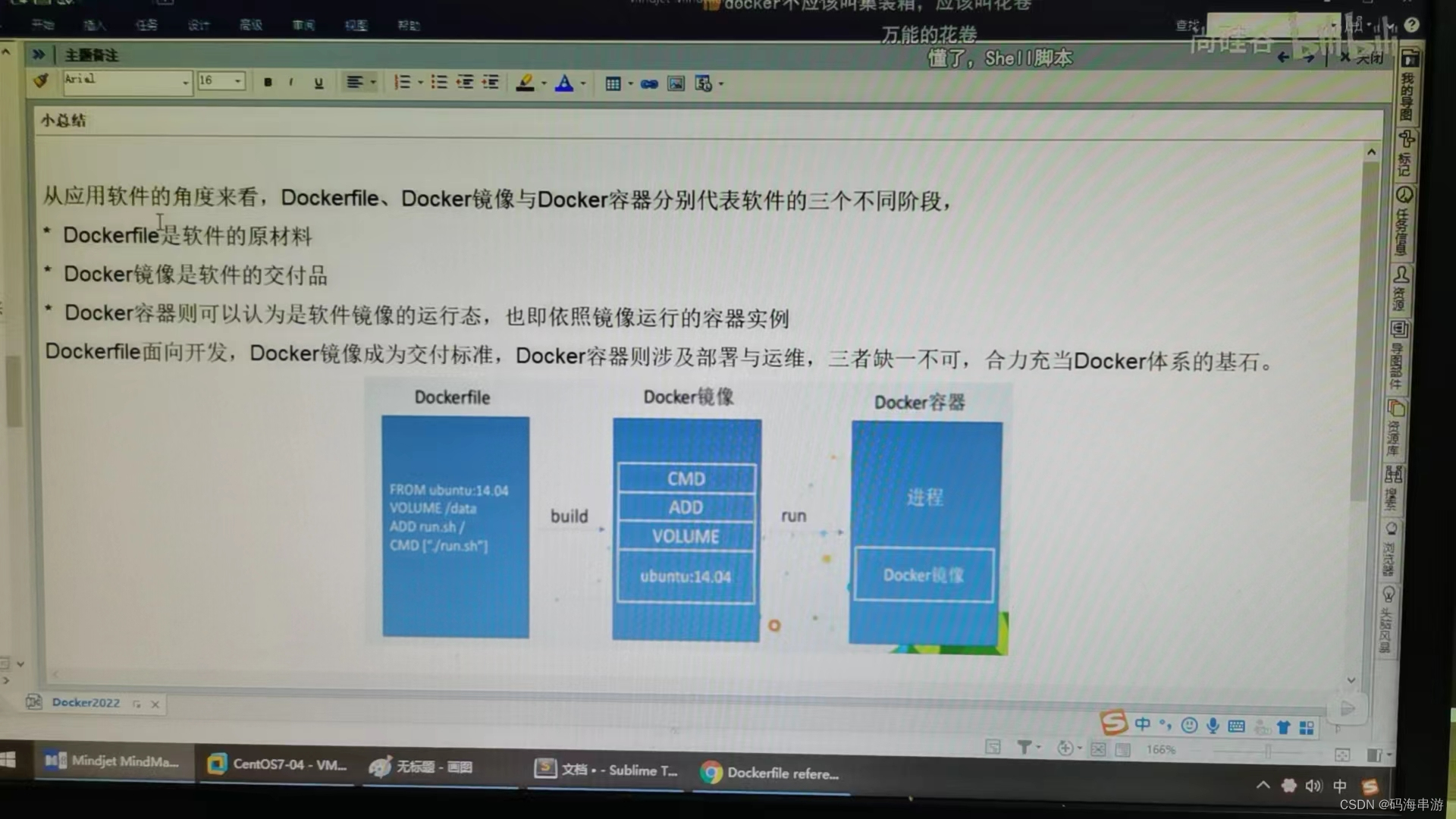

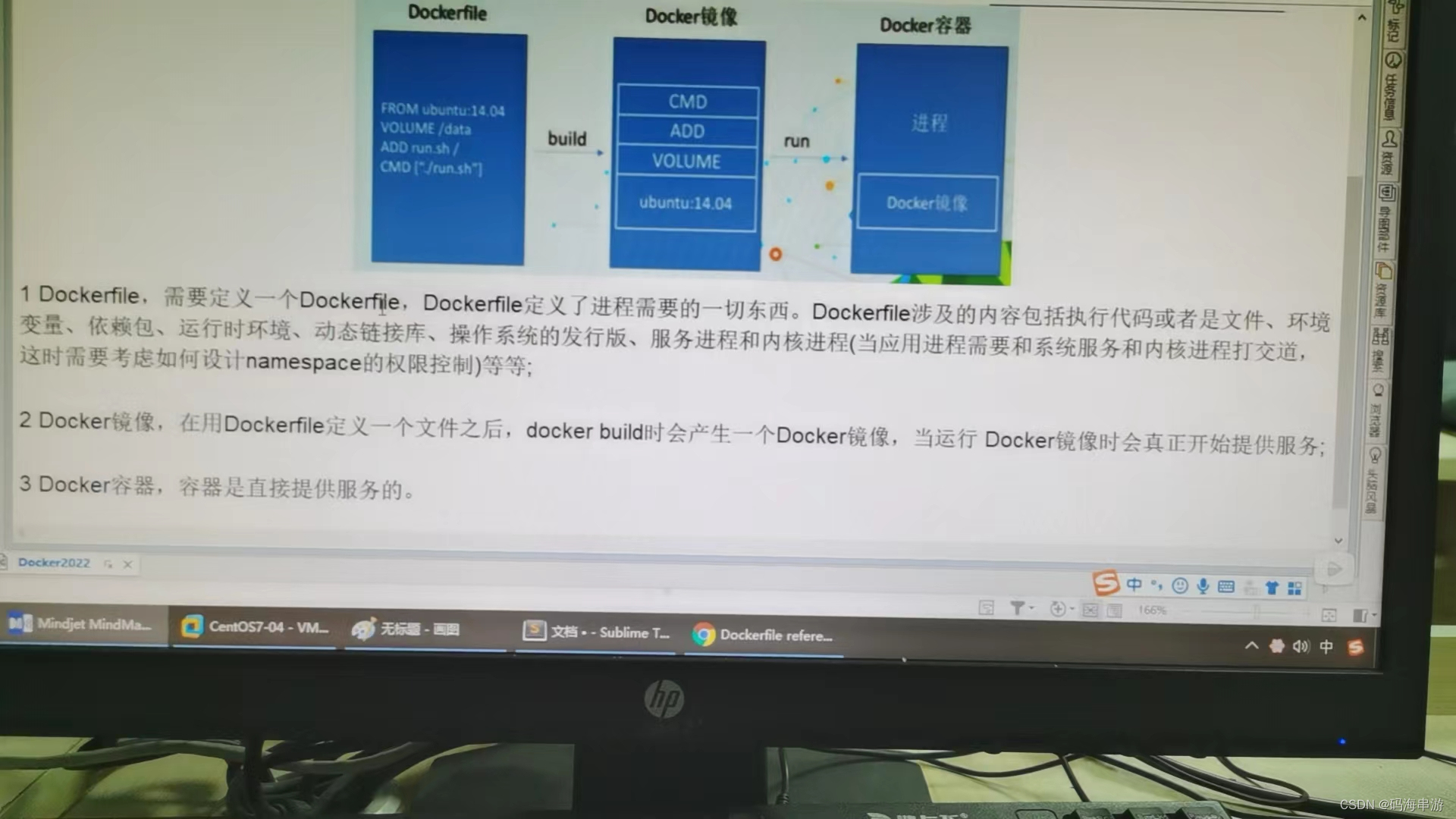

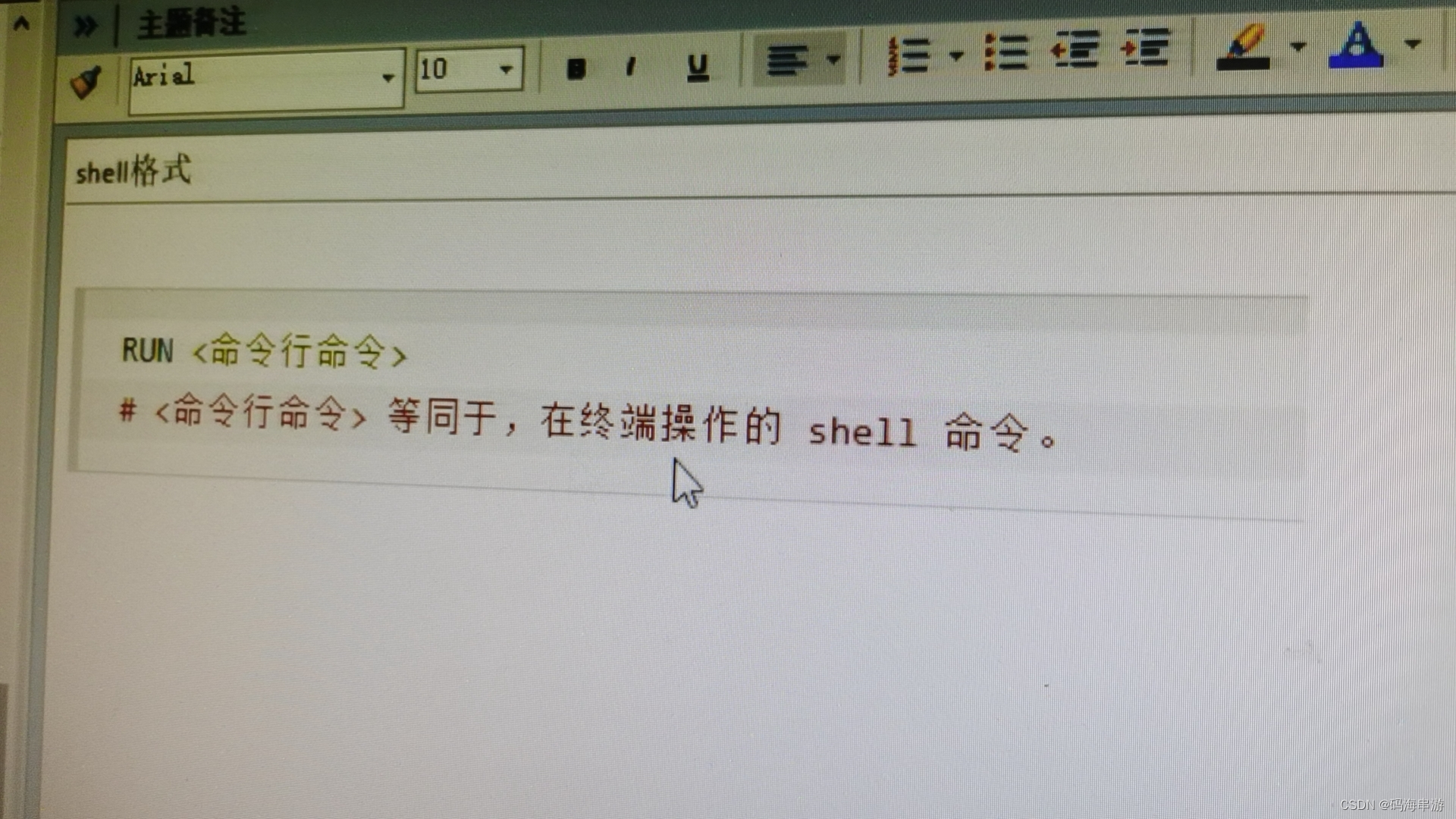

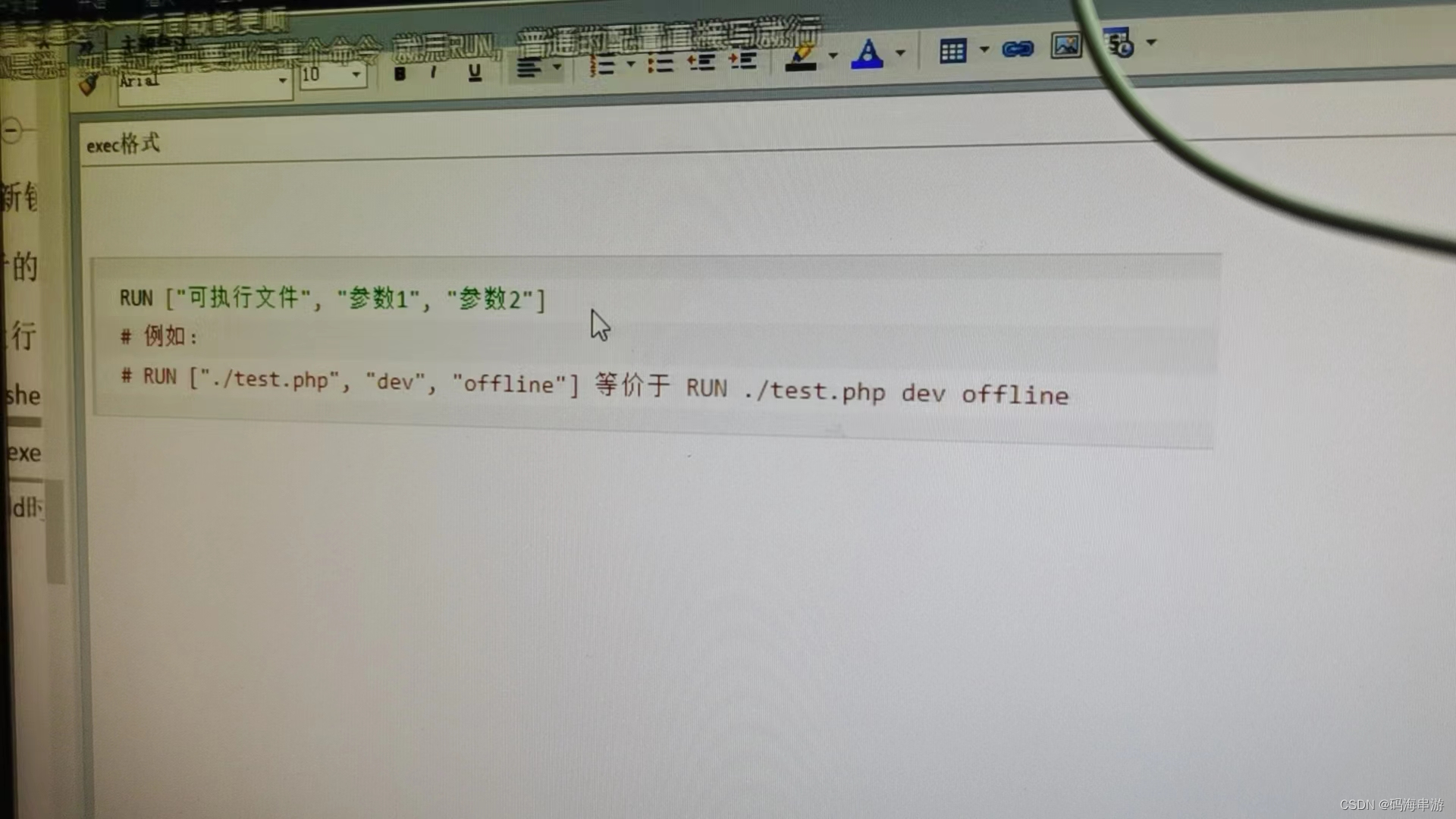

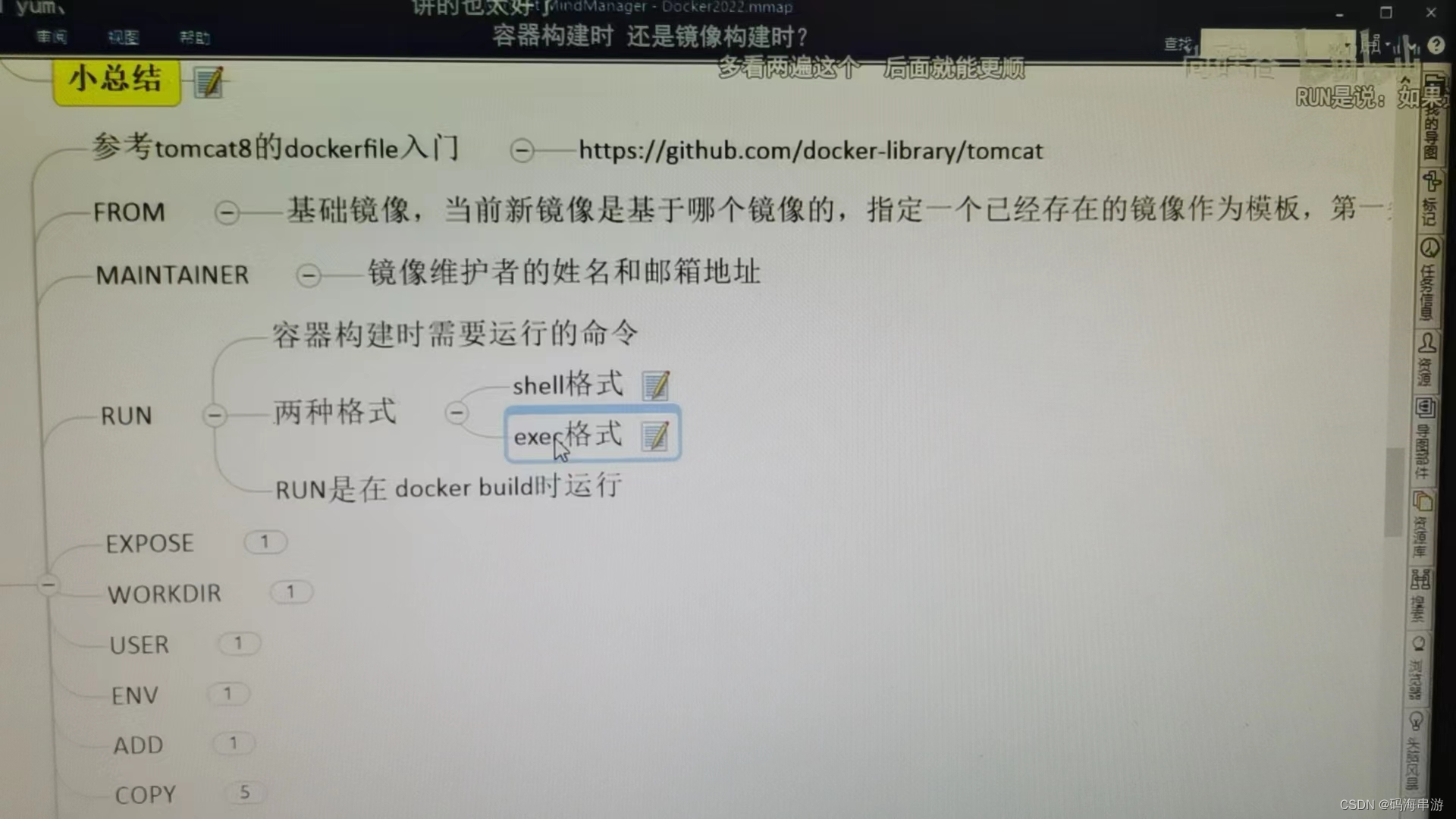

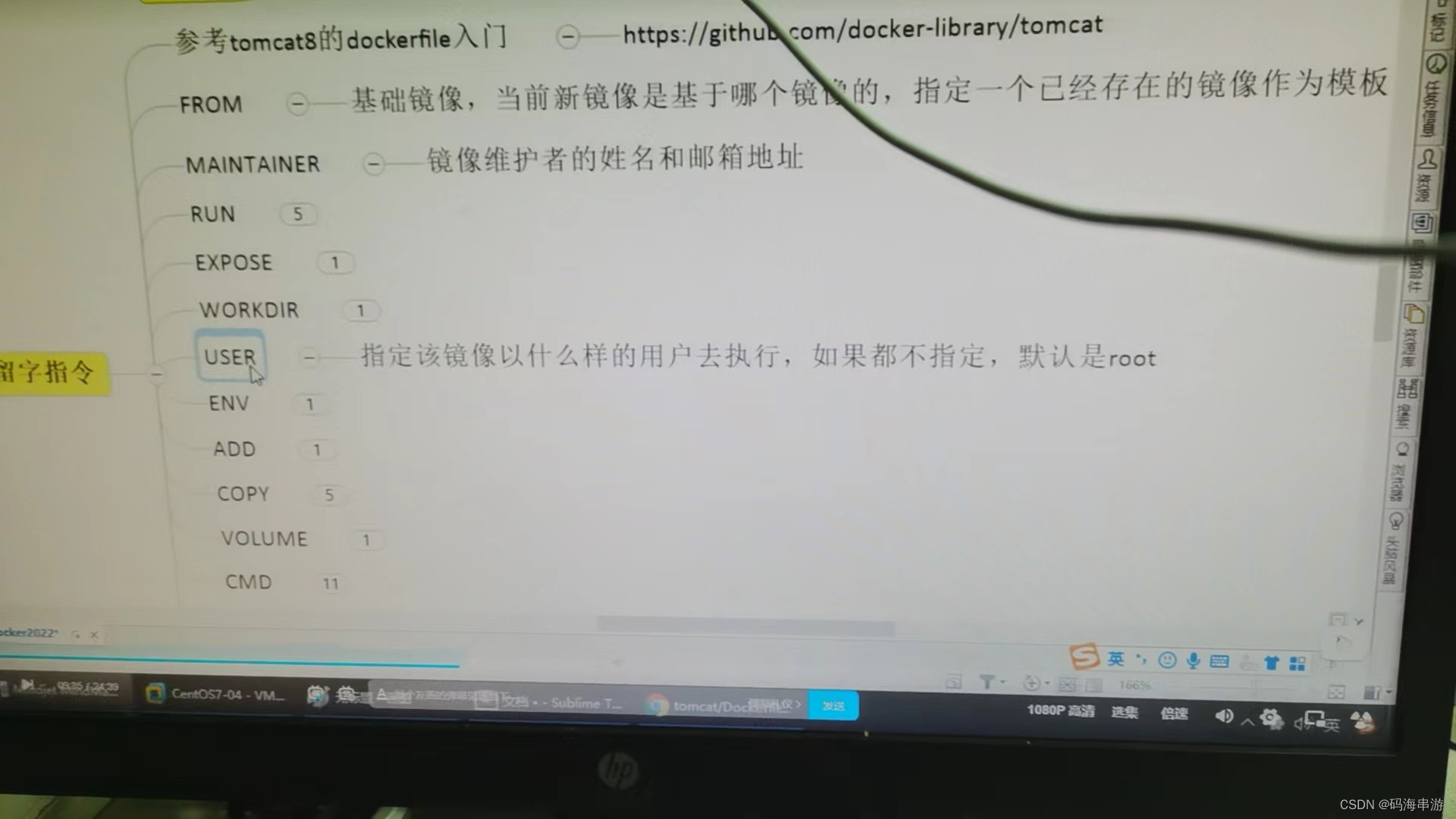

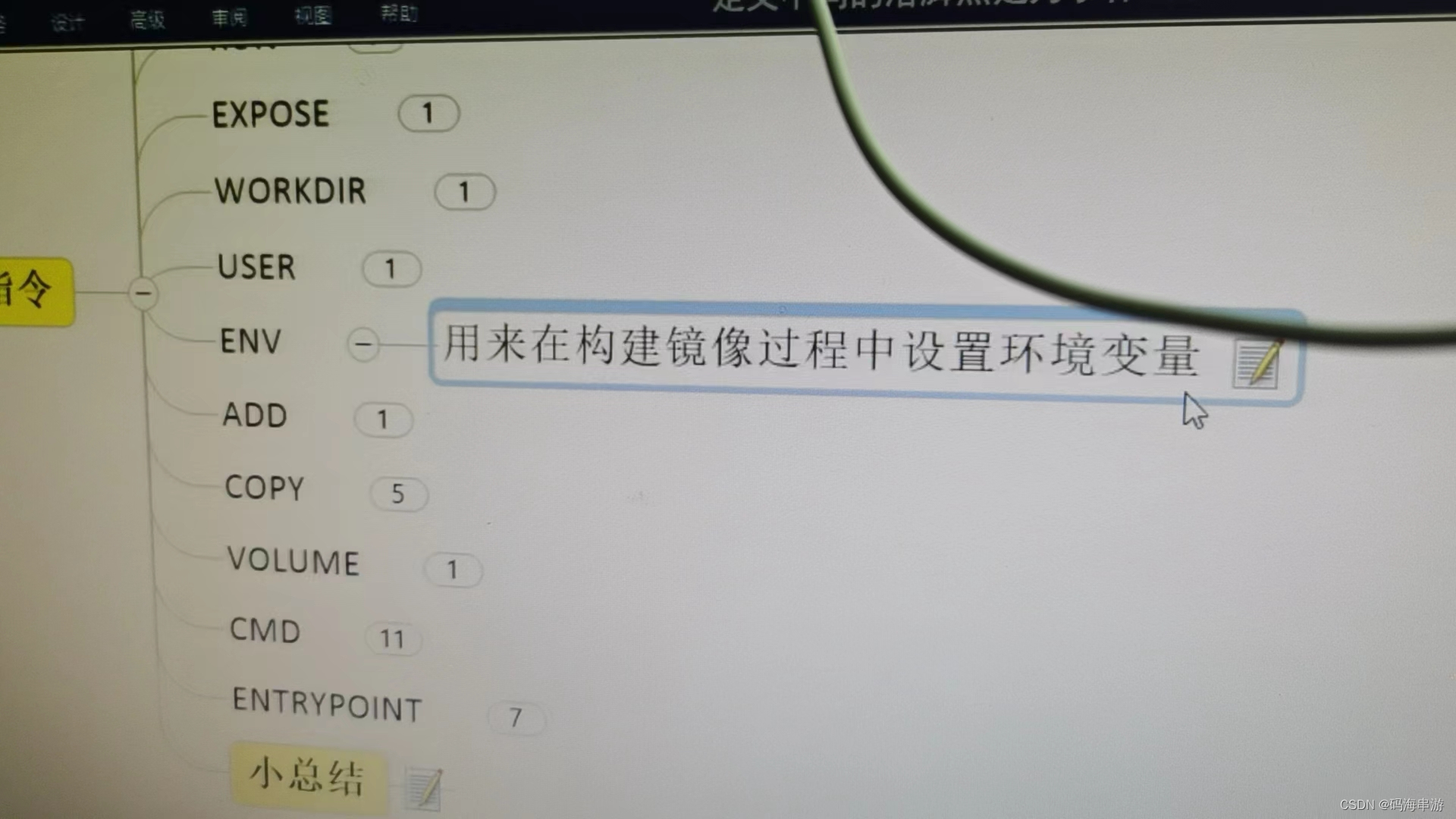

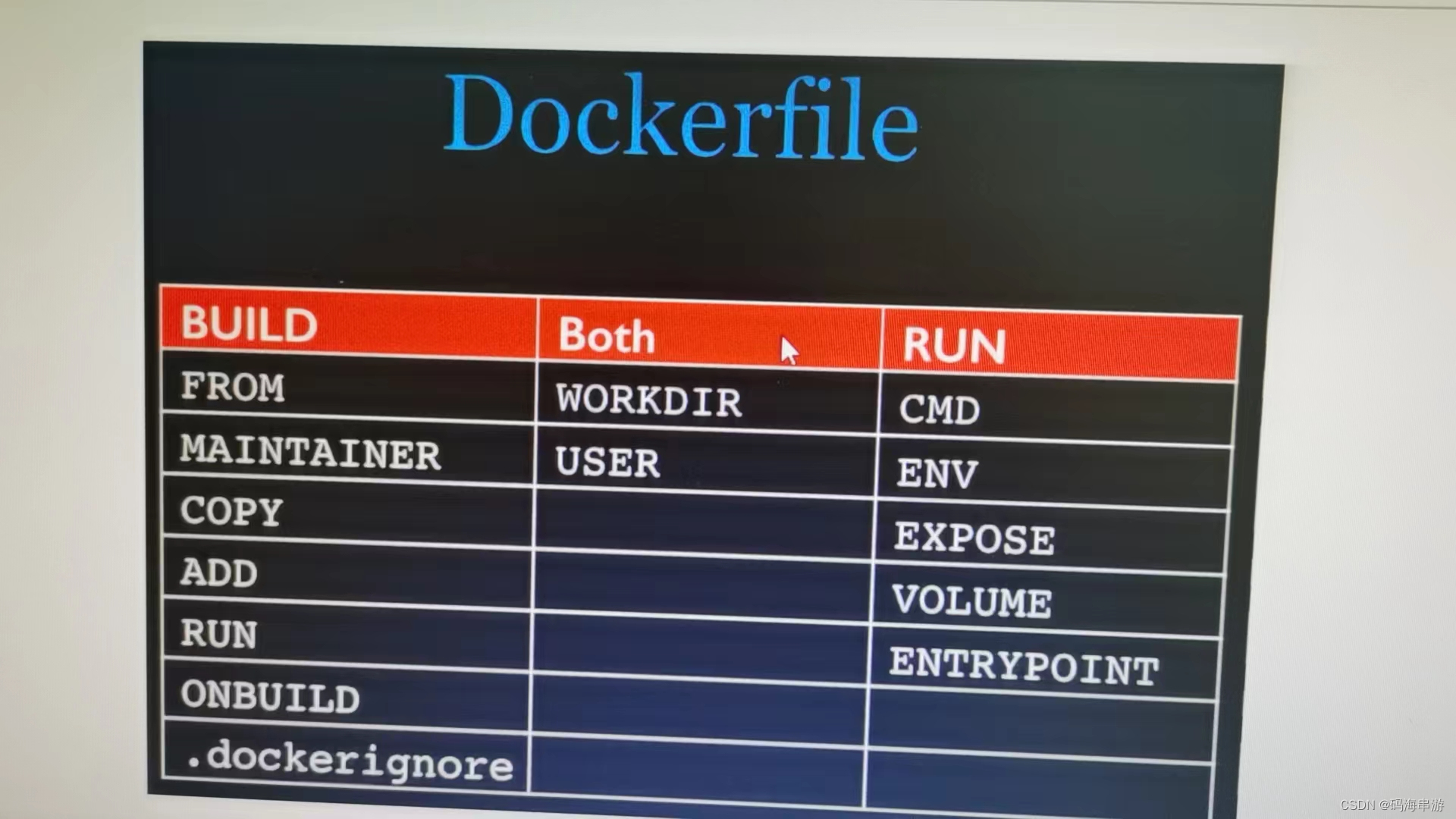

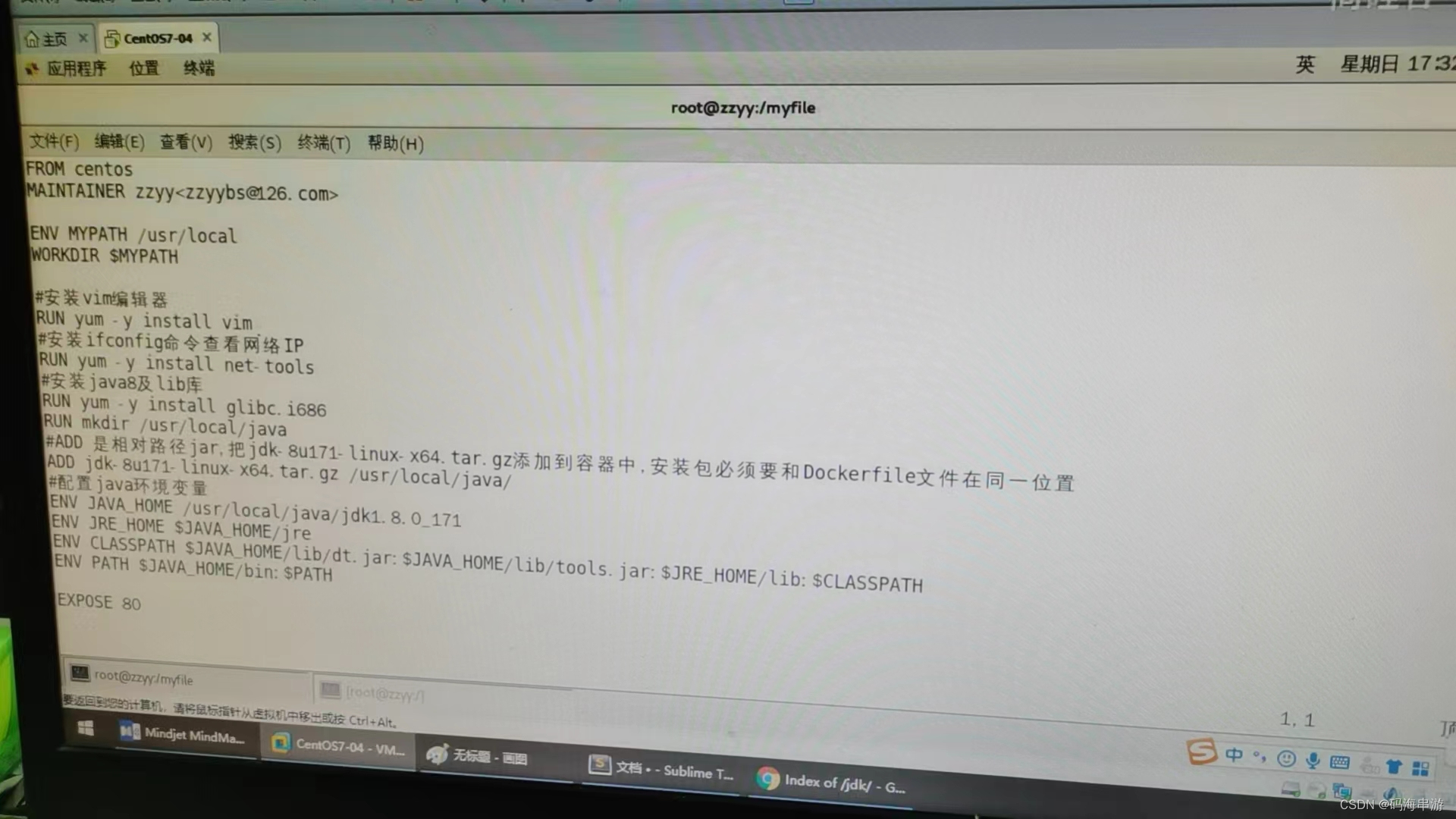

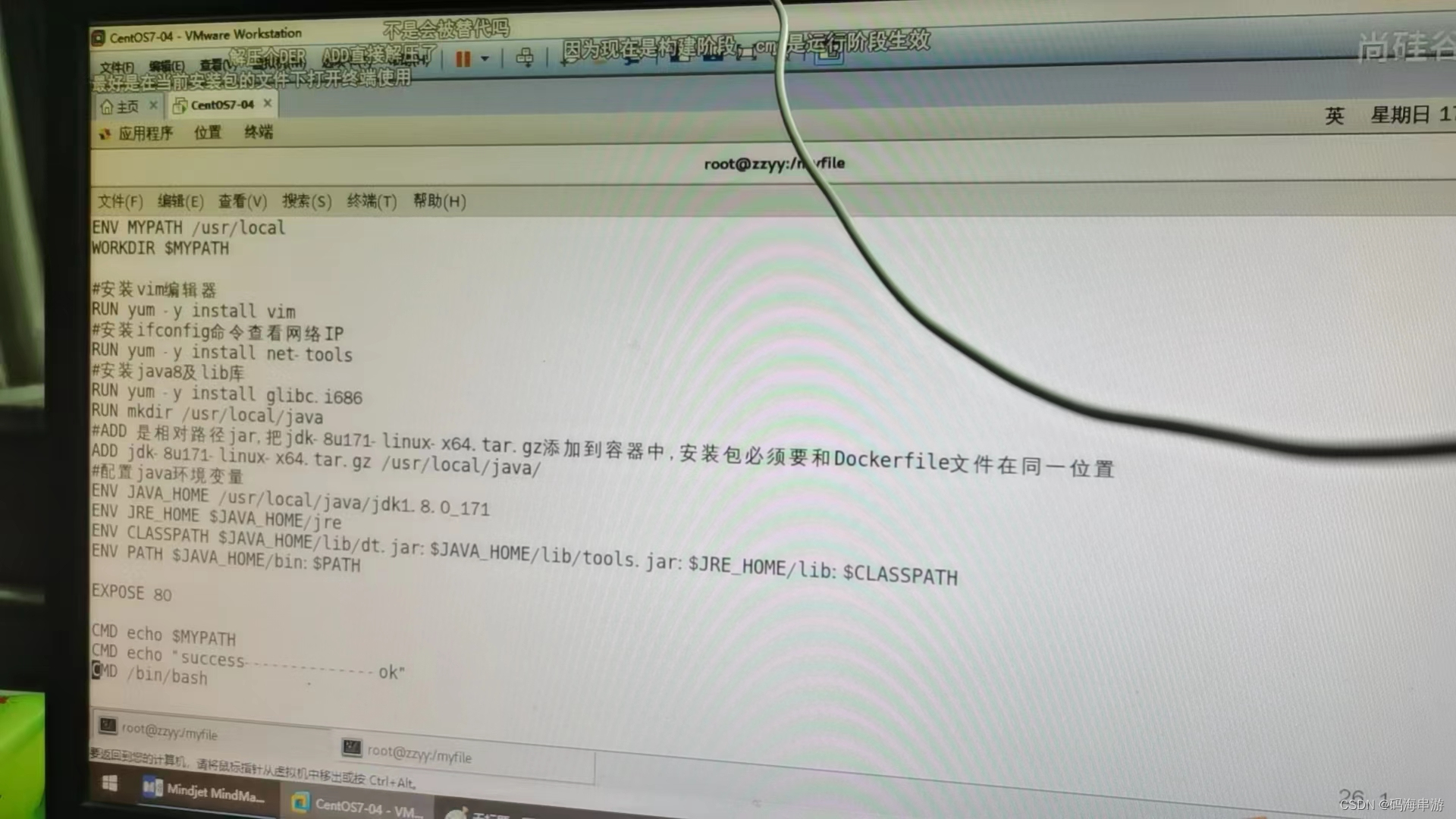

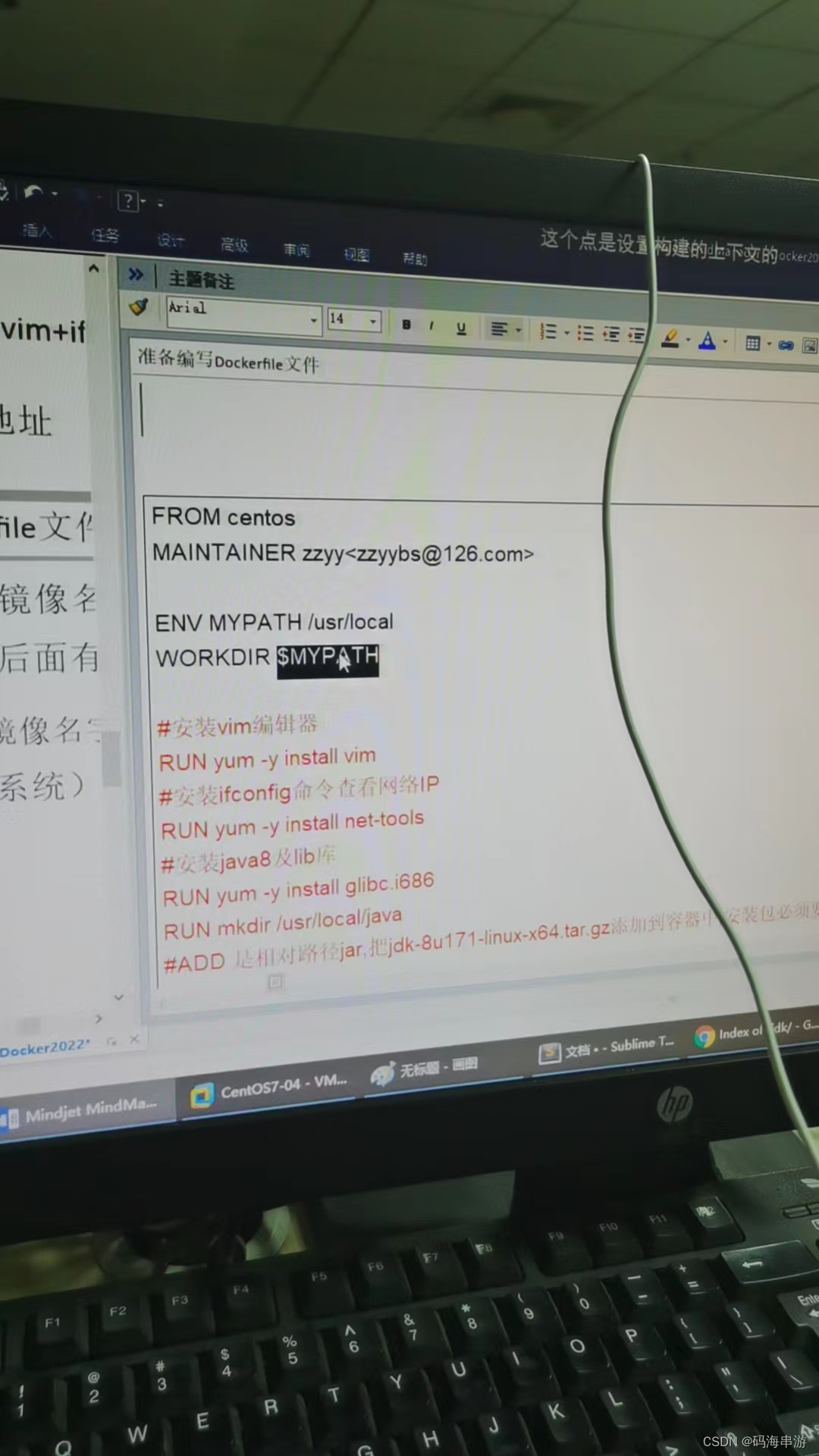

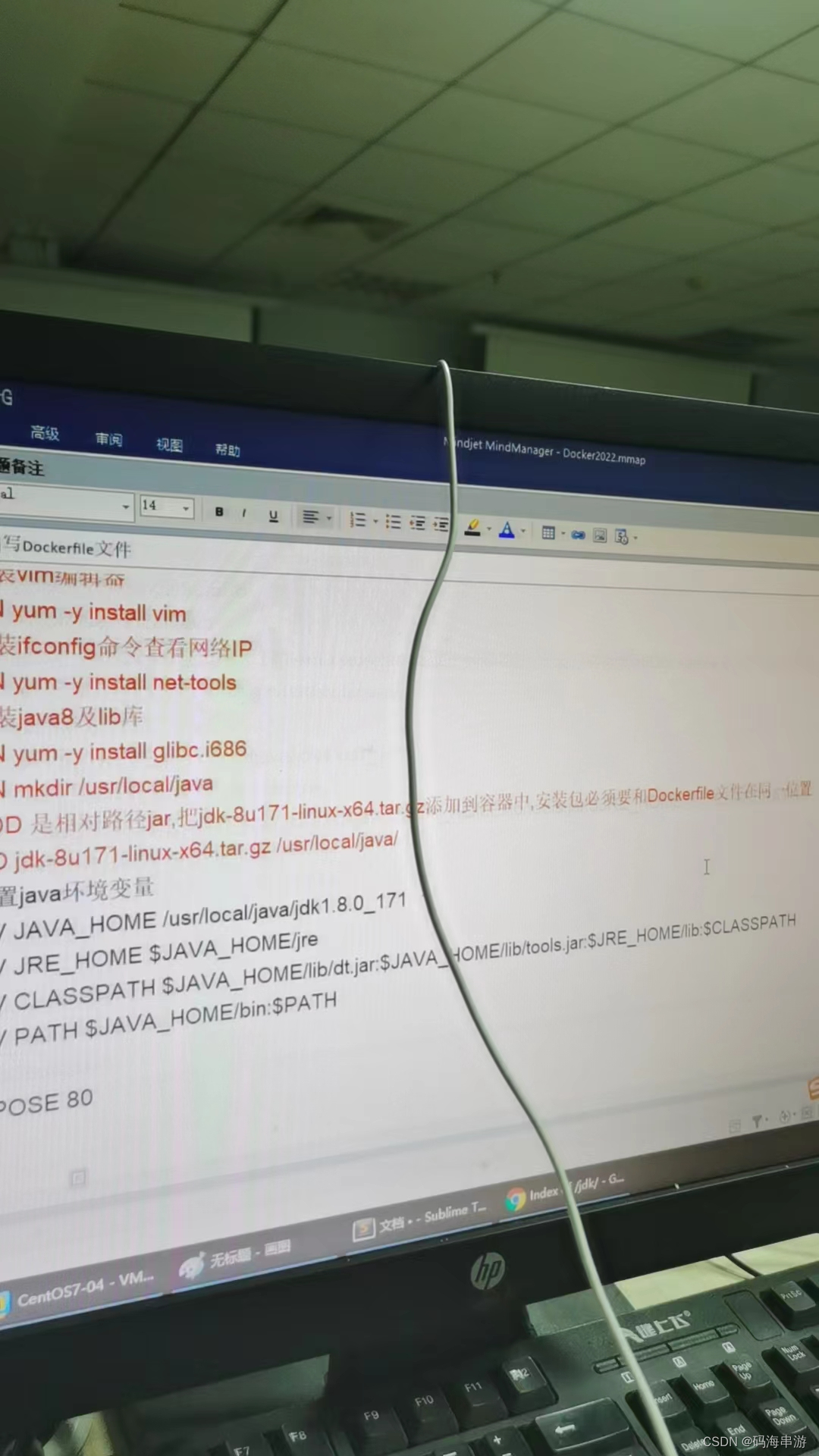

DockerFile解析

官网:https://docs.docker.com/engine/reference/builder/

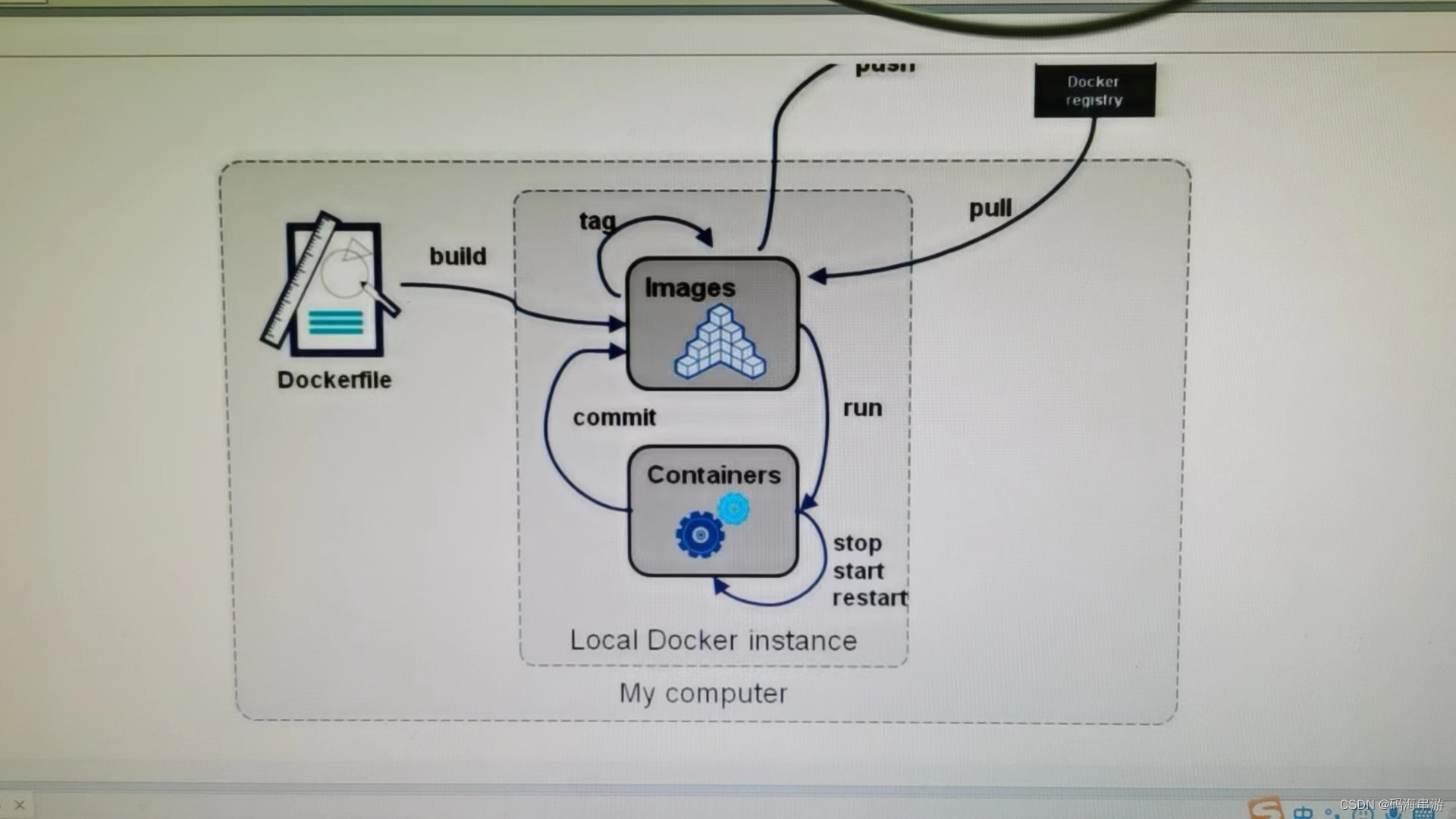

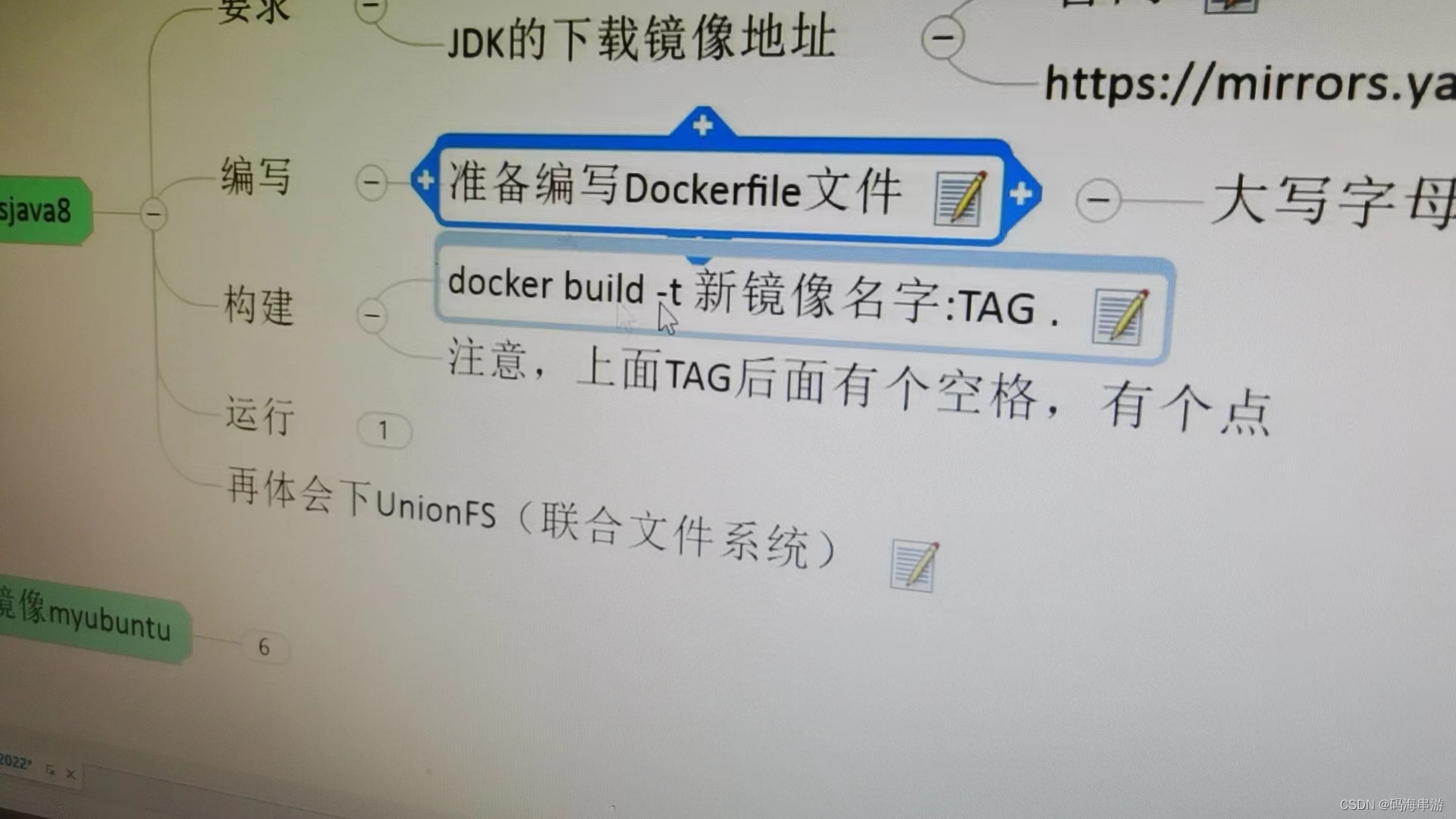

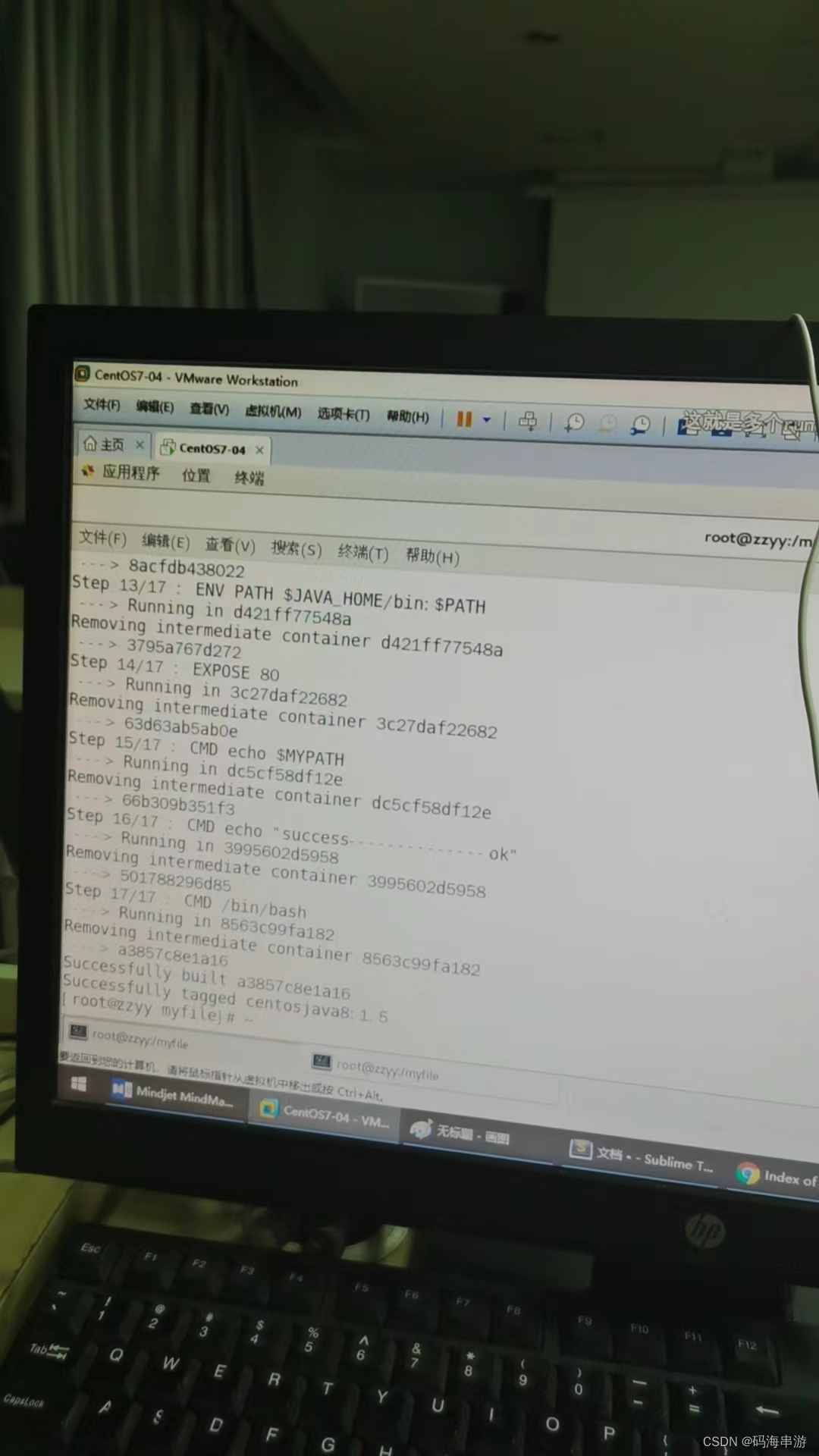

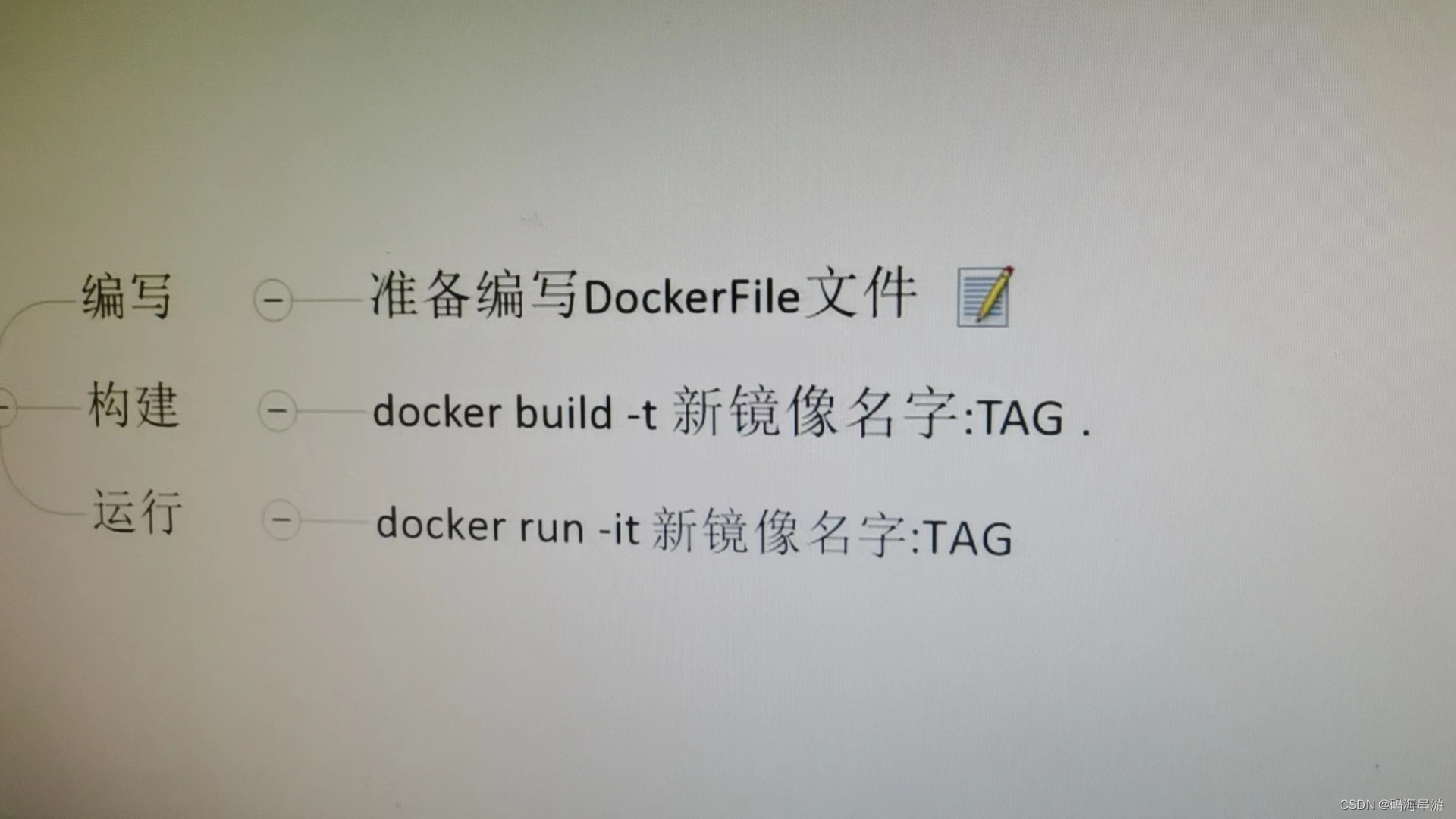

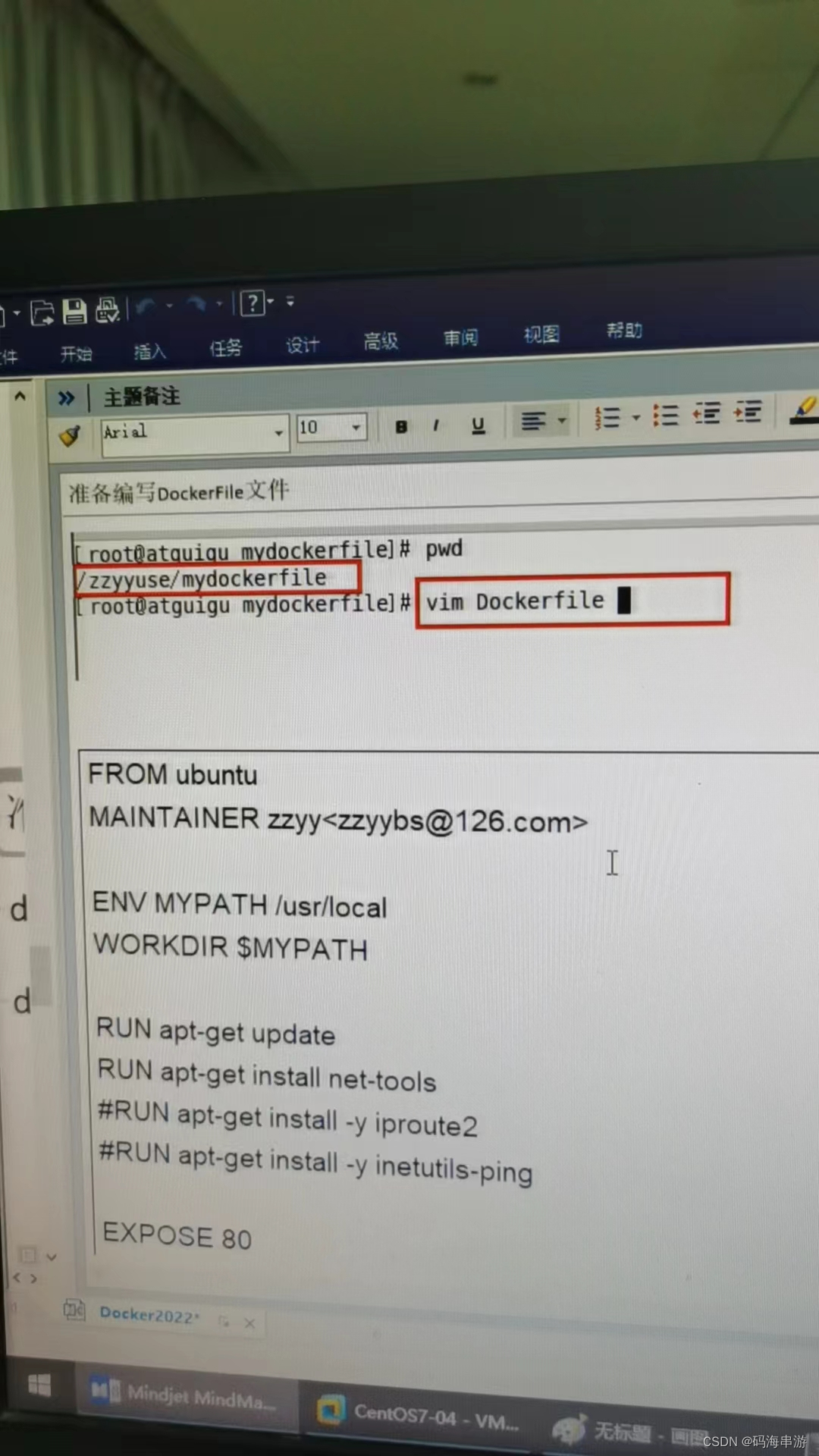

构建三部曲:编写Dockerfile文件。

docker build命令构建镜像

docker run 依镜像运行容器实例。

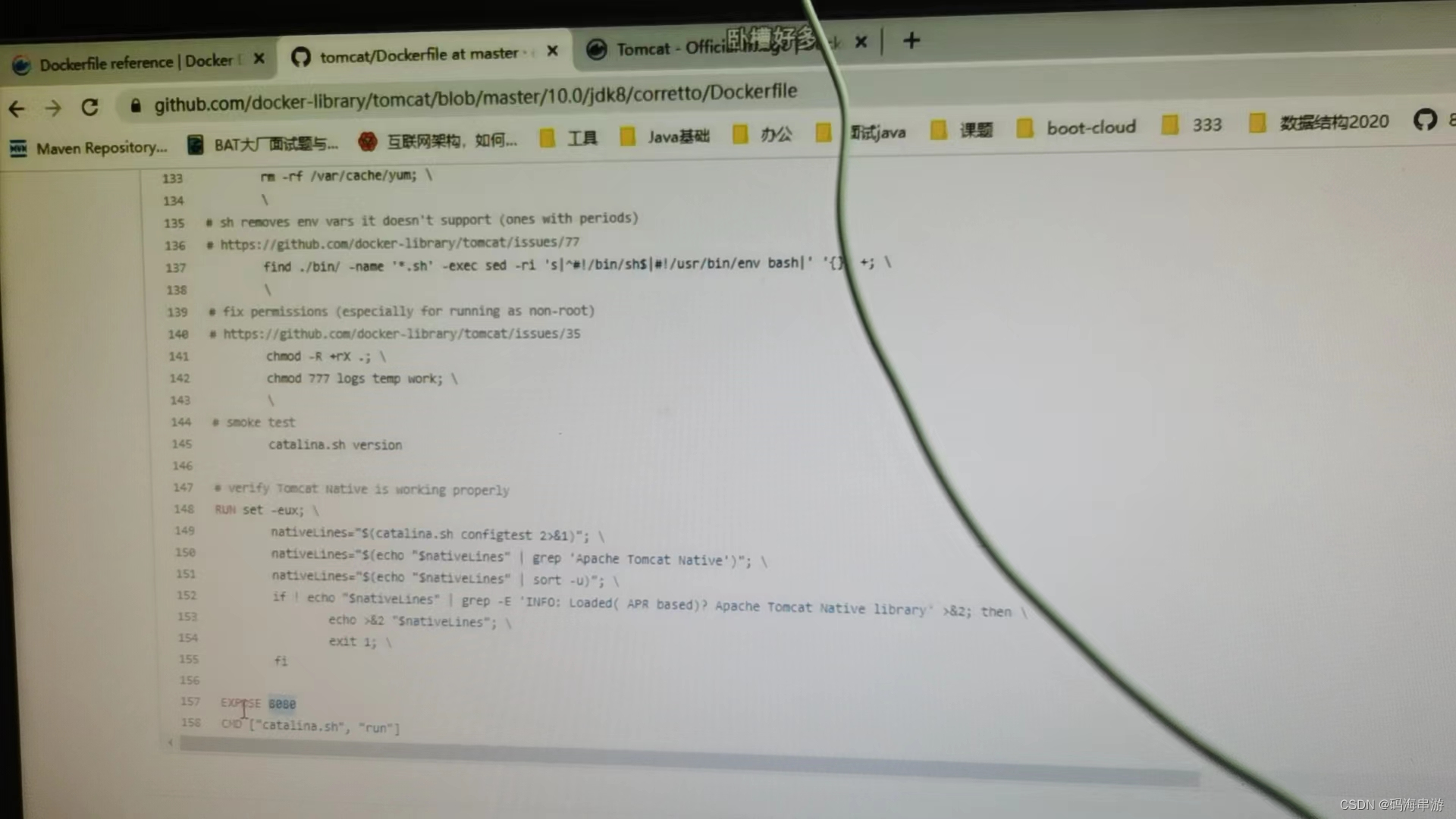

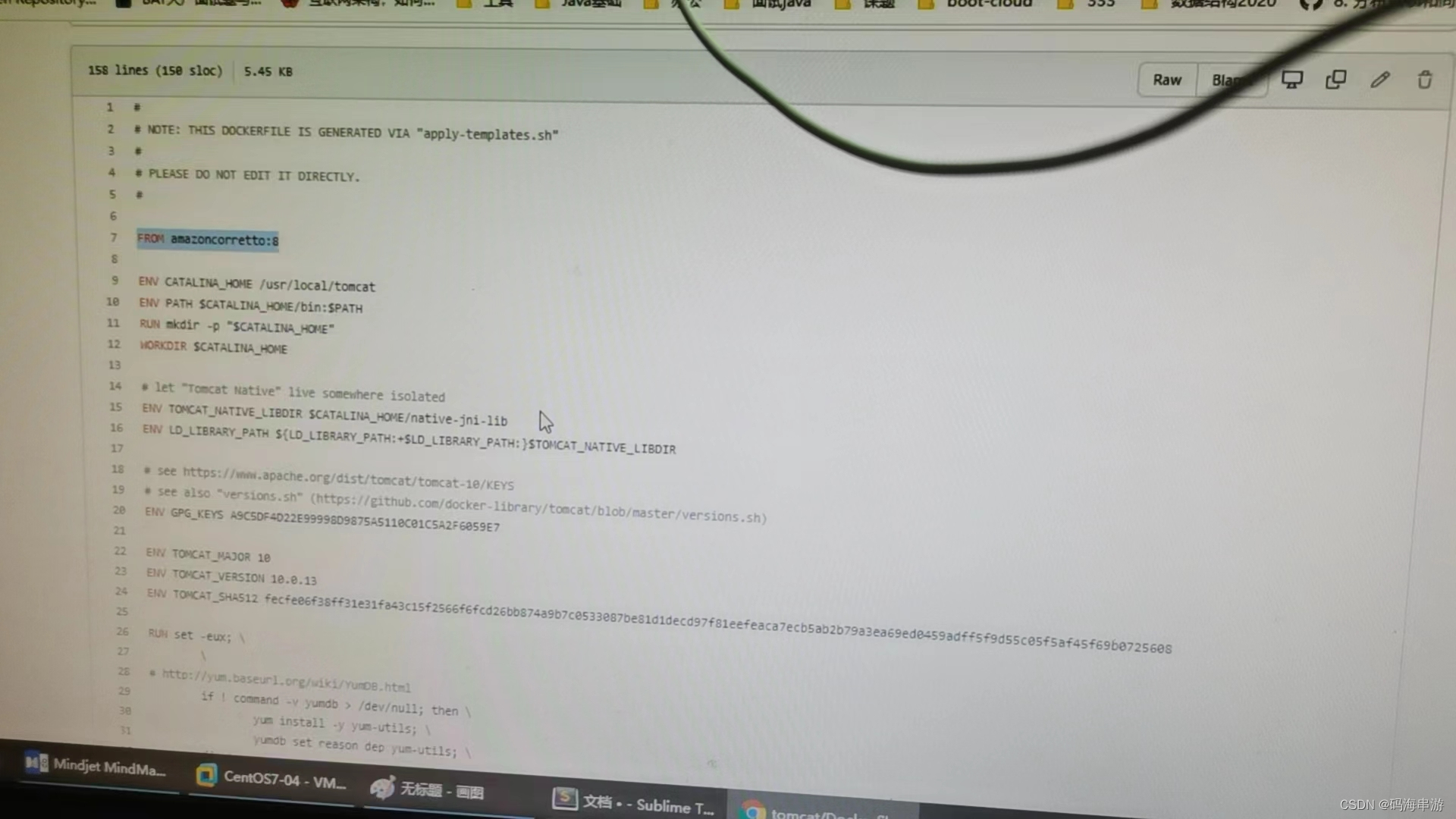

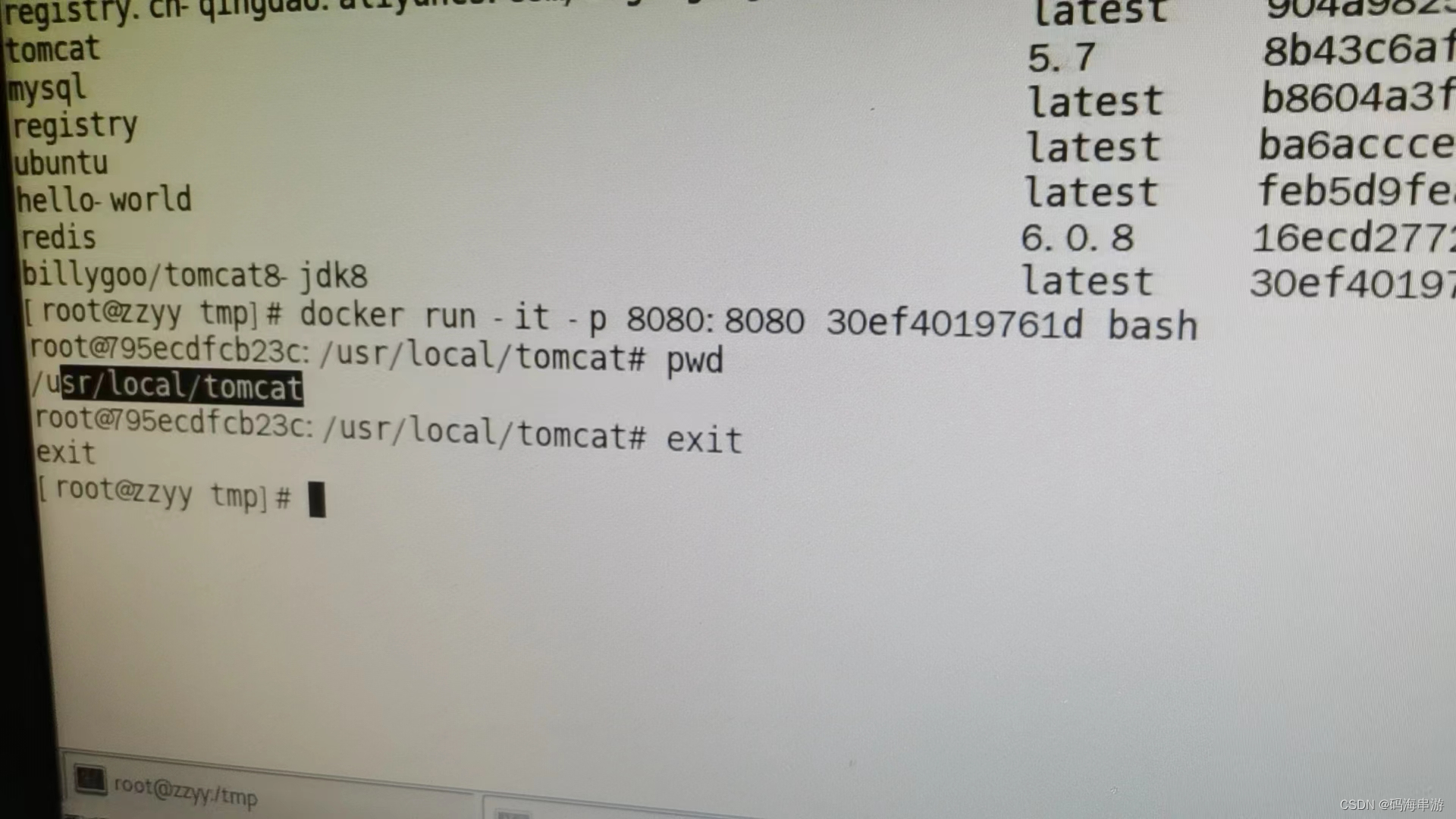

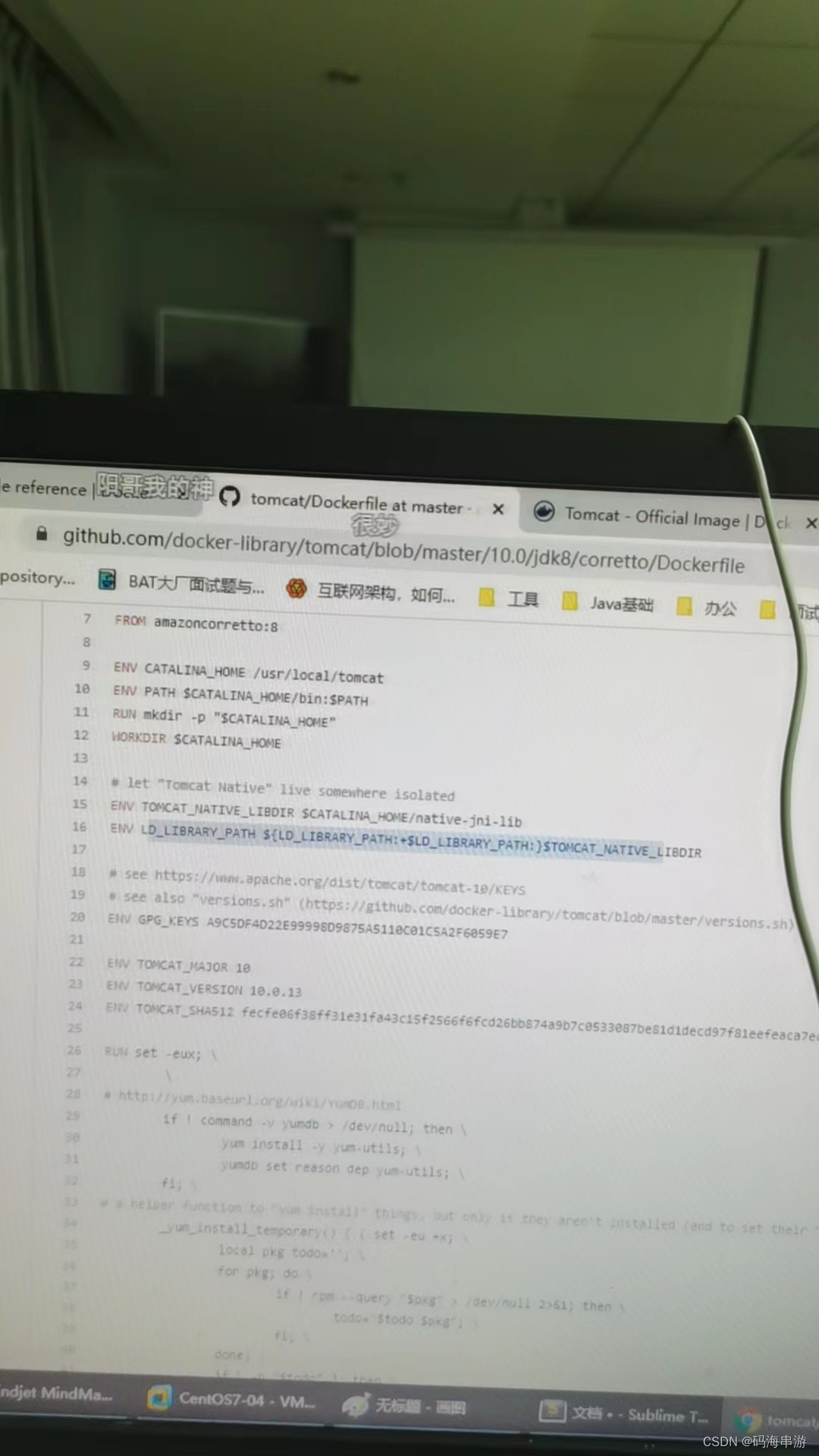

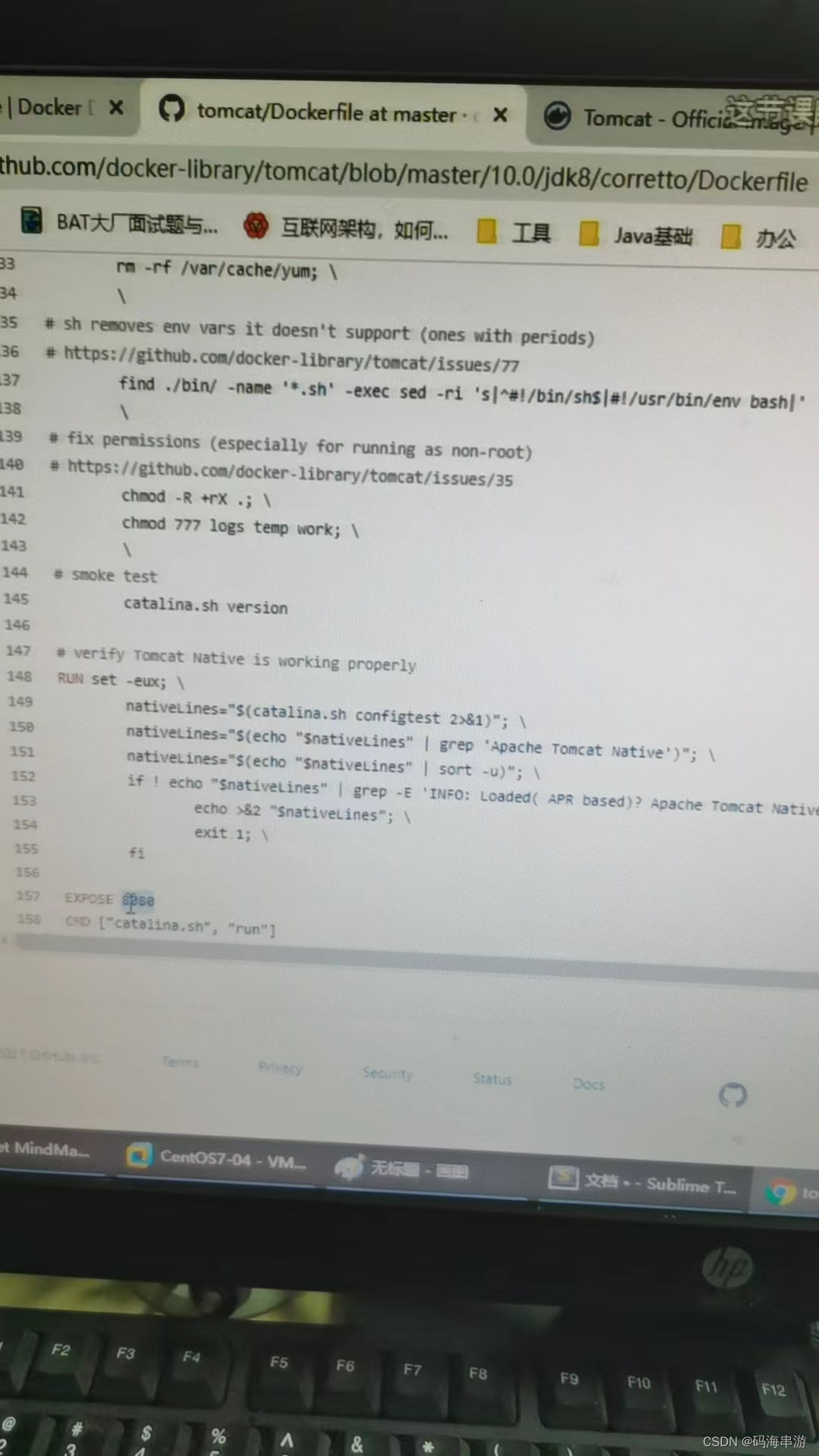

参考tomcat8的dockerfile入门 https://github.com/docker-library/tomcat

运行

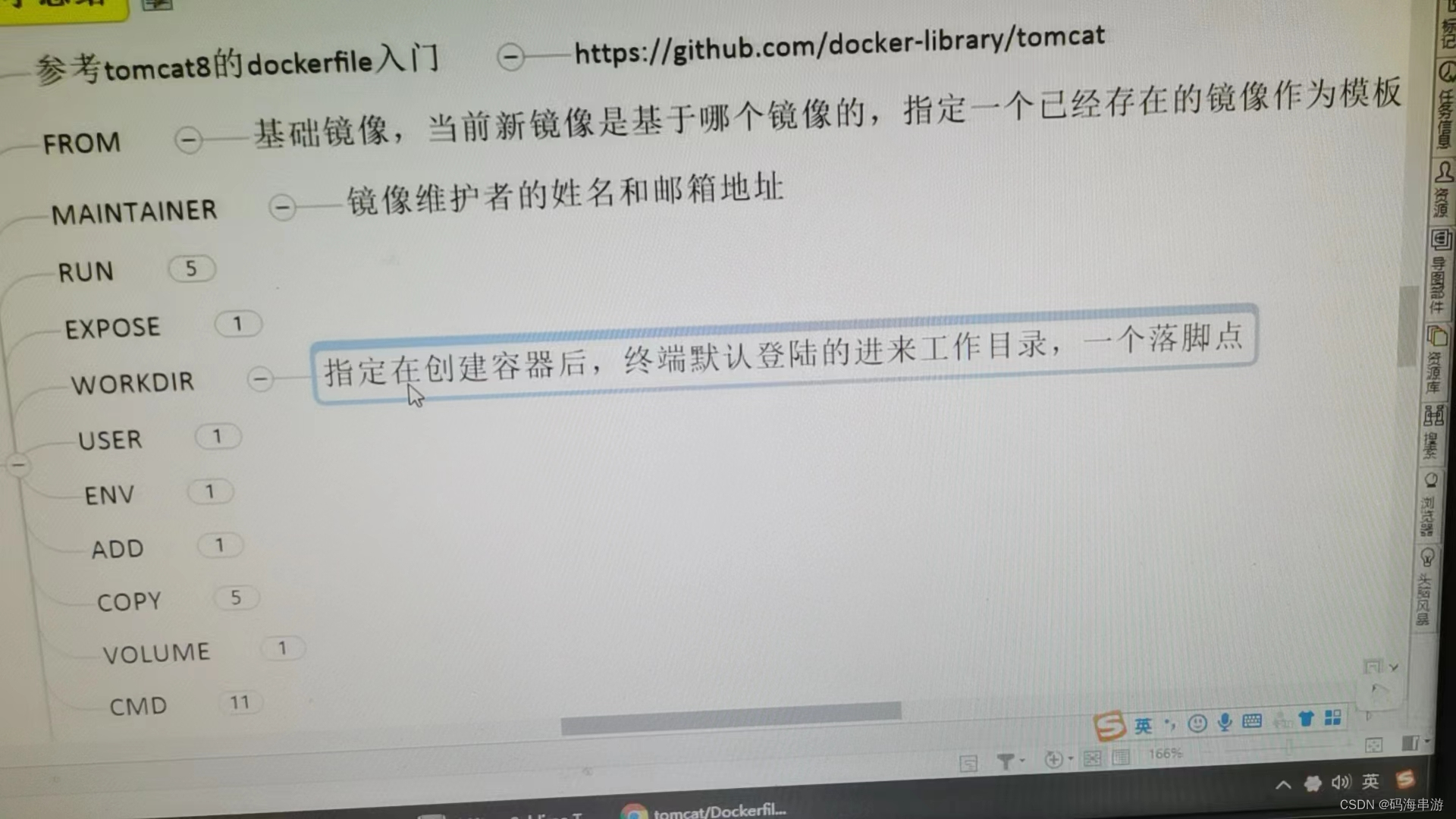

有不同的落脚点,这是为什么呢?落脚点

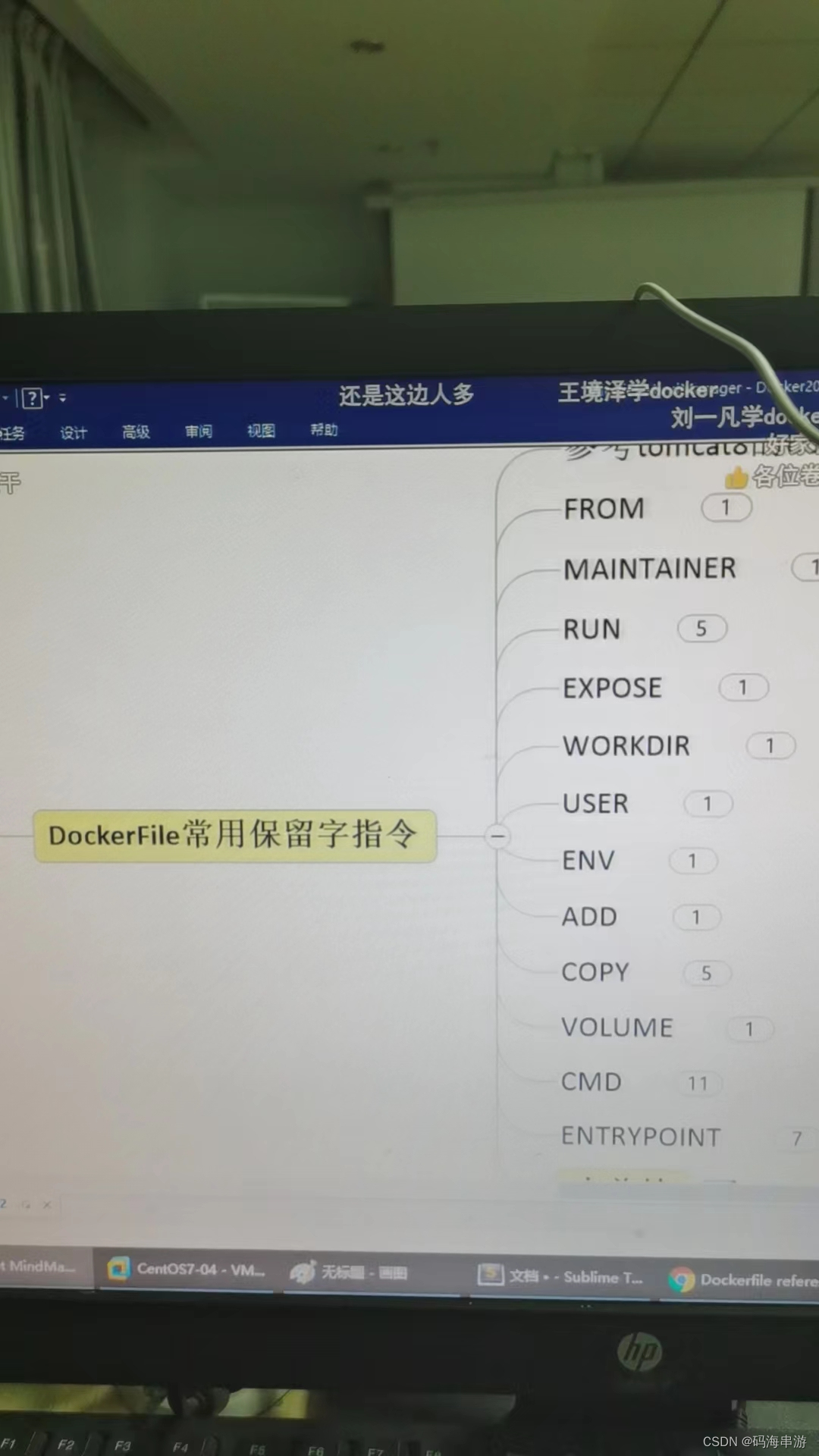

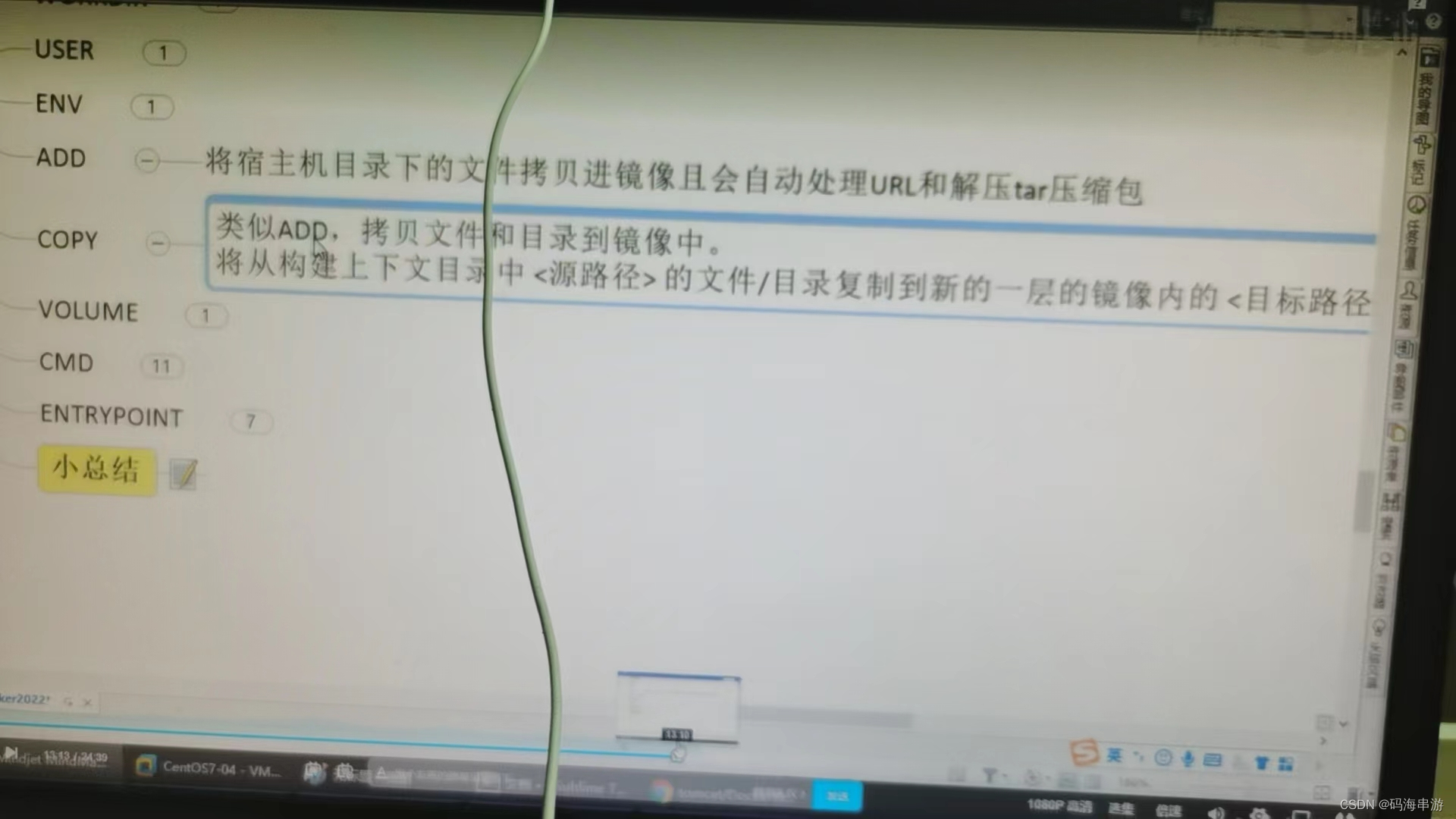

ADD和COPY一样,ADD有解压

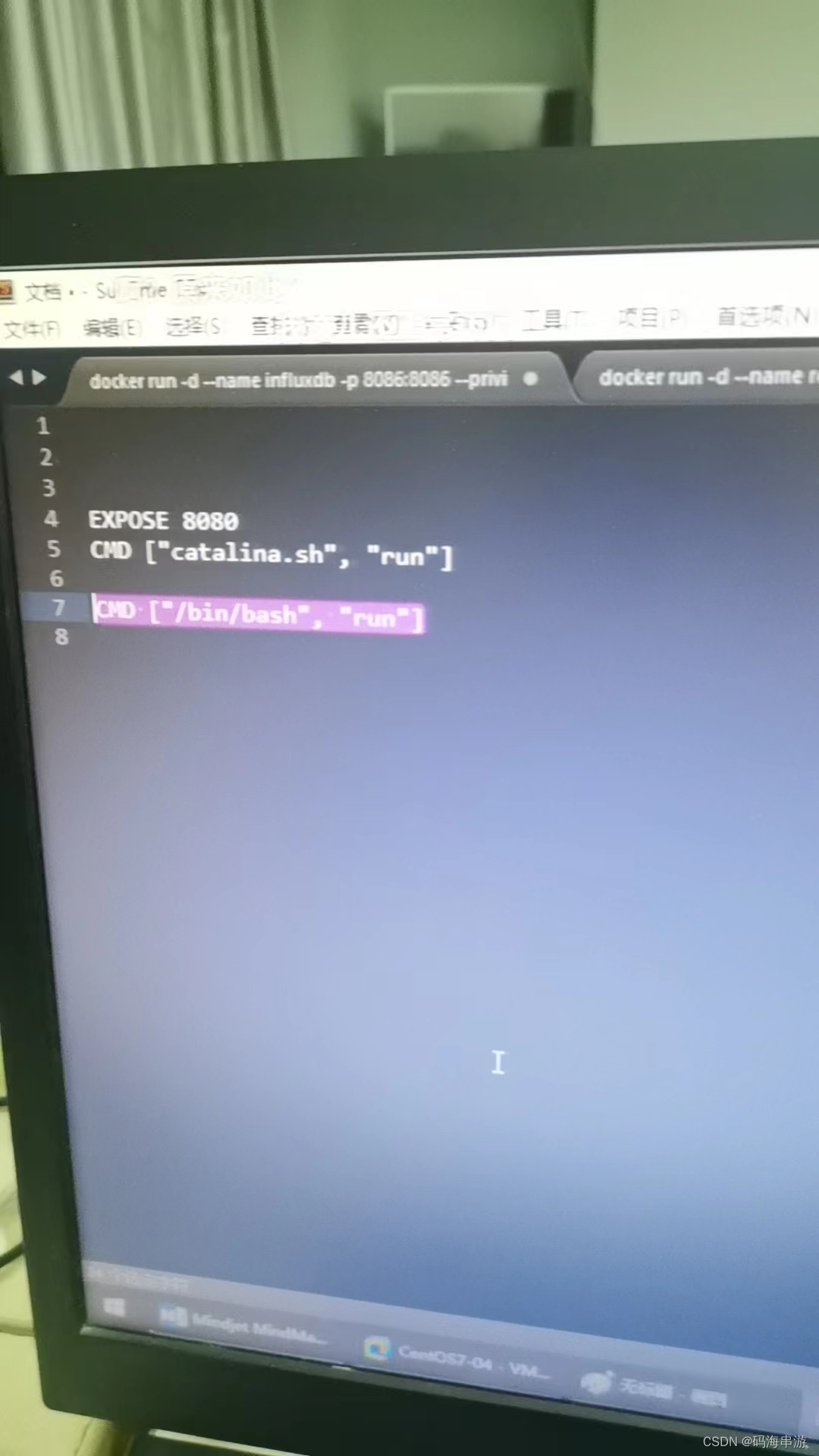

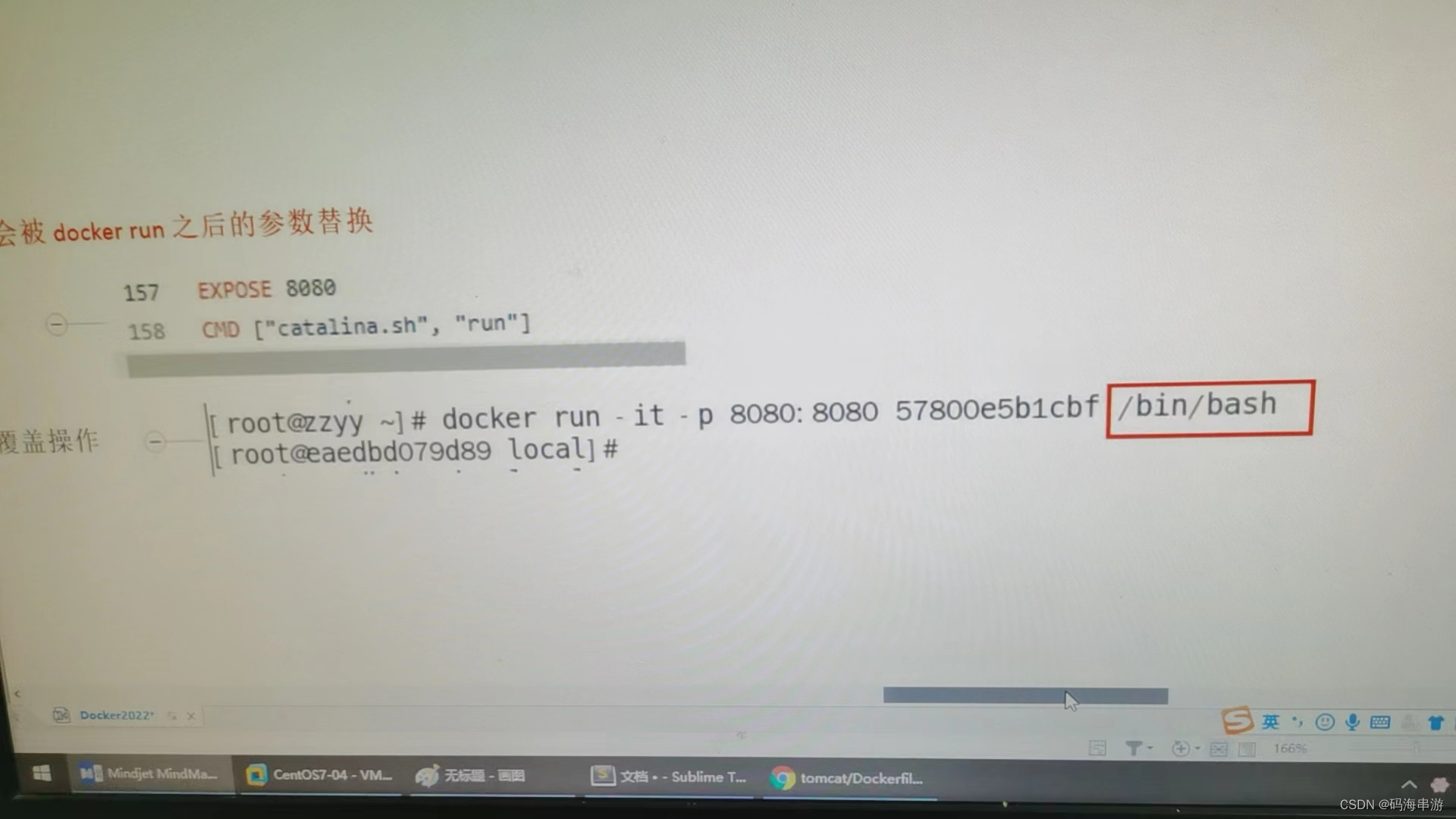

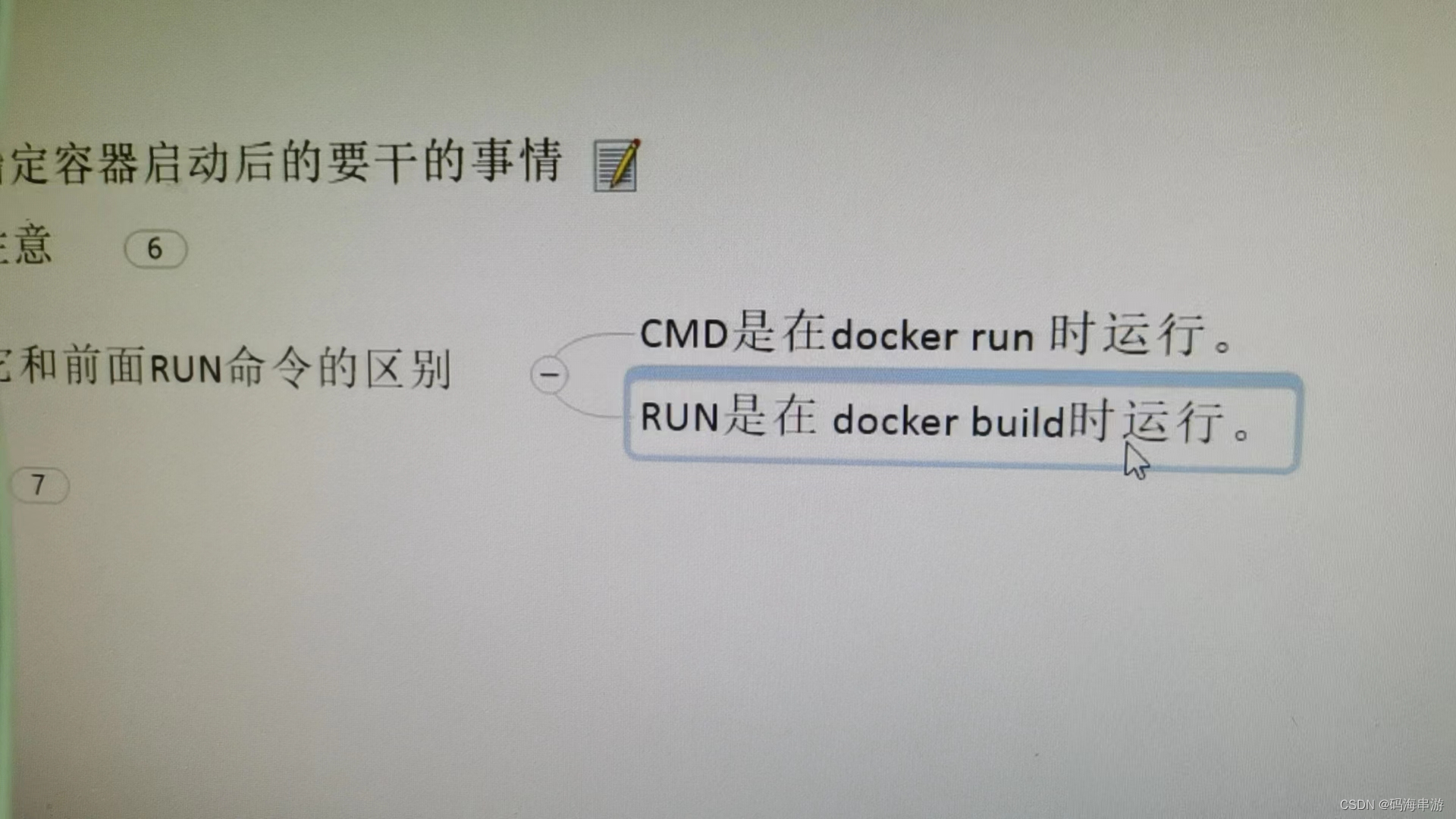

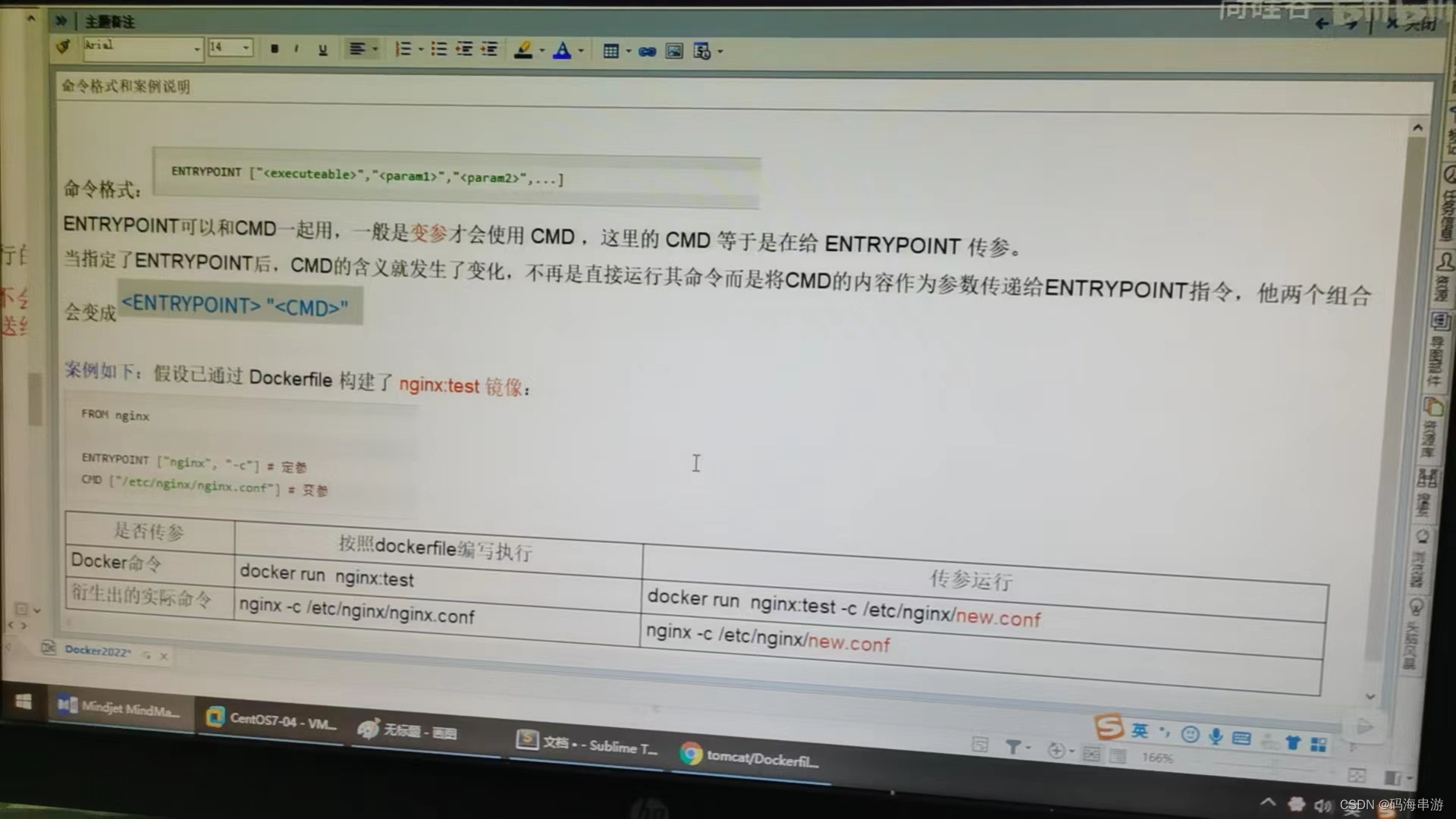

CMD与ENTRYPOINT是一组,功能类似。

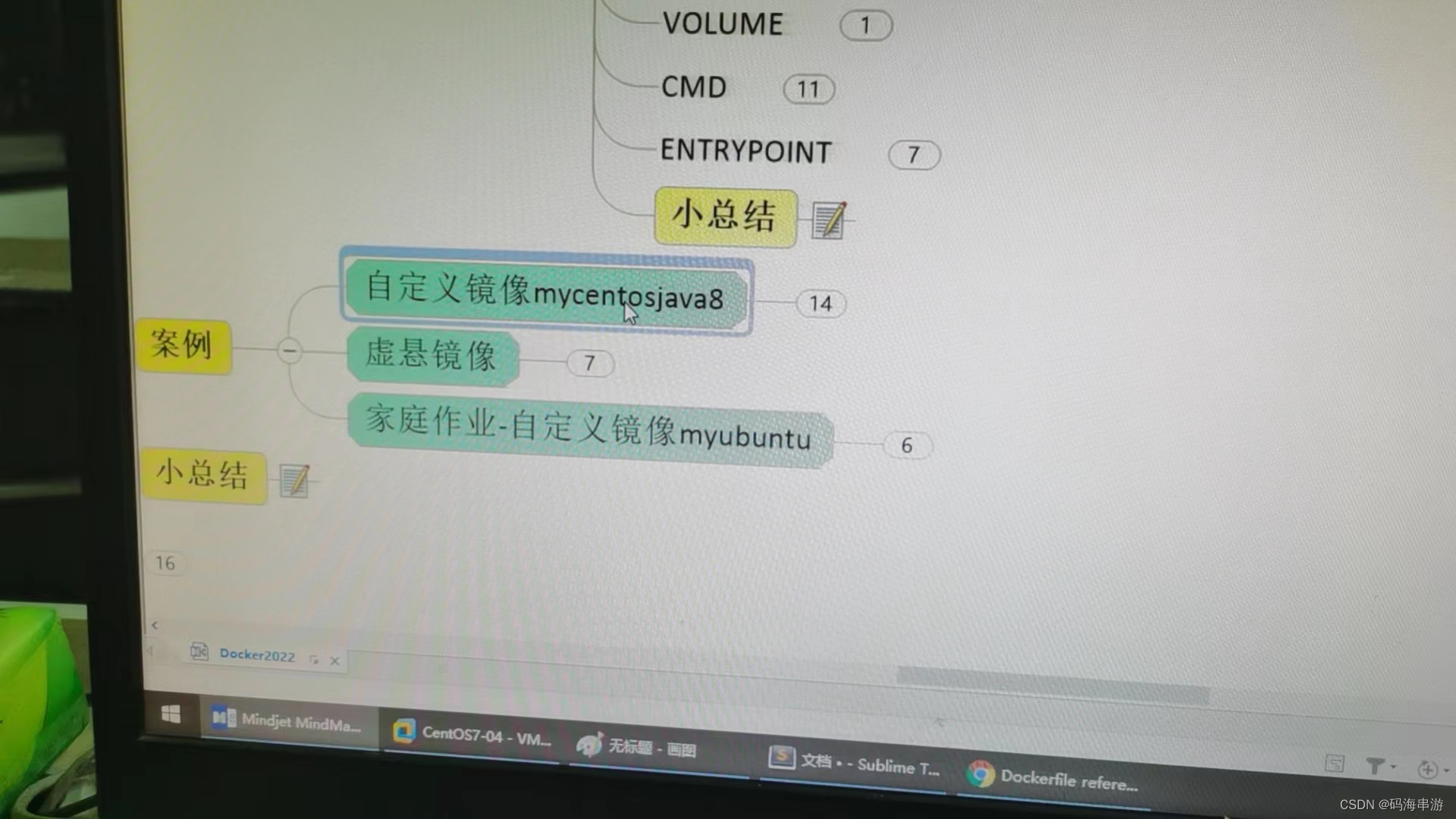

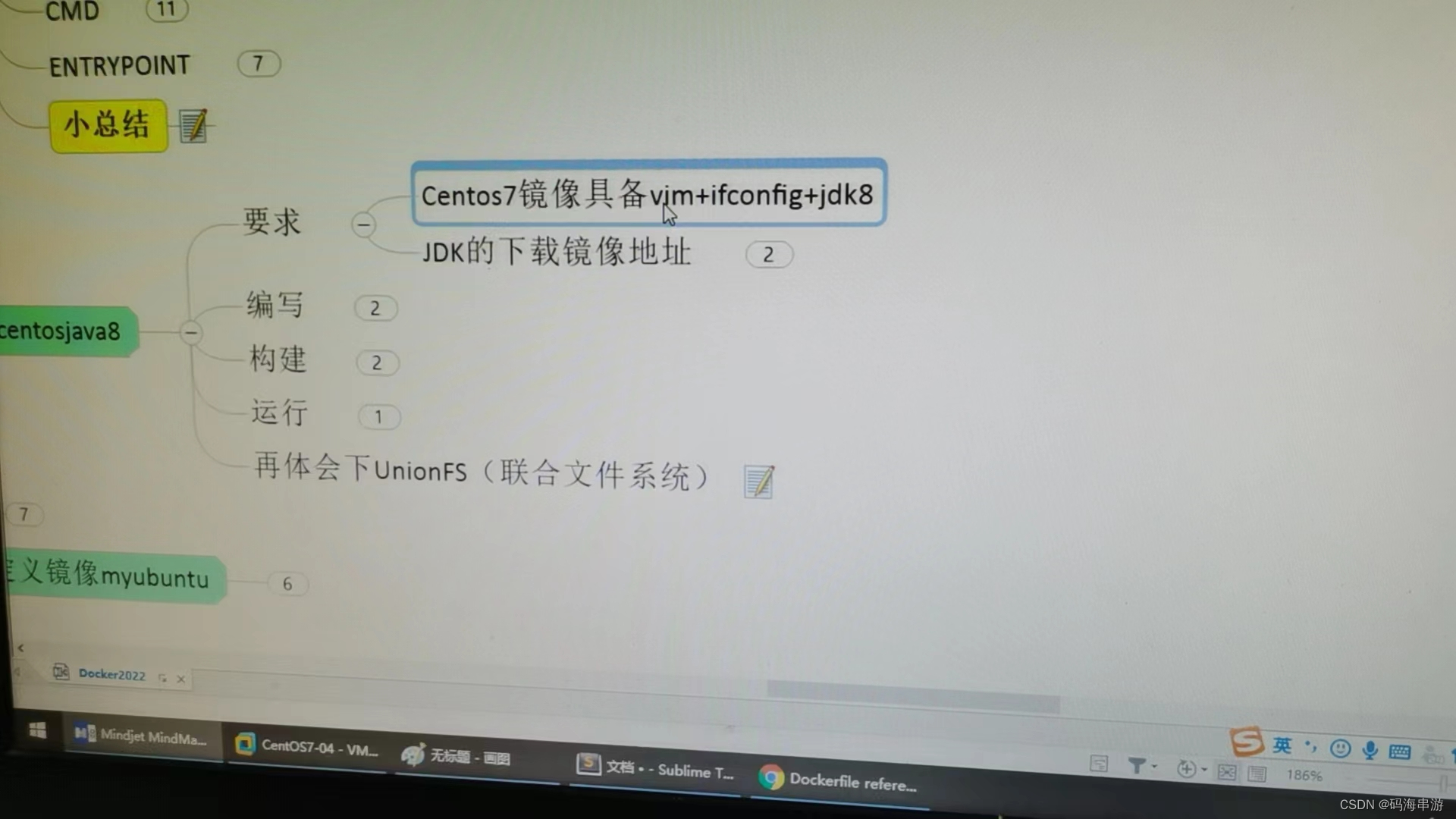

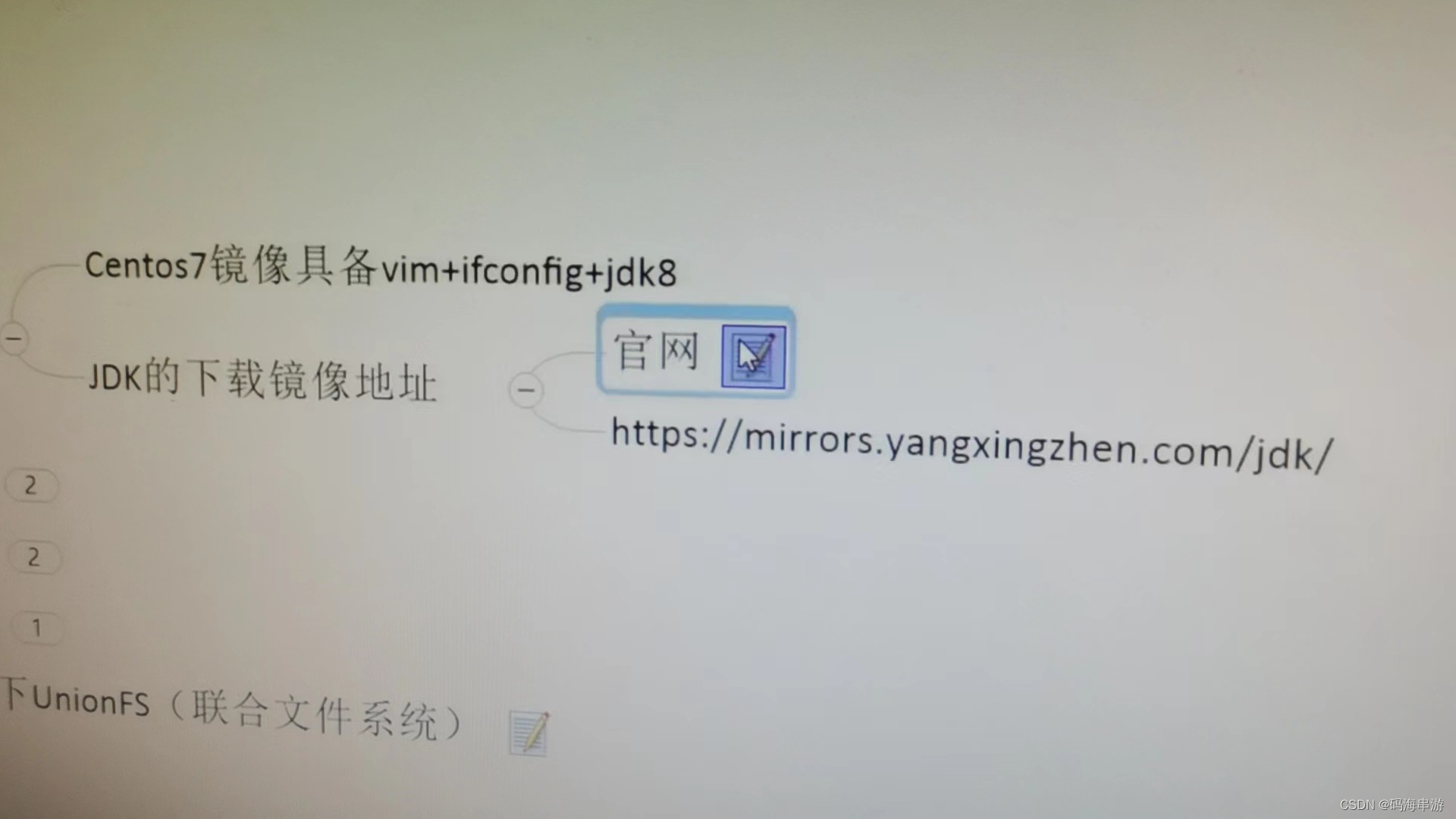

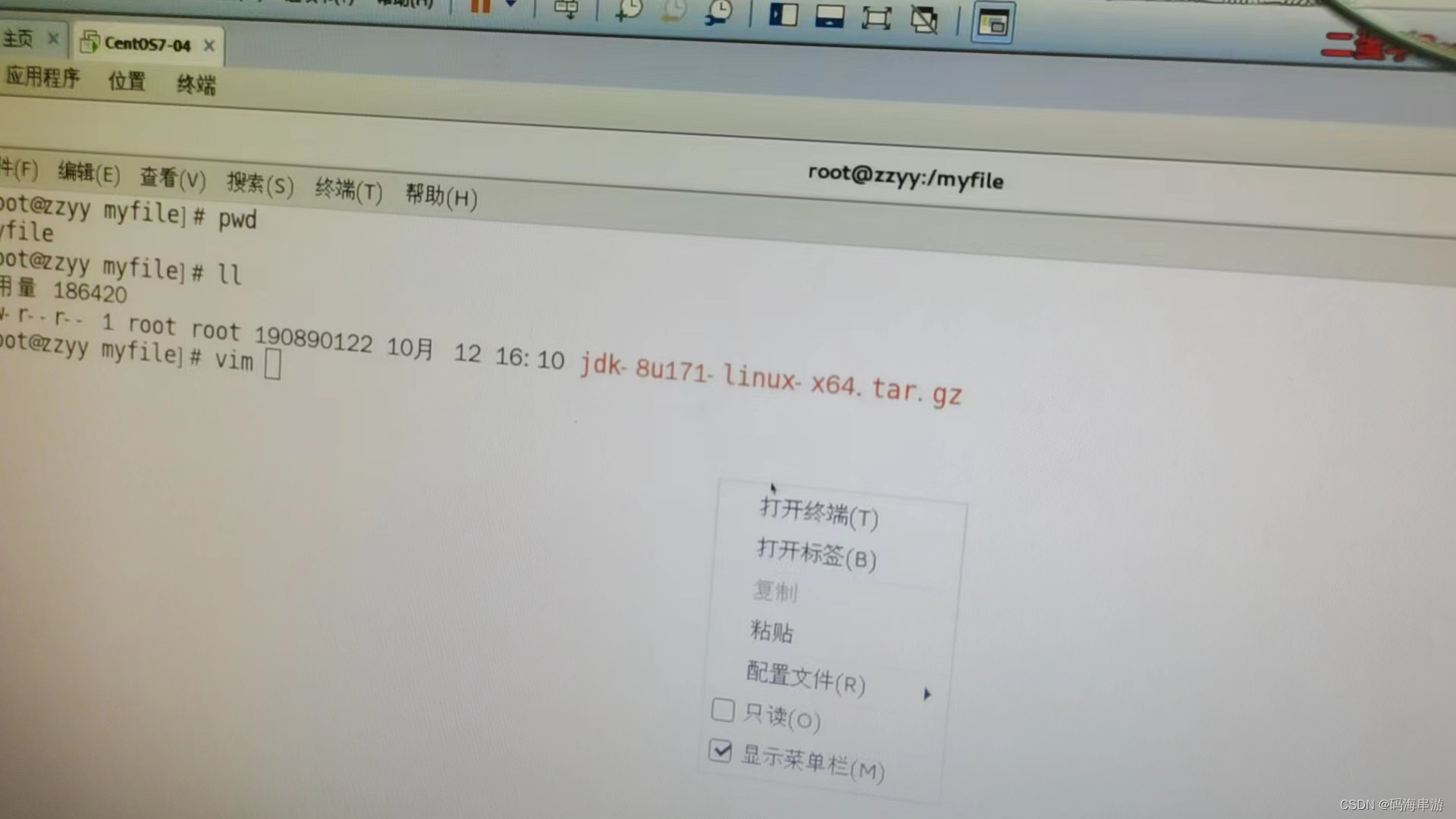

centosjava8

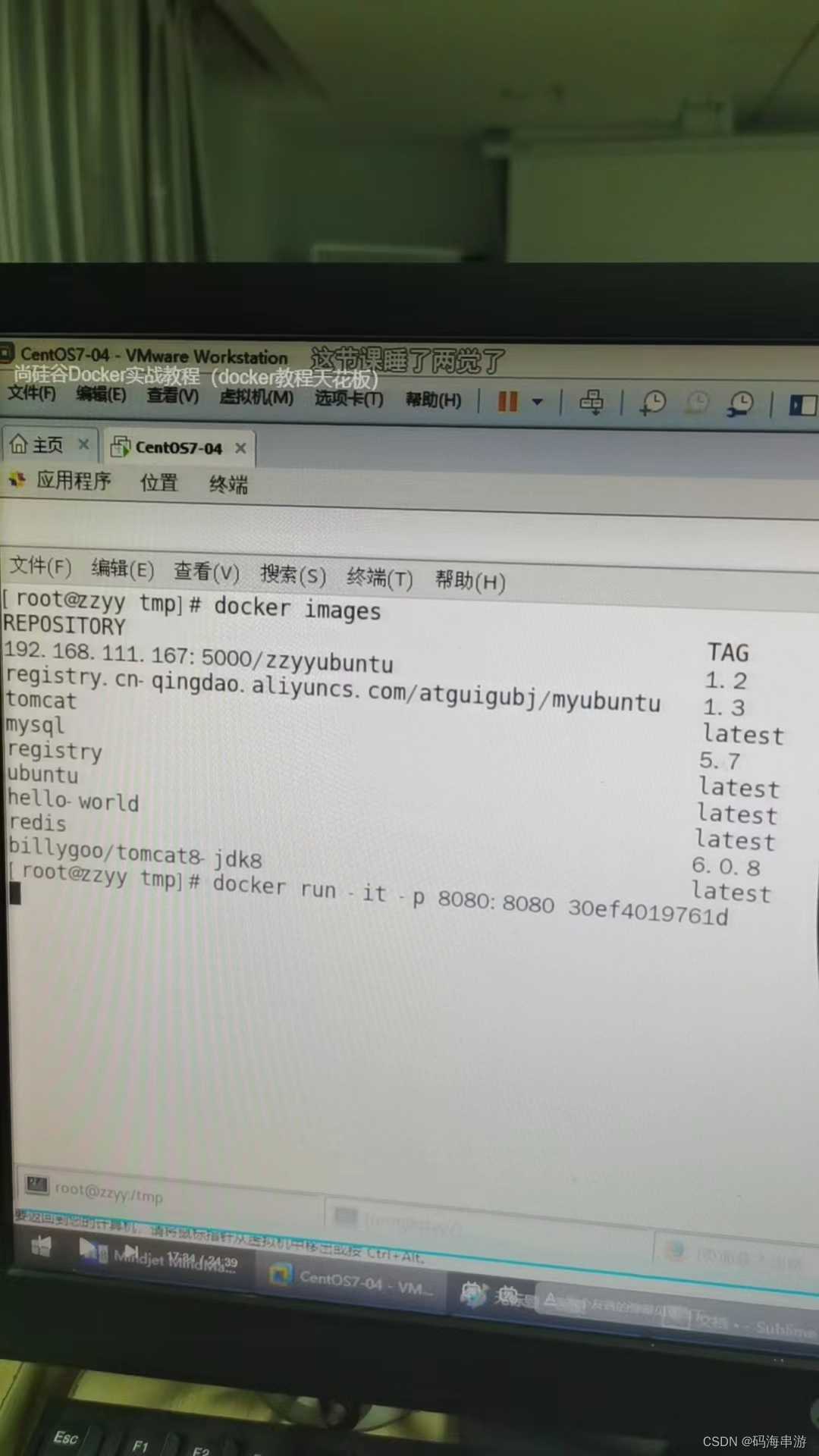

docker images

docker run -it biaohao1 /bin/bash

vim a.txt

ifconfig

java -version

docker images centos

小巧

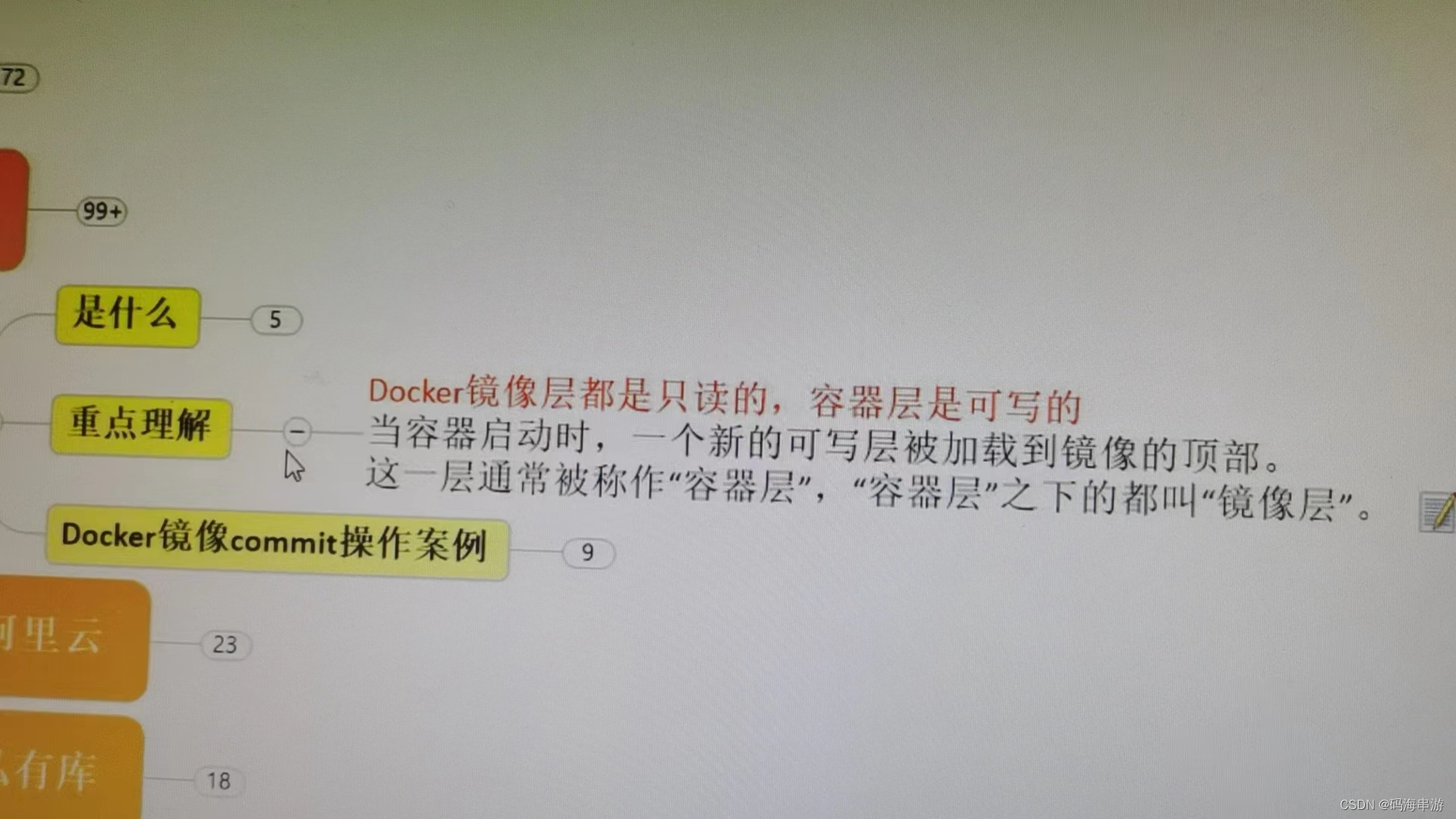

再体会下UnionFS(联合文件系统)

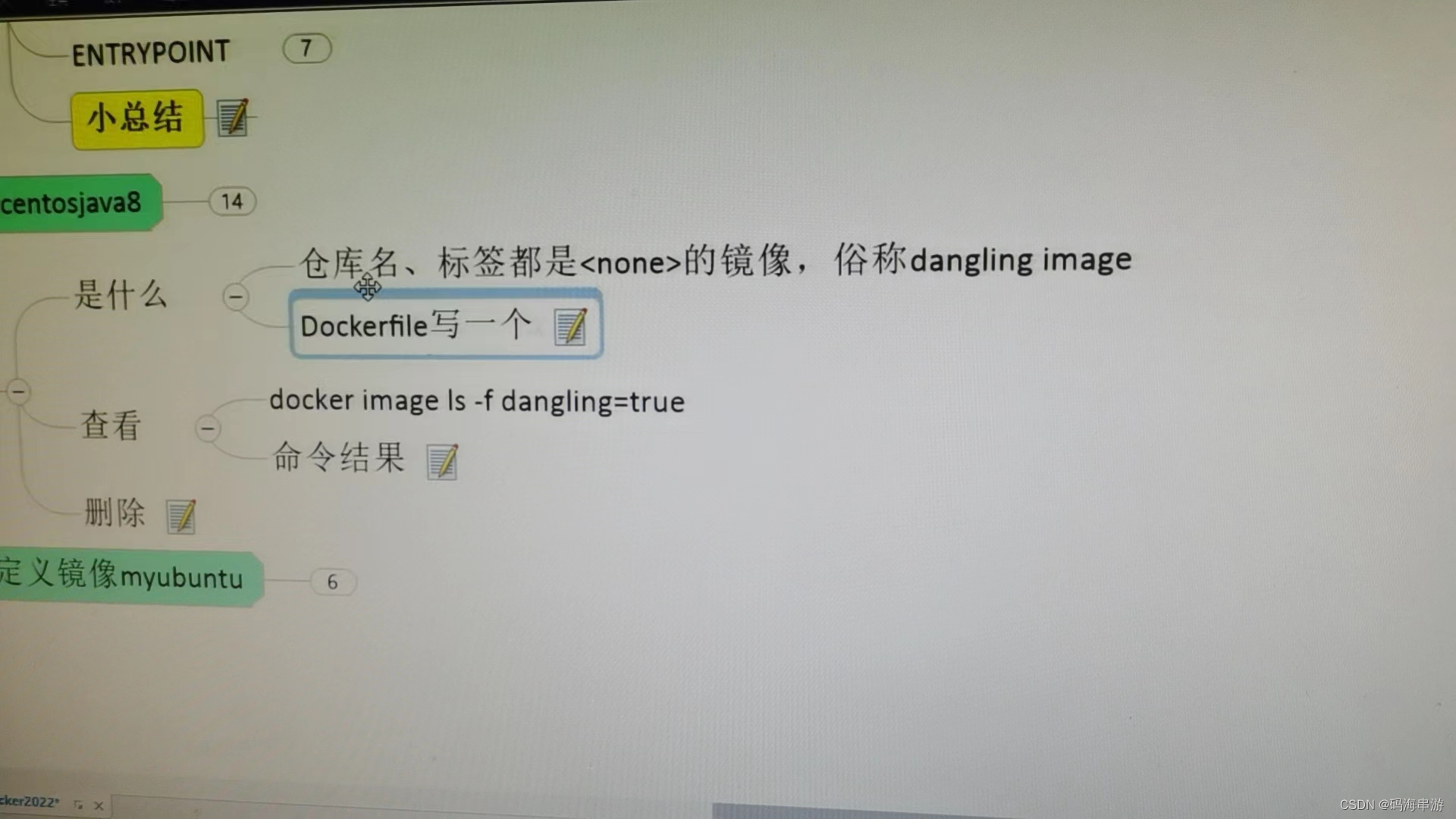

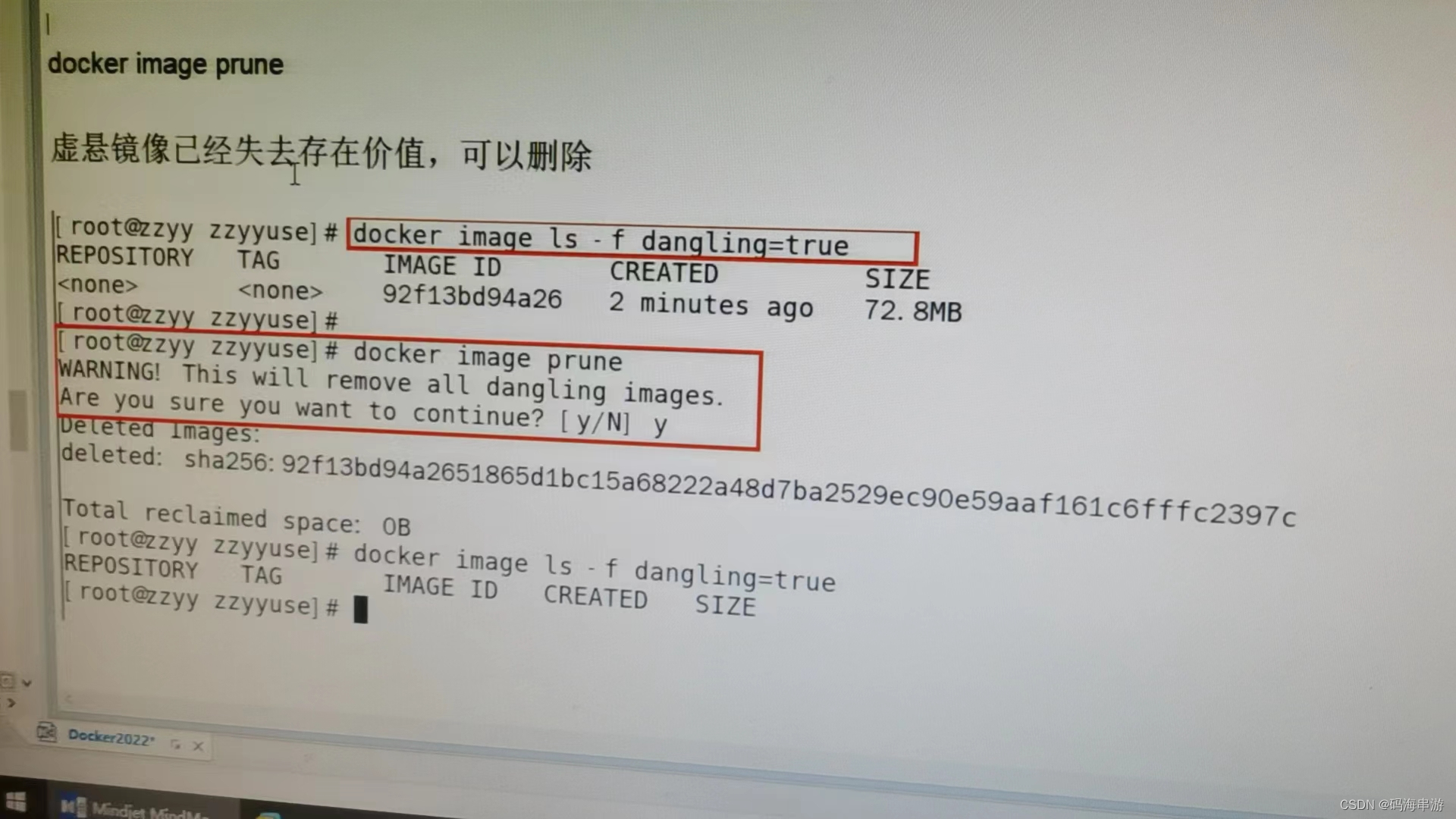

虚悬镜像

构建和删除镜像的时候出现一些错误,导致出现仓库none的标签none

一定要把这个删除掉,对系统会有风险

查出所有虚悬镜像

删除虚悬镜像

自定义镜像myubuntu

构建注意加点

会导致索引失效)

详细介绍)

,5-氯甲基荧光素二醋酸酯,广泛应用于细胞追踪和标记实验中)

环境配置过程)