Flink实时数仓部署

- 将common作为一个自定义的依赖部署到maven中

- 使用maven将各个子模块打包

- 可以使用FLink框架进行jar包的提交运行。

StreamPark

一个易于使用的流处理应用开发框架和一站式流处理操作平台和管理流应用。它提供了Flink和Spark编写流的脚手架。

- Core:可以使用FlinkSQL来编写简单的业务逻辑

- pump:提供各种连接器

- console:控制台,集成了项目编译、发布、参数配置、启动、保存点、火焰图、监控等功能(重点)

安装StreamPark

- 安装Linux的maven, 可以去检查一下版本目前是否还存在。

- 解压到/opt/moduel目录下

- 创建软链接,连接bin/mvn 和/usr/bin/mvn这两个目录

- 修改镜像源为国内的阿里镜像

- 上传streamPark的jar包

- 将mysql目录下的conncector连接器jar包复制到到streamPark的lib目录下

- 运行建库和建表的脚本

- 修改配置文件application.yml

- profiles.actives: mysql 改为mysql

- 工作目录

- local:/opt/module/stream_park_workspace

- remote: HDFS路径

- 配置mysql.yml

项目部署

- 打开Gitee或gitLab,复制仓库地址

- 复制到仓库地址到StreamPark中,点击构建项目,此时会下载各种依赖jar包,需要等待一会

- 上传common模块的jar包到HDFS中

- 添加作业,使用自定义代码,配置一些常用的参数

- 启动hadoop, yarn, zookeeper,redis等框架

- 发布作业

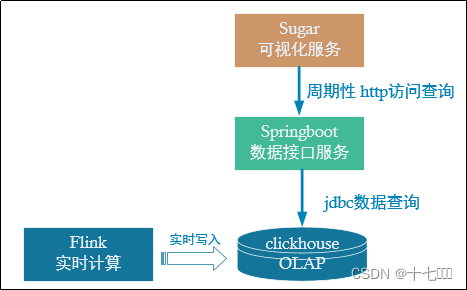

数据接口可视化

dws层已经把轻度聚合的结果保存到了Doris中,后续只要从Doris读取数据再做简单聚合即可。数据可视化主要看面向两种客户:

- 数据开发人员

- 普通客户

Suglar可视化

- 登录百度云,即可免费试用一个月

- 创建空白大屏

- 在数据->静态Json可以查看一下数据展示所需的格式

- 创建gmall-publisher项目,Spring boot架构

- 确定对外的服务端口号为8070,读取Doris数据的端口号为9030

)

笔记)

)

)

7层负载均衡)