近日,来自人工智能创业公司 Petuum 的研究人员发表论文,提出序列生成学习算法的通用框架——广义的熵正则化策略优化框架(Generalized Entropy-Regularized Policy Optimization)。该框架是对包括最大似然学习 (MLE)、增强学习 (RL) 等多种广泛使用的算法的泛化。研究人员进而提出一种新的序列生成算法,该算法在已有算法中进行动态插值,在机器翻译和文本摘要任务中实现了稳定的提升。

序列生成是一个常见的机器学习任务,比如机器翻译、文本摘要、图像字幕生成等。

近日,Petuum 发布论文《Connecting the Dots Between MLE and RL for Sequence Generation》,对多种广泛使用的序列生成学习算法提出了统一的视角,即广义的熵正则化策略优化框架。可以证明这些算法在数学上等同于在框架中设定不同超参数的特例。该研究提供了对不同算法的系统性的理解和对比,并启发更多的算法提升。基于此通用框架,研究人员还提出了一种新的插值算法,在机器翻译和文本摘要任务中实现了稳定的提升。

序列模型的发展(如具备不同单元和注意力机制的循环神经网络)促进了序列生成任务的进步。这些模型通常可以使用多种不同的学习算法进行训练,详见下文。

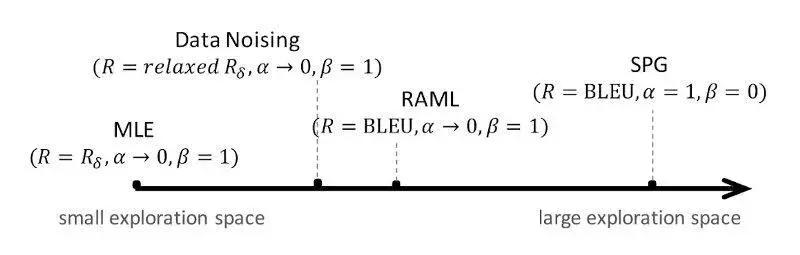

常用的序列生成学习算法(点)

标准的训练算法基于最大似然估计(MLE),即试图最大化真实数据的对数似然(data log-likelihood)。尽管 MLE 训练计算简单、高效,但它会遭遇曝光偏差(exposure bias)。即模型在预测下一个 token 时使用的是真实数据中的 token,而训练出的模型在测试时无法得到真实数据而只能使用模型预测出的 token。这种训练和测试之间的偏差导致预测出现误差,且随着序列长度的增加,这一偏差也会越来越大。

很多研究试图解决该问题,其中一些基于强化学习 (RL)。例如,Ranzato 等人在《Sequence Level Training with Recurrent Neural Networks》中采用策略梯度算法,通过在训练和测试阶段使用同样的解码策略来避免这种偏差。但是,基于 RL 的序列生成方法会面临极低的采样效率和极高的方差。

为了使训练更加可行,其他研究人员提出了多种方法,这些方法介于 MLE 和 RL 之间。例如,RAML 对 MLE 数据样本根据 reward 函数进行扰动,SPG 基于 reward 分布实现策略梯度的高效采样,数据加噪(data noising)等方法也有一定的性能提升。

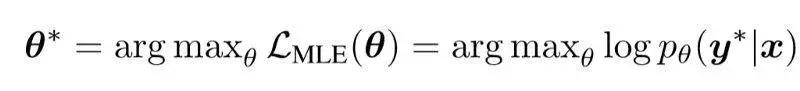

最大似然估计(MLE)

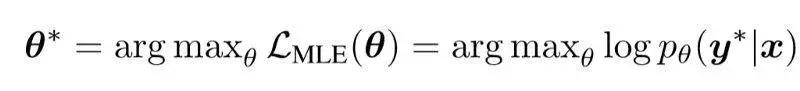

最大似然估计是训练序列生成模型最常用的方法。MLE 旨在寻找最大化数据对数似然的最优参数值:

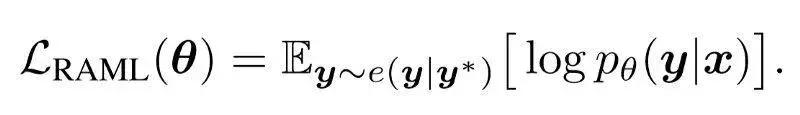

奖励增强最大似然(RAML)

RAML 最初用于将特定任务的 reward(task metric reward)纳入 MLE 训练,该方法相对于原版 MLE 有很大的性能提升。具体来说,RAML 引入了一个指数 reward 分布 e(y|y*) ∝ exp{R(y|y*)},其中 R 指任务度量(如 BLEU)。RAML 最大化以下目标函数:

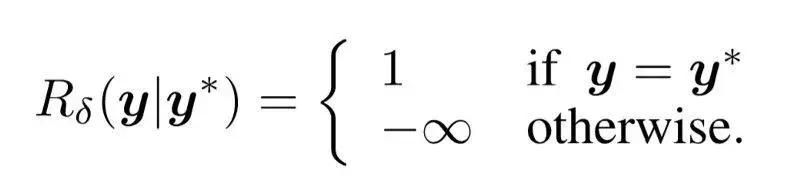

如果我们将 e(y|y*) 中的任务奖励 R 换成 MLE 的 δ 奖励,则 RAML 目标函数等同于原版 MLE 目标函数,即:

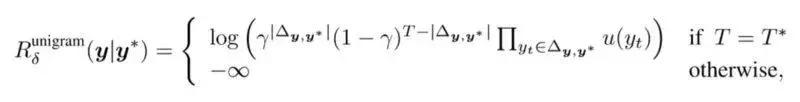

数据加噪

向训练数据添加噪声是常用的正则化方法。之前的研究提出多种适合序列生成 的数据加噪策略。例如,将数据 y* 中的每个 token 以概率 γ 替换成噪声 token,每个噪声 token 随机从一元频率分布(unigram frequency distribution)中采样获得。然后将得到的带噪声数据用于 MLE 训练。形式上来看,它等同于使用奖励函数:

其中 u(·) 表示一元频率分布。使用松弛(即平滑)奖励后,数据加噪一定程度上扩展了原版 MLE 的探索空间。其效果本质上等同于 RAML 算法,区别在于 RAML 基于任务奖励函数来扩展探索空间。

Softmax 策略梯度 (SPG)

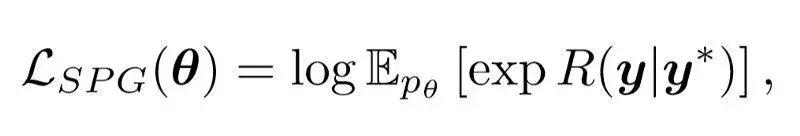

SPG 旨在适应原版策略梯度,用作采样的奖励函数。SPG 的目标函数如下:

其中 R 表示 reward 函数。作为标准策略梯度算法的变体,SPG 旨在解决曝光偏差问题,并表现出了卓越的结果。

图 1:不同算法的有效探索空间。(a):MLE 的探索空间即训练样本的集合。(b):RAML 和数据加噪使用平滑的奖励函数,允许训练样本周围的较大探索空间。(c):常见的策略优化算法(如 SPG)大体上允许全部探索空间。

连点成线

Petuum 对这些学习算法构建了一个统一的视角。具体来说,他们展示了一个广义熵正则化策略优化(ERPO)框架,并证明明显不同的多种算法(如 MLE、RAML、SPG 和数据加噪)都可以重新公式化为该框架中的特殊实例,唯一的区别在于 reward 函数和超参数值的不同选择。

除了对已有算法进行全新诠释以外,该统一视角还推动了新算法的开发。研究人员展示了一个新算法,随着训练的进行,新算法对 reward 函数和超参数值退火,从而逐渐扩展探索空间。退火实际上就是在已有算法中进行动态插值。在机器翻译和文本摘要任务上的实验表明,该插值算法比已有的方法有显著提升。

通用框架

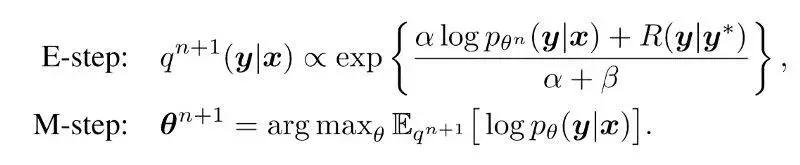

该研究提出的通用框架旨在用常见的数学公式统一上述算法。该框架基于策略优化,策略优化即在模型分布下最大化期望奖励。大量关于熵正则化策略优化(ERPO)的研究通过用信息论正则化项增强策略优化来稳定学习。Petuum 研究人员提出一个 ERPO 的通用公式。假设变量分布为 q(y|x),则我们采用以下目标函数:

其中 (x, y*) 表示训练数据对,y 指在 q(y|x) 分布中采样的句子,KL(·||·) 表示 KL 散度,H(·) 是香农熵,α 和 β表示相应项的均衡权重,pθ 指用 θ 进行参数化的序列生成模型。

使用拉格朗日乘子法,该目标函数可以通过类似 EM 算法的步骤分别优化 q 和θ。在第 n 次迭代时:

现有算法是特殊实例

我们可以将已有的序列生成算法表示为该框架的特殊实例。

最大似然估计(MLE)

使 (R = Rδ, α → 0, β = 1)。如果 y = y*,则 ERPO 的 E-step 中 q(y|x) = 1,反之结果为 0。因此 M-step 与以下公式等价:

可见上式精确地还原了 MLE 的目标函数。

也就是说,MLE 可以看做带有 δ 奖励及上述权重值的策略优化算法的一个实例。任何不能精确匹配数据 y* 的样本 y 都将收到负无穷奖励,从而永远不对模型学习做出贡献。

奖励增强最大似然(RAML)

如果用 MLE δ 奖励取代 e(y|y*) 中的任务奖励 R,则 RAML 目标函数就将等同于原版 MLE 目标函数。MLE 和 RAML 之间的这种关系在 ERPO 中仍然存在。与在 ERPO 中还原 MLE 的方法类似,使 (α → 0, β = 1),但将 R 设置为任务度量奖励,则 ERPO 的 M-step 精确地等同于最大化上述 RAML 目标函数。

数据加噪

数据加噪也可以作为 ERPO 框架中的特殊实例。从取 (R = Rδ, α → 0, β = 1) 的 MLE 的 ERPO 重公式化开始,数据加噪可以用上述一元松弛 Rδ 进行公式化。

Softmax 策略梯度(SPG)

SPG 可以轻松兼容 ERPO 框架。将 SPG 目标函数的梯度设为 θ,我们可以立即得到与 ERPO 相同的更新规则,(α = 1, β = 0, R = common reward)。

注意,SPG 和 RAML 配置中唯一的区别在于现在 α = 1。与 RAML 相比,SPG 利用奖励分布和模型分布使探索空间更向前了一步。从理论上来讲,在训练阶段进行充分的探索将提高测试阶段的性能。然而,随着训练难度的增加,必须使用额外的复杂优化及近似技术(Ding & Soricut, 2017),使训练更加可行。

图 2:不同学习算法的统一表述。每个算法对通用 ERPO 框架来说都是一个特例,采用了超参数 (R, α, β) 的某些特定取值。

应用:插值算法

在广义 ERPO 框架中,一系列常用学习算法都可以被理解为具有三个特定规格超参数 (R, α, β) 的实例。每个算法都可以被视为超参数空间(图 1)中的一个点。通常,具有更受限的奖励函数 R 和非常小的 α 的点具有更小的有效探索空间,并且允许高效学习(如 MLE),相比之下,带有平滑 R 和较大 α 的点将导致更难的学习问题,但允许更高效的探索和更好的测试性能(如 (softmax) 策略梯度)。研究人员在论文中还探索了一种对现有算法进行插值的示例算法。

该插值算法从最受限但最简单的配置 (MLE) 开始学习,并逐渐扩展探索空间以减少和测试阶段之间的差异——由易到难的学习范式。由于已经将常用算法映射到超参数空间中的点,因此插值变得非常简单,只需超参数值的退火。

实验结果

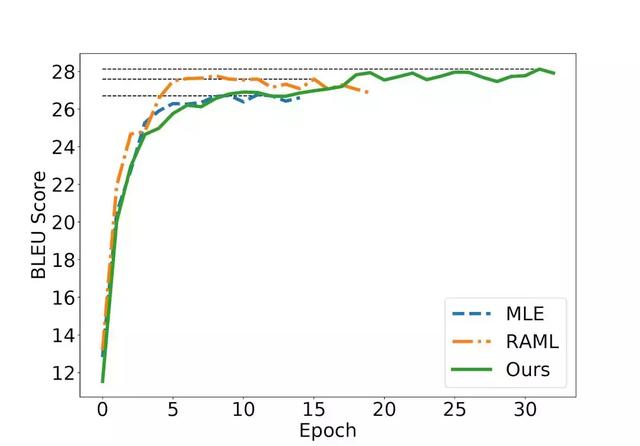

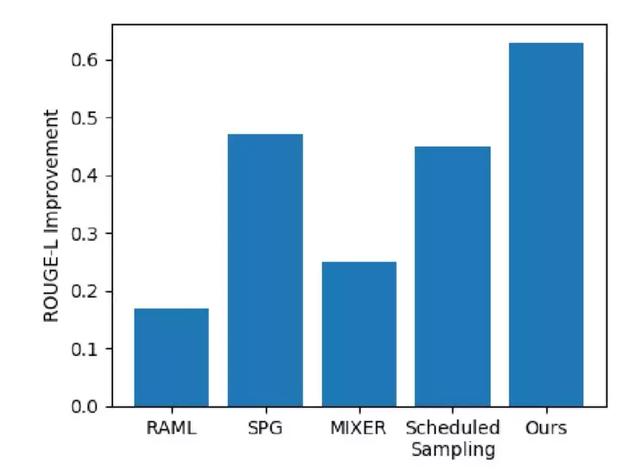

研究人员在机器翻译和文本摘要任务上评估了上述插值算法。如下图所示,与之前的方法相比,该算法达到了更好的效果。

图 3:上图是不同学习算法在机器翻译任务上的收敛曲线。下图是与 MLE 相比,该算法在文本摘要任务上的提升。

论文:Connecting the Dots Between MLE and RL for Sequence Generation

- 论文链接:https://arxiv.org/abs/1811.09740

- 代码:https://github.com/asyml/texar/tree/master/examples/seq2seq_exposure_bias

该研究的代码实现基于 Texar,一个通用、易用的文本生成工具库。

)