我们常常使用深度学习来指训练神经网络的过程。

在这里举一个房屋价格预测的例子:假设有一个数据集,它包含了六栋房子的信息。所以,你知道房屋的面积是多少平方米,并且知道这个房屋的价格。这是,你想要拟合一个根据房屋面积预测房价的函数。

我们使用这些数据拟合一条直线。于是乎,将得到下面这样一条直线。

但是值得注意的是,可能也发现了,我们知道价格永远不会是负数的。因此,为了代替一条可能会让价格为负的拟合直线。我们在快要为零的地方,让他最终在零结束。这条蓝线就是你最终的函数,用于根据房屋大小来预测价格。该函数一部分为零,而直线部分拟合的很好。

作为一个神经网络,这几乎是最简单的神经网络。我们将房屋的大小作为神经网络的输入(x),通过一个节点(一个小圆圈),最终输出了价格(这里我们用y表示)。其实这个小圆圈就是一个单独的神经元。接着你的网络实现了左边这个函数的功能。

在有关神经网络的激活函数中,你不难发现你会经常看到这个函数。从趋近零开始,然后变成一条直线。这个函数被称作为ReLU激活函数,他的全称是Rectified Linear Unit。

从上述例子中,不难发现如果这是一个单神经元网络,不管规模大小,它正式通过把单个神经元叠加在一起形成的。如果将神经元像成单独的乐高积木,你将可以通过搭积木的方式来构建一个更大的神经网络。

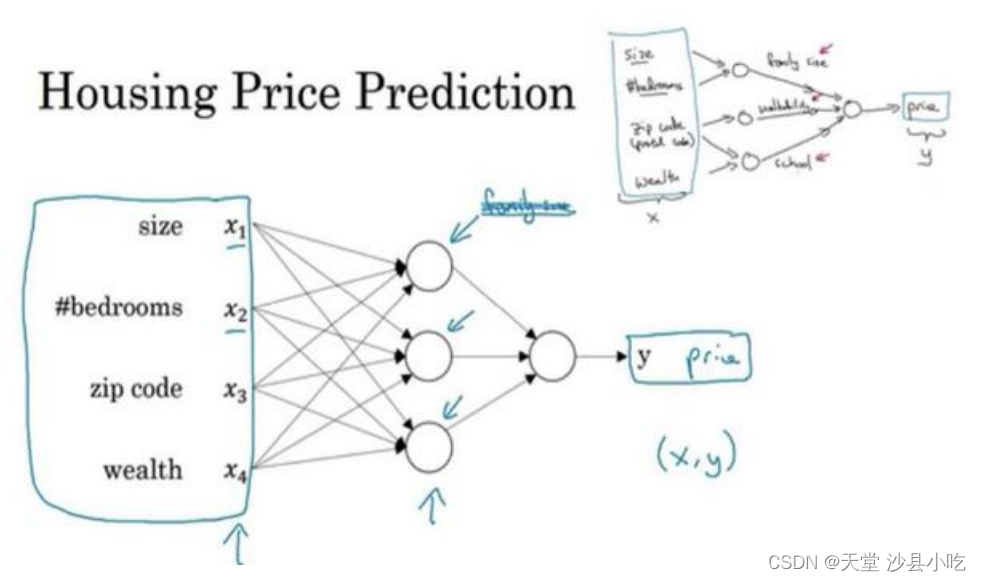

在实际生活中,我们除了用房屋大小来预测他的价格之外,我们还会考虑到房屋的其他特征,比如卧室的数量等。

在图中每一个小圆圈都可以是ReLU的一部分,也就是修正线性单元。基于房屋大小和卧室数量,可以估算家庭人数,基于邮编可以估测步行化程度。最后这些因素将会决定人们乐意花费多少线。

以此为例,x是所有的这四个输入,y是尝试预测的价格,把这些单个的神经元叠加在一起,我们就构成了一个稍微大一点的神经网络。

神经网络的一部分神奇之处在于,当你实现它之后,你要做的只是输入𝑥,就能得到输出𝑦。 因为它可以自己计算你训练集中样本的目以及所有的中间过程。所以,实际上要做的就是:这里有四个输入的神经网络,这输入的特征可能是房屋的大小、卧室的数量、邮政编码和区域的富裕程度。给出这些输入的特征之后,神经网络的工作就是预测对应的价格。同时 也注意到这些被叫做隐藏单元圆圈,在一个神经网络中,它们每个都从输入的四个特征获得自身输入,比如说,第一个结点代表家庭人口,而家庭人口仅仅取决于 x 1 x_1 x1和 x 2 x_2 x2特征,换句话说,在神经网络中,你决定在这个结点中想要得到什么,然后用所有的四个输入来计算想要得到的。

因此,我们说输入层和中间层被紧密的连接起来了。 值得注意的是神经网络给予了足够多的关于𝑥和𝑦的数据,给予了足够的训练样本有关𝑥 和𝑦。神经网络非常擅长计算从𝑥到𝑦的精准映射函数。 这就是一个基础的神经网络。你可能发现你自己的神经网络在监督学习的环境下是如此的有效和强大,也就是说你只要尝试输入一个𝑥,即可把它映射成𝑦,就好像我们在刚才房价预测的例子中看到的效果。

微服务环境搭建)

![[数据结构 -- C语言] 二叉树(BinaryTree)](http://pic.xiahunao.cn/[数据结构 -- C语言] 二叉树(BinaryTree))

)