顾名思义,深度残差收缩网络是由“残差网络”和“收缩”两部分所组成的,是在“残差网络”基础上的一种改进算法。

其中,残差网络在2016年斩获了ImageNet图像识别竞赛的冠军,目前已经成为了深度学习领域的基础网络;收缩就是软阈值化,是许多信号降噪方法的核心步骤。

在深度残差收缩网络中,软阈值化所需要的阈值,本质上是在注意力机制下设置的。

在本文中,我们首先对残差网络、软阈值化和注意力机制的基础知识进行了简要的回顾,然后对深度残差收缩网络的动机、算法和应用展开解读。(转载的)

1. 基础回顾

1.1 残差网络

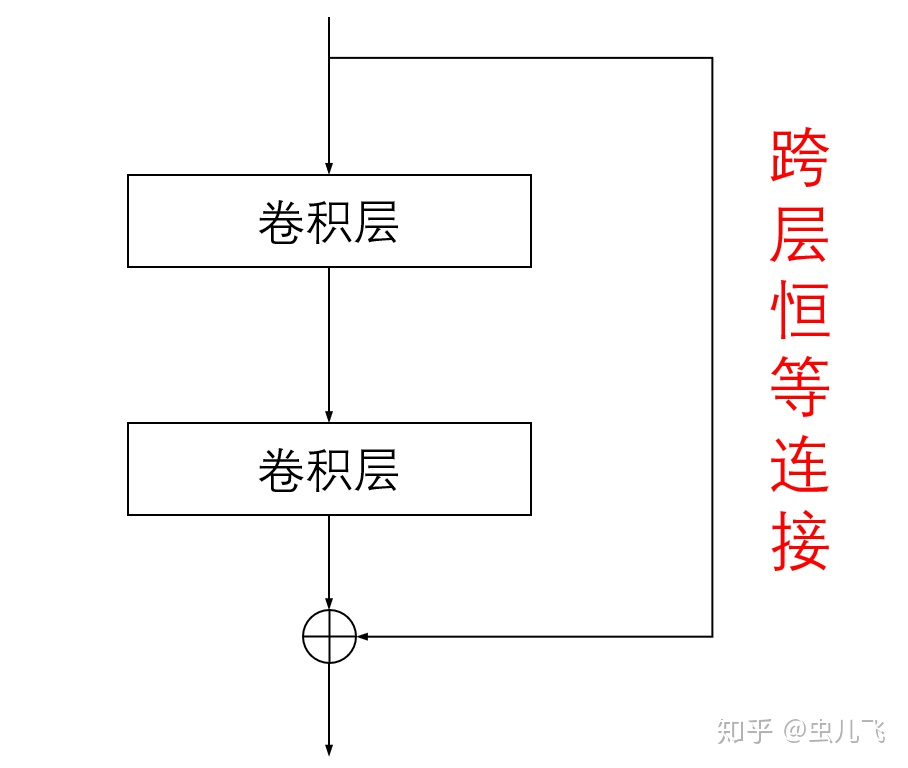

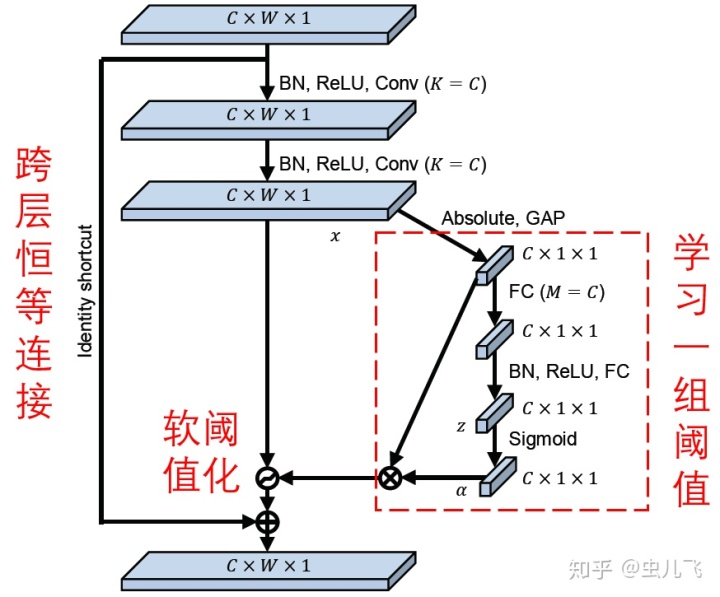

从本质上讲,残差网络(又称深度残差网络、深度残差学习)是一种卷积神经网络。相较于普通的卷积神经网络,残差网络采用了跨层恒等连接,以减轻卷积神经网络的训练难度。残差网络的一种基本模块如图1所示。

1.2 软阈值化

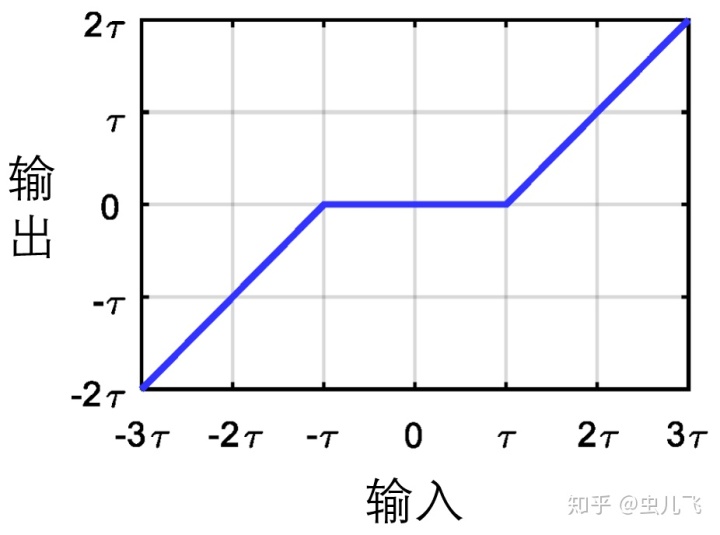

软阈值化是许多信号降噪方法的核心步骤。它的用处是将绝对值低于某个阈值的特征置为零,将其他的特征也朝着零进行调整,也就是收缩。在这里,阈值是一个需要预先设置的参数,其取值大小对于降噪的结果有着直接的影响。软阈值化的输入与输出之间的关系如图2所示。

从图2可以看出,软阈值化是一种非线性变换,有着与ReLU激活函数非常相似的性质:梯度要么是0,要么是1。因此,软阈值化也能够作为神经网络的激活函数。事实上,一些神经网络已经将软阈值化作为激活函数进行了使用。

1.3 注意力机制

注意力机制就是将注意力集中于局部关键信息的机制,可以分为两步:第一,通过扫描全局信息,发现局部有用信息;第二,增强有用信息并抑制冗余信息。

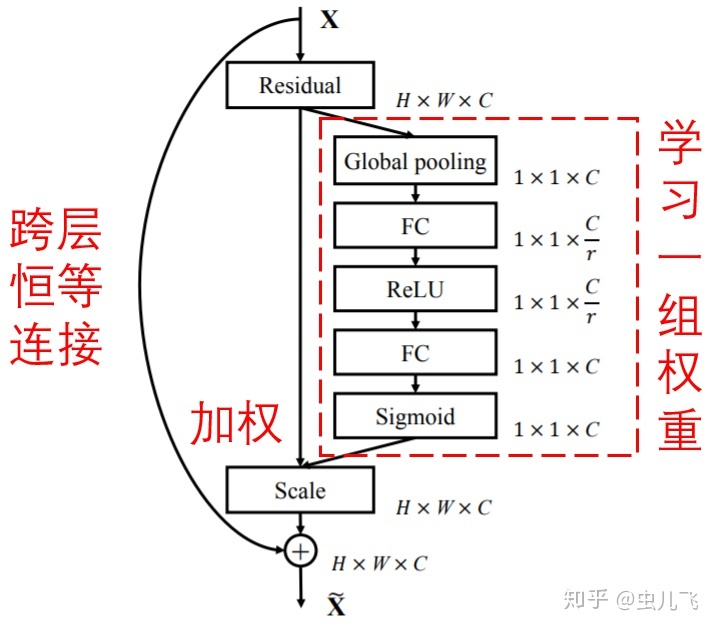

Squeeze-and-Excitation Network是一种非常经典的注意力机制下的深度学习方法。它可以通过一个小型的子网络,自动学习得到一组权重,对特征图的各个通道进行加权。其含义在于,某些特征通道是比较重要的,而另一些特征通道是信息冗余的;那么,我们就可以通过这种方式增强有用特征通道、削弱冗余特征通道。Squeeze-and-Excitation Network的一种基本模块如下图所示。

值得指出的是,通过这种方式,每个样本都可以有自己独特的一组权重,可以根据样本自身的特点,进行独特的特征通道加权调整。例如,样本A的第一特征通道是重要的,第二特征通道是不重要的;而样本B的第一特征通道是不重要的,第二特征通道是重要的;通过这种方式,样本A可以有自己的一组权重,以加强第一特征通道,削弱第二特征通道;同样地,样本B可以有自己的一组权重,以削弱第一特征通道,加强第二特征通道。

2. 深度残差收缩网络理论

2.1 动机

首先,现实世界中的数据,或多或少都含有一些冗余信息。那么我们就可以尝试将软阈值化嵌入残差网络中,以进行冗余信息的消除。

其次,各个样本中冗余信息含量经常是不同的。那么我们就可以借助注意力机制,根据各个样本的情况,自适应地给各个样本设置不同的阈值。

2.2 算法

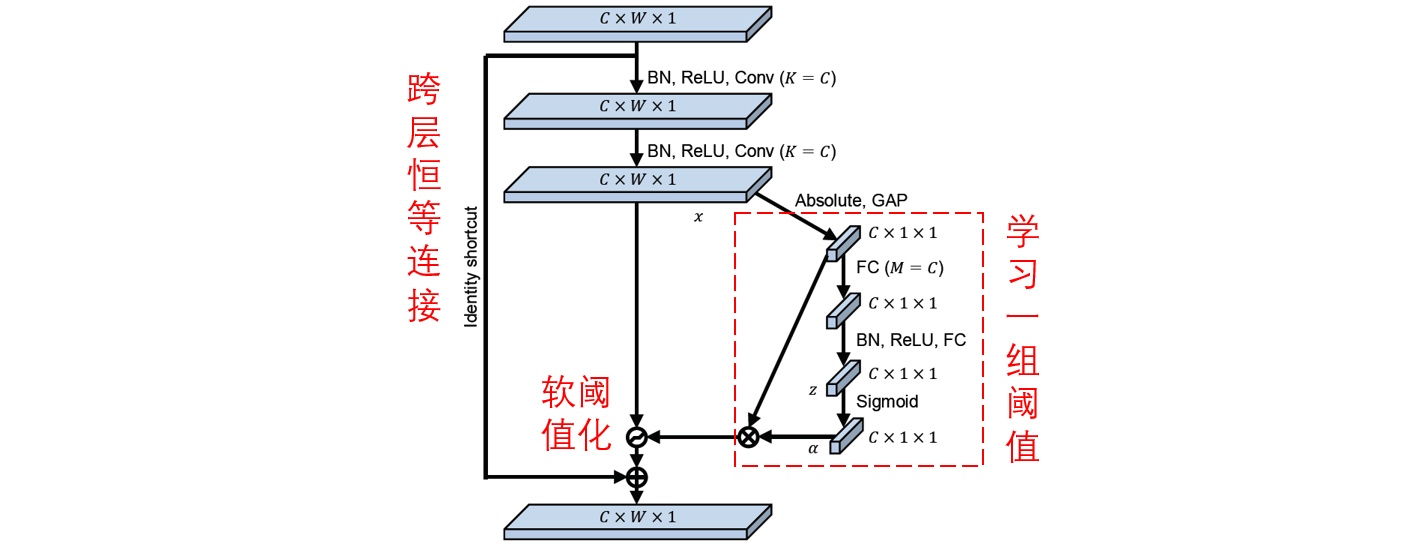

与残差网络和Squeeze-and-Excitation Network相似,深度残差收缩网络也是由许多基本模块堆叠而成的。每个基本模块都有一个子网络,用于自动学习得到一组阈值,用于特征图的软阈值化。值得指出的是,通过这种方式,每个样本都有着自己独特的一组阈值。深度残差收缩网络的一种基本模块如下图所示。

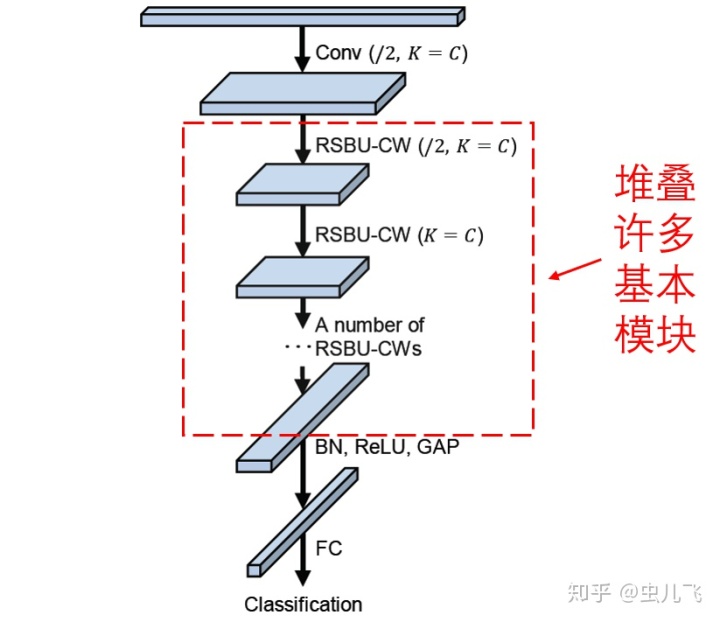

深度残差收缩网络的整体结构如下图所示,是由输入层、许多基本模块以及最后的全连接输出层等组成的。

2.3 应用

在论文中,深度残差收缩网络是应用于基于振动信号的旋转机械故障诊断。但是从原理上来讲,深度残差收缩网络面向的是数据集含有冗余信息的情况,而冗余信息是无处不在的。例如,在图像识别的时候,图像中总会包含一些与标签无关的区域;在语音识别的时候,音频中经常会含有各种形式的噪声。因此,深度残差收缩网络,或者说这种“注意力机制”+“软阈值化的思路,有着较为广泛的研究价值和应用前景。

参考文献

M. Zhao, S, Zhong, X. Fu, et al. Deep residual shrinkage networks for fault diagnosis. IEEE Transactions on Industrial Informatics, 2019, DOI: 10.1109/TII.2019.2943898

https://ieeexplore.ieee.org/document/8850096/ieeexplore.ieee.org源代码

zhao62/Deep-Residual-Shrinkage-Networksgithub.com

-原创力文档...)

?)

)