一、环境准备

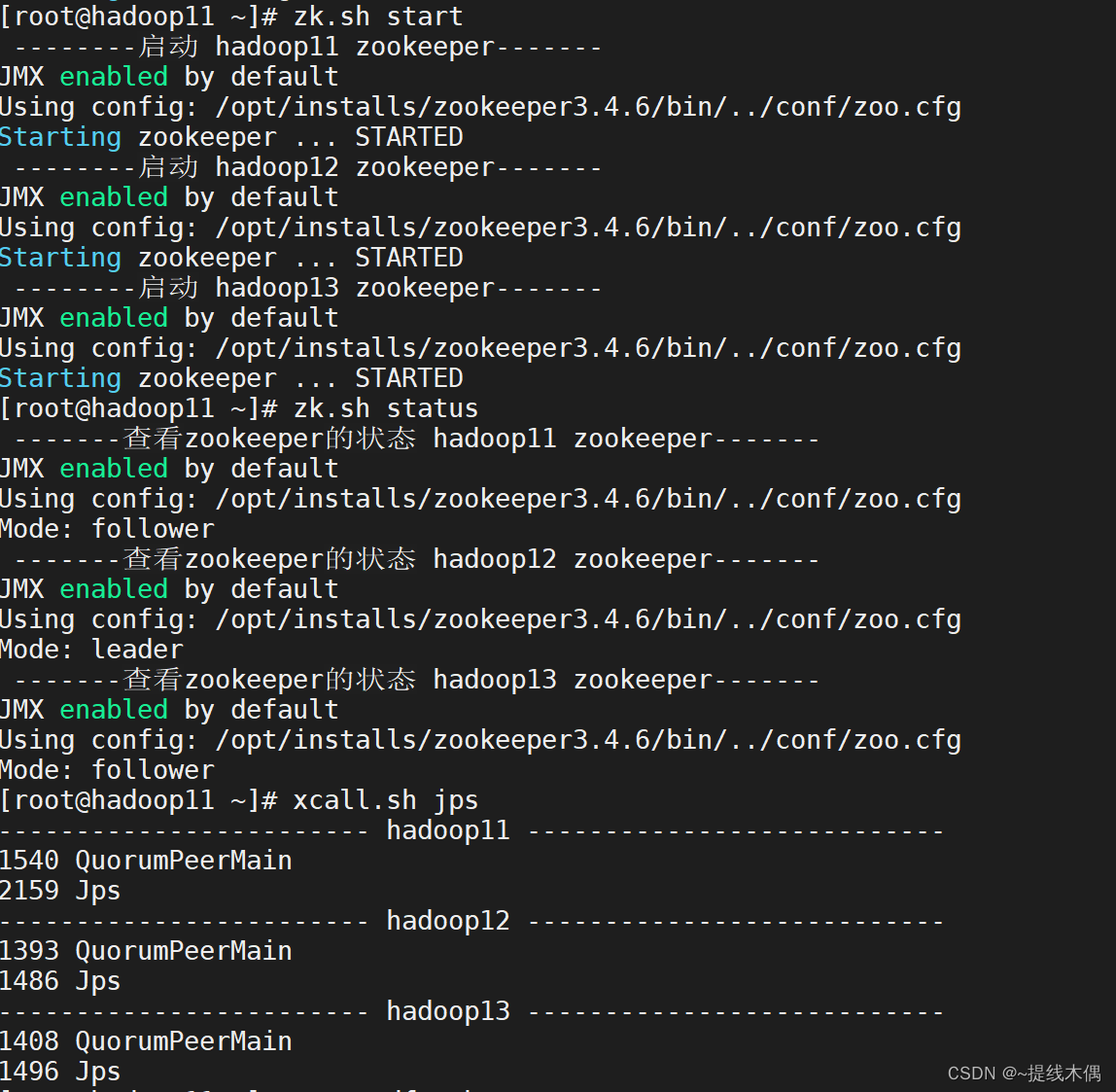

启动zookeeper

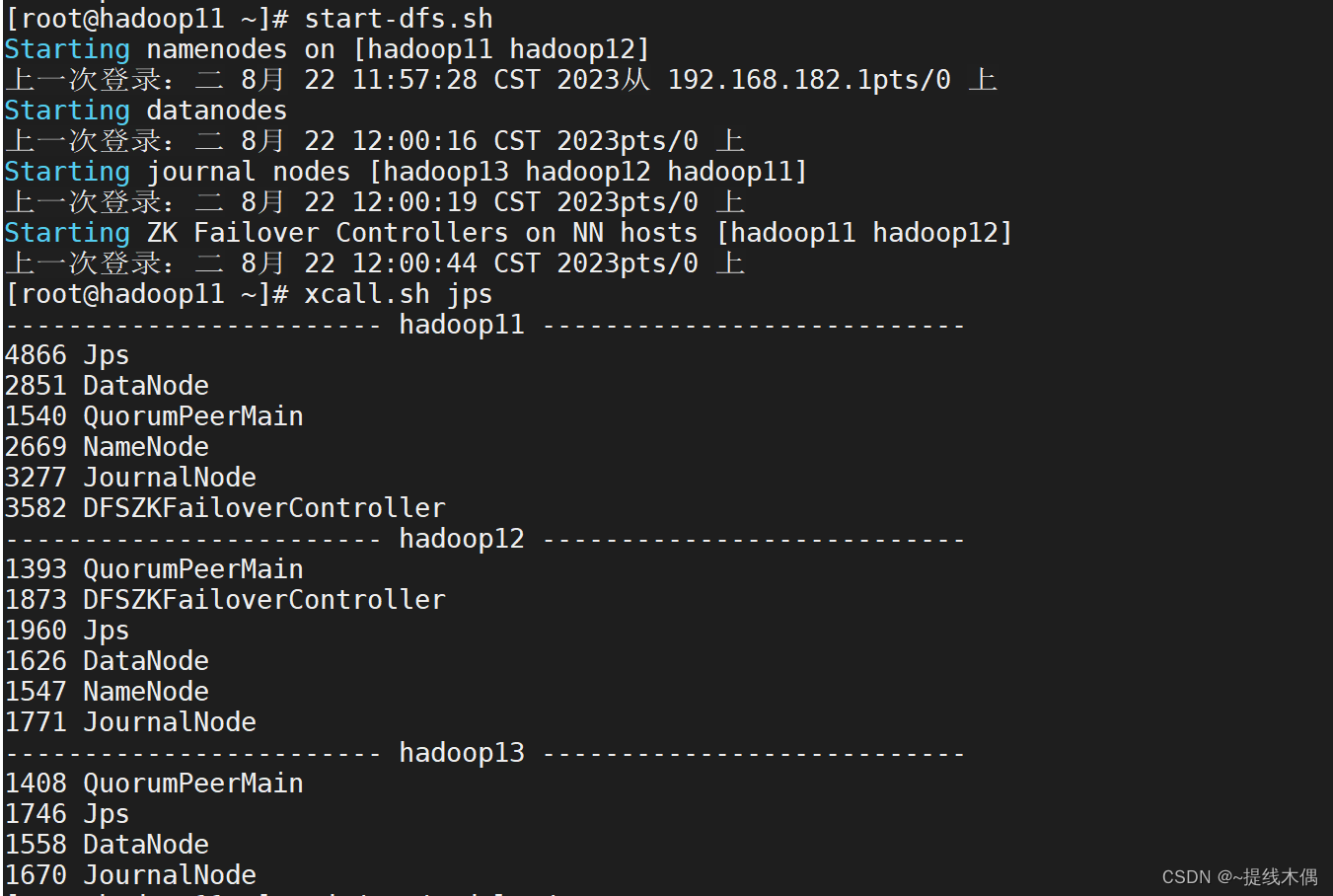

启动hdfs

二、安装

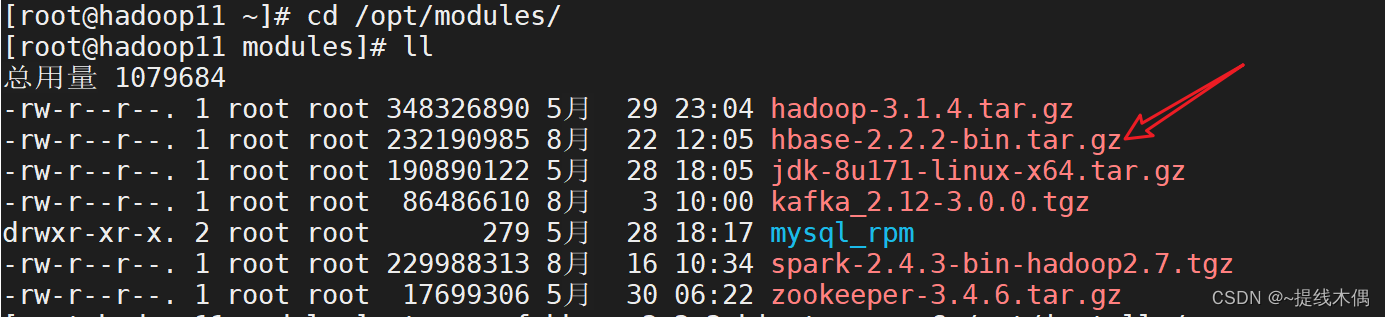

上传安装包

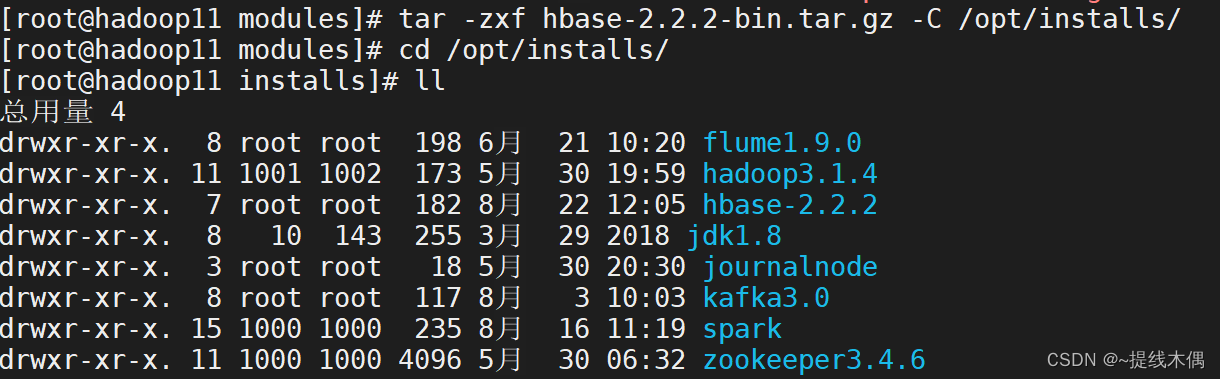

1、解压

tar -zxf hbase-2.2.2-bin.tar.gz -C /opt/installs/

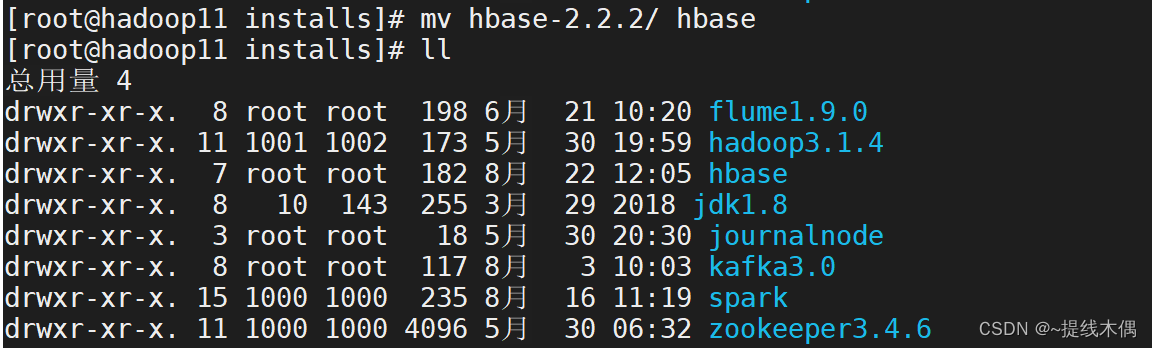

2、更名

mv hbase-2.2.2/ hbase

3、配置环境变量

[root@hadoop11 conf]# vim /etc/profile

export HBASE_HOME=/opt/installs/hbase

export PATH=$PATH:$HBASE_HOME/bin[root@hadoop11 conf]# source /etc/profile

修改配置文件

hbase-env.sh

export JAVA_HOME=/opt/installs/jdk1.8

export HBASE_MANAGES_ZK=false

hbase-site.xml

<property><name>hbase.rootdir</name><value>hdfs://hdfs-cluster/hbase</value><description>配置HBase的数据存放在HDFS中</description></property><property><name>hbase.cluster.distributed</name><value>true</value><description>开启HBase的分布式模式</description></property><property><name>hbase.zookeeper.quorum</name><value>hadoop11:2181,hadoop12:2181,hadoop13:2181</value><description>配置HBase使用真实的zookeeper的目录</description></property><property><name>hbase.unsafe.stream.capability.enforce</name><value>false</value></property>

regionservers

hadoop11

hadoop12

hadoop13

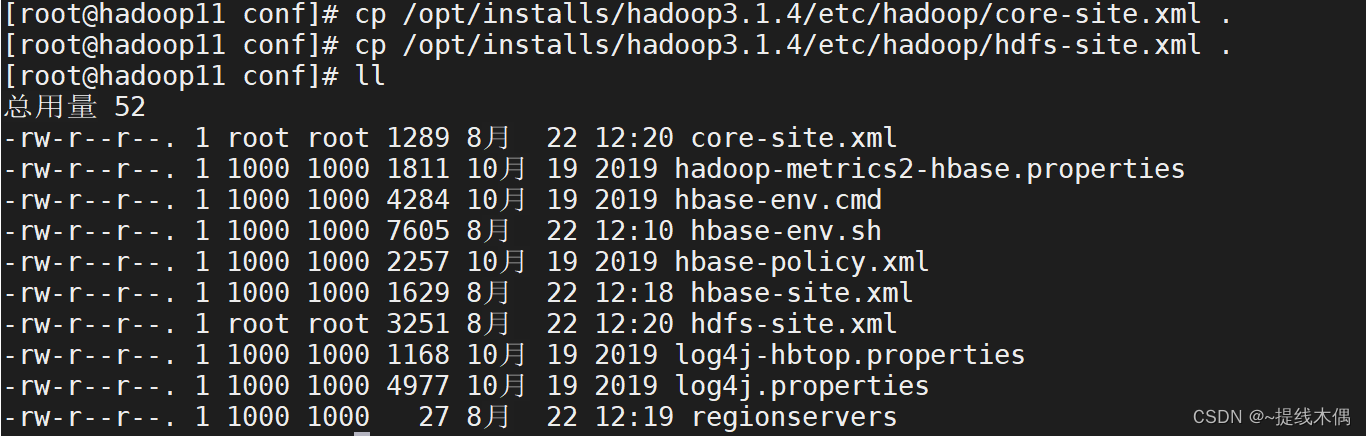

将hdfs的core-site.xml和hdfs-site.xml复制到hbase的conf目录下

[root@hadoop11 conf]# cp /opt/installs/hadoop3.1.4/etc/hadoop/core-site.xml .

[root@hadoop11 conf]# cp /opt/installs/hadoop3.1.4/etc/hadoop/hdfs-site.xml .

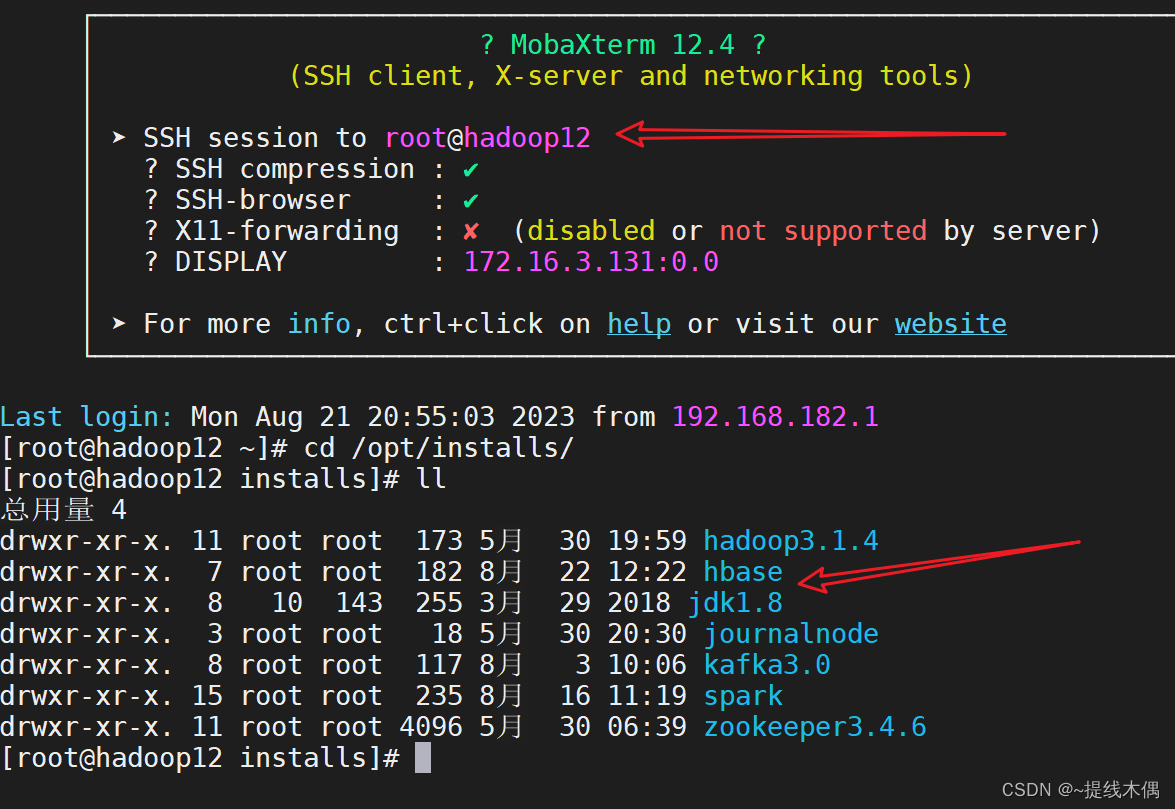

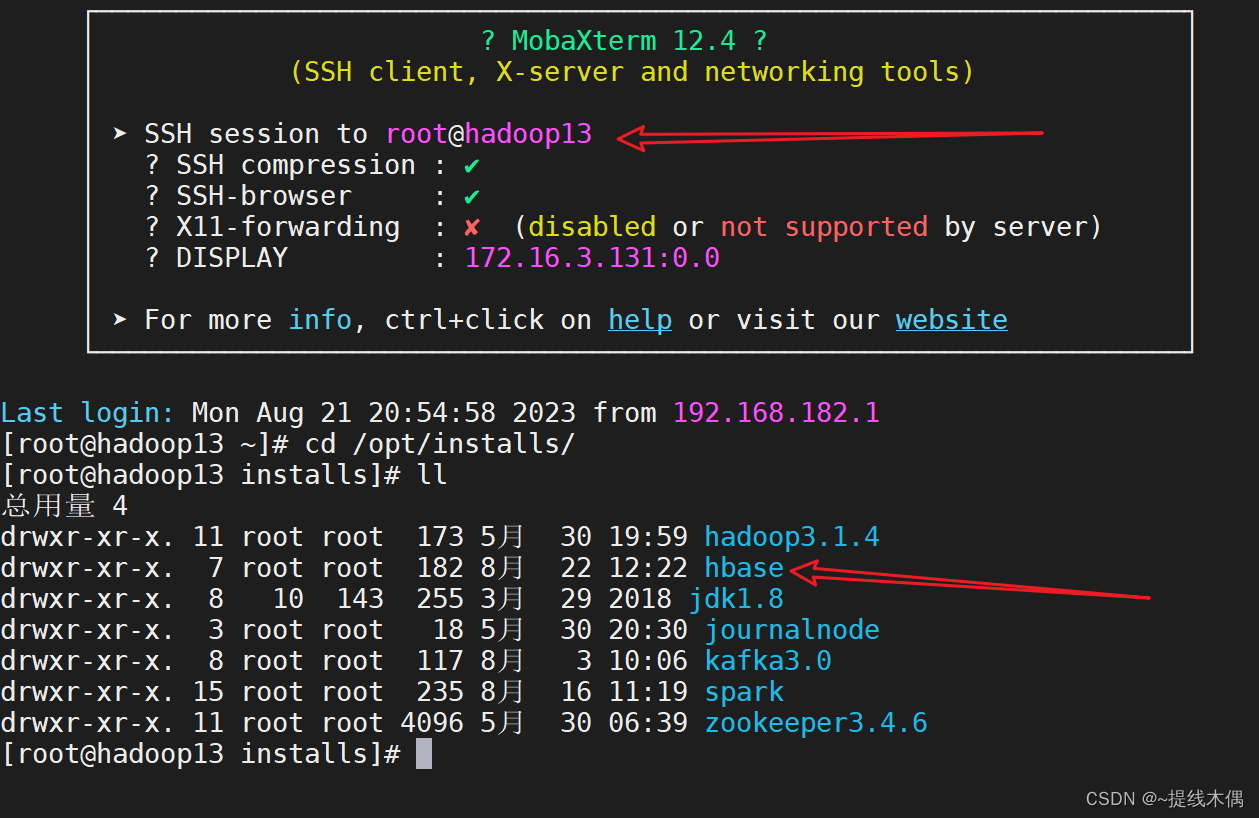

把Hbase分发到三台机器上

myscp.sh /opt/installs/hbase/ /opt/installs/

配置hadoop12 13的环境变量

vim /etc/profile

加载环境变量

source /etc/profile

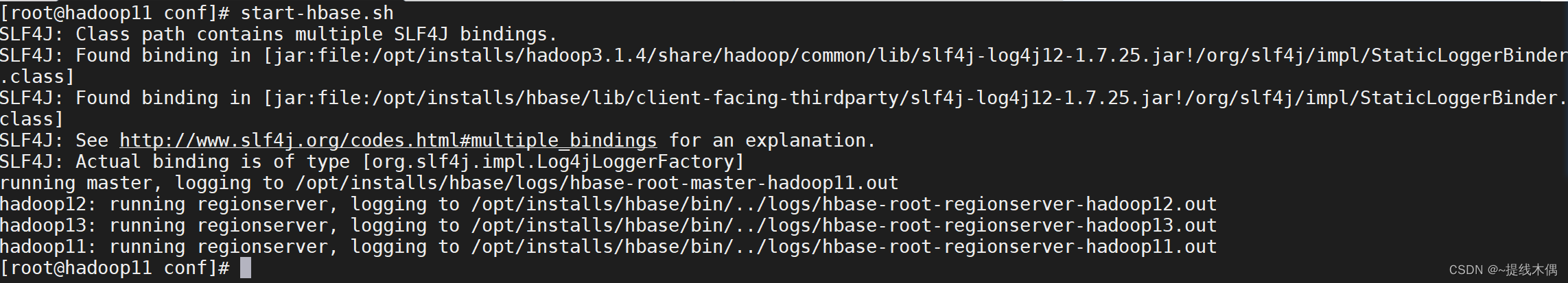

启动Hbase

在hadoop11上

start-hbase.sh

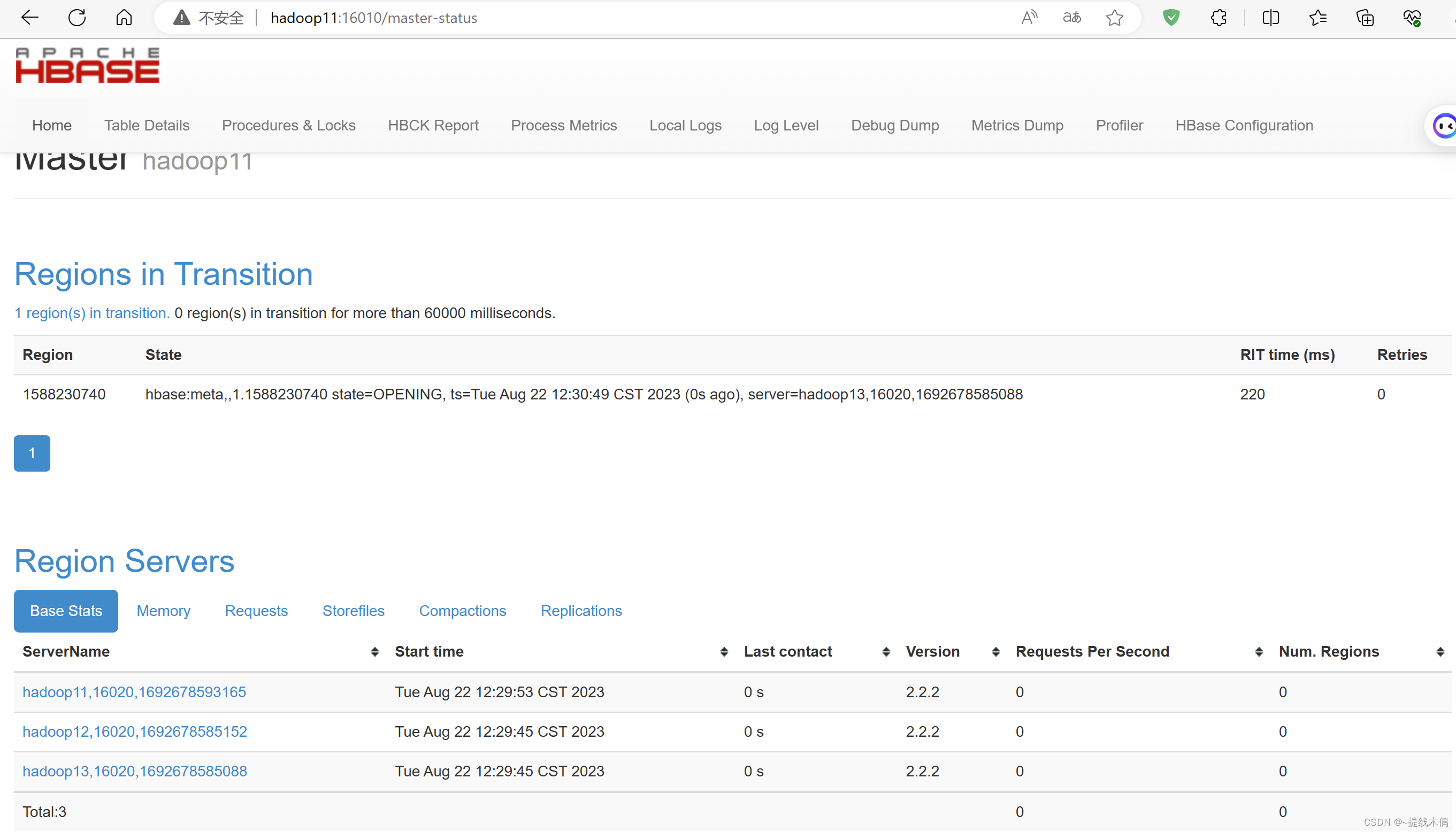

访问页面,验证是否成功

http://hadoop11:16010/

)

)