VIT:https://blog.csdn.net/qq_37541097/article/details/118242600

Swin Transform:https://blog.csdn.net/qq_37541097/article/details/121119988

一、VIT

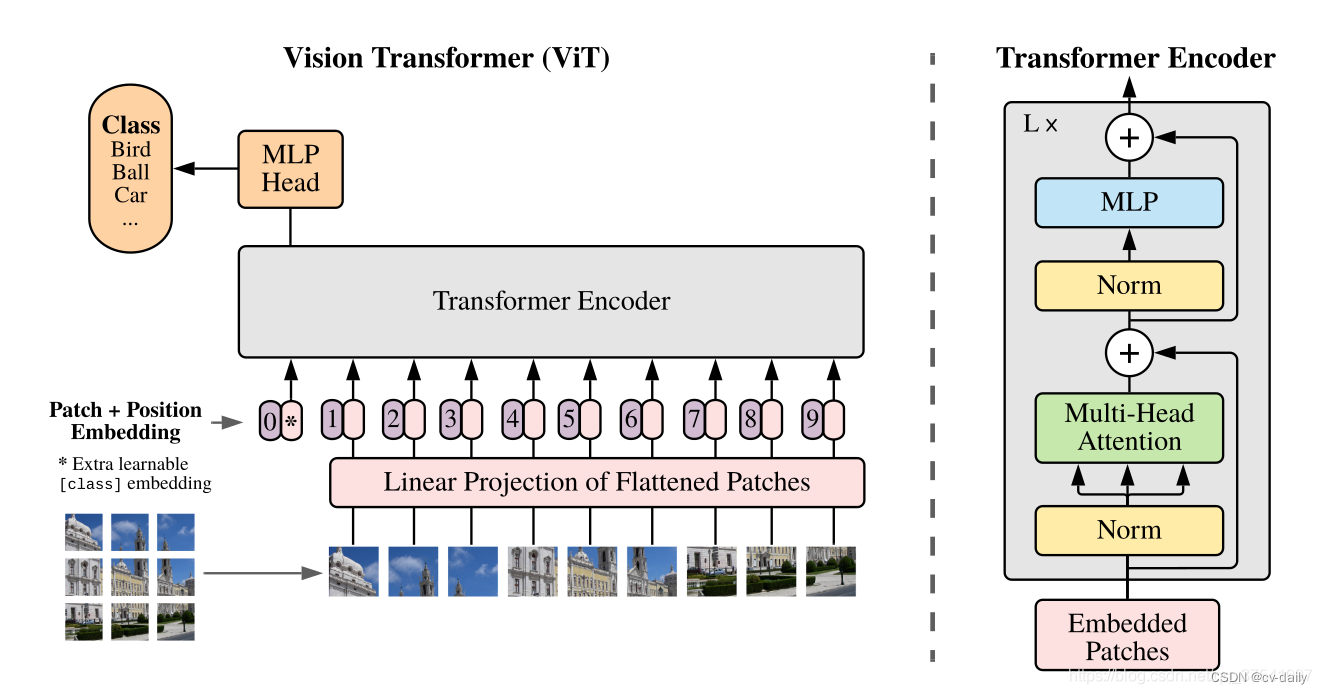

模型由三个模块组成:

Linear Projection of Flattened Patches(Embedding层)

Transformer Encoder(图右侧有给出更加详细的结构)

MLP Head(最终用于分类的层结构)

Embedding模块:

ViT-B/16为例,每个token向量长度为768。要求输入的token必须是二维的。需要把三维的图片信息转成二维。

以ViT-B/16为例,直接使用一个卷积核大小为16x16,步距为16,卷积核个数为768的卷积来实现。通过卷积[224, 224, 3] -> [14, 14, 768],然后把H以及W两个维度展平即可[14, 14, 768] -> [196, 768],此时正好变成了一个二维矩阵,正是Transformer想要的。

还要有一个用于分类的token,长度与其他token保持一致。与之前从图片中生成的tokens拼接在一起,Cat([1, 768], [196, 768]) -> [197, 768]。

Transformer Encoder模块:

VIT Swin Transformer

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.mzph.cn/news/51128.shtml

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

星际争霸之小霸王之小蜜蜂(六)--让子弹飞

目录

前言 一、添加子弹设置 二、创建子弹 三、创建绘制和移动子弹函数 四、让子弹飞 五、效果 总结 前言 小蜜蜂的基本操作已经完成了,现在开始编写子弹的代码了。 一、添加子弹设置 在我的预想里,我们的小蜜蜂既然是一只猫,那么放出的子弹…

List的流操作结合hutool的最优雅处理,处理前端所需要的参数定制化返回给前端

前言: java用于服务器端是很方便的,特别是对于前后端分离的项目来说.经常需要对接前端写接口,有时候前端要接口必须得一次性查出来数据,那就得处理从数据库查询到的数据了,下面就是如何更加高效更加优雅的处理数据,这里用到了hutool的方法,这篇文章主要就是让大家如何快速的去处…

微信小程序开发教学系列(1)- 开发入门

第一章:微信小程序简介与入门

1.1 简介

微信小程序是一种基于微信平台的应用程序,可以在微信内直接使用,无需下载和安装。它具有小巧、高效、便捷的特点,可以满足用户在微信中获取信息、使用服务的需求。

微信小程序采用前端技…

自定义WEB框架结合Jenkins实现全自动测试

自定义WEB框架结合Jenkins实现全自动测试 allure生成 allure生成

1.allure–纯命令运行 -固定的–稍微记住对应的单词即可。2 安装,2个步骤: 1.下载allure包,然后配置环境变量。 https://github.com/allure-framework/allure2/releases/tag/2.22.4 2.在…

mysql 、sql server 临时表、表变量、

sql server 临时表 、表变量 mysql 临时表 创建临时表 create temporary table 表名 select 字段 [,字段2…,字段n] from 表

leetcode 355 设计推特

用链表存储用户发送的每一个推特,用堆获取最先的10条动态

class Twitter {Map<Integer,Set<Integer>> followMap;//规定最新的放到最后Map<Integer,Tweet> postMap;//优先队列(堆)PriorityQueue<Tweet> priorityQueue;int time…

[JavaWeb]【十】web后端开发-SpringBootWeb案例(配置文件)

目录

一、参数配置化

1.1 问题分析

1.2 问题解决(application.properties)

1.2.1 application.properties 1.2.2 AliOSSUtils

1.2.3 启动服务-测试

二、yml配置文件

2.1 配置格式

2.1.1 新增 application.yml

2.1.2 启动服务

2.2 XML与prope…

LeetCode438.找到字符串中所有字母异位词

因为之前写过一道找字母异位词分组的题,所以这道题做起来还是比较得心应手。我像做之前那道字母异位词分组一样,先把模板p排序,然后拿滑动窗口去s中从头到尾滑动,窗口中的这段字串也给他排序,然后拿这两个排完序的stri…

Python 基础 -- Tutorial(三)

7、输入和输出

有几种方法可以表示程序的输出;数据可以以人类可读的形式打印出来,或者写入文件以备将来使用。本章将讨论其中的一些可能性。

7.1 更花哨的输出格式

到目前为止,我们已经遇到了两种写值的方法:表达式语句和print()函数。(第三种方法是使…

等保测评--安全区域边界--测评方法

安全子类--边界防护

a) 应保证跨越边界的访问和数据流通过边界设备提供的受控接口进行通信;

一、测评对象

网闸、防火墙、路由器、交换机和无线接入网关设备等提供访问控制功能的设备或相关组件

二、测评实施

1)应核查在网络边界处是否部署访问控制设备&#x…

【SA8295P 源码分析】13 - Android GVM 虚拟机 QUPv3 UART / SPI / I2C功能配置及透传配置

【SA8295P 源码分析】13 - Android GVM 虚拟机 QUPv3 UART / SPI / I2C功能配置及透传配置 一、QUP v3 介绍二、QUP v3 UART 功能配置2.1 TrustZone 域 Uart 资源权限配置:以 QUPV3_0_SE2 为例2.2 QNX Host 域关闭 Uart 资源:以 QUPV3_0_SE2 为例2.3 Android Kernel 域使能 U…

GEE/PIE 遥感大数据处理与典型案例

查看原文>>>【399三天】GEE/PIE遥感大数据处理与典型案例实践

随着航空、航天、近地空间等多个遥感平台的不断发展,近年来遥感技术突飞猛进。由此,遥感数据的空间、时间、光谱分辨率不断提高,数据量也大幅增长,使其越来…

python中的matplotlib画散点图(数据分析与可视化)

python中的matplotlib画散点图(数据分析与可视化)

import numpy as np

import pandas as pd

import matplotlib.pyplot as pltpd.set_option("max_columns",None)

plt.rcParams[font.sans-serif][SimHei]

plt.rcParams[axes.unicode_minus]Fa…

我的动态归纳(便于搜索)

linux dns配置文件是“/etc/resolv.conf”,该配置文件用于配置DNS客户,它包含了主机的域名搜索顺序和DNS/服务器的地址,每一行包括一个关键字和一个或多个空格隔开的参数。 /etc/resolv.conf (不配置就不能域名解析) 可…

完全免费的GPT,最新整理,2023年8月24日,已人工验证,不用注册,不用登录,更不用魔法,点开就能用

完全免费的ChatGPT,最新整理,2023年8月24日,已人工验证,

不用注册,不用登录,更不用魔法,点开就能用! 第一个:网址地址统一放在文末啦!文末直达 看上图你就能…

Spring Boot+Atomikos进行多数据源的分布式事务管理详解和实例

文章目录 0.前言1.参考文档2.基础介绍3.步骤1. 添加依赖到你的pom.xml文件:2. 配置数据源及其对应的JPA实体管理器和事务管理器:3. Spring BootMyBatis集成Atomikos4. 在application.properties文件中配置数据源和JPA属性: 4.使用示例5.底层原理 0.前言 背景&#x…

YOLO目标检测——足球比赛中球员检测数据集下载分享

足球比赛中球员检测数据集,真实场景的高质量图片数据,数据场景丰富,图片格式为jpg,共500张图片 数据集点击下载:YOLO足球比赛中球员检测数据集500图片.rar

[时序数据库]:InfluxDB进阶

文章目录 1 摘要2 背景2.1 问题一:针对Influx V2.0工具2.2 问题二:针对Influx查询语言 3 需求分析4 快速入门4.1 客户端驱动版本选择4.2 连接influx4.2.1 influx配置信息4.2.2 influx连接配置4.2.3 测试连通情况 5 Influx工具类5.1 InfluxQL工具类5.1.1 …

前端进阶Html+css10----定位的参照对象(高频面试题)

1.relative的参照对象 1)元素按照标准流进行排布; 2)定位参照对象是元素自己原来的位置,可以通过left、right、top、bottom来进行位置调整;

2.absolute(子绝父相) 1)元素脱离标准流…

--让子弹飞)

- 开发入门)

![[JavaWeb]【十】web后端开发-SpringBootWeb案例(配置文件)](http://pic.xiahunao.cn/[JavaWeb]【十】web后端开发-SpringBootWeb案例(配置文件))

)

)

)

)

![[时序数据库]:InfluxDB进阶](http://pic.xiahunao.cn/[时序数据库]:InfluxDB进阶)

)