进入安装sparkclient的节点

hdfs准备一个文件

su - hdfs

vi text.txt

随便写几行东西

#创建目录

hdfs dfs -mkdir /user/hdfs/test

#上传文件

hdfs dfs -put test.txt /user/hdfs/test/

#检查文件是否在

hdfs dfs -ls /user/hdfs/test/

#检查内容是否对

hdfs dfs -cat /user/hdfs/test/test.txt

spark在yarn上运行参见官方文档

http://spark.apache.org/docs/latest/running-on-yarn.html

进入spark-shell

spark-shell --master yarn --deploy-mode client

统计下

scala> sc.textFile("/user/hdfs/test/test.txt").count()

res0: Long = 7

scala> sc.stop()

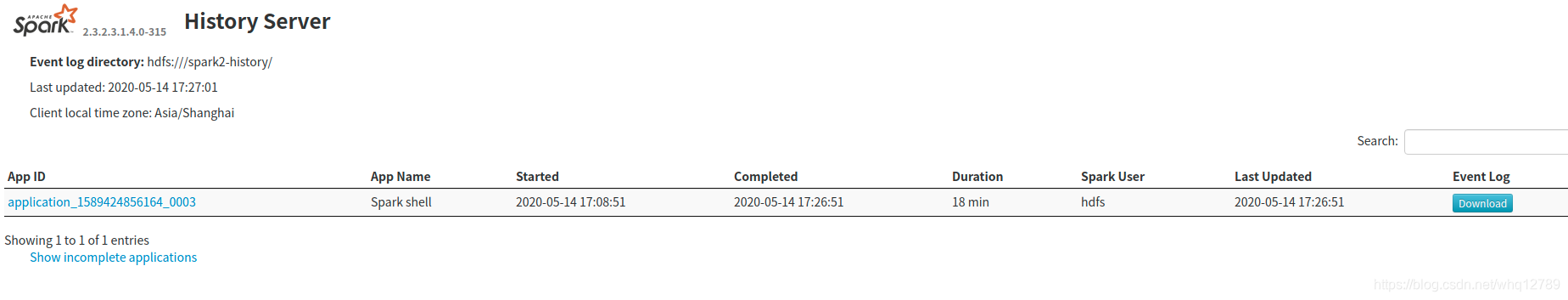

再次刷新Spark History Server页面即可

http://192.168.128.55:18081/?showIncomplete=false

spark-submit提交任务到yarn

spark-submit --class org.whq.sparkTest.MLTest1 \

--master yarn \

--deploy-mode cluster \

--driver-memory 4g \

--executor-memory 2g \

--executor-cores 1 \

--queue default \

spark244test_2.11-0.1.jar \

10

--deploy-mode cluster集群模式,多个application,每个application启动一个Driver在集群的多台worker(NodeManager)上启动。

--deploy-mode client客户端模式,多个application,每个application启动一个Driver只在本机运行,与集群产生大量通讯。