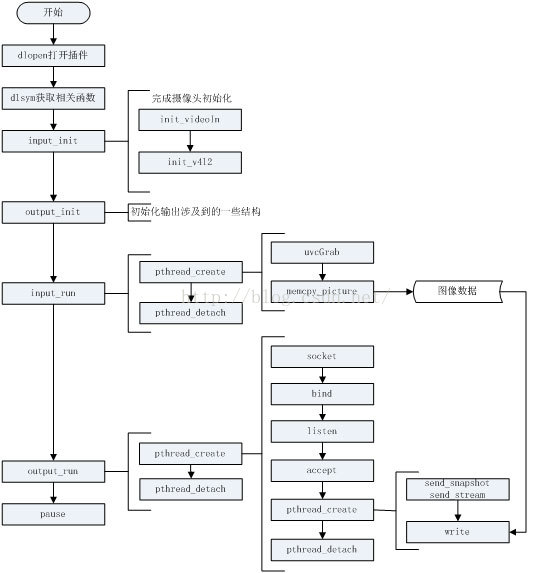

mjpg-streamer程框架图如下所示:

程序运行起来后,主进程根据传入的参数设置的输入输出通道打开对应的输入输出动态链接库,并依次调用以下函数

1、输入---仓库-----输出(mjpg-streamer.h)

(1)global结构体

stop为停止标志位,置1时程序停止运行;

db和db_update分别为互斥锁和条件变量,两者用于线程同步,当输入通道把数据放入仓库后,通知输出通道来取数据

仓库对应的是buf指针,仓库的大小是size.

输出对应的是output结构体(输出插件)

outcnt表示当前输出通道中有几种方式

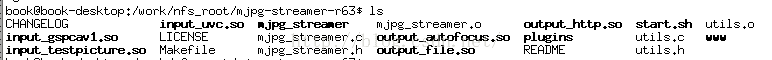

(2)mjpg-streamer-r63文件

.so文件是插件,可能是输入插件(前面带有input字样),也可能是输出插件(前面带有output插件)。

运行mjpg_streamer时通过命令行mjpg_streamer -i "input_uvc.so -f 10 -r 320*240" -o "output_http.so -w www"指定输入输出通道

由于用的是USB摄像头来采集数据,因此选择input_uvc.so输入插件作为输入渠道(如上所示,通过-i指定哪一个插件作为输入渠道)。

由于我们要用的是网页显示,因而选择output_http.so输出插件作为输出渠道。(如上图所示,通过-o选项指定哪一个插件作为输出渠道)

(3)主函数通过解析命令行-i "input_uvc.so -f 10 -r 320*240“ ,打开对应的input_uvc.so动态链接库

通过dlopen函数打开动态链接库

(4) 主函数通过解析命令行-o "output_http.so -w www" ,打开对应的out_http.so动态链接库

2、输入插件和输出插件所做的工作

(1)输入插件1(input_uvc.c文件)

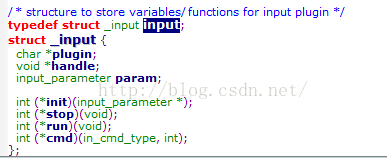

input结构体

(2)输入插件2

init函数

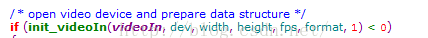

主要执行init_videoIn函数

传入参数宽度width ,高度height,帧率fps,格式format

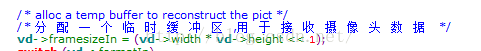

init_videoIn所做工作:①调用init_v4l2函数(通过V4L2提供的一系列的ioctl来设置摄像头的分辨率,帧率,以及摄像头的输出格式,并分配缓冲区然后映射到应用程序空间videoIn->mem[i]);②分配一个临时缓冲区videoIn->tmpbuffer,用于接收摄像头数据(摄像头数据流向为:videoIn->mem[i] -----> videoIn->tmpbuffer -----> globals->buf(我们所说的仓库) ---------->输出通道取出数据外发)

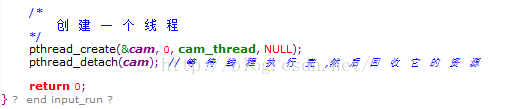

run函数

主要执行创建线程函数参数里面的cam_thread函数

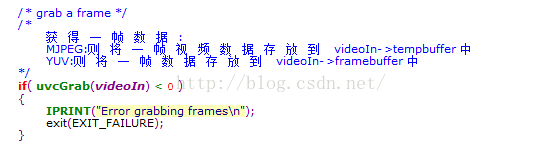

所做工作:调用uvcGrab函数(该函数把一帧数据从拷贝videoIn->mem[i] 里拷贝到videoIn->tmpbuffer)获取一帧数据

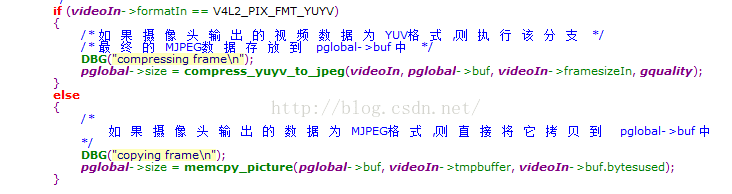

判断获得数据的格式,如果输入数据格式是MJPEG格式,直接把它拷贝到 global结构体的buf里面(也就是放入仓库);如果是YUV格式,要把YUV格式数据转变成MJPEG格式的数据再拷贝到global结构体的buf里面(也就是放入仓库globals->buf)

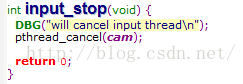

stop函数

做一些清理工作

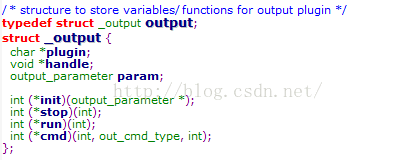

(3)输出插件1

output结构体

(4)输出插件2

init函数

socket编程以及用socket来模拟http协议,因此做socket的一些初始化工作,如端口号

run函数

从仓库中取出数据,存到一个缓冲区中,然后通过write函数将数据发送出去,供手机或其他设备接收

stop函数

做一些清理工作

本文参考链接:

https://blog.csdn.net/qingkongyeyue/article/details/52400036

https://blog.csdn.net/qingkongyeyue/article/details/52401514

https://blog.csdn.net/qingkongyeyue/article/details/52824165

)