虚拟网络排查问题困难,传统的traceroute等工具很难起到太大作用,大部分情况下都需要到宿主机、混合云网关上抓包来troubleshooting,耗时又费力。有些场景中包的传送路径比较长(如跨域、混合云等),可能丢包的地方比较多,更增加了故障排查的难度。

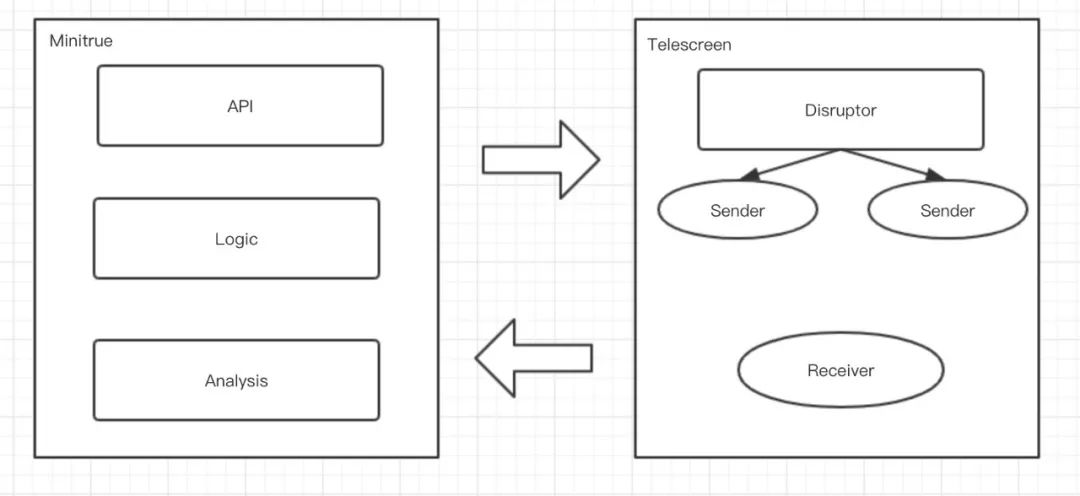

为此,我们设计了一款支持全链路大规模的网络连通性内部检测系统BigBrother。基于TCP报文的染色可将检测报文和用户流量区分开,能支持物理云和跨地域的复杂场景,还打造了完整的检测框架,帮助运维同事直接定位故障点,或一键判断虚拟网络是否存在问题。BigBrother上线后即用于云主机迁移前后的连通性验证,保证出现异常后可以及时告警回滚。从8月初至今历时两个月,共迁移2000多台主机,及时发现迁移异常近10起。

检测效率低下,无论是ssh、packet out,还是tcpdump都无法支持大规模的快速检查;

适应的场景有限,对于部分dpdk、p4网关类产品,无法通过tcpdump进行抓包判断。

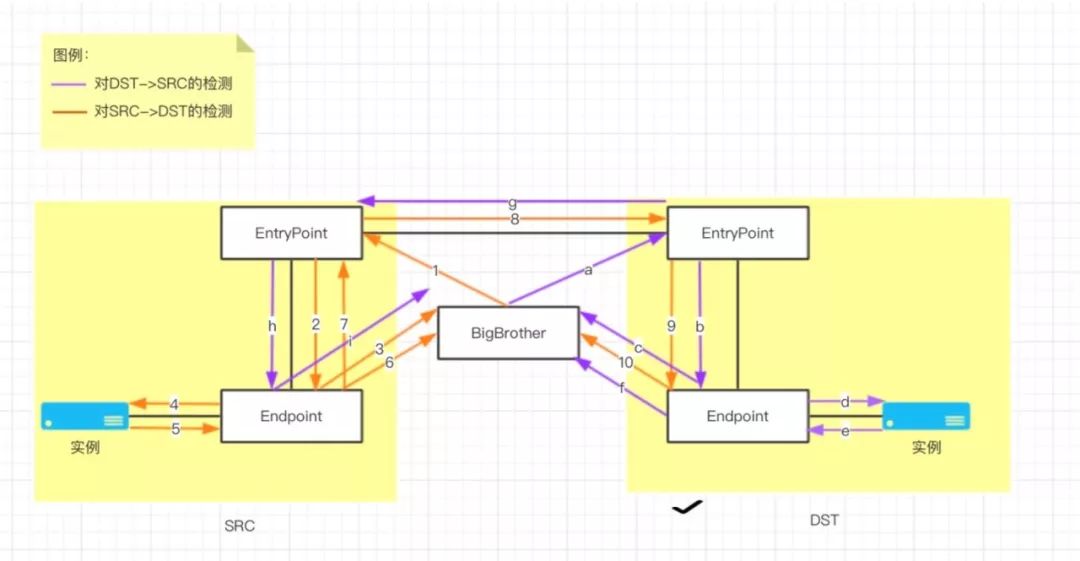

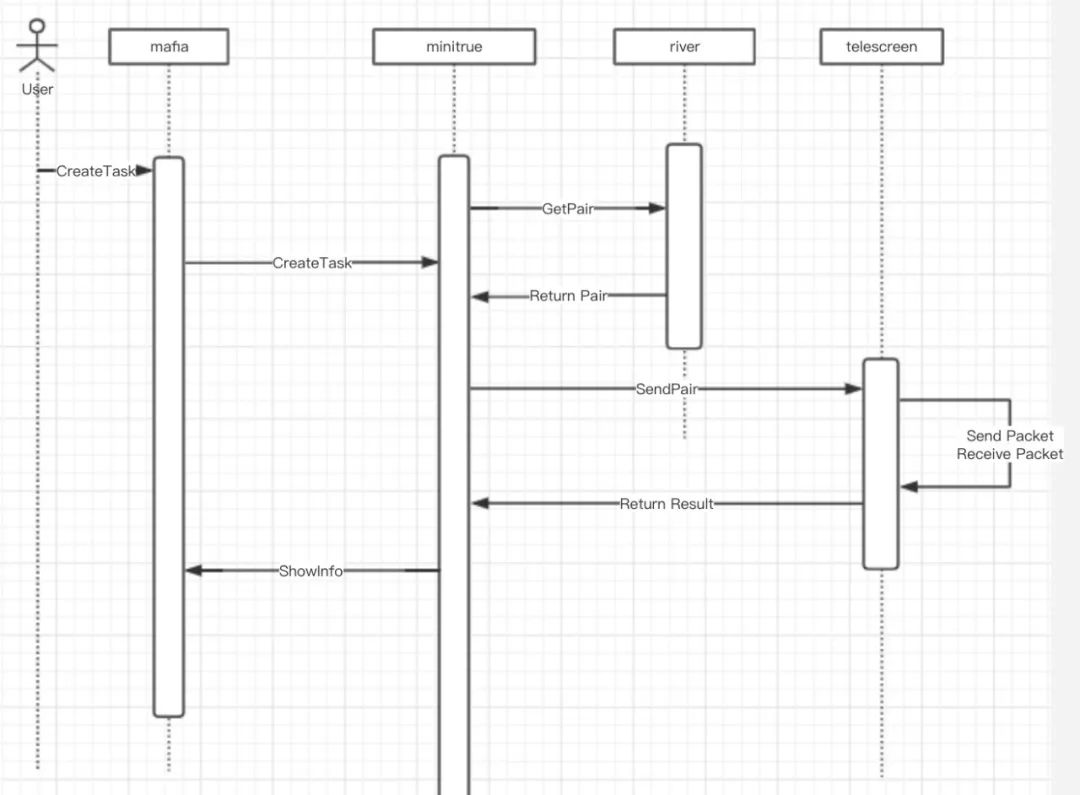

Entrypoint和Endpoint

在具体介绍BB的原理前,我们先来看两个概念。在我们的虚拟网络中,每个实例(uhost、umem、udb等)都是通过接入点来接入虚拟网络,接入点由两部分组成:Entrypoint: inbound/outbound报文都是经由Entrypoint进行接受和发送的。

Endpoint:连接实例的端点,Endpoint为最接近实例的网元。

场景 | Entrypoint | Endpoint |

公有云 | ovs | ovs |

物理云 | vpcgw、hybridgw | ToR |

托管云 | hcgw、cloudgw | PE |

跨域网关 | sdngw | ovs |

公共服务 | ovs | ovs |

CNAT | ovs | ovs |

托管云(UXR) | UXR | PE |

跨域网关(UXR) | UXR | ovs |

CNAT(UXR) | UXR | ovs |

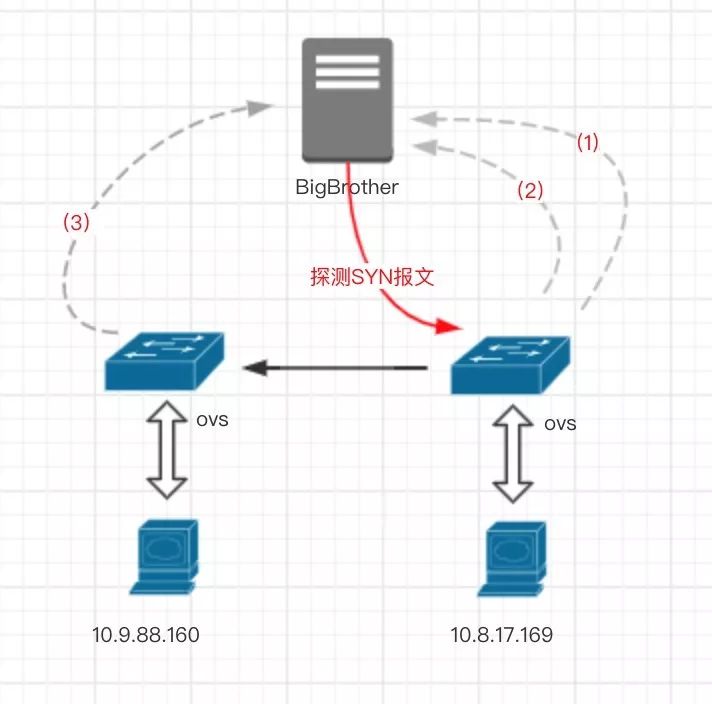

以上就是各种场景中的接入点说明,之所以要明确这两个概念,是因为在BB系统中,我们将Entrypoint作为注包点,向其发送GRE探测报文,同时将Endpoint作为采样点,Endpoint会识别并镜像特殊的探测报文至BB。

2检测流程检测方案如图所示,可分为两部分组成,在图中的流向分为橙色和紫色。

染色信息与主机、OS无关;

ovs2.3、ovs2.6版本(现网主要版本)可以识别并处理此种染色信息。

cookie=0x20008,table=1,priority=40000,metadata=0x1,icmp,icmp_type=8,icmp_code=0,nw_tos=0x40 actions=Send_BB(),Learn(),Back_0()Send_BB() 将报文镜像给BB;

Learn() 通过icmp_request报文学习到一条用于匹配icmp_reply报文的flow,该条flow的主要动作包括:染色、镜像至BB;

# 1. ??REG3 ?64200# (global hook) reg3 load:64200->NXM_NX_REG3[], # 2. learn action learn(table=31,idle_timeout=2,hard_timeout=4,priority=30000,dl_type=0x0800,ip_proto=1,icmp_type=0,icmp_code=0,NXM_OF_IP_SRC[]=NXM_OF_IP_DST[],NXM_OF_IP_DST[ ]=NXM_OF_IP_SRC[],Stain(),Send_BB()),# 3. REG3 0load:0->NXM_NX_REG3[] Back_0() 将该报文送回table_0,进行常规的转发操作。

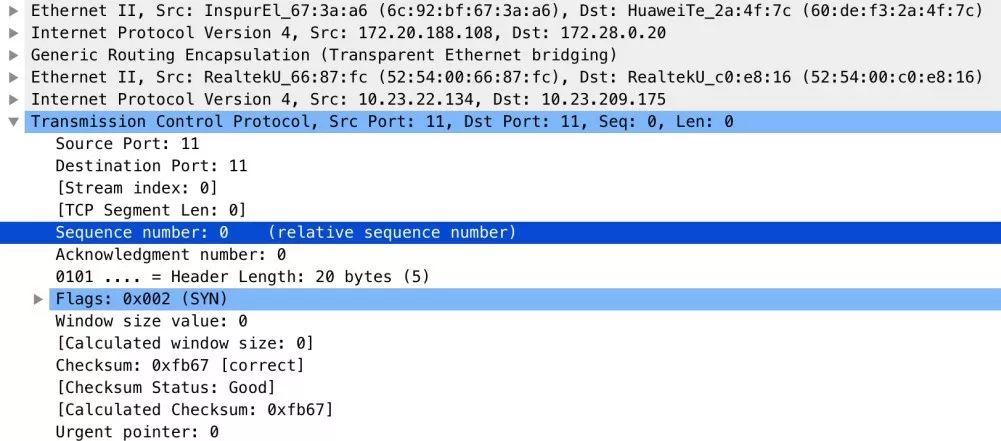

cookie=0x20008,table=1,priority=40000,metadata=0x1,icmp,icmp_type=0,icmp_code=0,nw_tos=0x40ovs-vsctl set in options:tos=inheritcookie=0x20008,table=1,priority=40000,tcp,metadata=0x1,tp_src=[port],tp_dst=[port] actions=Send_BB(),Back_0()以上两种方案进行对比不难看出,第一种方案依赖较多并且适用场景受限,所以BB采用的是第二种方案。但是tcp方案也有一定的缺陷,如何选择染色的port并且要与用户的流量区分开来,这是一个难点。经过我们几次踩坑后分析,最后决定使用tcp源目port=11来进行染色(目前已告知用户会使用TCP 端口11进行扫描,详见文档),报文如下图所示。

物理云

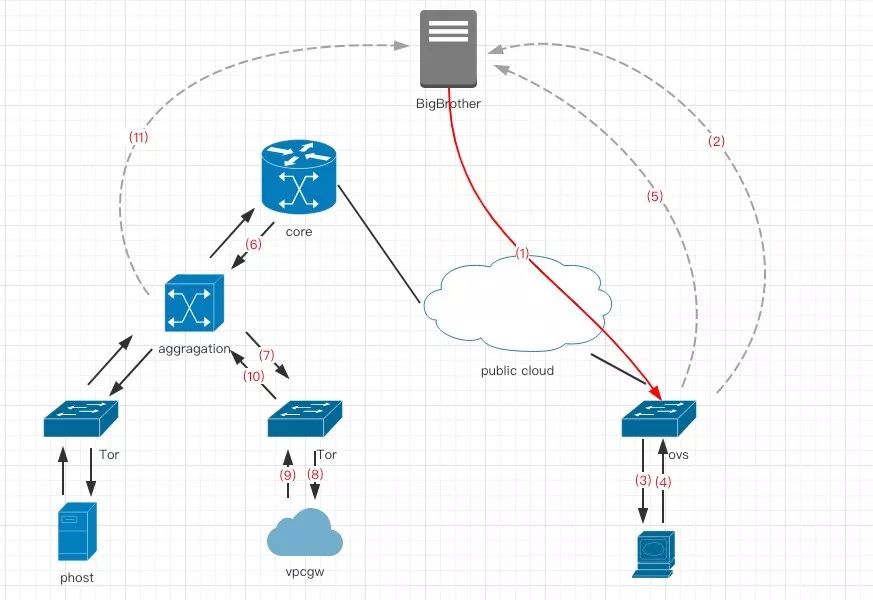

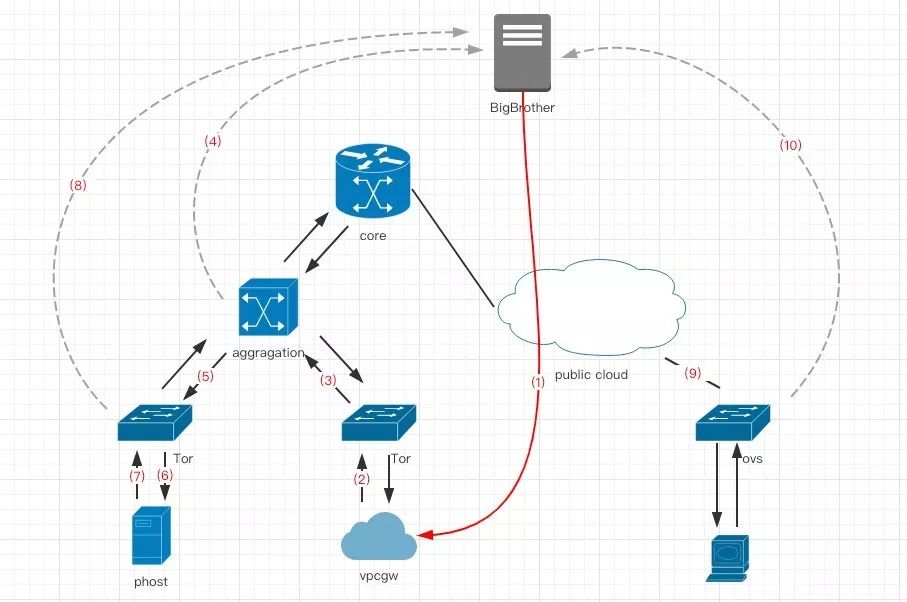

公有云—> 物理云

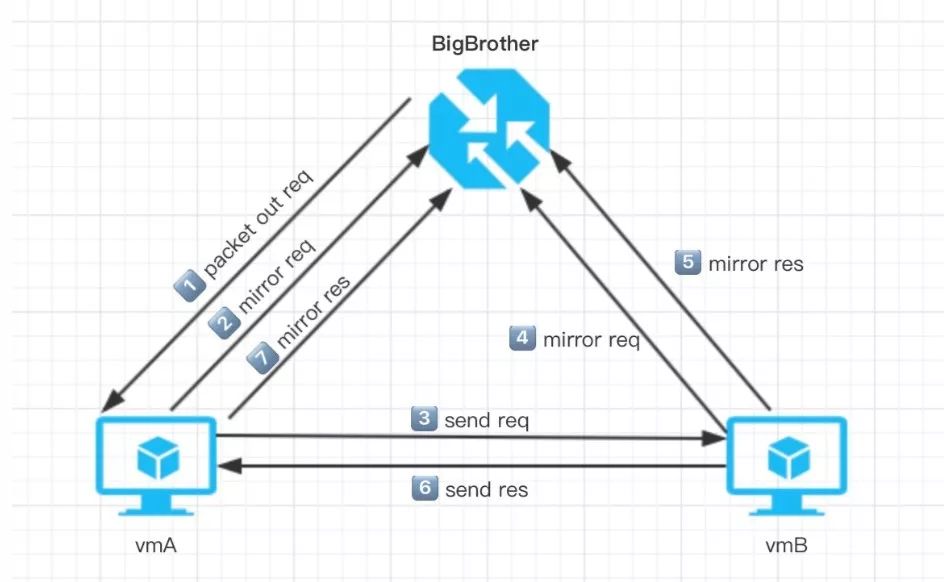

1)BigBrother向公有云宿主机发送探测报文

2)ovs收到报文后镜像至BigBrother3)ovs将报文送至实例4)实例回应报文5)ovs将回应报文镜像至BigBrother6)物理云核心交换机收到报文,并发送给汇聚交换机7)8)9)10)物理云汇聚交换机发送报文给vpcgw,vpcgw处理报文后回送至汇聚交换机11)在物理云汇聚交换机配置ERSPAN,将报文镜像至BigBrother。物理云—> 公有云

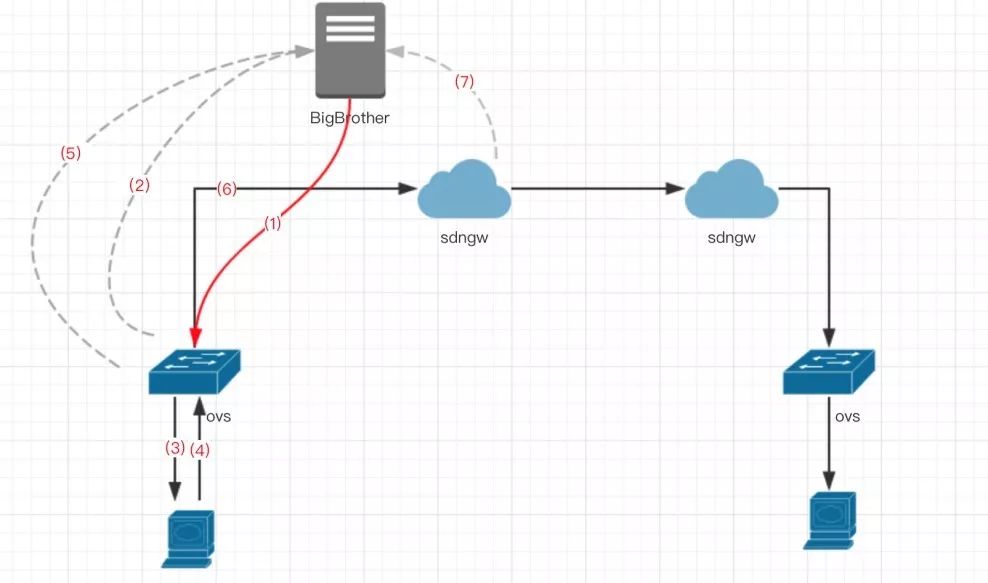

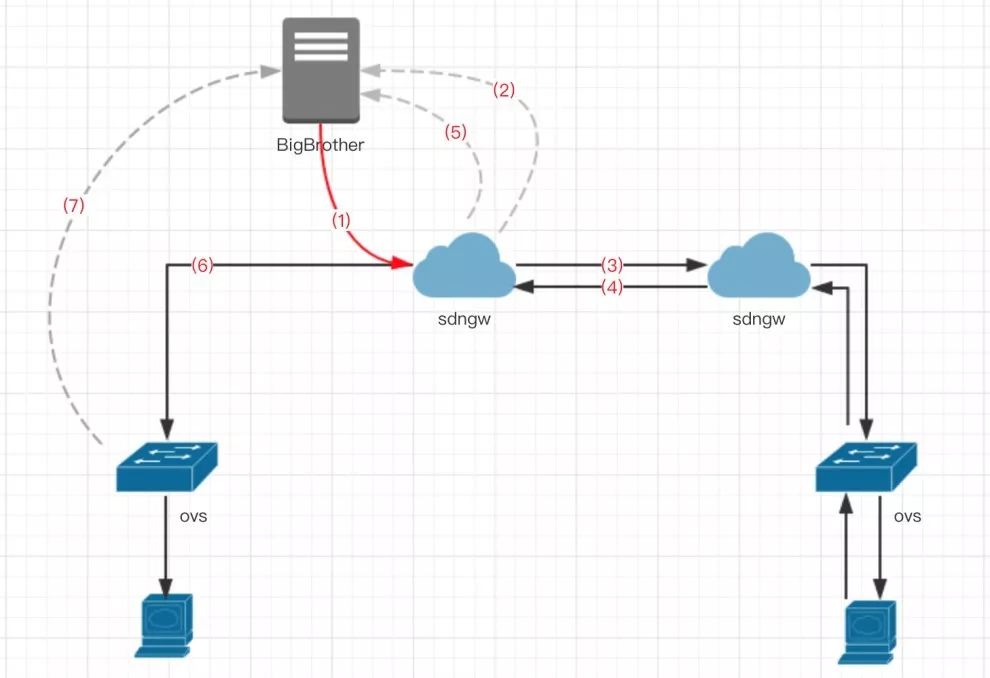

跨域网关

本地域—> 地域B

1)BigBrother 向本域主机发送探测报文

2)ovs收到报文后镜像至BigBrother3)ovs将报文送至实例4)实例回应报文5)ovs将回应报文镜像至BigBrother6)ovs将报文送至sdngw7)sdngw将报文镜像至BigBrother地域B—> 本地域

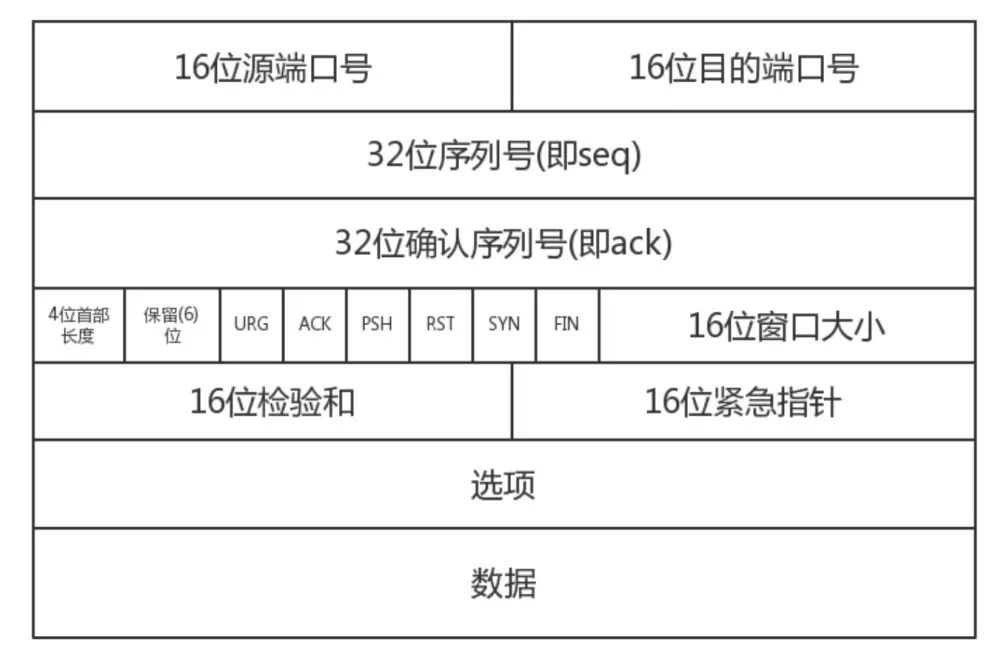

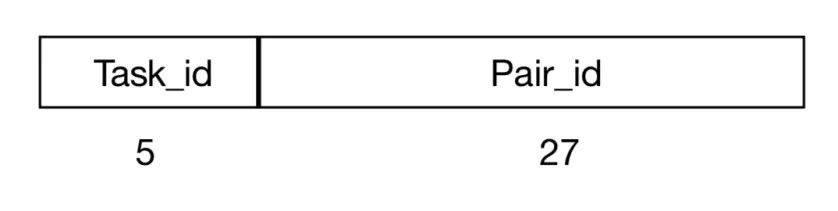

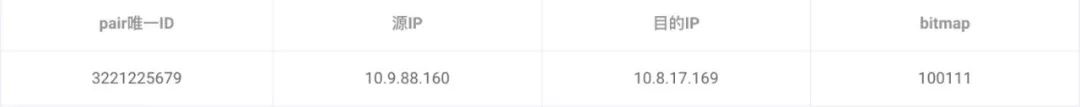

其中32位的Seq序列号就是我们要利用的,在BB探测过程中每个Seq序列号都唯⼀标识⼀个pair对,然后我们将Seq序列号分成了两部分:

Task_id:⽤于标识一个Task,由于仅有5位,所以每次同时进⾏的Task不能超过32个 ;

Pair_id:用于标识在一个Task内,待检测的一个pair对。

(1)

nw_dst=10.8.17.169>

(2)

nw_dst=10.9.88.160>

(3)

nw_dst=10.9.88.160>

上图bitmap后三位的结果为111,表示这3个报文都收到了,即10.8.17.169 —>10.9.88.160 单向的连通性正常。

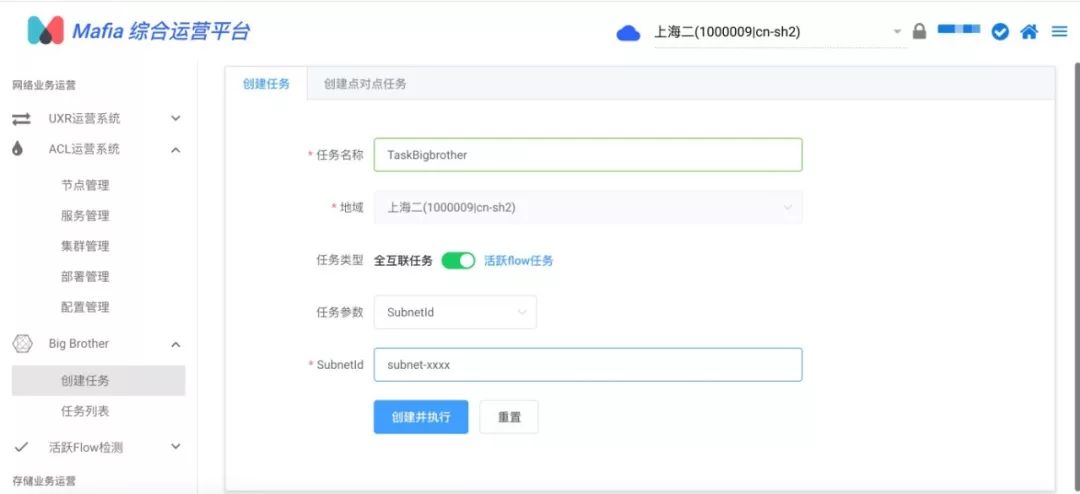

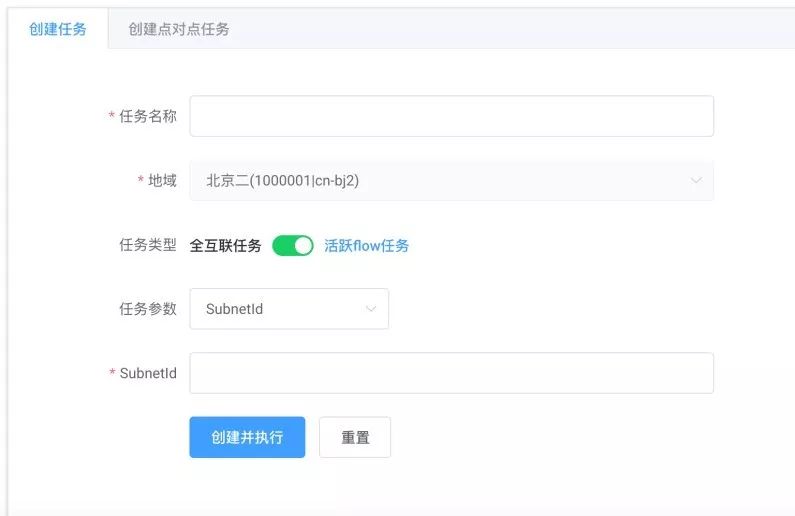

反之亦然,前三位则表示10.9.88.160 —> 10.8.17.169单向的连通性情况,结果为100,(2)(3)报文没有收到,即表示 10.9.88.160 —> 10.8.17.169单向的连通性异常,虚机10.9.88.160没有回复报文,可以断定虚机内部异常或虚机内部存在iptables规则将探测报文过滤。3基于活跃flow的连通性检查上文我们提到,运维同学可以在mafia上创建BB task来进行连通性的检查,通过传入mac、子网id、VPC id来确定检测的范围,进而进行全量验证。但是大多数场景中,我们不需要进行全互联检查,这样不仅浪费时间而且还会对控制面造成一定的压力。我们仅需要针对指定范围内的活跃flow验证连通性即可,所以我们又引入了活跃flow检测的服务——river。river是虚拟网络亿级别活跃流的分析系统,借助这个系统BB可以拿到用户的活跃通信源目,类似于缓存里的热点数据,这样可以让BB快速精准验证变更。

除了对连通性的检测外,还需要有平均时延,最大时延对、丢包率的检测;

- 打算基于BigBrother构建针对指定用户的内网全天候监控。

来源:本文转自公众号 Ucloud 技术。

更多云实践和技术干货,欢迎关注“UCloud技术”

更多云实践和技术干货,欢迎关注“UCloud技术” !

!

:用户持有凭证)

查询)

...)