- 论文作者简介

本论文第一作者Matt J. Kusner是牛津大学的副教授,致力于设计适应现实世界问题需求的新机器学习模型(例如,fair algorithms, discrete generative models, document distances, privacy, dataset compression, budgeted learning, and Bayesian optimization)。

- 论文摘要

论文中作者提出了一个度量文本文档之间距离的新指标,即词移距离WMD(Word Mover's Distance)。该成果基于Mikolov等人提出的词嵌入(word embeddings),一种语义上有意义的词汇表征。具体来说,将每个单词标记编码为某个向量,该向量表示为某种“单词”空间中的一个点(该空间的维数远远小于词汇表的大小|V|),每个维度都会编码某个含义。WMD距离衡量的是两个文本文档之间的差异性,即一篇文档的词汇需要对应到另一篇文档的某一个相近词汇,取该过程中所生成距离的最小值作为文档距离。该距离度量可以视为Earth Mover's Distance的一个特例。作者在8个现实世界的文档分类数据集上,与当时7个state-of-the-art的基准算法相比较,WMD度量取得了前所未有的较低的K最近邻文档分类错误率。

- 论文内容介绍

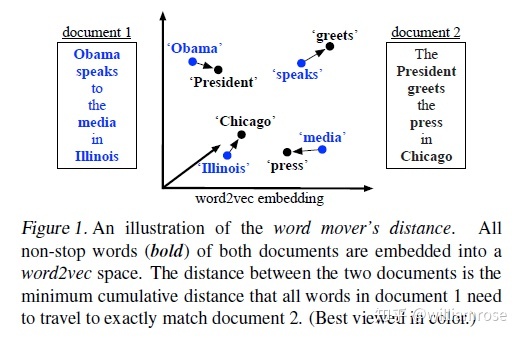

准确地表示两个文档之间的距离在文档检索、新闻分类和聚类、歌曲识别和多语言文档匹配中具有广泛的应用。早先通过词袋模型BOW(bag of words)或词频-逆向文件频率TF-IDF(term frequency-inverse document frequency)表示文档的方式,由于它们频繁的接近正交的特性,故不适用于文档距离。这些表示方式的另一个显著缺点是他们没有捕获到单词之间的距离。作者利用Mikolov等人提出的word2vec模型构建了新的文档距离度量指标Word Mover's Distance (WMD),将文本文档表示为词嵌入向量的加权点云,每个词嵌入向量对应高维空间中的一个点。两篇文本文档A和B之间的距离是一个最小累积距离,该距离是来自文档A的单词需要travel来精确匹配文档B的点云。见下方新度量指标的略图。

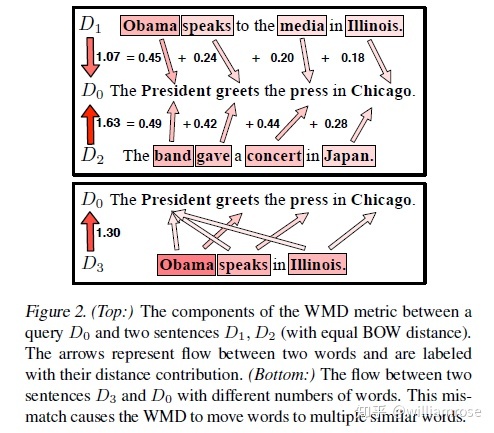

作者还比较了几个下限方法,这些下限方法可以用作近似计算或者修剪掉被证明不在一个查询的k个最近邻中的文档。WMD距离具有几个有趣的特性:(1) 没有超参数,易于理解和使用; (2)高度可解释的,两个文档之间的距离可以分解并解释为少数几个单词之间的稀疏距离;(3)它自然地融入了word2vec空间中的编码知识并获得高检索准确率。作者是首次将高质量的词嵌入和EMD检索算法关联起来进行文档距离研究的。

- 词嵌入向量(word embedding vector)

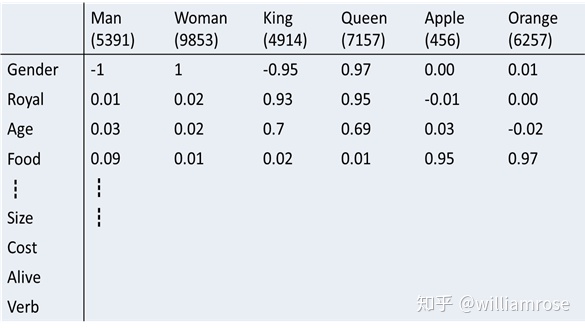

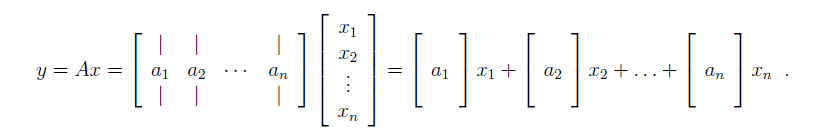

比如,针对300维的词嵌入向量,每个维度表示某个特定的含义。词汇表中所有词汇构成的词嵌入矩阵(word embedding matrix)如下图所示(图中的每一列表示该词汇对应的词嵌入向量,例如单词man表示的词嵌入向量为

- Word Mover's Distance

nBOW:假设有n个单词的词汇表的word2vec嵌入矩阵

Word travel cost:我们的目标是将每个单词对(例如,President and Obama)之间的语义相似度包含进文档距离度量中。单词

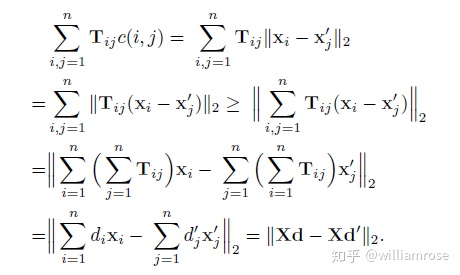

Document distance:两个词之间的“travel cost”是一个自然的构建块用以创建两个文档之间的距离。令

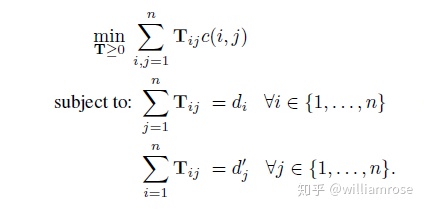

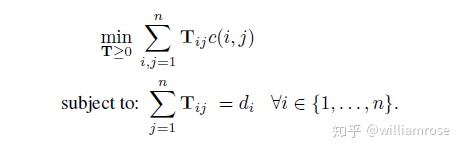

Transportation problem:在给定约束条件下,将文档

上述优化问题可以看做是earth mover's distance metric(EMD)的一个特例。

Visualization:考虑WMD度量文档距离的一个例子,

- Fast Distance Computation

由于解决WMD优化问题的最佳平均时间复杂度为

下限方法1(Word centroid distance):质心距离

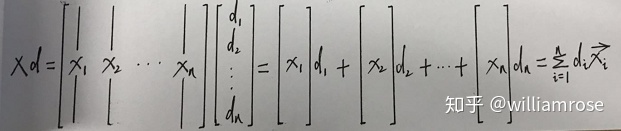

note:矩阵向量乘法的第二种形式

将该距离称为Word Centroid Distance(WCD),每个文档由其加权平均词向量表示。该下限计算方法只需要通过几个矩阵运算便可得出,时间复杂度也只有O(dp)

下限方法2(Relaxed word moving distance):由于WCD计算出的下限比较宽松,通过松弛WMD优化问题并分别移除两个约束条件中的一个,我们可以得到更严格的界限。如果只移除第二个约束条件,优化问题就变成了,

这个松弛问题一定会产生WMD距离的一个下限(lower-bound),一个明显的事实是每个WMD的解决方案(满足两个约束条件),一定仍然是移除一个约束条件的松弛问题的一个可行解决方案。令两个松弛解决方案分别是

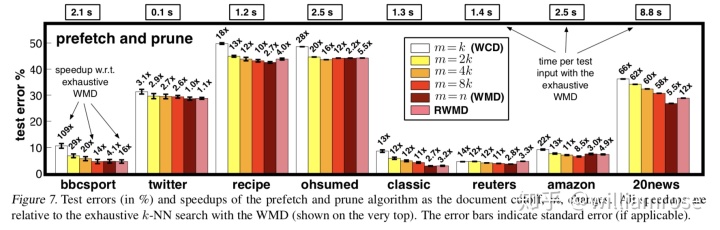

Prefetch and prune:我们使用两个下限来大幅减少我们需要进行的WMD距离计算量,以便找到一个查询文档的k个最近邻。首先将所有文档按照它们到查询文档的WCD距离(该距离计算成本廉价)进行升序排列,然后计算查询文档到这些文档中前k个文档的精确WMD距离。接下来遍历剩余的其它文档。对于余下的每篇文档我们首先检查RWMD下限是否超过当前第k个最近文档的距离,如果是这样我们就将其修剪掉。否则的话就计算WMD距离并在必要时更新第k个最近邻。由于RWMD近似非常严格,它允许我们在一些数据集上修剪掉高达95%的文档数。

- 结果

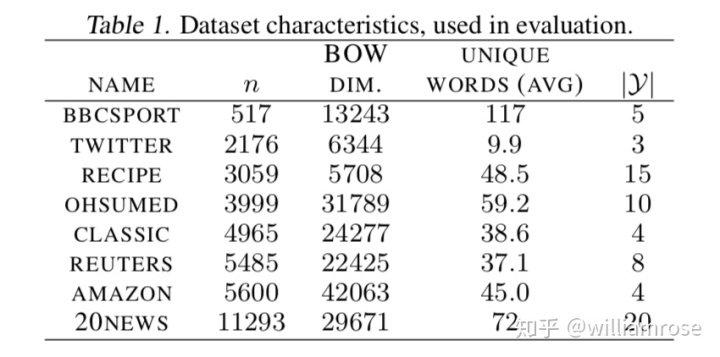

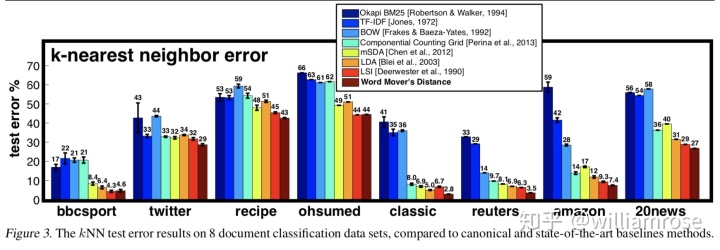

作者在八个基准文档分类任务上以kNN分类的形式评估了WMD距离(word mover’s distance)。

1、8个监督学习范畴的公开文档数据集

2、用于与WMD距离相比较的表示文档的7个基准方法

对于每个基准方法,我们使用欧氏距离进行kNN分类。

bag-of-words (BOW), TFIDF(term frequency-inverse document frequency), BM25 Okapi, LSI(Latent Semantic Indexing), LDA(Latent Dirichlet Allocation), mSDA(Marginalized Stacked Denoising Autoencoder), CCG(Componential Counting Grid)

3、文档分类结果

在除了两个(BBCSPORT,OHSUMED)之外的所有数据集上,WMD取得了最低的测试误差。

4、Lower Bounds and Pruning

最后,作者评估了在m的不同取值下prefetch和prune算法的精确和近似版本的加速性能和准确性。所有加速都是相对于详尽的WMD度量所需时间(图的最上方)而报告的,并且在4个核心上并行运行。(8 cores for 20NEWS) of an Intel L5520 CPU with 2.27Ghz clock frequency.首先,我们注意到在所有情况下,通过prefetching增加的错误相对较小,而可以获得可观的速度提升。

从图中可以观察到,误差在m = k和m = 2k之间下降最多,对于时间敏感的应用来说,这可能会产生一个介于准确率和检索时间之间的最佳点(sweet spot)。如前所述,使用RWMD直接导致令人印象深刻的低错误率,并且在所有数据集上的平均检索时间低于1秒。

- 结论

WMD度量在所有数据集上的错误率如此之低,我们将其归因于其利用了word2vec词嵌入向量高效表征词汇的能力。

- 参考文献:

【1】Matt J. Kusner, From Word Embeddings To Document Distances

【2】Mikolov, T., Chen, K., Corrado, G., and Dean, J. Efficient estimation of word representations in vector space. In Proceedsings of Workshop at ICLR, 2013a.

【3】Mikolov, T., Sutskever, I., Chen, K., Corrado, G. S., and Dean, J. Distributed representations of words and phrases and their compositionality. In NIPS, pp. 3111– 3119, 2013b.

Word2Vec Tutorial - The Skip-Gram Model

吴恩达、深度学习第五门课程-序列模型(sequence models)、网易云课堂

C语言版(转))

)

)