当回归模型建立好以后,如何评价该回归模型是否与另一个回归模型有区别,如何比较两个回归模型的性能?这一讲中,我们将给大家介绍几个评价回归模型性能的统计指标。

1. 模型性能指标

在回归模型中,最常用的评估指标包括:

- R平方(R2),它是预测变量能解释结果变量变异的百分比例,范围为0到1。 R2是观察到的实际结果与模型构建的预测值之间的相关系数的平方。R平方越高,模型越好。

- 均方根误差(root mean squared error, RMSE),它测量的是模型预测的结果与实际观察结果间的平均误差。从数学上讲,RMSE是均方误差(mean squared error, MSE)的平方根,该均方根是观察到的实际值与模型预测的值之间的均方差。因此,MSE = mean((observeds - predicteds)^2)和RMSE = sqrt(MSE)。RMSE越低,模型越好。

- 残差标准误/残留标准误差(residual standard error, RSE),也称为模型sigma(model sigma),是针对模型中预测变量数量进行调整的RMSE。RSE越低,模型越好。实际上,RMSE和RSE之间的差异很小,尤其是对于多元数据(含有多个预测变量的模型)而言。

- 像RMSE一样,平均绝对误差(mean absolute error, MAE)也可以测量预测误差。在数学上,它是观察到的结果与预测的结果之间的平均绝对差MAE = mean(abs(observeds - predicteds))。与RMSE相比,MAE对异常值的敏感性较低。

- F统计量:它提供了模型的整体重要性。它评估至少一个预测变量是否具有非零系数。F统计量越大, 对应的统计显着性p值(p <0.05)越小。

上述性能指标都存在一个问题,即预测变量在解释结果上即便没有显着贡献,但当加入新的预测变量进模型时,也会对上述性能指标产生影响,这些性能指标对模型的变化是非常敏感的。即,在模型中包括新加的变量时,将始终增加R2并降低RMSE。

因此,我们需要一个更加稳定的指标来指导最佳模型的选择。

关于R2,有一个调整预测变量数的指标,称为调整后的R方(Adjusted R-squared),它有效地考虑了模型中的预测变量数量的不同,从而使各个模型可比较。

此外,还有其他四个重要指标- AIC,AICc,BIC和Mallows Cp –它们通常用于模型评估和选择,是MSE的无偏估计。这些指标数值越低,表示模型越好。

- AIC(Akaike‘s Information Criteria)的基本思想是对模型中包含额外变量的行为进行惩罚。每当增加一个新变量时,它将增加一个惩罚值,从而达到控制额外预测变量的效果。AIC越低,模型越好。

- AICc是AIC的变体版本,主要是针对小样本量进行了校正。

- BIC(Bayesian information criteria)是AIC的另一种变体,它利用了贝叶斯原理,当模型中增加新的变量时,它将受到比AIC更大的惩罚。

- Mallows Cp:是AIC的另一种变体,有Colin Mallows发明,因而称为Mallows Cp。

通常,用于测量回归模型性能,以及用于模型间的比较的最常用指标是:校正R方,AIC,BIC和Cp。

2. 加载所需的R包

- tidyverse 用于数据处理和可视化

- modelr 用于计算回归模型性能指标

- broom 轻松创建包含模型统计指标的整洁数据框(数据集)

library(tidyverse)

library(modelr)

library(broom)3. 数据示例

我们将使用R的内置数据集swiss。

# 加载数据

library(datasets)

data("swiss")

# 查看数据(随机选取3行数据来查看)

sample_n(swiss, 3)

Fertility Agriculture Examination Education Catholic Infant.Mortality

1 77.3 89.7 5 2 100.00 18.3

2 76.1 35.3 9 7 90.57 26.6

3 83.1 45.1 6 9 84.84 22.2研究问题:根据社会经济相关的多个指标(Agriculture,Examination,Education,Catholic,Infant.Mortality)预测生育力得分(Fertility)。

4. 建立回归模型

我们首先创建两个模型:

- 模型1,包括所有预测变量([.]表示数据swiss中所有出了结果变量Fertility外所有的变量)

- 模型2,包括除变量Examination外的所有预测变量([.-Examination]表示所有的变量,减去Examination)

model1 <- lm(Fertility ~., data = swiss)

model2 <- lm(Fertility ~. -Examination, data = swiss)5. 评估模型性能

有许多用于评估模型质量的R函数和软件包,包括:

5.1 Stats软件包

- summary() [stats 软件包中],返回R平方,调整后的R方和RSE

- AIC()和BIC()[stats 软件包中],分别计算AIC和BIC

summary(model1)

AIC(model1)

BIC(model1)5.2 modelr软件包

- rsquare(),rmse()和mae()[modelr软件包中],分别计算R2,RMSE和MAE。

library(modelr)

data.frame(R2 = rsquare(model1, data = swiss),RMSE = rmse(model1, data = swiss),MAE = mae(model1, data = swiss)

)5.3 caret软件包

- R2(),RMSE()并MAE()[caret软件包中],分别计算R2,RMSE和MAE。

library(caret)

predictions <- model1 %>%

predict(swiss)

data.frame(R2 = R2(predictions, swiss$Fertility),RMSE = RMSE(predictions, swiss$Fertility),MAE = MAE(predictions, swiss$Fertility)

)5.4 broom软件包

- glance() [broom软件包中],可以一次性计算所有的指标:R2,调整后的R方,sigma(RSE),AIC,BIC。

library(broom)

glance(model1)5.5 手动计算

- 手动计算R2,RMSE和MAE:

swiss %>%add_predictions(model1) %>%summarise(R2 = cor(Fertility, pred)^2,MSE = mean((Fertility - pred)^2),RMSE = sqrt(MSE),MAE = mean(abs(Fertility - pred)))6. 比较回归模型的性能

在这里,我们将使用该函数glance()来简单比较两个模型的整体质量:

# 计算model 1的各个参数

glance(model1) %>%dplyr::select(adj.r.squared, sigma, AIC, BIC, p.value)

## adj.r.squared sigma AIC BIC p.value

## 1 0.671 7.17 326 339 5.59e-10

# 计算model 2的各个参数

glance(model2) %>%dplyr::select(adj.r.squared, sigma, AIC, BIC, p.value)

## adj.r.squared sigma AIC BIC p.value

## 1 0.671 7.17 325 336 1.72e-10从上面的输出中可以看出:

- 这两个模型的调整后的R方(0.67)完全相同,这意味着它们在解释结果(此处为生育力得分Fertility)方面是等效的。此外,它们具有相同的残留标准误差(RSE或sigma = 7.17)。但是,模型2比模型1更简单,因为它包含更少的变量。在统计学中,有一个原则就是,如果简单跟复杂效果一样,永远默认简单模型更好。

- 模型2的AIC和BIC低于模型1的AIC和BIC。在模型比较中,具有更低AIC和BIC分数的模型是首选。

- 最后,模型2的统计p值低于模型1的统计p值。这意味着模型2在统计上比模型1显著性差异更大,这也与上述结论一致。

请注意,RMSE和RSE的度量单位与结果变量是相同的。将RSE除以结果变量的平均值将得到预测误差率,该误差率应尽可能小:

sigma(model1)/mean(swiss$Fertility)

## [1] 0.102在我们的示例中,平均预测错误率是10%。

7. 总结

请注意,以上例子中,这些回归指标都是对内部数据性能进行评价。即,它们是根据用于构建回归模型的相同数据计算得出的。他们表示的是该模型与现有数据(训练数据集)的拟合程度,但并不衡量模型与新的测试数据集的拟合程度。

通常,我们并不十分在乎模型在训练数据上的效果如何。我们更在乎的是,我们建的模型对另一个完全独立的测试数据集的预测准确性。

但是,并不是每个研究都能找个一个或者多个相对独立的测试数据集,因此,我们有了交叉验证法和自举重采样(bootstrap-resampling)验证法来对该模型对测试数据集的预测准确性进行评估。

我们将在第四十二和四十三讲中进行解说。

参考内容:

1. Alboukadel Kassambara, Machine Learning Essentials: Practical Guide in R

如果您觉得我说的对您有帮助,请点赞让我感到您的支持,您的支持是我写作最大的动力~

ijournal:高颜值的期刊检索网站,助您快速找到理想目标期刊(weixin小程序也上线了哦)

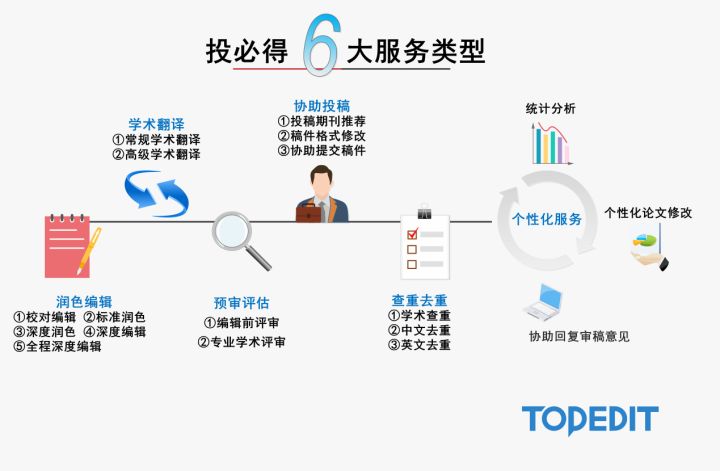

投必得:全专业中英文论文润色编辑助力您的论文快速发表,点击了解业务详情

专栏传送门:

投必得科研软件安装使用手册;投必得:SCI期刊介绍与选择;投必得,教你写论文;投必得统计分析大讲堂;投必得科研生活解忧杂货店

Linux上的内存分配)

,python多用户,多用户全双工聊天简陋...)

)

-《公告牌技术与几何着色器》)

![python 工资管理软件_基于[Python]的员工管理系统](http://pic.xiahunao.cn/python 工资管理软件_基于[Python]的员工管理系统)

...)

)

.doc)