点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

讲者简介

孙奥:

香港科技大学软件安全实验室在读博士,研究兴趣为可解释性人工智能和可信机器学习,主要是从Post-hoc,逻辑和概念的角度分析神经网络的机理

Title

「解释一切」图像概念解释器

Content

内容简介

可解释AI(XAI)是提高人类对深度神经网络(DNN)理解给定黑盒内部的重要主题。对于计算机视觉任务,主流的基于像素的XAI方法通过识别重要像素来解释DNN决策,新兴的基于概念的XAI探索用概念形成解释。然而,像素通常很难解释和敏感XAI方法的不精确性,而先前工作中的“概念”需要人工注释或仅限于预定义的概念集。另一方面,由大规模预训练驱动, Segment Anything Model(SAM)已被证明是执行精确和全面的实例分割的强大且可扩展的框架,从而能够从给定的图像中自动准备概念集。本文首次探索了使用SAM来增强基于概念的XAI。我们提出了一种有效的灵活的基于概念的解释方法,即解释任何概念(EAC),它用任何概念解释DNN决策。虽然SAM非常有效并提供“开箱即用”实例分割,但在集成到事实上的XAI方法中时成本很高。因此,我们提出了一种轻量级的每个输入等效(PIE)方案,从而能够使用代理模型进行有效的解释。我们对两个流行数据集(ImageNet和COCO)的评估说明了EAC相对于常用XAI方法具有更好的性能。

个人主页:

https://jerry00917.github.io

论文链接:

https://openreview.net/pdf?id=X6TBBsz9qi

代码链接:

https://github.com/Jerry00917/samshap

Background

随着深度学习模型的崛起,越来越多的网络被提出,像Resnet、DenseNet等的黑箱模型越来越普遍,并且网络预测的准确率很高,但是其中的可解释性问题仍然是一个难题。

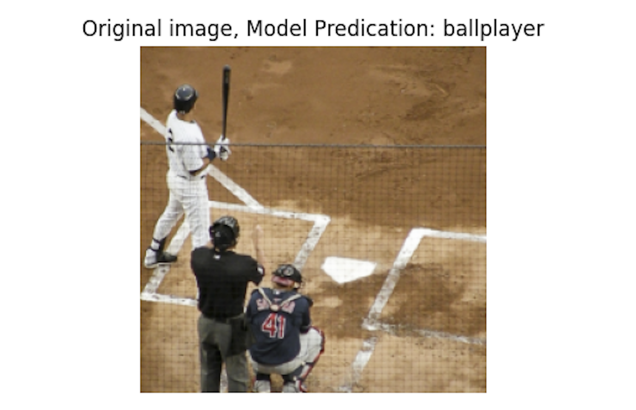

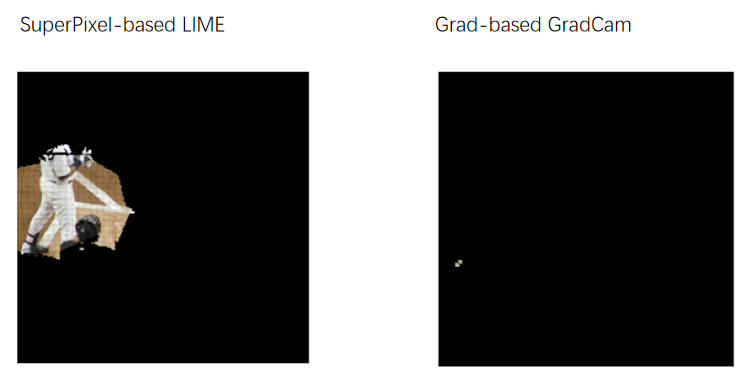

如下图,之前的工作中大致可以分为两类。第一类是SuperPixel-based LIME,它使用超像素来创建图像的局部表示,然后使用LIME来解释与这些超像素相关的机器学习模型的预测结果。这种方法的目标是提高解释性,帮助我们更好地理解模型是如何基于图像的局部特征做出预测的。通过关注图像的关键局部区域,我们可以更清晰地了解模型的决策过程。

第二类是Grad-based GradCam,它指的是使用梯度信息来生成GradCam 图,从而可视化深度学习模型对于给定输入图像中哪些区域产生了影响。这有助于我们理解模型是如何基于输入图像的不同部分作出决策的,特别是关于特定类别的决策。这种方法使我们能够直观地看到模型在图像中关注的重要区域,有助于提高模型的解释性。

Motivation

对于第一种方法,如果超像素的尺寸过大,可能会导致不准确但更“完整”,更易于人类理解的输出;反之,对于第二种方法,如果超像素的尺寸过小,可能会导致不准确的输出,但更容易理解。这两种方法的解释都不够人性化,所以,作者希望能够实现一种对人类友好的,也能够高精度预测的方法。

Approach

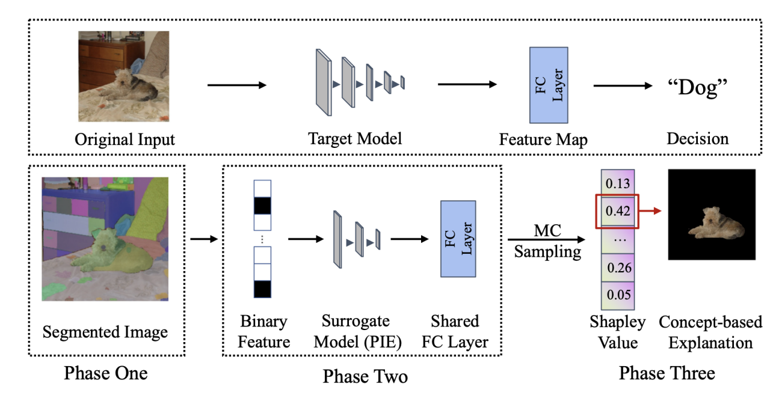

本文中,作者提出了一种通用且灵活的基于概念的解释方法,即Explain Any Concept(EAC),它可以用任何概念解释模型预测。该方法分为三个阶段:第一阶段,Segmented Image,使用模型SAM将输入图像划分为一组视觉概念;第二阶段,训练一个每个输入等效的(PIE)代理模型来近似目标DNN的行为;第三阶段,使用代理模型通过第一阶段获得的概念有效地解释模型预测。

值得注意的是,在EAC的第二阶段,作者使用Shapley值来识别有助于目标模型预测的关键概念。然而,尽管Shapley值很有效,但是由于其指数复杂性,计算成本很高。所以,作者提出了(PIE)的方案来降低目标模型的复杂性,这可以显著降低Shapely值的计算成本。

Post-hoc Model Explanation: EAC

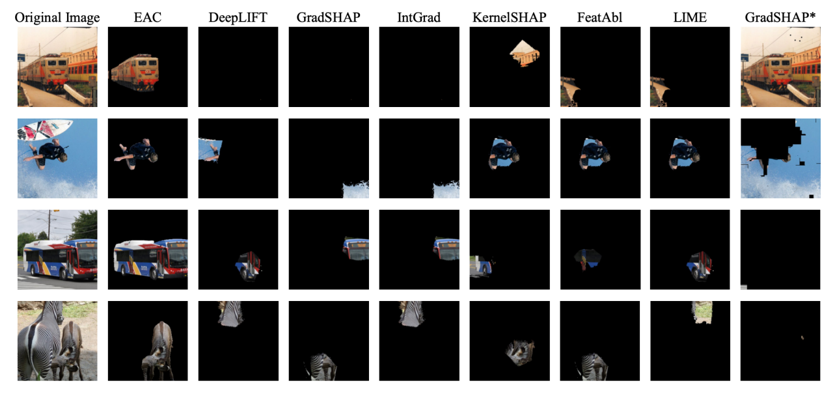

如下图是所提方法的效果图,它规避了SuperPixel-based LIME和Grad-based GradCam的缺点,可以将最完整、最准确的内容解释出来,对人类也是十分友好的。

Comparison

下图中展示了几个案例,证明了EAC在解释模型预测方面的有效性。我们可以观察到,EAC在解释其他测试用例中的模型预测方面显著优于其他方法。EAC生成了更多“格式良好的”概念级别的解释,而这些解释在下图的案例中都是人类可理解的。例如,在第一种情况下,EAC正确地突出了“训练”作为概念级别的解释,而前三个基线方法会产生一些可忽略的像素、图像的片段(第4、第5和第6个基线)或整个图像(第7个基线)。对比图显著说明了EAC在理解性方面的优势。

Experiments

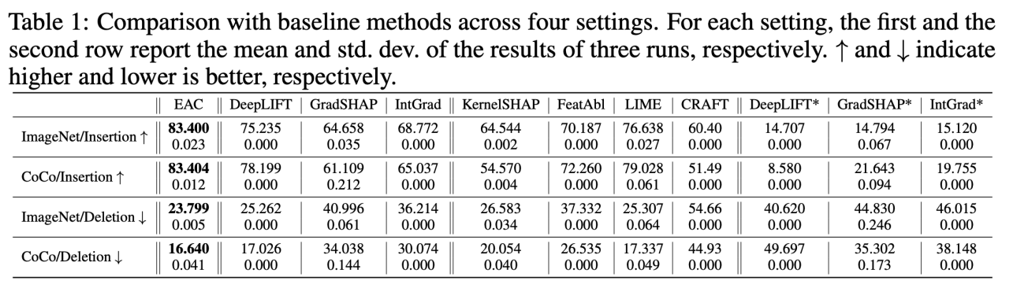

该部分通过实验验证了EAC方法的有效性。与其他基线方法的对比结果显示,EAC在不同条件下的效果都要优于其他方法。比如,以ImageNet和CoCO作为数据集,在不同的基线方法中插入或删除新的概念,比较对模型性能的影响,EAC都实现了更高的AUC值,显著优于其他方法。

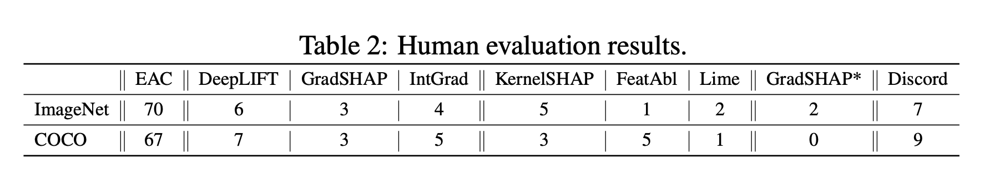

Human-friendly Explanation

本篇工作还进行了有意思的人机交互实验。作者通过随机邀请6位该领域的研究者,以此来投票选出认为对人类最为友好的解释方法。实验显示,EAC在所有baseline中得分最好,能够预测最完整的概念,也更易于人类理解。

Conclusion

本文提出的框架有两大优势。第一,模型的准确度很高,这可以由上述的Insertion和Deletion实验体现;第二,XAI本质上是需要服务人类的,所以它的输出对人类而言应该是友好的,而本文首次在XAI中提出了一种创新性的人机交互实验,并且所提方法更易于人类理解。

Future Work

本文所提出的EAC方法也可用于解释 DNN 对医学图像的预测,但是目前而言,效果并不够好,这可能会误导医生并导致严重的后果。因此,作者期望在将来能够有更多的研究者专注于该细分领域,实现更加鲁棒的新方法。

整理:陈妍

审核:孙奥

提醒

点击“阅读原文”跳转到01:33:22

可以查看回放哦!

往期精彩文章推荐

记得关注我们呀!每天都有新知识!

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了1400多位海内外讲者,举办了逾600场活动,超600万人次观看。

我知道你

在看

哦

~

点击 阅读原文 观看回放!

三层路由、DHCP以及VRRP协议介绍)