这篇文章其实就是基于Axial-DeepLab: Stand-Alone Axial-Attention forPanoptic Segmentation论文上进行的一些小创新

Stand-Alone Axial-Attention forPanoptic Segmentation论文解读:

论文解读:Axial-DeepLab: Stand-Alone Axial-Attention forPanoptic Segmentation-CSDN博客

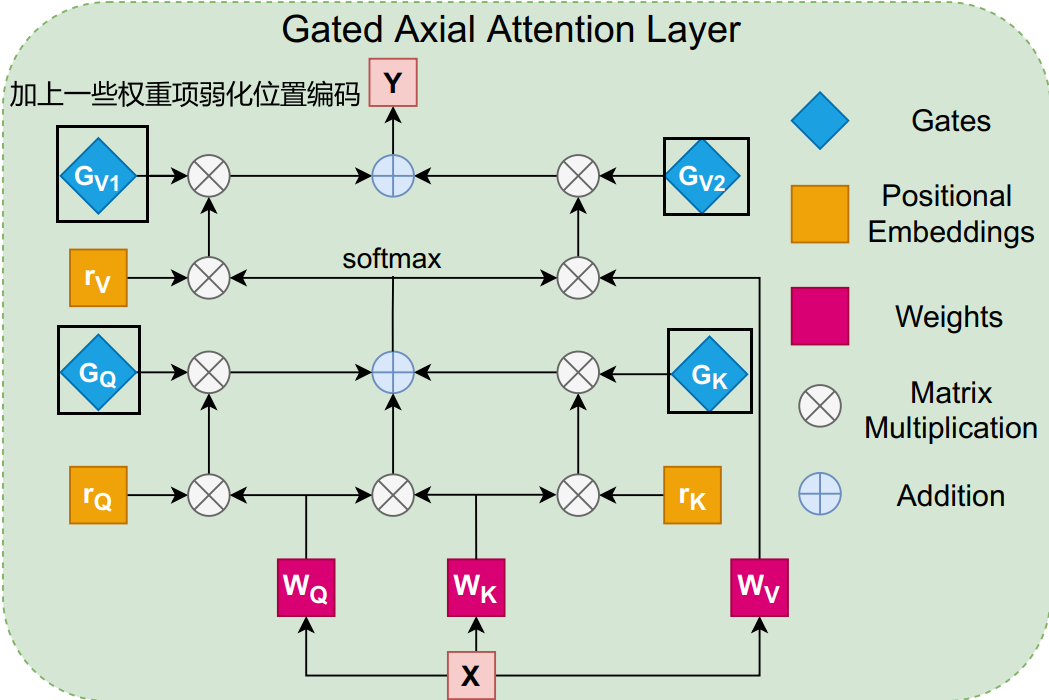

创新点1:

文章中把权重项(比如值都为0.1)说成门控单元,这个权重项是可学习的

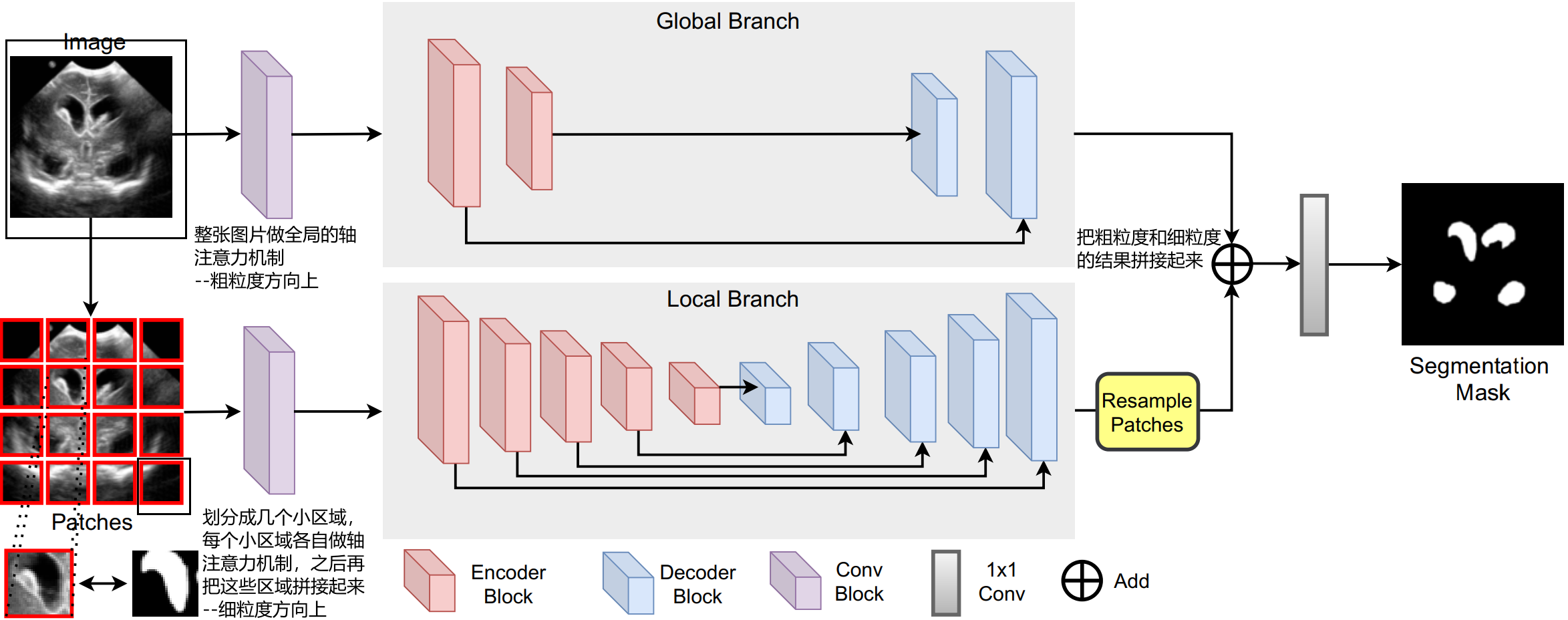

创新点2:

创新点3:

细粒度匹配的计算比粗粒度更快一点,所以在创新点2的过程中会进行多次细粒度匹配

比如,上图创新点2中图片大小为256*256

粗粒度匹配为256*256*(256(行方向上)+256(列方向上))

细粒度匹配为:

每个区域为256/4*256/4=64*64,每个区域的轴注意力机制规模为64+64

所以一次完整的细粒度匹配为16*64*64*(64+64)=256*256*(64+64)

故粗粒度匹配/细粒度匹配=8

所以可以进行1次粗粒度的注意力机制的同时进行8次细粒度的注意力机制

文章下载

https://www.yuque.com/attachments/yuque/0/2023/pdf/27783288/1702111305819-e97ac573-e43d-4521-b0f9-65f766db22c2.pdf

)

)

operator)