笔记整理:邹铭辉,天津大学硕士,研究方向为自然语言处理

链接:https://aclanthology.org/2023.acl-long.897

动机

文档级事件关系抽取(Document-level Event-Event Relation Extraction,简称DERE)旨在从文档中提取事件之间的关系。相较于传统的句子级任务(SERE),它涉及更加复杂的长文本理解。为了更好地进行文档级推理,不同于现有方法通过语言工具构建事件图,本文工作更关注文档本身的性质,并且不依赖于任何先验知识。为了做到这一点,作者强调以下关键问题:(1)如何捕捉可能相距较远的事件依赖关系?(2)考虑到SERE和DERE之间的本质差异,是否应该将所有事件对同等对待?为了解决这些问题,作者提出了一种新颖的DERE模型,该模型学习稀疏的事件表示,用于区分句内和句间推理,即SENDIR(Sparse EveNt representations for Discriminating Intra- and inter-sentential Reasoning)。其基本思想是通过假设同一句子中或跨越多个句子的事件对具有不同的信息密度来区分它们:(1)文档中的低密度暗示着对不相关信息的稀疏注意。本文模型的模块1设计了各种类型的注意力机制来学习事件表示,以捕捉远距离依赖关系。(2)句子中的高密度使得SERE相对较容易。本文模型的模块2使用不同的权重来强调句内和句间推理的作用和贡献,从而为联合建模引入了支持性事件对。大量实验证明了SENDIR的显著改进以及各种稀疏注意力在文档级表示上的有效性。

亮点

本文亮点主要包括:

(1)考虑到DERE和SERE任务的本质差异,提出了区分句内推理和句间推理的想法;

(2)本文提出的SENDIR模型关注文档本身的性质,而无需任何的先验知识和外部工具。

模型与方法

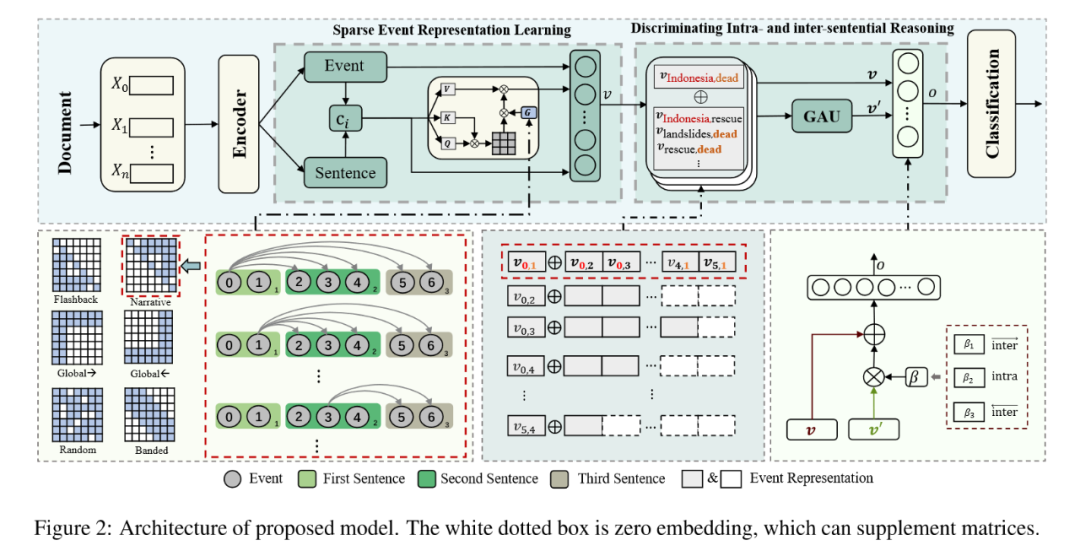

SENDIR旨在学习高质量的事件表示,以促进句内和句间推理。如图2所示,模型框架有四个主要组件:(1)编码器(Encoder)用于将文档编码为向量,(2)稀疏事件表示学习(SER)根据文档嵌入进一步学习事件表示,(3)区分句内和句间推理(DIR)基于每对事件表示进行联合推理,以及(4)分类模块(Classification)用于进行最终预测。

编码器(Encoder)

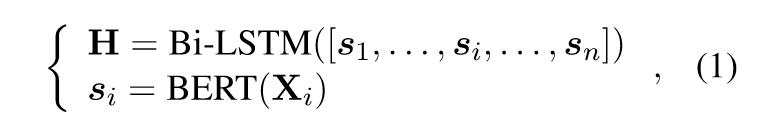

使用BERT和Bi-LSTM对长文档(超过512个token)进行编码,具体来说,首先使用BERT对单个句子进行编码得到每个句子中token的表示,然后使用Bi-LSTM对所有句子的所有token进行编码。公式如下:

其中Xi=[x1, x2, …, xm]表示第i个包含m个token的句子,H=[ h1, h2, …, hn]表示所有句子的所有n个token的嵌入。

对于事件ei,p,其中i表示第i个事件,p表示句子的索引,定义其嵌入为ei,p = hk,如果事件提及的词是xk,则该事件在文档中的位置为k。

稀疏事件表示学习(SER)

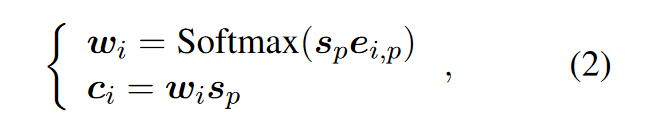

SER研究了不同类型的注意力机制,以捕捉句子之间的长距离依赖关系,以获得高质量的文档表示,并用于增强事件表示。具体而言,SER首先学习事件特定的句子嵌入ci作为局部上下文(基于事件嵌入与所在句子的句子嵌入计算点积注意力):

基于这些嵌入,SER再应用稀疏自注意力机制来跳过不相关的信息,以得到全局上下文c'i。特别地,SER引入了六种不同类型的长距离依赖假设。图2的模型结构图的左下角可视化展示了不同类型的注意力掩码。Global→假设前两个句子中的事件是文档的核心主题,并且应该看到所有其他事件;Global←假设最后两个句子中的事件是文档的结论主题,并且应该看到所有其他事件;Random通常用于增加非局部交互的能力,本文随机采样20%的矩阵元素为0,其他为1;Banded假设相关信息仅限于邻居句子(距离小于3),即每个事件只能看到邻居句子中的事件;Narrative假设事件大多是按叙述顺序描述的,以便前一个事件可以看到后一个事件;Flashback假设事件是按顺序写入的,因此后一个事件应该看到前一个事件。

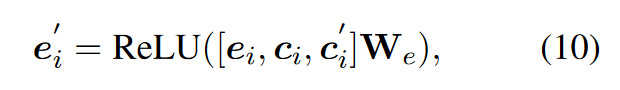

然后,根据局部和全局上下文定义事件表示e'i为:

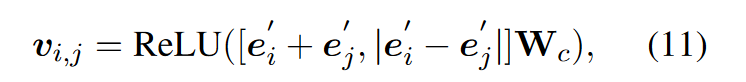

最后,给定一个事件对(ei, ej),定义其表示vi,j为:

区分句内和句间推理(DIR)

上一节定义了基于局部和全局上下文的事件对表示vi,j。在本节中,DIR将它们作为句内特征进行处理,表明尚未考虑从其他句子中获取事件对以形成推理链。为了进一步获得每对事件的句间特征,DIR首先为每对事件选择支持事件对,并使用GAU进行信息融合。然后,以不同的权重将两种类型的特征组合在一起,以区分两种类型的推理。

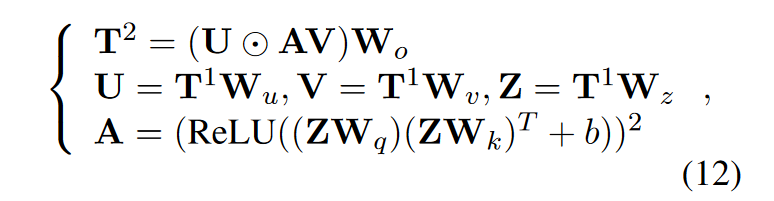

首先,假设只有共享至少一个公共事件的事件对才能对推理链做出贡献,而不是使用所有事件对作为支持。基于这一假设,可以为给定的一个事件对(ei, ej)构建一个支持事件对集合T1=[vi,j, vi,1, …, vN,j],然后使用GAU进行推理得到增强后的事件对表示T2=[v'i,j, v'i,1, …, v'N,j]。公式如下:

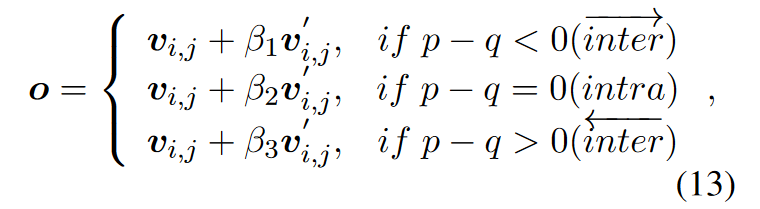

然后,需要将两种不同权重的特征组合起来。基本思想是,同一句子内的事件对相对容易预测,并且有很高的置信度。因此,DIR利用句内特征来促进跨不同句子的事件对。为了避免更容易的预测带来的问题,如果事件对在同一句子内,则给予句内特征更高的权重。相反,对于来自不同句子的事件,则给予句间特征更高的权重,以突出句间推理。最后,对于关系(ei, ej)之间的查询事件对表示定义如下:

其中β1, β2和β3是超参数(本文中分别设置为0.8, 0.2和0),p和q表示事件所在句子的索引。

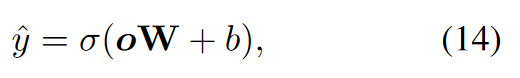

分类模块(Classification)

给定事件对的最终表示o,使用线性函数来预测关系,公式如下:

实验

本文在两个领域的三个数据集上对模型进行评估。EventStoryLine和Causal-TimeBank是事件因果关系抽取(RE)数据集,而MATRES是事件时间关系抽取数据集。其中,EventStoryLine标注了258份文档,包含22个主题,共有4,316个句子,5,334个事件提及,7,805个句内事件对,以及46,521个句间事件对。Causal-TimeBank (Causal-TB)标注了184份文档,包含6,813个事件,和7,608个事件对。MATRES标注了275份文档,涵盖了四种时间关系,即BEFORE,AFTER,EQUAL和VAGUE。

本文使用精确率(P)、召回率(R)和F1分数(F1)作为评估指标。

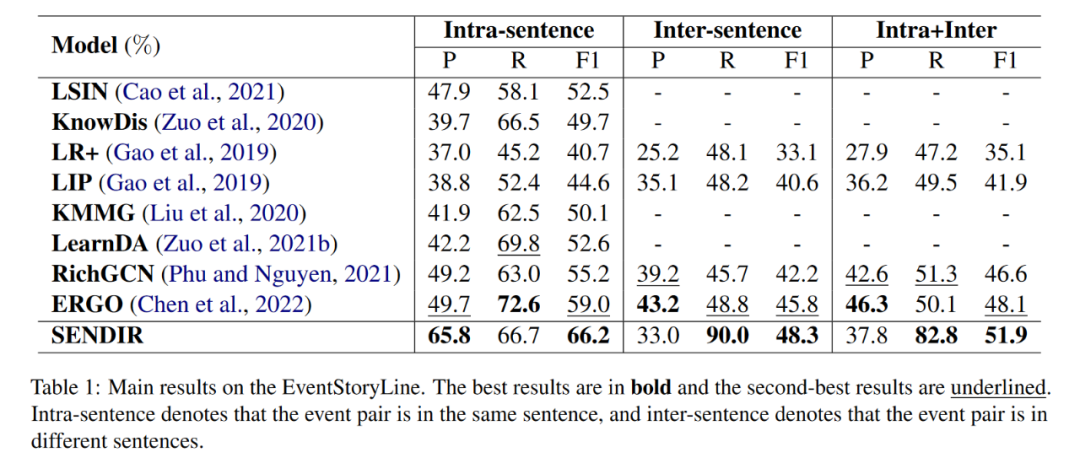

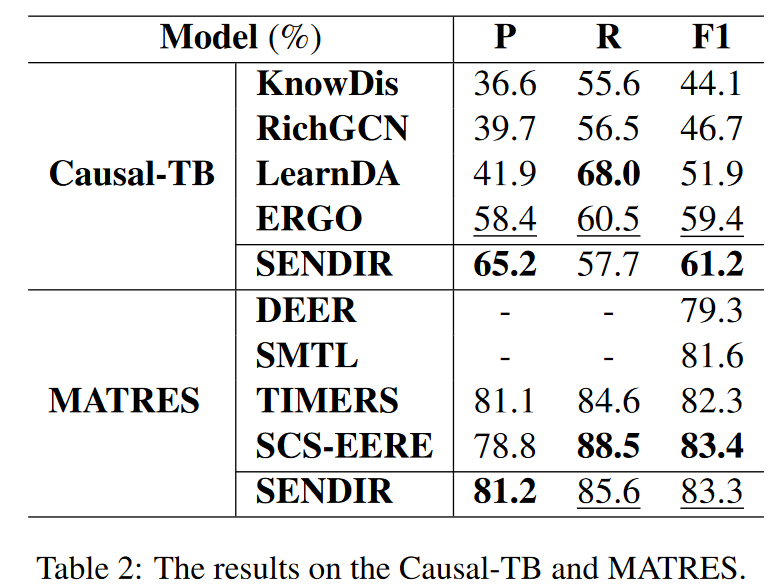

表1和表2分别展示了在EventStoryLine、Causal-TB和MATRES上的整体性能。我们可以看到:(1)SENDIR在EventStoryLine和Causal-TB上取得了更好的F1得分,并且在MATRES上也有竞争力的结果,这证明了模型的有效性和泛化能力。(2)在MATRES上,SENDIR略低于SCS-EERE。因为事件时间关系抽取对事件之间的方向尤为敏感。(3)在表1中,所有模型在句内表现比句间更好。这与本文的论断一致,即句内关系抽取更容易。(4)特别地,SENDIR在句内具有更高的精确度。因为区分性推理方案减轻了更困难的跨句子推理的负面影响。(5)在句间设置中,改进主要来自更高的召回率。作者将这归因于增强的远距离建模能力和支持性的查询集——它倾向于从更广泛的上下文和其他事件对中找到关系线索。

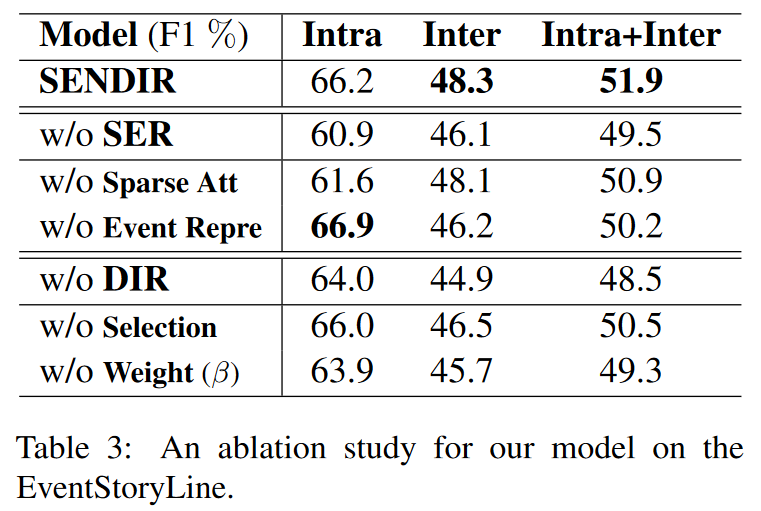

为了进一步分析SENDIR,本文还进行了消融分析,以说明主要模块的有效性。表3展示了消融实验的结果。

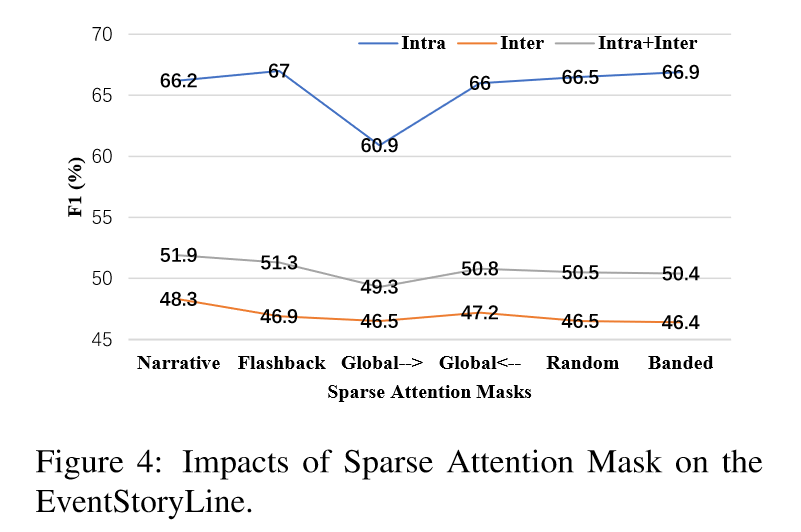

为了研究不同的稀疏注意力掩码对SER(某个特定任务或模型的准确率)的影响,本文使用了以下不同的稀疏注意力掩码:Narrative、Flashback、Global→、Global←、Random和Banded。从图4中可以得到以下结论:(1)在句内,这些稀疏注意力掩码除了Global→外,其他的结果都相似。这与之前的结果一致,即事件对更多地依赖于局部语境而不是远距离的全局语境。(2)Random意外地表现良好,表明文档中存在大量冗余信息,而稀疏掩码矩阵可以减轻噪声的影响。(3)Narrative取得了最佳性能,这反映了人类写作习惯中的语言偏好——总是首先谈论主题。

总结

本文将一种新颖的具有稀疏事件表示的判别推理方法SENDIR用于DERE。该方法可以学习高质量的事件表示,并促进文档级理解中的跨句推理。实验结果表明了方法的有效性,改善了句间情况,而不损害句内事件对。广泛的分析还为稀疏长文本表示学习中的各种语言偏差提供了有趣的见解。SENDIR的局限性包括以下两个方面:(1)它尚未扩展到文档级别的以实体为中心的关系任务。本文工作是以事件为中心的,未来的工作将在实体为中心的情况下进行扩展。文档级别的以实体为中心的关系抽取需要考虑实体的多次提及以及同一实体对的不同方向上的不同关系。(2)它没有引入外部常识知识。知识可以用于丰富事件并提高准确的事件关系抽取。

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文,进入 OpenKG 网站。

)

Java+ssm+MYSQL酒店大数据资源管理系统的设计与实现02029)