论文地址:Excellent-Paper-For-Daily-Reading/summarize at main

类别:综述

时间:2023/11/03

摘要

这篇论文比较久了,但仍能从里面获得一些收获,论文主要是讨论并研究了不同的非线性激活函数的影响,sigmoid函数它的非零均值会在Hessian中诱发重要的奇异值,很容易导致在隐藏层中达到饱和区域,且也证实了sigmoid激活函数在随机初始化的深度网络并不是很合适。不过却又发现,处于处于饱和的神经元能够自己“逃脱出”饱和状态。这可能是由于训练算法中的一些机制,例如学习率的调整或梯度剪切。

此外,论文还讨论了雅可比矩阵的奇异值与训练困难之间的关系。当雅可比矩阵的奇异值远大于1时,训练会更加困难,这表明了梯度问题在深度网络中的重要性。

实验

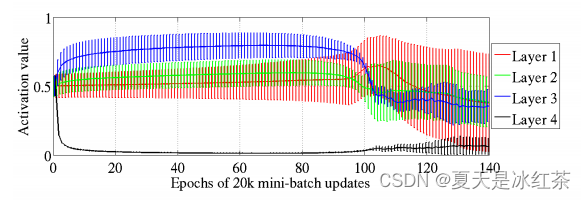

sigmoid

在监督学习期间,对于深度架构的不同隐藏层,激活值(sigmoid曲线的输出)的平均值和标准差(竖条)。顶部隐藏层在0处迅速饱和(减慢所有学习速度),然后在epoch 100左右慢慢去饱和。

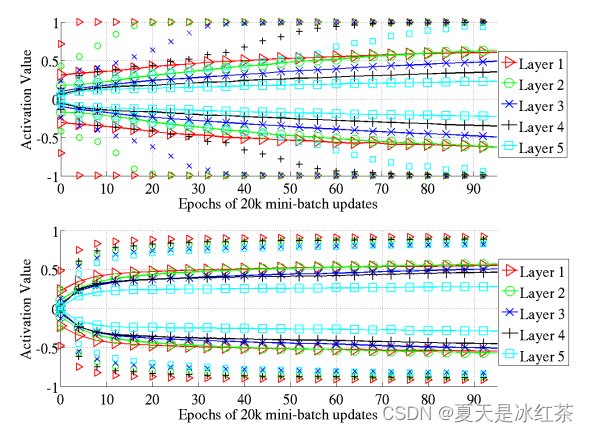

tanh

上图分别为 tanh 作为激活函数的激活值情况和 softsign 函数作为激活函数的激活值情况。其中实线表示上下标准差,而没有实线的点则表示 98% 的数据分布。

首先看上面的图像,可以看出从第一层到第五层,在标准均匀初始化权值的前提下,逐渐每层都慢慢到了饱和区, 对于这个现象,文中也没有给出合理的解释。再观察下面的图像,可以看出 softsign 函数的激活值比 tanh 函数的激活值区域饱和区的速度慢,因此效果也就更好。

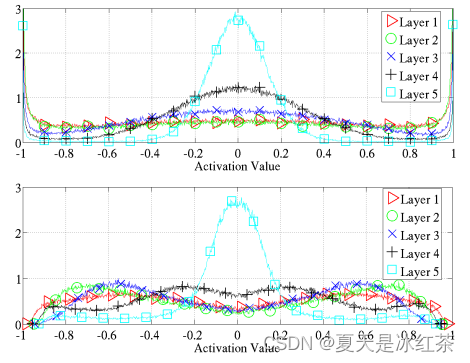

Softsign

上图表示激活值在学习结束时归一化的直方图,分布在同一层上的所有神经元和300个测试示例。两幅图中上面的表示的是激活函数为 tanh ,下面表示的是激活函数为 softsign,处在 0 附近的激活值是线性区,而 (-0.8, -0.6) 和 (0.6, 0.8) 区域处于非线性区。

总结

- 训练迭代是理解深度网络中训练困难的一个强大的研究工具。

- 当从小的随机权重初始化时,应该避免Sigmoid激活(在0周围不对称),因为它们产生较差的学习动态,顶部隐藏层初始饱和。

- 保持层到层的转换,这样激活和梯度都很好地流动(即雅可比矩阵在1左右)似乎是有帮助的,并且可以消除纯监督深度网络和使用无监督学习预训练的深度网络之间的很大一部分差异。

)

--nbiot - NB-IOT操作库)

)

)

)