Diffusion models代码解读:入门与实战

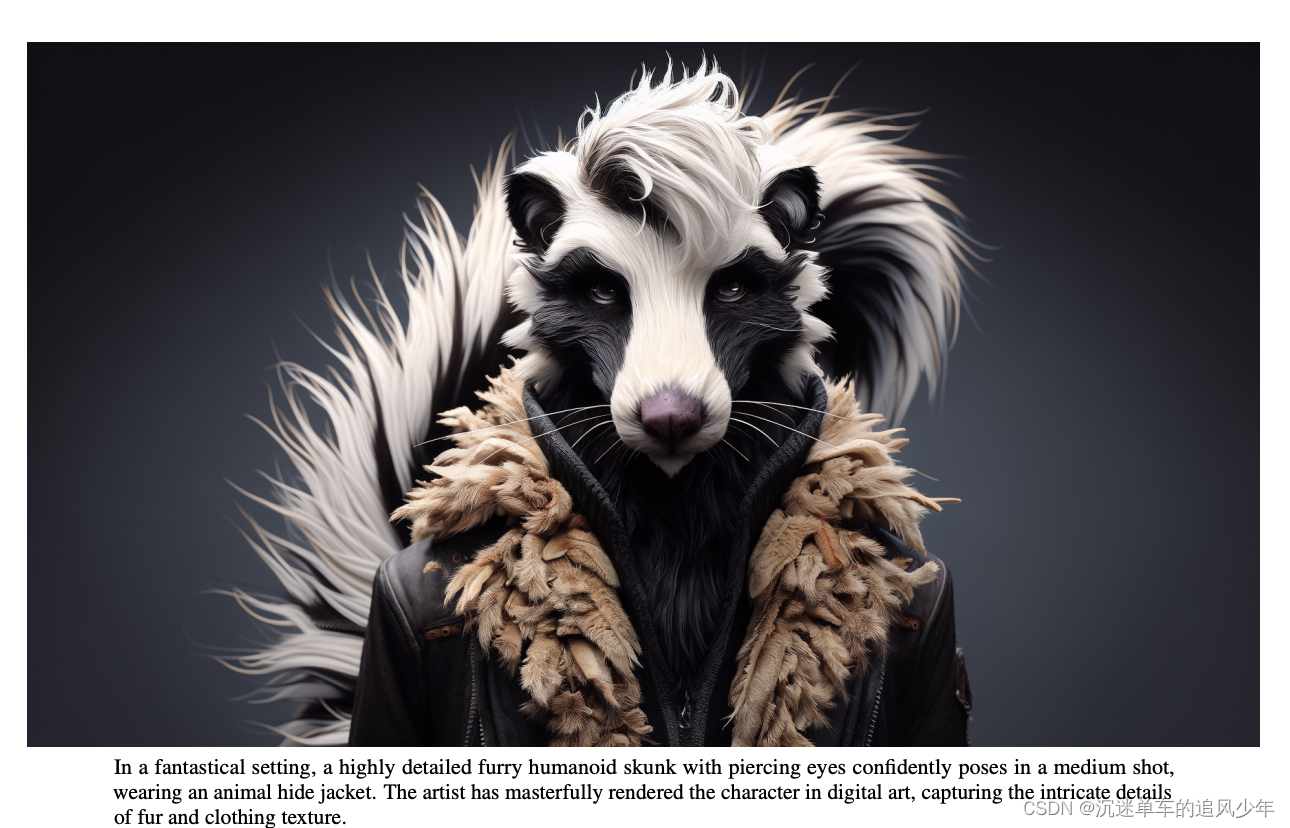

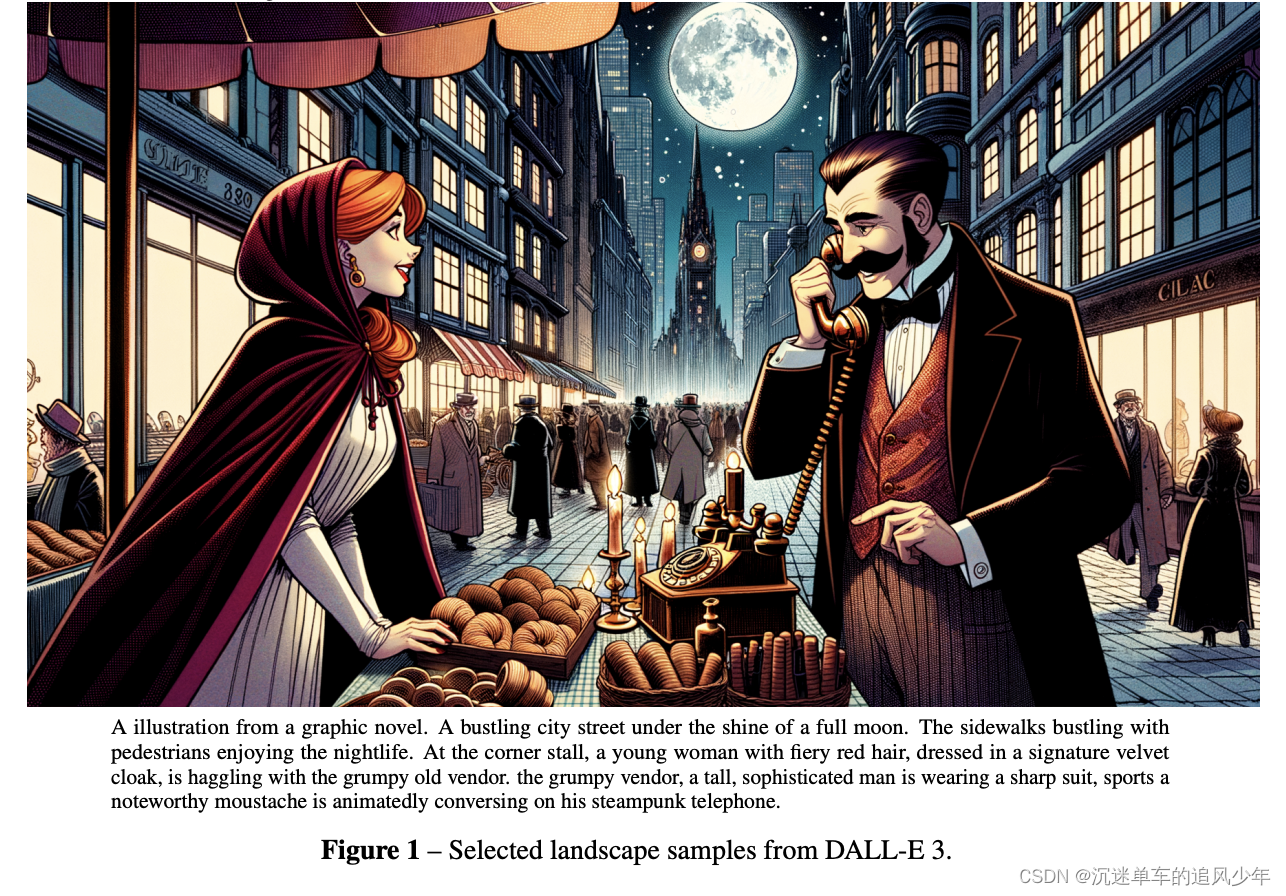

前言:OpenAI是推动大模型创新的领头羊,最近发布的DALLE 3凭借着远超市面上其他图片生成模型的表现,再次火出圈。最近OpenAI官方发布了DALLE 3的技术报告《Improving Image Generation with Better Captions》。这篇博客详细解读这篇技术报告,揭示DALLE 3背后的秘密。

目录

贡献概述

方法详解

原有图像标题存在的问题

微调图像标题生成器

论文和代码地址

个人感悟

贡献概述

现有的文本到图像模型在跟随详细的图像描述方面存在问题,常常忽略单词或混淆提示的含义,例如DALL-E 2没有强制要求每个单词只有一个含义的约束。作者假设这个问题源于训练数据集中不准确的图像标题。为了解决这个问题,作者训练了一个定制的图像标题生成器,并使用它对训练数据集进行了重新标注。作者利用这些发现构建了DALL-E 3,取得了非常好的效果。

方法详解

原有图像标题存在的问题

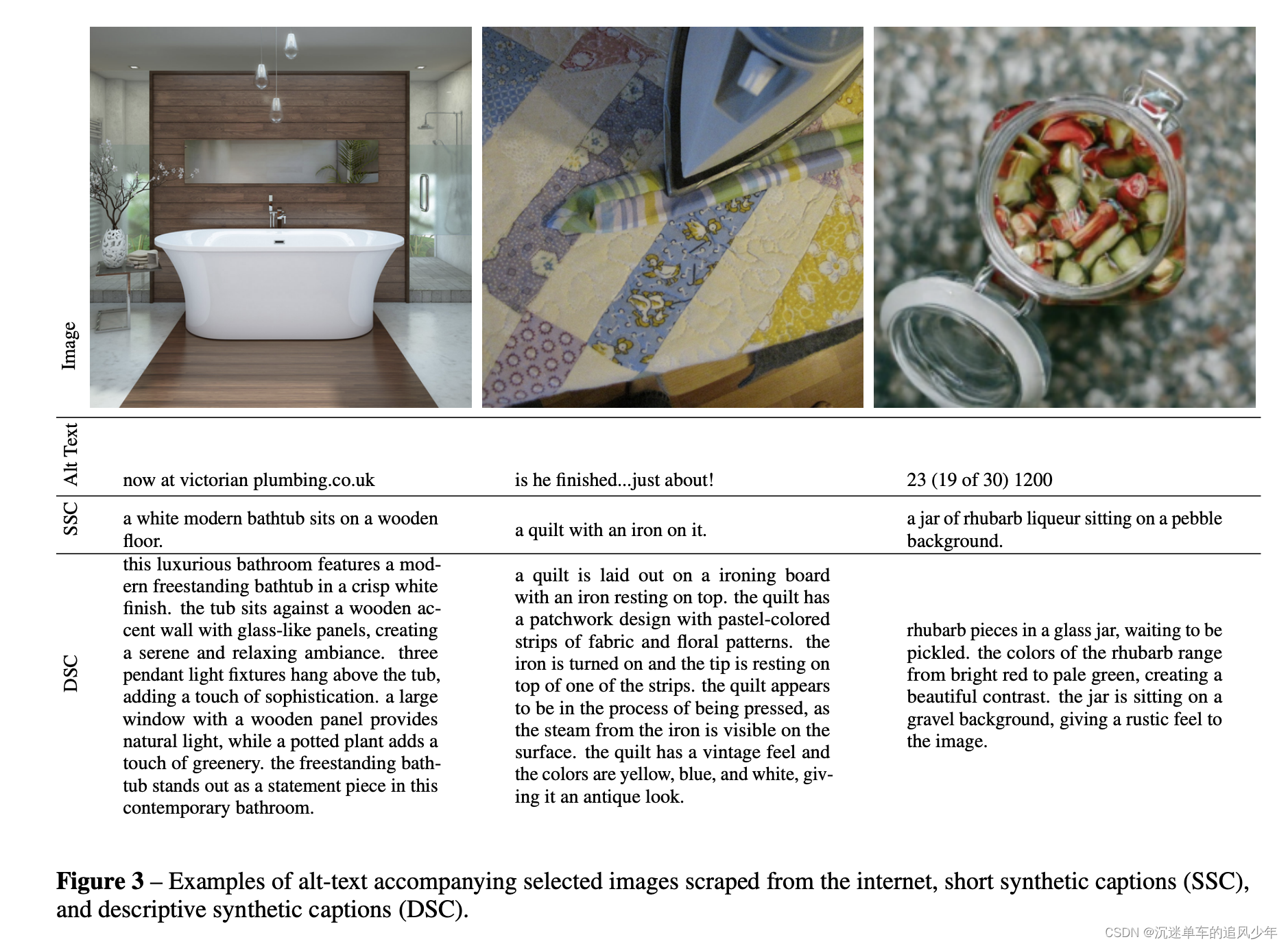

在互联网上找到的标题往往是错误的,描述了与图像边缘相关的细节。所以作者决定要用给图像打标题的方法来合成这样的数据集。

下面这样图展示了合成的图片标题会比直接从收集到的描述详细很多。

微调图像标题生成器

作者采用了先合成短标题再合成长标题的方法。

先构建了一个小的数据集,其中的标题只描述图像的主要主题。然后继续在该数据集上训练图像标题生成器。这个过程中θ的更新使得模型更倾向于描述图像的主要主题,将这种微调后生成的标题称为“短标题合成器”。

重复这个过程,创建一个包含每个图像内容的长、高度描述性标题的数据集。这些标题不仅描述图像的主要主题,还描述了其周围环境、背景、图像中的文字、风格、着色等。再次在这个数据集上对基础的图像标题生成器进行微调,将这个图像标题生成器生成的标题称为“描述性标题合成”。

论文和代码地址

https://cdn.openai.com/papers/dall-e-3.pdf

代码地址暂无

个人感悟

1、openai太强了,先跪为敬。

2、这篇技术报告不包含DALL-E 3模型的训练或实验细节,只介绍了前期洗数据时候如何标注图片,其他关键部分讳莫如深。

3、这篇技术报告对自己做预训练的研究者来说特别有借鉴意义。

4、在技术介绍上也太抠了,方法才讲了1页,讳莫如深啊!很小气!