本心、输入输出、结果

文章目录

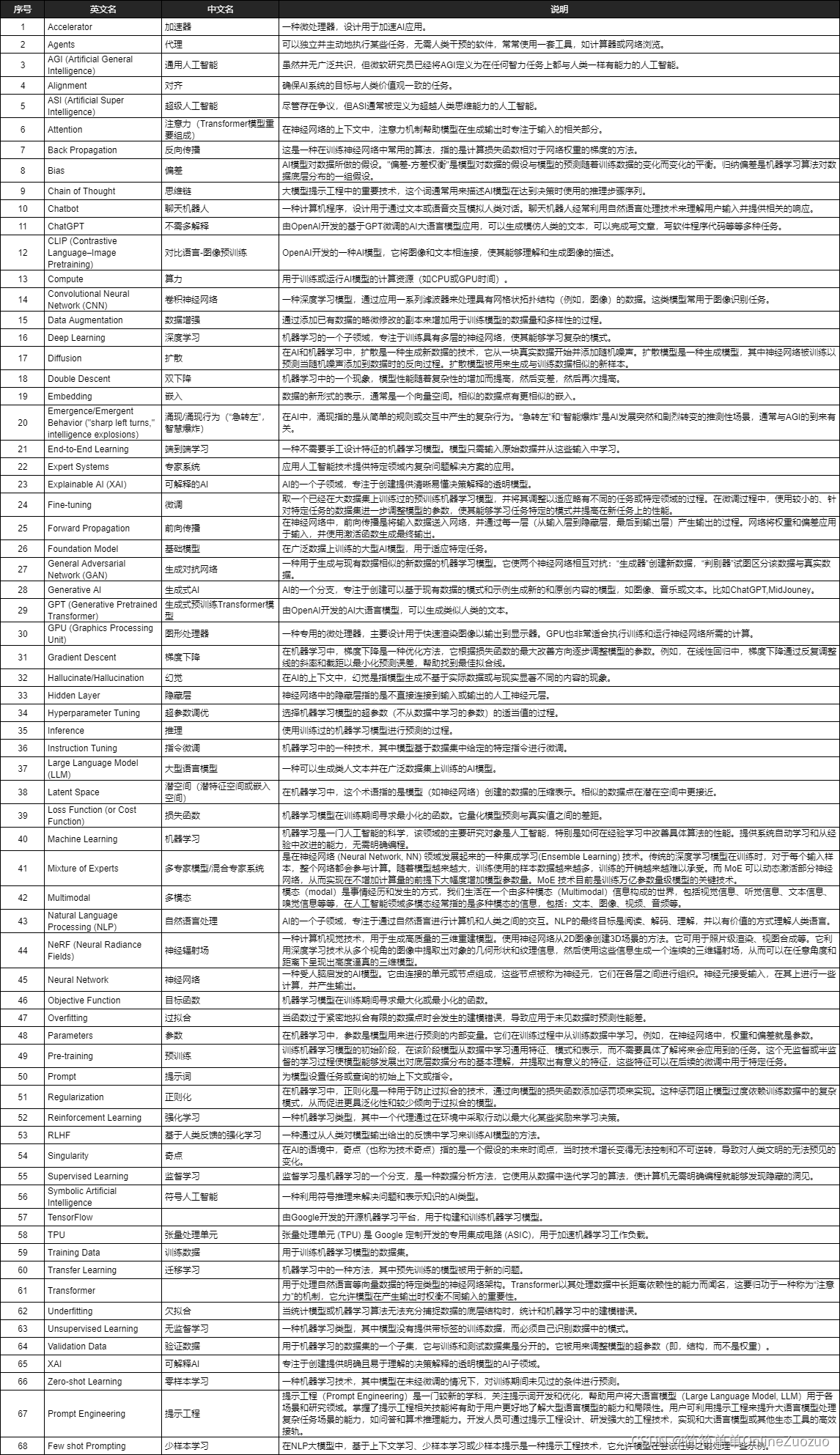

- 了解 AI :了解 AI 方面的一些术语 (中英文对照)

- 前言

- AI 方面的一些术语 (中英文对照)

- AI 方面的一些术语 (中英文对照) - 文字版

- 弘扬爱国精神

了解 AI :了解 AI 方面的一些术语 (中英文对照)

编辑:简简单单 Online zuozuo

地址:https://blog.csdn.net/qq_15071263

前言

了解 AI :了解 AI 方面的一些术语 (中英文对照)

了解 AI :了解 AI 方面的一些术语 (中英文对照)

AI 方面的一些术语 (中英文对照)

AI 方面的一些术语 (中英文对照) - 文字版

1 Accelerator 加速器 一种微处理器,设计用于加速AI应用。

2 Agents 代理 可以独立并主动地执行某些任务,无需人类干预的软件,常常使用一套工具,如计算器或网络浏览。

3 AGI (Artificial General Intelligence) 通用人工智能 虽然并无广泛共识,但微软研究员已经将AGI定义为在任何智力任务上都与人类一样有能力的人工智能。

4 Alignment 对齐 确保AI系统的目标与人类价值观一致的任务。

5 ASI (Artificial Super Intelligence) 超级人工智能 尽管存在争议,但ASI通常被定义为超越人类思维能力的人工智能。

6 Attention 注意力(Transformer模型重要组成) 在神经网络的上下文中,注意力机制帮助模型在生成输出时专注于输入的相关部分。

7 Back Propagation 反向传播 这是一种在训练神经网络中常用的算法,指的是计算损失函数相对于网络权重的梯度的方法。

8 Bias 偏差 AI模型对数据所做的假设。"偏差-方差权衡"是模型对数据的假设与模型的预测随着训练数据的变化而变化的平衡。归纳偏差是机器学习算法对数据底层分布的一组假设。

9 Chain of Thought 思维链 大模型提示工程中的重要技术,这个词通常用来描述AI模型在达到决策时使用的推理步骤序列。

10 Chatbot 聊天机器人 一种计算机程序,设计用于通过文本或语音交互模拟人类对话。聊天机器人经常利用自然语言处理技术来理解用户输入并提供相关的响应。

11 ChatGPT 不需多解释 由OpenAI开发的基于GPT微调的AI大语言模型应用,可以生成模仿人类的文本,可以完成写文章,写软件程序代码等等多种任务。

12 CLIP (Contrastive Language–Image Pretraining) 对比语言-图像预训练 OpenAI开发的一种AI模型,它将图像和文本相连接,使其能够理解和生成图像的描述。

13 Compute 算力 用于训练或运行AI模型的计算资源(如CPU或GPU时间)。

14 Convolutional Neural Network (CNN) 卷积神经网络 一种深度学习模型,通过应用一系列滤波器来处理具有网格状拓扑结构(例如,图像)的数据。这类模型常用于图像识别任务。

15 Data Augmentation 数据增强 通过添加已有数据的略微修改的副本来增加用于训练模型的数据量和多样性的过程。

16 Deep Learning 深度学习 机器学习的一个子领域,专注于训练具有多层的神经网络,使其能够学习复杂的模式。

17 Diffusion 扩散 在AI和机器学习中,扩散是一种生成新数据的技术,它从一块真实数据开始并添加随机噪声。扩散模型是一种生成模型,其中神经网络被训练以预测当随机噪声添加到数据时的反向过程。扩散模型被用来生成与训练数据相似的新样本。

18 Double Descent 双下降 机器学习中的一个现象,模型性能随着复杂性的增加而提高,然后变差,然后再次提高。

19 Embedding 嵌入 数据的新形式的表示,通常是一个向量空间。相似的数据点有更相似的嵌入。

20 Emergence/Emergent Behavior (“sharp left turns,” intelligence explosions) 涌现/涌现行为(“急转左”,智慧爆炸) 在AI中,涌现指的是从简单的规则或交互中产生的复杂行为。“急转左”和“智能爆炸”是AI发展突然和剧烈转变的推测性场景,通常与AGI的到来有关。

21 End-to-End Learning 端到端学习 一种不需要手工设计特征的机器学习模型。模型只需输入原始数据并从这些输入中学习。

22 Expert Systems 专家系统 应用人工智能技术提供特定领域内复杂问题解决方案的应用。

23 Explainable AI (XAI) 可解释的AI AI的一个子领域,专注于创建提供清晰易懂决策解释的透明模型。

24 Fine-tuning 微调 取一个已经在大数据集上训练过的预训练机器学习模型,并将其调整以适应略有不同的任务或特定领域的过程。在微调过程中,使用较小的、针对特定任务的数据集进一步调整模型的参数,使其能够学习任务特定的模式并提高在新任务上的性能。

25 Forward Propagation 前向传播 在神经网络中,前向传播是将输入数据送入网络,并通过每一层(从输入层到隐藏层,最后到输出层)产生输出的过程。网络将权重和偏差应用于输入,并使用激活函数生成最终输出。

26 Foundation Model 基础模型 在广泛数据上训练的大型AI模型,用于适应特定任务。

27 General Adversarial Network (GAN) 生成对抗网络 一种用于生成与现有数据相似的新数据的机器学习模型。它使两个神经网络相互对抗:“生成器”创建新数据,“判别器”试图区分该数据与真实数据。

28 Generative AI 生成式AI AI的一个分支,专注于创建可以基于现有数据的模式和示例生成新的和原创内容的模型,如图像、音乐或文本。比如ChatGPT,MidJouney。

29 GPT (Generative Pretrained Transformer) 生成式预训练Transformer模型 由OpenAI开发的AI大语言模型,可以生成类似人类的文本。

30 GPU (Graphics Processing Unit) 图形处理器 一种专用的微处理器,主要设计用于快速渲染图像以输出到显示器。GPU也非常适合执行训练和运行神经网络所需的计算。

31 Gradient Descent 梯度下降 在机器学习中,梯度下降是一种优化方法,它根据损失函数的最大改善方向逐步调整模型的参数。例如,在线性回归中,梯度下降通过反复调整线的斜率和截距以最小化预测误差,帮助找到最佳拟合线。

32 Hallucinate/Hallucination 幻觉 在AI的上下文中,幻觉是指模型生成不基于实际数据或与现实显著不同的内容的现象。

33 Hidden Layer 隐藏层 神经网络中的隐藏层指的是不直接连接到输入或输出的人工神经元层。

34 Hyperparameter Tuning 超参数调优 选择机器学习模型的超参数(不从数据中学习的参数)的适当值的过程。

35 Inference 推理 使用训练过的机器学习模型进行预测的过程。

36 Instruction Tuning 指令微调 机器学习中的一种技术,其中模型基于数据集中给定的特定指令进行微调。

37 Large Language Model (LLM) 大型语言模型 一种可以生成类人文本并在广泛数据集上训练的AI模型。

38 Latent Space 潜空间(潜特征空间或嵌入空间) 在机器学习中,这个术语指的是模型(如神经网络)创建的数据的压缩表示。相似的数据点在潜在空间中更接近。

39 Loss Function (or Cost Function) 损失函数 机器学习模型在训练期间寻求最小化的函数。它量化模型预测与真实值之间的差距。

40 Machine Learning 机器学习 机器学习是一门人工智能的科学,该领域的主要研究对象是人工智能,特别是如何在经验学习中改善具体算法的性能。提供系统自动学习和从经验中改进的能力,无需明确编程。

41 Mixture of Experts 多专家模型/混合专家系统 是在神经网络 (Neural Network, NN) 领域发展起来的一种集成学习(Ensemble Learning) 技术。传统的深度学习模型在训练时,对于每个输入样本,整个网络都会参与计算。随着模型越来越大,训练使用的样本数据越来越多,训练的开销越来越难以承受。而 MoE 可以动态激活部分神经网络,从而实现在不增加计算量的前提下大幅度增加模型参数量。MoE 技术目前是训练万亿参数量级模型的关键技术。

42 Multimodal 多模态 模态(modal)是事情经历和发生的方式,我们生活在一个由多种模态(Multimodal)信息构成的世界,包括视觉信息、听觉信息、文本信息、嗅觉信息等等,在人工智能领域多模态经常指的是多种模态的信息,包括:文本、图像、视频、音频等。

43 Natural Language Processing (NLP) 自然语言处理 AI的一个子领域,专注于通过自然语言进行计算机和人类之间的交互。NLP的最终目标是阅读、解码、理解,并以有价值的方式理解人类语言。

44 NeRF (Neural Radiance Fields) 神经辐射场 一种计算机视觉技术,用于生成高质量的三维重建模型。使用神经网络从2D图像创建3D场景的方法。它可用于照片级渲染、视图合成等。它利用深度学习技术从多个视角的图像中提取出对象的几何形状和纹理信息,然后使用这些信息生成一个连续的三维辐射场,从而可以在任意角度和距离下呈现出高度逼真的三维模型。

45 Neural Network 神经网络 一种受人脑启发的AI模型。它由连接的单元或节点组成,这些节点被称为神经元,它们在各层之间进行组织。神经元接受输入,在其上进行一些计算,并产生输出。

46 Objective Function 目标函数 机器学习模型在训练期间寻求最大化或最小化的函数。

47 Overfitting 过拟合 当函数过于紧密地拟合有限的数据点时会发生的建模错误,导致应用于未见数据时预测性能差。

48 Parameters 参数 在机器学习中,参数是模型用来进行预测的内部变量。它们在训练过程中从训练数据中学习。例如,在神经网络中,权重和偏差就是参数。

49 Pre-training 预训练 训练机器学习模型的初始阶段,在该阶段模型从数据中学习通用特征、模式和表示,而不需要具体了解将来会应用到的任务。这个无监督或半监督的学习过程使模型能够发展出对底层数据分布的基本理解,并提取出有意义的特征,这些特征可以在后续的微调中用于特定任务。

50 Prompt 提示词 为模型设置任务或查询的初始上下文或指令。

51 Regularization 正则化 在机器学习中,正则化是一种用于防止过拟合的技术,通过向模型的损失函数添加惩罚项来实现。这种惩罚阻止模型过度依赖训练数据中的复杂模式,从而促进更具泛化性和较少倾向于过拟合的模型。

52 Reinforcement Learning 强化学习 一种机器学习类型,其中一个代理通过在环境中采取行动以最大化某些奖励来学习决策。

53 RLHF 基于人类反馈的强化学习 一种通过从人类对模型输出给出的反馈中学习来训练AI模型的方法。

54 Singularity 奇点 在AI的语境中,奇点(也称为技术奇点)指的是一个假设的未来时间点,当时技术增长变得无法控制和不可逆转,导致对人类文明的无法预见的变化。

55 Supervised Learning 监督学习 监督学习是机器学习的一个分支,是一种数据分析方法,它使用从数据中迭代学习的算法,使计算机无需明确编程就能够发现隐藏的洞见。

56 Symbolic Artificial Intelligence 符号人工智能 一种利用符号推理来解决问题和表示知识的AI类型。

57 TensorFlow 由Google开发的开源机器学习平台,用于构建和训练机器学习模型。

58 TPU 张量处理单元 张量处理单元 (TPU) 是 Google 定制开发的专用集成电路 (ASIC),用于加速机器学习工作负载。

59 Training Data 训练数据 用于训练机器学习模型的数据集。

60 Transfer Learning 迁移学习 机器学习中的一种方法,其中预先训练的模型被用于新的问题。

61 Transformer 用于处理自然语言等向量数据的特定类型的神经网络架构。Transformer以其处理数据中长距离依赖性的能力而闻名,这要归功于一种称为“注意力”的机制,它允许模型在产生输出时权衡不同输入的重要性。

62 Underfitting 欠拟合 当统计模型或机器学习算法无法充分捕捉数据的底层结构时,统计和机器学习中的建模错误。

63 Unsupervised Learning 无监督学习 一种机器学习类型,其中模型没有提供带标签的训练数据,而必须自己识别数据中的模式。

64 Validation Data 验证数据 用于机器学习的数据集的一个子集,它与训练和测试数据集是分开的。它被用来调整模型的超参数(即,结构,而不是权重)。

65 XAI 可解释AI 专注于创建提供明确且易于理解的决策解释的透明模型的AI子领域。

66 Zero-shot Learning 零样本学习 一种机器学习技术,其中模型在未经微调的情况下,对训练期间未见过的条件进行预测。

67 Prompt Engineering 提示工程 提示工程(Prompt Engineering)是一门较新的学科,关注提示词开发和优化,帮助用户将大语言模型(Large Language Model, LLM)用于各场景和研究领域。掌握了提示工程相关技能将有助于用户更好地了解大型语言模型的能力和局限性。用户可利用提示工程来提升大语言模型处理复杂任务场景的能力,如问答和算术推理能力。开发人员可通过提示工程设计、研发强大的工程技术,实现和大语言模型或其他生态工具的高效接轨。

68 Few shot Prompting 少样本学习 在NLP大模型中,基于上下文学习、少样本学习或少样本提示是一种提示工程技术,它允许模型在尝试任务之前处理一些示例。

弘扬爱国精神

![C:warning: null argument where non-null required (argument 2) [-Wnonnull]](http://pic.xiahunao.cn/C:warning: null argument where non-null required (argument 2) [-Wnonnull])

![买卖股票的最佳时机 II[中等]](http://pic.xiahunao.cn/买卖股票的最佳时机 II[中等])

)

- 安装LC-3 模拟器和编译器)